mcp-local-rag Máy chủ MCP

Máy chủ MCP mcp-local-rag cung cấp tìm kiếm web Retrieval-Augmented Generation (RAG) tại chỗ, bảo vệ quyền riêng tư cho LLMs. Nó cho phép trợ lý AI truy cập, nh...

Máy chủ MCP mcp-local-rag cung cấp tìm kiếm web Retrieval-Augmented Generation (RAG) tại chỗ, bảo vệ quyền riêng tư cho LLMs. Nó cho phép trợ lý AI truy cập, nh...

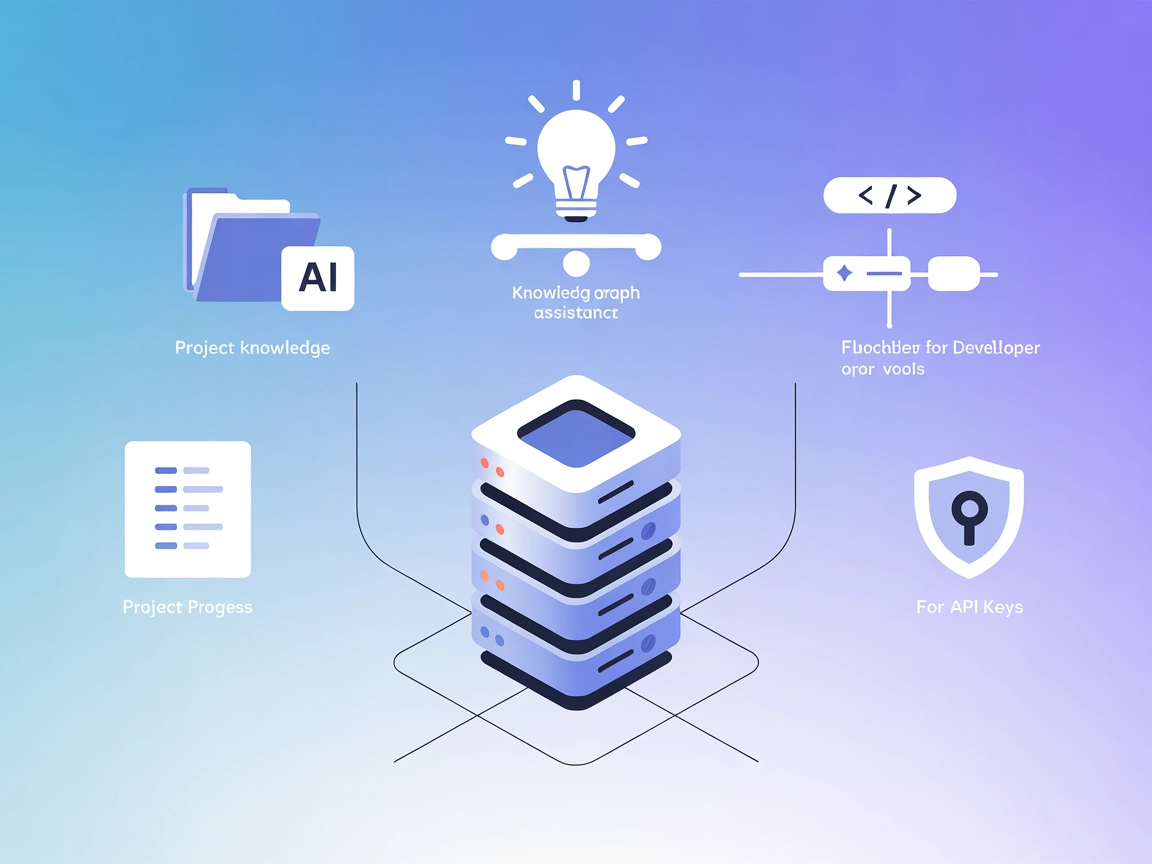

Context Portal (ConPort) là một máy chủ MCP ngân hàng bộ nhớ giúp các trợ lý AI và công cụ phát triển quản lý ngữ cảnh dự án có cấu trúc, cho phép Retrieval Aug...

Máy chủ MCP RAG Web Browser trang bị cho trợ lý AI và LLM khả năng tìm kiếm web trực tiếp và trích xuất nội dung, cho phép tích hợp truy xuất tăng cường (RAG), ...

Tích hợp FlowHunt với cơ sở dữ liệu vector Pinecone bằng Máy chủ MCP Pinecone. Kích hoạt tìm kiếm ngữ nghĩa, Retrieval-Augmented Generation (RAG), và quản lý tà...

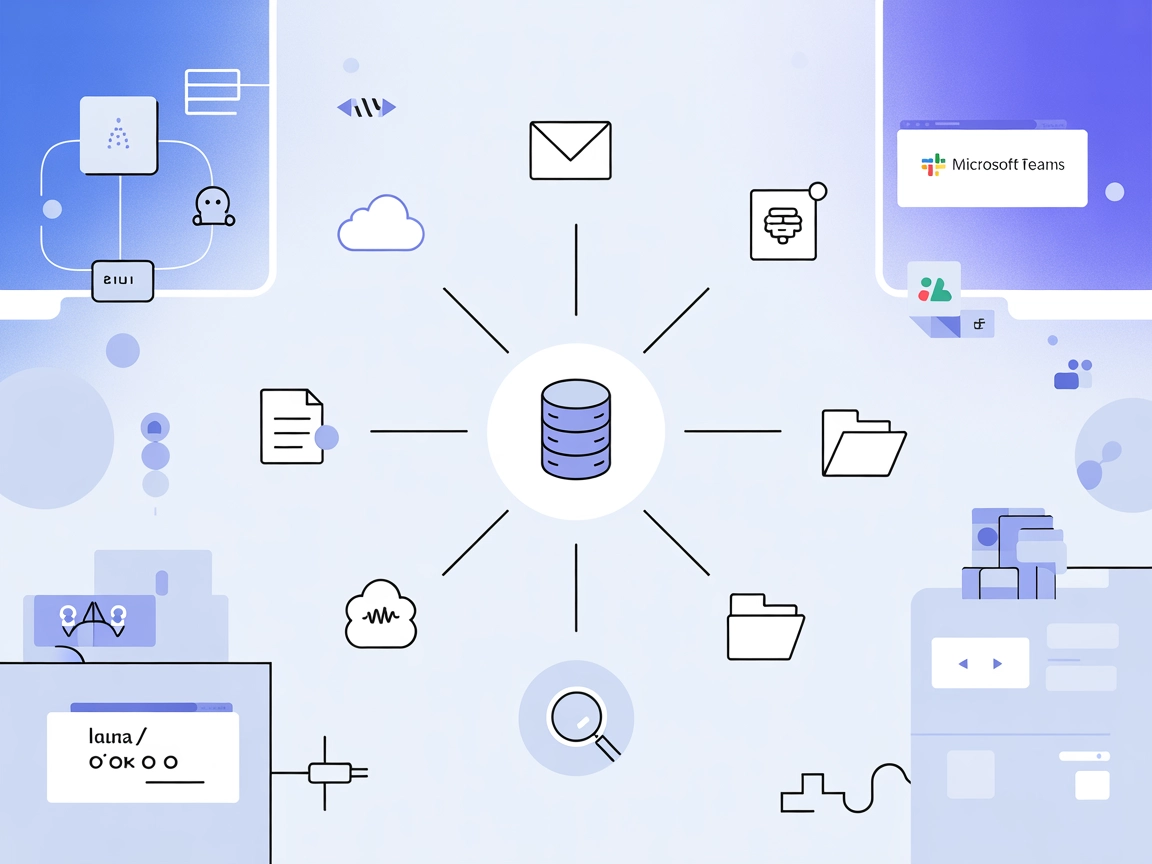

Agentset MCP Server là một nền tảng mã nguồn mở cho phép Retrieval-Augmented Generation (RAG) với khả năng tác nhân, cho phép trợ lý AI kết nối với các nguồn dữ...

Máy chủ Inkeep MCP kết nối trợ lý AI và các công cụ phát triển với tài liệu sản phẩm luôn được cập nhật trong Inkeep, cho phép truy xuất nội dung liên quan một ...

Máy chủ mcp-rag-local MCP mang đến cho trợ lý AI khả năng ghi nhớ ngữ nghĩa, cho phép lưu trữ và truy xuất các đoạn văn bản dựa trên ý nghĩa, không chỉ dựa trên...

Máy chủ Graphlit MCP kết nối FlowHunt và các khách hàng MCP khác với một nền tảng tri thức hợp nhất, cho phép nhập liệu, tổng hợp và truy xuất tài liệu, tin nhắ...

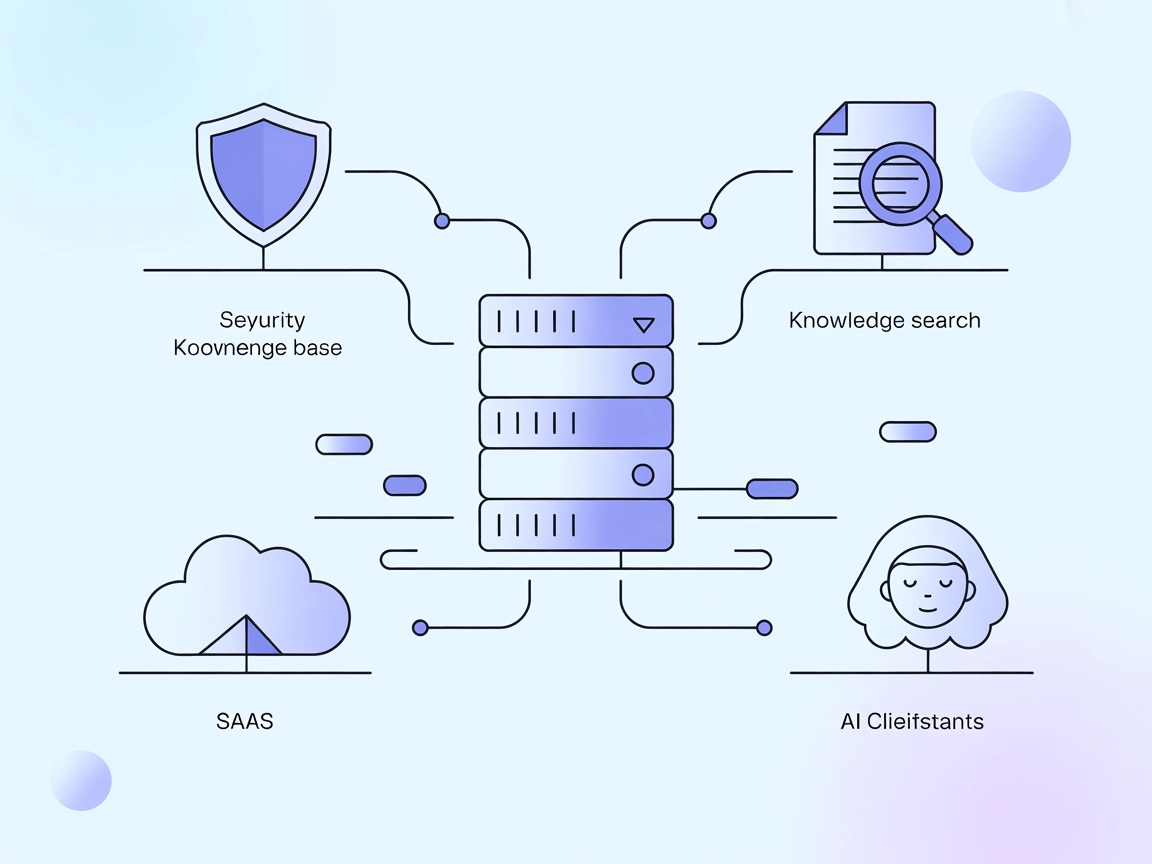

Vectara MCP Server là một cầu nối mã nguồn mở giữa các trợ lý AI và nền tảng Trusted RAG của Vectara, cho phép Retrieval-Augmented Generation (RAG) và tìm kiếm ...

Chấm điểm tài liệu trong Retrieval-Augmented Generation (RAG) là quá trình đánh giá và xếp hạng các tài liệu dựa trên mức độ liên quan và chất lượng của chúng đ...

Tăng độ chính xác AI với RIG! Tìm hiểu cách tạo chatbot kiểm tra thông tin bằng cả nguồn dữ liệu tùy chỉnh lẫn nguồn tổng hợp để mang lại câu trả lời đáng tin c...

LazyGraphRAG là một phương pháp tiếp cận sáng tạo cho Retrieval-Augmented Generation (RAG), tối ưu hóa hiệu quả và giảm chi phí trong truy xuất dữ liệu do AI đi...

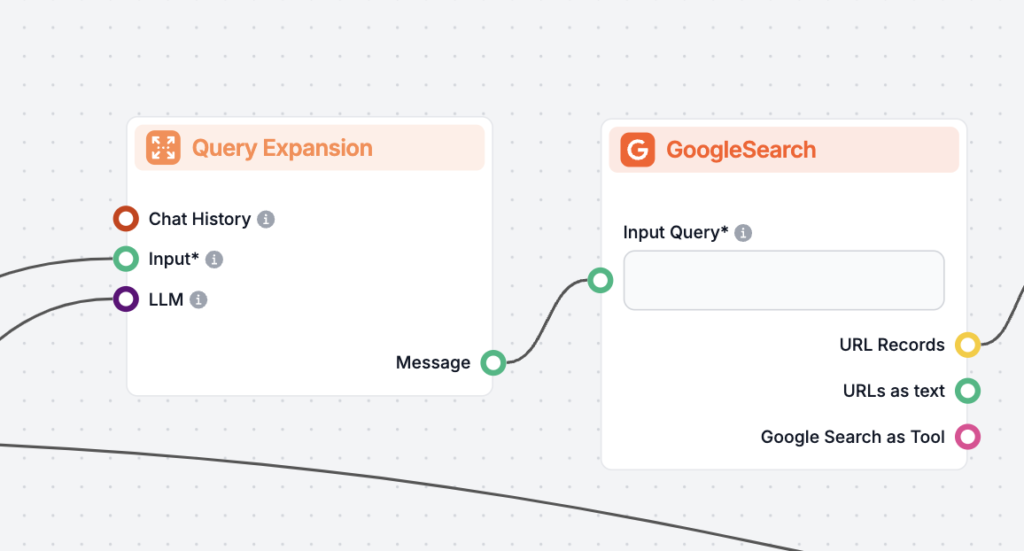

Mở rộng truy vấn là quá trình nâng cao truy vấn gốc của người dùng bằng cách thêm các thuật ngữ hoặc ngữ cảnh, giúp cải thiện việc truy xuất tài liệu để có phản...

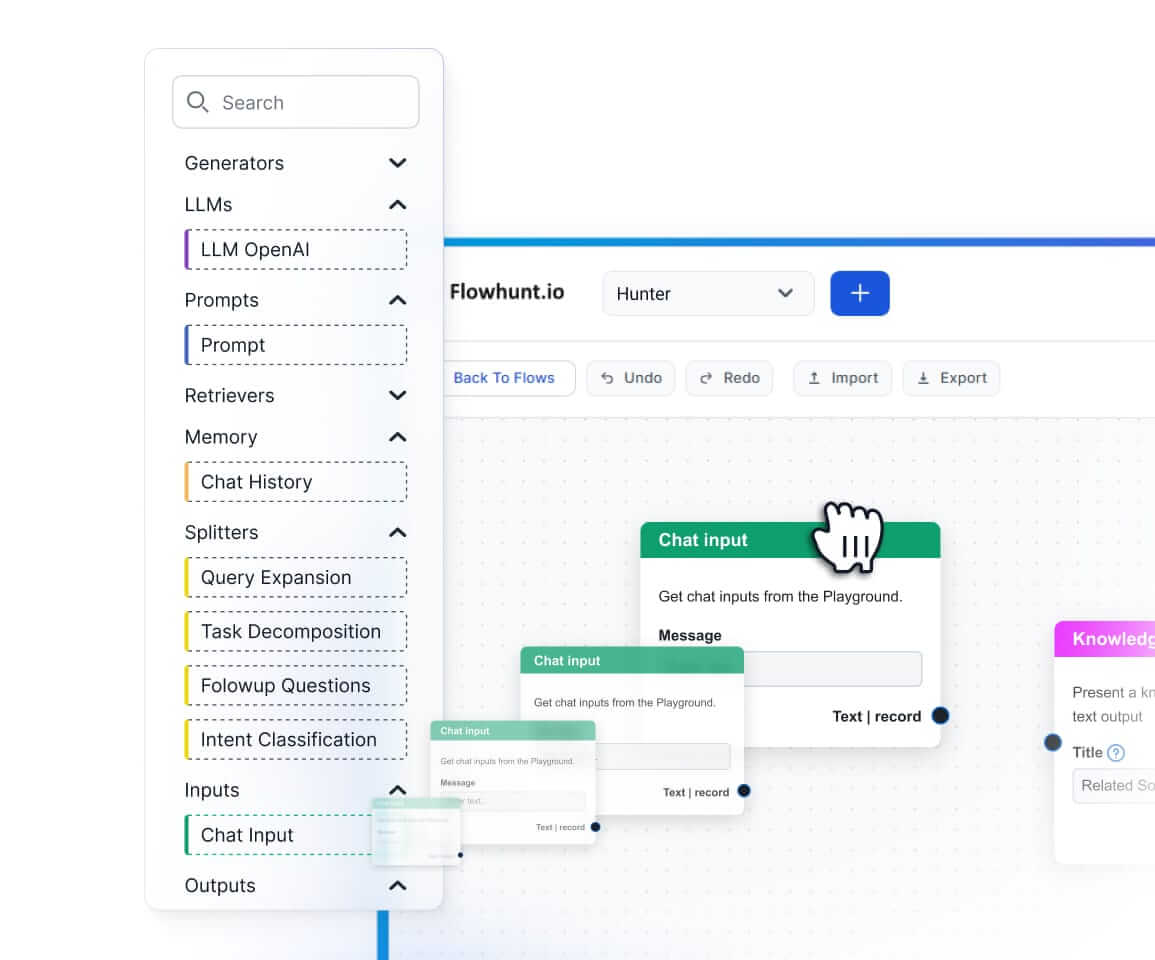

Nguồn Tri Thức giúp việc dạy AI theo nhu cầu của bạn trở nên dễ dàng. Khám phá mọi cách liên kết tri thức với FlowHunt. Dễ dàng kết nối website, tài liệu, và vi...

Khám phá quy trình truy xuất thông tin cho chatbot là gì, các thành phần, trường hợp sử dụng và cách Retrieval-Augmented Generation (RAG) cùng nguồn dữ liệu bên...

Khám phá cách khả năng lý luận tiên tiến và học tăng cường của OpenAI O1 vượt trội so với GPT4o về độ chính xác RAG, kèm theo các chỉ số đánh giá và phân tích c...

Sắp xếp lại tài liệu là quá trình sắp xếp lại thứ tự các tài liệu đã truy xuất dựa trên mức độ liên quan đến truy vấn của người dùng, tinh chỉnh kết quả tìm kiế...

Cache Augmented Generation (CAG) là một phương pháp mới nhằm nâng cao các mô hình ngôn ngữ lớn (LLM) bằng cách nạp trước tri thức dưới dạng bộ nhớ đệm key-value...

Khám phá những điểm khác biệt chính giữa Tạo sinh kết hợp truy hồi (RAG) và Tạo sinh kết hợp bộ nhớ đệm (CAG) trong AI. Tìm hiểu cách RAG truy xuất thông tin th...

Tạo sinh kết hợp truy xuất (RAG) là một khuôn khổ AI tiên tiến kết hợp các hệ thống truy xuất thông tin truyền thống với các mô hình ngôn ngữ lớn sinh sinh (LLM...

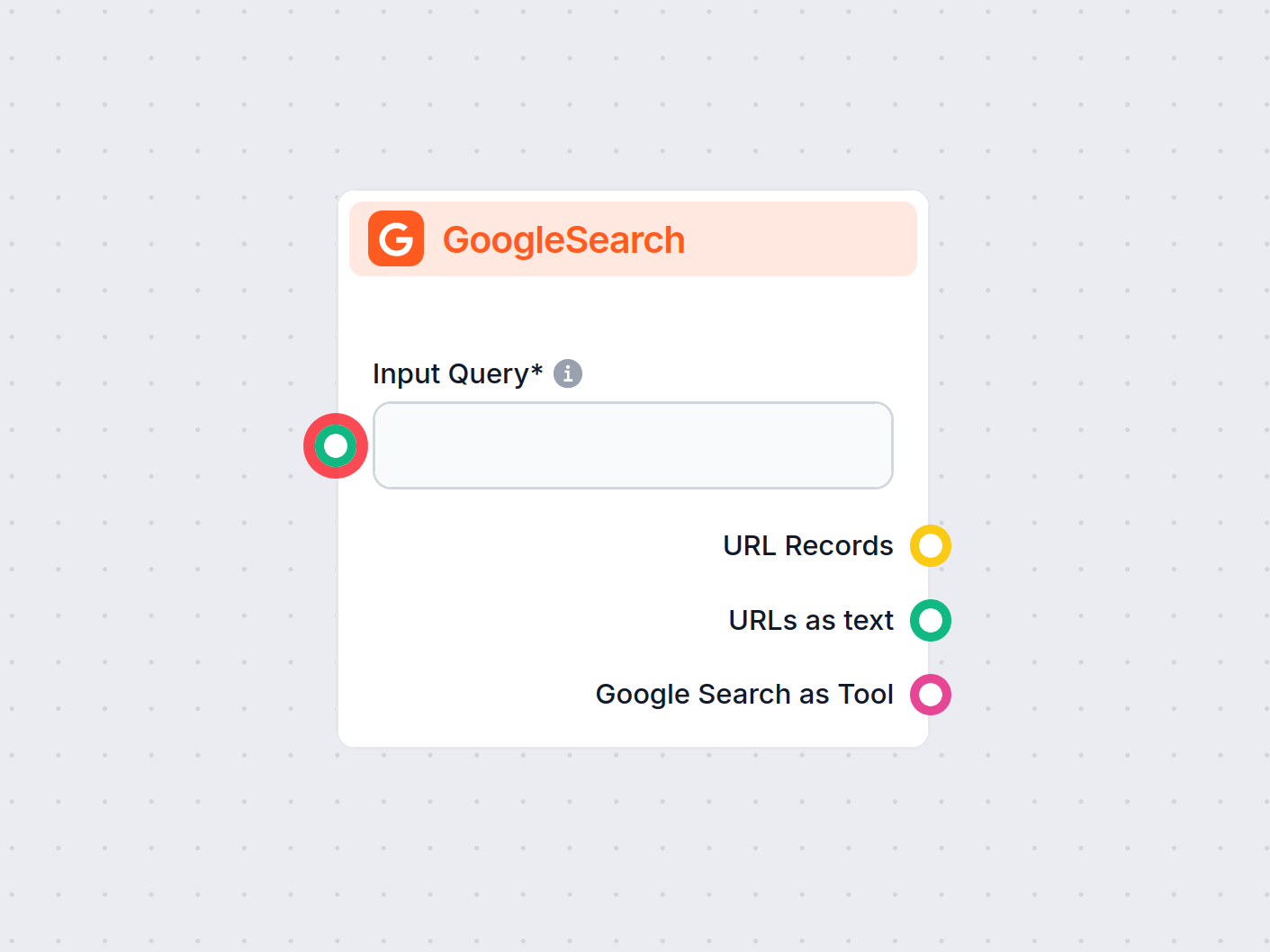

Thành phần GoogleSearch của FlowHunt tăng độ chính xác cho chatbot bằng cách sử dụng Retrieval-Augmented Generation (RAG) để truy cập kiến thức cập nhật từ Goog...

Trả lời câu hỏi với Retrieval-Augmented Generation (RAG) kết hợp truy xuất thông tin và sinh ngôn ngữ tự nhiên để nâng cao các mô hình ngôn ngữ lớn (LLMs) bằng ...

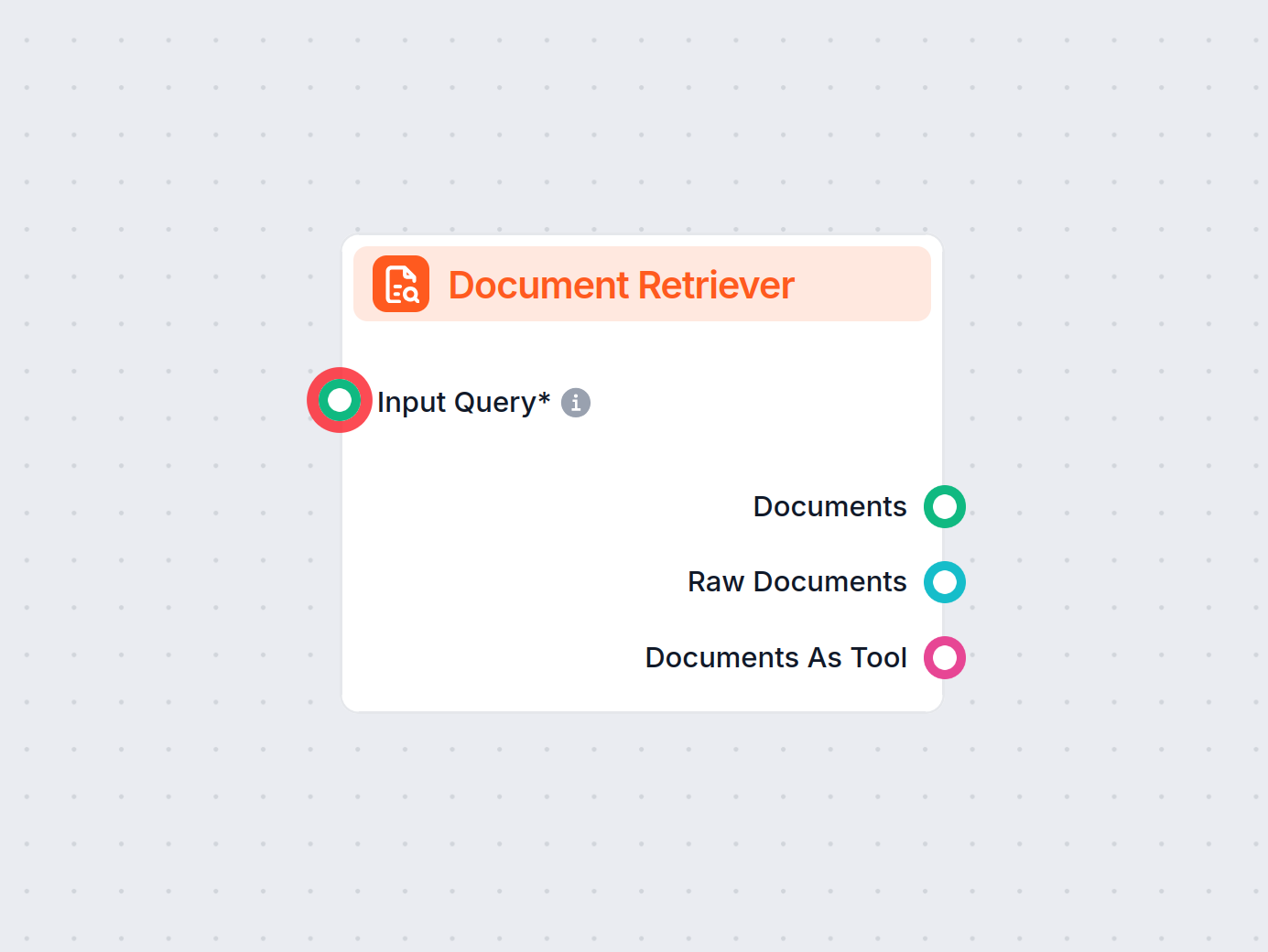

Trình Tìm kiếm Tài liệu của FlowHunt nâng cao độ chính xác của AI bằng cách kết nối các mô hình tạo sinh với tài liệu và URL cập nhật của riêng bạn, đảm bảo câu...