MCP服务器示例:为AI代理构建智能集成

探索全面的MCP服务器示例,学习如何构建、部署和集成模型上下文协议(MCP)服务器,以提升AI代理在企业系统中的能力。...

全面指南,帮助您构建、部署和扩展MCP服务器,通过模型上下文协议将AI模型与外部工具、数据源和工作流连接起来。

模型上下文协议(MCP)是一种开放标准,帮助人工智能(AI)模型与外部工具、数据源和软件系统顺畅连接。MCP就像通用接口一样,使AI助手和不同应用能够轻松交换数据和运行功能。你可以把它看作是“AI应用的USB-C”,帮助不同系统无兼容性障碍地协同工作。构建自己的MCP服务器,可以深入了解后端系统架构,并掌握AI与真实工具及日常工作流程对接的实用技能。

本MCP服务器指南将带你逐步了解所需的一切,从基础理念到实际搭建、测试和部署过程。无论你是想自动化业务流程,将AI代理连接到生产力应用,还是探索新的AI集成方式,都能在这里找到实用的指导和最佳实践。本指南为你提供信心和工具,开启MCP之旅。

模型上下文协议(MCP)是一种开放标准,帮助人工智能(AI)模型与不同软件和工具轻松共享信息。MCP就像一座桥梁,让AI系统(如大语言模型LLM)可以通过统一、清晰的规则与多种软件、数据库和实时资源通信。

MCP让AI助手能够安全高效地连接外部数据。没有MCP时,开发者需要为每个新应用单独开发连接,过程繁琐且效率低。MCP通过标准消息格式和明确的通信方式,解决了这一问题。无论每个工具采用什么技术,都能通过MCP互相理解。

开发者常用JSON等结构化数据格式与MCP配合,使其能在多种编程语言和平台间轻松实现。借助MCP,AI模型可以请求信息、执行任务或在其他系统中发起操作。例如,AI助手可以通过MCP查询日历事件、检查数据库或发送通知,无需为每个任务单独开发连接。

MCP支持多种实际用途:

有了MCP,添加新工具或功能更加轻松。开发速度提升,安全性因明确的访问规则而增强,同时可构建具备扩展能力的AI解决方案。

MCP为开发者提供简单灵活的方式,将AI能力与其他工具及数据连接。这有助于快速创新、保障系统平稳运行,并灵活应对新需求。组织采用MCP后,AI助手能实时获取详细信息,提供更优回答和更精准的操作。

了解模型上下文协议,为你打造可靠、适应性强的AI系统奠定基础,使其能与多种工具和数据源协作。

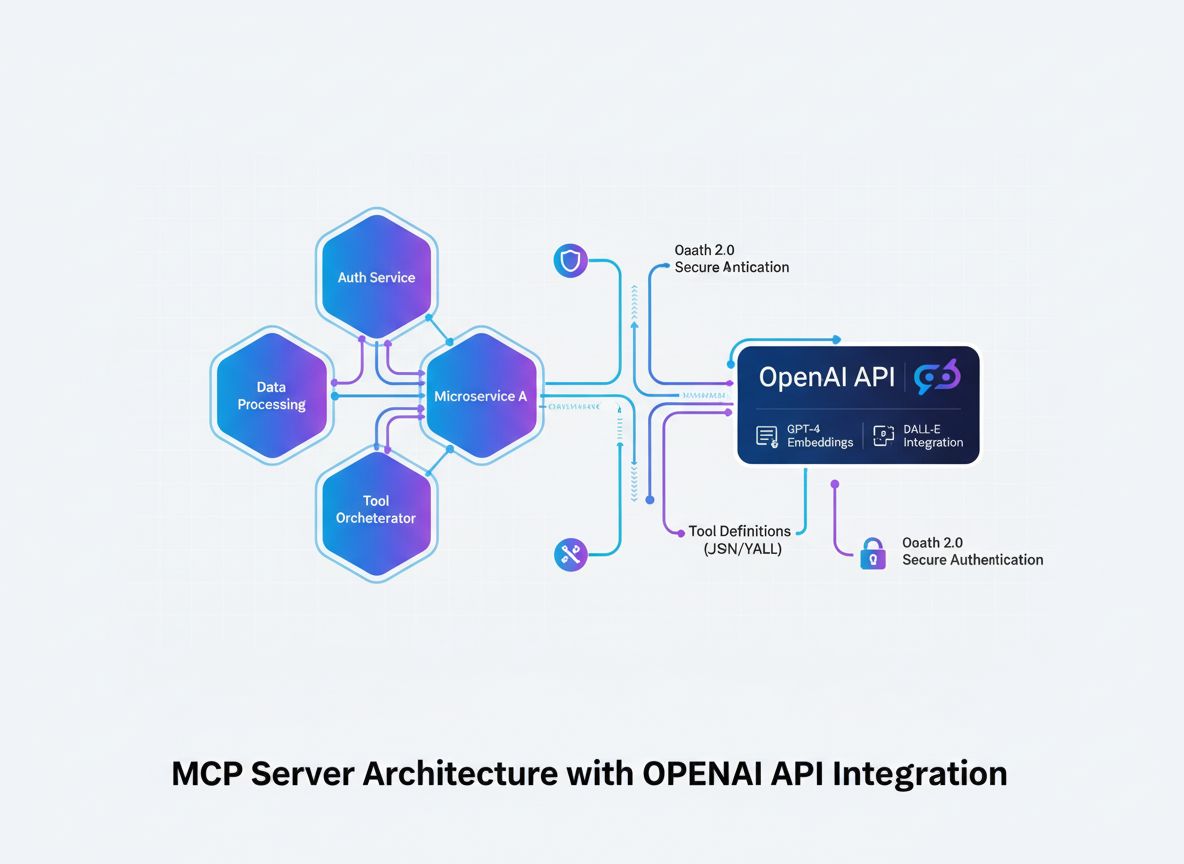

MCP服务器负责管理AI助手与外部工具或数据源间基于协议的通信。其架构采用模块化设计,每个部分负责系统中的特定任务。

服务器应用是主枢纽,接收、解析并响应MCP协议消息。它负责安全网络连接、客户端身份校验,以及管理服务器各部分间的数据流。服务器应用保障系统稳定高效地运行,通常能同时处理多路连接和任务。

工具与资源模块是服务器注册的独立代码单元。每个工具负责特定任务,比如获取数据、执行计算或自动化操作。MCP服务器维护这些工具的注册表,收到请求后能调用相应工具。这样可以轻松添加新工具,无需改动主服务器逻辑。

通信处理器负责读取遵循MCP协议的消息,检查请求格式是否正确,并将其分发给对应的工具或资源模块。同时,它还负责将响应按协议格式化后返回给客户端。通信处理器屏蔽了协议细节,使不同客户端都能顺畅接入。

集成接口是将MCP服务器与外部客户端(如AI助手或其他应用)对接的专用接口,这些接口可以采用HTTP端点、WebSocket或其他支持的传输方式。集成接口使客户端能够调用服务器的工具,实现实时通信与数据共享。

MCP服务器架构强调模块化。将服务器应用、工具、通信处理器和集成接口分离,便于单独升级或增加新功能。这让系统更易维护和扩展,适合支持大型复杂部署。

本节概述了MCP服务器各组成部分的协作方式,以及它们如何共同实现清晰可靠的协议通信。

首先选择一门拥有良好社区支持、易于构建MCP服务器的编程语言。Python和Node.js都是不错的选择,Python语法简洁、类库丰富,Node.js适合高并发异步任务。选择合适的代码编辑器,如Visual Studio Code、PyCharm或WebStorm,有助于高效编写与管理代码。

依赖和包管理方面,Python项目推荐使用pip和venv,Node.js则用npm或yarn。使用Git进行版本控制,便于追踪变更和多人协作。这些工具让开发过程井然有序,也便于在其他电脑上复现开发环境。

清晰的文件夹结构有助于项目维护和扩展。推荐如下方式组织服务器项目:

/mcp-server-project

/tools

/handlers

server.py (或 server.js)

requirements.txt (或 package.json)

README.md

每个工具或资源单独放在 /tools 文件夹内。所有协议相关逻辑放在 /handlers 文件夹。这样可保持代码整洁、各模块分明,符合最佳实践。

python -m venv venv && source venv/bin/activate 创建并激活虚拟环境。npm init -y 初始化。pip install flask,Node.js用 npm install express。.gitignore 文件,防止虚拟环境和系统文件被提交到版本库。README.md,方便他人复现开发环境。建议始终在虚拟环境中开发,隔离依赖。文件和文件夹命名要清晰统一,代码随时注释。频繁提交Git仓库,并做好备份。这样可打造稳定、可扩展的MCP服务器开发环境,支持专业开发需求。

你可以用清晰、模块化的代码快速搭建简单的MCP服务器。以Python和Flask为例,设置一个可以接收MCP格式请求并返回结构化响应的端点。以下是完整可运行的极简MCP服务器示例,代码可读性强,便于后续扩展。

首先导入Flask并创建应用实例。在/mcp路径下设置POST请求端点。MCP采用POST方法,因为它是发送协议消息的标准方式。

from flask import Flask, request, jsonify

app = Flask(__name__)

@app.route('/mcp', methods=['POST'])

def handle_mcp():

data = request.json

# 这里是处理MCP消息的逻辑占位符

return jsonify({'result': 'Hello, MCP!'})

if __name__ == '__main__':

app.run(port=5000)

科学解释:

POST请求配合JSON格式,便于在多种编程语言间发送结构化数据。Flask的请求处理机制会检查内容并妥善管理错误。

接下来完善处理器,使其能根据请求中指定的工具进行分发。这种写法结构清晰,便于维护。

def handle_mcp():

data = request.json

tool = data.get('tool')

if tool == 'calculator':

result = calculator_tool(data)

else:

result = 'Tool not found'

return jsonify({'result': result})

启动服务器:

python server.py

可用curl发送请求测试:

curl -X POST -H "Content-Type: application/json" -d '{"tool":"calculator","num1":2,"num2":3}' http://localhost:5000/mcp

如果服务器正常,会返回JSON响应。这说明服务器已具备接收并处理不同工具请求的能力。

这个例子为MCP服务器开发打下坚实基础,可随着项目成长不断添加协议兼容工具和扩展功能。

在MCP服务器中,工具是可供客户端或AI模型调用、执行特定动作或获取数据的独立函数或端点。每个工具专注于一个明确任务,例如运算、数据库查询或外部API对接。所有工具都遵循MCP(模型上下文协议)对信息收发的规范。

每个工具在MCP服务器中以函数形式注册。每个工具应有描述其用途、所需输入及输出的schema。MCP规范要求每个工具包括:

这样,客户端(包括AI模型)便可按需发现和调用工具,提升系统兼容性并减少通信错误。协议设计领域的研究表明,清晰的schema可以减少出错并提升系统对接效率。更多细节可参考MCP官方文档。

通常在服务器代码内用字典等结构维护工具注册表。收到请求时,服务器根据请求中的工具名称定位并分发至对应函数。添加新工具时建议:

模块化设计意味着添加新工具无需改动主服务器代码,方便随时拓展功能,提升服务器可扩展性。

tools = {

'calculator': calculator_tool,

'weather': weather_tool,

# 在此注册更多工具

}

def handle_mcp():

data = request.json

tool_name = data.get('tool')

if tool_name in tools:

result = tools[tool_name](data)

else:

result = 'Tool not found'

return jsonify({'result': result})

工具指可执行的函数,资源则是这些工具可访问的数据、服务或外部API。工具可连接数据库、文件存储或第三方服务,从而让MCP服务器能将AI客户端桥接到多样的数字资源。

测试MCP服务器时,首先用MCP Inspector、Postman或cURL等工具逐一检查各端点。这些工具可模拟协议消息发送,便于验证服务器返回的数据结构及错误码是否满足MCP规范。

可用自动化测试覆盖代码各部分。Python推荐用pytest,Node.js用mocha。这些框架有助于测试单个工具逻辑及服务器对不同消息的处理能力。要测试合法与非法请求,确认服务器对异常的应对。集成测试可模拟真实客户端行为,检查服务器是否正确分发请求并保存所需信息。

调试时应实时监控日志,并逐步跟踪代码。建议在关键节点(如接收请求、解析协议消息、调用工具、发送响应)开启详细日志,便于追踪数据流和定位异常。推荐用Python的logging或Node.js的winston等日志库,条理清晰地管理日志。

如需更深入排查,可用集成开发环境的调试器(如PyCharm Debugger或VS Code Debugger)设置断点,实时查看变量值。服务器部署于云端时,可借助远程调试工具或日志收集服务,如Dynatrace或CloudWatch,集中追踪错误。

常见问题有端点URL错误、消息格式不符或依赖缺失。应反复核查服务器配置(如端口号等)。用schema校验工具确保消息格式与服务器期望一致。遇到工具结果异常时,拆分为单元测试逐步排查,并检查相关代码变更。

良好的测试和详尽日志有助于快速定位问题,提升服务器稳定性和可维护性。

MCP服务器既可部署在本地测试,也可根据生产需求部署在云平台。Google Cloud Run、AWS Elastic Container Service(ECS)、Microsoft Azure App Service等云服务,提供自动扩缩、内置安全和高可用性。利用Docker容器可实现环境一致性,便于在不同平台间迁移服务器。

在部署前用环境变量管理敏感信息(如API密钥、数据库凭据)。合理分配CPU和内存资源以适应预期负载。务必采用HTTPS及TLS证书,保障客户端与服务器间数据安全。通过防火墙或安全组限制仅开放必要端口。

为MCP服务器端点实现认证机制,如API Key或OAuth,仅允许受信客户端访问。定期更新和轮换凭据,降低未授权访问风险。

启用服务器日志,并用CloudWatch或Google Operations Suite等云监控工具跟踪性能与错误。设置健康检查端点,自动监控服务器在线状态。配置告警,及时发现异常或故障。

利用云服务商的自动扩缩功能,根据负载自动调整服务器实例数量。高负载工具可动态分配资源。如支持,优先采用水平扩展(增加实例数)而非单实例资源扩容,以更好应对大流量。

定期更新依赖和操作系统补丁,防范安全威胁。部署变更时采用蓝绿或滚动更新,保障服务不中断。

遵循上述流程,可确保MCP服务器始终可用、安全,并具备面向未来的扩展能力,支撑稳定的生产级集成。

扩展MCP服务器时,首先可加入更复杂的工具,如数据分析模块、自动报告生成器,或对接工作流自动化平台的连接器。每个工具都应作为独立函数或微服务实现,并遵守MCP工具注册协议。这样即便功能增多,也能保持服务器易于管理。

集成AI时,可为服务器添加外部大语言模型与AI API接口。可通过SDK或RESTful端点对接OpenAI、Claude或Mistral等。服务器要能跟踪对话状态,实现更复杂的AI任务和多步操作链。可利用社区适配器或SDK,如Vercel AI SDK、LangChain MCP Adapters,简化集成并提升兼容性。

可通过构建专用MCP工具,接入天气、支付、通知等第三方API。每个工具要处理好认证、请求格式化和响应解析。认证方式应采用OAuth 2.1或API Key等安全协议。建议在容器或WebAssembly等隔离环境中运行这些工具,保障服务器和用户数据安全。

参考官方MCP文档和开源项目获取实现示例和社区扩展。积极参与开发者社区,贡献标准和最佳实践。每开发一个新工具,你的服务器就更强大,也能积累更多协议工程的实战经验。

借助这些方法,MCP服务器可不断拓展,支持更高级、更智能、更安全的应用场景。

搭建MCP服务器让你掌握了基于协议的集成、模块化后端设计,以及AI与其他系统的对接。通过本指南,你已完成从理解MCP原理、组装服务器核心部件、编写和测试代码、到安全部署及后续功能扩展的关键步骤。

MCP框架为AI代理与外部工具间的实时数据交换提供了明确方法。这种结构简化了集成过程,有助于支持可扩展、可演进的自动化(Anthropic,2024)。掌握这些技能,能让你顺应AI工作流和后端需求的不断变化。

欢迎继续尝试新工具、接入多样数据,并参与MCP开发者社区的讨论。提升MCP服务器搭建能力,将助你用AI创造新解决方案,推动现代软件项目进步。

现在就行动起来,利用已有资源,将所学知识付诸实践。

模型上下文协议(MCP)是一种开放标准,使AI模型能够通过通用接口与外部工具、数据源和软件系统连接、交换数据并运行函数。

自行开发MCP服务器可以获得后端架构、协议设计和AI集成的实践经验。它可以帮助您自动化工作流程,将AI代理连接到生产力应用,并尝试新的集成方法。

您可以使用任何编程语言。常用选择包括Python、JavaScript(Node.js)和C#,可根据您的熟悉程度和可用的Web服务器及协议处理库选择。

MCP服务器由核心服务器应用、工具/资源模块、协议消息通信处理器,以及用于连接客户端和AI模型的集成接口组成。

您可以使用MCP Inspector、Postman或cURL等工具测试MCP服务器。使用自动化测试框架、详细日志和调试器,确保协议合规性并定位问题。

可以,MCP服务器可以使用Google Cloud Run、AWS或Azure等云服务部署,实现可扩展和可靠的远程访问。

将新工具作为模块化函数或微服务添加,按照协议注册,并通过安全接口和最佳实践(如沙箱和身份验证)连接外部AI模型API。

探索全面的MCP服务器示例,学习如何构建、部署和集成模型上下文协议(MCP)服务器,以提升AI代理在企业系统中的能力。...

学习如何开发能够无缝集成 OpenAI API 的模型上下文协议(MCP)服务器,实现强大的 AI 驱动工具执行与智能自动化。

了解 MCP(模型上下文协议)服务器是什么、如何工作,以及它们为何正在革新 AI 集成。探索 MCP 如何简化 AI 智能体与工具、数据源和 API 的连接。...

Cookie 同意

我们使用 cookie 来增强您的浏览体验并分析我们的流量。 See our privacy policy.