OpenCV

OpenCV 是一个先进的开源计算机视觉与机器学习库,提供 2500 多种图像处理、目标检测和实时应用的算法,支持多种语言和平台。...

Wan 2.1是阿里巴巴推出的强大开源AI视频生成模型,可将文本或图片转化为工作室级别的视频,人人皆可本地免费使用。

Wan 2.1(又称WanX 2.1)是由阿里巴巴通义实验室开发的完全开源AI视频生成模型,开创了新纪元。不像许多需要高昂订阅或API访问的专有视频生成系统,Wan 2.1在免费开放的同时,输出质量媲美甚至优于同类商业产品,任何开发者、研究者及创意人士都能轻松使用。

Wan 2.1真正特别之处在于其兼顾易用性和高性能。较小的T2V-1.3B版本仅需约8.2GB显存,大多数主流消费级GPU均可运行。大参数量的14B版本则带来行业领先的表现,在标准基准上超越开源和众多商业模型。

Wan 2.1不仅限于文生视频,其多元架构支持:

这种灵活性意味着你可以用文本、单帧图片,甚至现有视频作为起点,自由变换,实现创意愿景。

Wan 2.1是首个能在生成视频中渲染可读英文和中文文本的模型,为国际创作者带来全新可能。此功能尤适用于多语言视频中的字幕或场景文字制作。

Wan 2.1高效性的核心是其3D因果视频变分自编码器(VAE)。这项技术突破使模型能够:

1.3B小模型仅需8.19GB显存,在RTX 4090上大约4分钟即可生成5秒480p视频。高效的同时,画质不输乃至超越许多大模型,实现了速度与画质的最佳平衡。

在公开评测中,Wan 14B在Wan-Bench测试中总体得分最高,优于其他模型,表现突出于:

Wan 2.1不同于OpenAI的Sora或Runway的Gen-2等闭源系统,用户可完全本地运行。它整体上超越了早期开源模型(如CogVideo、MAKE-A-VIDEO和Pika),并在质量基准上领先众多商业产品。

近期行业调查指出,“在众多AI视频模型中,Wan 2.1与Sora最为突出”——Wan 2.1胜在开放与高效,Sora则以专有创新见长。在社区测试中,Wan 2.1的图生视频能力在清晰度和电影感方面优于竞品。

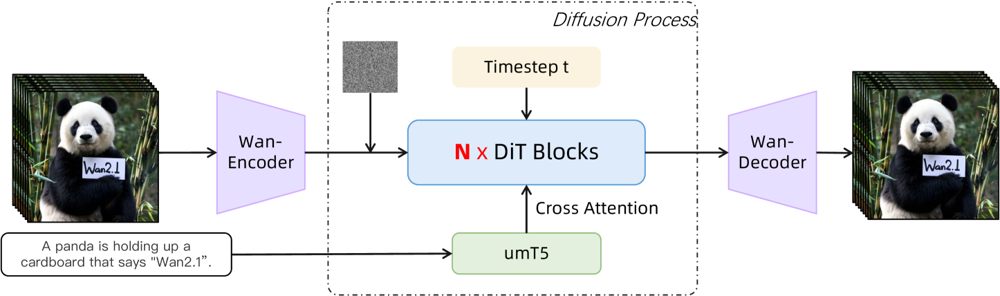

Wan 2.1以扩散-Transformer为主干,结合创新的时空VAE,整体流程如下:

图示: Wan 2.1的高层架构(以文生视频为例)。视频(或图片)首先由Wan-VAE编码器编码为潜在变量。该潜在变量经过N个扩散Transformer模块处理,模块通过交叉注意力关注umT5生成的文本嵌入。最后,Wan-VAE解码器重建视频帧。此设计(“3D因果VAE编码器/解码器包裹扩散Transformer” ar5iv.org)高效压缩时空信息,并支持高质量视频输出。

这种创新架构——“3D因果VAE编码器/解码器包裹扩散Transformer”——实现了时空数据的高效压缩,支持高质量视频生成。

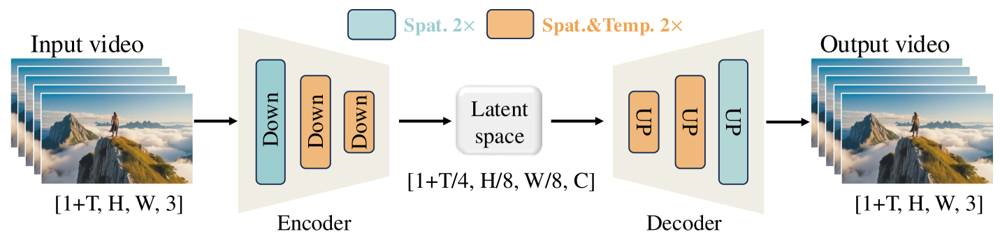

Wan-VAE专为视频设计,能以极高倍率(时间上4倍,空间上8倍)压缩输入为紧凑潜变量,再还原为完整视频。3D卷积和因果(保时)层保证生成内容的运动连贯。

图示: Wan 2.1的Wan-VAE框架(编码-解码)。Wan-VAE编码器(左)对输入视频(形状为[1+T, H, W, 3]帧)多次下采样(“Down”),直到得到紧凑的潜变量([1+T/4, H/8, W/8, C])。Wan-VAE解码器(右)对潜变量对称上采样(“UP”),还原为原始视频帧。蓝色块表示空间压缩,橙色块表示空间+时间联合压缩(ar5iv.org)。通过将视频在时空体积上压缩256倍,Wan-VAE让高分辨率视频建模变得可行。

想亲自体验Wan 2.1吗?操作指南如下:

克隆仓库并安装依赖:

git clone https://github.com/Wan-Video/Wan2.1.git

cd Wan2.1

pip install -r requirements.txt

下载模型权重:

pip install "huggingface_hub[cli]"

huggingface-cli login

huggingface-cli download Wan-AI/Wan2.1-T2V-14B --local-dir ./Wan2.1-T2V-14B

生成第一个视频:

python generate.py --task t2v-14B --size 1280*720 \

--ckpt_dir ./Wan2.1-T2V-14B \

--prompt "A futuristic city skyline at sunset, with flying cars zooming overhead."

--offload_model True --t5_cpu将部分模型转移到CPU运行--size参数控制宽高比(如832*480为16:9的480p)供参考,RTX 4090大约4分钟可生成5秒480p视频。多GPU和多种性能优化(如FSDP、量化等)也支持大规模应用。

作为挑战AI视频生成巨头的开源利器,Wan 2.1极大提升了技术可及性。免费开源意味着只要配有适配GPU,任何人都能探索前沿视频生成,无需订阅或API费用。

对开发者而言,开源许可支持深度定制和二次开发;研究者可拓展其能力;创意人士可以高效原型化视频内容。

在越来越多专有AI模型被高墙封闭的时代,Wan 2.1证明了最前沿的性能也可以被大众共享和民主化。

Wan 2.1是由阿里巴巴通义实验室开发的完全开源AI视频生成模型,能够根据文本提示、图片或现有视频生成高质量视频。它免费开放,支持多种任务,并能高效运行于消费级GPU上。

Wan 2.1支持多任务视频生成(文生视频、图生视频、视频编辑等)、多语言视频文本渲染、采用3D因果Video VAE实现高效能,并在基准测试中超越许多商业和开源模型。

您需要Python 3.8+、支持CUDA的PyTorch 2.4.0+,以及NVIDIA GPU(小模型需8GB+显存,大模型需16-24GB)。克隆GitHub仓库,安装依赖,下载模型权重,然后用提供的脚本在本地生成视频。

Wan 2.1以开源和免费的方式,让最前沿的视频生成技术触手可及,开发者、研究者和创意人士都能自由探索和创新,无需付费墙或专有限制。

与Sora或Runway Gen-2等闭源模型不同,Wan 2.1完全开源且可本地运行。它通常优于以往开源模型,并在质量基准上可与许多商业方案媲美甚至超越。

阿尔西亚是 FlowHunt 的一名 AI 工作流程工程师。拥有计算机科学背景并热衷于人工智能,他专注于创建高效的工作流程,将 AI 工具整合到日常任务中,从而提升生产力和创造力。

OpenCV 是一个先进的开源计算机视觉与机器学习库,提供 2500 多种图像处理、目标检测和实时应用的算法,支持多种语言和平台。...

FlowHunt v2.19.14 带来了 OpenAI 的 GPT-4.1 模型、来自 Stable Diffusion、Google 和 Ideogram 的 9 款全新图像生成模型,以及 HubSpot 集成,助力流程自动化更高效。...

将 FlowHunt 与 WavespeedMCP 集成,实现先进的 AI 图像与视频生成自动化工作流。通过强大的模型控制协议(MCP)服务器集成,解锁文本转图像、图像转图像和视频创建,支持创意自动化、安全配置和可扩展的媒体输出。...