什么是 LLM DeepSeek 组件?

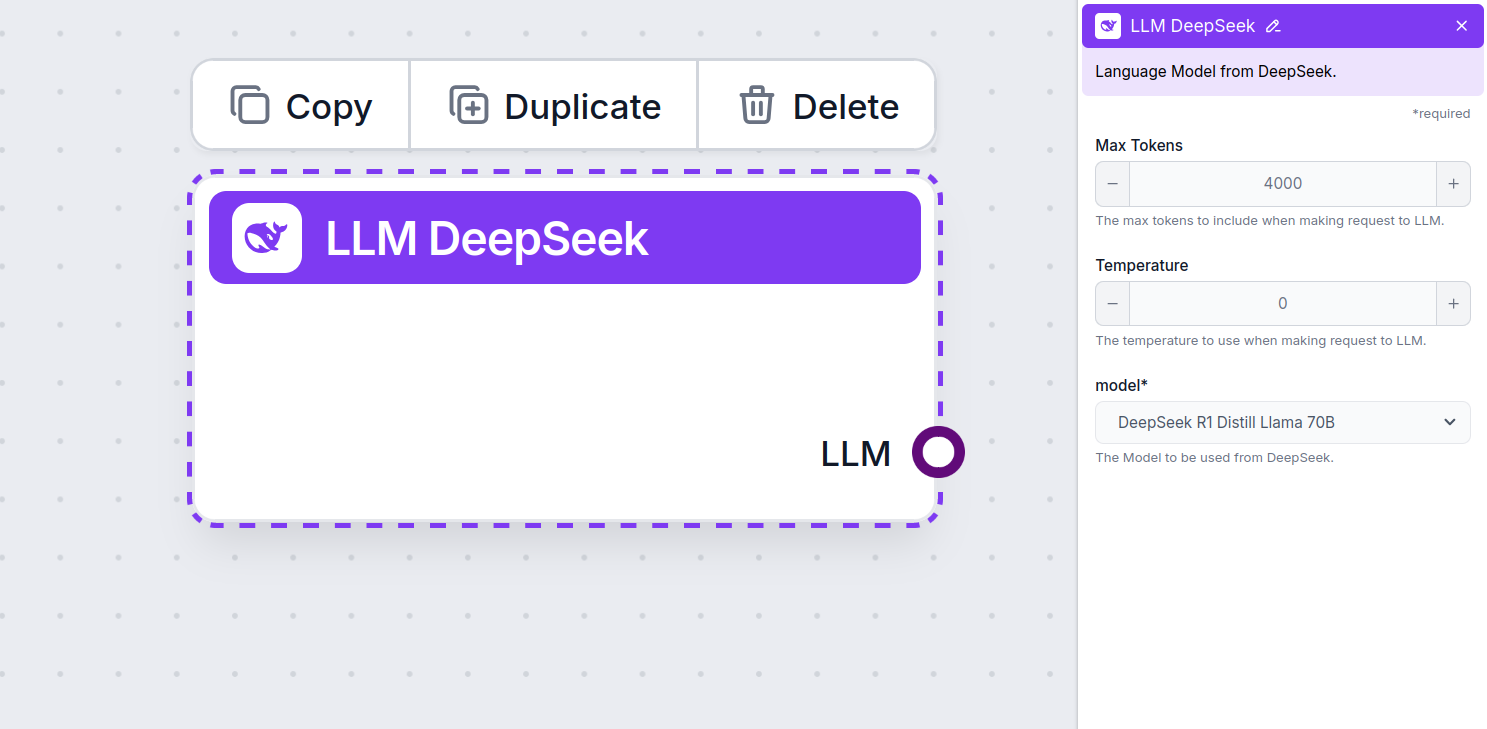

LLM DeepSeek 组件将 DeepSeek 模型连接到您的 Flow。虽然内容生成器和智能体(Agent)才是实际生成内容的地方,但 LLM 组件允许您切换和控制所用的模型。

请记住,连接 LLM 组件是可选的。所有使用 LLM 的组件默认都采用 ChatGPT-4o。LLM 组件让您可以更换模型并控制模型设置。

LLM Gemini 组件设置

最大 tokens

token 代表模型处理和生成文本的最小单位。不同模型的 token 使用量各不相同,一个 token 可以是单词、子词甚至单个字符。模型通常按百万 token 定价。

最大 tokens 设置限制了单次交互或请求中可处理的总 token 数,确保回复内容在合理范围内生成。默认上限为 4,000 tokens,是总结文档和多个来源生成答案的最佳规模。

Temperature

Temperature 控制答案的多样性,范围从 0 到 1。

0.1 的 temperature 会让回答非常直接,但可能重复且内容贫乏。

1 的高 temperature 会让回答极具创造力,但也有可能出现无关甚至臆造内容。

例如,推荐客户服务机器人采用 0.2 到 0.5 的 temperature。这样既能保证答案相关且按脚本执行,又能保留自然的回答变化。

模型

这里是模型选择器。您可以在此找到所有受支持的 DeepSeek 模型。我们支持所有最新的 Gemini 系列模型:

- DeepSeek R1: 这是一款于 2025 年初风靡全球的中文轻量级开源模型。目前它是速度最快、性能最优的 DeepSeek 模型,轻松超越 OpenAI 的 o1 模型。

如何将 LLM DeepSeek 添加到您的 Flow

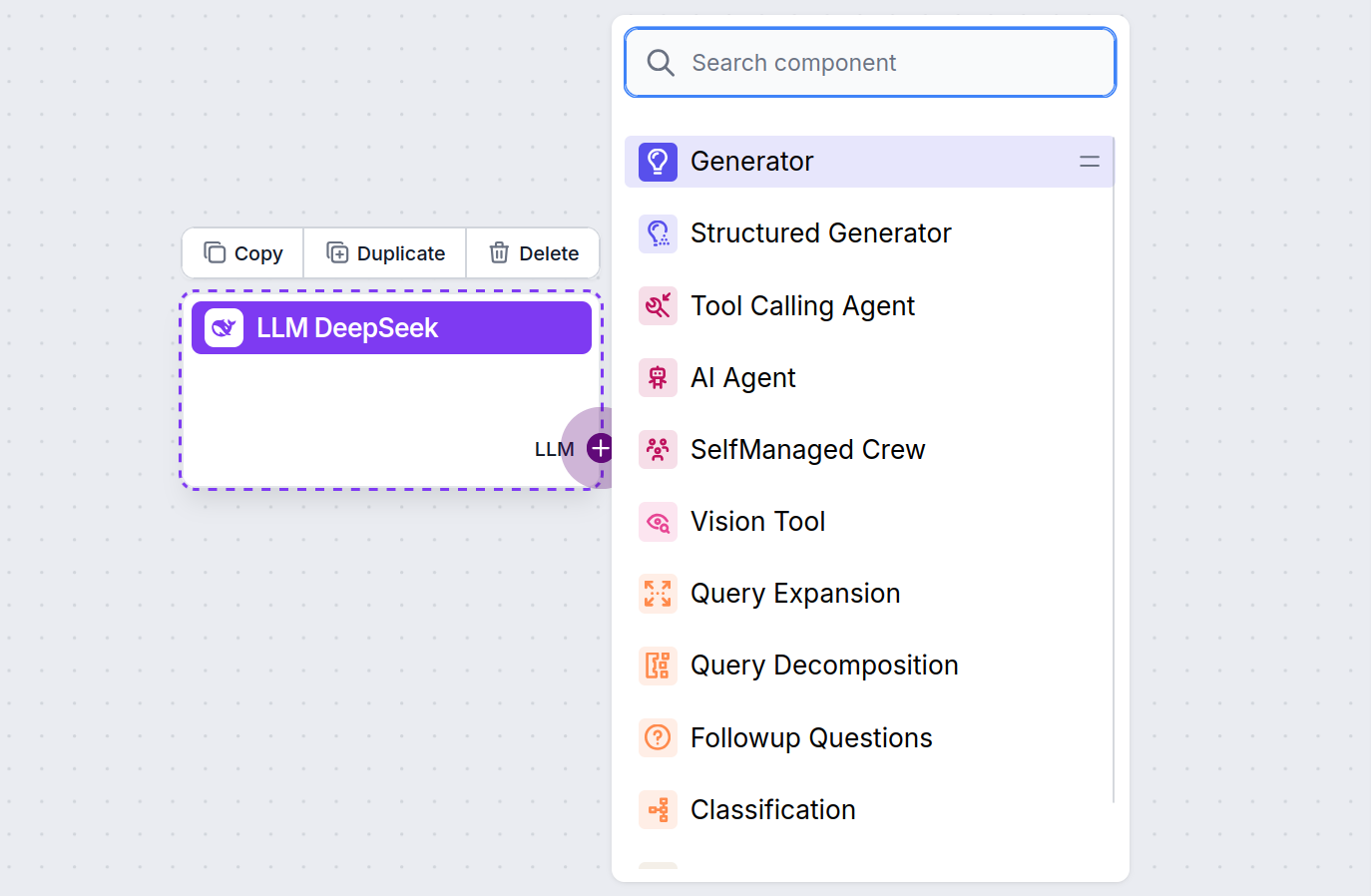

您会注意到,所有 LLM 组件只有输出端口。输入不会经过该组件,因为它仅代表模型,实际内容生成发生在 AI Agent 和 Generator 中。

LLM 端口总是紫色。所有使用 AI 生成文本或处理数据的组件上都能找到 LLM 输入端口。点击端口即可看到选项:

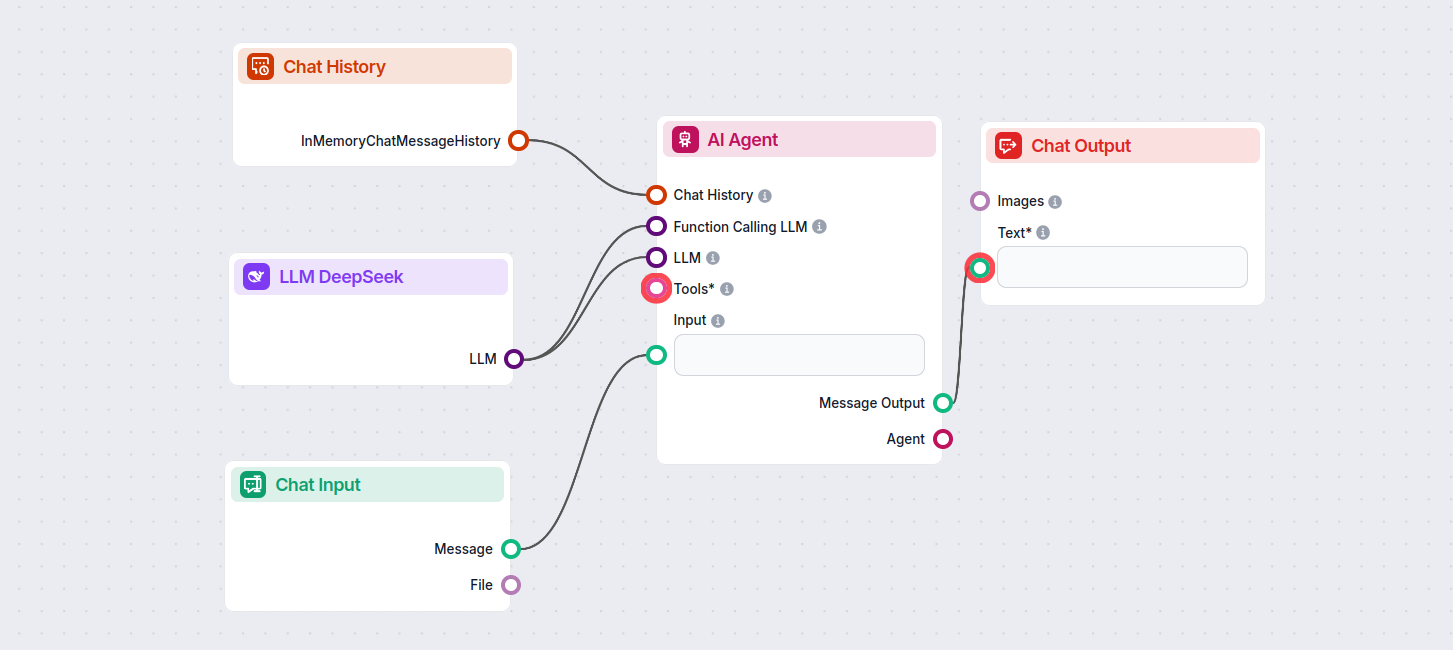

这让您可以打造各种工具。让我们看看该组件的实际应用。以下是一个简单的 AI Agent 聊天机器人 Flow,使用 DeepSeek R1 来生成回复。您可以把它看作一个基础的 DeepSeek 聊天机器人。

该简单聊天机器人 Flow 包括:

- 聊天输入: 代表用户在聊天中发送的信息。

- 聊天历史: 确保聊天机器人能够记住并考虑以往的回复内容。

- 聊天输出: 代表聊天机器人的最终回复。

- AI Agent: 用于生成回复的自主 AI 智能体。

- LLM DeepSeek: 连接 DeepSeek 生成模型。