什么是 LLM xAI 组件?

LLM xAI 组件可以将 Grok 模型连接到您的流程中。虽然实际的“魔法”发生在 Generator 和 Agent 之中,但 LLM 组件允许您控制所用的模型。所有组件默认都配备 ChatGPT-4。您可以在需要更换模型或获得更多控制权时,连接此组件。

请记住,连接 LLM 组件是可选的。所有使用 LLM 的组件默认都采用 ChatGPT-4o。LLM 组件允许您更换模型并控制模型设置。

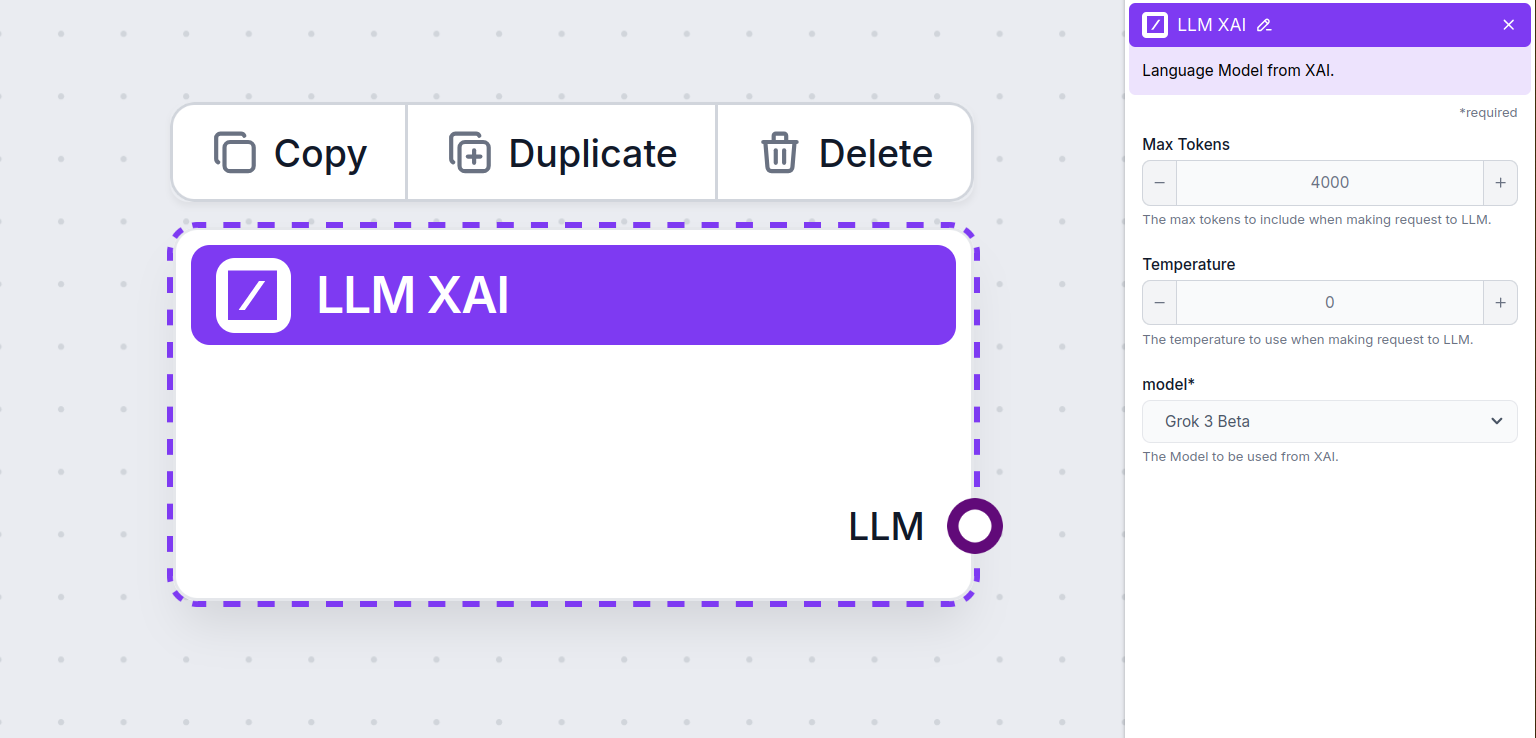

LLM xAI 组件设置

最大 Tokens

Token 代表模型处理和生成的最小文本单元。每种模型的 token 用法各不相同,一个 token 可能是一个单词、子词,甚至单个字符。模型通常以百万 tokens 计价。

最大 tokens 设置限制每次交互或请求能处理的总 tokens 数,确保生成的回复在合理范围内。默认上限为 4,000 个 tokens,这也是用于文档和多来源摘要生成答案的最佳大小。

Temperature

Temperature 控制回答的多样性,范围从 0 到 1。

0.1 的 temperature 会让回复非常简明,但可能重复且不够丰富。

而 1 的高 temperature 则允许生成最大创意的回答,但也有可能产生无关甚至“幻觉”内容。

例如,客服机器人的建议 temperature 是 0.2 到 0.5。该范围内回复既相关、规范,又保留自然的变化。

模型

这是模型选择器。在这里,您能看到所有来自 xAI 提供商支持的模型。xAI 的旗舰文本模型名为 Grok。目前我们仅支持 grok-beta 模型,因为这是唯一对外开放 API 的模型。

想了解更多 Grok-beta 的信息及其与其他模型的对比?请查看相关文章。

如何将 LLM xAI 添加到您的流程中

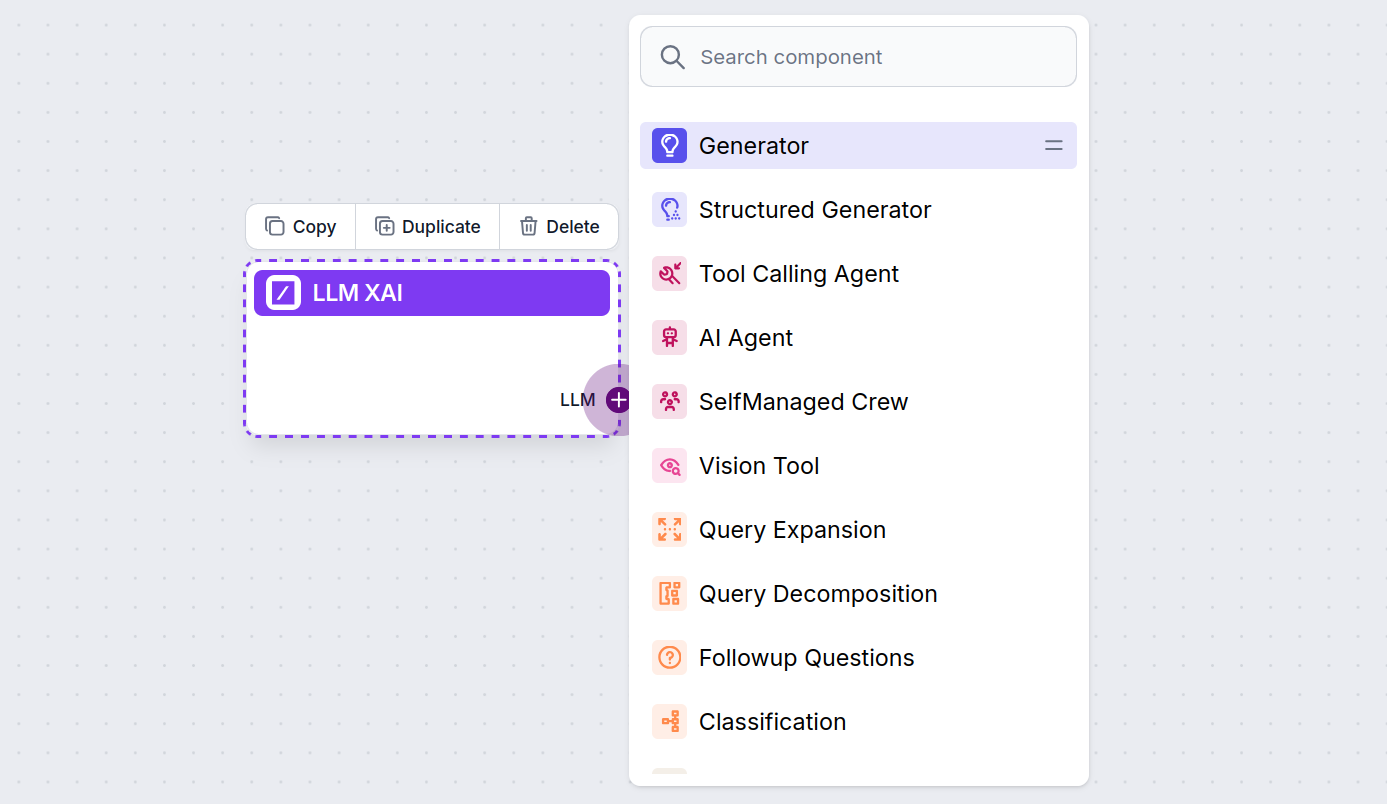

您会注意到,所有 LLM 组件仅有输出端口。输入不会经过该组件,因为它只代表模型,实际的生成发生在 AI Agent 和 Generator 中。

LLM 端口始终是紫色。任何用 AI 生成文本或处理数据的组件都可以找到 LLM 输入端口。点击端口即可查看选项:

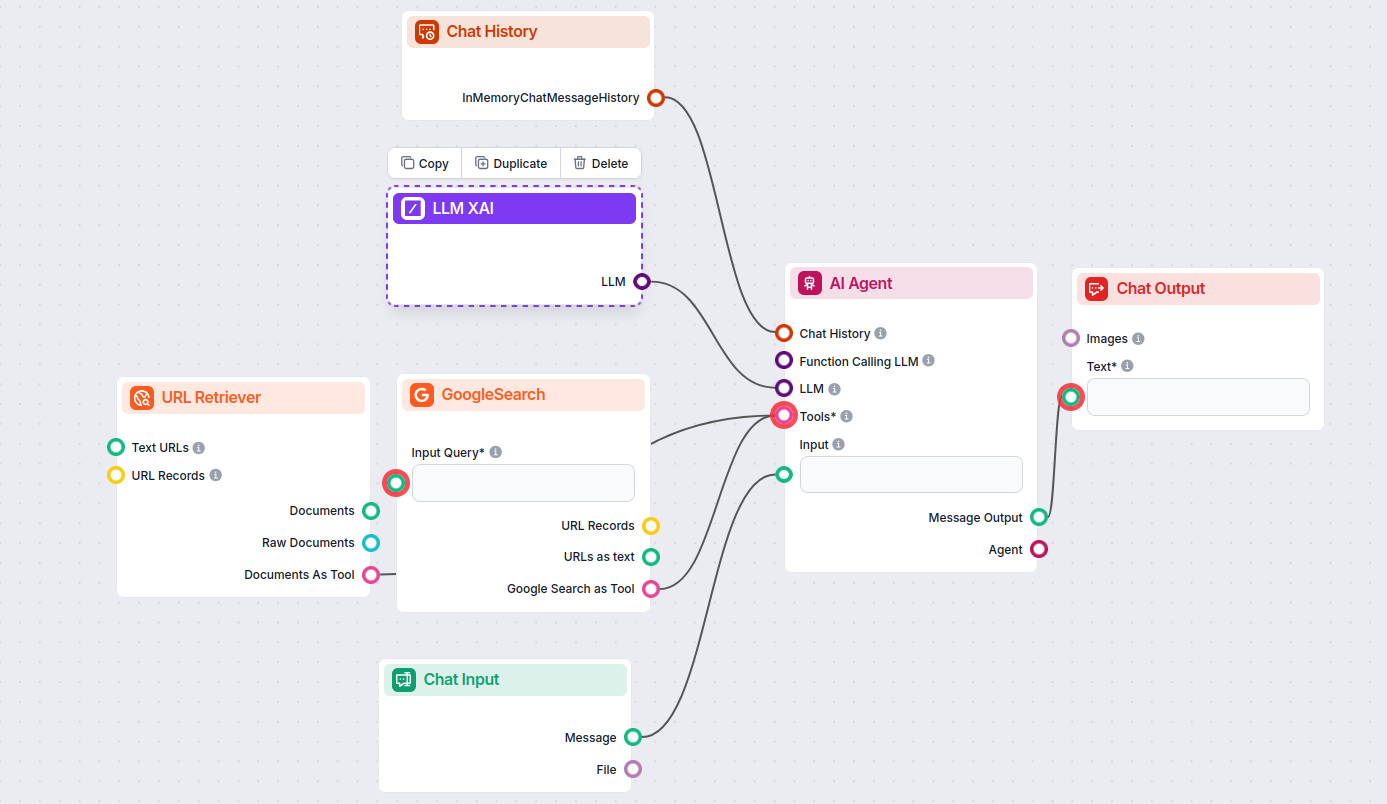

这样,您就可以创建各种工具。让我们看看该组件的实际应用。以下是一个简单的 AI Agent 聊天机器人流程,使用 xAI 的 grok-beta 生成回复。您可以将它视为基础版的 xAI 聊天机器人。

该简单聊天机器人流程包含:

- 聊天输入:代表用户在对话中发送的消息。

- 聊天历史:确保机器人能记住并考虑以往回答。

- 聊天输出:代表机器人的最终回复。

- AI Agent:自动生成回复的 AI 智能体。

- LLM xAI:连接 xAI 文本生成模型的组件。