跳过内容索引

通过 FlowHunt 的跳过索引功能提升您的 AI 聊天机器人的准确性。排除不适合的内容,确保互动相关且安全。使用 flowhunt-skip 类控制哪些内容被索引,提升机器人可靠性和性能。...

AI机器人屏蔽是指防止AI驱动的机器人访问和抓取网站数据的做法。通常通过使用robots.txt文件实现,该文件为网络爬虫提供了允许访问网站哪些部分的指令。

屏蔽AI机器人对于保护敏感网站数据、维护内容原创性、以及防止内容被用于AI训练等用途至关重要。它有助于保持网站内容的完整性,并防范潜在的隐私问题和数据滥用。

什么是robots.txt?

Robots.txt是网站用于与网络爬虫和机器人沟通的文本文件。它指示这些自动化程序可爬取和索引网站的哪些区域。

功能:

实施方法:

网站应将robots.txt文件放置在根目录,确保可通过如下URL访问:https://example.com/robots.txt

文件语法包括指定user-agent后,使用“Disallow”禁止访问,或用“Allow”允许访问。

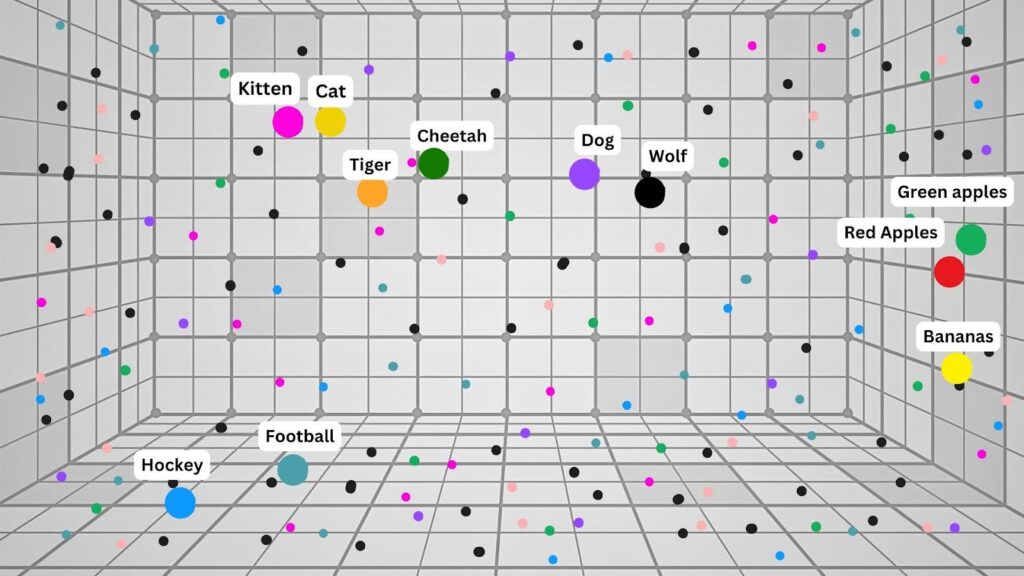

AI助手

AI数据爬取器

AI搜索爬虫

| 机器人名称 | 描述 | 屏蔽方法(robots.txt) |

|---|---|---|

| GPTBot | OpenAI的数据收集机器人 | User-agent: GPTBot Disallow: / |

| Bytespider | 字节跳动的数据爬取器 | User-agent: Bytespider Disallow: / |

| OAI-SearchBot | OpenAI的搜索索引机器人 | User-agent: OAI-SearchBot Disallow: / |

| Google-Extended | Google的AI训练数据机器人 | User-agent: Google-Extended Disallow: / |

内容保护:

屏蔽机器人有助于防止网站原创内容未经许可被用于AI训练数据集,从而维护知识产权。

隐私问题:

通过控制机器人访问,网站可以降低数据隐私和未经授权数据采集的风险。

SEO考量:

虽然屏蔽机器人可以保护内容,但也可能影响网站在AI驱动搜索引擎中的可见性,减少流量和曝光机会。

法律与伦理层面:

此做法引发了关于数据所有权和AI公司合理使用网络内容的问题。网站需在保护内容与利用AI驱动搜索带来潜在益处之间取得平衡。

AI机器人屏蔽是指通过robots.txt文件中的指令,防止AI驱动的机器人访问和抓取网站数据的行为。

屏蔽AI机器人有助于保护敏感数据,保持内容的原创性,防止内容被用于AI训练,以及保障隐私和知识产权。

在网站根目录放置robots.txt文件,通过指定user-agent和disallow指令,可以限制机器人访问特定页面或整个站点。

流行的AI机器人如GPTBot、Bytespider、OAI-SearchBot和Google-Extended等,都可以通过针对其user-agent名称的robots.txt指令进行屏蔽。

屏蔽AI机器人虽然能降低数据隐私风险,但可能会影响网站在AI驱动搜索引擎中的可见性,进而影响流量和曝光度。

通过 FlowHunt 的跳过索引功能提升您的 AI 聊天机器人的准确性。排除不适合的内容,确保互动相关且安全。使用 flowhunt-skip 类控制哪些内容被索引,提升机器人可靠性和性能。...

将 FlowHunt 与 Scrapling Fetch MCP 集成,使 AI 驱动的代理能够安全地从网站检索文本内容,绕过高级反爬虫检测,提取文档或参考数据,助力高级自动化与搜索流程。...

利用 FlowHunt 中的 AI 代理和工具调用代理,打造能够自动化任务、集成多种工具并提升用户交互体验的高级 AI 聊天机器人的指南。...