检索增强生成(RAG)

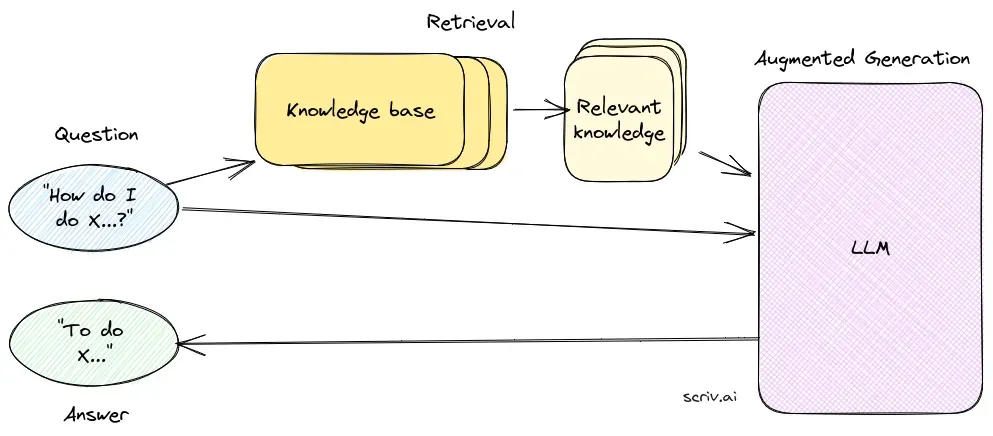

检索增强生成(RAG)是一种先进的人工智能框架,将传统的信息检索系统与生成式大语言模型(LLM)相结合,通过整合外部知识,使AI生成的文本更加准确、及时且具有上下文相关性。...

通过RAG的问答系统集成实时数据检索与自然语言生成,实现准确且具上下文相关性的回答,提升LLM能力。

基于检索增强生成(RAG)的问答系统通过集成实时外部数据,为回答提供准确且相关的信息,优化了语言模型在动态领域中的表现,并带来更高的准确性、动态内容和相关性提升。

基于检索增强生成(RAG)的问答系统是一种创新方法,结合了信息检索和自然语言生成的优势,可从数据中生成类人文本,提升AI、聊天机器人、报告生成和个性化体验。该混合模式通过从外部数据源检索到的相关、最新信息,为大语言模型(LLM)的回答提供补充。与仅依赖预训练模型的传统方法不同,RAG能够动态整合外部数据,使系统在需要最新信息或专业知识的领域提供更准确、具备上下文的答案。

RAG通过确保答案不仅来自内部数据集,还依赖于实时权威来源,优化了LLM的表现。这对于信息不断变化的动态领域中的问答任务至关重要。

检索组件负责从大量数据集中获取相关信息,通常存储于向量数据库。此组件采用语义搜索技术,识别并提取与用户查询高度相关的文本片段或文档。

生成组件通常为如GPT-3或BERT等LLM,通过结合用户原始问题与检索到的上下文来综合生成答案。该组件对生成连贯且具备上下文的回答至关重要。

实现RAG系统涉及多个技术步骤:

基于检索增强生成(RAG)的问答系统研究

检索增强生成(RAG)通过结合检索机制和生成模型,提升了问答系统的能力。近期研究在不同场景下探索了RAG的效果与优化方法。

RAG是一种结合信息检索和自然语言生成的方法,通过整合外部数据源到大语言模型中,提供准确、最新的答案。

RAG系统由检索组件和生成组件组成。检索组件通过语义搜索从向量数据库中获取相关信息,生成组件(通常为LLM)则结合用户问题和检索到的上下文来综合生成答案。

RAG通过检索上下文相关信息提升准确性,支持从外部知识库动态更新内容,并增强生成回答的相关性和质量。

常见应用包括AI聊天机器人、客户支持、自动化内容生成以及需要准确、具备上下文和时效性的教育工具。

RAG系统可能资源消耗较大,需要精心集成以获得最佳性能,并且必须确保检索信息的事实准确性,以避免产生误导或过时的答案。

检索增强生成(RAG)是一种先进的人工智能框架,将传统的信息检索系统与生成式大语言模型(LLM)相结合,通过整合外部知识,使AI生成的文本更加准确、及时且具有上下文相关性。...

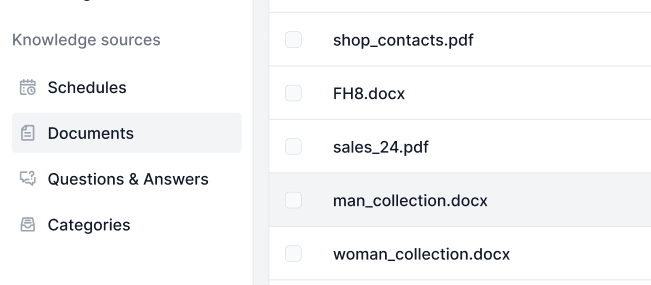

知识源让根据您的需求教会 AI 变得轻而易举。探索在 FlowHunt 中链接知识的所有方式。轻松连接网站、文档和视频,提升您的 AI 聊天机器人的表现。...

探索人工智能中检索增强生成(RAG)与缓存增强生成(CAG)的关键区别。了解RAG如何动态检索实时信息以实现灵活、准确的响应,而CAG则利用预缓存数据实现快速一致的输出。找出哪种方法更适合您的项目需求,并探讨实际应用场景、优势与局限性。...