精通Stable Diffusion模型提示词:全面指南

精通Stable Diffusion模型提示词,打造高质量AI生成图像。学习如何通过主题、风格和分辨率等关键要素,撰写有效提示词。探索迭代构建、负面提示词、关键词融合等技术,实现最佳效果。...

稳定扩散是一款领先的文本到图像AI模型,用户可通过高级潜变量扩散与深度学习技术,根据提示生成照片级视觉图像。

稳定扩散是一种文本到图像的AI模型,通过深度学习根据描述生成高质量图像。它采用负面提示词和参考图片等技术,尤其在处理如手部等复杂元素时能获得更好效果。

稳定扩散是一款先进的文本到图像生成模型,采用深度学习技术,根据文本描述生成高质量、照片级真实感的图像。作为一种潜变量扩散模型,它代表了生成式人工智能领域的重要突破,将扩散模型与机器学习原理相结合,实现了对输入文本提示高度匹配的图像生成。

稳定扩散利用深度学习和扩散模型,通过逐步去除随机噪声生成连贯的视觉图像。尽管模型在数百万张图片上进行了大规模训练,但在处理如手部等复杂元素时仍有一定困难。随着数据集规模的持续扩大,这些问题正在逐渐减少,生成图像的质量也越来越逼真。

应对手部问题的一种有效方法是使用负面提示词。在提示中添加如 (-bad anatomy) 或 (-bad hands -unnatural hands) 这样的短语,可以引导AI避免生成扭曲的特征。注意不要过度使用负面提示词,否则可能会限制模型的创造力。

另一种技巧是使用参考图片来引导AI。只需在提示中添加 {image} 标签并链接参考图片,即可为AI提供准确绘制手部的视觉模板。对于保持正确的手部比例和姿势尤其有用。

想获得最佳效果,可以同时结合使用负面提示词和参考图片。这种双重方式既能避免常见错误,也能参考高质量范例。

(-bent fingers) 或 (realistic perspectives),以进一步提升手部质量。掌握这些方法后,你可以大幅提升稳定扩散作品中的手部表现,创作出媲美资深艺术家的佳作。收集参考图片,精心编写提示,见证你的AI艺术不断进化!

稳定扩散的核心机制是通过一系列计算过程将文本提示转化为可视化表现。理解其功能需涉及扩散模型、潜变量空间和神经网络等概念。

扩散模型是一类机器学习生成模型,通过逆转扩散过程来学习数据的生成。扩散过程是逐步向数据(如图像)加入噪声,直到无法分辨为止。模型学习如何逐步反向去噪,还原原始数据。这一逆扩散过程是从随机噪声生成全新、连贯数据的关键。

稳定扩散采用的是潜变量扩散模型。与直接在高维图像像素空间操作的传统扩散模型不同,潜变量扩散模型在压缩后的潜变量空间中运作。这个空间是对数据的低维表示,能保留关键特征并降低计算复杂度。通过在潜变量空间操作,稳定扩散能更高效地生成高分辨率图像。

稳定扩散的核心机制是在潜变量空间中进行逆扩散。模型从随机噪声的潜变量向量出发,逐步预测并移除噪声,细化潜变量表示。整个过程受到用户输入的文本描述引导,直到潜变量收敛,解码后生成与文本提示一致的图像。

稳定扩散的架构集成了多个关键组件,共同实现将文本提示转化为图像的功能。

VAE作为编码-解码系统,将图像压缩到潜变量空间再还原为图像。编码器将图像转为潜变量表示,提取其核心特征;解码器则将潜变量还原为细致图像。

这一过程至关重要,因为它让模型能处理低维数据,显著降低了与像素空间直接运算相比的资源消耗。

U-Net是一种专用于图像处理的神经网络结构,在稳定扩散中用于噪声预测。它包含编码路径与解码路径,且在对称层之间有跳跃连接。在稳定扩散中,U-Net作为逆扩散过程中的噪声预测器。

在扩散过程的每一步,U-Net预测当前潜变量中的噪声量,并利用该预测值对潜变量进行去噪,逐步生成与文本提示相符的图像。

为了融入文本信息,稳定扩散采用基于CLIP(对比语言-图像预训练)的文本编码器。CLIP能理解和关联文本与视觉信息,并将其映射到共享的潜变量空间。

当用户输入文本提示,文本编码器将其转为一组嵌入(文本数据的数值化表示)。这些嵌入在逆扩散过程中对U-Net进行条件控制,引导图像生成内容与文本一致。

稳定扩散在图像生成方面非常灵活,可根据用户需求以多种方式应用。

稳定扩散的主要用途是根据文本提示生成图像。用户输入描述性文本,模型输出对应的图像。例如,输入“夕阳下椰树环抱的宁静海滩”,即可获得对应场景的图片。

该功能对创意行业、内容创作和设计领域尤为有价值,能快速实现概念可视化。

除了从零生成图像,稳定扩散还可以根据文本指令修改已有图片。只需提供初始图像和文本提示,模型即可生成包含指定变化的新图片。

比如,用户上传一张白天城市风光图,并输入提示“变为夜晚且有霓虹灯”,即可获得相应夜景图像。

修复(Inpainting)即填补图片缺失或损坏部分。稳定扩散在这方面表现突出,用户只需用文本提示描述需修复区域内容即可。可对图片部分区域进行遮罩,并指定内容补全。

该功能适用于照片修复、移除不需要的物体或局部元素调整,同时保持整体连贯性。

通过生成一系列略有变化的图像,稳定扩散可以扩展到动画或视频内容的制作。Deforum等工具进一步提升了稳定扩散的动态视觉内容生成能力,支持基于文本提示的动画序列。

这为动画、视觉特效和动态内容生成带来新可能,无需传统逐帧动画技术。

稳定扩散根据文本描述生成图片的能力,使其成为AI自动化与聊天机器人开发的强大工具。

将稳定扩散集成到聊天机器人中,能实时根据用户问题生成视觉内容。例如在客户服务场景下,机器人可即时生成操作指南或说明图。

文本提示经CLIP文本编码器转为嵌入,这些嵌入在图像生成过程中起核心条件作用,确保输出图片与用户描述一致。

逆扩散是反复对潜变量去噪的过程。每一步模型都会结合文本嵌入和当前潜变量,准确预测需去除的噪声成分。

模型对噪声图片的处理能力,源于其在大规模数据集上的训练,学会了有效区分和去除噪声。即使起始为随机噪声,也能生成清晰图片。

在潜变量空间操作更高效。因其维度远低于像素空间,各类运算资源消耗较低。这种效率让稳定扩散可以轻松生成高分辨率图像,无需过多计算资源。

艺术家和设计师可用稳定扩散快速实现概念可视化,助力创意流程,大幅缩短从想法到成品的时间。

营销团队可为活动、社交媒体和广告快速生成定制图片,无需大量美工资源。

游戏开发者可用描述性提示生成素材、场景和概念图,加快资源生产流程。

零售商可生成各种场景下的产品图片,提升商品可视化和客户体验。

教育者与内容创作者可用其生成插图和示意图,帮助解释复杂概念,让学习更易于理解。

人工智能与计算机视觉领域的研究者可用稳定扩散进一步探索扩散模型与潜变量空间的能力。

想高效使用稳定扩散,需注意以下技术条件:

想体验稳定扩散,可按以下步骤操作:

对于开发AI自动化系统和聊天机器人的开发者,稳定扩散可以集成以增强功能:

使用稳定扩散时需注意相关伦理问题:

稳定扩散是生成模型领域的一个重要研究方向,尤其在数据增强与图像合成方面应用广泛。近期研究涵盖了稳定扩散的多种应用与效果。

Fuxi Wen(2013)《α-稳定噪声环境下分布式估计的扩散最小均幂算法》:

提出了一种针对α-稳定噪声环境的分布式扩散最小均幂(LMP)算法。该研究将扩散LMP与扩散最小均方(LMS)算法进行比较,结果表明在α-稳定噪声下LMP方法表现更优。该成果对提升噪声环境下的鲁棒估计技术有重要意义。阅读原文

Boyang Deng(2024)《COCO与Weed数据集的数据增强中的稳定扩散》:

探讨了利用稳定扩散模型生成高分辨率合成图像以增强小数据集的方法。研究结合了图像到图像转换、Dreambooth与ControlNet等技术,评估了稳定扩散在分类和检测任务中的表现,显示出在多领域应用的前景。阅读原文

Aleksander Stanislavsky、Karina Weron、Aleksander Weron(2011)《受控于Tempered α-stable过程的扩散与弛豫》:

推导了利用Tempered α-stable过程实现的异常扩散和非指数弛豫特性,解决了α-stable随机操作时间中的无穷矩难题,提出了包含亚扩散为特例的统一模型。阅读原文

Andreas Stöckl(2022)《使用稳定扩散生成的合成图像数据集评估》:

评估了稳定扩散模型生成的合成图片,通过Wordnet分类体系考察了模型对不同概念的表现准确性。这些评估有助于理解稳定扩散在数据增强中的实际效果。阅读原文

Sanchayan Vivekananthan(2024)《生成模型对比分析:用VAE、GAN和稳定扩散提升图像合成》:

探索了VAE、GAN和稳定扩散三种生成框架的优劣。研究指出,虽然VAE和GAN各有优势,但在某些合成任务中,稳定扩散表现尤为突出。阅读原文

下面以Hugging Face Diffusers库为例,介绍如何在Python中实现稳定扩散模型。

安装所需库:

pip install torch transformers diffusers accelerate

pip install xformers # 可选

Diffusers库可方便加载预训练模型:

from diffusers import StableDiffusionPipeline

import torch

# 加载稳定扩散模型

model_id = "stabilityai/stable-diffusion-2-1"

pipe = StableDiffusionPipeline.from_pretrained(model_id, torch_dtype=torch.float16)

pipe = pipe.to("cuda") # 将模型移至GPU以加快推理速度

只需提供文本提示即可生成图片:

prompt = "A serene landscape with mountains and a lake, photorealistic, 8K resolution"

image = pipe(prompt).images[0]

# 保存或展示图片

image.save("generated_image.png")

model_id指定的预训练模型。torch.float16可降低显存消耗。你可以自定义多个参数:

image = pipe(

prompt=prompt,

num_inference_steps=50, # 去噪步数

guidance

稳定扩散是一种先进的AI模型,旨在通过文本提示生成高质量、照片级真实感的图像。它利用潜变量扩散与深度学习技术将文本描述转化为视觉内容。

稳定扩散通过CLIP文本编码器将文本提示转为图像嵌入,然后在提示词的引导下,对潜变量表示逐步去噪,最终输出连贯的图像。

稳定扩散可应用于创意内容生成、营销物料、游戏素材制作、电商产品可视化、教育插图以及AI驱动的聊天机器人等领域。

可以,稳定扩散支持图像到图像转换与修复(inpainting),用户可根据文本提示对已有图片进行修改或补全缺失部分。

建议使用配备现代GPU的计算机以高效生成图像。模型运行还需Python及如PyTorch和Diffusers等相关库。

是的,稳定扩散以宽松的开源协议发布,鼓励社区贡献、定制和广泛使用。

精通Stable Diffusion模型提示词,打造高质量AI生成图像。学习如何通过主题、风格和分辨率等关键要素,撰写有效提示词。探索迭代构建、负面提示词、关键词融合等技术,实现最佳效果。...

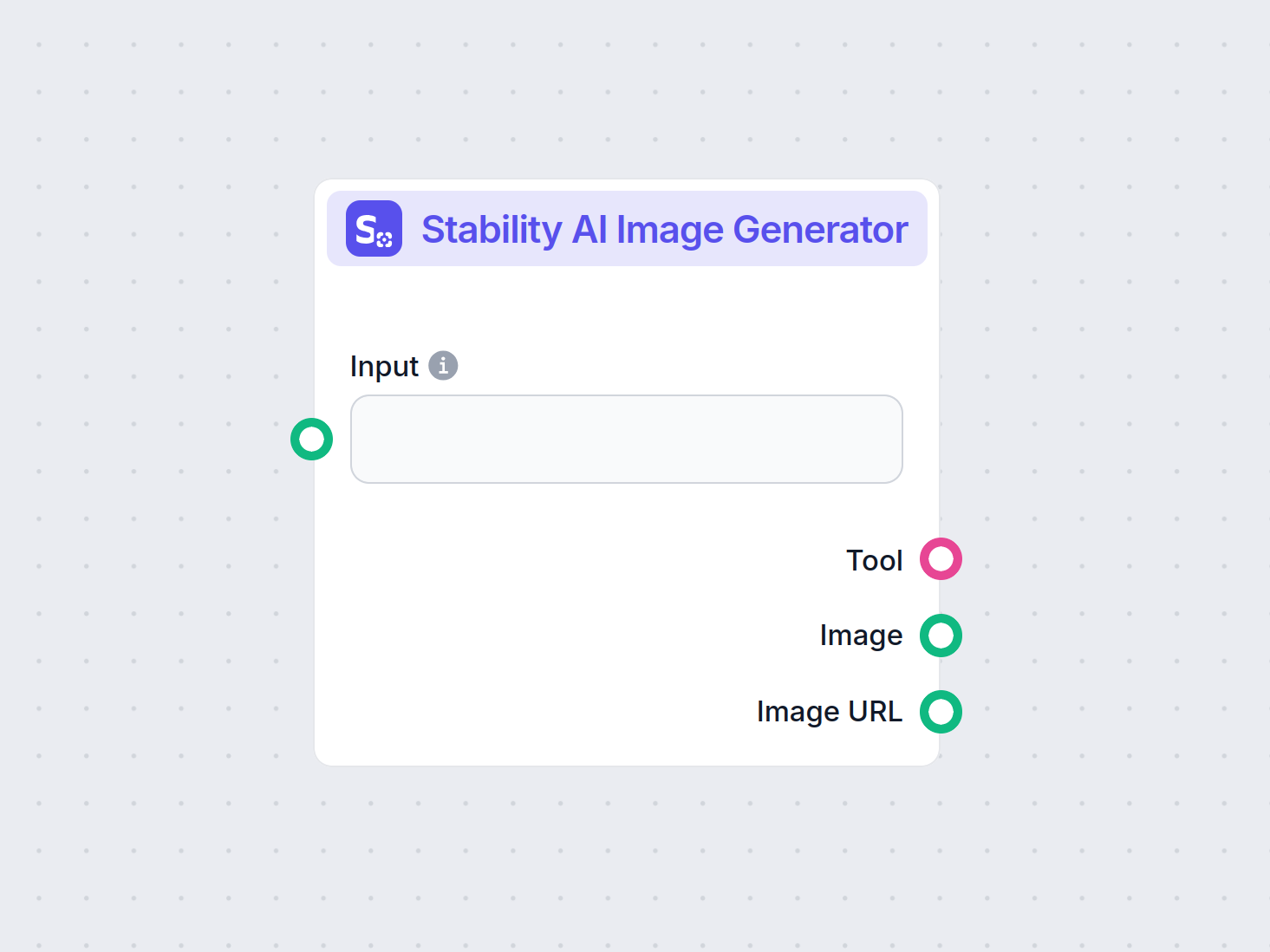

使用 Stability AI 图像生成器组件,通过文本提示生成高质量图像。该工具由 Stable Diffusion 模型驱动,提供图像尺寸、模型选择和 CFG 比例等可自定义设置,非常适合需要 AI 驱动图像创作的工作流。...

深入了解我们对 Stability AI SD3 Large 的评测。分析其在多样文本生成图像提示下的优劣势与创意输出,探索这款 AI 图像生成器的实际表现。...