变换器(Transformer)

变换器模型是一种专为处理序列数据(如文本、语音或时间序列数据)而设计的神经网络。与传统的循环神经网络(RNN)和卷积神经网络(CNN)不同,变换器利用注意力机制对输入序列中各元素的重要性进行加权,使其在自然语言处理、语音识别、基因组学等应用中表现出强大的性能。...

变换器是开创性的神经网络,利用自注意力机制实现并行数据处理,驱动BERT和GPT等模型在NLP、视觉等领域的应用。

变换器模型处理的第一步是将输入序列中的词或标记转换为数值向量,即嵌入。嵌入捕捉了语义信息,是模型理解词之间关系的关键。这种转化使模型能够以数学形式处理文本数据。

变换器本身不具备顺序处理能力,因此需要通过位置编码注入每个标记在序列中的位置信息。这对于保持序列顺序至关重要,特别是在像机器翻译这样语境依赖词序的任务中。

多头注意力机制是变换器的高级组件,使模型能够同时关注输入序列的不同部分。通过计算多个注意力分数,模型能够捕捉数据中的各种关系和依赖,增强理解和生成复杂数据模式的能力。

变换器通常采用编码器-解码器架构:

在注意力机制之后,数据会进入前馈神经网络,进行非线性变换,帮助模型学习复杂模式。这些网络进一步处理数据,以优化模型输出。

这些技术用于稳定和加速训练过程。层归一化确保输出在一定范围内,便于高效训练。残差连接让梯度在网络中顺畅流动,提升了深度神经网络的训练效果。

变换器适用于各种序列数据,如句子中的词或其他顺序信息。它们通过自注意力机制判断序列各部分之间的相关性,使模型聚焦于影响输出的关键元素。

在自注意力中,序列中的每个标记都会与其他所有标记进行比较,以计算注意力分数。这些分数反映了每个标记在当前上下文中的重要性,使模型能够关注序列中最相关的部分。这对于理解语言任务中的上下文和语义至关重要。

变换器块是模型的基本单元,由自注意力和前馈层组成。多个块叠加,形成能够捕捉数据复杂模式的深度学习模型。这种模块化设计让变换器可以高效扩展以应对不同任务的复杂性。

变换器能够一次性处理整个序列,远高于RNN和CNN的效率。这种高效性使其可以扩展到如GPT-3这类拥有1750亿参数的超大模型。变换器的可扩展性让它们能够高效处理海量数据。

传统模型由于顺序特性难以处理长距离依赖。变换器通过自注意力机制能同时考虑序列的所有部分,极大提升了对长文本上下文的理解能力。

最初设计用于NLP的变换器,如今已被应用于计算机视觉、蛋白质折叠、时间序列预测等众多领域。其广泛适应性展示了变换器在不同领域的巨大潜力。

变换器极大提升了翻译、摘要、情感分析等NLP任务的表现。BERT和GPT等模型利用变换器架构理解和生成类人文本,在NLP领域树立了新标杆。

在机器翻译中,变换器通过理解句中词语的上下文,实现比以往更准确的翻译。其一次性处理整句的能力带来更连贯、上下文相关的译文。

变换器能够对蛋白质的氨基酸序列建模,辅助预测蛋白质结构,这对药物开发和理解生物过程至关重要。这一应用凸显了变换器在科学研究中的潜力。

通过变换器架构,可以分析历史序列预测未来的数值,如电力需求预测等。这为金融、资源管理等领域带来了新的可能。

BERT模型通过同时关注词语的前后文,极大提升了对语句中词语关系的理解能力。这种双向性让BERT在理解上下文时远胜单向模型。

GPT模型是自回归的,通过预测序列中下一个词生成文本。它们广泛应用于文本补全、对话生成等场景,能够生成类人的自然语言。

最初用于NLP的变换器已扩展到计算机视觉任务。视觉变换器将图像数据视为序列,能够将变换器技术应用于视觉输入,推动了图像识别和处理的进步。

大规模变换器模型的训练需要大量计算资源,通常涉及庞大的数据集和高性能硬件(如GPU)。这在成本和可及性上对许多组织提出了挑战。

随着变换器的普及,AI模型偏见和生成式AI内容的伦理使用等问题愈发重要。研究者正致力于缓解这些问题,确保AI的负责任发展,强调AI伦理框架的重要性。

变换器的多样性不断开辟新的研究和应用领域,从提升AI聊天机器人到改进医疗、金融等数据分析。未来,变换器将在各行各业带来更多创新可能。

总之,变换器代表了AI技术的重要进步,在处理序列数据方面展现出无与伦比的能力。其创新架构和高效性为AI应用树立了新标准,推动了人工智能的飞跃发展。无论是语言理解、科学研究还是视觉数据处理,变换器都在不断重塑人工智能的可能性。

变换器彻底革新了人工智能领域,特别是在自然语言处理和理解方面。Denis Newman-Griffis于2024年发表的论文《AI思维:重新思考人工智能实践的框架》提出了一个名为“AI思维”的新概念框架。该框架建模了AI使用中涉及的关键决策和考量,涵盖了激发AI应用、制定AI方法以及将AI置于社会技术背景下的能力,旨在弥合学科间的鸿沟,重塑AI实践的未来。阅读全文。

另一项重要研究是Evangelos Katsamakas等人于2024年发表的《人工智能与高等教育机构变革》,利用复杂系统方法分析了AI在高等教育机构(HEIs)变革中的因果反馈机制。研究探讨了推动AI变革的力量及其对价值创造的影响,强调高校需适应AI技术进步,同时管理学术诚信和就业变化。阅读全文。

在软件开发领域,Mamdouh Alenezi及其同事于2022年发表的论文《人工智能能否变革DevOps?》探讨了AI与DevOps的交汇。研究指出,AI可提升DevOps流程功能,实现高效软件交付,对软件开发者和企业利用AI变革DevOps实践具有重要意义。阅读全文

变换器是一种于2017年提出的神经网络架构,利用自注意力机制并行处理序列数据。它们彻底革新了人工智能,尤其是在自然语言处理和计算机视觉领域。

与RNN和CNN不同,变换器利用自注意力机制同时处理序列的所有元素,提高了效率和可扩展性,并能捕捉长距离依赖关系。

变换器广泛应用于NLP任务,如翻译、摘要和情感分析,以及计算机视觉、蛋白质结构预测和时间序列预测等领域。

著名的变换器模型包括BERT(双向编码器表示)、GPT(生成式预训练变换器)以及用于图像处理的视觉变换器。

变换器在训练和部署时需要大量计算资源。同时,它们还涉及如AI模型潜在偏见和生成式AI内容负责任使用等伦理问题。

变换器模型是一种专为处理序列数据(如文本、语音或时间序列数据)而设计的神经网络。与传统的循环神经网络(RNN)和卷积神经网络(CNN)不同,变换器利用注意力机制对输入序列中各元素的重要性进行加权,使其在自然语言处理、语音识别、基因组学等应用中表现出强大的性能。...

生成式预训练变换器(GPT)是一种利用深度学习技术生成接近人类写作文本的人工智能模型。基于变换器架构,GPT采用自注意力机制实现高效文本处理与生成,彻底革新了内容创作、聊天机器人等自然语言处理(NLP)应用。...

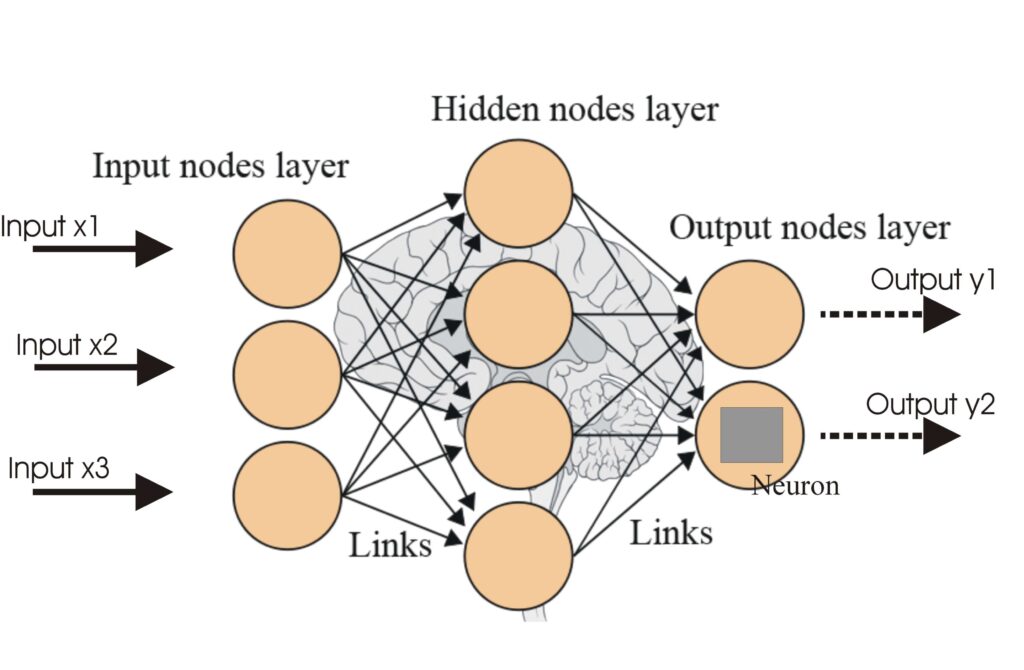

神经网络,或称人工神经网络(ANN),是一种受人脑启发的计算模型,是人工智能和机器学习中进行模式识别、决策制定以及深度学习应用等任务的核心技术。...