Langfuse MCP 服务器集成

Langfuse MCP 服务器通过模型上下文协议(Model Context Protocol),将 FlowHunt 及其它 AI 客户端连接到 Langfuse 提示词仓库,实现集中式提示词发现、检索和动态编译,从而简化 LLM 和智能体的工作流程。...

本文将介绍如何将 FlowHunt 与 Langfuse 连接,实现全面可观测性,追踪 AI 工作流表现,并利用 Langfuse 仪表盘监控和优化您的 FlowHunt 工作区。

随着您在 FlowHunt 中的 AI 工作流不断扩展,理解幕后发生了什么变得至关重要。例如:“为什么这个工作流很慢?”、“我消耗了多少 token?”、“错误发生在哪里?”等问题,都需要对系统有详细的可见性。

没有合适的可观测性,调试 AI 工作流就像盲飞——只能看到结果,看不到过程。像 Langfuse 这样的追踪工具能够捕捉工作流执行的每一步,为性能、成本和行为提供细致的洞察。

本文将介绍如何将 FlowHunt 与 Langfuse 无缝连接,实现对所有 AI 工作流的全面可观测性。您将学会追踪执行路径、监控 token 使用、定位瓶颈,并可视化性能指标——所有这些都可在一个集中式仪表盘中完成。

阅读完毕后,您将拥有对 FlowHunt 工作区的全面可见性,助您优化工作流、降低成本、保障可靠性。

可观测性 是通过外部输出(主要是追踪、指标和日志)对系统内部状态进行观测和分析的实践。

对于运行 AI 工作流的 FlowHunt 用户,可观测性可以带来以下可见性:

没有可观测性,问题诊断变得被动且耗时。有了可观测性,您能主动洞察,持续优化并快速排障。

Langfuse 是一款专为 LLM 应用打造的开源可观测性和分析平台。它能捕获 AI 工作流的详细追踪,为开发者和团队提供调试、监控和优化 AI 系统所需的洞察。

Langfuse 的主要特性包括:

将 Langfuse 连接到 FlowHunt 后,您可将原始执行数据转化为可操作的情报——明确什么有效、什么无效,以及优化的重点。

按照本指南,您将能够:

请按以下步骤启用 Langfuse 中的 FlowHunt 可观测性:

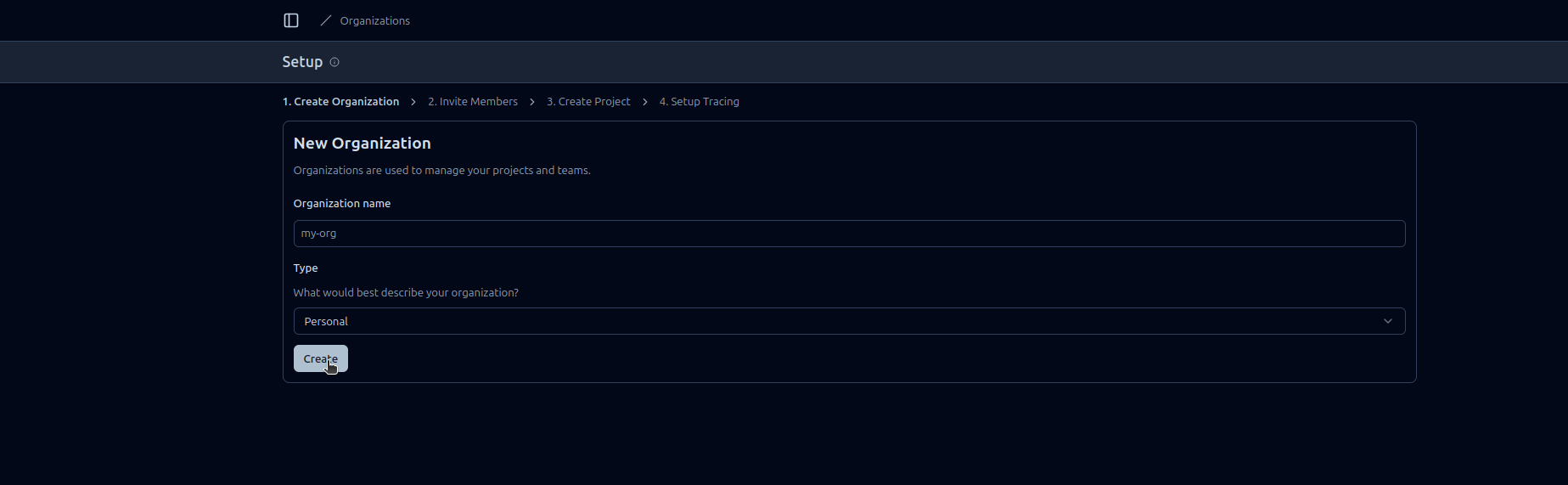

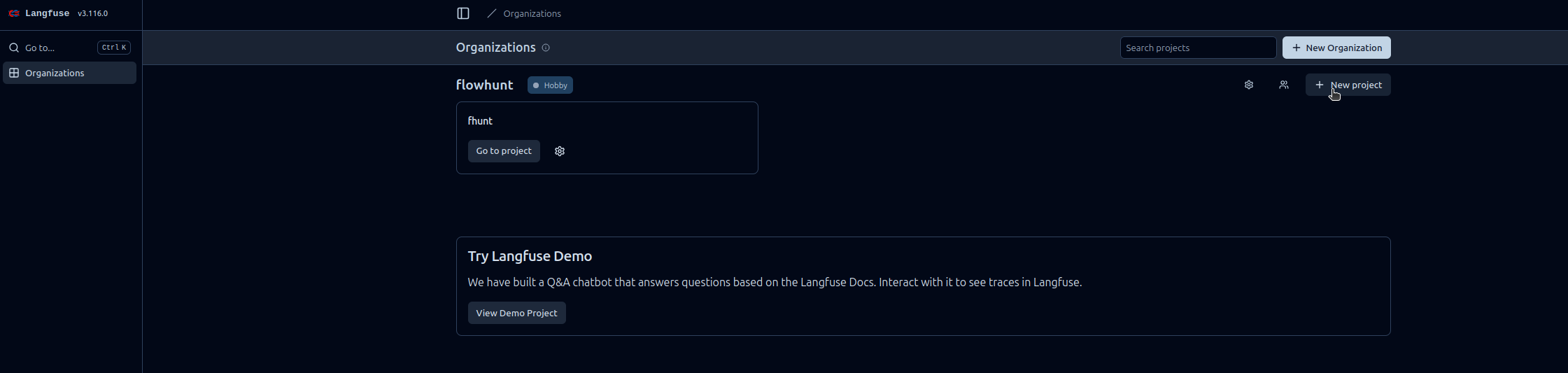

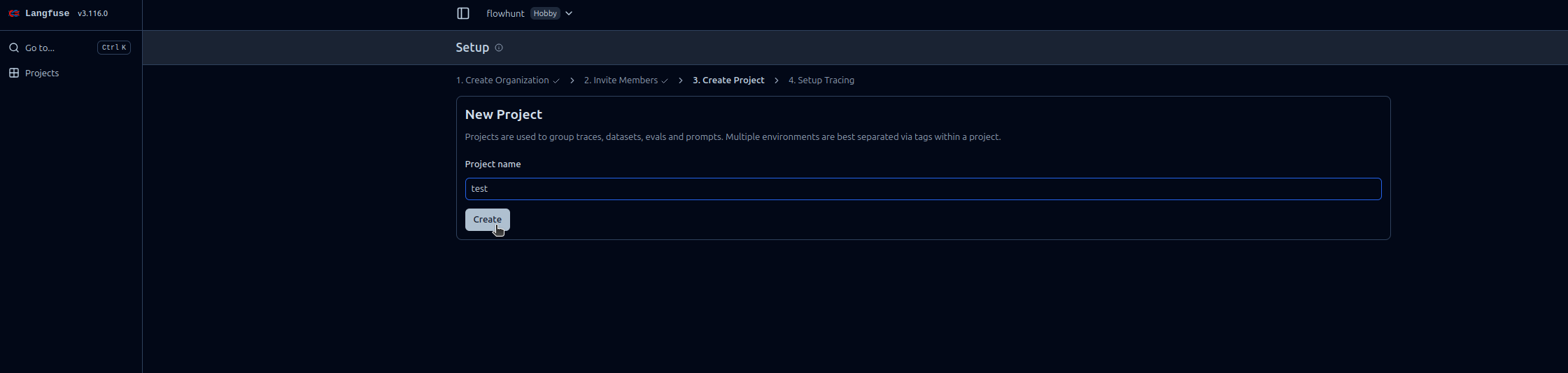

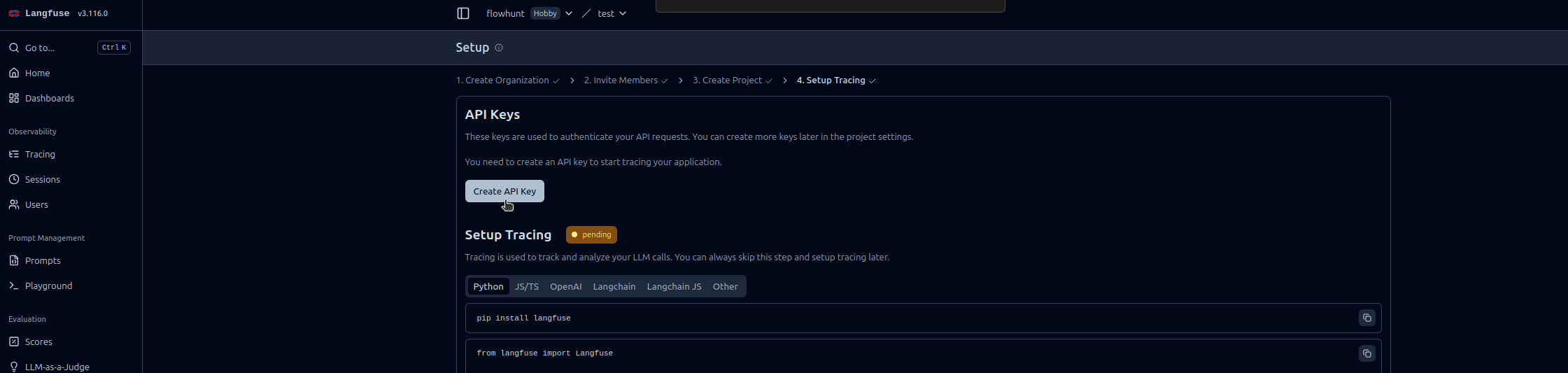

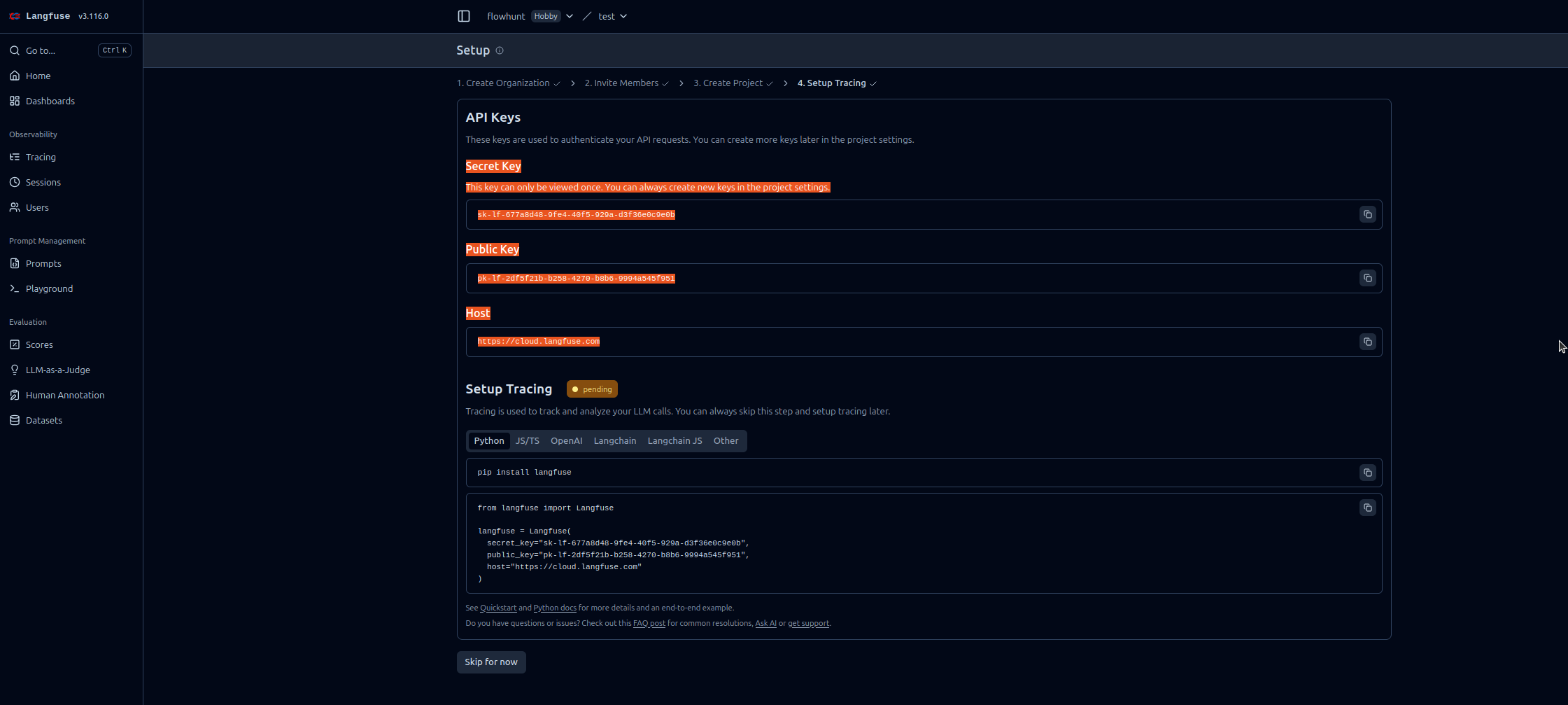

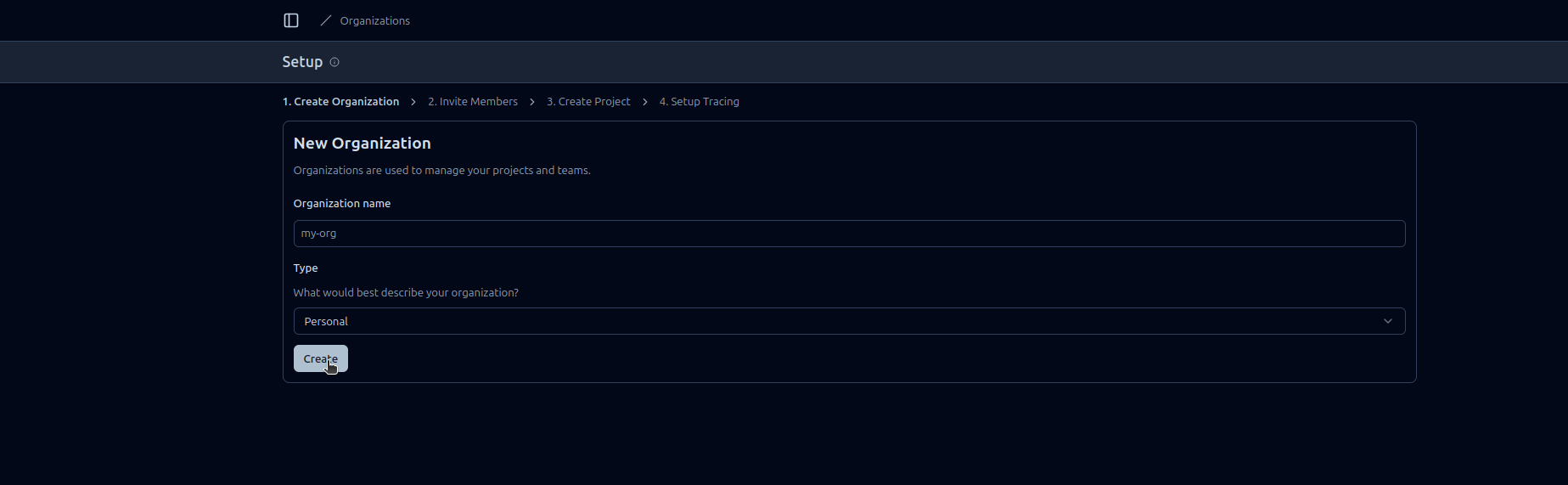

https://cloud.langfuse.com)

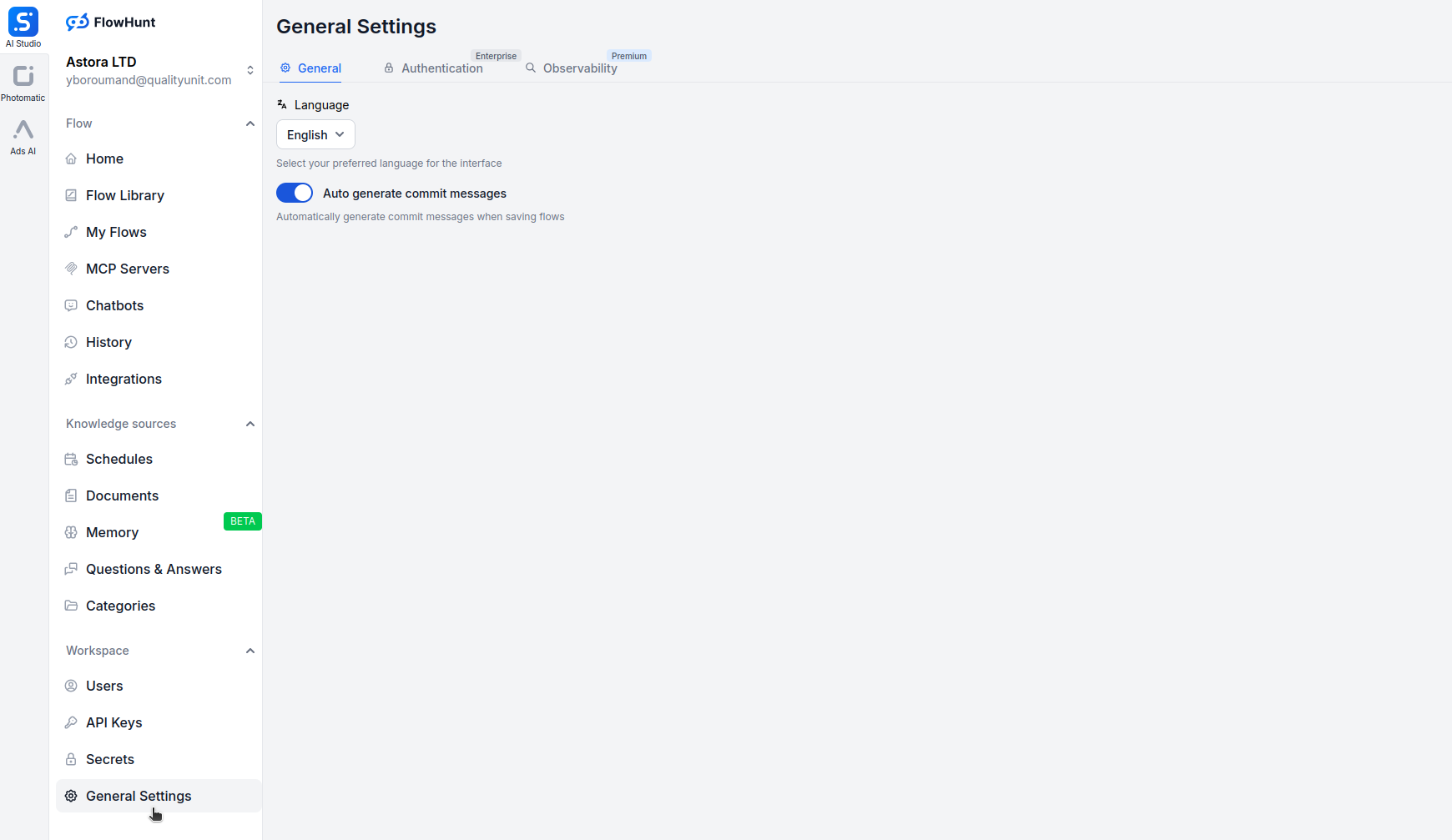

在浏览器中打开 app.flowhunt.io 。

进入常规设置(通常在侧边栏或顶部菜单中)。

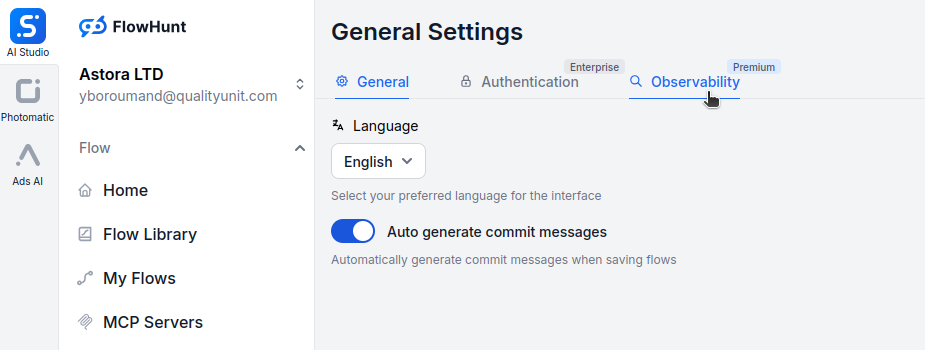

滚动到底部,点击可观测性标签页。

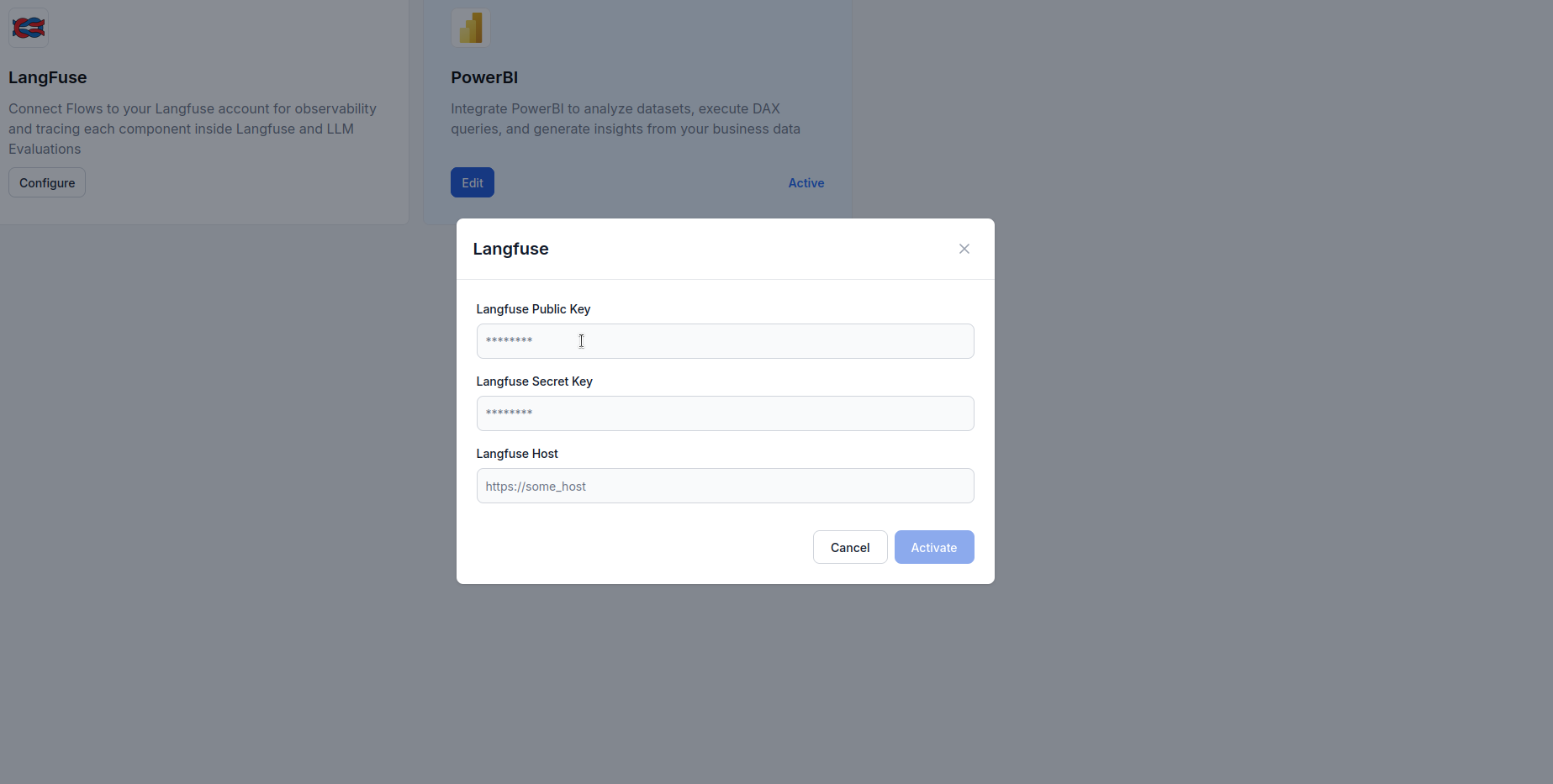

找到 Langfuse 区块,点击 Configure。

https://cloud.langfuse.com)

连接后,您将获得强大的可视化和分析能力。以下是您可以生成的部分洞察示例:

详细查看每次工作流执行的时间线,包括:

助您定位瓶颈,深入理解工作流行为。

监控不同工作流的 token 消耗:

帮助识别高 token 消耗环节,实现成本优化。

追踪关键性能指标:

帮助维护 SLA 并优化用户体验。

识别并诊断失败:

加速故障排查,提高系统可靠性。

针对对话式 AI 智能体,追踪:

助力智能体优化和用户体验提升。

对比不同 LLM 供应商的性能:

帮助基于真实数据做出模型选择决策。

将 FlowHunt 与 Langfuse 集成,让您的 AI 工作流从“黑盒”变为透明、可优化的系统。通过全面的追踪,您可以洞察每一步执行,为性能、成本和可靠性做出数据驱动的决策。

Langfuse 可观测性集成让监控变得简单——只需配置 API 密钥,即可获得丰富的仪表盘,直观展现工作流在生产环境中的真实表现。

现在,您的 FlowHunt 工作区已经与 Langfuse 连接,具备了持续改进的基础:定位瓶颈、优化 token 使用、降低延迟,让 AI 系统在信心十足的前提下发挥最大价值。

FlowHunt 的可观测性是指能够实时监控、追踪和分析 AI 工作流、智能体和自动化的运行表现。它帮助用户发现瓶颈、追踪 token 使用量、衡量延迟,并基于数据做出优化决策。

Langfuse 是一款开源的 LLM 工程平台,专为追踪、监控和分析 AI 应用而设计。与 FlowHunt 集成后,它能够提供关于工作流执行、token 消耗、模型性能和错误追踪的详细洞察。

不需要,集成过程非常简单。只需注册 Langfuse 账号,生成 API 密钥,并粘贴到 FlowHunt 的可观测性设置中,无需编写代码。

连接后,您可以追踪执行追踪、token 使用、模型成本、延迟指标、错误率、工作流长期表现,以及 AI 智能体交互的详细分解步骤。

Langfuse 提供包含基础追踪和可观测性功能的免费套餐。对于大型团队和高级分析,Langfuse 还提供包含更多功能的付费方案。

Langfuse MCP 服务器通过模型上下文协议(Model Context Protocol),将 FlowHunt 及其它 AI 客户端连接到 Langfuse 提示词仓库,实现集中式提示词发现、检索和动态编译,从而简化 LLM 和智能体的工作流程。...

FlowHunt 发布了一个开源 CLI 工具包,用于评估 AI 流程并提供高级报告能力。了解我们如何利用自有平台实现“大语言模型担任评审”,打造智能化流程评估系统。...

FlowHunt 2.4.1 推出了多项全新 AI 模型,包括 Claude、Grok、Llama、Mistral、DALL-E 3 和 Stable Diffusion,为您的 AI 项目带来更多实验、创意和自动化的选择。...

Cookie 同意

我们使用 cookie 来增强您的浏览体验并分析我们的流量。 See our privacy policy.