Codacy MCP 服务器集成

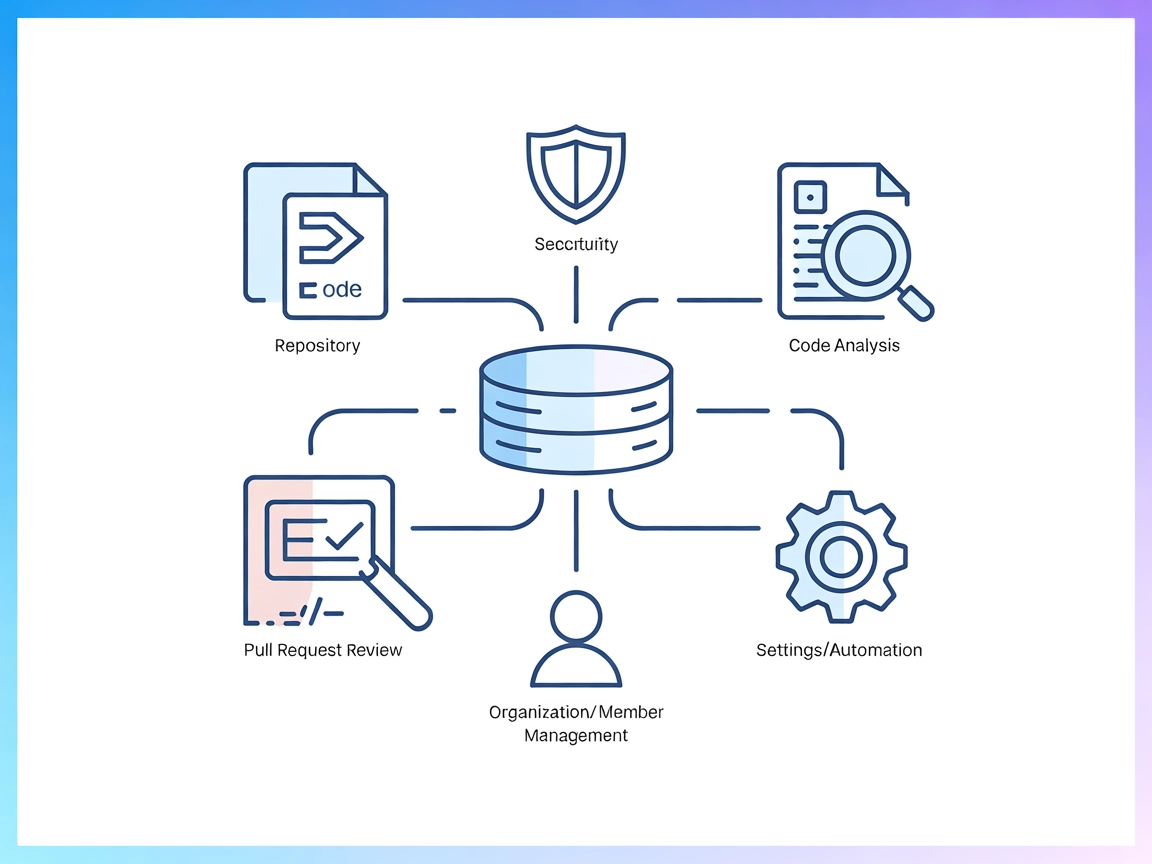

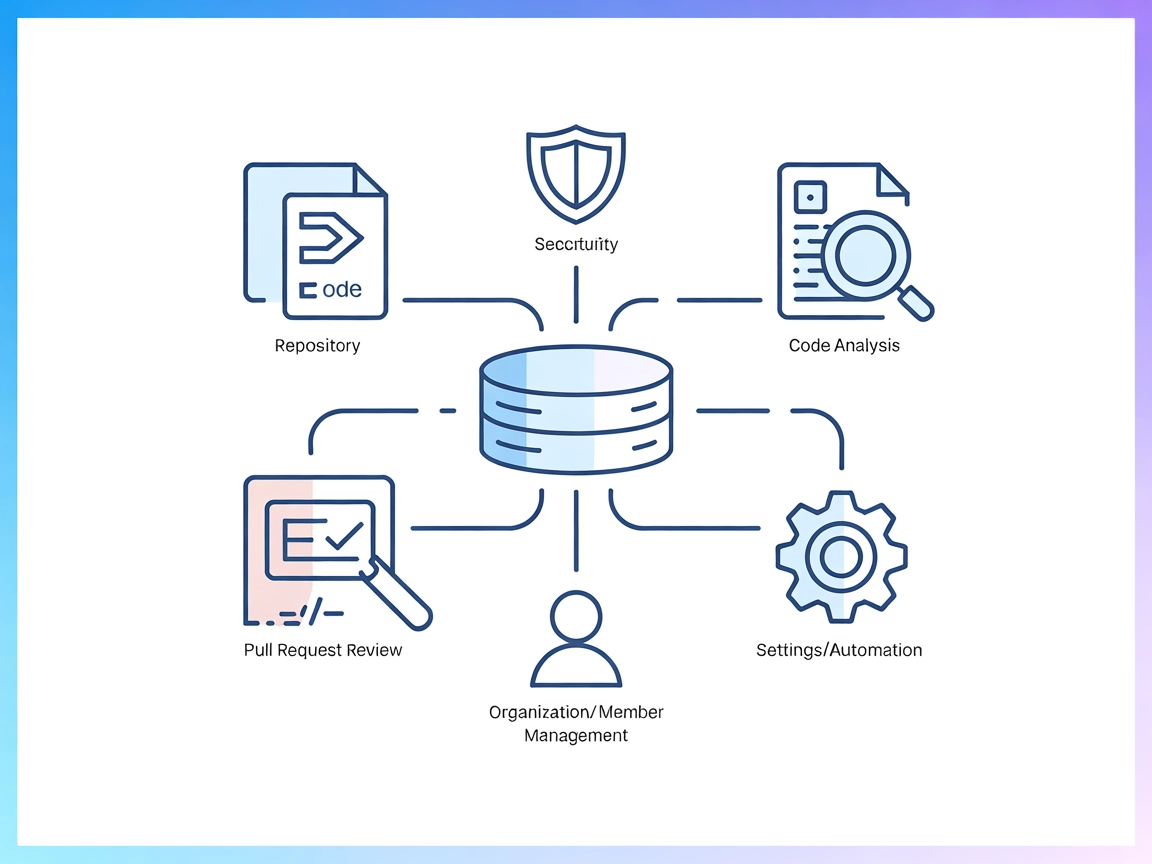

Codacy MCP 服务器作为 AI 助手与 Codacy 平台之间的桥梁,通过对 Codacy 强大 API 的程序化访问,实现自动化的代码质量、安全分析、仓库管理和开发者工作流优化。...

FlowHunt在您的内部系统和AI工具之间提供额外的安全层,让您能够精细控制从MCP服务器可访问哪些工具。托管在我们基础设施中的MCP服务器可以与FlowHunt的聊天机器人以及ChatGPT、Claude和各种AI编辑器等热门AI平台无缝集成。

Coda MCP(模型上下文协议)服务器是一个标准化的通用 API 服务器,将 AI 助手与 Coda 的工具和服务套件连接起来。通过实现 MCP 规范,Coda MCP 服务器使 AI 客户端能够以编程方式与 Coda 交互,便于查询文档、自动化工作流以及在 Coda 生态中管理文件或数据。这让开发者能够构建更完善的开发工作流,将上下文数据集成到大语言模型交互中,并通过统一协议协调外部系统的动作。该服务器旨在确保与其他 MCP 兼容服务的兼容性,是 AI 代理与 Coda 强大平台之间的重要桥梁。

在可用的仓库文件中未找到提示模板相关信息。

在可用文件中没有文件化或列出明确的 MCP 资源。

完整可用工具列表请参见 src/universal_mcp_coda/README.md 。然而,提供的信息中未包含该文件内容,故无法列出工具详情。

uv sync

source .venv/bin/activate.venv\Scripts\Activatemcp dev src/universal_mcp_coda/server.py

mcp install src/universal_mcp_coda/server.py

JSON 配置示例: 可用文档未提供。

API 密钥安全措施: 未找到相关示例或说明。

未提供 Claude 的特定设置说明。

未提供 Cursor 的特定设置说明。

未提供 Cline 的特定设置说明。

在 FlowHunt 中使用 MCP

要将 MCP 服务器集成到您的 FlowHunt 工作流中,请先将 MCP 组件添加到流程并连接至您的 AI 代理:

点击 MCP 组件,打开配置面板。在系统 MCP 配置区域,使用以下 JSON 格式填写您的 MCP 服务器信息:

{

"coda": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

配置后,AI 代理即可将此 MCP 作为工具使用,具备其全部功能和能力。请记得将 “coda” 替换为您实际的 MCP 服务器名称,并将 URL 替换为您自己的 MCP 服务器地址。

| 部分 | 可用性 | 详情/备注 |

|---|---|---|

| 概览 | ✅ | 在 README.md 中提供了摘要 |

| 提示词列表 | ⛔ | 未文档化任何提示词/模板 |

| 资源列表 | ⛔ | 未文档化任何明确的 MCP 资源 |

| 工具列表 | ⛔ | 工具有引用但在可用内容中未列出 |

| API 密钥安全措施 | ⛔ | 未找到任何说明或示例 |

| 采样支持(评估中不重要) | ⛔ | README 或其他文件中未提及 |

根据可用文档,Coda MCP 提供了基本概述和本地设置说明,但缺少详细的资源、提示模板、工具列表和安全指导,似乎仍处于早期或文档不完善阶段。

Coda MCP 仓库目前在资源、工具、提示和安全文档方面存在严重缺失,这极大限制了其实用性和可发现性。根据上述表格,我们为该 MCP 服务器打分 2/10,它展现了开发意图和基础设置引导,但缺乏生产级 MCP 实现所需的详实文档。

| 是否有 LICENSE | ✅ (MIT) |

|---|---|

| 至少有一个工具 | ⛔ (未确认) |

| Fork 数 | 0 |

| Star 数 | 1 |

Coda MCP 服务器是一个通用的 API 服务器,将 AI 助手与 Coda 连接,实现通过模型上下文协议在 Coda 生态系统内以编程方式查询文档、自动化工作流和管理数据。

将 MCP 组件添加到您的流程中,然后在系统 MCP 设置中以 JSON 格式配置您的 Coda MCP 服务器信息。例如:{ "coda": { "transport": "streamable_http", "url": "https://yourmcpserver.example/pathtothemcp/url" } }

当前文档未提供提示模板或明确的资源清单。工具信息有引用,但在可用文件中未列出。

Coda MCP 仓库为 Windsurf 提供了基础概述和设置步骤,但缺乏关于工具、资源、提示和安全实践的完整文档。截至目前,文档被认为是不完整的。

该仓库采用 MIT 许可证。

Codacy MCP 服务器作为 AI 助手与 Codacy 平台之间的桥梁,通过对 Codacy 强大 API 的程序化访问,实现自动化的代码质量、安全分析、仓库管理和开发者工作流优化。...

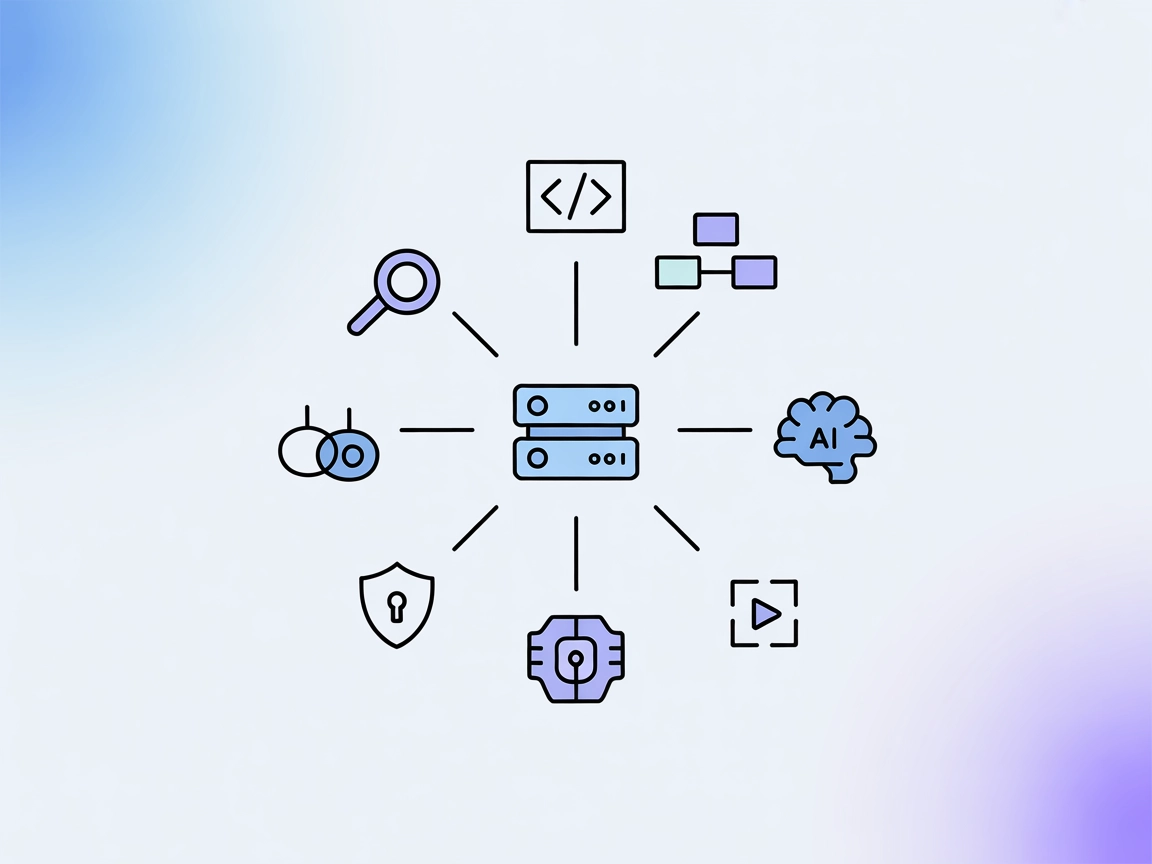

模型上下文协议(MCP)服务器将 AI 助手与外部数据源、API 和服务连接起来,实现复杂工作流的无缝集成,并在 FlowHunt 中安全管理开发任务。...

CodeLogic MCP 服务器将 FlowHunt 和 AI 编程助手连接到 CodeLogic 的详细软件依赖数据,支持高级代码分析、可视化和自动化工作流,提升软件开发效率。...

Cookie 同意

我们使用 cookie 来增强您的浏览体验并分析我们的流量。 See our privacy policy.