计算器 MCP 服务器

计算器 MCP 服务器通过 MCP 协议为 AI 助手和大语言模型(LLM)带来快速、可编程的数学计算,实现精确的计算能力,直接在 FlowHunt 流程中使用。...

专为约束、SAT 和 SMT 求解设计的 MCP 服务器,使 LLM 和 AI 智能体能够交互式构建、编辑并求解复杂模型。

FlowHunt在您的内部系统和AI工具之间提供额外的安全层,让您能够精细控制从MCP服务器可访问哪些工具。托管在我们基础设施中的MCP服务器可以与FlowHunt的聊天机器人以及ChatGPT、Claude和各种AI编辑器等热门AI平台无缝集成。

MCP 求解器是一款基于模型上下文协议(MCP)的服务器,专为 AI 助理和大语言模型(LLM)提供高级约束优化与求解功能。它集成了 SAT(布尔可满足性)、SMT(可满足性模理论)及约束求解能力,使 AI 模型能够交互式地创建、编辑和求解复杂的数学模型。支持多种问题表达方式,包括用于约束模型的 MiniZinc、用于 SAT/MaxSAT 问题的 PySAT 及 SMT 公式的 Z3。这让开发者和 AI 智能体能够轻松实现自动推理、优化及模型分析,极大提升科研、工程和决策领域的工作效率。该服务器架起了高性能求解器与 AI 驱动界面之间的桥梁,便于在自动化流程和交互式 AI 系统中利用这些工具。

uv 项目管理器。git clone https://github.com/szeider/mcp-solver.git

cd mcp-solver

uv venv

source .venv/bin/activate

uv pip install -e ".[all]"

windsurf.json 或类似文件)。{

"mcpServers": {

"mcp-solver": {

"command": "python",

"args": ["-m", "mcp_solver"]

}

}

}

{

"mcpServers": {

"mcp-solver": {

"command": "python",

"args": ["-m", "mcp_solver"],

"env": {

"SOLVER_API_KEY": "${SOLVER_API_KEY}"

},

"inputs": {

"api_key": "${SOLVER_API_KEY}"

}

}

}

}

uv。{

"mcpServers": {

"mcp-solver": {

"command": "python",

"args": ["-m", "mcp_solver"]

}

}

}

uv。cursor.json)。{

"mcpServers": {

"mcp-solver": {

"command": "python",

"args": ["-m", "mcp_solver"]

}

}

}

uv。{

"mcpServers": {

"mcp-solver": {

"command": "python",

"args": ["-m", "mcp_solver"]

}

}

}

**注意:**如需配置 API 密钥或其他敏感信息,请参考 Windsurf 示例将环境变量传递给服务器。

在 FlowHunt 中集成 MCP

要在 FlowHunt 工作流中集成 MCP 服务器,首先添加 MCP 组件,并将其连接到您的 AI 智能体:

点击 MCP 组件打开配置面板。在系统 MCP 配置区域,使用如下 JSON 格式填写您的 MCP 服务器信息:

{

"mcp-solver": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

配置完成后,AI 智能体即可作为工具访问该 MCP,使用其所有功能。请务必将 “mcp-solver” 替换为实际 MCP 服务器名称,并把 URL 换成您自己的 MCP 服务器地址。

| 部分 | 是否可用 | 说明/备注 |

|---|---|---|

| 概览 | ✅ | 面向 LLM 的 SAT、SMT 与约束求解 |

| 提示词模板列表 | ⛔ | 未发现提示词模板 |

| 资源列表 | ⛔ | 未描述明确的 MCP 资源 |

| 工具列表 | ✅ | clear_model、add_item、delete_item、replace_item 等 |

| 安全配置 API 密钥 | ✅ | 已给出环境变量与输入配置示例 |

| 采样支持(评测时可忽略) | ⛔ | 未提及 |

| Roots 支持 | ⛔ | 未提及 |

根据现有文档,MCP 求解器是专注于约束与优化问题求解的高专业性 MCP 服务器,工具定义完善,但暂不包含明确的提示词模板与资源。其安装、集成说明详尽,但未涉及 Roots 或采样等高级 MCP 功能支持。

| 是否有 LICENSE | ✅ (MIT) |

|---|---|

| 是否包含至少一个工具 | ✅ |

| Fork 数量 | 11 |

| Star 数量 | 85 |

我们的评价:

MCP 求解器是一款高聚焦、学术性强的 MCP 服务器,集成了丰富的求解器与工具支持。虽未涵盖提示词模板与资源,影响其通用性,但在约束/优化类工作流中的核心功能表现出色。综合来看通用 MCP 评分为 7/10,若后续补充 prompt/resource 支持,评分还将提升。

MCP 求解器是一款模型上下文协议(MCP)服务器,为 AI 智能体和 LLM 提供 SAT、SMT 及约束求解功能。它通过 MiniZinc、PySAT 和 Z3 等工具支持模型构建、编辑与求解,实现高级推理与优化流程。

MCP 求解器包含模型编辑(clear_model、add_item、delete_item、replace_item)、获取当前模型(get_model)、求解模型(solve_model,支持超时设置)等工具。

包括构建和求解约束模型、自动化 SAT/SMT 问题求解、优化(如排班)、约束编程教学集成,以及自动化逻辑模型相关科研。

在 FlowHunt 流程中添加 MCP 组件,并在系统 MCP 配置中填写您的 MCP 服务器信息,使用提供的 JSON 格式,更新服务器名称和 URL,您的 AI 智能体即可访问全部 MCP 求解器功能。

默认不需要 API 密钥。如您的环境要求,可通过配置环境变量并参考文档设置示例将密钥传递给服务器。

计算器 MCP 服务器通过 MCP 协议为 AI 助手和大语言模型(LLM)带来快速、可编程的数学计算,实现精确的计算能力,直接在 FlowHunt 流程中使用。...

JupyterMCP 通过模型上下文协议(MCP)实现 Jupyter Notebook(6.x)与 AI 助手的无缝集成。利用 LLM 自动执行代码、管理单元格和获取输出,简化数据科学工作流程并提升生产力。...

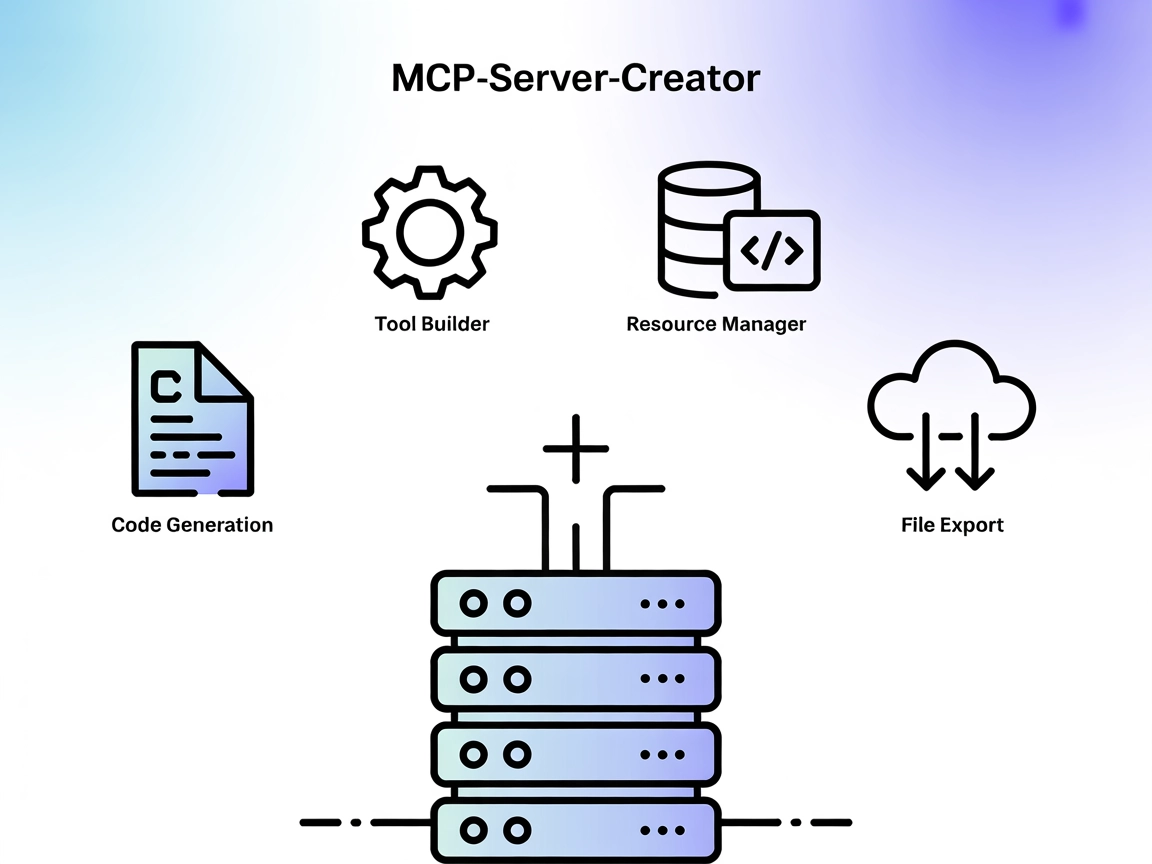

MCP-Server-Creator 是一个元服务器,可以快速创建和配置新的模型上下文协议(MCP)服务器。通过动态代码生成、工具构建和资源管理,它简化了自定义 AI 连接与集成服务器的开发,帮助技术团队自动化工作流程并加速部署。...

Cookie 同意

我们使用 cookie 来增强您的浏览体验并分析我们的流量。 See our privacy policy.