F-分数(F-度量,F1 度量)

F-分数,也称为F-度量或F1分数,是一种用于评估测试或模型准确性的统计指标,尤其适用于二元分类。它在精确率和召回率之间取得平衡,能够全面反映模型的表现,特别适用于数据集类别分布不均衡的情况。...

F-分数,也称为F-度量或F1分数,是一种用于评估测试或模型准确性的统计指标,尤其适用于二元分类。它在精确率和召回率之间取得平衡,能够全面反映模型的表现,特别适用于数据集类别分布不均衡的情况。...

深入探索我们对 Gemini 2.0 Thinking 性能的评测,涵盖内容生成、计算、摘要等多个方面——突出其优势、局限性,以及独特的“思考”透明性,这使其在 AI 推理领域中独树一帜。...

接收者操作特征(ROC)曲线是一种图形表示方式,用于评估二分类器系统在不同判别阈值下的性能。该曲线起源于二战期间的信号检测理论,如今在机器学习、医学和人工智能等领域成为模型评估的重要工具。...

调整后的R平方是一种用于评估回归模型拟合优度的统计量,通过考虑预测变量的数量来避免过拟合,并提供对模型性能更准确的评估。...

对数损失(Log Loss),又称对数/交叉熵损失,是评估机器学习模型性能的关键指标,尤其适用于二分类,通过衡量预测概率与实际结果之间的差异,惩罚错误或过于自信的预测。...

泛化误差衡量机器学习模型对未见数据的预测能力,通过平衡偏差和方差,确保 AI 应用的稳健性与可靠性。了解其重要性、数学定义,以及减少泛化误差的有效技术,助力真实世界的成功。...

混淆矩阵是机器学习中用于评估分类模型性能的工具,详细展示了真/假阳性和真/假阴性结果,能够提供超越准确率的洞察力,尤其适用于数据不均衡的场景。...

AI模型的基准测试是指使用标准化数据集、任务和性能指标,对人工智能模型进行系统性的评估和比较。这有助于实现客观评估、模型对比、进展跟踪,并促进AI开发过程中的透明度与标准化。...

交叉验证是一种统计方法,通过多次将数据划分为训练集和验证集,评估和比较机器学习模型,确保模型能够很好地泛化到未见过的数据,并有助于防止过拟合。...

深入探索AI代理模型领域,全面分析20款前沿系统。了解它们如何思考、推理和在各种任务中的表现,洞察让它们与众不同的细微差别。...

平均精度均值(mAP)是计算机视觉中用于评估目标检测模型的关键指标,通过一个标量值同时体现检测与定位的准确性。它被广泛用于自动驾驶、安防监控和信息检索等任务中,进行AI模型的基准测试与优化。...

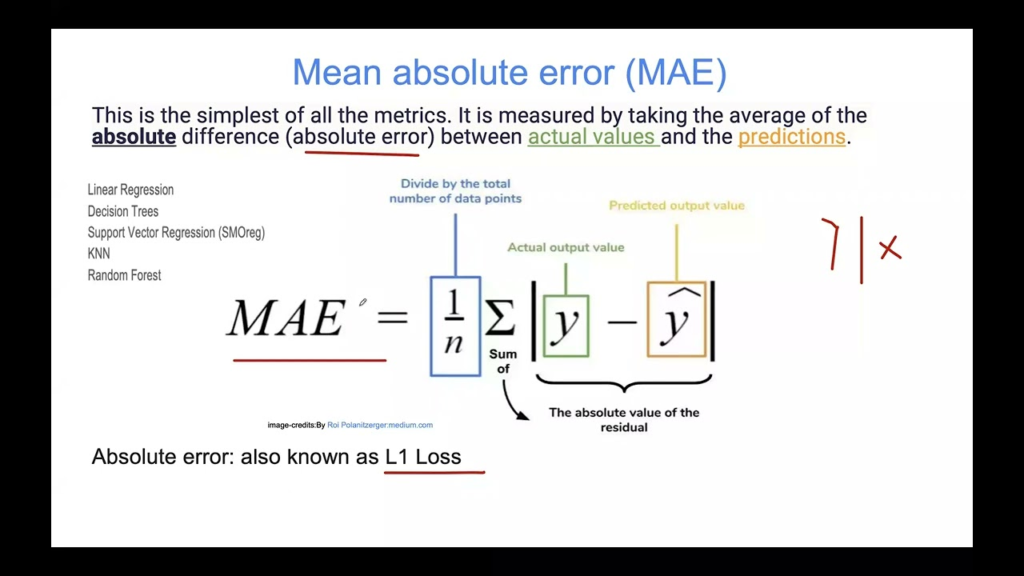

平均绝对误差(MAE)是机器学习中用于评估回归模型的基本指标。它衡量预测误差的平均幅度,为评估模型准确性提供了一种直接且易于解释的方法,而不考虑误差的方向。...

人工智能中的学习曲线是一种图形化表示,用于展示模型的学习性能与数据集大小或训练迭代次数等变量之间的关系,有助于诊断偏差-方差权衡、模型选择以及优化训练过程。...

在人工智能和机器学习中,训练误差指的是模型在训练过程中预测输出与实际输出之间的差异。它是评估模型性能的关键指标,但必须结合测试误差一起考虑,以避免过拟合或欠拟合。...