Prompt

Prompt-Vorlage zum Erstellen einer API-URL mit dynamischer Nutzereingabe.

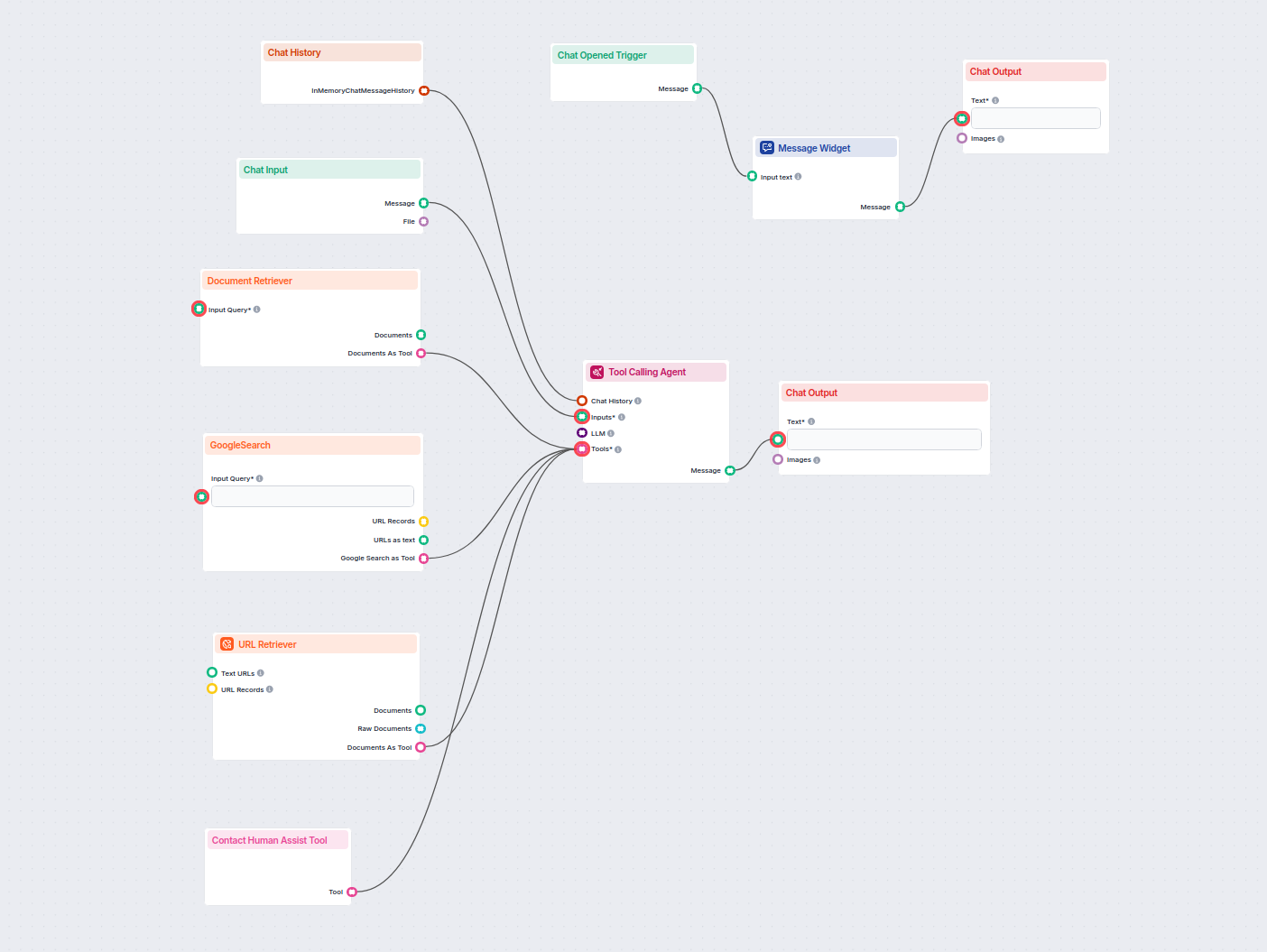

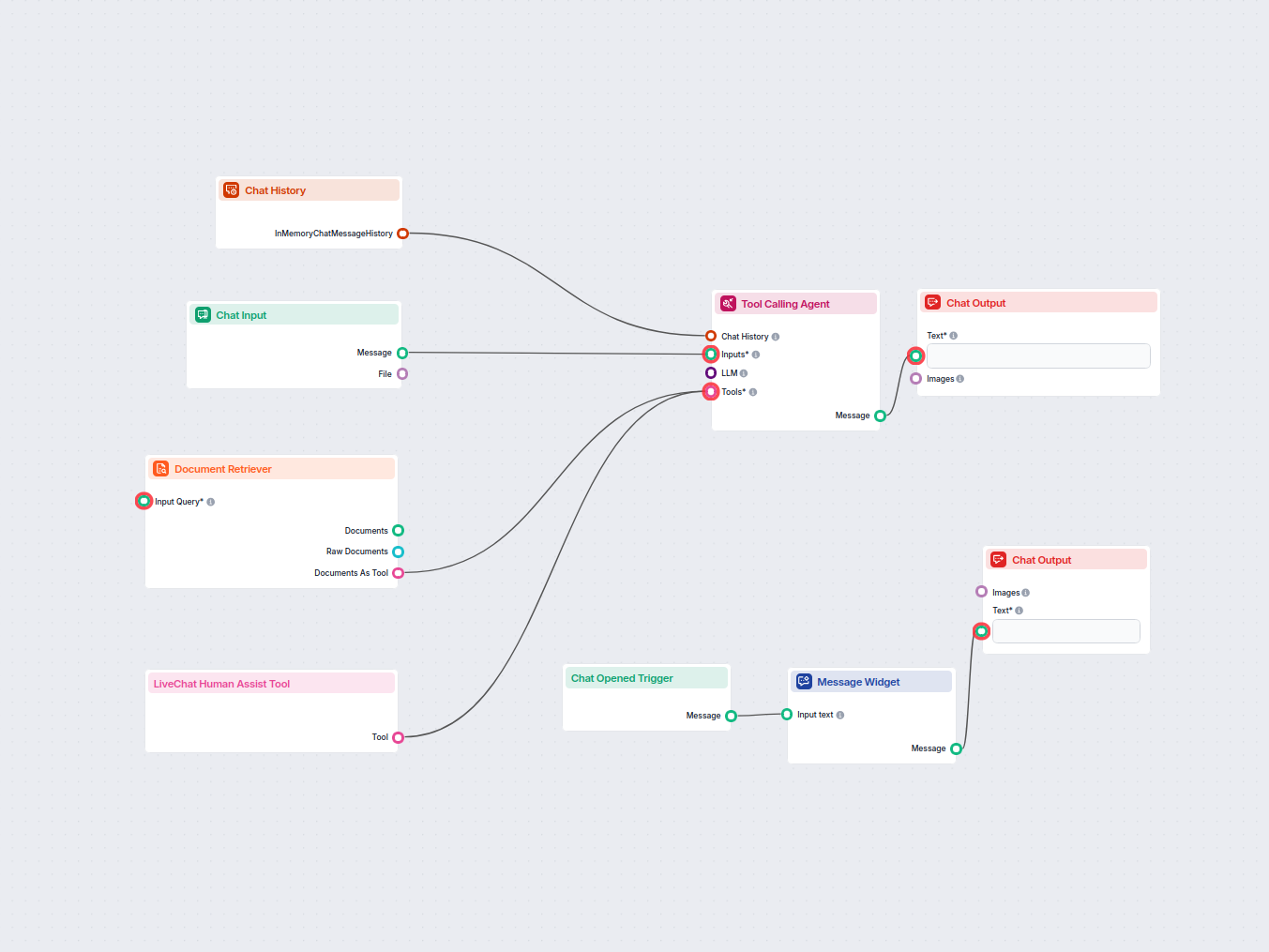

Dieser KI-Workflow klassifiziert eingehende E-Mails automatisch als Spam oder Nicht-Spam und leitet legitime Nachrichten intelligent an einen KI-Assistenten weiter, der auf Unternehmenswissen zugreift, um professionelle Supportantworten zu liefern. Er integriert Dokumentenabruf, fortschrittliche LLMs und API-Interaktionen für eine nahtlose Automatisierung des Kundensupports.

Flows

Prompt-Vorlage zum Erstellen einer API-URL mit dynamischer Nutzereingabe.

Prompt-Vorlage für die Ausgabe bei Spam-Nachrichten.

Prompt-Vorlage zum Erstellen einer API-URL mit dynamischer Eingabe.

Prompt-Vorlage zum Erstellen einer API-URL mit dynamischer Nutzereingabe.

Systemprompt für das LLM zur Klassifizierung von E-Mails als Spam oder Nicht-Spam.

Systemprompt für das LLM, um die Vorschau-Abschnitte aus der Eingabe zu extrahieren.

Systemprompt für den LLM-Agenten, als professioneller Kundensupport-Assistent zu agieren.

Nachfolgend finden Sie eine vollständige Liste aller Komponenten, die in diesem Flow verwendet werden, um seine Funktionalität zu gewährleisten. Komponenten sind die Bausteine jedes KI-Flows. Sie ermöglichen es Ihnen, komplexe Interaktionen zu erstellen und Aufgaben zu automatisieren, indem verschiedene Funktionalitäten verbunden werden. Jede Komponente dient einem bestimmten Zweck, wie z.B. der Verarbeitung von Benutzereingaben, der Datenverarbeitung oder der Integration mit externen Diensten.

Die Chat Input-Komponente in FlowHunt initiiert Benutzerinteraktionen, indem sie Nachrichten aus dem Playground erfasst. Sie dient als Startpunkt für Flows und ermöglicht die Verarbeitung von Text- und dateibasierten Eingaben im Workflow.

Erfahren Sie, wie die Prompt-Komponente von FlowHunt es ermöglicht, die Rolle und das Verhalten Ihres KI-Bots zu definieren und so relevante, personalisierte Antworten sicherstellt. Passen Sie Prompts und Vorlagen an, um effektive, kontextbewusste Chatbot-Flows zu erstellen.

Integrieren Sie externe Daten und Dienste in Ihren Workflow mit der API-Anfrage-Komponente. Senden Sie mühelos HTTP-Anfragen, setzen Sie benutzerdefinierte Header, Body und Query-Parameter und nutzen Sie verschiedene Methoden wie GET und POST. Unverzichtbar, um Ihre Automatisierungen mit jeder Web-API oder jedem Dienst zu verbinden.

Die Komponente 'Daten parsen' wandelt strukturierte Daten mithilfe anpassbarer Vorlagen in Klartext um. Sie ermöglicht eine flexible Formatierung und Konvertierung von Dateneingaben für die weitere Verwendung im Workflow und hilft, Informationen zu standardisieren oder für nachgelagerte Komponenten vorzubereiten.

Entdecken Sie die Komponente Generator in FlowHunt – leistungsstarke, KI-gesteuerte Textgenerierung mit Ihrem gewählten LLM-Modell. Erstellen Sie mühelos dynamische Chatbot-Antworten, indem Sie Prompts, optionale Systemanweisungen und sogar Bilder als Eingabe kombinieren. So wird es zu einem zentralen Werkzeug für den Aufbau intelligenter, konversationeller Workflows.

Die Komponente 'Bedingter Router' ermöglicht dynamische Entscheidungsfindung innerhalb Ihres Workflows. Sie vergleicht einen eingegebenen Text mit einem angegebenen Wert mithilfe verschiedener Operatoren – wie 'gleich', 'enthält' oder 'ist leer' – und leitet die Nachricht je nach Ergebnis des Vergleichs an verschiedene Ausgänge weiter. So können Sie Ihre Logik verzweigen und personalisierte, intelligente Workflows erstellen, die sich an die Benutzereingaben anpassen.

Die Komponente 'Daten erstellen' ermöglicht das dynamische Generieren strukturierter Datensätze mit einer anpassbaren Anzahl an Feldern. Ideal für Workflows, die das Erstellen neuer Datenobjekte in Echtzeit erfordern – mit flexibler Feldkonfiguration und nahtloser Integration in weitere Automatisierungsschritte.

Entdecken Sie die Chat-Ausgabe-Komponente in FlowHunt – finalisieren Sie Chatbot-Antworten mit flexiblen, mehrteiligen Ausgaben. Unverzichtbar für nahtlose Flow-Abschlüsse und die Erstellung fortschrittlicher, interaktiver KI-Chatbots.

FlowHunt unterstützt Dutzende von Textgenerierungsmodellen, darunter Modelle von OpenAI. So verwenden Sie ChatGPT in Ihren AI-Tools und Chatbots.

FlowHunt unterstützt Dutzende von KI-Modellen, einschließlich der Claude-Modelle von Anthropic. Erfahren Sie, wie Sie Claude in Ihren KI-Tools und Chatbots mit anpassbaren Einstellungen für maßgeschneiderte Antworten nutzen können.

Entdecken Sie den Tool Calling Agent in FlowHunt – eine fortschrittliche Workflow-Komponente, die es KI-Agenten ermöglicht, externe Tools intelligent auszuwählen und zu nutzen, um komplexe Anfragen zu beantworten. Perfekt für den Aufbau intelligenter KI-Lösungen, die dynamische Tool-Nutzung, iteratives Denken und die Integration mehrerer Ressourcen erfordern.

Die Chatverlauf-Komponente in FlowHunt ermöglicht es Chatbots, sich an vorherige Nachrichten zu erinnern. So werden zusammenhängende Gespräche und ein verbessertes Kundenerlebnis gewährleistet, während Speicher und Token-Nutzung optimiert werden.

FlowHunts Dokumenten-Retriever verbessert die Genauigkeit von KI, indem generative Modelle mit Ihren eigenen aktuellen Dokumenten und URLs verbunden werden. So erhalten Sie zuverlässige und relevante Antworten durch Retrieval-Augmented Generation (RAG).

Die Notiz-Komponente in FlowHunt ermöglicht es Ihnen, Kommentare und Dokumentationen direkt in Ihren Workflow einzufügen. Nutzen Sie sie, um innerhalb Ihres Flows Klarheit zu schaffen, Anmerkungen zu machen oder Anweisungen zu geben, sodass komplexe Automatisierungen leichter zu verstehen und zu pflegen sind.

Flow-Beschreibung

Dieser Workflow ist darauf ausgelegt, die Verarbeitung, Klassifizierung und Weiterleitung von Geschäfts-E-Mails und Chat-Nachrichten zu automatisieren und zu skalieren – mit besonderem Fokus auf Kundensupport-Szenarien. Er verwendet eine Kombination aus KI-gestützter Klassifizierung, bedingter Logik, API-Integrationen und kontextbewussten Agentenantworten und ist dadurch besonders nützlich für Organisationen, die ihren Kundensupport optimieren, Spam erkennen und KI-Agenten mit externen Systemen wie LiveAgent verbinden möchten.

Der Flow besteht aus zwei Hauptzweigen:

Logiktabelle für Spam-Weiterleitung:

| Schritt | Tool/Knoten | Zweck |

|---|---|---|

| Nachrichteneingang | ChatInput | Empfängt Nutzer-/Kundennachricht |

| Prompt für API | PromptTemplate | Formatiert Nachricht für LiveAgent-API |

| API-Aufruf | APIRequest | Sendet/empfängt Nachrichtendaten |

| Daten parsen | ParseData | Extrahiert Nachrichten-Vorschau |

| Spam-LLM-Klassifizierung | Generator (OpenAI) | Klassifiziert als Spam oder Nicht-Spam |

| Bedingte Weiterleitung | ConditionalRouter | Leitet auf Basis des LLM-Outputs weiter |

| Spam-Benachrichtigung | PromptTemplate & ChatOutput | Standardantwort bei Spam |

| Kein Spam | Übergabe an Support-Agent | Für weitere menschlich wirkende Bearbeitung |

Logiktabelle für Agentenantworten:

| Schritt | Tool/Knoten | Zweck |

|---|---|---|

| Dokumentenabruf | DocumentRetriever | Holt relevante Infos aus der Wissensdatenbank |

| Chatverlauf | ChatHistory | Liefert aktuellen Gesprächskontext |

| LLM-Modell | Anthropic Claude | Liefert fortschrittliches Sprachverständnis |

| Tool Calling Agent | ToolCallingAgent | Kombiniert Tools, Kontext und Richtlinien |

| Ausgabe | ChatOutput | Antwortausgabe im Chat/Playground |

| API-Weiterleitung | APIRequest/ParseData | Optionales Weiterleiten für Logging/LiveAgent |

Dieser Workflow bietet eine robuste, skalierbare Architektur zur Automatisierung der Kundenkommunikation und stellt sowohl Effizienz als auch qualitativ hochwertige, richtlinienkonforme Antworten sicher. Dank seiner Modularität lässt er sich einfach erweitern, wenn Ihr Unternehmen wächst oder neue Automatisierungsanforderungen entstehen.

Wir helfen Unternehmen wie Ihrem, intelligente Chatbots, MCP-Server, KI-Tools oder andere Arten von KI-Automatisierungen zu entwickeln, um Menschen bei sich wiederholenden Aufgaben in Ihrer Organisation zu ersetzen.

Ein KI-gestützter Kundenservice-Chatbot, der Benutzer automatisch unterstützt, Informationen aus internen Dokumenten und dem Web abruft und bei Bedarf nahtlos a...

Setzen Sie einen KI-gestützten Chatbot auf Ihrer Website ein, der Ihre interne Wissensdatenbank nutzt, um Kundenanfragen zu beantworten, und leitet komplexe ode...

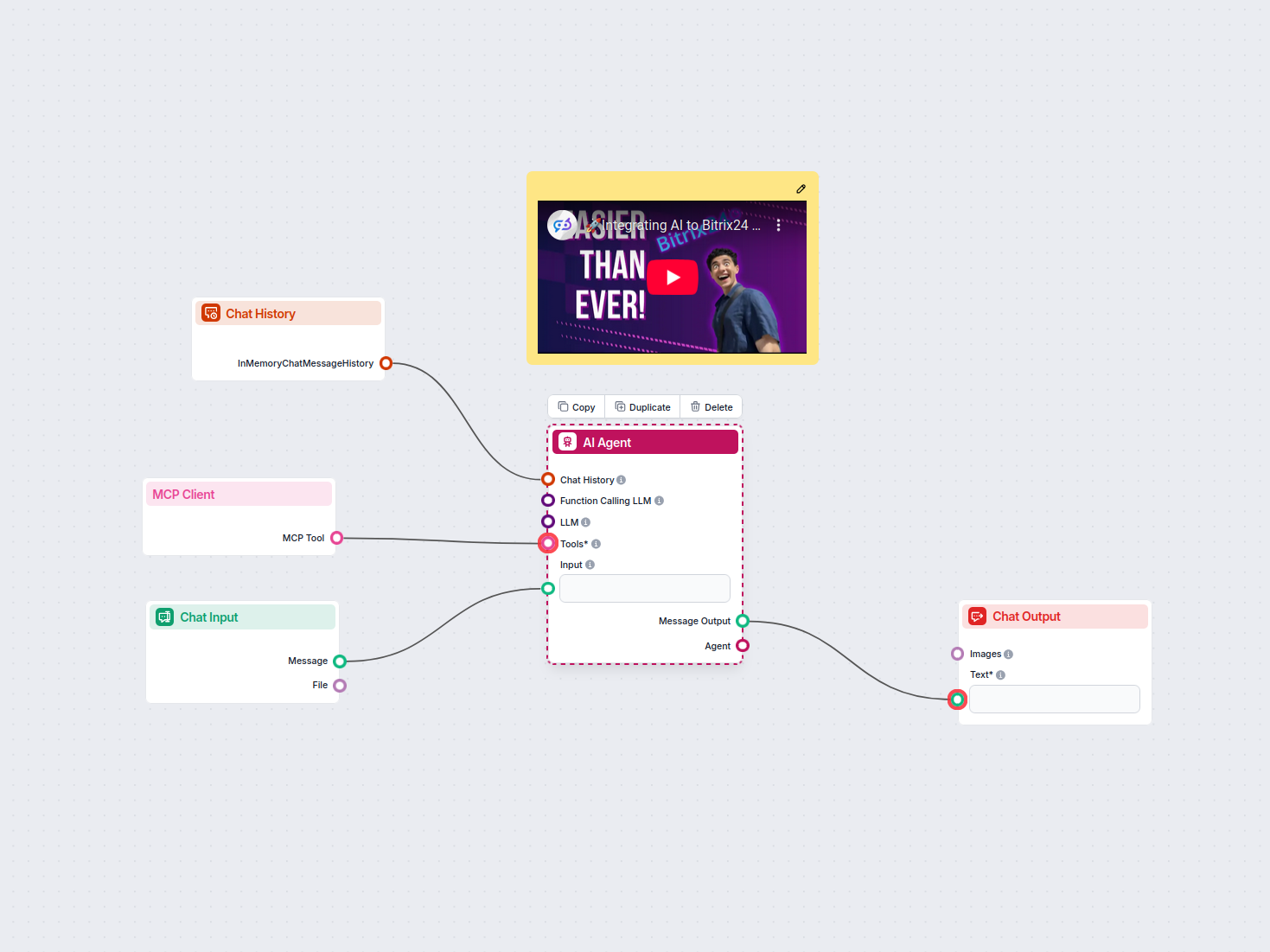

Dieser Workflow nutzt einen KI-Agenten, der mit dem MCP Client Tool integriert ist, um Benutzereingaben im Chat zu verarbeiten, den Chatverlauf für besseren Kon...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.