Was ist der Google Gemini KI-Chatbot?

Erfahren Sie, was Google Gemini ist, wie es funktioniert und wie es sich mit ChatGPT vergleicht. Lernen Sie seine multimodalen Fähigkeiten, Preisgestaltung und ...

Erleben Sie, wie Google I/O 2025 mit KI-gesteuerten Updates im gesamten Google-Ökosystem das Zeitalter von Gemini einläutet und wie FlowHunt das neueste Gemini 2.5 Flash-Modell in Ihre KI-Projekte bringt.

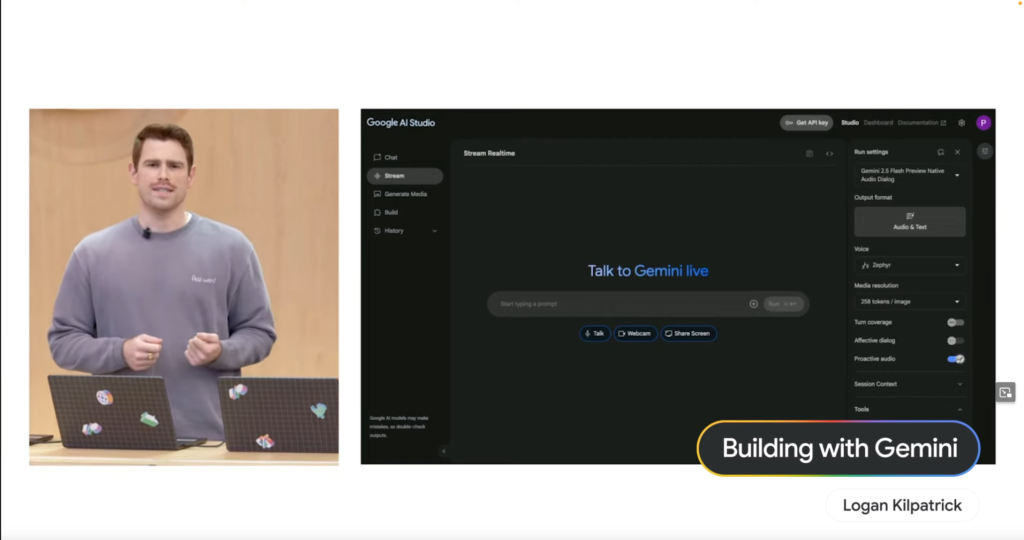

Logan Kilpatrick eröffnete die Veranstaltung und zeigte, wie Project Astra die Interaktion mit KI vollkommen natürlich wirken lässt. Viele dieser Fähigkeiten sind jetzt über die Live API zugänglich, die vom neuen Gemini 2.5 Flash nativen Audio-Modell angetrieben wird. Dieses Modell kann Störgeräusche besser ignorieren und unterstützt nativ 24 Sprachen – der Wegbereiter für eine intuitivere und reaktionsfähigere KI-Erfahrung.

Paige Bailey demonstrierte die Leistungsfähigkeit von Gemini mit einer „Keynote Companion“-Demo. Mit Google AI Studio zeigte sie, wie die KI gesprochene Befehle versteht, mit Live-Daten interagiert (z. B. das Shoreline Amphitheatre auf einer Karte anzeigt) und sogar komplexe Suchanfragen wie das Finden von Cafés mit WLAN in der Nähe in einem Gesprächsfluss ausführt. Das unterstreicht Geminis beeindruckende multimodale Fähigkeiten.

Adaptiv by Design: Compose und Android XR

Diana Wong betonte Googles Engagement, adaptive UIs einfacher zu gestalten. Neue Funktionen in der Compose Adaptive Layouts-Bibliothek wie Pane Expansion helfen Entwicklern, Apps zu bauen, die sich nahtlos an verschiedene Bildschirmgrößen und Formfaktoren anpassen. Dieses adaptive Prinzip gilt auch für Android XR, die Extended-Reality-Plattform, die gemeinsam mit Samsung entwickelt wurde. Entwickler können schon jetzt für kommende Headsets wie Project Moohan entwickeln, und wissen, dass ihre adaptiv gestalteten Apps für diese neue immersive Welt bereit sein werden.

Intelligenteres Coding: KI-Agenten in Android Studio

Florina Muntenescu stellte eine bahnbrechende Neuerung für Android-Entwickler vor: einen neuen KI-Agenten, der bald in Android Studio verfügbar ist. Dieser Agent unterstützt bei lästigen Aufgaben wie Versionsupdates. In einer eindrucksvollen Demo analysierte der KI-Agent ein altes Projekt, erkannte Build-Fehler und nutzte Gemini, um herauszufinden, wie die Probleme zu beheben sind – und iterierte, bis der Build erfolgreich war. Das verspricht eine deutliche Vereinfachung des Entwicklungsworkflows.

Vereinfachte Web-UIs: Neue Möglichkeiten für komplexe Elemente

Una Kravets stellte neue Web-Fähigkeiten vor, die die Erstellung gängiger, aber komplexer UI-Elemente vereinfachen. Entwickler können künftig robuste und barrierefreie Komponenten wie Karussells und Hover-Karten leichter bauen und so das Nutzererlebnis im Web verbessern.

Gemini Nano im Web: Multimodale KI-APIs entfesselt

Addy Osmani verkündete, dass Gemini Nano neue multimodale Möglichkeiten direkt im Web eröffnet. Neue eingebaute multimodale KI-APIs erlauben es, mit Gemini sowohl per Audio- als auch Bildeingabe zu interagieren. Eine „Cinemal“-Demo zeigte, wie ein Nutzer mit der Webcam ein Ticket fotografiert und die On-Device-KI sofort den Sitzbereich auf einem Theaterplan findet – ein beeindruckendes Beispiel für On-Device-Verarbeitung.

David East zeigte, wie Firebase KI integriert, um die App-Entwicklung zu beschleunigen. Entwickler können nun ihre Figma-Designs mit Unterstützung von Builder.io in Firebase Studio zum Leben erwecken. Das Beeindruckende: Es handelt sich nicht um einen monolithischen Code-Export; der Figma-Export generiert sauber getrennte, einzelne React-Komponenten. Mit Gemini innerhalb von Firebase Studio konnte David der KI einfach den Auftrag geben, z. B. einen „In den Warenkorb“-Button auf einer Produktseite hinzuzufügen – die KI setzte dies prompt um und aktualisierte Code und Live-Vorschau.

Gemma 3n: Leistungsstarke KI auf nur 2GB RAM

Gus Martins hatte aufregende Neuigkeiten für die Open-Source-Community: Die Ankündigung von Gemma 3n. Dieses extrem effiziente Modell läuft mit nur 2GB RAM und ist damit für mobile Hardware viel schneller und schlanker als Gemma 3. Entscheidend: Gemma 3n versteht nun auch Audio und ist damit wirklich multimodal.

SignGemma: Kommunikationsbarrieren überbrücken

Auch im Bereich Barrierefreiheit setzt Google mit SignGemma neue Maßstäbe. Diese neue Modelfamilie ist darauf trainiert, Gebärdensprache (aktuell mit Fokus auf American Sign Language – ASL) in gesprochene Sprache zu übersetzen und eröffnet so neue Wege der Kommunikation und Inklusion.

Von den beeindruckenden KI-Fortschritten auf der Google I/O inspiriert? Sie möchten eigene, intelligente KI-Agenten erstellen, die verstehen, schlussfolgern und handeln können?

FlowHunt ist die KI-basierte Plattform, mit der Sie leistungsstarke KI-Agenten ganz einfach – auch ohne Machine-Learning-Expertise – erstellen können. Gestalten Sie komplexe Workflows, integrieren Sie verschiedenste Tools und setzen Sie intelligente Agenten mit Leichtigkeit ein.

Und das Beste: Wie in der Keynote hervorgehoben, unterstützt FlowHunt jetzt das bahnbrechende Gemini 2.5 Flash! Sie können also ab sofort dessen Geschwindigkeit, Effizienz und verbesserte Audio-Fähigkeiten nutzen, um noch leistungsstärkere und reaktionsschnellere KI-Agenten zu bauen.

Probieren Sie die neuen Modelle, die in weniger als 24 Stunden in FlowHunt implementiert wurden, sofort aus!

Google I/O 2025 hebt den Wandel des Unternehmens hin zu einer AI-nativen Zukunft hervor, mit Gemini-Modellen im Zentrum neuer Produkte und Funktionen über Android, das Web und Entwickler-Tools hinweg.

Gemini 2.5 Flash ist Googles neuestes natives Audio-KI-Modell, das schnelle, effiziente und mehrsprachige Audioverarbeitung bietet – jetzt für Entwickler verfügbar und in Plattformen wie FlowHunt integriert.

Gemma 3n ist ein effizientes KI-Modell, das mit nur 2GB RAM und mit multimodalen (Audio-)Fähigkeiten läuft. SignGemma ist eine Modellfamilie, die Gebärdensprache, mit Fokus auf ASL, in gesprochene Sprache übersetzt.

FlowHunt unterstützt jetzt Gemini 2.5 Flash, sodass Nutzer fortschrittliche KI-Agenten mit verbesserten Audio- und Multimodal-Fähigkeiten erstellen können, ohne Expertenwissen in maschinellem Lernen zu benötigen.

Android führte adaptive UIs, XR-Unterstützung und KI-Agenten in Android Studio für intelligenteres Coding ein. Im Web ermöglicht Gemini Nano multimodale KI-APIs für Audio- und Bildeingaben direkt im Browser.

Yasha ist ein talentierter Softwareentwickler mit Spezialisierung auf Python, Java und Machine Learning. Yasha schreibt technische Artikel über KI, Prompt Engineering und Chatbot-Entwicklung.

Erleben Sie die Leistungsfähigkeit des neuen Gemini 2.5 Flash-Modells in FlowHunt und erstellen Sie KI-Agenten der nächsten Generation mit fortschrittlichen multimodalen Fähigkeiten.

Erfahren Sie, was Google Gemini ist, wie es funktioniert und wie es sich mit ChatGPT vergleicht. Lernen Sie seine multimodalen Fähigkeiten, Preisgestaltung und ...

Gemini Flash 2.0 setzt neue Maßstäbe in der KI mit verbesserter Leistung, Geschwindigkeit und multimodalen Fähigkeiten. Entdecken Sie das Potenzial in realen An...

Entdecken Sie, warum Googles Gemini 3 Flash die KI revolutioniert – mit überragender Leistung, geringeren Kosten und schnellerer Geschwindigkeit. Es übertrifft ...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.