Metaprompt

Ein Metaprompt in der künstlichen Intelligenz ist eine hochrangige Anweisung, die dazu dient, andere Prompts für große Sprachmodelle (LLMs) zu generieren oder z...

Beherrschen Sie die Prompt-Optimierung für KI, indem Sie klare, kontextreiche Prompts erstellen, um die Ausgabequalität zu steigern, Kosten zu senken und die Verarbeitungszeit zu verkürzen. Entdecken Sie Techniken für intelligentere KI-Workflows.

Prompt-Optimierung bedeutet, die Eingabe, die Sie einem KI-Modell geben, so zu verfeinern, dass es möglichst genaue und effiziente Antworten liefert. Es geht nicht nur um klare Kommunikation – optimierte Prompts reduzieren auch den Rechenaufwand, was zu schnelleren Verarbeitungszeiten und geringeren Kosten führt. Egal, ob Sie Anfragen für Kundenservice-Chatbots formulieren oder komplexe Berichte generieren: Wie Sie Ihre Prompts strukturieren und formulieren, macht den Unterschied.

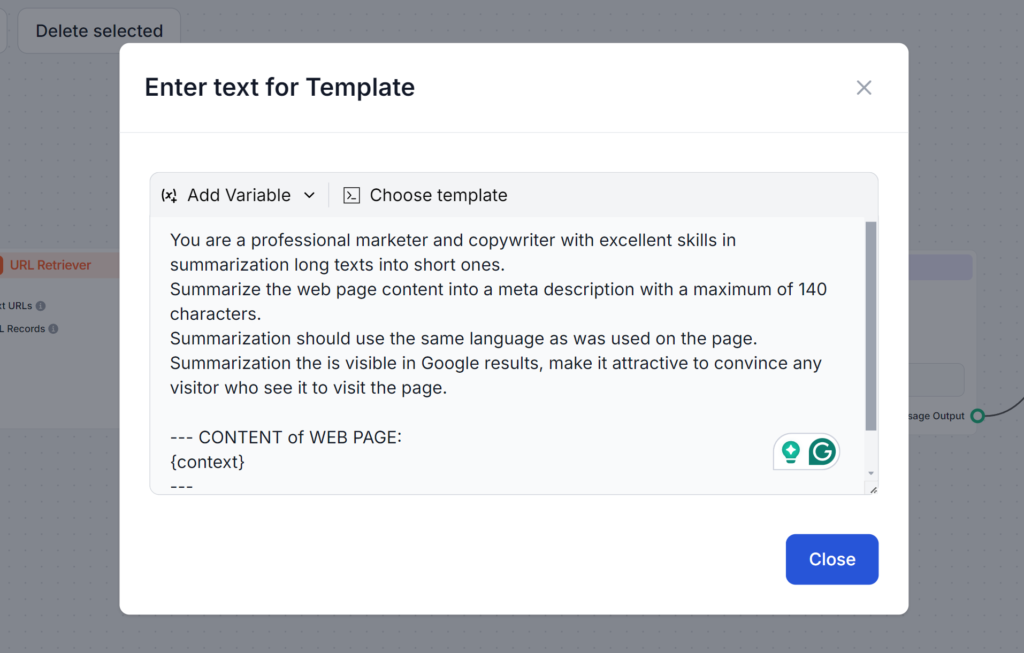

Haben Sie schon einmal versucht, eine KI um das Schreiben einer Meta-Beschreibung zu bitten? Wahrscheinlich lautete Ihr erster Prompt in etwa so:

Schreibe mir eine Meta-Beschreibung zum Thema Prompt-Optimierung.

Dieser Prompt ist aus mehreren Gründen nicht optimal. Wenn Sie die von Google geforderten 140 Zeichen nicht angeben, überschreitet die KI diese oft. Falls die Länge stimmt, nutzt sie häufig einen anderen Stil oder macht die Beschreibung zu langweilig, als dass jemand darauf klicken würde. Und ohne Ihren Artikel zu kennen, kann sie nur vage Meta-Beschreibungen liefern.

Sehen Sie sich den folgenden Prompt an. Er ist länger und verwendet verschiedene Techniken, die wir in diesem Blog besprechen. Dieser Prompt adressiert alle möglichen Probleme und sorgt dafür, dass Sie beim ersten Versuch genau das gewünschte Ergebnis erhalten:

Tokens sind die Bausteine von Texten, die KI-Modelle verarbeiten. Die Modelle zerteilen den Text in diese Tokens. Ein Token kann ein Wort, mehrere Wörter oder sogar ein Teil eines Wortes sein. Mehr Tokens bedeuten in der Regel langsamere Antworten und höhere Rechenkosten. Daher ist es entscheidend zu verstehen, wie Tokens funktionieren, um Prompts zu optimieren und sie kostengünstig und schnell auszuführen.

Warum Tokens wichtig sind:

Zum Beispiel:

Beim Prompt mit vielen Tokens soll die KI auf alle Optionen detailliert eingehen, während beim Prompt mit wenigen Tokens lediglich ein Überblick verlangt wird. Mit dem Überblick können Sie gezielt nach Ihren Bedürfnissen weiterarbeiten und kommen schneller sowie günstiger zu Ihrem Ziel.

Effektive Prompts erfordern eine Mischung aus Klarheit, Kontext und Kreativität. Unterschiedliche Formate auszuprobieren, empfiehlt sich, um die besten Methoden zur KI-Ansprache zu entdecken. Hier einige wichtige Techniken:

Mehrdeutige Prompts können das Modell verwirren. Ein gut strukturierter Prompt stellt sicher, dass die KI Ihre Absicht versteht.

Beispiel:

Relevante Details helfen der KI, Antworten passgenau auf Ihre Bedürfnisse zu generieren.

Beispiel:

Durch Beispiele kann die KI Format oder Ton besser nachvollziehen.

Beispiel:

Standardisierte Vorlagen für ähnliche Aufgaben sorgen für Konsistenz und sparen Zeit.

Beispiel-Vorlage für Blog-Erstellung:

„Schreibe einen [Wortzahl] Blogbeitrag über [Thema], mit Fokus auf [spezifische Details]. Verwende einen freundlichen Ton und integriere [Schlüsselwörter].“

Mehrere fortgeschrittene Strategien helfen Ihnen, Ihre Prompts auf das nächste Level zu heben. Sie gehen über Klarheit und Struktur hinaus, ermöglichen komplexere Aufgaben, dynamische Datenintegration und zugeschnittene KI-Antworten auf bestimmte Bereiche oder Anforderungen. Hier eine kurze Übersicht, wie jede Technik funktioniert – mit praktischen Beispielen.

Few-Shot Learning bedeutet, dem Prompt einige Beispiele hinzuzufügen, damit die KI Format oder Muster versteht. Das Modell kann so mit wenig Daten effektiv generalisieren – ideal für neue oder unbekannte Aufgaben.

Geben Sie einfach einige Beispiele im Prompt an, damit das Modell Ihre Erwartungen erkennt.

Beispiel-Prompt:

Übersetze die folgenden Sätze ins Französische:

Prompt Chaining bedeutet, komplexe Aufgaben in kleinere, aufeinander aufbauende Schritte zu unterteilen. So kann die KI mehrstufige Probleme systematisch lösen und liefert klare, präzise Ergebnisse.

Beispiel-Prompt:

Kontextuelle Abfrage integriert relevante, aktuelle Informationen in den Prompt, indem auf externe Quellen verwiesen oder wichtige Details zusammengefasst werden. So erhält die KI genaue und aktuelle Daten für fundierte Antworten.

Beispiel:

„Nutze die Daten aus diesem Bericht [Link einfügen], um die wichtigsten Erkenntnisse zu erneuerbaren Energien [Trends] zusammenzufassen.“

Feintuning mit Embeddings passt das KI-Modell an spezifische Aufgaben oder Bereiche mithilfe spezialisierter Datenrepräsentationen an. Diese Anpassung erhöht die Relevanz und Genauigkeit der Antworten in Nischen- oder branchenspezifischen Anwendungen.

Das Management der Token-Nutzung ermöglicht es, die Geschwindigkeit und Kosteneffizienz der KI bei der Verarbeitung von Eingaben und Ausgaben zu steuern. Durch Reduzierung der verarbeiteten Tokens sparen Sie Kosten und erhalten schnellere Antworten – ohne Qualitätsverlust. Hier einige Techniken für ein effektives Token-Management:

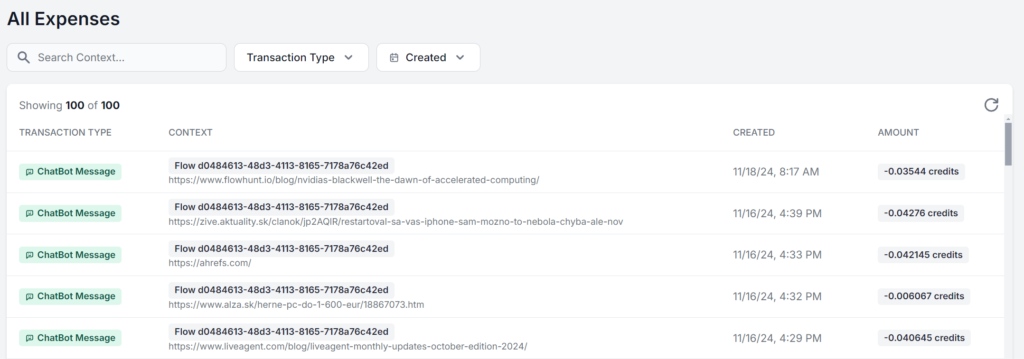

Optimierung endet nicht beim Schreiben besserer Prompts. Überwachen Sie regelmäßig die Performance und passen Sie die Prompts anhand von Feedback an. Dieses kontinuierliche Tracking ermöglicht stetige Verbesserungen und informiert Ihre Anpassungen.

Konzentrieren Sie sich auf diese Bereiche:

Am besten nutzen Sie eine Oberfläche, in der Sie die genaue Nutzung für jeden Prompt einsehen und analysieren können. Hier sehen Sie denselben FlowHunt-KI-Workflow, der fünfmal mit nur wechselndem Ausgangsmaterial läuft. Der Unterschied bei den Kosten beträgt nur ein paar Cent, aber bei häufigerer Nutzung summiert sich das schnell:

Ob Sie das Maximum aus kostenlosen KI-Modellen herausholen oder eine KI-Strategie im großen Stil aufbauen möchten – Prompt-Optimierung ist für jeden KI-Nutzer entscheidend. Diese Techniken ermöglichen Ihnen eine effiziente KI-Nutzung, präzise Ergebnisse und geringere Kosten.

Mit dem Fortschritt der KI-Technologie wird die Bedeutung klarer und optimierter Kommunikation mit Modellen weiter zunehmen. Probieren Sie diese Strategien noch heute kostenlos aus. FlowHunt ermöglicht es Ihnen, mit verschiedenen KI-Modellen und Funktionen in einem einzigen Dashboard optimierte und effiziente KI-Workflows für jede Aufgabe zu erstellen. Testen Sie die 14-tägige kostenlose Testversion !

Prompt-Optimierung bedeutet, die Eingabe an ein KI-Modell so zu verfeinern, dass die genauesten und effizientesten Antworten geliefert werden. Optimierte Prompts reduzieren den Rechenaufwand, was zu schnelleren Verarbeitungszeiten und geringeren Kosten führt.

Die Token-Anzahl beeinflusst sowohl die Geschwindigkeit als auch die Kosten der KI-Ausgaben. Weniger Tokens führen zu schnelleren Antworten und geringeren Kosten, während prägnante Prompts dem Modell helfen, sich auf relevante Details zu konzentrieren.

Fortgeschrittene Techniken umfassen Few-Shot Learning, Prompt Chaining, kontextuelle Abfrage und Feintuning mit Embeddings. Diese Methoden helfen, komplexe Aufgaben zu bewältigen, dynamische Daten zu integrieren und Antworten auf spezifische Anforderungen zuzuschneiden.

Überwachen Sie die Antwortgenauigkeit, den Token-Verbrauch und die Verarbeitungszeiten. Regelmäßiges Tracking und Iteration anhand von Feedback helfen, Prompts zu verfeinern und die Effizienz aufrechtzuerhalten.

FlowHunt bietet Tools und ein Dashboard zum Erstellen, Testen und Optimieren von KI-Prompts, sodass Sie mit verschiedenen Modellen und Strategien für effiziente KI-Workflows experimentieren können.

Maria ist Copywriterin bei FlowHunt. Als Sprachliebhaberin, die in literarischen Gemeinschaften aktiv ist, weiß sie genau, dass KI die Art und Weise verändert, wie wir schreiben. Anstatt sich dagegen zu wehren, möchte sie helfen, das perfekte Gleichgewicht zwischen KI-Workflows und dem unersetzlichen Wert menschlicher Kreativität zu definieren.

Beginnen Sie mit dem Aufbau optimierter KI-Workflows mit FlowHunt. Experimentieren Sie mit Prompt Engineering und steigern Sie Ihre Produktivität.

Ein Metaprompt in der künstlichen Intelligenz ist eine hochrangige Anweisung, die dazu dient, andere Prompts für große Sprachmodelle (LLMs) zu generieren oder z...

Erfahren Sie, warum Prompt Engineering schnell zu einer unverzichtbaren Fähigkeit für jeden Berufstätigen wird, wie es die Produktivität am Arbeitsplatz verände...

Entdecken Sie gängige Prompt-Engineering-Techniken, um Ihren E-Commerce-Chatbot effektiver auf Kundenfragen antworten zu lassen.

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.