What is the LLM Meta AI component?

The LLM Meta AI component connects the Claude family of model to your Flow. While the Generators and Agents are where the actual magic happens, LLM components allow you to control the used model. All components come with ChatGPT-4 by default. You can connect this component if you wish to change the model or gain more control over it.

Remember that connecting an LLM Component is optional. All components that use an LLM come with ChatGPT-4o as the default. The LLM components allow you to change the model and control model settings.

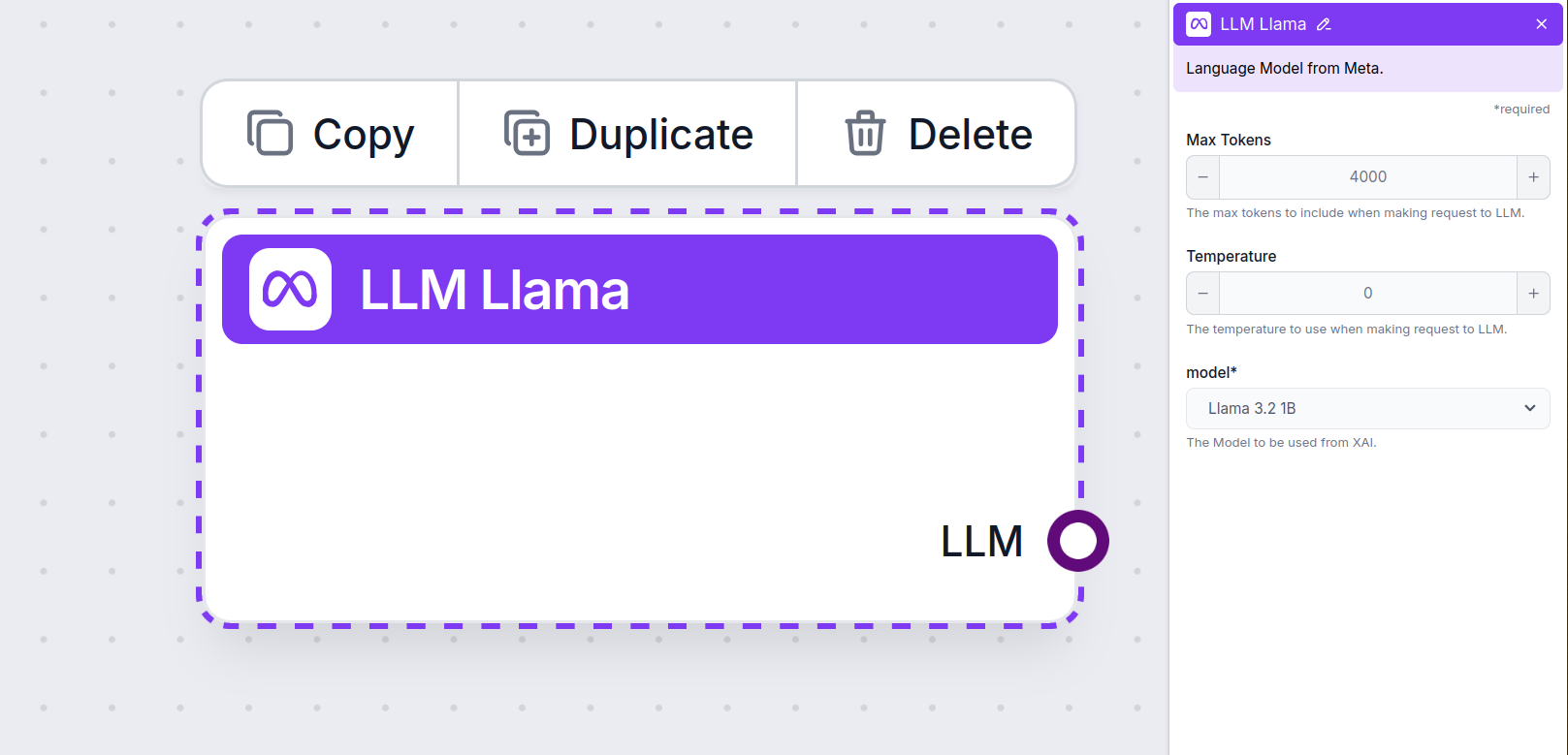

LLM Meta AI Component Settings

Max Tokens

Tokens represent the individual units of text the model processes and generates. Token usage varies with models, and a single token can be anything from words or subwords to a single character. Models are usually priced in millions of tokens.

The max tokens setting limits the total number of tokens that can be processed in a single interaction or request, ensuring the responses are generated within reasonable bounds. The default limit is 4,000 tokens, the optimal size for summarizing documents and several sources to generate an answer.

Temperature

Temperature controls the variability of answers, ranging from 0 to 1.

A temperature of 0.1 will make the responses very to the point but potentially repetitive and deficient.

A high temperature of 1 allows for maximum creativity in answers but creates the risk of irrelevant or even hallucinatory responses.

For example, the recommended temperature for a customer service bot is between 0.2 and 0.5. This level should keep the answers relevant and to the script while allowing for a natural response variation.

Model

This is the model picker. You’ll find all the supported models from Meta AI here. We support Meta’s open-source lightweight Llama models. These models are designed for efficient on-device and edge deployments:

- Llama 3.2 1B – The 1B model contains approximately 1.23 billion parameters, with a context length of up to 128,000 tokens. The model is optimized for tasks such as summarization, instruction following, and rewriting, making them suitable for mobile and embedded device applications. Learn more about this model and how it thinks in this article.

- Llama 3.2. 3B – The 3B model has about 3.21 billion parameters with a context length of up to 128,000 tokens. Learn more about how this model handles various tasks.

How To Add The LLM Meta AI To Your Flow

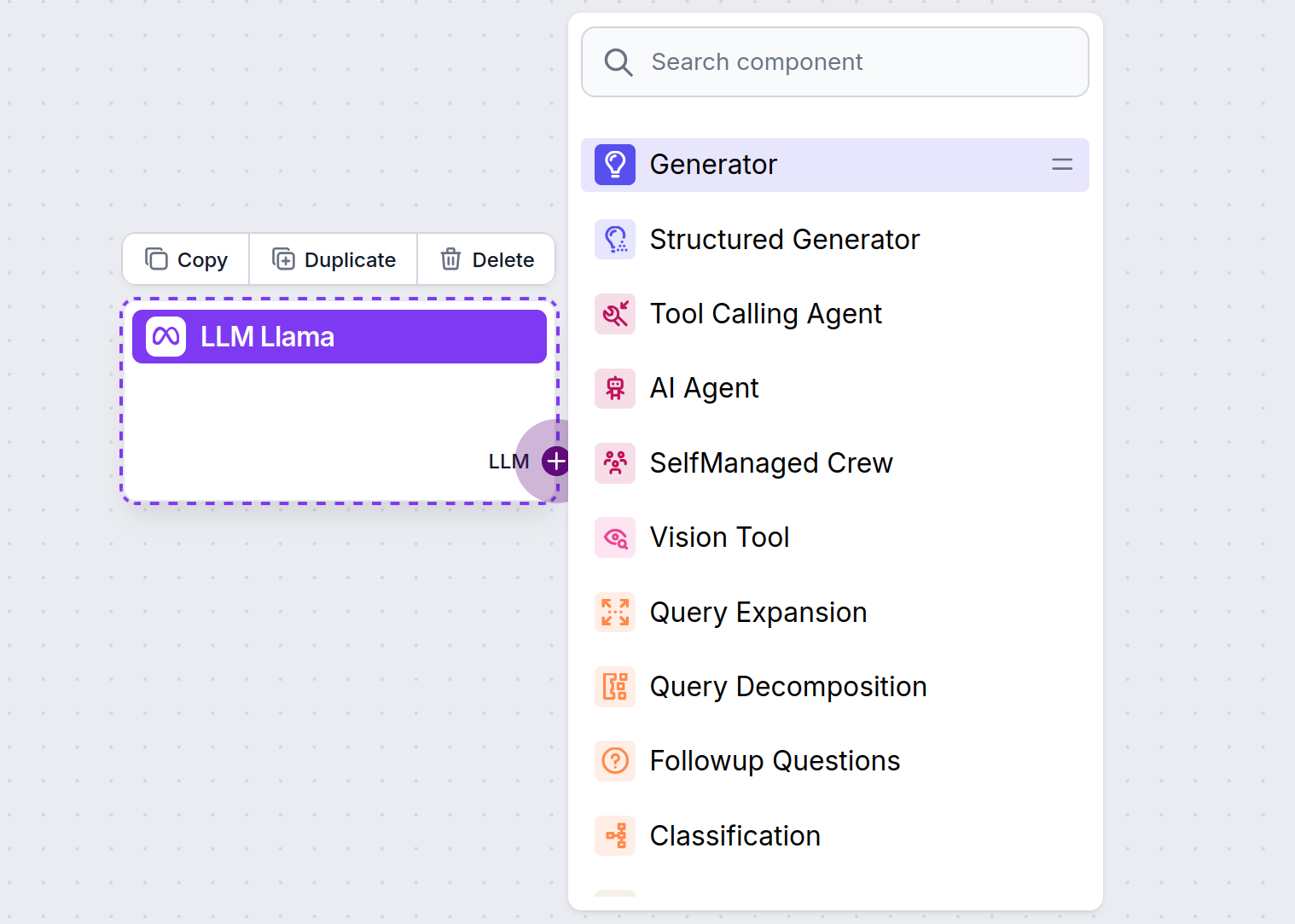

You’ll notice that all LLM components only have an output handle. Input doesn’t pass through the component, as it only represents the model, while the actual generation happens in AI Agents and Generators.

The LLM handle is always purple. The LLM input handle is found on any component that uses AI to generate text or process data. You can see the options by clicking the handle:

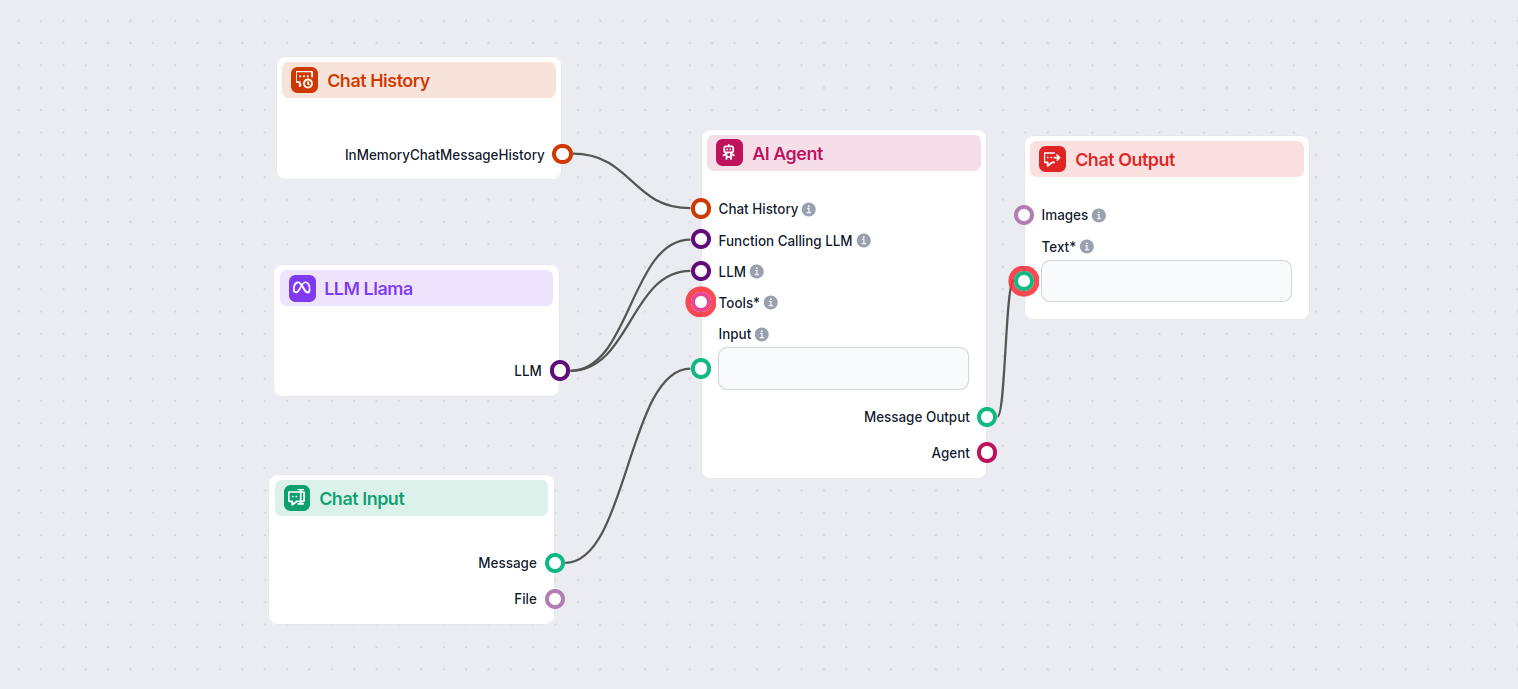

This allows you to create all sorts of tools. Let’s see the component in action. Here’s a simple AI Agent chatbot Flow that’s using Meta AI’s Llama 3.2 1B to generate responses. You can think of it as a basic Llama chatbot.

This simple Chatbot Flow includes:

- Chat input: Represents the message a user sends in chat.

- Chat history: Ensures the chatbot can remember and factor in past responses.

- Chat output: Represent the chatbot’s final response.

- AI Agent: An autonomous AI agent that generates responses.

- LLM Meta AI: The connection to Meta’s text generation models.