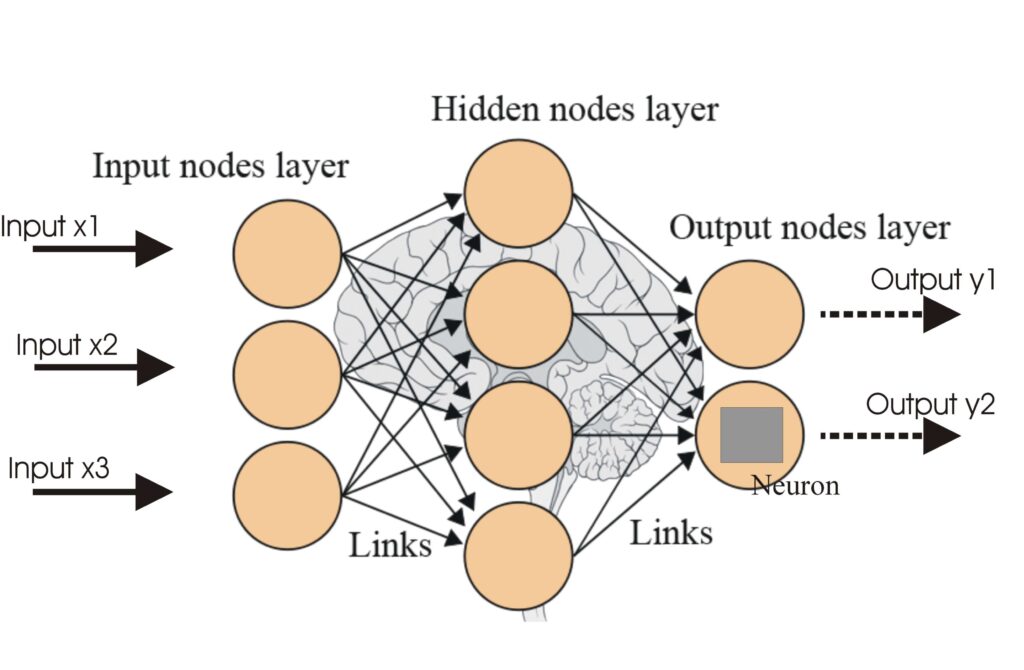

Künstliche Neuronale Netze (ANNs)

Künstliche Neuronale Netze (ANNs) sind eine Untergruppe von Machine-Learning-Algorithmen, die dem menschlichen Gehirn nachempfunden sind. Diese Rechenmodelle be...

RNNs sind neuronale Netzwerke, die für sequentielle Daten entwickelt wurden und mithilfe von Gedächtnis Eingaben verarbeiten und zeitliche Abhängigkeiten erfassen – ideal für NLP, Spracherkennung und Prognosen.

Rekurrente neuronale Netzwerke (RNNs) sind eine fortschrittliche Klasse künstlicher neuronaler Netzwerke, die für die Verarbeitung sequentieller Daten entwickelt wurden. Im Gegensatz zu traditionellen Feedforward-Netzwerken, die Eingaben in einem einzigen Durchgang verarbeiten, verfügen RNNs über einen eingebauten Gedächtnismechanismus, der es ihnen ermöglicht, Informationen über vorherige Eingaben zu behalten. Dadurch eignen sie sich besonders für Aufgaben, bei denen die Reihenfolge der Daten entscheidend ist, wie etwa Sprachmodellierung, Spracherkennung und Zeitreihenprognosen.

RNN steht für Rekurrentes Neuronales Netzwerk. Dieser Typ von neuronalen Netzwerken zeichnet sich dadurch aus, dass er Datenfolgen verarbeiten kann, indem er einen versteckten Zustand aufrechterhält, der bei jedem Zeitschritt basierend auf der aktuellen Eingabe und dem vorherigen versteckten Zustand aktualisiert wird.

Ein rekurrentes neuronales Netzwerk (RNN) ist eine Art künstliches neuronales Netzwerk und spielt eine wichtige Rolle in der KI. Erfahren Sie mehr über Typen, Training und Anwendungen in verschiedenen Branchen.") wobei die Verbindungen zwischen den Knoten einen gerichteten Graphen entlang einer zeitlichen Abfolge bilden. Dies ermöglicht ein dynamisches zeitliches Verhalten für eine Zeitreihe. Im Gegensatz zu Feedforward-Netzwerken können RNNs ihren internen Zustand (Gedächtnis) zur Verarbeitung von Eingabesequenzen verwenden, wodurch sie für Aufgaben wie Handschrifterkennung, Spracherkennung und natürliche Sprachverarbeitung besonders geeignet sind. Entdecken Sie heute die wichtigsten Aspekte, Funktionsweisen und Anwendungen!").

Die Kernidee hinter RNNs ist die Fähigkeit, vergangene Informationen zu speichern und diese zur Beeinflussung der aktuellen Ausgabe zu verwenden. Dies wird durch die Nutzung eines versteckten Zustands erreicht, der bei jedem Zeitschritt aktualisiert wird. Der versteckte Zustand fungiert als eine Form des Gedächtnisses, das Informationen über frühere Eingaben behält. Diese Rückkopplungsschleife ermöglicht es RNNs, Abhängigkeiten in sequentiellen Daten zu erfassen.

Der grundlegende Baustein eines RNN ist die rekurrente Einheit, die aus folgenden Komponenten besteht:

RNNs gibt es in verschiedenen Architekturen, abhängig von der Anzahl der Eingaben und Ausgaben:

RNNs sind äußerst vielseitig und finden in einer Vielzahl von Anwendungen Einsatz:

Feedforward-Netzwerke verarbeiten Eingaben in einem einzigen Durchgang und werden typischerweise für Aufgaben verwendet, bei denen die Reihenfolge der Daten keine Rolle spielt, wie z. B. bei der Bildklassifikation. Im Gegensatz dazu verarbeiten RNNs Sequenzen von Eingaben, wodurch sie zeitliche Abhängigkeiten erfassen und Informationen über mehrere Zeitschritte hinweg behalten können.

Um einige der Einschränkungen traditioneller RNNs zu überwinden, wurden fortgeschrittene Architekturen wie Long Short-Term Memory (LSTM) und Gated Recurrent Unit (GRU) entwickelt. Diese Architekturen besitzen Mechanismen, um langfristige Abhängigkeiten besser zu erfassen und das Problem des verschwindenden Gradienten zu verringern.

Ein rekurrentes neuronales Netzwerk (RNN) ist eine Art künstliches neuronales Netzwerk, das für die Verarbeitung sequentieller Daten entwickelt wurde. Im Gegensatz zu Feedforward-Netzwerken nutzen RNNs das Gedächtnis vorheriger Eingaben, um aktuelle Ausgaben zu beeinflussen, was sie ideal für Aufgaben wie Sprachmodellierung, Spracherkennung und Zeitreihenprognosen macht.

Feedforward-Netzwerke verarbeiten Eingaben in einem Durchgang ohne Gedächtnis, während RNNs Sequenzen von Eingaben verarbeiten und Informationen über mehrere Zeitschritte hinweg behalten, wodurch sie zeitliche Abhängigkeiten erfassen können.

RNNs werden in der Verarbeitung natürlicher Sprache (NLP), Spracherkennung, Zeitreihenprognose, Handschrifterkennung, Chatbots, prädiktivem Text und der Analyse von Finanzmärkten eingesetzt.

RNNs können mit dem Problem des verschwindenden Gradienten kämpfen, was das Erlernen langfristiger Abhängigkeiten erschwert. Außerdem sind sie rechenintensiver als Feedforward-Netzwerke.

Fortschrittliche Architekturen wie Long Short-Term Memory (LSTM) und Gated Recurrent Unit (GRU) wurden entwickelt, um die Einschränkungen von RNNs zu überwinden, insbesondere beim Erlernen langfristiger Abhängigkeiten.

Intelligente Chatbots und KI-Tools unter einem Dach. Verbinden Sie intuitive Bausteine, um Ihre Ideen in automatisierte Flows zu verwandeln.

Künstliche Neuronale Netze (ANNs) sind eine Untergruppe von Machine-Learning-Algorithmen, die dem menschlichen Gehirn nachempfunden sind. Diese Rechenmodelle be...

Ein neuronales Netzwerk, oder künstliches neuronales Netzwerk (KNN), ist ein vom menschlichen Gehirn inspiriertes Rechenmodell, das in KI und maschinellem Lerne...

Backpropagation ist ein Algorithmus zum Trainieren künstlicher neuronaler Netze, indem Gewichte angepasst werden, um den Vorhersagefehler zu minimieren. Erfahre...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.