DeepSeek MCP Server

Der DeepSeek MCP Server integriert DeepSeeks fortschrittliche Sprachmodelle mit MCP-kompatiblen Anwendungen, bietet sicheren, anonymisierten API-Zugang und ermö...

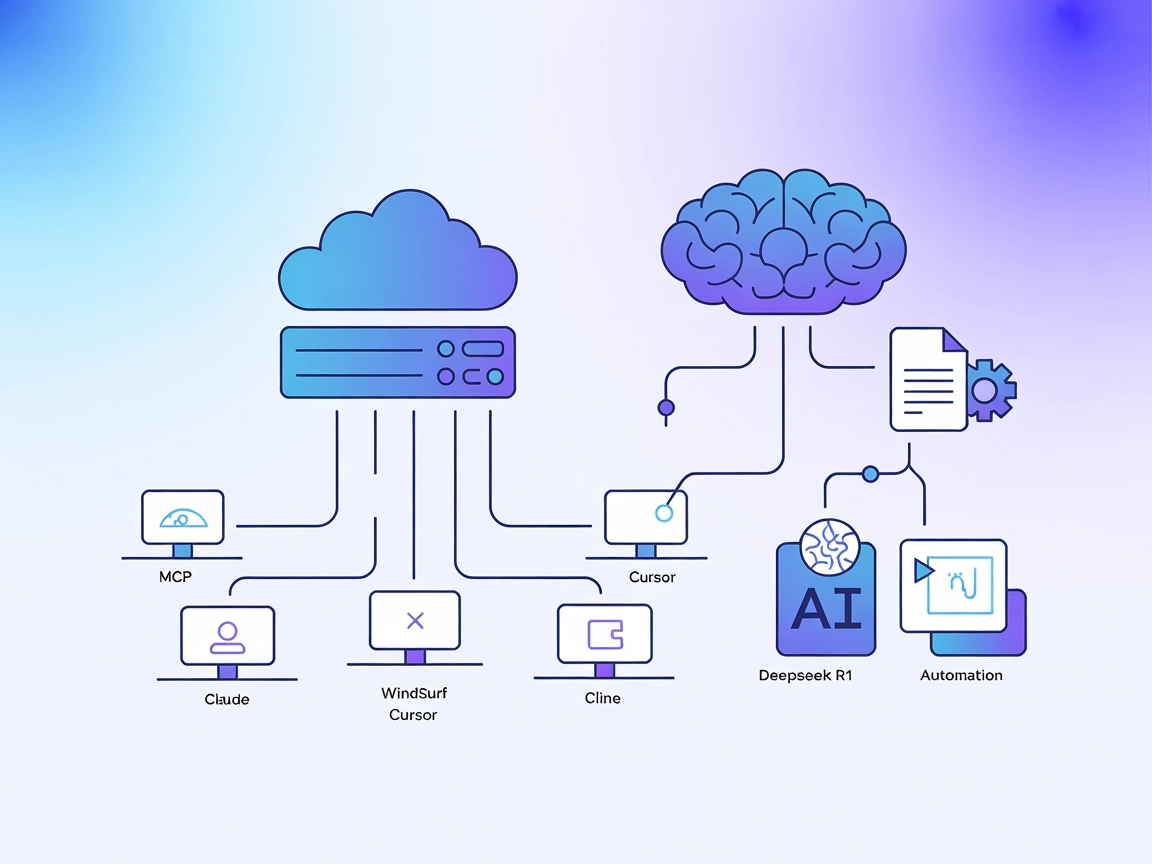

Integrieren Sie DeepSeeks kontextstarke, für Reasoning optimierte Modelle in Ihre KI-Workflows mit dem Deepseek R1 MCP Server für anspruchsvolle Sprachaufgaben und Automatisierung.

FlowHunt bietet eine zusätzliche Sicherheitsschicht zwischen Ihren internen Systemen und KI-Tools und gibt Ihnen granulare Kontrolle darüber, welche Tools von Ihren MCP-Servern aus zugänglich sind. In unserer Infrastruktur gehostete MCP-Server können nahtlos mit FlowHunts Chatbot sowie beliebten KI-Plattformen wie ChatGPT, Claude und verschiedenen KI-Editoren integriert werden.

Der Deepseek R1 MCP Server ist eine Model Context Protocol (MCP) Server-Implementierung, die Claude Desktop mit den fortschrittlichen Sprachmodellen von DeepSeek, wie Deepseek R1 und DeepSeek V3, verbindet. Durch die Funktion als Brücke zwischen KI-Assistenten und den leistungsstarken, auf Reasoning optimierten DeepSeek-Modellen (mit einem 8192-Token-Kontextfenster) ermöglicht dieser Server KI-Agenten verbesserte Aufgaben in natürlichem Sprachverständnis und -generierung. Entwickler können den Deepseek R1 MCP Server nutzen, um diese Modelle nahtlos in ihre Workflows zu integrieren – für fortschrittliche Textgenerierung, Reasoning und Interaktion mit externen Datenquellen oder APIs innerhalb unterstützter Plattformen. Die Implementierung legt Wert auf eine stabile, zuverlässige und effiziente Integration mit Node.js/TypeScript für optimale Kompatibilität und Typsicherheit.

Im Repository sind keine Prompt-Vorlagen dokumentiert.

Es sind keine expliziten MCP-Ressourcen im Repository dokumentiert.

git clone https://github.com/66julienmartin/MCP-server-Deepseek_R1.git

cd deepseek-r1-mcp

npm install

.env.exemple nach .env und tragen Sie Ihren DeepSeek API-Schlüssel ein.{

"mcpServers": {

"deepseek_r1": {

"command": "node",

"args": ["/path/to/deepseek-r1-mcp/build/index.js"],

"env": {

"DEEPSEEK_API_KEY": "your-api-key"

}

}

}

}

{

"mcpServers": {

"deepseek_r1": {

"command": "node",

"args": ["/path/to/deepseek-r1-mcp/build/index.js"],

"env": {

"DEEPSEEK_API_KEY": "your-api-key"

}

}

}

}

{

"mcpServers": {

"deepseek_r1": {

"command": "node",

"args": ["/path/to/deepseek-r1-mcp/build/index.js"],

"env": {

"DEEPSEEK_API_KEY": "your-api-key"

}

}

}

}

{

"mcpServers": {

"deepseek_r1": {

"command": "node",

"args": ["/path/to/deepseek-r1-mcp/build/index.js"],

"env": {

"DEEPSEEK_API_KEY": "your-api-key"

}

}

}

}

Verwenden Sie Umgebungsvariablen in Ihrer Konfiguration, um API-Schlüssel sicher zu speichern:

{

"mcpServers": {

"deepseek_r1": {

"command": "node",

"args": ["/path/to/deepseek-r1-mcp/build/index.js"],

"env": {

"DEEPSEEK_API_KEY": "your-api-key"

}

}

}

}

MCP in FlowHunt nutzen

Um MCP-Server in Ihren FlowHunt-Workflow zu integrieren, fügen Sie die MCP-Komponente zu Ihrem Flow hinzu und verbinden Sie diese mit Ihrem KI-Agenten:

Klicken Sie auf die MCP-Komponente, um das Konfigurationspanel zu öffnen. Fügen Sie im Bereich System-MCP-Konfiguration die Details Ihres MCP-Servers im folgenden JSON-Format ein:

{

"deepseek_r1": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Nach der Konfiguration kann der KI-Agent dieses MCP als Tool mit Zugriff auf alle verfügbaren Funktionen nutzen. Achten Sie darauf, “deepseek_r1” durch den tatsächlichen Namen Ihres MCP Servers zu ersetzen und die URL entsprechend anzupassen.

| Abschnitt | Verfügbarkeit | Details/Hinweise |

|---|---|---|

| Übersicht | ✅ | |

| Liste der Prompts | ⛔ | Keine Prompt-Vorlagen dokumentiert |

| Liste der Ressourcen | ⛔ | Keine expliziten MCP-Ressourcen dokumentiert |

| Liste der Tools | ✅ | Fortgeschrittenes Textgenerierungstool |

| API-Schlüssel absichern | ✅ | Verwendung von Umgebungsvariablen empfohlen |

| Sampling-Unterstützung (weniger wichtig) | ⛔ | Nicht dokumentiert |

| Roots-Unterstützung | ⛔ | Nicht dokumentiert |

Laut der verfügbaren Dokumentation bietet der Deepseek R1 MCP Server eine schlanke, fokussierte Implementierung, die einfach zu konfigurieren und zu nutzen ist, aber keine Dokumentation für Prompts, Ressourcen oder fortgeschrittene MCP-Features wie Roots und Sampling enthält. Damit ist er sehr praktisch für Textgenerierung, aber weniger funktionsreich für komplexe Workflows.

| Hat eine LICENSE | ✅ (MIT) |

|---|---|

| Mindestens ein Tool | ✅ |

| Anzahl Forks | 12 |

| Anzahl Stars | 58 |

Es handelt sich um einen Model Context Protocol (MCP) Server, der als Brücke zwischen Claude Desktop (oder anderen Plattformen) und den fortschrittlichen Sprachmodellen von DeepSeek (R1, V3) fungiert und erweiterte Textgenerierung, Reasoning und Automatisierung in Ihren KI-Workflows ermöglicht.

Der Server unterstützt Deepseek R1 und DeepSeek V3 – beide Modelle sind für große Kontextfenster und komplexe Reasoning-Aufgaben optimiert.

Anwendungsfälle sind fortschrittliche Textgenerierung (Langform, technisch oder kreativ), logikintensive Reasoning-Aufgaben, nahtlose Erweiterung des KI-Assistenten in Claude Desktop sowie Automatisierung der Content-Erstellung oder Wissensverwaltung via API.

Verwenden Sie immer Umgebungsvariablen in Ihrer MCP-Server-Konfiguration, um eine versehentliche Offenlegung Ihres DeepSeek API-Schlüssels zu verhindern.

Im Repository sind keine Prompt-Vorlagen oder spezifische MCP-Ressourcen dokumentiert; der Server konzentriert sich auf den direkten Modellzugriff und die Integration.

DeepSeek R1 bietet ein Kontextfenster mit 8192 Token, sodass auch lange und komplexe Aufgaben bearbeitet werden können.

Ja, es ist MIT-lizenziert und auf GitHub verfügbar.

Schalten Sie fortschrittliche Textgenerierung und Reasoning frei, indem Sie FlowHunt oder Claude Desktop mit den leistungsstarken Modellen von DeepSeek R1 verbinden. Starten Sie noch heute mit intelligenteren Workflows.

Der DeepSeek MCP Server integriert DeepSeeks fortschrittliche Sprachmodelle mit MCP-kompatiblen Anwendungen, bietet sicheren, anonymisierten API-Zugang und ermö...

Der DeepSeek MCP-Server fungiert als sicherer Proxy und verbindet die fortschrittlichen Sprachmodelle von DeepSeek mit MCP-kompatiblen Anwendungen wie Claude De...

Der Deepseek Thinker MCP Server integriert die Deepseek-Modell-Logik in MCP-fähige KI-Clients wie Claude Desktop und liefert fortschrittliche Chain-of-Thought-A...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.