DeepSeek MCP Server

Der DeepSeek MCP Server integriert DeepSeeks fortschrittliche Sprachmodelle mit MCP-kompatiblen Anwendungen, bietet sicheren, anonymisierten API-Zugang und ermö...

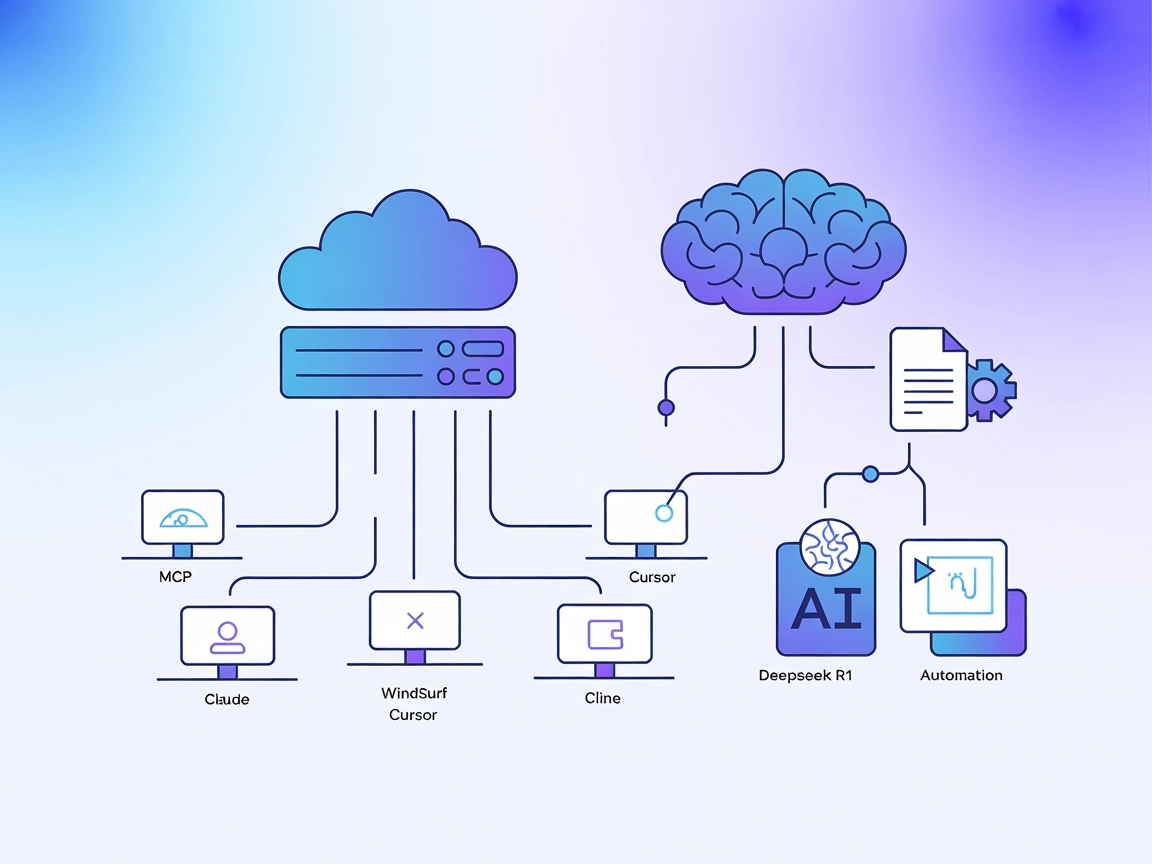

Bringen Sie Deepseeks transparente Logik und Chain-of-Thought-Antworten in Ihre MCP-fähigen Assistenten – mit Unterstützung für Cloud- und lokale Bereitstellungen.

FlowHunt bietet eine zusätzliche Sicherheitsschicht zwischen Ihren internen Systemen und KI-Tools und gibt Ihnen granulare Kontrolle darüber, welche Tools von Ihren MCP-Servern aus zugänglich sind. In unserer Infrastruktur gehostete MCP-Server können nahtlos mit FlowHunts Chatbot sowie beliebten KI-Plattformen wie ChatGPT, Claude und verschiedenen KI-Editoren integriert werden.

Der Deepseek Thinker MCP Server agiert als Model Context Protocol (MCP) Provider und liefert Deepseek-Modelllogik an MCP-fähige KI-Clients wie Claude Desktop. KI-Assistenten können dadurch auf die Denkprozesse und Reasoning-Ausgaben von Deepseek zugreifen – entweder über den Deepseek API-Service oder von einem lokalen Ollama-Server. Die Integration dieses Servers ermöglicht Entwicklern, ihre KI-Workflows mit gezielter Logik zu bereichern – wahlweise über Cloud- oder lokale Inferenz. Besonders nützlich ist der Server für Szenarien, in denen detaillierte Reasoning-Chains („Chain of Thought“-Ausgaben) zur Unterstützung nachgelagerter KI-Aufgaben benötigt werden – ideal für fortgeschrittene Entwicklung, Debugging und die Anreicherung von KI-Agenten.

Im Repository oder in der Dokumentation sind keine expliziten Prompt-Vorlagen genannt.

In der Dokumentation oder im Code sind keine expliziten MCP-Ressourcen aufgeführt.

originPrompt (String) — Der ursprüngliche Prompt des Nutzers.windsurf_config.json).mcpServers hinzu:{

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Ihr API Key>",

"BASE_URL": "<Ihre Base URL>"

}

}

}

claude_desktop_config.json.{

"mcpServers": {

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Ihr API Key>",

"BASE_URL": "<Ihre Base URL>"

}

}

}

}

{

"mcpServers": {

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Ihr API Key>",

"BASE_URL": "<Ihre Base URL>"

}

}

}

}

{

"mcpServers": {

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Ihr API Key>",

"BASE_URL": "<Ihre Base URL>"

}

}

}

}

Für alle Plattformen sollten API-Keys und sensible Konfigurationswerte über Umgebungsvariablen im Abschnitt env angegeben werden. Beispiel:

{

"mcpServers": {

"deepseek-thinker": {

"command": "npx",

"args": [

"-y",

"deepseek-thinker-mcp"

],

"env": {

"API_KEY": "<Ihr API Key>",

"BASE_URL": "<Ihre Base URL>"

}

}

}

}

Für den lokalen Ollama-Modus setzen Sie USE_OLLAMA auf "true" im env-Objekt:

"env": {

"USE_OLLAMA": "true"

}

MCP in FlowHunt verwenden

Um MCP-Server in Ihren FlowHunt-Workflow zu integrieren, fügen Sie zunächst die MCP-Komponente zu Ihrem Flow hinzu und verbinden Sie sie mit Ihrem KI-Agenten:

Klicken Sie auf die MCP-Komponente, um das Konfigurationspanel zu öffnen. Im System-MCP-Konfigurationsbereich tragen Sie Ihre MCP-Server-Daten im folgenden JSON-Format ein:

{

"deepseek-thinker": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Nach der Konfiguration kann der KI-Agent dieses MCP als Tool nutzen und hat Zugriff auf alle seine Funktionen. Denken Sie daran, “deepseek-thinker” durch Ihren tatsächlichen MCP-Servernamen und die korrekte URL zu ersetzen.

| Abschnitt | Verfügbar | Details/Hinweise |

|---|---|---|

| Übersicht | ✅ | |

| Liste der Prompts | ⛔ | Keine Prompt-Vorlagen dokumentiert |

| Liste der Ressourcen | ⛔ | Keine expliziten MCP-Ressourcen gefunden |

| Liste der Tools | ✅ | get-deepseek-thinker Tool |

| Sichere API-Schlüssel | ✅ | Umgebungsvariablen in der Konfiguration |

| Sampling Support (weniger relevant für Bewertung) | ⛔ | Nicht erwähnt |

Basierend auf den beiden Tabellen bietet der Deepseek Thinker MCP Server ein fokussiertes Tool zur Reasoning-Integration, ist einfach einzurichten, aber es fehlen detaillierte Prompt-Vorlagen und explizite Ressourcendefinitionen. Das Projekt ist Open Source, hat eine moderate Community und unterstützt sichere Credential-Verwaltung. Die Gesamtbewertung liegt bei 6/10 für Vollständigkeit und Nutzen als MCP-Server.

| Hat eine LICENSE | ⛔ (Keine LICENSE-Datei gefunden) |

|---|---|

| Mindestens ein Tool | ✅ |

| Anzahl Forks | 12 |

| Anzahl Sterne | 51 |

Es handelt sich um einen Model Context Protocol Server, der Deepseek-Modelllogik für MCP-fähige KI-Clients bereitstellt und Chain-of-Thought-Ausgaben sowie transparente Modell-Logik für fortgeschrittene KI-Workflows und Debugging liefert.

Er bietet das Tool 'get-deepseek-thinker' zur Durchführung von Reasoning mit dem Deepseek-Modell und zur Ausgabe strukturierter Reasoning-Ergebnisse.

Ja, Deepseek Thinker unterstützt sowohl Cloud-basierte als auch lokale (Ollama) Inferenz. Setzen Sie die Umgebungsvariable 'USE_OLLAMA' auf 'true' für den lokalen Modus.

API-Schlüssel und sensible Werte sollten im Abschnitt 'env' Ihrer MCP-Server-Konfiguration als Umgebungsvariablen gespeichert und nicht im Quellcode hinterlegt werden.

Die Limits werden vom zugrunde liegenden Deepseek-Modell oder der API bestimmt; bei Überschreitung können Antworten gekürzt werden oder Fehler auftreten. Passen Sie daher Ihre Konfiguration und Eingaben entsprechend an.

Es werden keine expliziten Prompt-Vorlagen oder zusätzlichen MCP-Ressourcen in der aktuellen Deepseek Thinker MCP Server-Dokumentation bereitgestellt.

Integrieren Sie den Deepseek Thinker MCP Server, um Ihren KI-Agenten detaillierte Logikfähigkeiten zu verleihen und Entwicklungsworkflows zu optimieren.

Der DeepSeek MCP Server integriert DeepSeeks fortschrittliche Sprachmodelle mit MCP-kompatiblen Anwendungen, bietet sicheren, anonymisierten API-Zugang und ermö...

Der DeepSeek MCP-Server fungiert als sicherer Proxy und verbindet die fortschrittlichen Sprachmodelle von DeepSeek mit MCP-kompatiblen Anwendungen wie Claude De...

Der Deepseek R1 MCP Server ermöglicht die nahtlose Integration fortschrittlicher Sprachmodelle von DeepSeek, wie Deepseek R1 und V3, in Claude Desktop und ander...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.