ModelContextProtocol (MCP) Server-Integration

Der ModelContextProtocol (MCP) Server fungiert als Brücke zwischen KI-Agenten und externen Datenquellen, APIs und Diensten und ermöglicht FlowHunt-Nutzern den A...

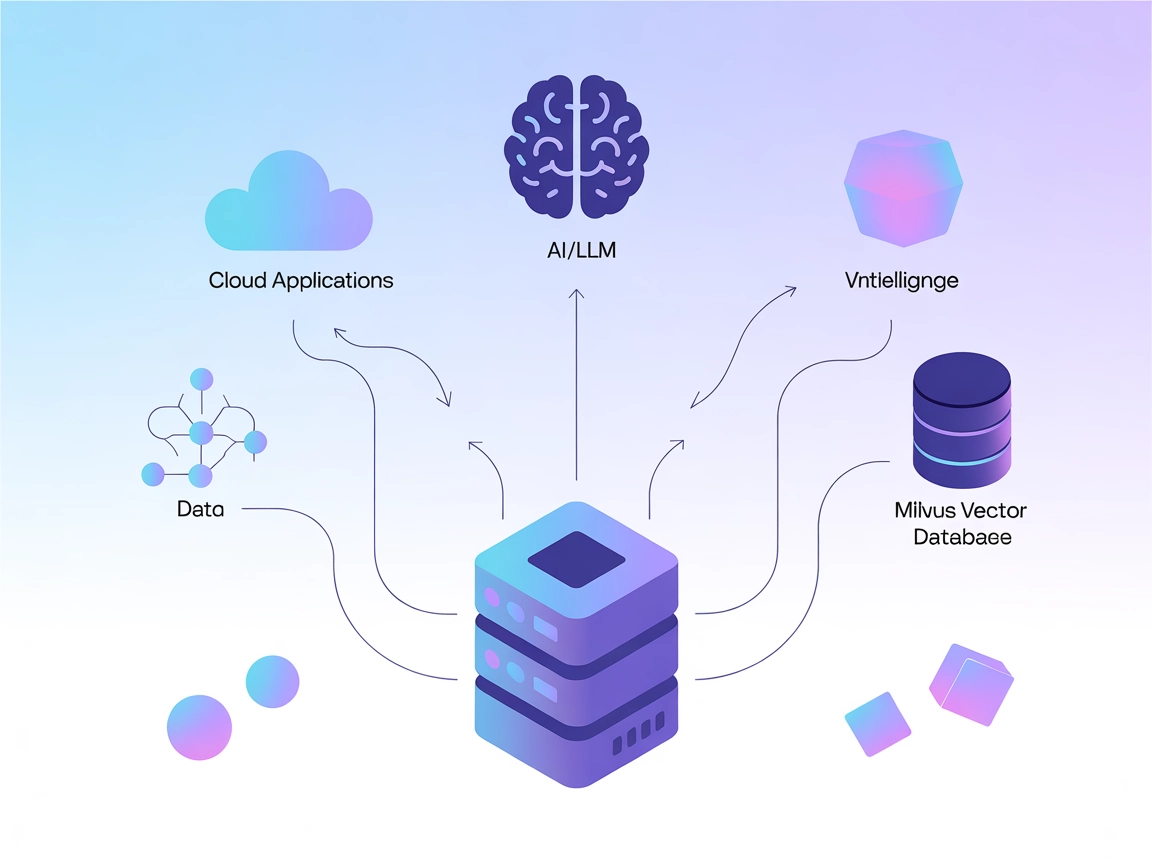

Verbinden Sie LLMs und KI-Agenten mit Milvus für leistungsstarke Vektorsuche, kontextbezogenes Gedächtnis und datengesteuerte Empfehlungen direkt in Ihren FlowHunt-Workflows.

FlowHunt bietet eine zusätzliche Sicherheitsschicht zwischen Ihren internen Systemen und KI-Tools und gibt Ihnen granulare Kontrolle darüber, welche Tools von Ihren MCP-Servern aus zugänglich sind. In unserer Infrastruktur gehostete MCP-Server können nahtlos mit FlowHunts Chatbot sowie beliebten KI-Plattformen wie ChatGPT, Claude und verschiedenen KI-Editoren integriert werden.

Der Milvus MCP (Model Context Protocol) Server verbindet KI-Assistenten und LLM-basierte Anwendungen mit der Milvus-Vektordatenbank. Dadurch wird eine nahtlose Interaktion zwischen Sprachmodellen und großskaligen Vektordaten möglich und ein standardisierter Zugriff, eine Abfrage und Verwaltung von Milvus direkt aus KI-Workflows bereitgestellt. Mit dem Milvus MCP Server können Entwickler Milvus-basierte Such-, Abfrage- und Datenmanagement-Funktionen direkt in ihre KI-Agenten, IDEs oder Chat-Oberflächen integrieren. Der Server unterstützt mehrere Kommunikationsmodi (stdio und Server-Sent Events) und passt so zu verschiedenen Deployments und Entwicklungsumgebungen. Durch die Verbindung von LLMs und Milvus wird die Fähigkeit von KI-Systemen zur kontextsensitiven Arbeit mit hochdimensionalen Daten deutlich erweitert – für reichhaltigere und intelligentere KI-Erlebnisse auf LLM-Basis.

Im Repository sind keine Informationen zu Prompt-Vorlagen vorhanden.

In der verfügbaren Dokumentation oder im Code wird keine explizite Liste von Model Context Protocol „resources“ beschrieben.

In der verfügbaren Dokumentation oder in Code-Dateien, einschließlich server.py, ist keine explizite Tool-Liste oder Funktionsnamen dokumentiert.

git clone https://github.com/zilliztech/mcp-server-milvus.gituv run src/mcp_server_milvus/server.py --milvus-uri http://localhost:19530{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

Absichern von API-Keys:

Falls der Server sensible Daten benötigt, nutzen Sie Umgebungsvariablen:

{

"env": {

"MILVUS_URI": "http://localhost:19530"

},

"inputs": {}

}

{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

Zugangsdaten sichern über Umgebungsvariablen wie oben gezeigt.

uv.uv run src/mcp_server_milvus/server.py --milvus-uri http://localhost:19530{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

Absicherung von API-Schlüsseln:

Nutzen Sie Umgebungsvariablen wie oben.

uv.{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

Umgebungsvariablen:

{

"env": {

"MILVUS_URI": "http://localhost:19530"

}

}

MCP in FlowHunt nutzen

Um MCP-Server in Ihren FlowHunt-Workflow zu integrieren, fügen Sie die MCP-Komponente zu Ihrem Flow hinzu und verbinden sie mit Ihrem KI-Agenten:

Klicken Sie auf die MCP-Komponente, um das Konfigurationspanel zu öffnen. Im Bereich System-MCP-Konfiguration fügen Sie Ihre MCP-Serverdaten in diesem JSON-Format ein:

{

"milvus-mcp": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Nach der Konfiguration kann der KI-Agent diesen MCP als Tool mit Zugriff auf alle Funktionen und Fähigkeiten nutzen. Denken Sie daran, “milvus-mcp” durch den tatsächlichen Namen Ihres MCP-Servers zu ersetzen und die URL entsprechend anzupassen.

| Abschnitt | Verfügbarkeit | Details/Anmerkungen |

|---|---|---|

| Übersicht | ✅ | |

| Liste der Prompts | ⛔ | Keine Prompt-Vorlagen dokumentiert |

| Liste der Ressourcen | ⛔ | Keine explizite MCP-Ressourcenliste |

| Liste der Tools | ⛔ | Keine expliziten Tools in verfügbaren Dateien gelistet |

| Absicherung von API-Keys | ✅ | Nutzt Umgebungsvariablen, dokumentiert in Setup-Beispielen |

| Sampling-Support (weniger wichtig bei Bewertung) | ⛔ | Nicht erwähnt |

Roots-Support: Nicht erwähnt

Sampling-Support: Nicht erwähnt

Der Milvus MCP Server ist eine praktische und fokussierte Brücke, um LLMs mit Milvus zu verbinden – mit klaren Anleitungen für beliebte Entwickler-Tools. Allerdings fehlt es der Dokumentation an Details zu MCP-Ressourcen, Prompts und nutzbaren Tool-APIs, was die Out-of-the-Box-Auffindbarkeit einschränkt. Dennoch ist er eine solide Basis für vektorbasierte KI-Integrationen.

| Hat eine LICENSE | ✅ (Apache-2.0) |

|---|---|

| Hat mindestens ein Tool | ⛔ |

| Anzahl der Forks | 32 |

| Anzahl der Sterne | 139 |

Insgesamt: 4/10

Der Server ist nützlich für seine Nische, würde jedoch stark von expliziterer Dokumentation zu Ressourcen, Prompt-Vorlagen und Tool-APIs profitieren – für maximale Interoperabilität und Benutzerfreundlichkeit.

Der Milvus MCP Server verbindet KI-Assistenten und LLM-Anwendungen mit der Milvus-Vektordatenbank und ermöglicht nahtlose Vektorsuche, kontextbezogenes Gedächtnis und Datenmanagement für fortgeschrittene KI-Workflows.

Zentrale Anwendungsfälle sind Vektorsuche, Embedding-Management, kontextbezogenes Chatbot-Gedächtnis, KI-gestützte Empfehlungen und Echtzeitanalyse mit Milvus in FlowHunt.

Verwenden Sie Umgebungsvariablen (z.B. MILVUS_URI) zur Speicherung sensibler Verbindungsdaten, wie in den Setup-Anleitungen für jeden unterstützten Client gezeigt.

Es sind keine expliziten Prompt-Vorlagen oder Tool-APIs dokumentiert. Der Server konzentriert sich auf die Bereitstellung einer Brücke für Vektoroperationen und das Embedding-Management.

Es ist eine solide Grundlage, um LLMs mit Vektordatenbanken zu verbinden, mit klaren Installationsanleitungen, aber es wäre wünschenswert, mehr Dokumentation zu Prompts und Tool-APIs für eine leichtere Auffindbarkeit und Integration zu erhalten.

Erweitern Sie Ihre KI-Agenten um nahtlosen Zugriff auf Vektordatenbanken und ermöglichen Sie intelligentere Suche, Empfehlungen und kontextbezogenes Gedächtnis. Integrieren Sie jetzt den Milvus MCP Server mit FlowHunt!

Der ModelContextProtocol (MCP) Server fungiert als Brücke zwischen KI-Agenten und externen Datenquellen, APIs und Diensten und ermöglicht FlowHunt-Nutzern den A...

Der Model Context Protocol (MCP) Server verbindet KI-Assistenten mit externen Datenquellen, APIs und Diensten und ermöglicht so eine optimierte Integration komp...

Der Patronus MCP Server vereinfacht die LLM-Evaluierung und -Experimentation für Entwickler und Forscher, bietet Automatisierung, Batch-Processing und eine robu...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.