Model Context Protocol (MCP) Server

Der Model Context Protocol (MCP) Server verbindet KI-Assistenten mit externen Datenquellen, APIs und Diensten und ermöglicht so eine optimierte Integration komp...

Der UnifAI MCP Server verbindet KI-Agenten mit externen APIs und Diensten für erweiterte Automatisierung, allerdings ist die aktuelle Dokumentation spärlich.

FlowHunt bietet eine zusätzliche Sicherheitsschicht zwischen Ihren internen Systemen und KI-Tools und gibt Ihnen granulare Kontrolle darüber, welche Tools von Ihren MCP-Servern aus zugänglich sind. In unserer Infrastruktur gehostete MCP-Server können nahtlos mit FlowHunts Chatbot sowie beliebten KI-Plattformen wie ChatGPT, Claude und verschiedenen KI-Editoren integriert werden.

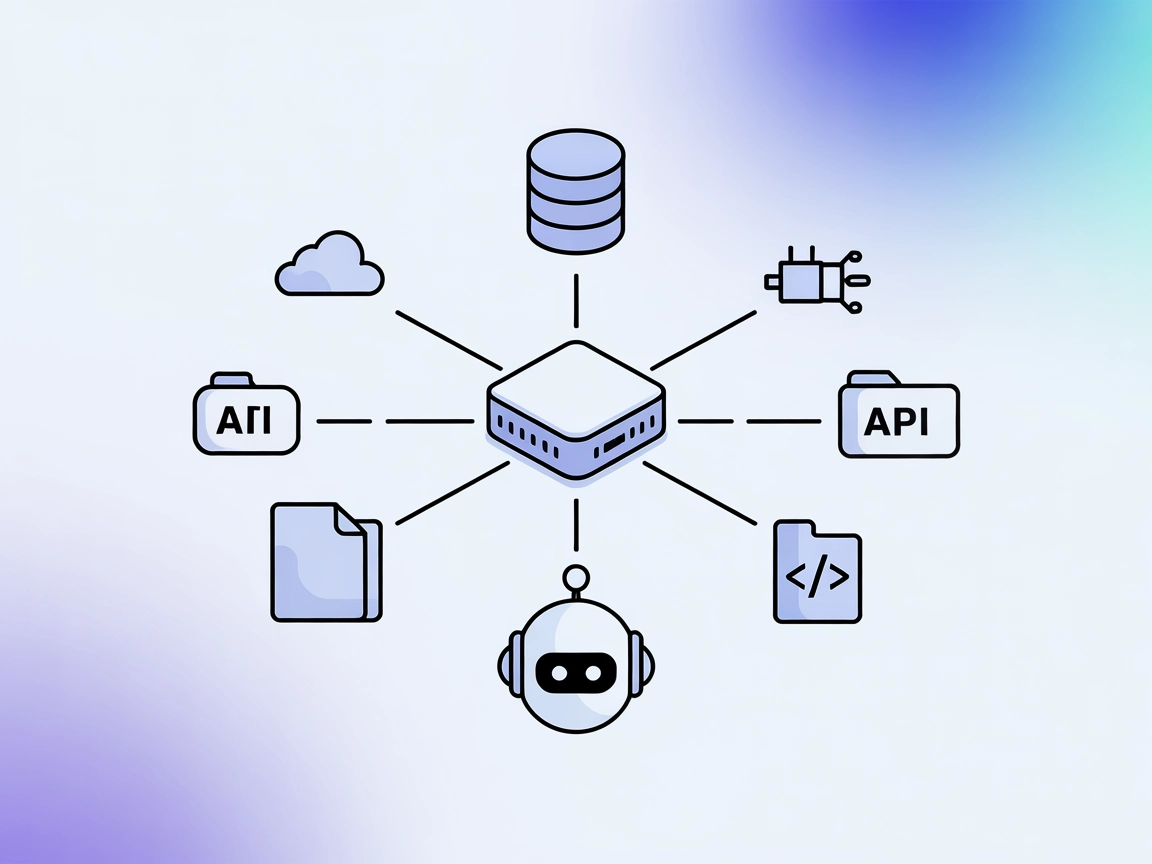

Der UnifAI MCP (Model Context Protocol) Server ist Teil des UnifAI SDK-Ökosystems und wurde entwickelt, um KI-Assistenten mit externen Datenquellen, APIs und Diensten zu verbinden, um Entwicklungs-Workflows zu verbessern. Als Brücke ermöglicht der UnifAI MCP Server KI-gestützten Tools und Agenten Aufgaben wie Datenbankabfragen, Dateioperationen und API-Interaktionen nahtlos durchzuführen. Dies erweitert die Fähigkeiten von KI-Assistenten und erlaubt es Entwicklern, komplexe Abläufe zu automatisieren, externe Aktionen zu orchestrieren und zentrale Interaktionen zwischen KI und realen Systemen zu standardisieren. UnifAI MCP Server sind als Python- und TypeScript-Implementierungen Teil der UnifAI SDKs verfügbar.

Im Repository wurden keine Informationen zu Prompt-Vorlagen gefunden.

Im Repository wurden keine Informationen zu spezifischen Ressourcen, die vom UnifAI MCP Server bereitgestellt werden, gefunden.

Im Repository wurden keine Informationen zu spezifischen Tools, die vom UnifAI MCP Server zur Verfügung gestellt werden, gefunden.

Im Repository wurden keine expliziten Anwendungsfälle angegeben. Basierend auf den allgemeinen MCP-Server-Fähigkeiten sind jedoch folgende Beispiele denkbar:

Im Repository wurden keine Anleitungen oder Konfigurationsbeispiele für Windsurf, Claude, Cursor oder Cline gefunden.

MCP in FlowHunt verwenden

Um MCP-Server in Ihren FlowHunt-Workflow zu integrieren, fügen Sie zunächst die MCP-Komponente zu Ihrem Flow hinzu und verbinden Sie sie mit Ihrem KI-Agenten:

Klicken Sie auf die MCP-Komponente, um das Konfigurationsfeld zu öffnen. Im Abschnitt System-MCP-Konfiguration tragen Sie Ihre MCP-Server-Daten in folgendem JSON-Format ein:

{

"MCP-Name": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Nach der Konfiguration kann der KI-Agent diesen MCP als Tool mit Zugriff auf alle Funktionen und Möglichkeiten nutzen. Denken Sie daran, „MCP-Name“ durch den tatsächlichen Namen Ihres MCP-Servers zu ersetzen (z.B. „github-mcp“, „weather-api“ etc.) und die URL durch Ihre eigene MCP-Server-URL auszutauschen.

| Abschnitt | Verfügbarkeit | Details/Anmerkungen |

|---|---|---|

| Übersicht | ✅ | Aus Repository und verknüpften SDKs abgeleitet |

| Liste der Prompts | ⛔ | Keine Prompt-Vorlagen gefunden |

| Liste der Ressourcen | ⛔ | Keine Ressourcen gefunden |

| Liste der Tools | ⛔ | Keine Tools gefunden |

| API-Key-Sicherheit | ⛔ | Keine Details gefunden |

| Sampling-Unterstützung (weniger relevant) | ⛔ | Keine Details gefunden |

Im Repository finden sich keine Informationen zu Roots oder Sampling-Unterstützung.

Aufgrund fehlender konkreter Informationen und Dokumentation ist die Nutzbarkeit des UnifAI MCP Servers aus Entwicklersicht derzeit eingeschränkt. Das Konzept ist vielversprechend, aber das Fehlen von Details zu Tools, Prompts, Ressourcen und Einrichtung mindert die praktische Bewertung.

| Hat eine LICENSE | ⛔ |

|---|---|

| Mindestens ein Tool | ⛔ |

| Anzahl Forks | 3 |

| Anzahl Stars | 3 |

Insgesamt erhält dieser MCP Server eine Bewertung von 2/10 für Nutzbarkeit und Dokumentation. Die Grundidee ist solide, aber ohne Details zu Einrichtung, Nutzung oder Implementierung ist er für Entwickler aktuell nicht praktikabel.

Der UnifAI MCP Server ist Teil des UnifAI SDK und wurde entwickelt, um KI-Assistenten mit externen Datenquellen, APIs und Diensten zu verbinden, sodass Automatisierung und Workflow-Orchestrierung für Entwickler möglich werden.

Potenzielle Anwendungsfälle umfassen die Integration mit APIs für die Datenabfrage, die Automatisierung des Datenbankmanagements, Codebase-Exploration, Dateimanagement, die Orchestrierung mehrstufiger Workflows und die Standardisierung von LLM-Interaktionen. Allerdings werden in der aktuellen Dokumentation keine konkreten Beispiele genannt.

Um den UnifAI MCP Server in FlowHunt zu nutzen, fügen Sie die MCP-Komponente zu Ihrem Flow hinzu und konfigurieren Sie sie mit der URL Ihres MCP-Servers in der System-MCP-Konfiguration im bereitgestellten JSON-Format. Ersetzen Sie den Platzhalter durch Ihre tatsächlichen Serverdaten.

Im aktuellen Repository sind keine spezifischen Tools, Ressourcen oder Prompt-Vorlagen dokumentiert, was den unmittelbaren Nutzen einschränkt.

Benutzerfreundlichkeit und Dokumentation werden momentan als niedrig (2/10) eingestuft, da es nur begrenzte praktische Informationen für Entwickler gibt, die diesen Server integrieren oder nutzen möchten.

Der Model Context Protocol (MCP) Server verbindet KI-Assistenten mit externen Datenquellen, APIs und Diensten und ermöglicht so eine optimierte Integration komp...

Der UNS-MCP Server verbindet KI-Assistenten und Entwicklungs-Workflows mit externen Datenquellen über die Unstructured API. So ermöglicht er die automatisierte ...

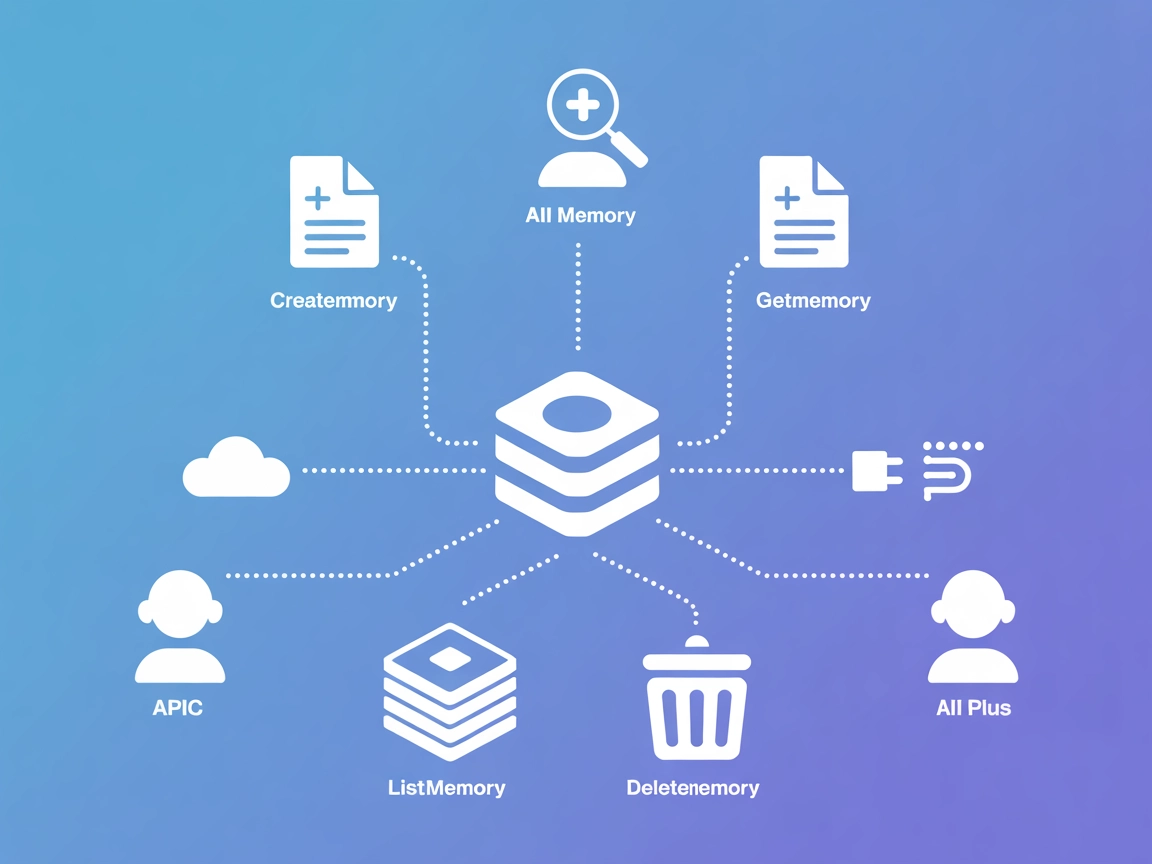

Der StitchAI MCP Server ermöglicht kontextbezogenes Speichermanagement für KI-Agenten, sodass diese strukturiertes Wissen effizient speichern, abrufen und organ...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.