Introducción

El panorama de los medios generativos ha experimentado una transformación notable en los últimos años, evolucionando de proyectos experimentales de investigación a un mercado de infraestructura multimillonario. Lo que comenzó como modelos especializados de generación de imágenes se ha expandido hacia un ecosistema integral que abarca síntesis de imágenes, creación de video, generación de audio y capacidades avanzadas de edición. Esta historia técnica explora cómo empresas como FAL construyeron un negocio con más de $100 millones en ingresos al identificar una brecha crítica en el mercado: los desarrolladores necesitaban infraestructura de inferencia optimizada y escalable, diseñada específicamente para modelos de medios generativos, no simplemente orquestación genérica de GPU ni alojamiento de modelos de lenguaje. El recorrido desde Stable Diffusion 1.5 hasta modelos modernos de video como Veo3 revela importantes lecciones sobre posicionamiento de mercado, especialización técnica y los requisitos de infraestructura que permiten a las aplicaciones de IA escalar de prototipos de investigación a sistemas en producción que sirven a millones de desarrolladores.

Qué son los medios generativos y por qué son importantes

Los medios generativos representan una categoría fundamentalmente diferente de inteligencia artificial en comparación con los grandes modelos de lenguaje que han dominado los titulares recientes. Mientras que los modelos de lenguaje procesan texto y generan respuestas basadas en patrones aprendidos, los sistemas de medios generativos crean contenido visual y sonoro—imágenes, videos, música y efectos de sonido—a partir de descripciones en texto, imágenes existentes u otras modalidades de entrada. Esta distinción es más que semántica; refleja profundas diferencias en los requisitos técnicos, la dinámica de mercado y las oportunidades de negocio. Los modelos de medios generativos operan bajo diferentes restricciones computacionales, requieren técnicas de optimización especializadas y sirven casos de uso que la infraestructura tradicional de modelos de lenguaje no puede manejar de manera eficiente. El auge de los medios generativos ha creado una categoría completamente nueva de empresas de infraestructura centradas específicamente en optimizar la inferencia para estos modelos, permitiendo a los desarrolladores integrar sofisticadas capacidades de generación de imagen y video en sus aplicaciones sin tener que gestionar complejos despliegues de GPU ni lidiar con una utilización ineficiente de recursos.

Los requisitos técnicos para la inferencia de medios generativos difieren significativamente de los del servicio de modelos de lenguaje. Modelos de generación de imágenes como Stable Diffusion y Flux operan mediante procesos de difusión iterativos que requieren una gestión cuidadosa de la memoria, optimización precisa del tiempo y procesamiento eficiente por lotes. La generación de video añade otra capa de complejidad, requiriendo consistencia temporal, sincronización de audio y recursos computacionales mucho mayores. Estos requisitos no pueden abordarse eficientemente con plataformas genéricas de orquestación de GPU ni servicios de inferencia para modelos de lenguaje. En cambio, demandan infraestructura especializada diseñada desde cero para manejar las características únicas de los modelos de difusión, generación autoregresiva de imágenes y síntesis de video. Las compañías que identificaron esta brecha desde el inicio—y que invirtieron en construir una infraestructura diseñada a propósito—se posicionaron para capturar una porción significativa del mercado a medida que la adopción de medios generativos se aceleró en diferentes industrias.

¿Listo para hacer crecer tu negocio?

Comienza tu prueba gratuita hoy y ve resultados en días.

El caso de negocio para la especialización: por qué medios generativos y no modelos de lenguaje

La decisión de especializarse en medios generativos en lugar de seguir el camino aparentemente más obvio del alojamiento de modelos de lenguaje representa una de las elecciones estratégicas más trascendentales en la reciente historia de la infraestructura de IA. Cuando los fundadores de FAL evaluaron sus opciones alrededor de 2022-2023, se enfrentaron a un punto crítico: ¿debían expandir su runtime de Python hacia una plataforma de inferencia de modelos de lenguaje de propósito general, o debían apostar por el emergente espacio de medios generativos? La respuesta revela valiosos aprendizajes sobre la dinámica de mercado, el posicionamiento competitivo y la importancia de elegir batallas donde se puede ganar. El alojamiento de modelos de lenguaje, aunque atractivo por la atención y financiación masiva que recibían los grandes modelos de lenguaje, presentaba un panorama competitivo imposible. OpenAI ya había establecido a GPT como el modelo dominante, con una enorme base de usuarios y un flujo de ingresos consolidado. Anthropic estaba construyendo Claude con un respaldo considerable y talento técnico de primer nivel. Google, Microsoft y otros gigantes tecnológicos invertían miles de millones en sus propias infraestructuras de modelos de lenguaje. Para una startup, competir en este espacio significaba desafiar directamente a compañías con recursos infinitamente superiores, posiciones de mercado establecidas y la capacidad de ofrecer acceso a modelos de lenguaje a coste o incluso con pérdidas si beneficiaba a sus intereses estratégicos.

El mercado de medios generativos, en cambio, presentaba una dinámica competitiva fundamentalmente diferente. Cuando Stable Diffusion 1.5 fue lanzado en 2022, creó una necesidad inmediata de infraestructura de inferencia optimizada, pero ningún actor dominante había surgido aún en este espacio. El modelo era de código abierto, lo que permitía a cualquiera descargarlo y ejecutarlo, pero la mayoría de los desarrolladores carecían de la experiencia o los recursos para optimizarlo eficazmente. Esto creó la oportunidad perfecta para que surgiera una empresa de infraestructura especializada. FAL reconoció que los desarrolladores querían usar estos modelos pero no deseaban gestionar la complejidad del despliegue de GPU, la optimización de modelos y el escalado. Al enfocarse exclusivamente en medios generativos, FAL podía convertirse en el experto de este dominio específico, construir relaciones profundas con creadores de modelos y desarrolladores, y establecerse como la plataforma de referencia para la inferencia de medios generativos. Esta estrategia de especialización resultó notablemente exitosa, permitiendo a FAL pasar de un punto de inflexión a una compañía que sirve a 2 millones de desarrolladores y aloja más de 350 modelos, con ingresos que superan los $100 millones anuales.

Comprendiendo la infraestructura y optimización de medios generativos

La base técnica de las plataformas modernas de medios generativos descansa sobre una optimización de inferencia sofisticada que va mucho más allá de simplemente ejecutar modelos en GPUs. Cuando los desarrolladores comenzaron a usar Stable Diffusion 1.5, muchos intentaron desplegarlo ellos mismos utilizando infraestructura genérica en la nube o GPUs locales. Este enfoque reveló ineficiencias críticas: los modelos no estaban optimizados para el hardware específico en el que se ejecutaban, se desperdiciaba memoria por lotes ineficientes y las tasas de utilización eran bajas porque la carga de trabajo de cada usuario estaba aislada. Un desarrollador podía usar solo el 20-30% de la capacidad de su GPU mientras pagaba el 100%. Este desperdicio creó la oportunidad para una plataforma que pudiera agregar la demanda de muchos usuarios, optimizar la inferencia para configuraciones de hardware específicas y lograr tasas de utilización mucho más altas mediante el procesamiento inteligente por lotes y la programación eficiente. El enfoque de FAL implicó el desarrollo de kernels CUDA personalizados—código de bajo nivel optimizado para operaciones específicas dentro de los modelos generativos—que podían mejorar drásticamente el rendimiento en comparación con implementaciones genéricas.

El reto de infraestructura va más allá de la simple optimización de rendimiento. Los modelos de medios generativos tienen características únicas que requieren manejo especializado. Los modelos de difusión, que son la base de la mayoría de los sistemas de generación de imágenes, funcionan mediante un proceso iterativo donde el modelo refina gradualmente ruido aleatorio en imágenes coherentes a lo largo de muchos pasos. Cada paso requiere una gestión cuidadosa de la memoria para evitar quedarte sin memoria de GPU, además de que el proceso debe ser lo suficientemente rápido para proporcionar una latencia aceptable en aplicaciones interactivas. La generación de video añade dimensiones temporales, exigiendo modelos que mantengan la consistencia entre fotogramas mientras generan contenido de alta calidad a 24 o 30 cuadros por segundo. Los modelos de audio tienen sus propios requisitos, como capacidades de procesamiento en tiempo real para algunas aplicaciones y salida de alta fidelidad para otras. Una plataforma que sirve todas estas modalidades debe desarrollar experiencia profunda en cada dominio, entendiendo las oportunidades de optimización y restricciones de cada tipo de modelo. Esta especialización es precisamente lo que hace valiosas a las compañías de infraestructura de medios generativos: acumulan conocimiento y técnicas de optimización que los desarrolladores individuales no pueden replicar fácilmente.

Únete a nuestro boletín

Obtén los últimos consejos, tendencias y ofertas gratis.

La evolución de los modelos de generación de imágenes: de Stable Diffusion a Flux

La historia de los medios generativos puede rastrearse a través de la evolución de los modelos de generación de imágenes, cada uno representando un punto de inflexión significativo en el desarrollo del mercado. Stable Diffusion 1.5, lanzado en 2022, fue el catalizador que transformó los medios generativos de una curiosidad académica a una herramienta práctica que los desarrolladores podían realmente usar. El modelo era de código abierto, relativamente eficiente comparado con modelos de difusión anteriores y producía imágenes de calidad aceptable para una amplia gama de casos de uso. Para FAL, Stable Diffusion 1.5 fue el momento en que reconocieron la oportunidad de pivotar toda su empresa. Comenzaron a ofrecer una versión optimizada y lista para API del modelo, a la que los desarrolladores podían acceder sin gestionar su propia infraestructura de GPU. La respuesta fue abrumadora—los desarrolladores reconocieron de inmediato el valor de no tener que lidiar con la complejidad del despliegue, y Stable Diffusion 1.5 se convirtió en el primer gran motor de ingresos de FAL. Más allá del modelo base, el ecosistema de fine-tuning en torno a Stable Diffusion 1.5 explotó. Los desarrolladores crearon LoRAs (Low-Rank Adaptations)—modificaciones ligeras del modelo base que podían personalizarlo para casos de uso específicos como estilos artísticos particulares, rostros de personas concretas u objetos únicos. Este ecosistema creó un círculo virtuoso donde más opciones de fine-tuning hacían la plataforma más valiosa, atrayendo a más desarrolladores y generando más oportunidades de personalización.

Stable Diffusion 2.1, lanzado como continuación del modelo original, representó una advertencia sobre la importancia de la calidad del modelo en el mercado de medios generativos. A pesar de ser técnicamente más avanzado en algunos aspectos, SD 2.1 fue ampliamente percibido como un paso atrás en calidad de imagen, especialmente para rostros humanos y escenas complejas. El modelo no logró una gran adopción y muchos desarrolladores continuaron usando la versión anterior 1.5. Esta experiencia enseñó una lección importante: en el mercado de medios generativos, la calidad importa más que la sofisticación técnica. A los usuarios les interesa la calidad del resultado que pueden crear, no la arquitectura subyacente ni la metodología de entrenamiento. Stable Diffusion XL (SDXL), lanzado en 2023, representó un verdadero salto en calidad y capacidad. SDXL podía generar imágenes de mayor resolución, con mejor detalle y texto más preciso. Para FAL, SDXL fue transformador—fue el primer modelo que generó $1 millón en ingresos para la plataforma. El éxito del modelo también aceleró el ecosistema de fine-tuning, con desarrolladores creando miles de LoRAs para personalizar SDXL según aplicaciones específicas. El éxito de SDXL demostró que existía una gran demanda comercial para la generación de imágenes de alta calidad, validando la decisión de FAL de especializarse en este mercado.

El lanzamiento de los modelos Flux por Black Forest Labs en 2024 marcó otro punto de inflexión clave. Flux representó la primera generación de modelos que podían describirse genuinamente como “comercialmente utilizables” y “listos para empresas”. La calidad era sustancialmente superior a modelos previos, la velocidad de generación era adecuada para aplicaciones en producción y los resultados eran lo suficientemente consistentes como para que las empresas construyeran productos en torno a ellos. Para FAL, Flux fue transformador: los ingresos de la plataforma saltaron de $2 millones a $10 millones en el primer mes tras el lanzamiento de Flux, y luego a $20 millones el mes siguiente. Este crecimiento explosivo reflejó la demanda contenida de generación de imágenes de alta calidad que pudieran usarse de forma confiable en aplicaciones comerciales. Flux llegó en varias versiones—Schnell (una versión rápida y destilada), Dev (una versión de mayor calidad con licencia no comercial) y Pro (que requiere colaboración para su alojamiento)—cada una pensada para diferentes casos de uso y precios. El éxito de Flux también demostró que el mercado de medios generativos había madurado hasta el punto de que las empresas estaban dispuestas a invertir significativamente en capacidades de generación de imágenes, no solo a experimentar con la tecnología.

El salto al video: un nuevo segmento de mercado

Mientras la generación de imágenes capturó una parte importante de la atención y los ingresos, el surgimiento de modelos prácticos de generación de video representó una oportunidad de mercado completamente nueva. Los primeros modelos de texto a video, incluyendo Sora de OpenAI, demostraron lo que era teóricamente posible, pero no estaban ampliamente disponibles o producían resultados interesantes desde la perspectiva de la investigación, aunque poco útiles en la práctica para la mayoría de aplicaciones. Los videos eran a menudo mudos, con inconsistencias temporales y sin el pulido necesario para un uso profesional. Esto cambió drásticamente con el lanzamiento de modelos como Veo3 de Google DeepMind, que representó un verdadero avance en la calidad de generación de video. Veo3 podía generar videos con audio sincronizado, tiempos y ritmo adecuados, sincronización labial precisa y una calidad visual cercana a los estándares profesionales. El modelo era costoso de ejecutar—considerablemente más intensivo computacionalmente que la generación de imágenes—pero la calidad justificó el coste para muchas aplicaciones.

El impacto de la generación de video de alta calidad en el negocio de FAL fue sustancial. La generación de video creó una fuente de ingresos completamente nueva y atrajo a otro tipo de clientes. Mientras la generación de imágenes era utilizada principalmente por desarrolladores individuales, diseñadores y pequeños equipos creativos, la generación de video atrajo a empresas más grandes interesadas en crear contenido publicitario, videos de marketing y otras aplicaciones profesionales. FAL se asoció con varios proveedores de modelos de video, incluyendo One de Alibaba, Kling de Kuaishou y otros, para ofrecer un conjunto completo de opciones de generación de video. El crecimiento de los ingresos de la plataforma se aceleró aún más a medida que el video se convertía en una parte cada vez más significativa del uso total. Los retos técnicos de la generación de video también impulsaron la innovación en la infraestructura de FAL—los modelos de video requerían diferentes estrategias de optimización que los de imagen, lo que exigió nuevos kernels personalizados y enfoques arquitectónicos. El éxito de la generación de video también validó la estrategia de FAL de construir una plataforma que pudiera servir múltiples modalidades. En lugar de especializarse solo en generación de imágenes, FAL creó una infraestructura lo suficientemente flexible como para acomodar modelos de imagen, video y audio, posicionándose como la plataforma integral de medios generativos.

El enfoque de FlowHunt para los flujos de trabajo de medios generativos

A medida que los medios generativos han cobrado un papel central en la creación de contenido y el desarrollo de aplicaciones, plataformas como FlowHunt han surgido para ayudar a los desarrolladores y equipos a gestionar la complejidad de integrar estas capacidades en sus flujos de trabajo. FlowHunt reconoce que, si bien plataformas como FAL han resuelto el desafío de infraestructura para ejecutar modelos de medios generativos de manera eficiente, los desarrolladores aún enfrentan retos significativos para orquestar estos modelos dentro de flujos de trabajo de aplicaciones más amplias. Una aplicación típica de medios generativos puede involucrar varios pasos: recibir una solicitud de usuario, procesar y validar la entrada, llamar a uno o más modelos generativos, postprocesar los resultados, almacenar las salidas y gestionar la analítica. FlowHunt proporciona herramientas para automatizar y optimizar estos flujos, permitiendo que los desarrolladores se centren en la lógica de su aplicación y no en la gestión de la infraestructura. Al integrarse con plataformas como FAL, FlowHunt permite a los desarrolladores construir aplicaciones sofisticadas de medios generativos sin gestionar la complejidad subyacente del servicio de modelos, la optimización y el escalado.

El enfoque de FlowHunt para los flujos de trabajo de medios generativos enfatiza la automatización, la confiabilidad y la observabilidad. La plataforma permite a los desarrolladores definir flujos de trabajo que encadenan múltiples operaciones de medios generativos, gestionan errores de manera elegante y proporcionan visibilidad de lo que ocurre en cada paso. Por ejemplo, un flujo de creación de contenido puede implicar generar múltiples variaciones de una imagen, seleccionar la mejor en función de métricas de calidad, aplicar efectos de postprocesado y luego publicar el resultado. FlowHunt permite a los desarrolladores definir todo este flujo de manera declarativa, con lógica automática de reintentos, manejo de errores y monitorización. Esta capa de abstracción es especialmente valiosa para equipos que construyen aplicaciones en producción y necesitan generar contenido de manera fiable y a escala. Al gestionar la orquestación y administración de flujos, FlowHunt permite que los desarrolladores se centren en la lógica creativa y de negocio de sus aplicaciones, mientras la plataforma se encarga de la complejidad técnica de coordinar múltiples operaciones de medios generativos.

Profundizando en lo técnico: kernels personalizados y optimización de rendimiento

El notable crecimiento del negocio de FAL y la calidad de su servicio se sustentan en una base de optimización técnica sofisticada que la mayoría de los usuarios nunca ve. La plataforma ha desarrollado más de 100 kernels CUDA personalizados—código especializado escrito en el lenguaje CUDA de NVIDIA—que optimizan operaciones específicas dentro de los modelos generativos. Estos kernels representan miles de horas de ingeniería dedicadas a exprimir el máximo rendimiento del hardware de GPU. La motivación detrás de este nivel de optimización es clara: cada milisegundo de reducción en la latencia se traduce en una mejor experiencia de usuario y menores costes de infraestructura. Un modelo que puede generar una imagen un 20% más rápido significa que la misma GPU puede servir a un 20% más de usuarios, mejorando directamente la economía de la plataforma. El desafío de escribir kernels personalizados es considerable. Programar en CUDA requiere un entendimiento profundo de la arquitectura de GPU, jerarquías de memoria y principios de computación paralela. No es algo que pueda aprenderse rápido ni aplicarse de forma genérica—cada kernel debe ajustarse cuidadosamente para operaciones y configuraciones de hardware específicas.

El proceso de optimización comienza con perfiles detallados—entender en qué operaciones realmente se invierte el tiempo durante la ejecución del modelo. Muchos desarrolladores asumen que las operaciones computacionalmente más intensivas son el cuello de botella, pero los perfiles a menudo revelan resultados sorprendentes. A veces, el cuello de botella es el movimiento de datos entre la memoria de la GPU y las unidades de cómputo, no el cálculo en sí. Otras veces, es la sobrecarga de lanzar muchas pequeñas operaciones de GPU en vez de agruparlas. Los ingenieros de FAL perfilan los modelos de manera exhaustiva, identifican los verdaderos cuellos de botella y luego escriben kernels personalizados para abordarlos. Por ejemplo, pueden desarrollar un kernel que fusione varias operaciones, reduciendo el tráfico de memoria y la sobrecarga de lanzamientos. O pueden escribir un kernel optimizado específicamente para las dimensiones y tipos de datos de un modelo concreto. Este nivel de optimización solo se justifica económicamente si se sirve a millones de usuarios—la inversión en el desarrollo de kernels personalizados se paga mediante una mayor eficiencia y menores costes de infraestructura.

Más allá de la optimización de kernels individuales, FAL ha invertido en mejoras arquitectónicas en el servicio de modelos. La plataforma utiliza técnicas como cuantización de modelos (reducir la precisión de los pesos del modelo para usar menos memoria y cómputo), procesamiento dinámico por lotes (agrupar solicitudes para mejorar la utilización de la GPU) y priorización de solicitudes (asegurando que las solicitudes sensibles a la latencia tengan prioridad sobre las orientadas a rendimiento). Estas técnicas requieren una implementación cuidadosa para mantener la calidad mientras se gana eficiencia. La cuantización, por ejemplo, puede reducir el tamaño del modelo y mejorar la velocidad, pero si se hace incorrectamente puede degradar la calidad de salida. Los ingenieros de FAL han desarrollado estrategias sofisticadas de cuantización que mantienen la calidad mientras logran importantes avances en eficiencia. El procesamiento dinámico por lotes requiere predecir cuánto tardará cada solicitud y agruparlas para maximizar la utilización de la GPU sin introducir demasiada latencia. Estas mejoras arquitectónicas, combinadas con la optimización de kernels personalizados, permiten a FAL alcanzar tasas de utilización y características de rendimiento imposibles con infraestructura genérica.

Dinámica de mercado y panorama competitivo

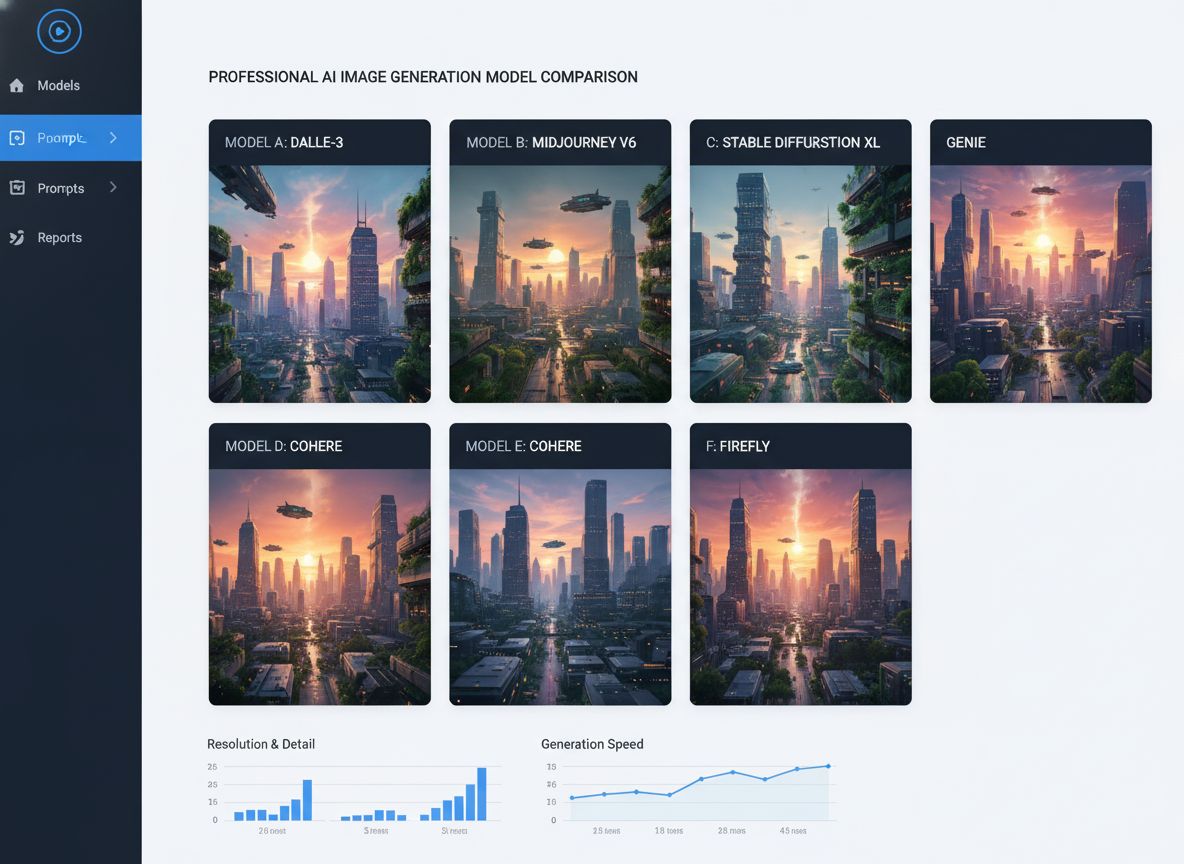

El mercado de medios generativos ha evolucionado rápidamente, con nuevos modelos y capacidades emergiendo constantemente. Comprender la dinámica competitiva y la estructura del mercado es esencial para apreciar por qué plataformas especializadas como FAL se han vuelto tan valiosas. El mercado puede dividirse en varios segmentos: generación de imágenes, generación de video, generación de audio y herramientas de edición/manipulación. Dentro de cada segmento, múltiples modelos compiten en calidad, velocidad, coste y capacidades específicas. Para la generación de imágenes, el mercado incluye variantes de Stable Diffusion, modelos Flux, modelos Gemini Image de Google y diferentes modelos especializados para casos de uso como generación de logotipos o síntesis de rostros humanos. Para la generación de video, el panorama incluye Veo3, One de Alibaba, Kling de Kuaishou y otros. Esta diversidad de modelos crea tanto oportunidades como retos para las plataformas de infraestructura. La oportunidad es que ningún modelo domina todos los casos de uso—diferentes modelos destacan en distintas áreas, por lo que una plataforma que pueda servir a varios modelos se vuelve más valiosa. El reto es que dar soporte a muchos modelos requiere un esfuerzo de ingeniería considerable para optimizar cada uno.

La estrategia de FAL ha sido seleccionar cuidadosamente modelos que, en conjunto, cubran los casos de uso más importantes manteniendo altos estándares de calidad. En lugar de sumar cada modelo que aparece, FAL evalúa los nuevos modelos detenidamente y solo los añade si aportan capacidades únicas o una calidad significativamente superior a las opciones existentes. Este enfoque de curaduría aporta varios beneficios. Primero, asegura que la selección de modelos de la plataforma sea de alta calidad y útil, evitando abrumar a los usuarios con demasiadas opciones mediocres. Segundo, permite que FAL enfoque sus esfuerzos de optimización en los modelos que realmente se usarán, en vez de dispersar recursos. Tercero, crea un círculo virtuoso donde la reputación de calidad de la plataforma atrae tanto a usuarios como a creadores de modelos. Los creadores de modelos quieren que sus modelos estén en FAL porque saben que los usuarios de la plataforma valoran la calidad. Los usuarios quieren usar FAL porque saben que los modelos disponibles están cuidadosamente seleccionados y optimizados. Este bucle de retroalimentación positiva ha sido clave en el éxito de FAL.

El panorama competitivo incluye también otras plataformas de infraestructura que sirven medios generativos, así como competencia directa de los propios creadores de modelos que ofrecen sus propios servicios de hosting. Algunos creadores, como Stability AI, han ofrecido sus propias APIs de inferencia. Otros, como Black Forest Labs con Flux, han optado por asociarse con plataformas como FAL en vez de construir su propia infraestructura. Decidir entre asociarse o construir es estratégico—desarrollar infraestructura propia requiere muchos recursos de ingeniería y experiencia operativa, mientras que asociarse permite al creador centrarse en el desarrollo del modelo. Para la mayoría, asociarse con plataformas especializadas como FAL tiene más sentido que construir su propia infraestructura. Esta dinámica ha creado un ecosistema saludable donde los creadores de modelos se concentran en la investigación y el desarrollo, mientras que las plataformas de infraestructura se centran en la optimización y el escalado.

El modelo de ingresos y métricas de negocio

Comprender el modelo de negocio y las métricas de FAL aporta una perspectiva sobre cómo las empresas de infraestructura de medios generativos crean valor y escalan. FAL opera con un modelo de precios basado en el uso, donde los clientes pagan según el número de llamadas a la API y los recursos computacionales consumidos. Este modelo alinea bien los incentivos—los clientes pagan más cuando usan más, y los ingresos de FAL crecen a medida que la plataforma se hace más valiosa y utilizada. Las métricas de crecimiento de la plataforma son impresionantes: 2 millones de desarrolladores en la plataforma, más de 350 modelos disponibles y más de $100 millones en ingresos anuales. Estas cifras representan una escala considerable, aunque también reflejan la etapa temprana del mercado de medios generativos. La penetración entre usuarios potenciales sigue siendo relativamente baja, y quedan muchos casos de uso por explorar. El crecimiento de los ingresos se ha acelerado, especialmente con la introducción de capacidades de generación de video. Los ingresos de la plataforma saltaron de $2 millones a $10 millones en el primer mes tras el lanzamiento de Flux, demostrando el impacto de modelos de alta calidad en los ingresos de las plataformas de infraestructura.

Las métricas de negocio también revelan aprendizajes importantes sobre la dinámica de mercado. El hecho de que FAL haya alcanzado más de $100 millones en ingresos anuales sirviendo a 2 millones de desarrolladores sugiere que los ingresos promedio por usuario son relativamente modestos—quizás $50-100 por año. Esto refleja que muchos usuarios experimentan con medios generativos o lo usan a pequeña escala. Sin embargo, la distribución probablemente está muy sesgada, con una pequeña proporción de usuarios intensivos generando la mayor parte de los ingresos. Estos usuarios suelen ser empresas que integran capacidades de medios generativos en sus productos o servicios. A medida que el mercado madura y más empresas integran los medios generativos en sus operaciones centrales, el ingreso promedio por usuario probablemente aumentará considerablemente. La trayectoria de crecimiento de la plataforma sugiere que la infraestructura de medios generativos aún está en las primeras etapas de una curva de crecimiento a largo plazo, con grandes oportunidades por delante.

Perspectivas avanzadas: el papel del fine-tuning y la personalización

Uno de los desarrollos más importantes en el mercado de medios generativos ha sido la aparición de capacidades de fine-tuning y personalización que permiten a los usuarios adaptar los modelos a casos de uso específicos. El fine-tuning implica tomar un modelo preentrenado y entrenarlo adicionalmente con datos de dominio específico para mejorar su rendimiento en tareas concretas. En la generación de imágenes, esto se ha manifestado principalmente en forma de LoRAs (Low-Rank Adaptations), que son modificaciones ligeras del modelo base que pueden personalizarlo sin necesidad de reentrenar desde cero. Un diseñador puede crear un LoRA que enseñe al modelo a generar imágenes en un estilo artístico específico. Un fotógrafo puede crear un LoRA que capture su estética particular. Una empresa puede crear un LoRA que genere imágenes de sus productos en contextos concretos. El ecosistema LoRA se ha convertido en una parte crucial del mercado de medios generativos, con miles de LoRAs disponibles para modelos populares como Stable Diffusion y SDXL.

La aparición del fine-tuning tiene importantes implicaciones para plataformas de infraestructura como FAL. Soportar fine-tuning requiere capacidades adicionales más allá de servir modelos base. La plataforma debe proveer herramientas para que los usuarios creen y gestionen LoRAs, almacenarlas de forma eficiente y servirlas junto con los modelos base. También debe manejar los retos técnicos de combinar modelos base con LoRAs en tiempo de inferencia, asegurando que la combinación produzca resultados de alta calidad sin latencia excesiva. FAL ha invertido considerablemente en estas capacidades, reconociendo que el fine-tuning es clave en la propuesta de valor para muchos usuarios. El soporte de la plataforma para fine-tuning ha sido un factor importante en su éxito, permitiendo a los usuarios personalizar modelos según sus necesidades específicas, mientras se benefician de la optimización y escalado de la plataforma. A medida que el mercado madura, el fine-tuning y la personalización serán aún más relevantes, con empresas invirtiendo en modelos personalizados ajustados a sus casos de uso concretos.

El futuro de la infraestructura de medios generativos

De cara al futuro, el mercado de infraestructura de medios generativos probablemente seguirá evolucionando rápidamente. Varias tendencias darán forma al mercado. Primero, los modelos seguirán mejorando en calidad y capacidad, habilitando nuevos casos de uso y atrayendo a más usuarios. La generación de video está aún en sus primeras etapas, y a medida que los modelos mejoren, la generación de video será tan ubicua como la de imágenes. La generación de audio y la creación musical emergen como nuevas fronteras, con modelos como PlayHD y otros mostrando gran potencial. Segundo, el mercado probablemente se consolidará en torno a un menor número de modelos y plataformas dominantes, similar a cómo la generación de imágenes se ha concentrado en variantes de Stable Diffusion y Flux. Esta consolidación creará oportunidades para que plataformas especializadas sean cada vez más valiosas al optimizar para los modelos dominantes. Tercero, el mercado verá una integración creciente de capacidades de medios generativos en aplicaciones y flujos de trabajo convencionales. En vez de ser una capacidad independiente, los medios generativos se integrarán en herramientas de diseño, sistemas de gestión de contenido y otras aplicaciones que los creadores usan a diario.

Los requisitos de infraestructura para medios generativos también seguirán evolucionando. A medida que los modelos sean más grandes y capaces, requerirán más recursos computacionales, impulsando la demanda de optimización de inferencia más eficiente. El surgimiento de nuevos aceleradores de hardware más allá de las GPUs—como chips de IA especializados de varios fabricantes—creará nuevas oportunidades y retos de optimización. Las plataformas que puedan servir modelos de manera eficiente en hardware diverso tendrán una gran ventaja. También veremos un enfoque creciente en la fiabilidad, la latencia y la optimización de costes a medida que los medios generativos sean más centrales en las operaciones de negocio. Los primeros usuarios toleraban fallos ocasionales o alta latencia, pero a medida que la tecnología gane importancia crítica, los usuarios exigirán mayor fiabilidad y menor latencia. Esto impulsará la inversión continua en optimización y en ingeniería de fiabilidad de infraestructura.

Conclusión

La historia técnica de los medios generativos revela un mercado que ha evolucionado de la investigación experimental a una oportunidad de infraestructura multimillonaria en tan solo unos años. El recorrido desde Stable Diffusion 1.5 hasta los modernos modelos de generación de video demuestra cómo la rápida innovación en modelos de IA genera oportunidades para plataformas de infraestructura especializadas. El éxito de FAL construyendo un negocio de más de $100M al enfocarse exclusivamente en infraestructura para medios generativos—en lugar de competir en el saturado mercado de modelos de lenguaje—ilustra la importancia del posicionamiento estratégico y la especialización técnica. La apuesta de la plataforma por la optimización de kernels CUDA personalizados, el soporte multimodal y la curaduría de modelos de alta calidad ha creado un servicio valioso en el que confían millones de desarrolladores. A medida que los medios generativos evolucionan y se vuelven más centrales en la creación de contenido y el desarrollo de aplicaciones, las plataformas de infraestructura que sirven este mercado serán cada vez más importantes. La combinación de modelos en mejora constante, casos de uso en expansión y mayor adopción empresarial indica que la infraestructura de medios generativos aún está en las primeras etapas de una trayectoria de crecimiento a largo plazo, con grandes oportunidades por delante para las plataformas que puedan ofrecer servicios fiables, eficientes e innovadores a sus usuarios.

{{ cta-dark-panel

heading=“Impulsa tu flujo de trabajo con FlowHunt”

description=“Descubre cómo FlowHunt automatiza tus flujos de contenido y SEO con IA—desde la investigación y generación de contenido hasta la publicación y analítica—todo en un solo lugar.”

ctaPrimaryText=“Solicita una demo”

ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo"

ctaSecondaryText=“Pruébalo gratis”

ctaSecondaryURL=“https://app.flowhunt.io/sign-in"

gradientStartColor="#123456”

gradientEndColor="#654321”

gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217”

}}