Dentro de la mente de Llama 3.3 70B Versatile 128k como Agente de IA

Explora las capacidades avanzadas de Llama 3.3 70B Versatile 128k como Agente de IA. Esta revisión en profundidad examina sus habilidades de razonamiento, resol...

Descubre cómo Jamba 3B de AI21 combina la atención de transformadores con modelos de espacio de estados para lograr una eficiencia sin precedentes y capacidades de contexto extenso en dispositivos edge, redefiniendo el futuro de los grandes modelos de lenguaje.

El panorama de los grandes modelos de lenguaje ha experimentado una transformación dramática en los últimos años, con investigadores y empresas buscando constantemente formas de mejorar la eficiencia sin sacrificar el rendimiento. La introducción de Jamba 3B por parte de AI21 representa un hito importante en esta evolución: un modelo híbrido que combina las fortalezas de los mecanismos de atención de los transformadores con modelos de espacio de estados para lograr ganancias de eficiencia sin precedentes. Este avance llega en un momento crítico, cuando las demandas computacionales del entrenamiento y despliegue de grandes modelos de lenguaje se han convertido en un gran cuello de botella para las organizaciones de todo el mundo. En esta guía completa, exploraremos las innovaciones técnicas detrás de Jamba 3B, entenderemos por qué las arquitecturas híbridas representan el futuro de los modelos de lenguaje y examinaremos cómo este enfoque está redefiniendo las posibilidades para el despliegue de IA en entornos computacionales diversos.

AI21 fue fundada hace más de siete años por Ori Levy, Yoav Shoham y Amnon Shashua con una premisa visionaria que guiaría todo su trabajo posterior: el deep learning, aunque increíblemente poderoso y útil, no es suficiente por sí solo. La filosofía fundacional de la empresa se centraba en tender puentes entre la inteligencia artificial clásica y los enfoques modernos de deep learning, creando sistemas capaces de aprovechar las fortalezas de ambos paradigmas. Esta misión resultó ser acertada, ya que la compañía comenzó su trabajo justo antes del lanzamiento de GPT-3, colocándose en una posición perfecta para observar y participar en los cambios revolucionarios que transformarían toda la industria de la IA. Desde sus primeros días en 2018, AI21 se comprometió a entrenar modelos manteniendo un enfoque dual en el rigor científico y las aplicaciones prácticas. Este enfoque equilibrado se convertiría en una característica definitoria del trabajo de la empresa, distinguiéndola de competidores que a menudo priorizaban ya fuera la investigación pura o la comercialización inmediata.

A lo largo de su historia, AI21 ha mantenido este compromiso de combinar investigación de vanguardia con aplicaciones reales. La empresa desarrolló Wordtune, una aplicación que proporcionó tracción en el mercado y sirvió como banco de pruebas para su investigación en modelos de lenguaje. Cuando surgió GPT-3, AI21 respondió entrenando su propio modelo, Jurassic-1, que alcanzó métricas de rendimiento comparables o ligeramente superiores a la oferta de OpenAI. Este éxito temprano posicionó a AI21 como un actor serio en el espacio de los grandes modelos de lenguaje, pero las ambiciones de la compañía iban mucho más allá de igualar los modelos existentes. El equipo reconoció que el futuro de la IA requeriría no sólo modelos más grandes, sino arquitecturas más inteligentes que pudieran ofrecer mejor rendimiento con mayor eficiencia. Esta visión conduciría finalmente al desarrollo de Jamba, su innovadora línea de modelos híbridos que desafiaría la sabiduría convencional sobre cómo deben construirse los modelos de lenguaje.

Los modelos de lenguaje híbridos representan una ruptura fundamental con la arquitectura puramente transformer que ha dominado el campo desde el lanzamiento de GPT-2 y los modelos posteriores. Los modelos tradicionales basados en transformadores dependen completamente de mecanismos de atención, donde cada token en una secuencia puede atender a cualquier otro token. Si bien este enfoque ha demostrado ser notablemente efectivo para la comprensión y generación de lenguaje, conlleva un coste computacional significativo: el mecanismo de atención tiene complejidad cuadrática respecto a la longitud de la secuencia, lo que significa que duplicar la ventana de contexto cuadruplica los requisitos computacionales. Además, la caché de claves y valores necesaria para la atención crece linealmente con la longitud de la secuencia, creando cuellos de botella de memoria cada vez más problemáticos a medida que se amplían las ventanas de contexto. Estas limitaciones se han convertido en restricciones críticas para aplicaciones modernas, especialmente aquellas que requieren procesamiento de contexto largo, personalización, retención de memoria y capacidades de razonamiento agente.

Los modelos híbridos abordan estas limitaciones combinando la atención del transformer con modelos de espacio de estados, especialmente Mamba, que ofrece complejidad lineal respecto a la longitud de la secuencia. En lugar de reemplazar completamente la atención—lo que sacrificaría las capacidades de razonamiento que hacen tan efectivos a los transformadores—las arquitecturas híbridas emplean la atención de manera selectiva, normalmente en una proporción de 1:8, donde solo una de cada ocho capas utiliza atención completa y el resto emplea el enfoque más eficiente de modelo de espacio de estados. Esta combinación estratégica preserva la capacidad del modelo para realizar tareas de razonamiento complejo que requieren la conciencia del contexto global que proporciona la atención, al tiempo que reduce drásticamente los costes computacionales y los requisitos de memoria para la mayor parte del procesamiento del modelo. El resultado es un modelo que mantiene o incluso mejora el rendimiento en la mayoría de los benchmarks, consumiendo muchos menos recursos computacionales tanto durante el entrenamiento como en la inferencia. Esta ganancia de eficiencia no es simplemente una mejora marginal—representa un cambio fundamental en lo que es posible para el despliegue de IA, permitiendo que los modelos se ejecuten en dispositivos edge, en entornos con restricciones de memoria y a escalas antes consideradas impracticables.

El camino hacia la arquitectura híbrida de Jamba no fue predeterminado, sino que surgió a través de la experimentación cuidadosa y la disposición a explorar enfoques poco convencionales. El equipo de AI21 estaba trabajando inicialmente en J3, la tercera versión de su línea de modelos Jurassic, con planes de implementar una arquitectura mixture-of-experts (MoE). La motivación principal para MoE era sencilla: reduciría significativamente los costes de entrenamiento al distribuir la computación entre múltiples redes expertas, haciendo que el presupuesto de entrenamiento fuera más manejable. Sin embargo, el equipo también quería asegurar que su modelo pudiera desplegarse eficientemente durante la inferencia, por lo que diseñaron J3 con varias versiones: una que pudiera caber en una sola GPU con 80 gigabytes de memoria (como una A100 o H100) y una versión más grande que pudiera ejecutarse en un solo pod. Este enfoque en la eficiencia desde el inicio resultaría crucial para su avance posterior.

Durante la fase de estudios de ablación del desarrollo del modelo, Barak Lenz, CTO de AI21, se topó con el paper de Mamba, que le había sido recomendado por varios colegas. A diferencia de anteriores papers sobre modelos de espacio de estados, que mostraban resultados poco prometedores, el trabajo sobre Mamba destacó por su rigor en las comparaciones y evaluación. En lugar de compararse con benchmarks obsoletos, los autores compararon Mamba directamente con las arquitecturas de atención más recientes, especialmente las mejoras introducidas por Llama, que había optimizado significativamente la normalización de capas, funciones de activación y otros detalles arquitectónicos que prevenían inestabilidades durante el entrenamiento. El paper de Mamba no sólo se comparó de manera justa con estos benchmarks de última generación, sino que también publicó kernels y código personalizados, demostrando un verdadero compromiso con la implementación práctica. Intrigado por este rigor, Lenz animó a su equipo de ingeniería a experimentar con Mamba y ver cómo rendía frente a su panel de evaluación, que ya contenía cientos de tareas y benchmarks diversos.

Los resultados iniciales fueron prometedores, aunque revelaron limitaciones importantes. Mamba mostró un rendimiento competitivo con modelos basados en atención en métricas de perplexity y la mayoría de tareas, pero había áreas específicas donde su desempeño era inferior, especialmente en tareas few-shot que requerían adaptación rápida a nuevos patrones. Tras investigar, el equipo concluyó que estas deficiencias provenían de la falta de mecanismos de atención en Mamba—algunos tipos de razonamiento y reconocimiento de patrones se benefician de la conciencia global del contexto que brinda la atención. En vez de aceptar esta limitación, el equipo comenzó a experimentar con arquitecturas híbridas, intercalando capas de atención con capas Mamba para tratar de capturar los beneficios de ambos enfoques. Los resultados superaron sus expectativas: no sólo el enfoque híbrido eliminó la degradación de rendimiento observada en los modelos Mamba puros, sino que también mostró mejoras en general respecto a las arquitecturas transformer convencionales. Este descubrimiento fue el catalizador que llevaría al desarrollo de Jamba.

El desarrollo de Jamba requirió resolver numerosos desafíos técnicos nunca antes abordados a tal escala. Cuando AI21 comenzó a entrenar Jamba Mini, el primer modelo de su línea híbrida, Mamba nunca se había escalado más allá de los 3 mil millones de parámetros. El modelo híbrido del equipo, en cambio, llegaría a tener 13 mil millones de parámetros activos, con aproximadamente 52 mil millones de parámetros totales al considerar los componentes mixture-of-experts. Esto representó un reto de escalado masivo, exigiendo que el equipo depurara y optimizara la arquitectura de maneras nunca intentadas antes. El propio proceso de optimización se convirtió en un fascinante reto de ingeniería: el equipo tuvo que analizar cuidadosamente el comportamiento del modelo, identificar cuellos de botella e implementar soluciones que permitieran entrenar la arquitectura híbrida eficientemente a esta escala sin precedentes.

Una de las decisiones más críticas en la arquitectura de Jamba fue determinar la proporción óptima de capas de atención a capas de espacio de estados y la posición de estas capas dentro del modelo. Mediante extensos estudios de ablación, AI21 descubrió que una proporción de 1:8—donde una de cada ocho capas usa atención y las restantes siete emplean Mamba—proporcionaba el mejor equilibrio entre rendimiento y eficiencia. Curiosamente, la ubicación de las capas de atención también resultó muy relevante. El equipo probó ponerlas al principio, en medio y al final del modelo, encontrando que situarlas en el medio de la arquitectura ofrecía resultados sustancialmente mejores que en los extremos. Si bien proporciones más agresivas como 1:6 mostraron mejoras marginales, estos avances caían dentro de la desviación estándar de los resultados y no justificaban el coste computacional adicional de más capas de atención, especialmente considerando que cada capa transformer añade costes cuadráticos a la caché de claves y valores durante el procesamiento de contexto largo.

Las ganancias de eficiencia de esta arquitectura son sustanciales y multifacéticas. Durante el entrenamiento, el enfoque híbrido reduce los requerimientos computacionales frente a los modelos puramente transformer, resultando más rentable entrenar modelos a escala. En la inferencia, los beneficios son aún más notorios, especialmente para aplicaciones de contexto largo. Si bien Mamba tiene un coste fijo mayor para secuencias cortas comparado con la atención, esta desventaja desaparece y se invierte a medida que aumenta la longitud de la secuencia. Para aplicaciones que requieren contexto largo—como casos de uso agente, sistemas empresariales de generación aumentada por recuperación, personalización con memoria y muchas otras aplicaciones emergentes—la arquitectura híbrida ofrece características de rendimiento mucho mejores. El escalado lineal de memoria de Mamba significa que duplicar la ventana de contexto duplica los requerimientos de memoria; en cambio, con atención pura, duplicar el contexto cuadruplica la memoria necesaria. Esta diferencia fundamental resulta cada vez más relevante a medida que las aplicaciones demandan ventanas de contexto más largas para mantener razonamiento y memoria coherentes a lo largo de interacciones extendidas.

A medida que las organizaciones adoptan modelos avanzados como Jamba 3B, el desafío de integrar estos modelos en flujos de trabajo de producción se vuelve crítico. FlowHunt aborda este reto proporcionando una plataforma integral para automatizar flujos de trabajo de IA, desde la selección y prueba de modelos hasta su despliegue y monitoreo. Las ganancias de eficiencia logradas por modelos híbridos como Jamba 3B solo se materializan plenamente cuando se combinan con una automatización de flujos de trabajo inteligente que optimice cómo se implementan, prueban y supervisan estos modelos en entornos productivos. FlowHunt permite a los equipos construir sistemas de IA sofisticados que aprovechan modelos como Jamba 3B manteniendo visibilidad y control sobre toda la cadena. Al automatizar los aspectos rutinarios del despliegue y monitoreo de modelos, FlowHunt permite que los equipos se concentren en los aspectos estratégicos de la integración de IA, asegurando que las ganancias de eficiencia computacional de arquitecturas avanzadas se traduzcan en valor empresarial real.

La combinación de modelos eficientes y automatización inteligente de flujos de trabajo crea una sinergia poderosa. Los equipos pueden desplegar Jamba 3B en dispositivos edge o en entornos con restricciones de memoria con confianza, sabiendo que las herramientas de monitoreo y optimización de FlowHunt asegurarán un rendimiento consistente. Para empresas que construyen sistemas de IA que requieren procesamiento de contexto largo, personalización y razonamiento agente, FlowHunt proporciona la infraestructura para gestionar estos complejos flujos de trabajo de manera eficiente. La capacidad de la plataforma para automatizar pruebas, despliegue y monitoreo permite a las organizaciones iterar rápidamente en sus sistemas de IA, experimentando con diferentes configuraciones y estrategias de despliegue sin carga manual. Esto es especialmente valioso para organizaciones que exploran las posibilidades de los modelos híbridos, ya que les permite comparar diferentes arquitecturas y configuraciones para encontrar el equilibrio óptimo para sus casos de uso específicos.

El lanzamiento de Jamba 3B representa un hito importante para hacer que las capacidades avanzadas de IA sean accesibles a una gama más amplia de aplicaciones y escenarios de despliegue. A diferencia de modelos previos en la línea Jamba, diseñados para el máximo rendimiento a gran escala, Jamba 3B está específicamente optimizado para dispositivos edge y entornos con restricciones de memoria. La denominación “3B” se refiere al tamaño del modelo—aproximadamente 3 mil millones de parámetros—lo que lo hace lo suficientemente pequeño como para ejecutarse en hardware de consumo, pero manteniendo los beneficios de eficiencia de la arquitectura híbrida. Esto es un avance crucial porque democratiza el acceso a capacidades avanzadas de modelos de lenguaje, posibilitando aplicaciones antes imposibles debido a limitaciones computacionales. Ahora los desarrolladores pueden desplegar modelos sofisticados en dispositivos móviles, IoT, sistemas embebidos y otras plataformas edge sin sacrificar las capacidades de razonamiento y el procesamiento de contexto largo que hacen valiosos a los modelos modernos.

La característica más significativa de Jamba 3B es su capacidad para manejar largas ventanas de contexto permaneciendo implementable en dispositivos edge. Esta combinación era antes imposible con arquitecturas puramente transformer—la complejidad cuadrática de la atención hacía que extender ventanas de contexto en dispositivos edge agotara rápidamente la memoria disponible. La arquitectura híbrida de Jamba 3B cambia esta ecuación fundamentalmente. La complejidad lineal de las capas Mamba permite extender el contexto sin el crecimiento exponencial de memoria que aqueja a los modelos de atención pura. Para aplicaciones que requieren personalización, retención de memoria, generación aumentada por recuperación y razonamiento agente, esta capacidad es transformadora. Un dispositivo edge ejecutando Jamba 3B puede mantener contexto coherente a través de interacciones extendidas, habilitando aplicaciones sofisticadas antes solo posibles con modelos en la nube. Este cambio tiene profundas implicaciones para la privacidad, latencia y coste: las aplicaciones pueden ahora procesar datos sensibles localmente sin transmitirlos a servidores remotos, responder a consultas de usuarios con mínima latencia y operar sin incurrir en costes de computación en la nube.

Al analizar el panorama de mini modelos disponibles en el mercado, Jamba 3B destaca como el único modelo híbrido en su categoría de tamaño. La mayoría de los mini modelos existentes dependen de arquitecturas puramente transformer, por lo que enfrentan las mismas limitaciones de eficiencia que sus homólogos mayores. El enfoque híbrido de Jamba 3B le otorga una ventaja significativa en capacidades de contexto largo y eficiencia computacional. El modelo logra esta distinción no a través de compromisos arquitectónicos que reduzcan su capacidad, sino mediante las ganancias fundamentales de eficiencia del enfoque híbrido. Esto posiciona a Jamba 3B como la opción ideal para aplicaciones que necesitan equilibrar el tamaño del modelo con sus capacidades, especialmente aquellas que requieren procesamiento de contexto largo en dispositivos edge.

Pese a las claras ventajas de los modelos híbridos, persisten obstáculos significativos para su adopción generalizada. La industria de la IA ha pasado años optimizando hardware y software específicamente para los mecanismos de atención de los transformadores. Cada gran plataforma de hardware—desde GPUs de NVIDIA hasta aceleradores de IA especializados—cuenta con kernels y optimizaciones personalizadas para operaciones de atención. Estas optimizaciones son el fruto de años de esfuerzo en ingeniería y representan inversiones sustanciales para hacer la atención lo más eficiente posible en plataformas específicas. En contraste, los modelos de espacio de estados como Mamba son relativamente nuevos y, aunque existen kernels personalizados para ellos, estas optimizaciones no son tan maduras ni están tan ampliamente desplegadas. Esto crea lo que Barak Lenz llama “la lotería del hardware”: las ventajas de eficiencia de los modelos híbridos pueden verse significativamente mermadas si la plataforma de hardware no cuenta con implementaciones optimizadas para las operaciones de modelos de espacio de estados.

Esta brecha de optimización de hardware es un obstáculo real para la adopción, pero no insalvable y probablemente disminuirá con el tiempo. A medida que más empresas reconocen el valor de los modelos híbridos y las arquitecturas de espacio de estados, los fabricantes de hardware tendrán mayores incentivos para invertir en optimizaciones para estas operaciones. NVIDIA ya ha comenzado a lanzar modelos híbridos y otras empresas han seguido su ejemplo, lo que sugiere que la industria reconoce la importancia a largo plazo de estas arquitecturas. Además, las ventajas de eficiencia de los modelos híbridos son tan sustanciales que, incluso sin una optimización perfecta de hardware, suelen superar a los modelos de atención pura. La complejidad cuadrática de la atención es una limitación fundamental que, incluso tras años de optimización, no puede igualar la complejidad lineal de los modelos de espacio de estados para aplicaciones de contexto largo. A medida que aumentan las longitudes de secuencia—una tendencia inevitable conforme las aplicaciones demandan más contexto para mejor razonamiento y personalización—las ventajas de los modelos híbridos serán cada vez más innegables.

Más allá del trabajo de AI21 en modelos híbridos, está surgiendo una tendencia más amplia en la industria a emplear la atención de forma más selectiva en lugar de en todas las capas. Incluso empresas que no implementan arquitecturas híbridas completas reconocen que la atención total en cada capa es innecesaria y derrochadora. Muchos modelos recientes emplean atención de ventana deslizante, donde cada token sólo puede atender a una ventana limitada de tokens circundantes en vez de a toda la secuencia. Este enfoque reduce la complejidad de la atención de cuadrática a lineal respecto al tamaño de la ventana, aunque aún requiere más computación que los modelos de espacio de estados. El hecho de que investigadores como Noam Shazir hayan llegado de manera independiente a conclusiones similares sobre proporciones óptimas de atención—específicamente la proporción 1:8 de atención local a global—sugiere que no es un hallazgo idiosincrático, sino una propiedad fundamental de cómo deben estructurarse los modelos de lenguaje.

Esta convergencia de hallazgos en diferentes grupos de investigación y empresas sugiere que la industria avanza hacia un nuevo consenso sobre la arquitectura óptima de modelos. En lugar del enfoque puramente transformer que ha dominado desde GPT-2, el futuro probablemente implique modelos que usen la atención de manera selectiva, ya sea mediante arquitecturas híbridas como Jamba o por otros enfoques como la atención de ventana deslizante. Los detalles de implementación pueden variar, pero el principio subyacente es consistente: la atención total en cada capa es ineficiente y superflua. Este cambio representa una maduración del campo, superando el éxito inicial de los transformers hacia una comprensión más matizada de cuándo y dónde es realmente necesaria la atención. Para los profesionales y organizaciones que construyen sistemas de IA, este cambio tiene importantes implicaciones: sugiere que los modelos que construyan y desplieguen en el futuro serán probablemente más eficientes que los enfoques actuales, habilitando nuevas aplicaciones y casos de uso hoy impracticables por limitaciones computacionales.

Descubre cómo FlowHunt automatiza tus flujos de contenido y SEO con IA — desde la investigación y generación de contenido hasta la publicación y analítica — todo en un solo lugar.

Más allá de modelos individuales, AI21 ha sido pionera en el desarrollo de sistemas de IA que van más allá de la simple inferencia de modelos de lenguaje. La empresa lanzó Jarvis, un sistema de IA temprano que intentó usar herramientas y recursos externos para potenciar las capacidades del modelo de lenguaje. Este trabajo precedió la adopción generalizada del uso de herramientas en modelos de lenguaje y fue influyente en la inspiración de frameworks posteriores como LangChain. La idea fundamental detrás de los sistemas de IA es que los modelos de lenguaje por sí solos, aunque poderosos, no son suficientes para muchas aplicaciones reales. Para cerrar la brecha entre el deep learning y la IA clásica, los sistemas deben ser capaces de invocar herramientas externas, acceder a bases de datos, ejecutar código y realizar operaciones que requieren más rigor y determinismo que la pura inferencia neuronal.

Maestro, la oferta empresarial de AI21, representa la evolución de este pensamiento hacia un sistema listo para producción diseñado para aplicaciones de negocio. En lugar de simplemente desplegar un modelo de lenguaje y esperar que produzca resultados útiles, Maestro proporciona un marco para construir sistemas de IA capaces de realizar tareas complejas de forma fiable, combinando las capacidades de los modelos de lenguaje con el uso de herramientas, recuperación y otras técnicas clásicas de IA. Este enfoque es especialmente importante para aplicaciones empresariales donde la fiabilidad, la precisión y la auditabilidad son requisitos críticos. Un modelo de lenguaje puede generar información verosímil pero incorrecta, mientras que un sistema de IA que puede verificar sus salidas frente a fuentes de datos externas y usar herramientas para tareas específicas puede ofrecer mucha mayor fiabilidad. La adopción de sistemas de IA en entornos empresariales ha sido más lenta de lo que algunos predijeron, pero esto está cambiando a medida que las organizaciones reconocen el valor de la IA para automatizar flujos de trabajo complejos y procesos de toma de decisiones.

El momento de este cambio hacia sistemas de IA es relevante. Cuando la IA generativa surgió como tecnología mainstream, muchas organizaciones se centraron en aplicaciones simples como la generación de contenido y los chatbots de atención al cliente. Estas aplicaciones podían ser servidas adecuadamente por un modelo de lenguaje con mínima infraestructura adicional. Sin embargo, a medida que las organizaciones ganan experiencia con la IA e identifican casos de uso más sofisticados, las limitaciones de los modelos de lenguaje puros se hacen evidentes. Aplicaciones que requieren procesamiento de contexto largo, personalización, retención de memoria y razonamiento agente se benefician del enfoque estructurado que proporcionan los sistemas de IA. Además, las ganancias de eficiencia de modelos como Jamba 3B hacen cada vez más práctico el despliegue de sistemas de IA sofisticados en dispositivos edge y entornos con recursos limitados. La convergencia de modelos más eficientes y arquitecturas de sistema más sofisticadas está generando nuevas posibilidades para el despliegue de IA en la empresa.

Para desarrolladores y organizaciones que consideren cómo aprovechar modelos avanzados de lenguaje en sus aplicaciones, la aparición de Jamba 3B y las arquitecturas híbridas tiene varias implicaciones importantes. Primero, sugiere que la era de los modelos puramente transformer podría estar llegando a su fin, al menos para nuevos desarrollos. Aunque los modelos transformer existentes seguirán utilizándose y mejorando, es cada vez más probable que los nuevos modelos incorporen arquitecturas híbridas o mecanismos de atención selectiva. Esto significa que los desarrolladores deben comenzar a familiarizarse con estas nuevas arquitecturas y comprender sus características, ventajas y limitaciones. Segundo, las ganancias de eficiencia de los modelos híbridos hacen práctico desplegar modelos de lenguaje sofisticados en escenarios antes imposibles: en dispositivos edge, aplicaciones móviles y otros entornos con recursos limitados. Esto abre nuevas posibilidades para aplicaciones capaces de procesar datos localmente, mantener la privacidad y responder con mínima latencia.

En tercer lugar, las capacidades de contexto largo de modelos como Jamba 3B permiten nuevos patrones de aplicación antes poco realistas. Ahora las aplicaciones pueden mantener contexto coherente a través de interacciones extendidas, habilitando personalización más sofisticada, retención de memoria y razonamiento agente. Esto es especialmente valioso para aplicaciones empresariales donde mantener el contexto entre múltiples interacciones e integrarse con sistemas externos es crítico. En cuarto lugar, la combinación de modelos eficientes y plataformas de automatización inteligente de flujos de trabajo como FlowHunt genera nuevas posibilidades para la iteración y experimentación rápida. Las organizaciones pueden ahora probar diferentes configuraciones de modelos, estrategias de despliegue y arquitecturas de sistema sin incurrir en costes computacionales prohibitivos. Esta democratización de la experimentación en IA probablemente acelerará la innovación y dará lugar a aplicaciones y casos de uso aún inimaginados.

La evidencia sugiere cada vez más que los modelos híbridos no son una tendencia temporal, sino que representan la dirección futura del desarrollo de modelos de lenguaje. Las ventajas de eficiencia son simplemente demasiado significativas para ignorarlas y las características de rendimiento son competitivas o superiores a los modelos puramente transformer en la mayoría de los benchmarks. A medida que los fabricantes de hardware inviertan en optimizaciones para modelos de espacio de estados y otras arquitecturas eficientes, las ventajas prácticas de los modelos híbridos sólo aumentarán. Además, la tendencia más amplia de la industria hacia la atención selectiva—ya sea mediante arquitecturas híbridas, atención de ventana deslizante u otros enfoques—indica un cambio fundamental en la forma de pensar acerca de la arquitectura de modelos. El enfoque puramente transformer que dominó durante los últimos años está dando paso a arquitecturas más matizadas que emplean distintos mecanismos para diferentes finalidades.

Para las organizaciones que construyen sistemas de IA, este cambio tiene importantes implicaciones estratégicas. Invertir en entender y trabajar con modelos híbridos ahora posiciona a las organizaciones para aprovechar las ganancias de eficiencia y capacidad que estos modelos ofrecen. La combinación de modelos eficientes como Jamba 3B con sistemas de IA sofisticados y automatización inteligente de flujos de trabajo crea una base poderosa para construir las aplicaciones de IA de próxima generación. A medida que el campo siga evolucionando, las organizaciones que hayan invertido en comprender estas nuevas arquitecturas y construir sistemas en torno a ellas estarán mejor posicionadas para capitalizar las oportunidades emergentes. El futuro de la IA no depende sólo de modelos más grandes o más datos—se trata de arquitecturas más inteligentes que ofrezcan mejor rendimiento con mayor eficiencia, habilitando nuevas aplicaciones y casos de uso antes imposibles.

El desarrollo de Jamba 3B y el movimiento más amplio hacia modelos híbridos representa una maduración del campo de los grandes modelos de lenguaje. En lugar de limitarse a escalar arquitecturas existentes, los investigadores y profesionales ahora piensan más cuidadosamente en cómo diseñar modelos que sean potentes y eficientes. Este enfoque reflexivo en el diseño de arquitectura, combinado con una evaluación rigurosa y una disposición a desafiar la sabiduría convencional, probablemente impulsará un progreso significativo en IA en los próximos años. Los modelos híbridos que AI21 y otras empresas están desarrollando hoy probablemente se convertirán en el enfoque estándar para construir modelos de lenguaje en el futuro, tal como los transformers lo hicieron tras su introducción. Para cualquiera que trabaje con modelos de lenguaje o esté interesado en ellos, entender estas nuevas arquitecturas y sus implicaciones es esencial para mantenerse al día en un campo que evoluciona rápidamente.

Un LLM híbrido combina mecanismos de atención de transformador con modelos de espacio de estados como Mamba. A diferencia de los modelos puramente transformer que dependen completamente de la atención (que tiene una complejidad computacional cuadrática), los modelos híbridos usan la atención de manera selectiva—normalmente en una proporción de 1:8—mientras aprovechan la complejidad lineal de los modelos de espacio de estados para la mayoría de las capas. Este enfoque mantiene la calidad del rendimiento mientras reduce significativamente los costes computacionales y los requerimientos de memoria.

Jamba 3B está optimizado para dispositivos edge porque logra capacidades de procesamiento de contexto largo manteniendo un tamaño lo suficientemente pequeño como para ejecutarse en entornos con restricciones de memoria. La eficiencia de la arquitectura híbrida permite que el modelo se ejecute en GPUs individuales o dispositivos edge sin sacrificar la capacidad de manejar ventanas de contexto extendidas, lo que lo hace ideal para aplicaciones de IA en el dispositivo.

A través de extensos estudios de ablación, AI21 descubrió que usar atención sólo en 1 de cada 8 capas (con Mamba en las 7 capas restantes) proporciona el equilibrio óptimo entre rendimiento y eficiencia. Las capas de atención se colocan estratégicamente en el medio del modelo en lugar de al principio o al final, lo que empíricamente mostró mejores resultados. Esta proporción minimiza el coste cuadrático de la atención mientras preserva la capacidad del modelo para manejar tareas de razonamiento complejas.

Los modelos híbridos ofrecen varias ventajas clave: costes de entrenamiento significativamente menores debido a menores requerimientos computacionales, mejor eficiencia para aplicaciones de contexto largo, escalado de memoria lineal en vez de cuadrático y rendimiento mantenido o mejorado en la mayoría de los benchmarks. También permiten la implementación en dispositivos edge y entornos con restricciones de memoria, manteniendo las capacidades de razonamiento que hacen valiosos a los grandes modelos de lenguaje.

Arshia es ingeniera de flujos de trabajo de IA en FlowHunt. Con formación en ciencias de la computación y una pasión por la IA, se especializa en crear flujos de trabajo eficientes que integran herramientas de IA en las tareas cotidianas, mejorando la productividad y la creatividad.

Optimiza la implementación, pruebas y optimización de tus modelos de IA con la plataforma de automatización inteligente de FlowHunt.

Explora las capacidades avanzadas de Llama 3.3 70B Versatile 128k como Agente de IA. Esta revisión en profundidad examina sus habilidades de razonamiento, resol...

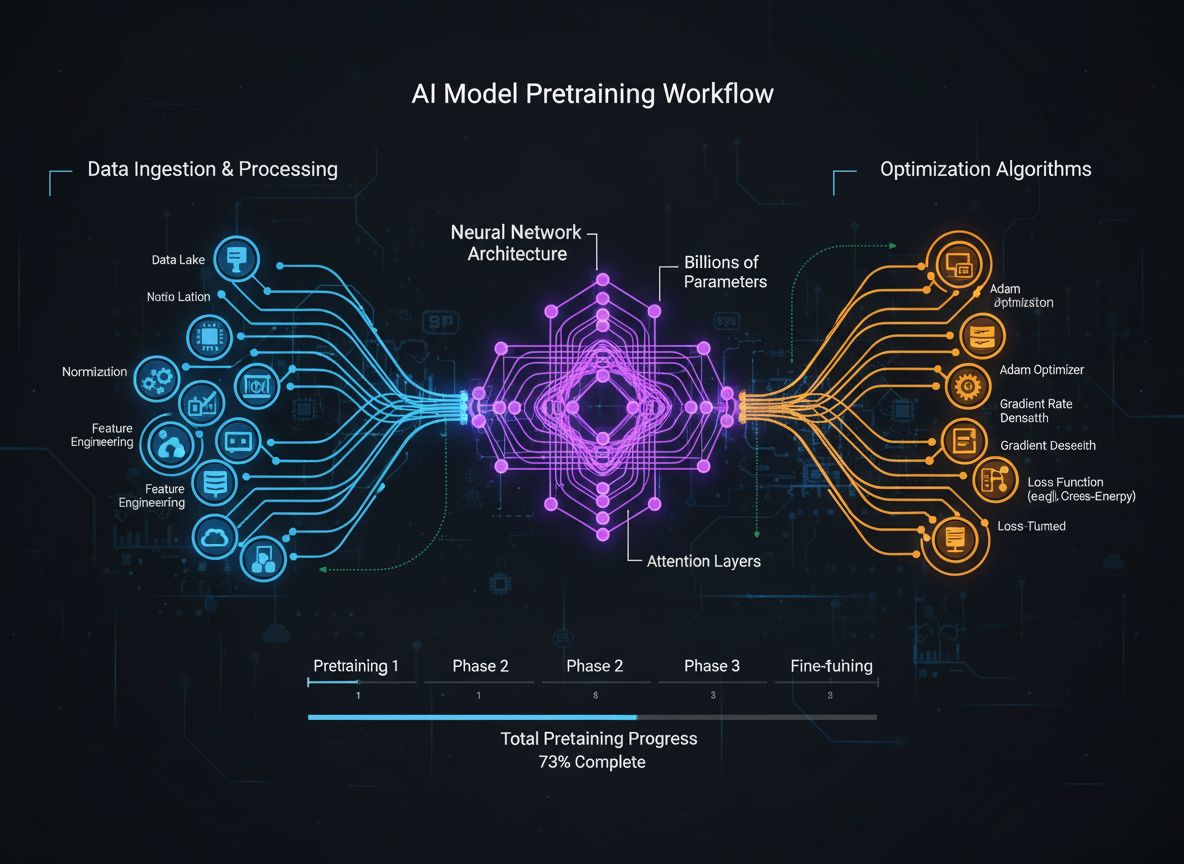

Una guía completa sobre estrategias modernas de preentrenamiento de modelos de lenguaje, técnicas de curación de datos y métodos de optimización utilizados por ...

La Generación de Texto con Modelos de Lenguaje de Gran Tamaño (LLMs) se refiere al uso avanzado de modelos de aprendizaje automático para producir texto similar...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.