Guía de desarrollo para servidores MCP

Aprenda a construir y desplegar un servidor de Protocolo de Contexto de Modelo (MCP) para conectar modelos de IA con herramientas externas y fuentes de datos. G...

Aprende a desarrollar un servidor Model Context Protocol (MCP) que se integra sin problemas con la API de OpenAI, permitiendo una potente ejecución de herramientas impulsadas por IA y automatización inteligente.

El Model Context Protocol (MCP) representa un cambio de paradigma en la forma en que los sistemas de inteligencia artificial interactúan con herramientas externas y fuentes de datos. Cuando se combina con los potentes modelos de lenguaje de OpenAI, un servidor MCP se convierte en una puerta de entrada a la automatización inteligente, permitiendo a los sistemas de IA ejecutar operaciones complejas, recuperar datos en tiempo real e integrarse sin problemas con tu infraestructura existente. Esta guía completa te acompaña en todo el proceso de desarrollo de un servidor MCP que se conecta a OpenAI, desde los conceptos fundamentales hasta una implementación lista para producción.

Ya sea que estés construyendo una plataforma de automatización de atención al cliente, un sistema inteligente de procesamiento de datos o una sofisticada herramienta de inteligencia empresarial, entender cómo diseñar e implementar un servidor MCP es esencial para el desarrollo moderno de IA. La integración entre servidores MCP y OpenAI crea un ecosistema poderoso donde los modelos de IA pueden razonar sobre problemas, decidir qué herramientas usar y ejecutarlas con precisión, manteniendo siempre la seguridad, fiabilidad y escalabilidad.

El Model Context Protocol es un estándar abierto que define cómo los modelos de IA pueden descubrir e interactuar con herramientas externas, servicios y fuentes de datos. En lugar de incrustar toda la funcionalidad directamente en el modelo de IA, MCP permite a los desarrolladores crear servidores especializados que exponen capacidades a través de una interfaz estandarizada. Esta separación de responsabilidades permite una mejor modularidad, seguridad y escalabilidad en las aplicaciones de IA.

En esencia, MCP opera bajo un principio simple: el modelo de IA (en este caso, el GPT de OpenAI) actúa como un orquestador inteligente que puede entender qué herramientas están disponibles, determinar cuándo usarlas e interpretar sus resultados. El servidor MCP actúa como el proveedor de estas herramientas, exponiéndolas a través de una API bien definida que el modelo de IA puede descubrir e invocar. Esto crea un contrato limpio entre el sistema de IA y tu lógica empresarial personalizada.

La belleza de MCP radica en su flexibilidad. Tu servidor puede exponer herramientas para cualquier cosa: consultas a bases de datos, llamadas a APIs de terceros, procesamiento de archivos, cálculos o incluso activar flujos de trabajo complejos. El modelo de IA aprende sobre estas capacidades y las utiliza de manera inteligente dentro de las conversaciones, decidiendo qué herramientas invocar según la petición del usuario y el contexto de la conversación.

La integración de servidores MCP con OpenAI resuelve una limitación fundamental de los modelos de lenguaje grandes: tienen un límite de conocimiento y no pueden interactuar directamente con sistemas en tiempo real o datos propietarios. Implementando un servidor MCP, extiendes las capacidades de los modelos de OpenAI mucho más allá de su entrenamiento base, permitiéndoles acceder a información actual, ejecutar lógica empresarial e integrarse con tus sistemas existentes.

Considera estos escenarios prácticos donde los servidores MCP son invaluables:

La arquitectura también ofrece ventajas significativas para los equipos de desarrollo. Múltiples equipos pueden desarrollar y mantener sus propios servidores MCP de manera independiente, que luego se componen para crear aplicaciones de IA sofisticadas. Este enfoque modular escala bien a medida que tu organización crece y tus capacidades de IA se vuelven más complejas.

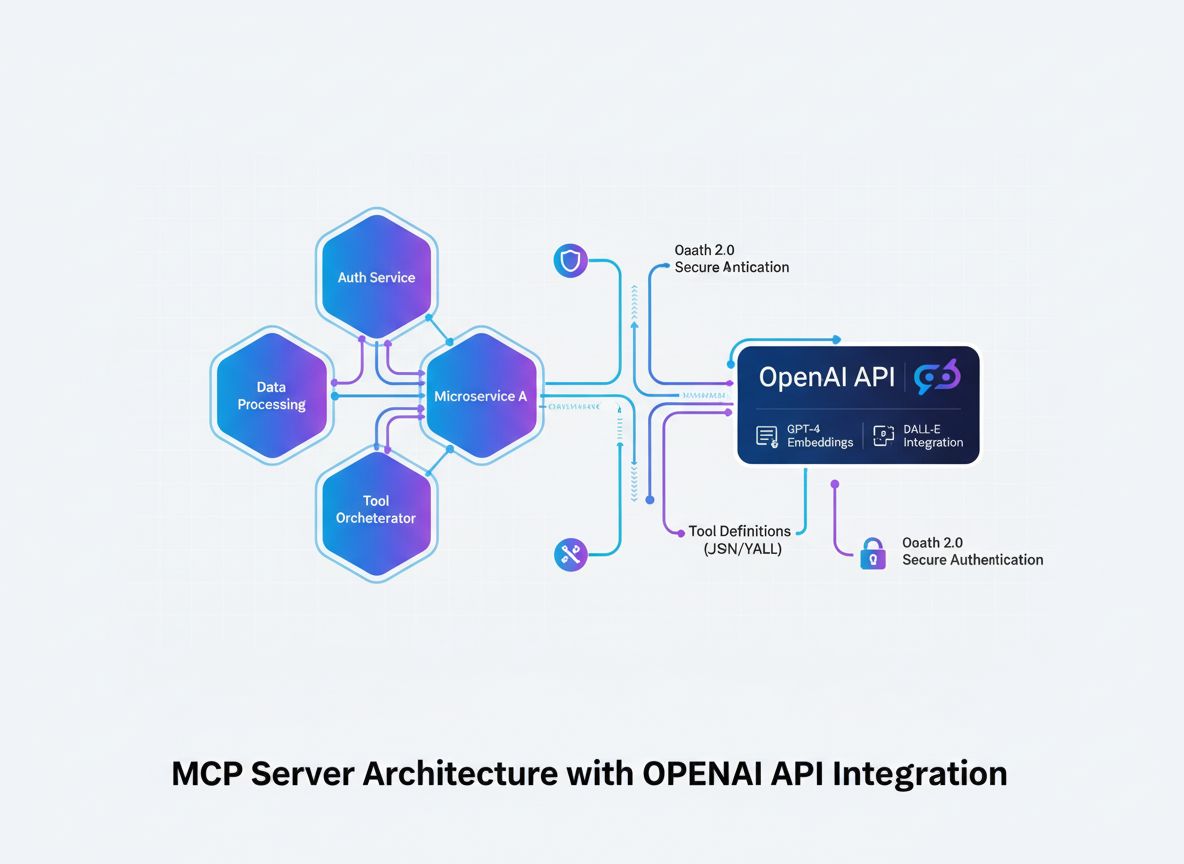

Antes de entrar en detalles de implementación, es crucial comprender el flujo arquitectónico de cómo un servidor MCP se integra con OpenAI. El proceso involucra varios componentes clave que trabajan en conjunto:

El modelo de IA (OpenAI) inicia conversaciones y toma decisiones sobre qué herramientas invocar. Cuando el modelo determina que es necesario llamar a una herramienta, genera una solicitud estructurada que contiene el nombre de la herramienta y los parámetros.

El cliente MCP actúa como traductor e intermediario. Recibe las solicitudes de invocación de herramientas desde OpenAI, las traduce al formato que espera tu servidor MCP, envía la solicitud al servidor correspondiente y retorna los resultados a OpenAI en el formato que el modelo espera.

El servidor MCP es tu aplicación personalizada que expone herramientas y capacidades. Recibe solicitudes del cliente MCP, ejecuta las operaciones solicitadas (que pueden implicar consultas a bases de datos, llamadas a APIs o cálculos complejos) y retorna resultados estructurados.

Las definiciones de herramientas son los contratos que definen qué herramientas están disponibles, qué parámetros aceptan y qué devuelven. Estas definiciones son descubiertas por el cliente MCP y registradas en OpenAI para que el modelo sepa qué hay disponible.

Esta arquitectura crea una separación limpia de responsabilidades: OpenAI gestiona el razonamiento y la toma de decisiones, tu servidor MCP gestiona la lógica de dominio y el acceso a datos, y el cliente MCP gestiona el protocolo de comunicación entre ambos.

La base de cualquier servidor MCP exitoso es una definición clara de las herramientas que quieres exponer. Esto no es solo un ejercicio técnico: es una decisión estratégica sobre qué capacidades necesita tu sistema de IA para cumplir sus objetivos.

Comienza identificando los problemas específicos que tu sistema de IA necesita resolver. ¿Estás construyendo un chatbot de atención al cliente que necesita consultar información de pedidos? ¿Un asistente de análisis de datos que debe consultar bases de datos? ¿Una herramienta de creación de contenidos que accede a la base de conocimiento de tu empresa? Cada caso de uso tendrá diferentes requisitos de herramientas.

Para cada herramienta, define:

get_customer_order_history, search_knowledge_base, execute_sql_query)Aquí tienes un ejemplo de especificaciones bien definidas para herramientas:

| Nombre de la herramienta | Propósito | Parámetros de entrada | Formato de salida | Caso de uso |

|---|---|---|---|---|

get_customer_info | Recuperar detalles del cliente | customer_id (string) | Objeto JSON con nombre, email, estado de cuenta | Consultas de atención al cliente |

search_orders | Buscar pedidos según criterios | customer_id, date_range, status | Array de objetos pedido | Consulta e historial de pedidos |

create_support_ticket | Abrir un nuevo caso de soporte | customer_id, issue_description, priority | Objeto ticket con ID y confirmación | Escalamiento de incidencias |

check_inventory | Consultar disponibilidad de productos | product_id, warehouse_location | Cantidad de inventario y detalles de ubicación | Consultas de stock |

process_refund | Iniciar una devolución | order_id, amount, reason | Confirmación de transacción con número de referencia | Procesamiento de reembolsos |

Este enfoque basado en tablas te ayuda a pensar en el ecosistema completo de herramientas antes de escribir una sola línea de código. Asegura consistencia, claridad y completitud en tus definiciones.

Crear un servidor MCP requiere una base de desarrollo sólida. Si bien los servidores MCP pueden desarrollarse en múltiples lenguajes, aquí nos centraremos en los enfoques más populares: TypeScript/Node.js y Python, ya que cuentan con las librerías MCP más maduras y mayor soporte comunitario.

Para desarrollo con TypeScript/Node.js:

Comienza creando un nuevo proyecto Node.js e instalando las dependencias necesarias:

mkdir mcp-server-openai

cd mcp-server-openai

npm init -y

npm install @modelcontextprotocol/sdk openai dotenv express cors

npm install --save-dev typescript @types/node ts-node

Crea un archivo tsconfig.json para configurar TypeScript:

{

"compilerOptions": {

"target": "ES2020",

"module": "commonjs",

"lib": ["ES2020"],

"outDir": "./dist",

"rootDir": "./src",

"strict": true,

"esModuleInterop": true,

"skipLibCheck": true,

"forceConsistentCasingInFileNames": true

}

}

Para desarrollo en Python:

Crea un entorno virtual e instala las dependencias:

python -m venv venv

source venv/bin/activate # En Windows: venv\Scripts\activate

pip install mcp openai python-dotenv fastapi uvicorn

Sea cual sea el lenguaje que elijas, necesitarás:

.env para almacenar credenciales sensibles de forma seguraEl núcleo de tu servidor MCP es la aplicación que expone tus herramientas a través del protocolo MCP. Esto implica crear endpoints para el descubrimiento de herramientas y la ejecución de las mismas.

Implementación con TypeScript/Node.js:

Crea una estructura básica de servidor MCP:

import { Server } from "@modelcontextprotocol/sdk/server/index.js";

import { StdioServerTransport } from "@modelcontextprotocol/sdk/server/stdio.js";

import {

CallToolRequestSchema,

ListToolsRequestSchema,

} from "@modelcontextprotocol/sdk/types.js";

const server = new Server({

name: "openai-mcp-server",

version: "1.0.0",

});

// Define tus herramientas

const tools = [

{

name: "get_customer_info",

description: "Recupera información del cliente por ID",

inputSchema: {

type: "object",

properties: {

customer_id: {

type: "string",

description: "Identificador único del cliente",

},

},

required: ["customer_id"],

},

},

// Añade más herramientas aquí

];

// Maneja solicitudes de listado de herramientas

server.setRequestHandler(ListToolsRequestSchema, async () => {

return { tools };

});

// Maneja solicitudes de ejecución de herramientas

server.setRequestHandler(CallToolRequestSchema, async (request) => {

const { name, arguments: args } = request.params;

if (name === "get_customer_info") {

// Implementa la lógica aquí

const customerId = args.customer_id;

// Consulta tu base de datos o API

return {

content: [

{

type: "text",

text: JSON.stringify({

id: customerId,

name: "John Doe",

email: "john@example.com",

}),

},

],

};

}

return {

content: [{ type: "text", text: `Herramienta desconocida: ${name}` }],

isError: true,

};

});

// Inicia el servidor

const transport = new StdioServerTransport();

server.connect(transport);

Implementación en Python:

from mcp.server import Server

from mcp.types import Tool, TextContent, ToolResult

import json

app = Server("openai-mcp-server")

# Define tus herramientas

TOOLS = [

Tool(

name="get_customer_info",

description="Recupera información del cliente por ID",

inputSchema={

"type": "object",

"properties": {

"customer_id": {

"type": "string",

"description": "Identificador único del cliente"

}

},

"required": ["customer_id"]

}

)

]

@app.list_tools()

async def list_tools():

return TOOLS

@app.call_tool()

async def call_tool(name: str, arguments: dict):

if name == "get_customer_info":

customer_id = arguments.get("customer_id")

# Implementa la lógica de la herramienta

result = {

"id": customer_id,

"name": "John Doe",

"email": "john@example.com"

}

return ToolResult(

content=[TextContent(type="text", text=json.dumps(result))]

)

return ToolResult(

content=[TextContent(type="text", text=f"Herramienta desconocida: {name}")],

isError=True

)

if __name__ == "__main__":

import uvicorn

uvicorn.run(app, host="0.0.0.0", port=8000)

El verdadero poder de tu servidor MCP reside en la implementación real de tus herramientas. Es aquí donde conectas bases de datos, llamas APIs externas, procesas datos y ejecutas lógica de negocio.

Ejemplo de integración con base de datos:

import { Pool } from "pg"; // Ejemplo con PostgreSQL

const pool = new Pool({

connectionString: process.env.DATABASE_URL,

});

async function getCustomerInfo(customerId: string) {

try {

const result = await pool.query(

"SELECT id, name, email, account_status FROM customers WHERE id = $1",

[customerId]

);

if (result.rows.length === 0) {

return {

error: "Cliente no encontrado",

status: 404,

};

}

return result.rows[0];

} catch (error) {

return {

error: "Error en la consulta a la base de datos",

details: error.message,

status: 500,

};

}

}

Ejemplo de integración con API externa:

import axios from "axios";

async function searchExternalDatabase(query: string) {

try {

const response = await axios.get(

"https://api.external-service.com/search",

{

params: { q: query },

headers: {

Authorization: `Bearer ${process.env.EXTERNAL_API_KEY}`,

},

}

);

return response.data;

} catch (error) {

return {

error: "Error en la llamada a la API externa",

details: error.message,

};

}

}

Gestión de errores y validación:

El manejo robusto de errores es crítico para servidores MCP en producción. Implementa validaciones y gestión de errores integral:

function validateInput(args: any, schema: any): { valid: boolean; error?: string } {

// Valida campos obligatorios

for (const required of schema.required || []) {

if (!(required in args)) {

return { valid: false, error: `Falta el parámetro requerido: ${required}` };

}

}

// Valida tipos de campo

for (const [key, property] of Object.entries(schema.properties || {})) {

if (key in args) {

const value = args[key];

const expectedType = (property as any).type;

if (typeof value !== expectedType) {

return {

valid: false,

error: `El parámetro ${key} debe ser de tipo ${expectedType}`,

};

}

}

}

return { valid: true };

}

El cliente MCP es el puente entre OpenAI y tu servidor MCP. Se encarga de la traducción entre el formato de llamada de funciones de OpenAI y el protocolo de tu servidor MCP.

Cliente MCP en TypeScript/Node.js:

import { Client } from "@modelcontextprotocol/sdk/client/index.js";

import { StdioClientTransport } from "@modelcontextprotocol/sdk/client/stdio.js";

import OpenAI from "openai";

class MCPOpenAIBridge {

private mcpClient: Client;

private openaiClient: OpenAI;

private availableTools: any[] = [];

constructor() {

this.openaiClient = new OpenAI({

apiKey: process.env.OPENAI_API_KEY,

});

}

async initialize() {

// Conecta al servidor MCP

const transport = new StdioClientTransport({

command: "node",

args: ["dist/server.js"],

});

this.mcpClient = new Client({

name: "openai-mcp-client",

version: "1.0.0",

});

await this.mcpClient.connect(transport);

// Descubre herramientas disponibles

const toolsResponse = await this.mcpClient.listTools();

this.availableTools = toolsResponse.tools;

}

async executeWithOpenAI(userMessage: string) {

const messages = [{ role: "user" as const, content: userMessage }];

// Convierte herramientas MCP al formato de función de OpenAI

const tools = this.availableTools.map((tool) => ({

type: "function" as const,

function: {

name: tool.name,

description: tool.description,

parameters: tool.inputSchema,

},

}));

let response = await this.openaiClient.chat.completions.create({

model: "gpt-4",

messages,

tools,

});

// Maneja llamadas a herramientas en bucle

while (response.choices[0].finish_reason === "tool_calls") {

const toolCalls = response.choices[0].message.tool_calls || [];

for (const toolCall of toolCalls) {

const toolName = toolCall.function.name;

const toolArgs = JSON.parse(toolCall.function.arguments);

// Ejecuta la herramienta en el servidor MCP

const toolResult = await this.mcpClient.callTool({

name: toolName,

arguments: toolArgs,

});

// Añade el resultado a los mensajes

messages.push({

role: "assistant",

content: response.choices[0].message.content || "",

});

messages.push({

role: "tool",

content: JSON.stringify(toolResult),

tool_call_id: toolCall.id,

});

}

// Obtén la siguiente respuesta de OpenAI

response = await this.openaiClient.chat.completions.create({

model: "gpt-4",

messages,

tools,

});

}

return response.choices[0].message.content;

}

}

// Uso

const bridge = new MCPOpenAIBridge();

await bridge.initialize();

const result = await bridge.executeWithOpenAI(

"¿Cuál es el historial de pedidos del cliente 12345?"

);

console.log(result);

La seguridad es fundamental al construir servidores MCP que interactúan con datos sensibles y APIs externas. Implementa múltiples capas de seguridad:

Gestión de claves API:

import crypto from "crypto";

class APIKeyManager {

private validKeys: Set<string> = new Set();

constructor() {

// Carga las claves API válidas desde el entorno o almacenamiento seguro

const keys = process.env.VALID_API_KEYS?.split(",") || [];

this.validKeys = new Set(keys);

}

validateRequest(apiKey: string): boolean {

return this.validKeys.has(apiKey);

}

generateNewKey(): string {

return crypto.randomBytes(32).toString("hex");

}

}

Firmado y verificación de solicitudes:

import crypto from "crypto";

function signRequest(payload: any, secret: string): string {

return crypto

.createHmac("sha256", secret)

.update(JSON.stringify(payload))

.digest("hex");

}

function verifySignature(payload: any, signature: string, secret: string): boolean {

const expectedSignature = signRequest(payload, secret);

return crypto.timingSafeEqual(

Buffer.from(signature),

Buffer.from(expectedSignature)

);

}

Limitación de velocidad (Rate Limiting):

import rateLimit from "express-rate-limit";

const limiter = rateLimit({

windowMs: 15 * 60 * 1000, // 15 minutos

max: 100, // máximo 100 solicitudes por IP en este periodo

message: "Demasiadas solicitudes desde esta IP, por favor intenta más tarde.",

});

app.use("/api/", limiter);

Saneado de entradas:

function sanitizeInput(input: string): string {

// Elimina caracteres potencialmente peligrosos

return input

.replace(/[<>]/g, "")

.trim()

.substring(0, 1000); // Limita la longitud

}

function validateCustomerId(customerId: string): boolean {

// Solo permite alfanuméricos y guiones

return /^[a-zA-Z0-9-]+$/.test(customerId);

}

Las pruebas exhaustivas aseguran que tu servidor MCP funciona correctamente y gestiona los casos límite de forma adecuada.

Ejemplo de pruebas unitarias (Jest):

import { getCustomerInfo } from "../tools/customer";

describe("Herramientas de cliente", () => {

test("debería retornar información del cliente para un ID válido", async () => {

const result = await getCustomerInfo("cust_123");

expect(result).toHaveProperty("id");

expect(result).toHaveProperty("name");

expect(result).toHaveProperty("email");

});

test("debería retornar error para un ID inválido", async () => {

const result = await getCustomerInfo("invalid");

expect(result).toHaveProperty("error");

});

test("debería manejar errores de base de datos adecuadamente", async () => {

// Simula error de base de datos

const result = await getCustomerInfo("cust_error");

expect(result).toHaveProperty("error");

expect(result.status).toBe(500);

});

});

Pruebas de integración:

describe("Integración del servidor MCP", () => {

let server: Server;

beforeAll(async () => {

server = new Server({ name: "test-server", version: "1.0.0" });

// Inicializa el servidor

});

test("debería listar todas las herramientas disponibles", async () => {

const tools = await server.listTools();

expect(tools.length).toBeGreaterThan(0);

expect(tools[0]).toHaveProperty("name");

expect(tools[0]).toHaveProperty("description");

});

test("debería ejecutar una herramienta y retornar el resultado", async () => {

const result = await server.callTool({

name: "get_customer_info",

arguments: { customer_id: "cust_123" },

});

expect(result).toBeDefined();

});

});

FlowHunt proporciona una plataforma integral para automatizar todo el ciclo de vida de desarrollo, prueba y despliegue de servidores MCP. En lugar de gestionar manualmente cada paso de tu flujo de trabajo, FlowHunt te permite crear flujos de automatización inteligente que manejan tareas repetitivas y aseguran la coherencia en todo tu proceso de desarrollo.

Pruebas y validación automatizadas:

FlowHunt puede orquestar tu pipeline de pruebas, ejecutando tests unitarios, de integración y end-to-end automáticamente cada vez que subes código. Así, te aseguras de que las herramientas de tu servidor MCP funcionan correctamente antes de desplegarlas en producción.

Integración continua y despliegue:

Configura flujos de trabajo en FlowHunt para construir, probar y desplegar tu servidor MCP automáticamente cada vez que hay cambios en el repositorio. Esto elimina pasos manuales de despliegue y reduce el riesgo de errores humanos.

Monitorización y alertas:

FlowHunt puede monitorizar la salud de tu servidor MCP, rastrear los tiempos de respuesta de la API y alertarte ante cualquier incidencia. Si una herramienta empieza a fallar o el rendimiento disminuye, recibirás una notificación para actuar rápidamente.

Generación de documentación:

Genera automáticamente la documentación de la API de las herramientas de tu servidor MCP, manteniendo la documentación siempre sincronizada con la implementación real. Así, los desarrolladores siempre tendrán información precisa y actualizada sobre las herramientas disponibles.

Optimización del rendimiento:

Las analíticas de FlowHunt te ayudan a identificar cuellos de botella en la ejecución de tus herramientas. Puedes ver cuáles son las más utilizadas, las que tienen mayor latencia y dónde enfocar los esfuerzos de optimización.

El despliegue de un servidor MCP en producción requiere planificación y ejecución cuidadosa. Considera estas estrategias de despliegue:

Contenerización con Docker:

Crea un Dockerfile para tu servidor MCP:

FROM node:18-alpine

WORKDIR /app

COPY package*.json ./

RUN npm ci --only=production

COPY dist ./dist

EXPOSE 8000

CMD ["node", "dist/server.js"]

Construye y sube la imagen a un registry:

docker build -t my-mcp-server:1.0.0 .

docker push myregistry.azurecr.io/my-mcp-server:1.0.0

Despliegue en Kubernetes:

Despliega tu servidor MCP contenerizado en Kubernetes:

apiVersion: apps/v1

kind: Deployment

metadata:

name: mcp-server

spec:

replicas: 3

selector:

matchLabels:

app: mcp-server

template:

metadata:

labels:

app: mcp-server

spec:

containers:

- name: mcp-server

image: myregistry.azurecr.io/my-mcp-server:1.0.0

ports:

- containerPort: 8000

env:

- name: OPENAI_API_KEY

valueFrom:

secretKeyRef:

name: openai-secrets

key: api-key

- name: DATABASE_URL

valueFrom:

secretKeyRef:

name: db-secrets

key: connection-string

resources:

requests:

memory: "256Mi"

cpu: "250m"

limits:

memory: "512Mi"

cpu: "500m"

Configuración de entorno:

Utiliza variables de entorno para toda la configuración:

# .env.production

OPENAI_API_KEY=sk-...

DATABASE_URL=postgresql://user:pass@host:5432/db

MCP_SERVER_PORT=8000

LOG_LEVEL=info

ENABLE_METRICS=true

A medida que tu servidor MCP crece en complejidad, considera estos patrones avanzados:

Composición de herramientas:

Crea herramientas de alto nivel que combinen varias herramientas de bajo nivel:

async function processCustomerRefund(customerId: string, orderId: string, amount: number) {

// Obtener información del cliente

const customer = await getCustomerInfo(customerId);

// Obtener detalles del pedido

const order = await getOrderDetails(orderId);

// Verificar que el pedido pertenece al cliente

if (order.customerId !== customerId) {

throw new Error("El pedido no pertenece al cliente");

}

// Procesar reembolso

const refund = await createRefund(orderId, amount);

// Enviar notificación

await sendNotification(customer.email, `Reembolso de $${amount} procesado`);

return refund;

}

Estrategia de caché:

Implementa caché para reducir la latencia y llamadas a la API:

import NodeCache from "node-cache";

const cache = new NodeCache({ stdTTL: 600 }); // TTL de 10 minutos

async function getCustomerInfoWithCache(customerId: string) {

const cacheKey = `customer_${customerId}`;

// Consulta primero la caché

const cached = cache.get(cacheKey);

if (cached) {

return cached;

}

// Consulta a la base de datos

const customer = await getCustomerInfo(customerId);

// Almacena en caché

cache.set(cacheKey, customer);

return customer;

}

Procesamiento asíncrono de trabajos:

Para operaciones de larga duración, implementa procesamiento asíncrono:

import Bull from "bull";

const jobQueue = new Bull("mcp-jobs");

jobQueue.process(async (job) => {

const { toolName, arguments: args } = job.data;

// Ejecuta la herramienta

const result = await executeTool(toolName, args);

return result;

});

async function executeToolAsync(toolName: string, args: any) {

const job = await jobQueue.add(

{ toolName, arguments: args },

{ attempts: 3, backoff: { type: "exponential", delay: 2000 } }

);

return job.id;

}

Los servidores MCP en producción requieren monitorización y registro exhaustivos:

Logs estructurados:

import winston from "winston";

const logger = winston.createLogger({

format: winston.format.json(),

transports: [

new winston.transports.File({ filename: "error.log", level: "error" }),

new winston.transports.File({ filename: "combined.log" }),

],

});

logger.info("Herramienta ejecutada", {

toolName: "get_customer_info",

customerId: "cust_123",

duration: 145,

status: "success",

});

Recopilación de métricas:

import prometheus from "prom-client";

const toolExecutionDuration = new prometheus.Histogram({

name: "mcp_tool_execution_duration_ms",

help: "Duración de la ejecución de herramientas en milisegundos",

labelNames: ["tool_name", "status"],

});

const toolExecutionCounter = new prometheus.Counter({

name: "mcp_tool_executions_total",

help: "Número total de ejecuciones de herramientas",

labelNames: ["tool_name", "status"],

});

async function executeToolWithMetrics(toolName: string, args: any) {

const startTime = Date.now();

try {

const result = await executeTool(toolName, args);

const duration = Date.now() - startTime;

toolExecutionDuration.labels(toolName, "success").observe(duration);

toolExecutionCounter.labels(toolName, "success").inc();

return result;

} catch (error) {

const duration = Date.now() - startTime;

toolExecutionDuration.labels(toolName, "error").observe(duration);

toolExecutionCounter.labels(toolName, "error").inc();

throw error;

}

}

Construir un servidor MCP que se conecta a OpenAI representa un paso significativo hacia la creación de aplicaciones de IA inteligentes e integradas. Siguiendo los patrones arquitectónicos, estrategias de implementación y buenas prácticas descritas en esta guía, puedes crear servidores MCP robustos y escalables que amplían las capacidades de OpenAI mucho más allá de su entrenamiento base.

La clave del éxito reside en una planificación cuidadosa de las definiciones de tus herramientas, una implementación minuciosa de medidas de seguridad, pruebas exhaustivas y monitorización continua en producción. Comienza con un conjunto simple de herramientas, valida que funcionan correctamente con OpenAI y expande gradualmente las capacidades de tu servidor a medida que adquieras experiencia y confianza.

Recuerda que tu servidor MCP no es un artefacto estático: es un sistema vivo que evolucionará conforme cambien las necesidades de tu negocio y descubras nuevas formas de aprovechar la IA en tus operaciones. Construye con modularidad y extensibilidad en mente, documenta tus herramientas cuidadosamente y mantén una separación clara entre tu lógica de negocio y la implementación del protocolo MCP.

La combinación de servidores MCP y los potentes modelos de lenguaje de OpenAI crea oportunidades sin precedentes para la automatización, la inteligencia y la integración. Al dominar esta tecnología, te posicionas a ti y a tu organización a la vanguardia de la innovación impulsada por IA.

Automatiza el desarrollo, pruebas y despliegue de tu servidor MCP. Desde integración continua hasta monitorización en producción, FlowHunt optimiza cada paso del ciclo de vida de desarrollo de IA.

El Model Context Protocol es un marco estandarizado que permite a modelos de IA como el GPT de OpenAI descubrir, comprender y ejecutar herramientas y funciones proporcionadas por servidores externos. Actúa como un puente entre los modelos de IA y la lógica empresarial personalizada.

Necesitas una clave de API válida de OpenAI con los permisos adecuados. El propio servidor MCP no requiere permisos especiales de OpenAI: se comunica mediante llamadas estándar a la API. Sin embargo, debes implementar autenticación y autorización adecuadas en tu servidor MCP.

Los servidores MCP pueden construirse en cualquier lenguaje que soporte APIs HTTP/REST o conexiones WebSocket. Las opciones más populares incluyen Python, TypeScript/Node.js, Java, C#/.NET y Go. La elección del lenguaje depende de tu infraestructura existente y la experiencia de tu equipo.

Implementa limitación de velocidad (rate limiting) en tu servidor MCP, cachea los resultados solicitados con frecuencia, utiliza retroceso exponencial (exponential backoff) para reintentos y monitoriza el uso de la API de OpenAI. Considera implementar un sistema de colas para las solicitudes de herramientas y así gestionar la carga de manera efectiva.

Arshia es ingeniera de flujos de trabajo de IA en FlowHunt. Con formación en ciencias de la computación y una pasión por la IA, se especializa en crear flujos de trabajo eficientes que integran herramientas de IA en las tareas cotidianas, mejorando la productividad y la creatividad.

Optimiza el desarrollo, prueba y despliegue de tu servidor MCP con la plataforma de automatización inteligente de FlowHunt.

Aprenda a construir y desplegar un servidor de Protocolo de Contexto de Modelo (MCP) para conectar modelos de IA con herramientas externas y fuentes de datos. G...

Descubre qué son los servidores MCP (Model Context Protocol), cómo funcionan y por qué están revolucionando la integración de la IA. Aprende cómo MCP simplifica...

Explora ejemplos completos de servidores MCP y aprende cómo construir, desplegar e integrar servidores Model Context Protocol para potenciar las capacidades de ...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.