Introducción

La ingeniería de contexto se ha convertido en una de las disciplinas más críticas para construir agentes de IA eficaces. A medida que los modelos de lenguaje se vuelven más potentes y los agentes abordan tareas cada vez más complejas y de múltiples pasos, el reto no es solo disponer de un modelo capaz, sino gestionar estratégicamente la información que se le proporciona. Cada token cuenta. En esta guía completa, exploraremos qué es la ingeniería de contexto, por qué es esencial para el rendimiento de los agentes de IA y las técnicas específicas que emplean las organizaciones líderes en investigación de IA y las plataformas para construir agentes óptimos. Ya sea que estés creando bots de atención al cliente, agentes de análisis de datos o flujos de trabajo autónomos, comprender la ingeniería de contexto mejorará fundamentalmente el rendimiento de tus sistemas de IA.

¿Qué es la Ingeniería de Contexto?

La ingeniería de contexto representa un cambio fundamental en la forma de concebir la construcción con modelos de lenguaje grandes. En lugar de ver el LLM como una caja negra que solo necesita buenas instrucciones, la ingeniería de contexto trata al modelo como un sistema con recursos cognitivos finitos que deben ser gestionados cuidadosamente. En esencia, la ingeniería de contexto consiste en saber exactamente qué contexto proporcionar a un agente de IA—reflexionando deliberadamente sobre cada token que pasa por cada llamada al LLM para crear las condiciones óptimas para que el agente tenga éxito.

Este concepto ha sido popularizado por investigadores como Andrej Karpathy y ha cobrado una importancia creciente a medida que los agentes de IA han evolucionado de simples chatbots a sofisticados sistemas capaces de razonar y actuar de forma autónoma. La idea fundamental es que los LLM, como los humanos, tienen una memoria de trabajo y una capacidad de atención limitadas. Así como una persona solo puede concentrarse en determinada cantidad de información antes de confundirse o perder detalles importantes, los modelos de lenguaje experimentan una degradación en sus habilidades de razonamiento cuando se les presenta un contexto excesivo. Esto significa que la calidad del contexto importa mucho más que la cantidad.

La ingeniería de contexto va más allá de la tradicional ingeniería de prompts, que se centraba principalmente en redactar el prompt o las instrucciones perfectas del sistema. En cambio, abarca todo el ecosistema de información disponible para un agente a lo largo de múltiples turnos de interacción—incluyendo prompts de sistema, definiciones de herramientas, ejemplos, historial de mensajes, datos recuperados e información cargada dinámicamente. El objetivo es mantener una ventana de contexto ajustada y de alta relevancia que proporcione al agente exactamente lo que necesita para tomar buenas decisiones, sin saturarlo de información irrelevante.

¿Listo para hacer crecer tu negocio?

Comienza tu prueba gratuita hoy y ve resultados en días.

Por Qué la Ingeniería de Contexto es Fundamental para Construir Agentes de IA Capaces

La importancia de la ingeniería de contexto no puede subestimarse al construir agentes de IA para producción. La investigación ha demostrado de forma consistente que los LLM experimentan lo que se conoce como “context rot”—una degradación medible del rendimiento a medida que la ventana de contexto se amplía. Estudios basados en técnicas de benchmarking tipo “aguja en un pajar” han demostrado que, al aumentar el número de tokens en el contexto, disminuye la capacidad del modelo para recordar y razonar con precisión sobre esa información. No es un efecto menor; es una limitación arquitectónica fundamental de los modelos de lenguaje basados en transformers.

La causa de esta degradación radica en la propia arquitectura transformer. En los transformers, cada token puede atender a cualquier otro token del contexto, creando n² relaciones para n tokens. A medida que aumenta la longitud del contexto, el mecanismo de atención del modelo se ve sobrecargado al intentar mantener estas relaciones en un espacio cada vez mayor. Además, los modelos de lenguaje se entrenan principalmente en secuencias cortas, por lo que tienen menos experiencia y menos parámetros especializados para manejar dependencias de muy largo alcance. Esto genera una tensión natural entre el tamaño del contexto y la capacidad de razonamiento: los modelos funcionan a contextos largos pero muestran menor precisión en la recuperación de información y el razonamiento a largo plazo en comparación con su rendimiento en contextos cortos.

Más allá de las limitaciones arquitectónicas, hay una realidad práctica: los LLM tienen un “presupuesto de atención” que se agota con cada nuevo token introducido. Cada pieza de información que añades al contexto consume parte de este presupuesto, aumentando la carga cognitiva del modelo. Por eso la ingeniería de contexto reflexiva es esencial. Si seleccionas cuidadosamente la información que llega al modelo, no solo optimizas la eficiencia—mejoras directamente la calidad del razonamiento y la toma de decisiones del agente. Un agente con una ventana de contexto ajustada y bien organizada tomará mejores decisiones, se recuperará mejor de errores y mantendrá un rendimiento consistente en secuencias de interacción largas, en comparación con un agente saturado de información irrelevante.

Entendiendo la Ingeniería de Contexto vs. Ingeniería de Prompts

Aunque la ingeniería de contexto y la ingeniería de prompts están relacionadas, representan diferentes niveles de abstracción al construir con modelos de lenguaje. La ingeniería de prompts, que predominó en la primera etapa de las aplicaciones con LLM, se centra específicamente en cómo redactar prompts e instrucciones de sistema eficaces. El objetivo principal es elegir las palabras y frases adecuadas para provocar el comportamiento deseado del modelo en una tarea concreta. Este enfoque funciona bien para tareas discretas de un solo turno, como clasificación, resumen o generación de texto puntual.

La ingeniería de contexto, en cambio, es la evolución natural de la ingeniería de prompts para la era de los agentes autónomos de múltiples turnos. Mientras la ingeniería de prompts pregunta “¿Cómo redacto la instrucción perfecta?”, la ingeniería de contexto plantea una cuestión más amplia: “¿Cuál es la configuración óptima de toda la información disponible que generará el comportamiento deseado?” Esto incluye no solo el prompt de sistema, sino también las herramientas disponibles para el agente, los ejemplos proporcionados, el historial de mensajes de turnos anteriores, cualquier dato recuperado y los metadatos que ayudan al agente a entender su entorno.

La transición de la ingeniería de prompts a la ingeniería de contexto refleja un cambio fundamental en la forma de construir aplicaciones de IA. Al principio, la mayoría de los casos de uso fuera del chat cotidiano requerían prompts optimizados para tareas de un solo disparo. Hoy en día, el campo avanza hacia agentes más capaces que operan en múltiples turnos de inferencia y horizontes temporales largos. Estos agentes generan cada vez más datos potencialmente relevantes para futuras decisiones, y esta información debe refinarse y seleccionarse cíclicamente. La ingeniería de contexto es la disciplina de gestionar todo este ecosistema de información en evolución, asegurando que en cada paso del proceso de razonamiento del agente, disponga exactamente de la información adecuada para tomar buenas decisiones.

Únete a nuestro boletín

Obtén los últimos consejos, tendencias y ofertas gratis.

Las Cuatro Técnicas Clave de la Ingeniería de Contexto

Las organizaciones líderes en investigación de IA y las plataformas han convergido en cuatro técnicas principales para la ingeniería de contexto eficaz. Cada una aborda un aspecto distinto del reto de gestionar ventanas de contexto limitadas manteniendo el rendimiento del agente. Entender estas técnicas y cómo aplicarlas es esencial para construir agentes de IA listos para producción.

Técnica 1: Offloading — Resumir y Gestionar Referencias

El offloading consiste en resumir información y almacenar los datos completos en referencias externas, permitiendo que el agente acceda a información detallada solo cuando la necesita. Cuando un agente de IA realiza una llamada a una herramienta—por ejemplo, consulta una base de datos o un API externo—recibe una respuesta que puede ser muy grande. En lugar de volcar toda la respuesta en la ventana de contexto, el offloading implica resumir la información clave y proporcionar una referencia que el agente puede usar para recuperar los datos completos si es necesario.

Un ejemplo práctico de este enfoque viene de Manus AI, una organización de investigación que trabaja con agentes de IA avanzados. Cuando su agente realiza una llamada a una herramienta y recibe una respuesta, no incluyen la respuesta completa en el contexto. En su lugar, proporcionan un resumen conciso y almacenan el resultado completo de la llamada en un archivo o base de datos con un puntero de referencia. Si el agente determina posteriormente que necesita más información de esa llamada, puede consultar los datos almacenados sin consumir más tokens de contexto en la conversación principal. Este enfoque refleja el modo en que funcionamos los humanos: no memorizamos cada detalle de cada conversación, sino que guardamos notas y referencias que podemos consultar cuando lo necesitamos.

Cognition, otra organización líder en investigación en IA, ha implementado un enfoque similar pero con un sistema de resúmenes propio. En lugar de depender de resúmenes genéricos, han construido una lógica de resumen especializada que extrae la información más relevante según sus casos de uso. Esto demuestra un principio importante: la mejor estrategia de offloading suele ser específica para cada tarea. Lo que constituye un resumen útil depende de lo que el agente intenta lograr. Si adaptas el resumen al dominio y tarea específicos, puedes mantener un contexto de alta calidad y reducir drásticamente el consumo de tokens.

Técnica 2: Reducción — Compactar el Contexto con el Tiempo

La reducción es la técnica de compactar y condensar el contexto para reducir el número total de tokens manteniendo la información esencial. A medida que un agente opera en varios turnos, el historial de conversación crece. Sin una gestión activa, este historial puede consumir rápidamente toda la ventana de contexto, dejando poco espacio para nueva información o razonamiento. La reducción soluciona esto resumiendo o compactando periódicamente la conversación en una forma más concisa.

Anthropic ha implementado esto mediante una técnica que llaman “compactar” la conversación. En lugar de conservar todo el historial de mensajes, periódicamente resumen o comprimen el historial en una versión más condensada. Esto es especialmente importante porque la investigación ha demostrado que mucho contexto dificulta el razonamiento eficaz de los agentes de IA. El exceso de contexto puede llevar a lo que se llama “envenenamiento de contexto”—un fenómeno en el que el proceso de razonamiento del agente se desvía debido a información irrelevante, alejándolo del camino óptimo.

La técnica de reducción se basa en un principio fundamental sobre cómo funcionan los modelos de lenguaje: no necesariamente razonan mejor con más información. De hecho, a menudo ocurre lo contrario. Un contexto ajustado y bien organizado que contenga solo la información más relevante suele conducir a un mejor razonamiento y un comportamiento más fiable del agente. Por eso muchas organizaciones líderes trabajan activamente para reducir el tamaño del contexto con el tiempo, incluso cuando podría haber más información disponible. Al mantener la ventana de contexto enfocada y manejable, conservan la capacidad del agente para razonar claramente y tomar buenas decisiones.

Técnica 3: Recuperación (RAG) — Carga Dinámica de Contexto

La Recuperación Aumentada por Generación (RAG) es una técnica en la que la información relevante se recupera y carga dinámicamente en el contexto en tiempo de ejecución, en lugar de precargarla desde el principio. Este enfoque se ha vuelto cada vez más popular a medida que los agentes se han sofisticado. En vez de intentar anticipar toda la información que podría necesitar un agente y cargarla de antemano, los sistemas RAG permiten que los agentes busquen activamente y recuperen información cuando determinan que es necesaria.

La ventaja de este enfoque es significativa. Primero, reduce drásticamente la carga inicial de contexto: el agente empieza con una ventana de contexto ajustada y solo añade información según la necesita. Segundo, permite una revelación progresiva, en la que el agente descubre de forma incremental el contexto relevante a través de la exploración. Cada interacción genera nueva información que informa la siguiente decisión. Por ejemplo, un agente puede comenzar buscando archivos relevantes, descubrir que ciertos archivos son más importantes por su nombre o fecha, y luego recuperar esos archivos específicos para un análisis detallado. Este enfoque en capas es mucho más eficiente que intentar cargarlo todo desde el principio.

Claude Code de Anthropic es un excelente ejemplo de RAG en la práctica. En lugar de cargar toda una base de código en el contexto, Claude Code mantiene identificadores ligeros como rutas de archivo y usa herramientas como grep y glob para recuperar dinámicamente los archivos relevantes según sea necesario. El agente puede escribir consultas específicas, almacenar resultados y usar herramientas de línea de comandos para analizar grandes volúmenes de datos sin cargar nunca los objetos de datos completos en el contexto. Este enfoque refleja la cognición humana: no memorizamos todos los cuerpos de información, sino que hemos desarrollado sistemas externos de organización como sistemas de archivos y herramientas de búsqueda que nos permiten recuperar información relevante bajo demanda.

Técnica 4: Aislamiento — Subagentes y Separación de Tareas

El aislamiento consiste en usar subagentes para gestionar tareas específicas, asegurando que diferentes agentes trabajen en problemas separados sin solapamiento de contexto. Esta técnica reconoce que, a veces, la mejor manera de gestionar el contexto es dividir un problema complejo en subproblemas más enfocados, cada uno gestionado por un agente dedicado con su propia ventana de contexto.

Hay dos paradigmas principales en cuanto al aislamiento. Cognition, una organización líder en IA, desaconseja el uso de subagentes salvo que las tareas estén completamente separadas y sin solapamiento. Su filosofía es que los subagentes añaden complejidad y puntos potenciales de fallo, y solo deben usarse si es absolutamente necesario. Sin embargo, otras organizaciones como Cloud Code han adoptado los subagentes como parte central de su arquitectura. En Cloud Code, puedes crear subagentes para diferentes aspectos de una tarea mayor, con un agente gestor coordinando entre ellos.

La clave del aislamiento es que supone un equilibrio. Por un lado, usar subagentes ayuda a gestionar el contexto dividiendo el espacio del problema: cada agente tiene una ventana de contexto enfocada y relevante para su tarea concreta. Por otro lado, los subagentes introducen sobrecarga de coordinación y puntos potenciales de fallo al transferir información entre agentes. El enfoque adecuado depende de tu caso de uso. Para tareas muy complejas con subproblemas claros, el aislamiento puede ser muy eficaz. Para tareas donde los diferentes aspectos están muy acoplados, puede ser más apropiado un solo agente con un contexto bien gestionado.

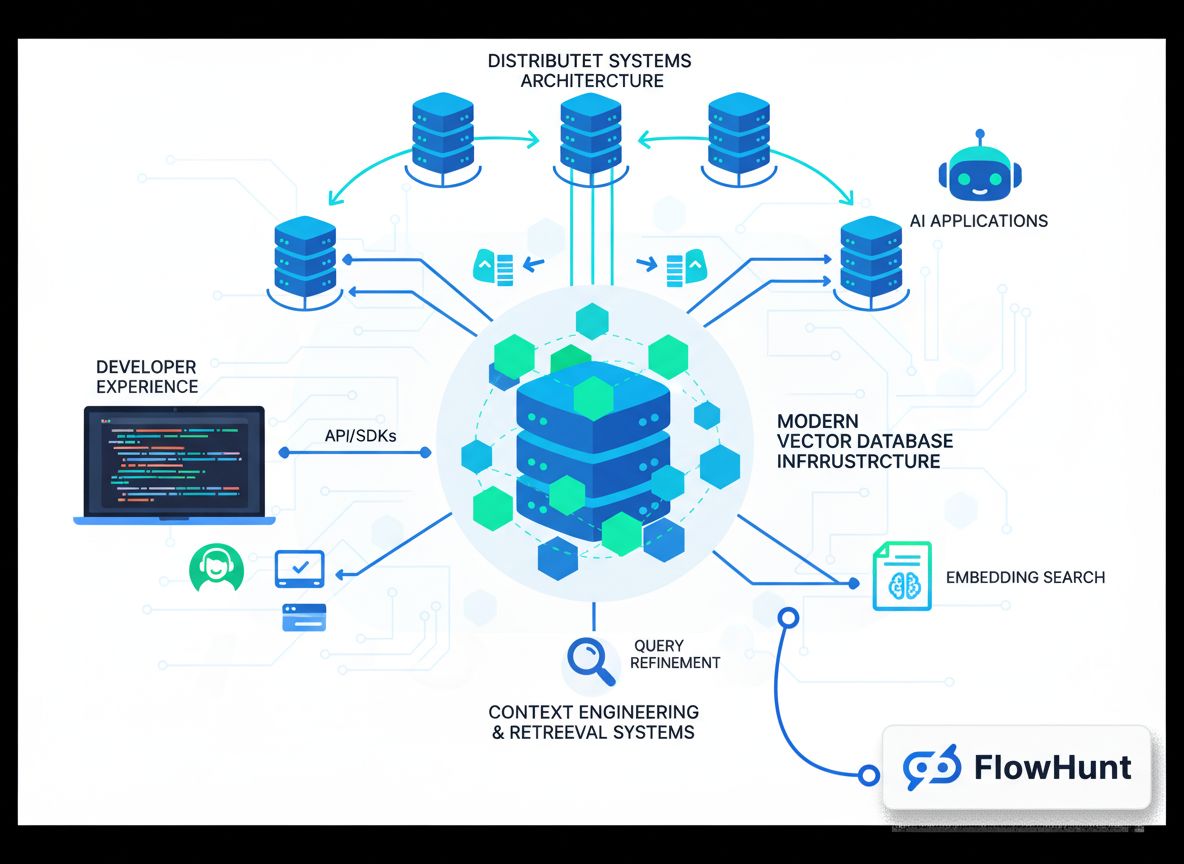

Implementación de la Ingeniería de Contexto en FlowHunt

FlowHunt ofrece una plataforma integral sin código para implementar todas estas técnicas de ingeniería de contexto. En vez de requerir que los desarrolladores creen soluciones personalizadas, FlowHunt permite a los equipos implementar estrategias sofisticadas de gestión de contexto mediante una interfaz visual intuitiva. Esto democratiza la ingeniería de contexto, haciéndola accesible incluso para equipos sin experiencia profunda en machine learning.

Dentro de FlowHunt, puedes implementar el aislamiento a través de equipos autogestionados. Un equipo autogestionado consiste en varios agentes de IA con un agente gestor que coordina entre ellos. El agente gestor recibe la tarea inicial, la divide en subtareas y las delega a agentes especializados. Cada agente mantiene su propia ventana de contexto enfocada y relevante para su responsabilidad específica. Una vez que los subagentes completan su trabajo, el agente gestor sintetiza los resultados. Este enfoque permite abordar problemas complejos dividiéndolos en partes manejables, cada una con su contexto optimizado.

FlowHunt también soporta flujos de tareas secuenciales, donde varios agentes trabajan en un problema en secuencia y la salida de cada agente se convierte en la entrada del siguiente. Esto es especialmente útil en flujos de trabajo con dependencias claras. Por ejemplo, en un flujo de generación de contenido, un agente puede investigar un tema, otro puede estructurar el contenido y un tercero escribir la pieza final. Cada agente tiene una ventana de contexto enfocada solo en lo relevante para su paso.

Además, FlowHunt permite construir sistemas inteligentes de recuperación directamente en tus flujos. En vez de cargar toda la información de antemano, puedes configurar agentes para recuperar dinámicamente los datos relevantes según sea necesario. Esto puede implicar consultar bases de datos, buscar en bases de conocimiento o recuperar archivos según el razonamiento del agente sobre la información que necesita. Combinando estas capacidades, FlowHunt permite implementar ingeniería de contexto a nivel empresarial sin escribir una línea de código.

Estrategias Avanzadas de Ingeniería de Contexto y Aplicaciones Reales

Más allá de las cuatro técnicas fundamentales, existen varias estrategias avanzadas que las organizaciones líderes utilizan para ampliar los límites de lo posible en ingeniería de contexto. Estos enfoques suelen combinar varias técnicas y requieren ajustes cuidadosos para casos de uso específicos.

Una estrategia avanzada es la gestión híbrida de contexto, donde se combina contexto precargado y recuperación justo a tiempo. En vez de elegir entre cargarlo todo al principio o recuperar todo dinámicamente, los enfoques híbridos cargan cierta información crítica al principio por velocidad y fiabilidad, mientras mantienen la capacidad de recuperar información adicional según sea necesario. Claude Code utiliza este enfoque híbrido: los archivos CLAUDE.md se introducen de forma directa en el contexto porque suelen ser pequeños y contienen información de configuración importante, mientras que archivos y datos más grandes se recuperan en el momento usando herramientas como grep y glob.

Otra estrategia avanzada implica la selección de contexto basada en metadatos. En vez de fijarse solo en el contenido de la información, sistemas sofisticados utilizan metadatos como nombres de archivo, fechas, jerarquías de carpetas y otras señales organizativas para tomar decisiones inteligentes sobre qué información es relevante. Un agente operando en un sistema de archivos, por ejemplo, puede inferir mucho de la presencia de un archivo llamado test_utils.py en una carpeta tests frente al mismo archivo en src/core_logic/. Estas señales ayudan a los agentes a entender cómo y cuándo usar la información, reduciendo la necesidad de cargar y analizar todo el contenido.

La mitigación del envenenamiento de contexto es otra estrategia avanzada crítica. Como se discutió antes, el envenenamiento de contexto ocurre cuando información irrelevante en el contexto hace que el proceso de razonamiento del agente se desvíe del camino óptimo. Los sistemas avanzados trabajan activamente para identificar y eliminar contexto potencialmente tóxico. Esto puede implicar analizar la cadena de razonamiento del agente para detectar dónde se desvió y luego eliminar o reformular el contexto que condujo a esa desviación. Con el tiempo, esto crea un bucle de retroalimentación que mejora continuamente la calidad del contexto.

El Futuro de la Ingeniería de Contexto y el Desarrollo de Agentes de IA

A medida que los agentes de IA se sofisticarán y se desplieguen en escenarios reales cada vez más complejos, la ingeniería de contexto será aún más importante. El campo evoluciona rápidamente, surgiendo constantemente nuevas técnicas y buenas prácticas. Varias tendencias probablemente moldearán el futuro de la ingeniería de contexto.

Primero, veremos sistemas de curación de contexto automatizados más sofisticados. En vez de decidir manualmente qué contexto incluir, los sistemas futuros utilizarán machine learning para determinar automáticamente el contexto óptimo para cada agente y tarea. Estos sistemas podrán aprender del rendimiento de los agentes para identificar qué piezas de contexto son más valiosas y cuáles pueden resultar perjudiciales.

Segundo, la ingeniería de contexto se integrará más con el diseño arquitectónico de los agentes. En vez de tratar la gestión de contexto como un añadido, los sistemas de agentes futuros se diseñarán desde cero para ser eficientes en el manejo del contexto. Esto podría implicar nuevas arquitecturas de agentes intrínsecamente mejores para manejar ventanas de contexto limitadas o nuevas formas de representar la información de forma más eficiente en tokens.

Tercero, veremos la aparición de la ingeniería de contexto como una disciplina profesional diferenciada, con herramientas, frameworks y buenas prácticas especializadas. Igual que la ingeniería de prompts evolucionó de una práctica ad hoc a una disciplina reconocida con técnicas establecidas, la ingeniería de contexto sigue una trayectoria similar. Las organizaciones invertirán en crear equipos y herramientas especializadas centradas específicamente en la optimización del contexto.

{{ cta-dark-panel

heading=“Potencia tu flujo de trabajo con FlowHunt”

description=“Descubre cómo FlowHunt automatiza tus flujos de contenido y SEO con IA: desde la investigación y generación de contenido hasta la publicación y analítica, todo en un solo lugar.”

ctaPrimaryText=“Solicitar una Demo”

ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo"

ctaSecondaryText=“Prueba FlowHunt Gratis”

ctaSecondaryURL=“https://app.flowhunt.io/sign-in"

gradientStartColor="#123456”

gradientEndColor="#654321”

gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217”

}}

Implementación Práctica: Construyendo tu Primer Agente con Ingeniería de Contexto

Para ayudarte a empezar con la ingeniería de contexto, repasemos un ejemplo práctico de construcción de un agente con ingeniería de contexto para un caso de uso común: la investigación y generación de contenido. Este ejemplo muestra cómo aplicar las técnicas que hemos tratado en un escenario real.

Comienza definiendo claramente la responsabilidad principal de tu agente. En este caso, el trabajo del agente es investigar un tema y generar un artículo completo. En vez de intentar hacerlo todo en un solo agente con una enorme ventana de contexto, usarás aislamiento para crear un sistema multiagente. El primer agente es un investigador que recopila información sobre el tema. El segundo agente es un redactor que utiliza la investigación para crear el artículo. Un agente gestor coordina entre ambos.

Para el agente investigador, implementa la gestión de contexto basada en recuperación. En vez de cargar toda la información disponible sobre el tema de antemano, el agente investigador debe tener herramientas para buscar en bases de datos, consultar APIs y recuperar documentos relevantes. Conforme descubre información, resume los hallazgos clave y almacena referencias a las fuentes completas. Así, la ventana de contexto del investigador se mantiene ajustada pero con acceso a toda la información necesaria.

Para el agente redactor, implementa offloading. El investigador pasa un resumen de hallazgos al redactor, junto con referencias a las fuentes completas. El contexto del redactor incluye el resumen y la posibilidad de recuperar material fuente completo si lo necesita. Esto permite al redactor trabajar eficientemente sin verse saturado de datos brutos de investigación.

Durante el proceso, monitoriza el envenenamiento de contexto. Si observas que el agente toma malas decisiones o se desvía, analiza su razonamiento para identificar qué partes del contexto pueden estar causando el problema. Elimina o reformula ese contexto y prueba de nuevo. Con el tiempo, desarrollarás una intuición sobre qué contexto funciona mejor para tu caso de uso concreto.

Medición y Optimización del Rendimiento de la Ingeniería de Contexto

Una ingeniería de contexto eficaz requiere medición y optimización continua. Debes establecer métricas que te ayuden a entender si tus esfuerzos realmente mejoran el rendimiento del agente. Algunas métricas clave a seguir:

Primero, mide la eficiencia de tokens—la relación entre la salida útil y los tokens consumidos. Un agente que produce resultados de alta calidad usando menos tokens es más eficiente. Haz un seguimiento de esta métrica a lo largo del tiempo conforme implementes técnicas de ingeniería de contexto. Deberías ver mejoras al aplicar estrategias de offloading, reducción y recuperación.

Segundo, mide la calidad del razonamiento. Esto puede implicar analizar las cadenas de razonamiento del agente para comprobar si son coherentes y lógicas, o medir la calidad de las salidas del agente frente a un estándar de referencia. A medida que mejores la ingeniería de contexto, la calidad del razonamiento debería aumentar porque el agente tiene menos información irrelevante que lo distraiga.

Tercero, mide la recuperación de errores. ¿Qué tan bien se recupera el agente cuando comete un error? Una mejor ingeniería de contexto debería llevar a una mejor recuperación, ya que el agente dispone de información más clara sobre lo que salió mal y qué hacer a continuación.

Cuarto, mide la latencia y el coste. Aunque la ingeniería de contexto se centra principalmente en la calidad, también tiene beneficios de eficiencia. Los agentes con ventanas de contexto mejor gestionadas suelen tener menor latencia (porque procesan menos tokens) y menor coste (porque consumen menos tokens). Haz un seguimiento de estas métricas para comprender el impacto total de tus esfuerzos de ingeniería de contexto.

Errores Comunes y Cómo Evitarlos

Al implementar ingeniería de contexto, hay varios errores comunes que los equipos suelen cometer. Ser consciente de ellos te ayudará a evitar problemas costosos.

El primer error es la sobreoptimización. Es tentador intentar reducir al máximo los tokens de la ventana de contexto, pero esto puede dejar un contexto demasiado escaso para ser útil. Recuerda que el objetivo es encontrar el equilibrio óptimo: suficiente información para que el agente razone eficazmente, pero no tanta como para confundirlo. Empieza con una cantidad razonable de contexto y solo redúcela si observas que el agente funciona bien.

El segundo error es ignorar los requisitos específicos de la tarea. La ingeniería de contexto no es igual para todas las situaciones. Lo que sirve para un agente de atención al cliente puede no servir para uno de análisis de datos. Dedica tiempo a entender tu caso y adapta tu enfoque de ingeniería de contexto en consecuencia.

El tercer error es no monitorizar ni iterar. La ingeniería de contexto no es una actividad puntual. Conforme el agente se enfrenta a nuevas situaciones y evolucionan los requisitos, debes monitorizar el rendimiento y ajustar tu estrategia de contexto. Incorpora la monitorización y la iteración desde el principio.

El cuarto error es subestimar la importancia de los metadatos. Muchos equipos se centran en el contenido de su contexto y descuidan los metadatos que ayudan a los agentes a entender cómo usar ese contenido. Nombres de archivo, fechas, estructuras de carpetas y otras señales organizativas son a menudo más valiosas de lo que imaginas. Presta atención a cómo organizas y etiquetas la información.

Conclusión

La ingeniería de contexto representa un cambio fundamental en la construcción de agentes de IA, pasando de centrarse en redactar prompts perfectos a gestionar estratégicamente toda la información disponible para optimizar el rendimiento del agente. Al comprender e implementar las cuatro técnicas clave—offloading, reducción, recuperación y aislamiento—junto con estrategias avanzadas como la gestión híbrida de contexto y la selección basada en metadatos, puedes construir agentes más capaces, fiables y eficientes. Plataformas como FlowHunt hacen accesibles estas técnicas sofisticadas a través de interfaces sin código, democratizando la ingeniería de contexto para equipos de cualquier tamaño. A medida que implementes la ingeniería de contexto en tus propios proyectos, recuerda que es un proceso iterativo que requiere medición y mejora continua. Comienza con los fundamentos, mide tus resultados e incorpora gradualmente técnicas más avanzadas conforme adquieras experiencia. Las organizaciones que dominen la ingeniería de contexto crearán los agentes de IA más capaces y fiables, obteniendo ventajas competitivas significativas en un mundo cada vez más impulsado por la IA.