Cómo un modelo de 7M parámetros está superando a los modelos AI de frontera

Descubre cómo un pequeño modelo de 7 millones de parámetros supera a Gemini, DeepSeek y Claude usando razonamiento recursivo y supervisión profunda. Conoce el e...

Un análisis en profundidad del modelo de razonamiento EXAONE Deep 32B de LG, probado frente a DeepSeek R1 y QwQ de Alibaba, examinando las afirmaciones de rendimiento superior y las capacidades de razonamiento reales.

El panorama de los modelos de razonamiento en inteligencia artificial se ha vuelto cada vez más competitivo, con múltiples organizaciones que afirman lograr avances revolucionarios en tareas matemáticas y lógicas complejas. El reciente lanzamiento por parte de LG de EXAONE Deep, un modelo de razonamiento de 32.000 millones de parámetros, generó gran atención con afirmaciones de superar a competidores establecidos como DeepSeek R1. Sin embargo, las pruebas en el mundo real revelan un panorama más matizado que el que sugieren las campañas de marketing. Este artículo ofrece un análisis detallado del rendimiento real de EXAONE Deep en comparación con otros modelos de razonamiento líderes, examinando la brecha entre los benchmarks declarados y la funcionalidad práctica. Mediante pruebas prácticas y comparaciones detalladas, exploraremos lo que estos modelos realmente pueden hacer, cómo abordan tareas de razonamiento complejas y qué significa esto para las organizaciones que consideran estas herramientas para uso en producción.

El surgimiento de modelos de razonamiento representa un cambio fundamental en cómo la inteligencia artificial aborda la resolución de problemas complejos. A diferencia de los modelos de lenguaje tradicionales que generan respuestas en una única pasada hacia adelante, los modelos de razonamiento emplean una técnica llamada decodificación en tiempo de prueba, que asigna recursos computacionales significativos durante la inferencia para pensar en los problemas paso a paso. Este enfoque imita el razonamiento humano, donde a menudo necesitamos analizar un problema desde varios ángulos antes de llegar a una solución. El concepto cobró relevancia con el modelo o1 de OpenAI y desde entonces ha sido adoptado por múltiples organizaciones, incluyendo DeepSeek, Alibaba y ahora LG. Estos modelos generan lo que se denomina una secuencia de tokens de “pensamiento” o “razonamiento” que los usuarios normalmente no ven en la salida final, pero que representa el proceso interno de deliberación del modelo. Los tokens de razonamiento son cruciales porque permiten al modelo explorar diferentes vías de solución, detectar errores y refinar su enfoque antes de comprometerse con una respuesta final. Esto es especialmente valioso para problemas matemáticos, tareas de razonamiento lógico y escenarios complejos de varios pasos donde una sola pasada podría pasar por alto detalles importantes o llevar a conclusiones incorrectas.

Para las organizaciones que implementan sistemas de IA, los modelos de razonamiento representan un avance significativo en fiabilidad y precisión para tareas complejas. Los modelos de lenguaje tradicionales suelen tener dificultades con problemas matemáticos de varios pasos, deducción lógica y escenarios que requieren un análisis cuidadoso de restricciones y condiciones. Los modelos de razonamiento abordan estas limitaciones mostrando explícitamente su trabajo, lo que también brinda transparencia acerca de cómo el modelo llegó a su conclusión. Esta transparencia es especialmente importante en entornos empresariales donde las decisiones basadas en recomendaciones de IA deben ser auditables y explicables. Sin embargo, esto tiene un coste: el coste computacional y la latencia. Debido a que los modelos de razonamiento generan extensos tokens de pensamiento antes de producir una respuesta final, requieren más potencia de procesamiento y tardan más en responder en comparación con los modelos de lenguaje estándar. Esto hace que la selección del modelo sea crítica: las organizaciones necesitan comprender no solo los resultados de benchmarks, sino el rendimiento real en casos de uso concretos. La proliferación de modelos de razonamiento de diferentes proveedores, cada uno afirmando ser superior, hace esencial la realización de pruebas y comparaciones independientes para tomar decisiones informadas de despliegue.

La entrada de LG en el espacio de modelos de razonamiento con EXAONE Deep generó considerable interés, especialmente dado el considerable potencial de investigación de la empresa y el tamaño relativamente modesto del modelo (32.000 millones de parámetros). Los materiales de marketing de LG presentaron impresionantes resultados de benchmarks, afirmando que EXAONE Deep alcanzó un 90% de precisión en la competencia AIME (American Invitational Mathematics Examination) con solo 64 intentos, y un 95% en problemas MATH-500. Estas cifras, de ser precisas, representarían un rendimiento competitivo o incluso superior a DeepSeek R1 y QwQ de Alibaba. La compañía también lanzó varias versiones del modelo en diferentes tamaños, incluyendo una variante de 2.400 millones de parámetros diseñada para usarse como modelo auxiliar en decodificación especulativa —una técnica que utiliza modelos más pequeños para predecir los tokens que generará el modelo principal, acelerando potencialmente la inferencia. Sin embargo, al someterse a pruebas prácticas en problemas estándar de razonamiento, EXAONE Deep mostró comportamientos preocupantes que contradicen los resultados de los benchmarks. El modelo mostró tendencia a entrar en bucles de pensamiento prolongados sin llegar a conclusiones lógicas, generando miles de tokens aparentemente repetitivos o sin sentido en lugar de razonamientos productivos. Este comportamiento sugiere posibles problemas en el entrenamiento del modelo, la metodología de evaluación de los benchmarks o la forma en que el modelo maneja ciertos tipos de prompts.

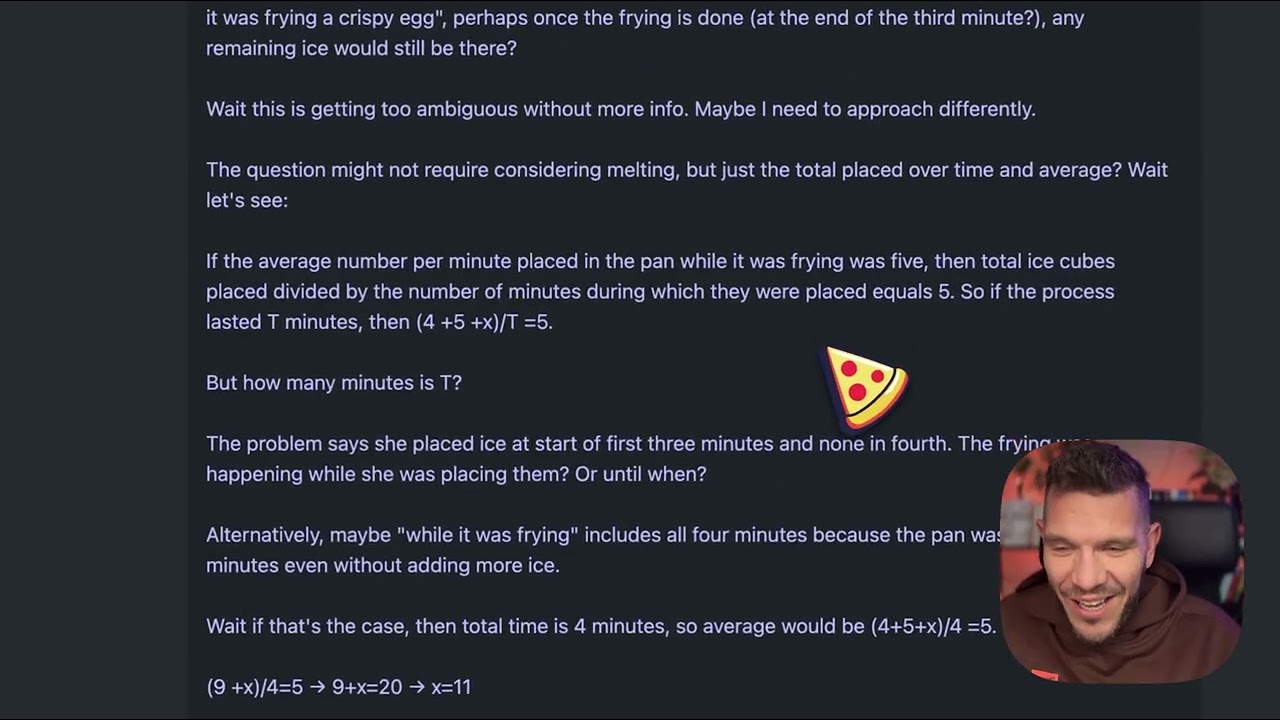

Para entender las diferencias prácticas entre modelos de razonamiento, consideremos un problema aparentemente simple que se ha convertido en un test estándar de calidad: “Beth coloca algunos cubos de hielo enteros en una sartén. Después de un minuto, hay 20 cubos de hielo. Después de dos minutos, hay 10 cubos de hielo. Después de tres minutos, hay 0 cubos de hielo. ¿Cuántos cubos de hielo enteros se pueden encontrar en la sartén al final del tercer minuto?” La respuesta correcta es cero, ya que la pregunta pide explícitamente los cubos enteros al final del tercer minuto, y el enunciado indica que hay cero en ese momento. Sin embargo, este problema está diseñado para confundir a los modelos que sobreanalizan o se enredan con la narrativa del derretimiento. Algunos modelos pueden razonar que los cubos se derriten con el tiempo e intentar calcular tasas de derretimiento, apartándose así de la respuesta directa. Cuando se probó a EXAONE Deep con este problema, generó aproximadamente 5.000 tokens de razonamiento sin llegar a una conclusión coherente. El proceso de pensamiento del modelo pareció desviarse, con el texto generado volviéndose cada vez más incoherente y sin demostrar una resolución lógica. Los tokens incluían fragmentos que no formaban ideas completas, y el modelo nunca articuló claramente una vía de razonamiento ni una respuesta final. Este desempeño contrasta fuertemente con la forma en que debería manejarse el problema: un modelo de razonamiento debería detectar la trampa, razonar con claridad y llegar eficientemente a la respuesta.

Cuando el mismo problema del cubo de hielo se probó en DeepSeek R1 y el modelo QwQ de Alibaba, ambos mostraron un rendimiento significativamente mejor. DeepSeek R1 generó un proceso de pensamiento claro, abordó el problema de forma metódica y llegó a la respuesta correcta de cero. El razonamiento fue transparente y lógico, mostrando cómo consideró el problema, detectó la trampa y se decantó por la respuesta adecuada. QwQ también mostró buen desempeño, aunque generó un proceso de pensamiento más extenso. Curiosamente, QwQ consideró inicialmente si los cubos tardaban en derretirse y si el problema era de física o matemáticas, pero finalmente llegó a la respuesta correcta. La diferencia clave fue que ambos modelos mantuvieron un razonamiento coherente durante todo el proceso, incluso explorando varios ángulos. Demostraron capacidad para reconocer cuándo tenían suficiente información y comprometerse con una respuesta final. EXAONE Deep, en cambio, nunca llegó a ese punto: siguió generando tokens sin propósito aparente, sin decidirse por una respuesta ni mostrar una progresión lógica. Esto sugiere problemas fundamentales en cómo el modelo maneja tareas de razonamiento, a pesar de las afirmaciones de los benchmarks.

Un aspecto técnico interesante del lanzamiento de EXAONE Deep es la inclusión de múltiples tamaños de modelo diseñados para trabajar juntos mediante decodificación especulativa. La versión de 2.400 millones de parámetros puede servir como modelo auxiliar que predice tokens que generará el modelo principal de 32.000 millones de parámetros. Cuando las predicciones del modelo auxiliar coinciden con la generación del principal, el sistema puede omitir el cálculo principal y usar la predicción auxiliar, acelerando la inferencia. Esta es una técnica de optimización sofisticada que puede reducir significativamente la latencia y los requisitos computacionales. En las pruebas, la implementación de decodificación especulativa mostró tokens verdes que indican predicciones auxiliares exitosas, lo que sugiere que la técnica funcionaba como se esperaba. Sin embargo, esta optimización no resuelve el problema fundamental de la calidad del razonamiento del modelo principal. Una inferencia más rápida con razonamientos pobres sigue siendo un razonamiento pobre. La presencia de esta función de optimización también plantea dudas sobre si los resultados de los benchmarks de LG pudieron haberse logrado usando configuraciones o técnicas que no se traducen bien al uso real.

Para las organizaciones que enfrentan dificultades al evaluar y comparar múltiples modelos de IA, FlowHunt ofrece una plataforma integral de automatización que agiliza el proceso de prueba y benchmarking. En lugar de realizar pruebas manuales en diferentes modelos y comparar resultados, FlowHunt permite a los equipos configurar flujos de trabajo automatizados que evalúan sistemáticamente el rendimiento de los modelos en múltiples dimensiones. Esto es especialmente valioso al comparar modelos de razonamiento, donde el desempeño puede variar considerablemente según el tipo de problema, su complejidad y la formulación del prompt. Las capacidades de automatización de FlowHunt permiten probar modelos contra conjuntos de problemas estandarizados, hacer seguimiento de métricas de rendimiento a lo largo del tiempo y generar informes de comparación exhaustivos. La plataforma puede integrarse con múltiples proveedores de modelos y APIs, haciendo posible evaluar modelos de distintos proveedores en un solo flujo unificado. Para equipos que consideren desplegar modelos de razonamiento como EXAONE Deep, DeepSeek R1 o QwQ, FlowHunt proporciona la infraestructura para tomar decisiones basadas en datos reales en lugar de afirmaciones de los proveedores. La capacidad de automatizar tareas repetitivas de prueba también libera recursos de ingeniería para centrarse en la integración y optimización, en lugar de benchmarking manual.

La brecha entre el rendimiento declarado de EXAONE Deep y su comportamiento real en pruebas resalta una lección crítica para la adopción de IA: los benchmarks de los proveedores siempre deben verificarse mediante pruebas independientes. Los resultados pueden verse influenciados por muchos factores, incluyendo el conjunto de pruebas utilizado, la metodología de evaluación, la configuración de hardware y los parámetros de inferencia. Un modelo puede tener buen desempeño en un benchmark concreto pero tener dificultades con otros tipos de problemas o escenarios reales. Por eso organizaciones como Weights & Biases e investigadores independientes juegan un papel tan importante en el ecosistema de IA: ofrecen pruebas y análisis imparciales que ayudan a la comunidad a entender las capacidades reales de los modelos. Al evaluar modelos de razonamiento para despliegue en producción, las organizaciones deben realizar sus propias pruebas con conjuntos de problemas representativos del dominio específico. Un modelo que es excelente en razonamiento matemático podría fallar en deducción lógica o generación de código. El problema del cubo de hielo, aunque aparentemente simple, sirve como test diagnóstico útil porque revela si un modelo puede manejar preguntas trampa y evitar el sobreanálisis. Los modelos que fallan en tales problemas probablemente también tengan dificultades con tareas de razonamiento más complejas.

Los bucles extensos de pensamiento observados en las pruebas de EXAONE Deep pueden deberse a varios problemas potenciales. Una posibilidad es que el proceso de entrenamiento del modelo no le enseñó adecuadamente cuándo dejar de razonar y comprometerse con una respuesta. Los modelos de razonamiento requieren calibración minuciosa durante el entrenamiento para equilibrar los beneficios del razonamiento extenso con los riesgos de sobreanalizar y generar tokens improductivos. Si el entrenamiento no incluyó suficientes ejemplos de cuándo detenerse, el modelo podría tender a generar tokens hasta llegar a un límite máximo. Otra posibilidad es que el manejo de prompts del modelo tenga problemas, especialmente en cómo interpreta ciertos tipos de preguntas o instrucciones. Algunos modelos son sensibles a la formulación específica del prompt y pueden comportarse de forma diferente según cómo se plantee la pregunta. El hecho de que EXAONE Deep generara secuencias incoherentes de tokens sugiere que el modelo podría estar entrando en un estado donde genera tokens sin contenido semántico significativo, lo que podría indicar problemas en los mecanismos de atención o de predicción de tokens. Una tercera posibilidad es que la metodología de evaluación de benchmarks haya usado configuraciones o estrategias de prompting diferentes a las de las pruebas reales, generando una brecha significativa entre los resultados reportados y los reales.

Los problemas de rendimiento observados con EXAONE Deep tienen implicaciones más amplias para el mercado de modelos de razonamiento. A medida que más organizaciones lanzan modelos, el mercado corre el riesgo de saturarse con productos que exhiben grandes afirmaciones de benchmarks, pero un rendimiento real cuestionable. Esto crea un entorno desafiante para las organizaciones que intentan elegir modelos para uso en producción. La solución pasa por dar mayor peso a las pruebas independientes, metodologías de evaluación estandarizadas y transparencia sobre las limitaciones de los modelos. El espacio de modelos de razonamiento se beneficiaría de estándares sectoriales sobre cómo se evalúan y comparan estos modelos, de forma similar a cómo han evolucionado otros benchmarks de IA. Además, las organizaciones deben ser cautas con modelos que afirman superar ampliamente a competidores establecidos, especialmente cuando la diferencia no parece consistente con la arquitectura o el enfoque de entrenamiento. DeepSeek R1 y QwQ han demostrado rendimiento consistente en múltiples escenarios de prueba, lo que genera confianza en sus capacidades. El desempeño inconsistente de EXAONE Deep—grandes afirmaciones de benchmarks pero pobres resultados reales—sugiere problemas en el propio modelo o en cómo se realizaron los benchmarks.

Descubre cómo FlowHunt automatiza tus flujos de contenido y SEO con IA — desde la investigación y generación de contenido hasta la publicación y analítica — todo en un solo lugar.

Las organizaciones que consideren desplegar modelos de razonamiento deben seguir un proceso de evaluación estructurado. Primero, establezca un conjunto de pruebas representativo que incluya problemas de su dominio o caso de uso específico. Los benchmarks genéricos pueden no reflejar el rendimiento en sus problemas reales. Segundo, pruebe varios modelos en los mismos problemas para permitir la comparación directa. Esto requiere estandarizar el entorno de prueba, incluyendo hardware, parámetros de inferencia y formulación de prompts. Tercero, evalúe no solo la precisión, sino también métricas de eficiencia como latencia y generación de tokens. Un modelo que da respuestas correctas pero requiere 10.000 tokens de razonamiento puede no ser práctico si necesita respuestas en tiempo real. Cuarto, examine el proceso de razonamiento del modelo, no solo la respuesta final. Un modelo que llega a la respuesta correcta por caminos erróneos puede fallar en problemas similares con otros parámetros. Quinto, pruebe casos límite y preguntas trampa para entender cómo maneja el modelo esos escenarios. Finalmente, considere el coste total de propiedad, incluyendo no solo la licencia o costes de API, sino también los recursos computacionales requeridos para la inferencia y el esfuerzo de integración.

El tamaño de 32.000 millones de parámetros de EXAONE Deep es notablemente menor que el de algunos modelos de razonamiento competidores, lo que plantea dudas sobre si los problemas del modelo provienen de una capacidad insuficiente. Sin embargo, el tamaño por sí solo no determina la capacidad de razonamiento. QwQ, que opera en un rango de parámetros similar, muestra un rendimiento fuerte. Esto sugiere que los problemas de EXAONE Deep probablemente están más relacionados con la metodología de entrenamiento, el diseño de la arquitectura o la configuración de inferencia que con limitaciones fundamentales de tamaño. La inclusión de un modelo auxiliar de 2.400 millones de parámetros en el lanzamiento de EXAONE Deep muestra que LG está pensando en eficiencia, lo cual es positivo. Sin embargo, las mejoras de eficiencia solo tienen valor si el modelo subyacente produce resultados correctos. Una respuesta rápida incorrecta es peor que una respuesta lenta correcta en la mayoría de escenarios de producción. Es probable que el mercado de modelos de razonamiento siga dando importancia a la eficiencia a medida que las organizaciones busquen desplegarlos a escala, pero esta optimización no debe ir en detrimento de la calidad del razonamiento.

El espacio de modelos de razonamiento aún está en sus primeras etapas y podemos esperar una evolución significativa en los próximos meses y años. A medida que más organizaciones lancen modelos y se realicen más pruebas independientes, el mercado probablemente se consolidará en torno a modelos que demuestren rendimiento consistente y fiable. Organizaciones como DeepSeek y Alibaba han establecido credibilidad mediante rendimiento consistente, mientras que nuevos actores como LG deberán abordar los problemas observados en las pruebas para ganar aceptación. También podemos esperar innovación continua en cómo se entrenan y evalúan los modelos de razonamiento. El enfoque actual de generar muchos tokens de razonamiento es efectivo pero costoso computacionalmente. En el futuro, los modelos podrían desarrollar mecanismos de razonamiento más eficientes que logren precisión similar con menos tokens. Además, probablemente veremos una mayor especialización, con modelos optimizados para dominios específicos como matemáticas, generación de código o razonamiento lógico. La integración de modelos de razonamiento con otras técnicas de IA, como generación aumentada por recuperación o uso de herramientas, también ampliará sus capacidades y aplicaciones.

EXAONE Deep de LG representa una apuesta ambiciosa en el mercado de modelos de razonamiento, pero las pruebas reales revelan brechas significativas entre el rendimiento declarado y sus capacidades reales. Aunque los resultados de benchmarks del modelo sugieren rendimiento competitivo con DeepSeek R1 y QwQ de Alibaba, las pruebas prácticas en problemas estándar muestran que EXAONE Deep tiene dificultades con tareas básicas, generando tokens excesivos sin llegar a conclusiones coherentes. DeepSeek R1 y QwQ demostraron un rendimiento superior en los mismos problemas, llegando a respuestas correctas mediante procesos de razonamiento claros y lógicos. Para las organizaciones que evalúan modelos de razonamiento para producción, este análisis subraya la importancia crítica de la prueba y verificación independiente. Los benchmarks de los proveedores deben tratarse como punto de partida para la evaluación, no como medida definitiva de capacidad del modelo. El mercado se beneficiará de una mayor transparencia, metodologías de evaluación estandarizadas y pruebas independientes continuas por parte de la comunidad investigadora. A medida que madura esta tecnología, las organizaciones que inviertan en procesos rigurosos de evaluación y comparación de modelos estarán mejor posicionadas para seleccionar y desplegar modelos que aporten valor real a sus casos de uso específicos.

EXAONE Deep es un modelo de razonamiento de 32.000 millones de parámetros desarrollado por LG que utiliza decodificación en tiempo de prueba para resolver problemas complejos. A diferencia de los modelos de lenguaje estándar, asigna recursos computacionales durante la inferencia para razonar paso a paso, de forma similar a los modelos DeepSeek R1 y QwQ de Alibaba.

En pruebas prácticas con tareas de razonamiento como el problema del cubo de hielo, EXAONE Deep mostró problemas significativos de sobrepensar y generar demasiados tokens sin llegar a conclusiones lógicas. DeepSeek R1 y QwQ tuvieron mejor desempeño, llegando a la respuesta correcta de forma más eficiente.

La decodificación en tiempo de prueba es una técnica donde los modelos de IA asignan más recursos computacionales durante la inferencia para razonar sobre problemas complejos. Esto permite que los modelos muestren su proceso de pensamiento y lleguen a respuestas más precisas, aunque requiere una calibración cuidadosa para evitar el sobreanálisis.

FlowHunt automatiza el flujo de trabajo de prueba, comparación y evaluación de múltiples modelos de IA, permitiendo a los equipos comparar sistemáticamente el rendimiento, rastrear métricas y tomar decisiones basadas en datos sobre qué modelos desplegar para casos de uso específicos.

Arshia es ingeniera de flujos de trabajo de IA en FlowHunt. Con formación en ciencias de la computación y una pasión por la IA, se especializa en crear flujos de trabajo eficientes que integran herramientas de IA en las tareas cotidianas, mejorando la productividad y la creatividad.

Utiliza FlowHunt para optimizar tus flujos de prueba, comparación y seguimiento de rendimiento de modelos de IA con automatización inteligente.

Descubre cómo un pequeño modelo de 7 millones de parámetros supera a Gemini, DeepSeek y Claude usando razonamiento recursivo y supervisión profunda. Conoce el e...

Explora el mundo de los modelos de agentes de IA con un análisis completo de 20 sistemas de vanguardia. Descubre cómo piensan, razonan y se desempeñan en divers...

La evaluación comparativa de modelos de IA es la evaluación y comparación sistemática de modelos de inteligencia artificial utilizando conjuntos de datos, tarea...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.