Introducción

El camino desde construir un prototipo funcional de IA hasta desplegar un sistema listo para producción ha sido durante mucho tiempo uno de los retos más complejos del desarrollo de inteligencia artificial. Lo que a menudo parece un proceso sencillo en las demos—recuperar información relevante, aumentar los prompts y generar respuestas—se vuelve exponencialmente más complejo al escalar a entornos de producción. Esta complejidad ha llevado a que muchos en la industria lo describan como “alquimia” en vez de ingeniería: un proceso misterioso en el que los desarrolladores ajustan configuraciones, modifican parámetros y esperan que sus sistemas sigan funcionando de forma fiable. La aparición de la ingeniería de contexto como disciplina representa un cambio fundamental en la forma en que abordamos la construcción de sistemas de IA, alejándonos de esta metodología de prueba y error para adoptar un enfoque más sistemático e ingenieril. En esta exploración integral, analizaremos cómo las bases de datos vectoriales modernas y los principios de ingeniería de contexto están transformando el panorama del desarrollo de aplicaciones de IA, permitiendo a los equipos construir sistemas no solo funcionales, sino realmente fiables y mantenibles a escala.

Qué es la Ingeniería de Contexto y Por Qué Importa

La ingeniería de contexto ha surgido como una de las disciplinas más críticas en el desarrollo moderno de IA, aunque sigue siendo poco entendida por muchos desarrolladores que ingresan al sector. En esencia, la ingeniería de contexto es la práctica de gestionar, organizar y optimizar de manera sistemática la información contextual que los sistemas de IA utilizan para tomar decisiones y generar resultados. A diferencia de la tradicional Generación Aumentada por Recuperación (RAG), que se centra de forma estrecha en recuperar documentos relevantes para enriquecer un prompt antes de enviarlo a un modelo de lenguaje, la ingeniería de contexto adopta una visión mucho más amplia de todo el pipeline. Engloba cómo fluye la información por el sistema, cómo se almacena e indexa, cómo se realiza la recuperación, cómo se ordenan y filtran los resultados y, en última instancia, cómo se presenta ese contexto al modelo. Esta perspectiva holística reconoce que la calidad de la salida de un sistema de IA está fundamentalmente limitada por la calidad y relevancia del contexto que recibe. Cuando el contexto se gestiona mal—cuando se recupera información irrelevante, cuando se pierden detalles importantes, cuando la misma información se procesa varias veces—todo el sistema se degrada. La ingeniería de contexto aborda estos retos tratando la gestión contextual como una preocupación de ingeniería de primer nivel, digna del mismo rigor y atención que aplicamos a otros componentes críticos de la infraestructura.

La importancia de la ingeniería de contexto se hace evidente en cuanto se considera la escala a la que operan los sistemas modernos de IA. Un modelo de lenguaje puede ser requerido para procesar cientos de miles de documentos, sintetizar información de múltiples fuentes y generar respuestas coherentes a partir de esa síntesis. Sin una correcta ingeniería de contexto, este proceso se vuelve caótico. Documentos irrelevantes saturan la ventana de contexto, se pierde información importante en el ruido y el rendimiento del modelo se degrada. Además, a medida que los sistemas de IA se vuelven más sofisticados y se despliegan en aplicaciones críticas—desde atención al cliente hasta diagnóstico médico o análisis financiero—las consecuencias de una mala ingeniería de contexto aumentan dramáticamente. Un sistema que ocasionalmente devuelve información irrelevante puede ser aceptable para fines de entretenimiento, pero resulta inaceptable cuando toma decisiones que afectan la vida o el sustento de las personas. La ingeniería de contexto garantiza que la información que fluye por el sistema no solo sea abundante, sino realmente relevante, bien organizada y optimizada para la tarea específica.

¿Listo para hacer crecer tu negocio?

Comienza tu prueba gratuita hoy y ve resultados en días.

La Evolución del Demo a la Producción: El Problema de la Alquimia

Uno de los retos más persistentes en el desarrollo de IA ha sido lo que los veteranos del sector llaman la “brecha del demo a la producción”. Construir un prototipo funcional que demuestre las capacidades de IA es relativamente sencillo. Un desarrollador puede ensamblar rápidamente un modelo de lenguaje, conectarlo a un sistema simple de recuperación y crear algo que funciona de forma impresionante en un entorno controlado. Sin embargo, en el momento en que ese sistema debe manejar datos del mundo real a escala, mantener la fiabilidad en el tiempo y adaptarse a requisitos cambiantes, todo se vuelve mucho más difícil. Esta brecha se ha salvado históricamente a través de lo que solo puede describirse como alquimia: una combinación misteriosa de ajustes de configuración, modificaciones de parámetros y prueba-error empírica que de alguna manera da lugar a un sistema funcional. El problema de este enfoque es que no es reproducible, ni escalable ni mantenible. Cuando algo falla en producción, a menudo no está claro por qué, y solucionarlo requiere repetir el mismo proceso misterioso.

La raíz de este problema de alquimia radica en que la mayoría de la infraestructura de IA no fue diseñada pensando en sistemas de producción. Las primeras bases de datos vectoriales y sistemas de recuperación se construyeron principalmente para demostrar la viabilidad de la búsqueda semántica y la recuperación basada en embeddings. Funcionaban bien en entornos controlados con pequeños conjuntos de datos y patrones de consulta predecibles. Pero al escalar estos sistemas para gestionar millones de documentos, miles de usuarios concurrentes y patrones de consulta imprevisibles, suelen colapsar. La consistencia de datos se convierte en un problema. El rendimiento de las consultas se degrada. El sistema se vuelve difícil de depurar y monitorizar. Los desarrolladores se encuentran gestionando un artefacto complejo y frágil que funciona a base de suerte e intervención constante, en vez de verdaderamente estar “ingenierizando” un sistema. Aquí es donde entran la ingeniería de contexto moderna y la infraestructura diseñada específicamente para ello. Al tratar el paso de demo a producción como un reto legítimo de ingeniería, y al construir sistemas pensados para cargas de trabajo en producción, podemos transformar esa alquimia misteriosa en verdadera práctica ingenieril.

Entendiendo la Infraestructura de Búsqueda Moderna para IA

La infraestructura de búsqueda tradicional, la que impulsa Google y otros motores, fue diseñada con suposiciones específicas sobre cómo se usaría la búsqueda. Estos sistemas estaban hechos para gestionar consultas basadas en palabras clave de usuarios humanos, quienes revisan los resultados y deciden a qué enlaces acceder. La infraestructura fue optimizada para este caso: coincidencia rápida de palabras clave, algoritmos de ranking diseñados para juicios de relevancia humana y presentación de resultados en forma de “diez enlaces azules” que los humanos pueden escanear y evaluar. Sin embargo, los sistemas de IA tienen requerimientos totalmente distintos. Cuando un modelo de lenguaje consume resultados de búsqueda, no mira diez enlaces—puede procesar órdenes de magnitud más información. El modelo no necesita resultados formateados para consumo humano; necesita datos estructurados sobre los que pueda razonar. Las consultas no son basadas en palabras clave; son semánticas, basadas en embeddings y similitud vectorial. Estas diferencias fundamentales hacen que la infraestructura de búsqueda tradicional no sirva para aplicaciones de IA.

La infraestructura de búsqueda moderna para IA afronta estas diferencias de varias formas clave. Primero, las herramientas y tecnologías empleadas son distintas. En lugar de índices de palabras clave y algoritmos de ranking optimizados para humanos, los sistemas modernos usan embeddings vectoriales y medidas de similitud semántica. En vez de depender de palabras clave explícitas, comprenden el significado y la intención detrás de las consultas. Segundo, los patrones de carga de trabajo son diferentes. Los sistemas de búsqueda tradicionales gestionan consultas relativamente simples que devuelven pocos resultados. Los sistemas de IA a menudo necesitan recuperar grandes volúmenes de documentos y procesarlos de forma sofisticada. Tercero, los desarrolladores que utilizan estos sistemas tienen necesidades diferentes. Los desarrolladores de IA requieren sistemas fáciles de integrar en sus aplicaciones, con buena experiencia de usuario y que no requieran gran experiencia en infraestructura de búsqueda para ser efectivos. Por último, y quizás lo más importante, los consumidores de los resultados de búsqueda han cambiado. En la búsqueda tradicional, los humanos hacen el trabajo final—decidiendo qué resultados son relevantes, abriendo nuevas pestañas, sintetizando información. En los sistemas de IA, el modelo de lenguaje hace ese trabajo y puede manejar mucha más información que los humanos. Este cambio fundamental en la forma en que se consumen los resultados de búsqueda lo cambia todo en cuanto al diseño de la infraestructura.

Únete a nuestro boletín

Obtén los últimos consejos, tendencias y ofertas gratis.

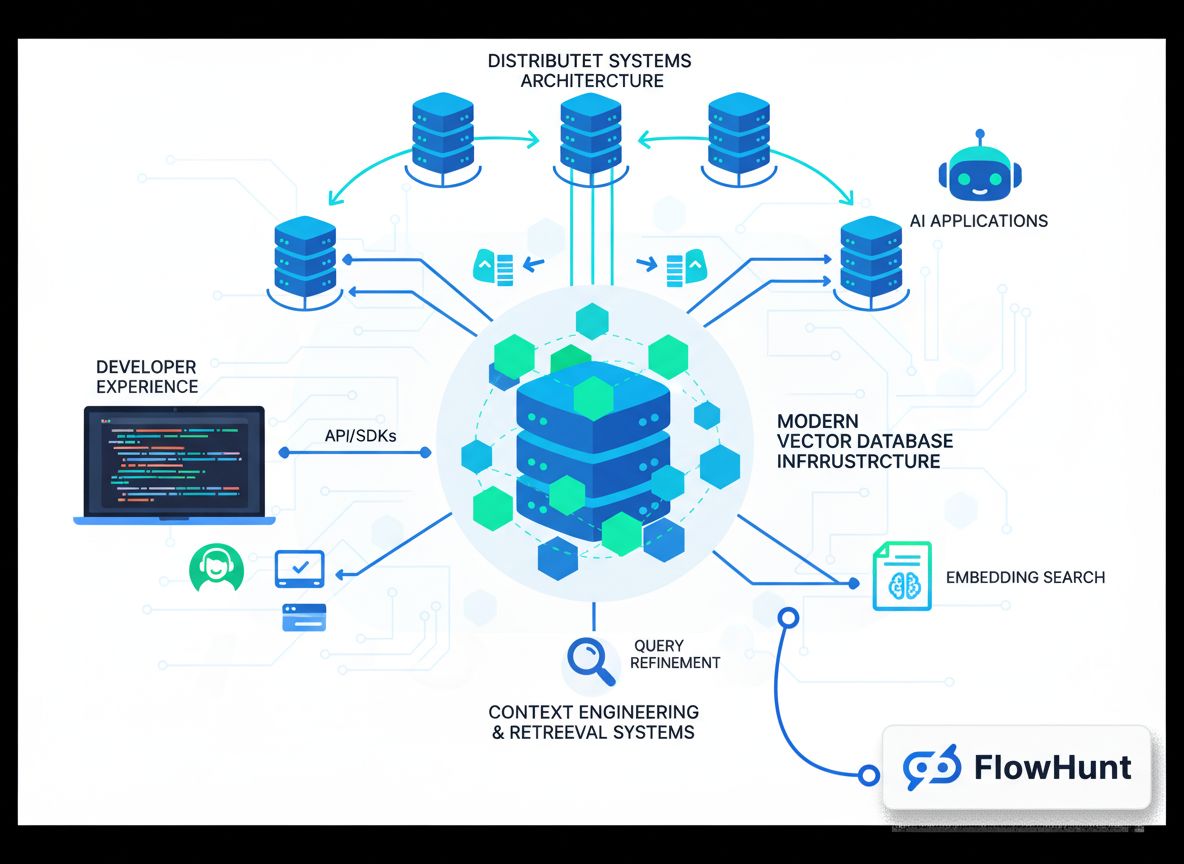

FlowHunt y el Futuro de la Automatización de Flujos de IA

A medida que las organizaciones reconocen la importancia de la ingeniería de contexto y la infraestructura de búsqueda moderna, el reto se convierte en cómo integrar estas capacidades en sus flujos y procesos de desarrollo existentes. Aquí es donde plataformas como FlowHunt entran en juego, proporcionando un entorno unificado para construir, probar y desplegar aplicaciones de IA que dependen de sofisticados sistemas de gestión y recuperación de contexto. FlowHunt entiende que la ingeniería de contexto no se trata solo de tener la base de datos adecuada—se trata de contar con las herramientas y flujos adecuados para gestionar el contexto a lo largo de todo el ciclo de vida del desarrollo de IA. Desde la ingesta e indexación inicial de datos, pasando por la recuperación y el ranking, hasta la inferencia final del modelo y la generación del resultado, cada paso del pipeline debe ser cuidadosamente orquestado y monitorizado. FlowHunt ofrece capacidades de automatización que hacen esta orquestación fluida, permitiendo a los desarrolladores centrarse en crear grandes aplicaciones de IA en vez de pelear con los detalles de la infraestructura.

El enfoque de la plataforma hacia la automatización de la ingeniería de contexto es especialmente valioso para equipos que construyen múltiples aplicaciones de IA o que deben gestionar pipelines complejos de recuperación en varias etapas. En vez de crear infraestructura personalizada para cada aplicación, los equipos pueden aprovechar los componentes y flujos preconstruidos de FlowHunt para acelerar el desarrollo. La plataforma se encarga del trabajo tedioso de ingesta de datos, generación de embeddings, gestión de índices y orquestación de la recuperación, liberando a los desarrolladores para centrarse en los aspectos únicos de sus aplicaciones. Además, FlowHunt proporciona visibilidad y monitorización, facilitando entender cómo fluye el contexto por el sistema, identificar cuellos de botella y optimizar el rendimiento. Esta combinación de automatización y visibilidad transforma la ingeniería de contexto de un proceso misterioso y de prueba-error en una disciplina sistemática y medible.

La Arquitectura de las Bases de Datos Vectoriales Listas para Producción

Construir una base de datos vectorial que funcione en un demo es una cosa; construir una que sirva de forma fiable cargas de trabajo en producción es otra muy distinta. Las bases de datos vectoriales listas para producción deben manejar múltiples usuarios concurrentes, mantener la consistencia de datos, ofrecer persistencia fiable y escalar de forma fluida a medida que crecen los volúmenes de información. Deben ser depurables cuando algo falla, monitorizables para entender su comportamiento y mantenibles para que los equipos puedan evolucionar el sistema con el tiempo. Estas necesidades han llevado al desarrollo de arquitecturas modernas de bases de datos vectoriales que incorporan principios de sistemas distribuidos probados durante décadas de uso en el mundo real.

Uno de los principios arquitectónicos más importantes en las bases de datos vectoriales modernas es la separación de almacenamiento y cómputo. En las bases de datos monolíticas tradicionales, almacenamiento y cómputo están fuertemente acoplados: el mismo servidor que almacena los datos procesa las consultas. Este acoplamiento genera problemas al escalar. Si se necesita más potencia de procesamiento de consultas, hay que añadir más almacenamiento. Si hace falta más capacidad de almacenamiento, hay que añadir más cómputo. Esta ineficiencia lleva al desperdicio de recursos y mayores costes. Al separar almacenamiento y cómputo, las bases de datos vectoriales modernas permiten que cada uno escale de forma independiente. El almacenamiento puede gestionarse mediante soluciones de objetos rentables como Amazon S3, mientras que los recursos de cómputo pueden escalarse según la demanda de consultas. Esta arquitectura ofrece enorme flexibilidad y eficiencia de costes. Otro principio crítico es la multi-tenencia, que permite que una sola instancia de base de datos sirva de forma segura a múltiples aplicaciones o equipos independientes. La multi-tenencia requiere un aislamiento riguroso para garantizar que los datos y consultas de un usuario no interfieran con los de otro, pero cuando se implementa correctamente mejora mucho la utilización de recursos y reduce la complejidad operativa.

Las bases de datos vectoriales modernas también incorporan principios de sistemas distribuidos que se han convertido en estándar en la última década. Estos incluyen la separación de lectura y escritura, donde las operaciones de lectura y escritura son manejadas por componentes optimizados para sus cargas de trabajo específicas; la replicación asíncrona, que asegura la durabilidad de los datos sin sacrificar el rendimiento de escritura; y mecanismos de consenso distribuidos que mantienen la consistencia entre varios nodos. Estos principios, combinados con lenguajes de programación modernos como Rust que ofrecen tanto rendimiento como seguridad, permiten que las bases de datos vectoriales alcancen los niveles de fiabilidad y rendimiento que requieren los sistemas en producción. El resultado es una infraestructura que no se siente como alquimia—se siente como ingeniería.

El Enfoque de Chroma en la Experiencia del Desarrollador

Cuando se fundó Chroma, el equipo tenía una tesis clara: la brecha entre construir un demo de IA funcional y desplegar un sistema en producción se sentía más como alquimia que como ingeniería, y había que salvar esa brecha. El enfoque del equipo fue comenzar con una obsesión por la experiencia del desarrollador. En vez de intentar crear el sistema más rico en funciones o más escalable posible, se centraron en facilitar al máximo que los desarrolladores comenzaran a usar bases de datos vectoriales y búsqueda semántica. Esto llevó a una de las características más distintivas de Chroma: la posibilidad de instalarlo con un solo comando pip y empezar a usarlo inmediatamente, sin configuraciones ni infraestructura complejas. Esta simplicidad supuso una revolución en el sector de las bases de datos vectoriales. La mayoría de las bases de datos requieren una configuración significativa incluso para ejecutar una consulta básica. Chroma eliminó esa fricción, permitiendo a los desarrolladores experimentar en minutos, no en horas o días.

El compromiso con la experiencia del desarrollador fue más allá del arranque inicial. El equipo de Chroma invirtió mucho en asegurar que el sistema funcionara de forma fiable en diferentes arquitecturas y entornos de despliegue. En los primeros tiempos, los usuarios reportaban ejecutar Chroma en todo, desde servidores Linux estándar hasta Arduinos y arquitecturas Power PC. En vez de descartar estos casos como marginales, el equipo de Chroma hizo el esfuerzo adicional para asegurar que el sistema funcionara bien en todos ellos. Este compromiso con la compatibilidad y fiabilidad universales generó confianza en la comunidad de desarrolladores y contribuyó a la rápida adopción de Chroma. El equipo comprendió que la experiencia del desarrollador no es solo facilidad de uso—es fiabilidad, consistencia y la seguridad de que el sistema funcionará como se espera en cualquier entorno y caso de uso.

A medida que Chroma evolucionó y el equipo comenzó a construir Chroma Cloud, se enfrentaron a una decisión crítica. Podrían haber lanzado rápidamente una versión alojada del producto mononodo, sacando algo al mercado rápidamente y capitalizando la demanda de servicios gestionados de bases de datos vectoriales. Muchas empresas del sector tomaron esta decisión, lo que les permitió captar grandes rondas de capital y hacer mucho ruido en el mercado. Sin embargo, el equipo de Chroma eligió otro camino. Reconocieron que simplemente alojar el producto mononodo como servicio no cumpliría sus estándares de experiencia del desarrollador. Un producto cloud realmente excelente debía diseñarse desde cero con principios cloud-native en mente. Debía ofrecer la misma facilidad de uso y fiabilidad que el producto mononodo, pero con la escalabilidad y fiabilidad que requieren los sistemas en producción. Esta decisión supuso dedicar más tiempo a construir Chroma Cloud, pero resultó en un producto que realmente cumple la promesa de hacer que la ingeniería de contexto se sienta como ingeniería y no como alquimia.

Las Cuatro Dimensiones de la “IA” en la Infraestructura de Búsqueda Moderna

Al hablar de infraestructura de búsqueda moderna para IA, es importante reconocer que “IA” significa cosas diferentes en distintos contextos. De hecho, hay cuatro dimensiones clave en las que la infraestructura de búsqueda moderna difiere de los sistemas tradicionales, y entenderlas es crucial para construir aplicaciones de IA efectivas. La primera dimensión es tecnológica. Las herramientas y tecnologías empleadas en la infraestructura moderna difieren radicalmente de las tradicionales. En vez de índices invertidos y coincidencia de palabras clave, los sistemas modernos usan embeddings vectoriales y similitud semántica. En vez de algoritmos de ranking TF-IDF, utilizan redes neuronales y funciones de ranking aprendidas. Estas diferencias tecnológicas reflejan la distinta naturaleza de los problemas a resolver y las capacidades de los sistemas modernos de IA.

La segunda dimensión son los patrones de carga de trabajo. Los sistemas de búsqueda tradicionales fueron diseñados para manejar consultas sencillas y sin estado que devuelven pocos resultados. Los sistemas modernos de IA suelen gestionar pipelines complejos de recuperación en varias etapas, que implican múltiples rondas de ranking, filtrado y re-ranking. Pueden requerir recuperar miles de documentos y procesarlos de forma sofisticada. Los patrones de carga de trabajo son fundamentalmente distintos, por lo que la infraestructura debe diseñarse de otra manera para gestionarlos eficientemente. La tercera dimensión son los desarrolladores. Los sistemas tradicionales eran desarrollados y mantenidos por ingenieros de búsqueda especializados, con gran experiencia en recuperación de información e infraestructura de búsqueda. Los desarrolladores de IA modernos, en cambio, suelen ser generalistas que quizá no tengan ese conocimiento profundo pero necesitan construir aplicaciones que dependan de capacidades de recuperación sofisticadas. Esto significa que la infraestructura de búsqueda moderna debe priorizar la facilidad de uso y accesibilidad, no solo la potencia y flexibilidad.

La cuarta, y probablemente más importante, dimensión es el consumidor de los resultados de búsqueda. En los sistemas tradicionales, los humanos consumen los resultados. Los humanos solo pueden digerir un número limitado—normalmente unos diez enlaces—y hacen el trabajo final de decidir relevancia y sintetizar información. En los sistemas modernos de IA, los consumidores son modelos de lenguaje, capaces de procesar órdenes de magnitud más información que un humano. Un modelo de lenguaje puede digerir fácilmente cientos o miles de documentos y sintetizar información de todos ellos. Esta diferencia fundamental en el consumidor de resultados lo cambia todo en el diseño de la infraestructura. Permite que los algoritmos de ranking se optimicen para consumo de máquina y no humano. Permite que la presentación de resultados se optimice para procesamiento automático y no para legibilidad humana. Permite que todo el pipeline se diseñe asumiendo que un sistema de IA sofisticado hará el trabajo final.

Construyendo y Manteniendo Visión en un Mercado Ruidoso

El mercado de bases de datos vectoriales en 2023 fue una de las categorías más calientes en la infraestructura de IA. Las empresas levantaban enormes rondas de capital, hacían grandes anuncios y competían por crear los sistemas más ricos en funcionalidades. En este entorno, habría sido fácil para Chroma perder el foco, perseguir todas las modas e intentar ser todo para todos. En su lugar, el equipo tomó la decisión deliberada de centrarse en su visión principal: construir un motor de recuperación para aplicaciones de IA que ofreciera una experiencia de desarrollador excepcional y realmente bridara la brecha entre demo y producción. Este enfoque requirió disciplina y convicción, especialmente cuando otras empresas levantaban más fondos y hacían anuncios más grandes.

La clave para mantener este enfoque fue tener una tesis clara y contraria sobre lo que realmente importa. El equipo de Chroma creía que lo importante no era el número de funcionalidades o la cantidad de capital captado, sino la calidad de la experiencia del desarrollador y la fiabilidad del sistema. Apostaron a que haciendo una cosa—construir un gran motor de recuperación—a nivel mundial, se ganarían el derecho de hacer más cosas después. Esta filosofía de enfoque maníaco en una sola competencia clave no es exclusiva de Chroma, pero es cada vez más rara en el mundo startup respaldado por capital riesgo, donde la presión por crecer rápido y captar grandes rondas suele llevar a las empresas a dispersarse demasiado. El compromiso del equipo con esta filosofía, incluso si eso significaba tardar más en lanzar Chroma Cloud y perder oportunidades de mercado a corto plazo, demostró ser la decisión correcta.

Mantener la visión también requiere mucho cuidado en la contratación y construcción de equipo. Las personas que contratas dan forma a la cultura de tu organización, y la cultura determina qué y cómo construyes. El equipo de Chroma lo reconoció y optó por contratar despacio y ser muy selectivos. En vez de crecer lo más rápido posible, se centraron en incorporar personas alineadas con la visión, que valoraran profundamente el trabajo bien hecho y fueran capaces de ejecutar de forma independiente al más alto nivel. Este enfoque hizo que el equipo creciera más lento de lo que podría haberlo hecho, pero garantizó que todos estuvieran realmente comprometidos con la misión y pudieran contribuir de forma significativa. Este tipo de alineación cultural es difícil de lograr en startups de rápido crecimiento, pero es esencial para mantener el enfoque y la visión a largo plazo.

La Importancia del Oficio y la Calidad en la Infraestructura

Uno de los aspectos más destacados del enfoque de Chroma es su énfasis en el oficio y la calidad. En el ámbito de la infraestructura, es fácil caer en la trampa de pensar que más funcionalidades, más rendimiento o más escala es siempre mejor. Pero el equipo de Chroma entendió que lo realmente importante es construir sistemas que funcionen de forma fiable, que sean fáciles de usar y que realmente resuelvan los problemas a los que se enfrentan los desarrolladores. Este énfasis en el oficio y la calidad se manifiesta de muchas maneras. Se ve en la decisión de escribir Chroma en Rust, un lenguaje que ofrece rendimiento y seguridad, en vez de otro más conveniente pero menos fiable. Se ve en el compromiso de hacer que el sistema funcione en diferentes arquitecturas y entornos, incluso los más inusuales o esotéricos. Se ve en la decisión de dedicar más tiempo a construir Chroma Cloud correctamente en vez de lanzar un producto mediocre apresuradamente.

Este énfasis también se extiende a cómo el equipo piensa el problema. En vez de ver la ingeniería de contexto como un problema técnico estrecho a resolver con algoritmos inteligentes, el equipo lo ve como un reto más amplio que abarca experiencia de desarrollador, fiabilidad, escalabilidad y mantenibilidad. Esta perspectiva holística lleva a mejores soluciones porque reconoce que un sistema solo es tan bueno como su eslabón más débil. Un sistema puede tener los algoritmos de recuperación más sofisticados del mundo, pero si es difícil de usar o poco fiable en producción, no resuelve realmente el problema. Al centrarse en el oficio y la calidad en todas las dimensiones, Chroma ha construido algo que realmente funciona para los desarrolladores y realmente cierra la brecha entre demo y producción.

Implicaciones Prácticas para Equipos de Desarrollo de IA

Para los equipos que construyen aplicaciones de IA, los aprendizajes del enfoque de Chroma tienen varias implicaciones prácticas. Primero, es importante reconocer que la ingeniería de contexto no es una misión secundaria en el desarrollo de IA—es parte de la misión principal. La calidad de tu sistema de IA está limitada por la calidad del contexto que recibe, así que invertir en infraestructura adecuada de ingeniería de contexto no es opcional. Es esencial. Segundo, conviene ser escéptico ante los sistemas que prometen hacerlo todo. Los sistemas más fiables y efectivos suelen ser los que hacen una sola cosa muy bien y luego construyen a partir de ahí. Si evalúas bases de datos vectoriales o sistemas de recuperación, busca aquellos con un enfoque claro y un compromiso con la excelencia en esa área. Tercero, la experiencia del desarrollador importa. Un sistema teóricamente más potente pero difícil de usar será menos valioso que uno ligeramente menos potente pero fácil de usar. Esto es porque los desarrolladores realmente usarán el sistema fácil y construirán cosas increíbles con él, mientras que con el difícil lucharán y pueden rendirse.

Cuarto, la fiabilidad y la consistencia importan más de lo que crees. En las primeras etapas del desarrollo de IA, es tentador priorizar funcionalidades y rendimiento por encima de la fiabilidad. Pero cuando tus sistemas pasan a producción y gestionan cargas reales, la fiabilidad es primordial. Un sistema con 95% de fiabilidad puede parecer aceptable, pero si ejecutas millones de consultas al día, ese 5% de fallos se traduce en cientos de miles de consultas fallidas. Invertir en fiabilidad desde el principio es mucho más barato que intentar adaptarla más tarde. Por último, es importante pensar en la trayectoria a largo plazo de tus sistemas. La infraestructura que elijas hoy determinará lo que podrás construir mañana. Escoge infraestructura diseñada para producción desde el inicio, que escale bien y que ofrezca buena visibilidad y monitorización; esto dará frutos a medida que crezcan y evolucionen tus sistemas.

{{ cta-dark-panel

heading=“Impulsa Tu Flujo de Trabajo con FlowHunt”

description=“Descubre cómo FlowHunt automatiza tus flujos de contenido y SEO con IA: desde la investigación y generación de contenido hasta la publicación y analítica, todo en un solo lugar.”

ctaPrimaryText=“Solicita una Demo”

ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo"

ctaSecondaryText=“Pruébalo Gratis”

ctaSecondaryURL=“https://app.flowhunt.io/sign-in"

gradientStartColor="#123456”

gradientEndColor="#654321”

gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217”

}}

El Papel del Open Source en la Construcción de Confianza y Comunidad

Una de las decisiones más importantes que tomó el equipo de Chroma fue abrir el código fuente del producto principal. Esta decisión tuvo varias implicaciones clave. Primero, generó confianza en la comunidad de desarrolladores. Cuando los desarrolladores pueden ver el código, entender cómo funciona el sistema y contribuir con mejoras, es mucho más probable que confíen en él y lo adopten. El open source también crea un círculo virtuoso donde las contribuciones de la comunidad mejoran el producto, lo que atrae más usuarios y, a su vez, genera más contribuciones. Segundo, abrir el producto generó una comunidad fuerte en torno a Chroma. Los desarrolladores que lo usan se implican en su éxito y tienen mayor tendencia a contribuir, dar feedback y recomendar el producto a otros. Esta comunidad se convierte en un activo valioso difícil de replicar por la competencia.

Tercero, el open source ofrece una vía natural de monetización a través de servicios alojados. Al abrir el producto principal, Chroma creó una situación en la que los desarrolladores pueden usarlo gratis si lo alojan por su cuenta, pero muchos preferirán una versión gestionada que se encargue de la operación, el escalado y el mantenimiento. Este es el modelo que representa Chroma Cloud. Al proporcionar una experiencia alojada superior manteniendo el core open source, Chroma puede servir tanto a la comunidad auto-gestionada como al mercado de servicios gestionados. Este enfoque ha demostrado ser más sostenible y más alineado con las preferencias de los desarrolladores que intentar mantener el producto cerrado y propietario.

Midiendo el Éxito: Las Métricas que Importan

Al evaluar el éxito de proyectos de infraestructura como Chroma, es importante centrarse en métricas que realmente reflejan el valor entregado. Chroma ha logrado cifras impresionantes bajo cualquier estándar: más de 21.000 estrellas en GitHub, más de 5 millones de descargas mensuales y más de 60-70 millones de descargas históricas. Estas cifras reflejan la amplia adopción del proyecto entre la comunidad de desarrolladores. Pero más allá de estos números, lo que realmente importa es si el proyecto resuelve los problemas de los desarrolladores. ¿Facilita construir aplicaciones de IA? ¿Reduce el tiempo y esfuerzo necesarios para pasar del demo a la producción? ¿Permite a los desarrolladores crear sistemas más fiables? La respuesta parece ser sí, según el feedback de la comunidad y la rápida adopción del proyecto.

Otra métrica importante es la calidad de la comunidad y la naturaleza de las contribuciones. Chroma ha atraído contribuciones de desarrolladores de toda la industria, incluyendo integraciones con frameworks populares como LangChain y Llama Index. Esta adopción amplia e integración con otras herramientas del ecosistema es señal de que Chroma resuelve problemas reales y aporta valor genuino. El hecho de que Chroma se haya convertido en la opción por defecto para funcionalidad de base de datos vectorial en muchos frameworks de IA populares es un testimonio de la calidad del producto y de la fortaleza de su comunidad. Estas métricas cualitativas—adopción por la comunidad, integración con otras herramientas y feedback positivo de los usuarios—suelen ser más significativas que los simples números de descargas.

El Futuro de la Ingeniería de Contexto y la Infraestructura de IA

A medida que los sistemas de IA se vuelvan más sofisticados y se desplieguen más ampliamente, la importancia de la ingeniería de contexto solo aumentará. Los sistemas que se están construyendo hoy son solo el principio. En el futuro, probablemente veremos enfoques aún más avanzados para la gestión del contexto, incluyendo sistemas que ajusten el contexto de forma dinámica según la tarea, que aprendan de feedback para mejorar la calidad de la recuperación y que gestionen múltiples modalidades de datos (texto, imágenes, audio, vídeo) de manera fluida. La infraestructura para soportar estos sistemas avanzados deberá ser todavía más sofisticada que la actual, pero los principios seguirán siendo los mismos: enfocarse en la experiencia del desarrollador, comprometerse con la fiabilidad y la calidad y mantener una visión clara sobre los problemas a resolver.

El papel de plataformas como FlowHunt también será cada vez más relevante. A medida que la ingeniería de contexto se convierte en algo central en el desarrollo de IA, los equipos necesitarán herramientas que faciliten la construcción, prueba y despliegue de pipelines sofisticados de gestión de contexto. El enfoque de FlowHunt, que ofrece automatización y visibilidad a lo largo de todo el ciclo de vida de desarrollo de IA, lo posiciona bien para cubrir esta necesidad. Al abstraer la complejidad de la infraestructura de ingeniería de contexto y proporcionar herramientas de alto nivel para construir aplicaciones de IA, plataformas como FlowHunt permiten a los desarrolladores centrarse en crear grandes aplicaciones en vez de pelear con detalles de infraestructura.

Conclusión

La ingeniería de contexto representa un cambio fundamental en la manera de construir sistemas de IA, pasando de un enfoque de prueba-error y alquimia a una disciplina sistemática y de ingeniería. Las bases de datos vectoriales modernas como Chroma, construidas sobre principios de separación de almacenamiento y cómputo, multi-tenencia y arquitectura de sistemas distribuidos, son la base de este cambio. Al combinar estas mejoras de infraestructura con un compromiso con la experiencia del desarrollador, la fiabilidad y el oficio, los equipos pueden crear sistemas de IA que realmente funcionan en producción y escalan de forma fiable a medida que crecen los requisitos. Los aprendizajes del enfoque de Chroma—mantener el foco en la visión central, contratar por alineación cultural, priorizar la calidad sobre las funcionalidades y construir comunidad a través del open source—ofrecen una hoja de ruta tanto para otros proyectos de infraestructura como para equipos que construyen aplicaciones de IA. A medida que el campo de la IA evoluciona y madura, la importancia de acertar en la ingeniería de contexto solo aumentará, siendo esta una de las áreas más críticas para cualquiera que construya sistemas de IA.