Introducción

El desarrollo de modelos de lenguaje ha experimentado un cambio fundamental en los últimos años. Mientras las grandes empresas tecnológicas siguen ampliando los límites del tamaño de los modelos, la comunidad open-source ha descubierto que el rendimiento excepcional no requiere modelos de billones de parámetros. Esta guía integral explora las técnicas y estrategias de vanguardia utilizadas por los investigadores de HuggingFace para construir modelos de lenguaje eficientes y de alto rendimiento mediante metodologías de preentrenamiento rigurosas. Analizaremos cómo SmolLM 3, FineWeb y FinePDF representan un nuevo paradigma en el desarrollo de modelos—uno enfocado en maximizar el rendimiento dentro de restricciones computacionales prácticas sin perder el rigor científico ni la reproducibilidad. Los conocimientos compartidos aquí representan meses de investigación y experimentación, ofreciendo una clase magistral sobre cómo abordar el preentrenamiento de modelos en la era moderna.

Comprendiendo el Preentrenamiento de Modelos de Lenguaje en la Era Moderna

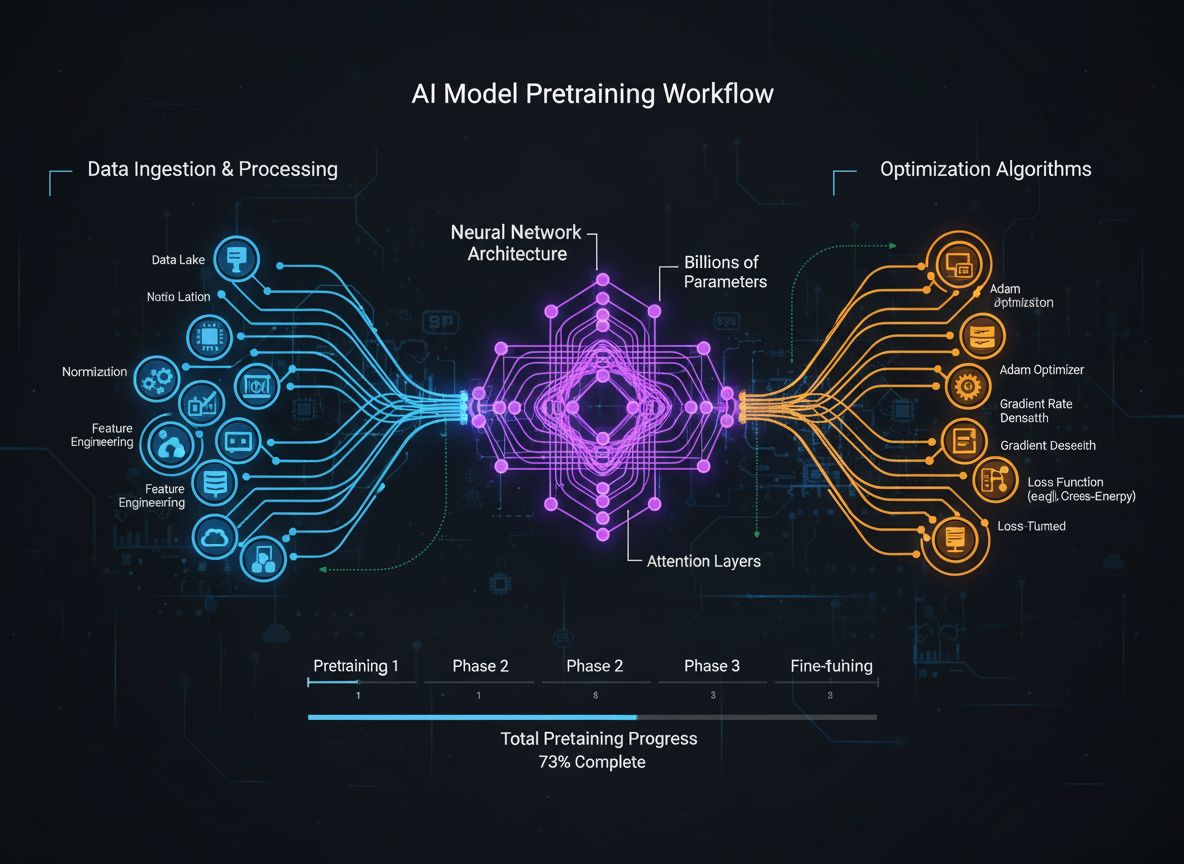

El preentrenamiento de modelos de lenguaje ha evolucionado de un proceso relativamente sencillo de alimentar datos de texto crudo a redes neuronales a una disciplina sofisticada con múltiples objetivos de optimización interconectados. En esencia, el preentrenamiento expone a un modelo a grandes cantidades de datos de texto, permitiéndole aprender patrones estadísticos del lenguaje mediante aprendizaje auto-supervisado. Sin embargo, el enfoque moderno reconoce que simplemente aumentar los datos y el cómputo no es suficiente. Los investigadores deben orquestar cuidadosamente varias dimensiones del proceso de entrenamiento—desde la selección y curación de datos hasta las decisiones arquitectónicas y los algoritmos de optimización. El campo ha madurado hasta el punto en que comprender estos matices diferencia a los modelos de última generación de los mediocres. Esta evolución refleja una comprensión más profunda de que el rendimiento de los modelos no viene dado por un solo factor, sino por la cuidadosa orquestación de múltiples objetivos ortogonales que pueden ser optimizados en paralelo. La comunidad investigadora reconoce cada vez más que el “ingrediente secreto” del desarrollo exitoso de modelos no está en la escala bruta, sino en elecciones inteligentes de diseño en cada capa del pipeline de entrenamiento.

¿Listo para hacer crecer tu negocio?

Comienza tu prueba gratuita hoy y ve resultados en días.

Por Qué la Calidad de los Datos Supera la Cantidad en el Desarrollo de Modelos

Una de las lecciones más importantes de la investigación reciente es que la calidad y diversidad de los datos de entrenamiento determina fundamentalmente el rendimiento del modelo más que la simple cantidad de datos. Este principio, a menudo resumido como “basura entra, basura sale”, ha sido cada vez más validado por la investigación empírica y la experiencia práctica. Cuando los modelos se entrenan con datos mal curados, duplicados o de baja calidad, aprenden patrones espurios y no generalizan bien a tareas nuevas. Por el contrario, los conjuntos de datos cuidadosamente seleccionados, deduplicados y filtrados permiten a los modelos aprender de manera más eficiente y lograr mejor rendimiento con menos pasos de entrenamiento. Las implicancias de este hallazgo son profundas: significa que las organizaciones e investigadores deben invertir fuertemente en curación de datos y aseguramiento de calidad en vez de simplemente acumular más datos en bruto. Este cambio de perspectiva ha llevado a la aparición de equipos y herramientas especializadas dedicadas a la creación y refinamiento de conjuntos de datos. El conjunto de datos FineWeb, que contiene más de 18.5 billones de tokens de datos web en inglés limpios y deduplicados, ejemplifica este enfoque. En vez de usar datos crudos de CommonCrawl, el equipo de FineWeb implementó técnicas sofisticadas de filtrado, deduplicación y evaluación de calidad para crear un dataset que supera consistentemente a alternativas más grandes y sin procesar. Esto representa una realización fundamental en el campo: el camino hacia mejores modelos es a través de mejores datos, no necesariamente a través de más datos.

Los Cinco Pilares de la Optimización del Entrenamiento de Modelos

El preentrenamiento moderno de modelos puede entenderse a través de cinco objetivos interconectados pero algo ortogonales que los investigadores deben optimizar simultáneamente. Comprender estos pilares brinda un marco para pensar sobre todo el proceso de entrenamiento e identificar dónde se pueden hacer mejoras. El primer pilar implica maximizar la relevancia y calidad de la información en los datos de entrenamiento. Esto abarca tanto la calidad de los datos individuales como la diversidad del conjunto en su totalidad. Un modelo entrenado con datos de alta calidad y diversidad aprenderá patrones más generalizables que uno entrenado con datos limitados o de baja calidad, sin importar otras optimizaciones. El segundo pilar se enfoca en el diseño de la arquitectura del modelo, que determina cuán eficientemente puede procesar información y bajo qué restricciones computacionales debe operar. Las decisiones arquitectónicas afectan la velocidad de inferencia, consumo de memoria, requerimientos de caché KV y la capacidad del modelo para ejecutarse en hardware específico. El tercer pilar implica maximizar la información extraída de los datos de entrenamiento en cada paso. Esto incluye técnicas como la destilación de conocimiento, donde modelos pequeños aprenden de otros más grandes, y la predicción multi-token, donde los modelos predicen varios tokens futuros a la vez. El cuarto pilar aborda la calidad de los gradientes y la dinámica de optimización, abarcando la elección de optimizador, esquemas de tasa de aprendizaje y técnicas para mantener la estabilidad del entrenamiento. El quinto pilar involucra el ajuste de hiperparámetros y estrategias de escalado que aseguran que el entrenamiento permanezca estable a medida que los modelos crecen y previenen problemas como explosión de gradientes o divergencia de activaciones. Estos cinco pilares no son independientes—interactúan de formas complejas—pero pensarlos por separado ayuda a los investigadores a identificar qué áreas necesitan atención y dónde pueden lograrse mejoras más impactantes.

Únete a nuestro boletín

Obtén los últimos consejos, tendencias y ofertas gratis.

FineWeb: Revolucionando la Curación de Datos Web a Gran Escala

FineWeb representa un hito en la creación de conjuntos de datos para preentrenamiento de modelos de lenguaje. En lugar de aceptar la salida cruda de crawlers web como CommonCrawl, el equipo de HuggingFace implementó un pipeline integral para limpiar, filtrar y deduplicar datos web a gran escala. El dataset resultante contiene más de 18.5 billones de tokens de texto en inglés de alta calidad, convirtiéndolo en uno de los conjuntos más grandes y curados disponibles para la comunidad open-source. La creación de FineWeb involucró múltiples etapas de procesamiento, cada una diseñada para eliminar contenido de baja calidad mientras se preserva la información valiosa. El equipo implementó algoritmos sofisticados de deduplicación para eliminar contenido redundante, filtros de calidad para remover spam y páginas de baja calidad, y detección de idioma para asegurar que el dataset contenga principalmente texto en inglés. Lo que hace a FineWeb particularmente valioso no es solo su tamaño, sino la validación empírica de que produce mejor rendimiento en modelos que alternativas sin procesar y de mayor tamaño. Cuando se mezcla con otros datasets, FineWeb supera sistemáticamente a otros conjuntos crudos mucho mayores, demostrando que la calidad realmente supera a la cantidad. Las curvas de rendimiento muestran que los modelos entrenados con FineWeb logran mejores resultados en benchmarks estándar comparados con modelos entrenados en datasets similares de otras fuentes. Este éxito ha inspirado a la comunidad a invertir más en curación de datos, reconociendo que allí es donde pueden lograrse grandes avances de rendimiento. El dataset FineWeb está disponible libremente para investigadores, democratizando el acceso a datos de entrenamiento de alta calidad y permitiendo que organizaciones pequeñas y equipos académicos entrenen modelos competitivos.

FinePDF: Liberando el Potencial de los Datos en PDF

Mientras FineWeb se enfocó en datos web, el equipo de HuggingFace reconoció que otra fuente masiva de información de alta calidad había sido mayormente ignorada: los documentos PDF. Los PDFs contienen enormes cantidades de información estructurada y valiosa, incluidos artículos académicos, documentación técnica, libros e informes profesionales. Sin embargo, extraer texto de PDFs es técnicamente desafiante y los enfoques previos no habían explorado sistemáticamente esta fuente a gran escala. FinePDF representa el primer esfuerzo integral para extraer, limpiar y curar datos PDF para el preentrenamiento de modelos de lenguaje. El equipo implementó un pipeline sofisticado que aborda los desafíos únicos del procesamiento de PDF, incluyendo el manejo de layouts complejos, la extracción precisa de texto de documentos multicolumna y la gestión de imágenes y tablas incrustadas. Un aspecto innovador del pipeline de FinePDF es el paso de “recuperar desde internet”, que afronta un problema crítico: los PDFs almacenados en CommonCrawl suelen estar mal extraídos o desactualizados. Al recuperar los PDFs de sus fuentes originales en internet, el equipo asegura el acceso a las versiones de mayor calidad de los documentos. Los resultados de rendimiento son impresionantes—cuando se mezcla con otros datasets, FinePDF muestra un rendimiento muy sólido en comparación con líneas base recientes como NeoTron B2. El dataset provee una nueva fuente de datos de entrenamiento de alta calidad que complementa los datos web y permite que los modelos aprendan de información más diversa y estructurada. Este trabajo abre nuevas posibilidades para la creación de datasets, sugiriendo que otras fuentes poco exploradas podrían brindar beneficios similares. El pipeline de FinePDF está siendo documentado en detalle a través de blogs y documentación técnica, permitiendo que otros investigadores construyan sobre este trabajo y apliquen técnicas similares a otras fuentes de datos.

SmolLM 3: Inteligencia Eficiente a Gran Escala

SmolLM 3 representa la culminación de aplicar técnicas de curación de datos y optimización de entrenamiento para crear un modelo de lenguaje altamente eficiente. Con 3 mil millones de parámetros, SmolLM 3 es significativamente más pequeño que muchos modelos contemporáneos, pero logra un rendimiento competitivo mediante una optimización cuidadosa a través de los cinco pilares del entrenamiento de modelos. El modelo admite razonamiento en modo dual, capacidades multilingües en seis idiomas y comprensión de largo contexto, haciéndolo notablemente versátil pese a su tamaño modesto. El desarrollo de SmolLM 3 implicó elecciones arquitectónicas orientadas a maximizar la eficiencia. El equipo seleccionó una arquitectura transformer que equilibra eficiencia computacional y capacidad de modelado, implementando técnicas como grouped query attention para reducir el consumo de memoria y la latencia de inferencia. El modelo fue entrenado usando un enfoque de preentrenamiento en tres etapas que potencia progresivamente el rendimiento en distintos dominios, permitiendo optimizar capacidades específicas en cada una. Lo que hace especialmente relevante a SmolLM 3 es que demuestra que la comunidad open-source puede ahora producir modelos que rivalizan con modelos propietarios mucho más grandes en muchas tareas. Esto desafía la suposición de que más grande siempre es mejor y sugiere que el campo ha llegado a un punto de inflexión respecto a los beneficios de la pura escala. El enfoque está cambiando hacia eficiencia, interpretabilidad y capacidades de despliegue práctico. SmolLM 3 puede ejecutarse en hardware de consumo, dispositivos de borde y entornos con recursos limitados, haciendo posible que capacidades avanzadas de IA lleguen a una audiencia mucho más amplia. Las capacidades multilingües y de largo contexto del modelo demuestran que la eficiencia no requiere sacrificar características importantes.

Destilación de Conocimiento: Aprendiendo de Modelos Más Grandes

La destilación de conocimiento es una técnica poderosa que permite que los modelos más pequeños se beneficien del conocimiento adquirido por modelos más grandes. En vez de entrenar un modelo pequeño desde cero con datos crudos, la destilación implica entrenar el modelo pequeño para imitar las salidas de uno más grande y capaz. Este enfoque es particularmente valioso en el preentrenamiento porque permite al modelo pequeño aprender patrones ya descubiertos por el grande, acelerando el aprendizaje y mejorando el rendimiento final. La mecánica de la destilación de conocimiento consiste en entrenar al modelo alumno (el más pequeño) para que iguale las distribuciones de probabilidad producidas por el modelo maestro (el más grande). Esto se realiza normalmente minimizando la divergencia entre la salida del alumno y la del maestro, a menudo usando técnicas como divergencia KL. El parámetro de temperatura controla cuán “suaves” son las distribuciones de probabilidad—temperaturas más altas suavizan las distribuciones, brindando más información sobre la confianza relativa de las predicciones. La destilación ha probado ser especialmente efectiva en el preentrenamiento de modelos de lenguaje porque permite transferir el conocimiento aprendido por modelos grandes a modelos más pequeños y eficientes. Esto es muy valioso para organizaciones que desean desplegar modelos en dispositivos de borde o entornos de recursos limitados, pero que buscan beneficiarse de las capacidades de modelos mayores. La técnica se ha sofisticado, explorando métodos como transferencia de atención (donde el alumno aprende a imitar patrones de atención del maestro) y destilación basada en características, donde se igualan representaciones intermedias de capas.

Predicción Multi-Token: Más Allá de Predecir el Siguiente Token

El entrenamiento tradicional de modelos de lenguaje se enfoca en la predicción del siguiente token—el modelo aprende a predecir el siguiente token dados todos los anteriores. Sin embargo, investigaciones recientes muestran que entrenar modelos para predecir varios tokens futuros simultáneamente puede mejorar significativamente el rendimiento, especialmente en tareas de programación y razonamiento complejo. La predicción multi-token obliga al modelo a aprender dependencias de mayor alcance y a desarrollar una comprensión más profunda de los patrones subyacentes en los datos. El enfoque consiste en añadir múltiples “cabezas” de predicción al modelo, cada una responsable de predecir un token varias posiciones adelante. Durante el entrenamiento, el modelo recibe señales de error de todas estas cabezas a la vez, alentándolo a aprender representaciones útiles para predecir múltiples pasos hacia el futuro. Esto es más desafiante que la predicción de siguiente token, pero produce mejores representaciones aprendidas. Los beneficios de la predicción multi-token van más allá de mejorar el objetivo de entrenamiento: los modelos entrenados así suelen mostrar mejor rendimiento en tareas posteriores, mejor generalización a nuevos dominios y capacidades de razonamiento superiores. La técnica resulta especialmente efectiva en generación de código, donde comprender dependencias de largo alcance es crucial para producir código sintáctica y semánticamente correcto. La investigación muestra que la predicción multi-token puede mejorar el rendimiento del modelo entre un 5% y 15% en diversos benchmarks, siendo una de las técnicas de entrenamiento más impactantes descubiertas en los últimos años. El enfoque es relativamente sencillo de implementar, pero requiere ajuste cuidadoso del número de cabezas de predicción y el peso de las pérdidas de cada una.

Innovación en Optimizadores: Más Allá de AdamW

Durante años, el optimizador AdamW ha sido la opción por defecto para entrenar grandes modelos de lenguaje. AdamW combina actualizaciones de gradiente con momento y decaimiento de pesos, brindando entrenamiento estable y buena convergencia. Sin embargo, investigaciones recientes muestran que AdamW puede no ser óptimo para todos los escenarios, especialmente al escalar a modelos muy grandes. Nuevos optimizadores como Muon y King K2 exploran enfoques alternativos que ofrecen mejores dinámicas de entrenamiento y mejor rendimiento. La idea central tras estos optimizadores es que la matriz Hessiana—que captura la curvatura del paisaje de pérdida—puede ser mejor aproximada mediante técnicas como los métodos de Newton-Schulz. Al mantener una mejor aproximación de la Hessiana, estos optimizadores generan actualizaciones de gradiente más informativas, conduciendo a una convergencia más rápida y mejor rendimiento final. Muon, por ejemplo, usa la iteración de Newton-Schulz para ortogonalizar la matriz de gradiente, lo que distribuye el aprendizaje en más dimensiones que los enfoques tradicionales basados en momento. Esto resulta en entrenamiento más estable y alienta al modelo a explorar nuevas regiones del espacio de parámetros en vez de seguir la misma trayectoria de optimización que AdamW. King K2 toma un enfoque distinto, rastreando cantidades como el log máximo por cabeza y usando esa información para ajustar de manera adaptativa las tasas de aprendizaje y el recorte de gradientes. Las implicancias de la innovación en optimizadores son significativas. Muchos profesionales continúan usando AdamW con hiperparámetros optimizados para modelos mucho más pequeños, incluso al entrenar modelos con órdenes de magnitud superiores en tamaño. Esto sugiere que puede lograrse una mejora considerable simplemente actualizando la elección de optimizador y los hiperparámetros para modelos modernos y de gran escala. La comunidad reconoce cada vez más que la elección de optimizador no está “resuelta” y que la innovación constante en este campo puede generar mejoras sustanciales en eficiencia y rendimiento final.

Calidad del Gradiente y Estabilidad del Entrenamiento

Mantener gradientes de alta calidad durante todo el entrenamiento es esencial para lograr buen rendimiento en los modelos. A medida que los modelos escalan a miles de millones o billones de parámetros, el entrenamiento se vuelve cada vez más inestable, con gradientes propensos a explotar o desvanecerse. Abordar estos problemas requiere atención cuidadosa a la calidad de los gradientes y la implementación de técnicas que aseguren estabilidad en todo el proceso de entrenamiento. Un enfoque para mejorar la calidad del gradiente es usar técnicas como el recorte de gradientes, que impide que estos se vuelvan demasiado grandes y desestabilicen el entrenamiento. Sin embargo, el recorte ingenuo puede descartar información valiosa. Enfoques más sofisticados normalizan los gradientes preservando la información y previniendo la inestabilidad. Otra consideración importante es la elección de funciones de activación y técnicas de normalización de capas. Diferentes funciones de activación poseen propiedades distintas respecto al flujo del gradiente, y una selección cuidadosa puede impactar significativamente la estabilidad. La normalización de capas, que normaliza activaciones a lo largo de la dimensión de características, es estándar en transformadores porque provee mejor flujo de gradiente que la normalización por lotes. El esquema de tasa de aprendizaje también es crucial para mantener la calidad del gradiente. Una tasa demasiado alta puede causar explosión de gradientes, mientras que una muy baja puede ralentizar la convergencia o hacer que el modelo quede atrapado en mínimos locales. El entrenamiento moderno suele emplear esquemas de tasa de aprendizaje que inician con una fase de “warm-up”, aumentando gradualmente la tasa para permitir que el modelo se asiente en una buena región del espacio de parámetros, seguida de una fase de decaimiento a medida que avanza el entrenamiento. Entender y optimizar estos aspectos es crucial para entrenar modelos grandes exitosamente, y sigue siendo un área activa de investigación.

FlowHunt y la Automatización de Flujos de Entrenamiento de Modelos

La complejidad del preentrenamiento moderno—con sus múltiples objetivos de optimización, pipelines sofisticados de datos y cuidadoso ajuste de hiperparámetros—plantea grandes desafíos para equipos que buscan implementar estas técnicas. FlowHunt aborda estos retos proporcionando una plataforma para automatizar y orquestar flujos de entrenamiento complejos. En vez de gestionar manualmente el procesamiento de datos, el entrenamiento y la evaluación, los equipos pueden usar FlowHunt para definir flujos que automatizan estas tareas, reduciendo errores y mejorando la reproducibilidad. Las capacidades de automatización de FlowHunt son especialmente valiosas para los pasos de curación y procesamiento de datos tan críticos para el rendimiento del modelo. La plataforma puede implementar automáticamente pipelines de datos como los usados en FineWeb y FinePDF, incluyendo deduplicación, filtrado de calidad y conversión de formatos. Esto permite que los equipos se concentren en decisiones de alto nivel sobre qué datos incluir y cómo procesarlos, sin atascarse en detalles de implementación. Además, FlowHunt ayuda a gestionar el ajuste de hiperparámetros y la experimentación necesaria para optimizar el entrenamiento. Al automatizar experimentos con distintos hiperparámetros y recolectar resultados, FlowHunt permite explorar el espacio de parámetros de forma eficiente e identificar configuraciones óptimas más rápido. También ofrece herramientas para monitorizar el progreso, detectar problemas como explosión de gradientes o divergencia y ajustar automáticamente parámetros para mantener la estabilidad. Para organizaciones que entrenan sus propios modelos de lenguaje o afinan modelos existentes, FlowHunt puede reducir significativamente el tiempo y el esfuerzo necesarios, mejorando la calidad de los resultados.

Escalando de Modelos Pequeños a Modelos Grandes

Uno de los aspectos más desafiantes del entrenamiento de modelos es entender cómo escalar de modelos pequeños a grandes manteniendo la estabilidad y el rendimiento. La relación entre el tamaño del modelo y los hiperparámetros óptimos no es directa—los hiperparámetros que funcionan bien para modelos pequeños suelen requerir ajuste para modelos grandes. Esto es especialmente cierto para las tasas de aprendizaje, que generalmente deben reducirse a medida que los modelos crecen. Comprender las leyes de escalado es crucial para predecir cómo se comportarán los modelos a diferentes escalas y tomar decisiones sobre la asignación de recursos. La investigación ha demostrado que el rendimiento de los modelos sigue leyes de escalado predecibles, donde el rendimiento mejora como una función de potencia del tamaño del modelo, el tamaño del conjunto de datos y el presupuesto computacional. Estas leyes permiten predecir cuánto mejorará el rendimiento al aumentar el modelo o los datos, permitiendo decisiones más informadas sobre dónde invertir recursos. Sin embargo, las leyes de escalado no son universales—dependen de la arquitectura, el procedimiento de entrenamiento y el dataset específico. Esto significa que los equipos deben realizar sus propios experimentos de escalado para entender cómo escala su configuración particular. Escalar modelos también implica prestar atención a la estabilidad: los modelos grandes son más propensos a inestabilidades como explosión de gradientes o divergencia. Abordar estos problemas requiere técnicas como recorte de gradientes, esquemas de tasa de aprendizaje cuidadosos y, potencialmente, cambios en la arquitectura o el optimizador. La comunidad reconoce cada vez más que escalar no es solo hacer modelos más grandes, sino gestionar cuidadosamente el proceso para asegurar que puedan entrenarse efectivamente.

El aprendizaje de características se refiere al proceso por el cual los modelos aprenden a extraer características útiles de los datos crudos durante el entrenamiento. En el preentrenamiento de modelos de lenguaje, implica que el modelo aprenda a representar conceptos lingüísticos, relaciones semánticas y patrones sintácticos en sus representaciones internas. Maximizar el aprendizaje de características—asegurando que el modelo extraiga la mayor cantidad posible de información útil de los datos en cada paso—es uno de los objetivos clave en el entrenamiento moderno. Una forma de pensar el aprendizaje de características es en términos de cuánto cambian las representaciones del modelo en respuesta a las actualizaciones de gradiente. Si el modelo aprende eficazmente, cada actualización resultará en cambios significativos que mejoran su capacidad de predecir tokens futuros. Si no aprende bien, los cambios pueden ser menores o no mejorar el rendimiento. Las técnicas para mejorar el aprendizaje de características incluyen la inicialización cuidadosa de los pesos, que puede afectar significativamente la rapidez con que el modelo aprende características útiles al principio. Otra técnica importante es el uso de esquemas de tasa de aprendizaje que permiten aprender rápidamente al inicio y reducir la velocidad a medida que avanza el entrenamiento y el modelo refina patrones más sutiles. El concepto de aprendizaje de características está estrechamente relacionado con el de “colapso de características”, donde los modelos aprenden a ignorar ciertas características o dimensiones de la entrada. Esto puede suceder cuando el modelo encuentra atajos para lograr buen rendimiento sin aprender todas las características necesarias. Técnicas como la regularización y el diseño cuidadoso de la función de pérdida pueden ayudar a prevenir el colapso y asegurar que los modelos aprendan características diversas y útiles.

{{ cta-dark-panel

heading=“Potencia tu flujo de trabajo con FlowHunt”

description=“Descubre cómo FlowHunt automatiza tus flujos de contenido de IA y SEO — desde la investigación y generación de contenido hasta la publicación y analítica — todo en un solo lugar.”

ctaPrimaryText=“Solicitar una Demostración”

ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo"

ctaSecondaryText=“Probar FlowHunt Gratis”

ctaSecondaryURL=“https://app.flowhunt.io/sign-in"

gradientStartColor="#123456”

gradientEndColor="#654321”

gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217”

}}

El Cambio de la Pura Escala: Por Qué Más Grande No Siempre es Mejor

Durante varios años, la narrativa dominante en la investigación de IA fue que los modelos más grandes son mejores. Esto generó una carrera por construir modelos cada vez más grandes, con empresas compitiendo por anunciar más parámetros. Sin embargo, desarrollos recientes sugieren que esta narrativa podría estar cambiando. El éxito de SmolLM 3 y otros modelos eficientes demuestra que puede lograrse rendimiento excepcional con modelos órdenes de magnitud más pequeños que los más grandes. Este cambio refleja una comprensión más profunda de que el rendimiento depende de múltiples factores, no solo del número de parámetros. Un modelo de 3 mil millones de parámetros entrenado con datos de alta calidad y técnicas sofisticadas puede superar a un modelo mucho más grande entrenado con datos inferiores y menor optimización. Esto tiene implicancias profundas para el campo. Sugiere que la investigación más impactante puede no estar en construir modelos más grandes, sino en mejorar la calidad de los datos, desarrollar mejores técnicas de entrenamiento y crear arquitecturas más eficientes. También democratiza el desarrollo de IA, haciendo posible que organizaciones pequeñas y equipos académicos creen modelos competitivos sin acceso a recursos computacionales masivos. El alejamiento de la pura escala también tiene implicancias prácticas para el despliegue. Los modelos más pequeños pueden ejecutarse en dispositivos de borde, entornos con recursos limitados y con menor latencia y consumo energético. Esto hace que capacidades avanzadas de IA sean accesibles para una gama mucho más amplia de aplicaciones y usuarios. La comunidad reconoce que el futuro del desarrollo de IA puede implicar un portafolio de modelos de diferentes escalas, cada uno optimizado para casos de uso y escenarios de despliegue específicos, en vez de un único enfoque en construir el modelo más grande posible.

Ajuste de Hiperparámetros y Dinámica de Entrenamiento

El ajuste de hiperparámetros es el proceso de seleccionar los valores de parámetros que controlan el entrenamiento, como la tasa de aprendizaje, el tamaño de lote y el decaimiento de pesos. Estos parámetros tienen un impacto significativo en el rendimiento del modelo y encontrar los valores óptimos es crucial. Sin embargo, el ajuste de hiperparámetros suele tratarse como un arte más que una ciencia, confiando en la intuición y prueba-error más que en métodos sistemáticos. Los enfoques modernos implican una exploración más sistemática del espacio de hiperparámetros. Técnicas como la optimización bayesiana pueden explorar eficientemente el espacio de valores posibles, identificando regiones prometedoras y concentrando la búsqueda allí. La búsqueda en cuadrícula y aleatoria son alternativas más simples que también pueden ser efectivas, especialmente combinadas con computación paralela para evaluar múltiples configuraciones a la vez. Una percepción importante de la investigación reciente es que los hiperparámetros óptimos suelen depender del modelo, dataset y configuración de entrenamiento específicos. Esto significa que los hiperparámetros que funcionan bien para un modelo pueden no funcionar para otro, incluso si son similares en tamaño y arquitectura. Esto ha conducido a la práctica de realizar barridos de hiperparámetros para cada nuevo modelo o conjunto de datos, lo que puede ser costoso computacionalmente, pero suele ser necesario para lograr el mejor rendimiento. Comprender la relación entre hiperparámetros y rendimiento también es importante para depurar problemas de entrenamiento. Si el entrenamiento es inestable o converge lentamente, el problema puede deberse a elecciones subóptimas de hiperparámetros y no a problemas fundamentales del modelo o los datos. Al explorar sistemáticamente el espacio de hiperparámetros, los profesionales pueden identificar y corregir estos problemas.

Implicaciones Prácticas para Organizaciones que Construyen Modelos

Las conclusiones de la investigación moderna sobre preentrenamiento de modelos tienen importantes implicaciones prácticas para organizaciones que construyen sus propios modelos de lenguaje o afinan modelos existentes. Ante todo, las organizaciones deben invertir fuertemente en curación de datos y aseguramiento de calidad. La evidencia es clara: los datos de alta calidad son más valiosos que grandes cantidades de datos de baja calidad. Esto implica implementar pipelines sofisticados que incluyan deduplicación, filtrado de calidad y estandarización de formatos. Segundo, las organizaciones deben considerar cuidadosamente sus objetivos de optimización y asegurarse de optimizar las métricas correctas. Diferentes aplicaciones pueden requerir distintos equilibrios entre tamaño, velocidad de inferencia y precisión. Definir claramente estos trade-offs desde el inicio permite tomar mejores decisiones sobre arquitectura y procedimientos de entrenamiento. Tercero, deben mantenerse informadas sobre los avances recientes en técnicas de entrenamiento y diseño de optimizadores. El campo avanza rápidamente y técnicas de vanguardia de hace un año pueden ser superadas por nuevos enfoques. Revisar regularmente artículos de investigación y experimentar con nuevas técnicas puede ayudar a mantener la competitividad. Cuarto, deben invertir en herramientas e infraestructura que faciliten la implementación de procedimientos sofisticados. Esto puede implicar usar plataformas como FlowHunt para automatizar el procesamiento de datos y el entrenamiento, o invertir en infraestructura propia para experimentar y ajustar hiperparámetros eficientemente. Finalmente, deben reconocer que el desarrollo de modelos no es solo entrenamiento—también implica evaluación cuidadosa, depuración e iteración. Construir buenos modelos requiere un enfoque sistemático que incluya evaluación regular en benchmarks diversos, análisis de casos de fallo y mejoras iterativas basadas en lo aprendido.

El Futuro de la Investigación en Preentrenamiento de Modelos

El campo del preentrenamiento de modelos evoluciona rápidamente, con nuevas técnicas y hallazgos emergiendo regularmente. Varias tendencias sugieren hacia dónde podría dirigirse el área. Primero, probablemente continuará el enfoque en la calidad y curación de datos. A medida que se reconoce que la calidad es más importante que la cantidad, veremos pipelines de procesamiento más sofisticados y más investigación sobre qué hace “buenos” los datos para el entrenamiento. Segundo, es probable que continúe la innovación en diseño de optimizadores y dinámica de entrenamiento. El éxito de nuevos optimizadores como Muon y King K2 sugiere que aún hay mucho por mejorar en cómo optimizamos el entrenamiento. Tercero, crecerá el enfoque en eficiencia y despliegue práctico. A medida que los modelos son más capaces, aumenta el interés en hacerlos más pequeños, rápidos y eficientes. Esto incluye investigación en compresión, cuantización y técnicas de destilación. Cuarto, habrá más investigación para entender y mejorar la interpretabilidad de los modelos. A medida que los modelos son más poderosos, comprender cómo funcionan y por qué toman ciertas decisiones será cada vez más importante. Finalmente, seguirá la democratización del desarrollo de modelos, con más herramientas y técnicas disponibles para que organizaciones pequeñas y equipos académicos construyan modelos competitivos.

Conclusión

El enfoque moderno del preentrenamiento de modelos de lenguaje representa una evolución significativa respecto a métodos anteriores y más simples. En lugar de simplemente escalar datos y cómputo, el desarrollo exitoso de modelos ahora requiere orquestar cuidadosamente múltiples objetivos de optimización, técnicas sofisticadas de curación de datos e innovación continua en métodos de entrenamiento y diseño de optimizadores. SmolLM 3, FineWeb y FinePDF ejemplifican este nuevo paradigma, demostrando que puede alcanzarse un rendimiento excepcional mediante atención rigurosa a la calidad de los datos, eficiencia arquitectónica y optimización del entrenamiento. El cambio de la pura escala hacia la eficiencia y la calidad marca la maduración del campo y abre nuevas posibilidades para democratizar el desarrollo de IA. Las organizaciones que comprendan e implementen estos principios estarán mejor posicionadas para construir modelos competitivos, ya sea desarrollando nuevos modelos desde cero o afinando existentes. La comunidad investigadora sigue expandiendo los límites de lo posible, con nuevas técnicas y hallazgos emergiendo regularmente. Manteniéndose informadas sobre estos avances e invirtiendo en las herramientas e infraestructura adecuadas, las organizaciones pueden asegurarse de construir modelos que representen el estado del arte en desarrollo de modelos.