Cómo Probar un Chatbot de IA

Aprende estrategias completas para probar chatbots de IA, incluyendo pruebas funcionales, de rendimiento, seguridad y usabilidad. Descubre mejores prácticas, he...

Descubre cómo el motor de simulación de Snowglobe te ayuda a probar agentes de IA, chatbots y sistemas generativos de IA antes de producción, simulando interacciones reales con usuarios e identificando puntos de fallo.

Construir agentes de IA y chatbots confiables se ha convertido en uno de los mayores desafíos en el desarrollo de software moderno. Aunque los modelos de machine learning son cada vez más sofisticados, la brecha entre el desempeño en laboratorio y el comportamiento en el mundo real sigue siendo considerable. Al desplegar un sistema de IA en producción, inevitablemente te enfrentas a la infinita variedad y complejidad del contexto humano, sus metas y patrones de interacción, que ningún set de entrenamiento puede capturar completamente. Aquí es donde entra Snowglobe: un motor de simulación diseñado para cerrar esta brecha permitiéndote probar cómo los usuarios interactuarán realmente con tu producto de IA antes de que llegue a producción. En vez de descubrir problemas después del despliegue, Snowglobe te permite simular miles de interacciones de usuarios, identificar puntos de fallo y validar el comportamiento de tu sistema según los requisitos específicos de tu producto. Esta guía completa explora cómo funciona Snowglobe, por qué la simulación se ha vuelto esencial para la confiabilidad de la IA y cómo se conecta con estrategias más amplias para construir sistemas de IA confiables.

El reto de desplegar sistemas de IA de forma fiable tiene profundas raíces en la historia del aprendizaje automático y los sistemas autónomos. Durante décadas, investigadores e ingenieros han lidiado con el problema fundamental de que los modelos entrenados con datos históricos a menudo se comportan de manera impredecible cuando se enfrentan a escenarios novedosos en el mundo real. Este problema se agudizó especialmente en dominios críticos para la seguridad, como los vehículos autónomos, donde las consecuencias de un comportamiento inesperado pueden ser catastróficas. La industria de autos autónomos desarrolló enfoques sofisticados para afrontar este reto, y muchos de estos patrones ahora se están adaptando para agentes y sistemas de IA generativa. Una de las ideas más potentes de este sector es que la simulación jugó un rol crucial tanto en las pruebas como en el entrenamiento: empresas como Waymo realizaron miles de millones de millas de conducción simulada para validar sus sistemas antes de ponerlos en las carreteras reales. El principio es simple: al exponer tu sistema a una gran variedad de escenarios en un entorno controlado y de bajo costo, puedes identificar y corregir problemas antes de que afecten a usuarios reales. Este mismo principio aplica para agentes de IA, chatbots y otras aplicaciones generativas, aunque los escenarios simulados sean interacciones conversacionales y no de conducción. La brecha de fiabilidad existe porque los entornos de producción introducen variables que los datasets de entrenamiento no pueden representar completamente: estilos de comunicación diversos, casos límite inesperados, requisitos dependientes del contexto y comportamientos emergentes que surgen de la interacción entre el sistema de IA y los usuarios humanos reales.

Cuando las organizaciones empiezan a construir sistemas de IA, normalmente recurren a marcos de seguridad y gestión de riesgos consolidados, como el NIST AI Risk Management Framework o el OWASP Top 10 para Modelos de Lenguaje Extensos. Estos marcos ofrecen guías valiosas sobre riesgos comunes como alucinaciones, inyecciones de prompts o generación de contenido tóxico. Sin embargo, existe una distinción crítica entre riesgos inherentes al modelo y riesgos que emergen de cómo el modelo se implementa en el contexto específico de un producto. La mayoría de los marcos tradicionales se centran en lo primero: propiedades generales de seguridad que los proveedores de modelos ya intentan resolver. Un modelo de un proveedor grande como OpenAI o Anthropic ya ha sido entrenado extensamente para minimizar alucinaciones y salidas tóxicas. Salvo que alguien intente hacer jailbreak a tu sistema, es poco probable que encuentres estos problemas usando el modelo como se pretende. Los retos reales emergen a nivel de implementación, donde tu caso de uso, requisitos de producto y diseño del sistema crean nuevas formas de fallo que los marcos generales no pueden anticipar. Considera un chatbot de soporte al cliente basado en un modelo de lenguaje. El modelo puede ser perfectamente seguro y fiable, pero si tu sistema está configurado de forma demasiado conservadora, podría negarse a responder preguntas legítimas de los clientes, generando una mala experiencia y reduciendo la adhesión al producto. Este fenómeno—el rechazo excesivo—es un problema a nivel de producto que los benchmarks tradicionales no detectan. Solo se hace evidente al simular interacciones reales y observar el comportamiento de tu implementación concreta. Por eso las pruebas basadas en simulación se han vuelto esenciales: te permiten identificar los modos de fallo relevantes para tu producto particular, en vez de centrarte solo en métricas generales de seguridad.

El paso de los guardarraíles a la simulación representa una evolución natural en la forma en que las organizaciones abordan la fiabilidad en IA. Los guardarraíles—reglas y filtros que previenen ciertos tipos de respuestas—son útiles como última línea de defensa ante violaciones que no puedes tolerar en producción. Sin embargo, los guardarraíles por sí solos son insuficientes porque requieren que sepas de antemano contra qué necesitas protegerte. Cuando las organizaciones empezaron a construir sistemas de guardarraíles, surgía la pregunta persistente: ¿qué guardarraíles debemos implementar realmente? ¿Deberíamos centrarnos en alucinaciones? ¿Protección de PII? ¿Toxicidad? ¿Bias? La respuesta siempre era insatisfactoria porque dependía completamente del caso de uso y la implementación. Un chatbot sanitario tiene preocupaciones distintas a un asistente creativo. Un bot asesor financiero necesita guardarraíles distintos a un chatbot de conocimiento general. En vez de adivinar qué guardarraíles importan más, la simulación te permite determinar empíricamente dónde realmente falla tu sistema. Al generar un gran conjunto de interacciones simuladas y observar la respuesta de tu sistema, puedes identificar los modos de fallo genuinos que afectan a tu producto. Una vez que entiendes dónde es frágil tu sistema, puedes implementar guardarraíles o mejoras específicas para esos problemas concretos. Este enfoque basado en datos es mucho más efectivo que aplicar marcos generales de seguridad. En la práctica, las organizaciones han descubierto que la simulación a menudo revela problemas inesperados. Un socio de diseño temprano que usaba simulación estaba preocupado por la toxicidad en su chatbot, así que implementó guardarraíles para toxicidad. Sin embargo, al ejecutar simulaciones completas, la toxicidad no resultó ser un problema relevante para su caso. Lo que sí surgió fue el rechazo excesivo—el chatbot era tan conservador que rechazaba solicitudes benignas que debía responder. Este hallazgo nunca habría surgido de marcos tradicionales; solo se hizo evidente mediante pruebas basadas en simulación.

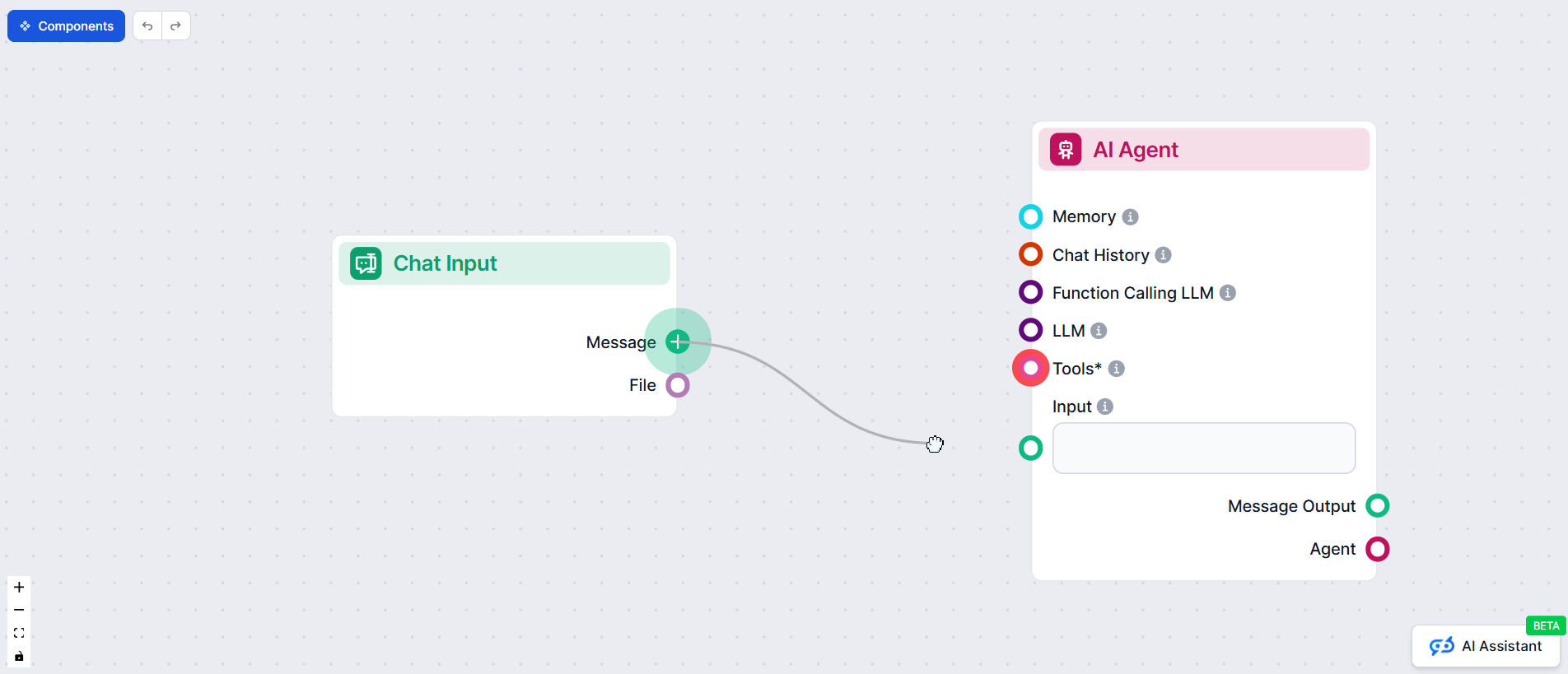

Snowglobe opera bajo un principio aparentemente sencillo: conéctate a tu sistema de IA, describe lo que hace y luego genera miles de interacciones simuladas para ver cómo se comporta. Sin embargo, su implementación involucra varios componentes sofisticados que trabajan juntos para crear escenarios de prueba realistas, diversos y significativos. El primer requisito es una conexión en vivo con el sistema de IA a probar. Puede ser un endpoint de API, un chatbot desplegado, un agente o cualquier otra aplicación de IA. Snowglobe establece y mantiene esta conexión durante el proceso de simulación, permitiendo enviar consultas de prueba y recibir respuestas como lo haría un usuario real. Esta conexión en vivo es crítica porque significa que pruebas tu sistema real tal como se comportará en producción, no un modelo simplificado o simulado. El segundo requisito es una descripción de lo que hace tu sistema de IA. No hace falta que sea un prompt elaborado o perfectamente diseñado. Basta con unas frases que expliquen el propósito del sistema, a quién sirve y qué tipo de preguntas o casos de uso pueden traer los usuarios. Esta descripción sirve como base para generar usuarios e interacciones simulados realistas. Snowglobe utiliza esta descripción para comprender el contexto y alcance de tu sistema, generando así escenarios de prueba relevantes para tu caso. El tercer componente es opcional pero potente: tu base de conocimiento o datos históricos. Si tu sistema de IA consulta una base de conocimiento, Snowglobe puede analizarla por temas y generar preguntas que requieran que el sistema acceda a esa base para responder. Así aseguras cobertura programática de toda tu base, en vez de depender de la creación manual de casos de prueba. De igual forma, si tienes logs o interacciones históricas, Snowglobe puede analizarlas y generar escenarios de prueba basados en patrones reales de uso. Una vez que estos componentes están listos, defines un prompt de simulación que especifica qué tipo de usuarios e interacciones quieres probar. Aquí es donde la flexibilidad de Snowglobe se hace evidente. Puedes probar usuarios generales con preguntas variadas, o enfocarte en escenarios específicos—por ejemplo, usuarios preguntando sobre cambios de carrera en un chatbot de coaching. También puedes ejecutar pruebas de comportamiento, donde los usuarios simulados intentan hacer jailbreak o poner a prueba los límites de tu sistema. Incluso puedes correr simulaciones centradas en seguridad, con usuarios preguntando sobre temas sensibles como autolesiones. Para cada simulación, configuras la escala: cuántos personajes distintos generar, cuántas conversaciones debe tener cada uno y cuánto debe durar cada conversación. También defines los riesgos a probar—seguridad de contenido, autolesiones, alucinaciones u otros. Al iniciar la simulación, Snowglobe genera personas diversas con estilos de comunicación, antecedentes y casos de uso propios. Cada persona tiene un perfil de personalidad único que influye en su interacción con tu sistema. Una persona puede ser alguien que piensa con mucho detenimiento y cambia de opinión a menudo, usando lenguaje formal y gramática correcta. Otra puede ser alguien que sobre-explica y matiza cada afirmación. Estas personas luego conversan con tu sistema de IA, y Snowglobe captura y analiza todas las interacciones para identificar patrones, fallos y áreas donde el sistema se comporta de forma inesperada.

Uno de los aspectos más sofisticados de Snowglobe es cómo genera personas diversas para las pruebas. En vez de crear usuarios genéricos, Snowglobe produce personas con estilos de comunicación, antecedentes, preocupaciones y patrones de interacción propios. Esta diversidad es clave porque los usuarios reales no son homogéneos: tienen diferentes formas de expresarse, distintos niveles de sofisticación técnica, contextos culturales y objetivos cuando interactúan con tu sistema de IA. Al simular esta diversidad, puedes identificar modos de fallo que solo emergen con ciertos tipos de usuarios o estilos de comunicación. Al crear una persona, Snowglobe construye un perfil detallado que incluye no solo información demográfica sino también características de comportamiento. Por ejemplo, una persona puede ser alguien que piensa cuidadosamente y cambia de opinión al hablar, usa ortografía y gramática muy correctas y se comunica de forma formal con el chatbot. Sus casos de uso pueden incluir transiciones de carrera, dinámicas de pareja y bloqueos creativos. Su estilo de comunicación puede ser sobre-explicativo, cortés y matizador. Este nivel de detalle garantiza que, cuando esta persona interactúe con tu sistema de IA, las interacciones sean realistas y representen cómo actuaría un usuario real con esas características. El poder de este enfoque se vuelve evidente al considerar cómo distintas personas pueden exponer diferentes modos de fallo. Una persona que se comunica de manera muy formal y cuidadosa puede revelar casos límite distintos a una que use lenguaje casual y abreviaturas. Una persona centrada en temas sensibles, como salud mental, puede detonar comportamientos diferentes a una que solo pregunte cuestiones generales. Al ejecutar simulaciones con decenas o cientos de personas distintas, creas una batería de pruebas mucho más amplia que la que lograrías con pruebas manuales. Además, Snowglobe te permite controlar las características de comportamiento de las personas para enfocarte en escenarios concretos. Si quieres probar cómo tu sistema gestiona usuarios que intentan hacerle jailbreak, puedes generar personas con ese objetivo. Si quieres ver cómo responde ante usuarios que preguntan sobre temas sensibles, puedes generar personas centradas en esos tópicos. Esta generación dirigida te permite realizar pruebas de seguridad enfocadas y, a la vez, mantener la capacidad de simular interacciones generales que expongan comportamientos imprevistos.

Un aprendizaje clave del enfoque de Snowglobe es que lo más importante a probar a menudo no son las métricas de seguridad genéricas recomendadas por los marcos, sino los KPIs específicos de producto que determinan si tu IA realmente aporta valor a los usuarios. Esto supone un cambio fundamental en la forma en que las organizaciones deben pensar sobre la fiabilidad de la IA. Los marcos tradicionales se centran en evitar malos resultados—alucinaciones, toxicidad, violaciones de privacidad. Aunque son importantes, a menudo no son el principal factor de éxito o fracaso del producto. Lo que realmente determina el éxito es si el sistema ayuda a los usuarios a lograr sus objetivos, si comunica conforme a tu marca y valores, si ofrece información precisa y útil y si genera una experiencia positiva. Estas métricas de producto suelen ser invisibles para los marcos tradicionales pero son críticas para probar mediante simulación. Piensa en un agente de soporte por email. El marco tradicional puede centrarse en si el agente genera contenido tóxico o alucina información. Pero la verdadera pregunta para el éxito del producto es si responde con las pautas de comunicación y tono que usa tu equipo de soporte. Si tu soporte destaca por ser cálido, empático y orientado a soluciones, pero tu agente de IA es frío, formal y distante, el producto fallará aunque sea seguro por métricas tradicionales. Este es un fallo a nivel de producto que solo puede detectarse mediante simulación. De igual forma, considera un chatbot de ventas. El marco tradicional puede centrarse en si genera afirmaciones engañosas, pero lo relevante es si realmente guía al usuario hacia la decisión de compra, responde a sus dudas y mantiene el interés durante la conversación. Estos son KPIs de producto que determinan el valor real del chatbot. Al ejecutar simulaciones centradas en estas métricas, las organizaciones pueden identificar los modos de fallo que más importan para su negocio. Este enfoque, además, es mucho más accionable. Si una simulación revela que tu agente rechaza solicitudes legítimas, tienes un problema claro que resolver. Si revela que tu chatbot no aborda bien las objeciones, hay un área concreta a mejorar. Estas conclusiones de producto son mucho más útiles que advertencias genéricas porque se conectan directamente con los resultados de negocio.

Descubre cómo FlowHunt automatiza tus flujos de contenido y SEO con IA — desde la investigación y generación de contenido hasta la publicación y analítica — todo en un solo lugar.

Implementar simulaciones con Snowglobe implica un flujo de trabajo sencillo que puede adaptarse a distintos escenarios y necesidades de la organización. El primer paso es establecer una conexión en vivo con tu sistema de IA. Esta conexión debe mantenerse durante todo el proceso de simulación ya que Snowglobe necesita enviar consultas y recibir respuestas en tiempo real. El proceso es simple y rápido—normalmente toma solo unos segundos verificar que Snowglobe puede comunicarse con tu sistema. Una vez establecida la conexión, pasas al segundo paso: proveer una descripción de tu sistema de IA. Esta descripción debe responder varias preguntas clave: ¿Cuál es el objetivo principal del sistema? ¿Quiénes son los usuarios previstos? ¿Qué tipo de preguntas o solicitudes harán los usuarios? ¿Cuáles son los casos de uso clave? No necesita ser exhaustiva ni perfectamente pulida. De hecho, Snowglobe está diseñado para funcionar con descripciones breves y naturales. La descripción sirve de base para generar escenarios de prueba realistas, así que debe ser precisa y representativa del alcance y propósito reales del sistema. El tercer paso es opcional pero muy recomendable: conectar tu base de conocimiento o datos históricos. Si tu sistema consulta una base para responder, puedes conectarla a Snowglobe, que la analizará, identificando temas y generando preguntas que requieran acceder a dicha base. Así aseguras una cobertura completa y detectas casos en los que tu sistema podría fallar al recuperar o usar la información correcta. De igual forma, si tienes logs o interacciones históricas, puedes proporcionarlos a Snowglobe, que generará escenarios de prueba basados en patrones reales de uso. El cuarto paso es definir tu prompt de simulación. Aquí especificas qué tipo de usuarios e interacciones quieres probar. Puedes escribir algo como “usuarios generales preguntando sobre vida y trabajo”, “usuarios intentando hacer jailbreak al sistema” o “usuarios preguntando sobre temas sensibles de salud mental”. El prompt de simulación es una palanca poderosa para enfocar las pruebas en escenarios o comportamientos concretos. Puedes ejecutar múltiples simulaciones con distintos prompts para probar varios aspectos del sistema. El quinto paso es configurar la escala y alcance de la simulación. Indicas cuántas personas distintas quieres generar, cuántas conversaciones debe tener cada una y la longitud de cada conversación. También defines qué riesgos quieres probar—seguridad de contenido, autolesiones, alucinaciones, sesgos u otros. Estas opciones te permiten equilibrar la cobertura de las pruebas con el tiempo y recursos necesarios. Una simulación pequeña puede implicar 10 personas, 30 conversaciones y 4-5 turnos por conversación. Una grande puede implicar cientos de personas y miles de conversaciones. Una vez configurado todo, inicias la simulación. Snowglobe empieza a generar personas y conversaciones, y puedes observar en tiempo real cómo se crean y cómo se desarrollan los diálogos. El sistema muestra información detallada sobre cada persona, incluyendo su estilo de comunicación, antecedentes, casos de uso y rasgos de comportamiento. A medida que avanzan las conversaciones, puedes ver cómo responde tu sistema ante distintos tipos de usuarios y preguntas. Al finalizar la simulación, Snowglobe ofrece análisis e informes completos de los resultados, permitiéndote identificar patrones, fallos y áreas de mejora.

El valor de la simulación solo se materializa al analizar los resultados y extraer conclusiones accionables. Snowglobe proporciona informes y herramientas de análisis detalladas que te ayudan a entender cómo se desempeñó tu sistema de IA en miles de interacciones simuladas. El análisis suele centrarse en varias dimensiones clave. Primero, puedes revisar tasas de éxito globales y patrones de fallo. ¿Cuántas interacciones simuladas resultaron en una respuesta útil y precisa? ¿Cuántas en rechazo, información incorrecta o comportamientos inesperados? Estas métricas generales te dan una idea de la fiabilidad global del sistema. Segundo, puedes profundizar en modos de fallo específicos. Cuando tu sistema falló, ¿cuál fue la naturaleza del fallo? ¿Rechazó preguntas que debía responder? ¿Dio información inexacta? ¿Malinterpretó la intención del usuario? ¿Violó las pautas de comunicación? Al categorizar los fallos, puedes identificar patrones y priorizar qué problemas abordar primero. Tercero, puedes analizar cómo distintas personas experimentaron tu sistema. ¿Ciertos tipos de usuarios encontraron más problemas? ¿Usuarios con estilos de comunicación o antecedentes específicos tuvieron peores experiencias? Este análisis puede revelar sesgos o casos límite que no se ven en las estadísticas agregadas. Cuarto, puedes examinar conversaciones concretas en detalle. Snowglobe permite revisar diálogos individuales entre usuarios simulados y tu sistema, lo cual ayuda a entender el contexto y matiz de los fallos. A veces, un fallo que parece grave en números resulta razonable al ver el contexto completo. Otras veces, un fallo menor revela un problema profundo en la comprensión de la intención del usuario. Quinto, puedes comparar resultados entre distintas simulaciones. Si corres pruebas con diferentes configuraciones, personas o prompts, puedes comparar los resultados para ver cómo afectan los cambios al comportamiento del sistema. Así puedes validar hipótesis sobre qué cambios mejoran la fiabilidad. Por ejemplo, puedes correr una simulación, detectar rechazos excesivos ante ciertos pedidos, modificar el prompt del sistema para ser menos conservador y luego correr otra simulación para ver si el problema se resuelve. Este enfoque iterativo es mucho más efectivo que hacer cambios basados en intuiciones o feedback anecdótico.

La inspiración para el enfoque de Snowglobe proviene de cómo la industria de los vehículos autónomos usa la simulación para lograr fiabilidad a gran escala. Este contexto histórico es importante porque demuestra que las pruebas basadas en simulación no son nuevas ni experimentales—se han perfeccionado durante décadas en uno de los ámbitos más críticos en seguridad. En los coches autónomos, la simulación se volvió esencial porque las pruebas en el mundo real no bastaban para alcanzar la fiabilidad necesaria. Un auto autónomo debe gestionar millones de casos límite y escenarios raros que pueden aparecer solo una vez en millones de millas. Probar solo en la vida real requeriría un tiempo y recursos imprácticos. En su lugar, empresas como Waymo desarrollaron entornos de simulación donde podían probar sus sistemas en miles de millones de millas simuladas. Estas simulaciones incluían no solo condiciones normales, sino también casos límite, escenarios raros, clima adverso, obstáculos inesperados y otras situaciones desafiantes. La escala es impresionante: Waymo realizó unas 20 mil millones de millas de simulación frente a 20 millones en el mundo real. Esta proporción 1000:1 permitió identificar y corregir problemas casi imposibles de detectar solo con pruebas reales. El aprendizaje clave es que la simulación permite cubrir el espacio de escenarios de forma exhaustiva, algo imposible en el mundo real. Lo mismo aplica a agentes y sistemas de IA generativa. El espacio de escenarios para IA conversacional es inmenso—hay formas infinitas en que los usuarios pueden interactuar, formular preguntas, y casos límite. Probar solo con usuarios reales llevaría un tiempo impráctico para descubrir todos los fallos. La simulación permite generar miles o millones de escenarios programáticamente, logrando cobertura exhaustiva. Además, es mucho más barata: correr una simulación cuesta casi nada—es solo computación. Probar en el mundo real requiere reclutar usuarios, gestionar expectativas, soportar las consecuencias de los fallos y, potencialmente, dañar tu reputación si el sistema se comporta mal. Usando simulación, puedes identificar y corregir problemas antes de que impacten a usuarios reales, reduciendo drásticamente el costo y riesgo de desplegar IA. Las lecciones de los autos autónomos también subrayan la importancia de la simulación continua. Waymo no corrió simulaciones una sola vez; las ejecutaba de forma continua al mejorar el sistema, encontrar nuevos casos en la vida real o expandirse a nuevas regiones o condiciones. Este enfoque continuo les permitió mantener y mejorar la fiabilidad. Lo mismo aplica a agentes de IA: la simulación no debe verse como una fase de prueba puntual antes del despliegue, sino integrarse en tu desarrollo continuo. Cada vez que cambies tu sistema, corre simulaciones para verificar mejoras. Si encuentras problemas en producción, agrégalos a tu suite de simulación. Al expandirse a nuevos casos o dominios, ejecuta simulaciones para verificar el funcionamiento fiable en esos nuevos contextos.

Una cuestión práctica que surge al usar simulación a escala es si las personas deben generarse de nuevo para cada simulación o pueden reutilizarse. Esta pregunta toca aspectos importantes de diseño y el equilibrio entre consistencia y diversidad. La respuesta depende de tus metas de prueba y cómo quieras usar la simulación. Si tu objetivo es probar el comportamiento del sistema ante una gran variedad de usuarios y patrones de interacción, generar personas nuevas en cada simulación tiene sentido. Así expones continuamente tu sistema a escenarios diversos, ayudando a identificar casos límite y comportamientos inesperados. Además, previenes el sobreajuste a un grupo fijo de usuarios de prueba—algo que podría suceder si los reutilizas siempre. Por otro lado, si buscas rastrear cómo cambian los resultados a medida que mejoras tu sistema, reutilizar personas es valioso. Al pasar las mismas personas por el sistema antes y después de un cambio, puedes medir directamente si la mejora beneficia o perjudica a esos usuarios. Es similar a las pruebas de regresión en software—mantienes una suite de casos de prueba y los ejecutas repetidamente para asegurar que los cambios no rompan funcionalidades existentes. En la práctica, muchas organizaciones usan un enfoque híbrido: mantienen un grupo base de personas que representan a los usuarios clave para pruebas de regresión y también generan personas nuevas en cada simulación para descubrir continuamente casos límite y comportamientos inesperados. Esta combinación equilibra los beneficios de la consistencia y la diversidad, permitiendo tanto rastrear mejoras como descubrir nuevos problemas. La flexibilidad para elegir entre personas nuevas o reutilizadas es una de las ventajas de la simulación—puedes adaptar la estrategia al proceso de desarrollo y tus necesidades específicas.

Para organizaciones que construyen flujos de trabajo y agentes de IA, integrar pruebas de simulación en el desarrollo es mucho más potente al combinarlo con plataformas de automatización como FlowHunt. FlowHunt te permite automatizar todo el ciclo de vida del desarrollo de agentes de IA, desde el diseño inicial hasta las pruebas, el despliegue y el monitoreo. Al integrar las capacidades de simulación de Snowglobe con la automatización de FlowHunt, puedes crear un sistema integral para construir agentes de IA fiables a escala. La integración funciona a varios niveles. Primero, FlowHunt puede automatizar la configuración y ejecución de simulaciones. En vez de configurarlas manualmente, puedes definir flujos de simulación que se ejecuten automáticamente cada vez que realices cambios en tu sistema de IA. Así, cada cambio se valida por simulación antes de llegar a producción. Segundo, FlowHunt puede automatizar el análisis de resultados. En vez de revisar manualmente miles de interacciones, puedes definir flujos de análisis automáticos que extraigan métricas clave, identifiquen patrones de fallo y generen informes. Estos análisis pueden disparar alertas si la fiabilidad cae por debajo del umbral aceptable, permitiéndote detectar problemas de inmediato. Tercero, FlowHunt puede automatizar la iteración del sistema en base a resultados. Si una simulación revela rechazos excesivos, puedes definir un flujo que ajuste automáticamente el prompt del sistema, reejecute la simulación y compare resultados. Este proceso iterativo puede automatizarse en gran medida, acelerando la mejora de la fiabilidad. Cuarto, FlowHunt puede integrar las pruebas de simulación en tu pipeline de desarrollo de IA. En vez de tratar la simulación como una fase separada, puedes integrarla en el desarrollo continuo. Cada vez que cambies el sistema—ya sea actualizando el prompt, agregando herramientas o modificando el pipeline RAG—puedes correr simulaciones automáticamente para verificar mejoras. Este enfoque continuo asegura que la fiabilidad se mantenga a medida que evoluciona el sistema. La combinación de la simulación de Snowglobe y la automatización de FlowHunt crea una plataforma poderosa para construir agentes de IA fiables. Las organizaciones pueden ir más allá de las pruebas manuales y la garantía de calidad ad-hoc hacia un enfoque sistemático y automatizado para garantizar el buen comportamiento en producción.

Snowglobe representa un cambio fundamental en la forma en que las organizaciones abordan la fiabilidad de la IA, pasando de marcos genéricos de seguridad a pruebas basadas en simulación que identifican los modos de fallo relevantes para tu producto. Al generar miles de interacciones simuladas diversas y observar cómo responde tu sistema de IA, puedes identificar problemas antes de que lleguen a usuarios reales, comprender dónde falla tu sistema y realizar mejoras específicas para aumentar la fiabilidad. El enfoque se basa en décadas de experiencia en la industria de vehículos autónomos, donde la simulación resultó esencial para lograr la fiabilidad necesaria en sistemas críticos para la seguridad. Para organizaciones que construyen agentes de IA, chatbots y otras aplicaciones generativas, integrar la simulación en el proceso de desarrollo ya no es opcional—es esencial para competir en un mercado donde la fiabilidad y la experiencia de usuario son diferenciadores clave. Combinando pruebas de simulación con plataformas de automatización como FlowHunt, puedes crear un sistema integral para construir, probar y mejorar continuamente agentes de IA a escala.

Snowglobe es un motor de simulación que te permite probar cómo interactuarán los usuarios con tus productos de IA antes de ponerlos en producción. Genera interacciones simuladas de usuarios basadas en la descripción de tu sistema de IA, permitiéndote identificar posibles fallos y comportamientos inesperados antes de que los usuarios reales los experimenten.

Mientras que los benchmarks tradicionales como NIST AIMF se centran en métricas generales de seguridad como toxicidad y alucinación, Snowglobe se enfoca en KPIs específicos del producto y problemas a nivel de implementación. Ayuda a identificar problemas propios de tu caso de uso, como rechazos excesivos en agentes de soporte al cliente o desalineación en el estilo de comunicación.

Sí, Snowglobe puede conectarse a tu base de conocimiento y analizarla automáticamente por diferentes temas. Luego genera preguntas que requieren que tu agente consulte la base de conocimiento para responder, garantizando una cobertura programática de toda tu base.

Puedes ejecutar simulaciones de usuarios generales, simulaciones temáticas (como usuarios preguntando sobre promociones), pruebas de comportamiento (como intentos de jailbreak) y pruebas centradas en seguridad. También puedes configurar el número de personas, la longitud de la conversación y los riesgos específicos a probar.

Arshia es ingeniera de flujos de trabajo de IA en FlowHunt. Con formación en ciencias de la computación y una pasión por la IA, se especializa en crear flujos de trabajo eficientes que integran herramientas de IA en las tareas cotidianas, mejorando la productividad y la creatividad.

Optimiza el desarrollo de agentes de IA con flujos de trabajo inteligentes de simulación y pruebas impulsados por la plataforma de automatización de FlowHunt.

Aprende estrategias completas para probar chatbots de IA, incluyendo pruebas funcionales, de rendimiento, seguridad y usabilidad. Descubre mejores prácticas, he...

FlowHunt permite la automatización de IA sin esfuerzo con una plataforma sin código, empoderando a los usuarios para crear herramientas personalizadas. Fundada ...

Guía completa de las mejores plataformas para crear agentes de IA en 2025, destacando FlowHunt.io, OpenAI y Google Cloud. Descubre reseñas detalladas, clasifica...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.