¿Cómo transformar la creación de contenido con la generación de video Wan 2.2 y 2.5?

FlowHunt ahora es compatible con los modelos de generación de video Wan 2.2 y 2.5 para texto a video, imagen a video, reemplazo de persona y animación. Transfor...

Wan 2.1 es un potente modelo de generación de video con IA de código abierto de Alibaba, que produce videos de calidad de estudio a partir de texto o imágenes, libre para que todos lo usen localmente.

Wan 2.1 (también llamado WanX 2.1) está abriendo nuevos caminos como un modelo de generación de video con IA completamente de código abierto desarrollado por el Tongyi Lab de Alibaba. A diferencia de muchos sistemas propietarios de generación de video que requieren suscripciones costosas o acceso vía API, Wan 2.1 ofrece una calidad comparable o superior, manteniéndose completamente libre y accesible para desarrolladores, investigadores y profesionales creativos.

Lo que realmente hace especial a Wan 2.1 es su combinación de accesibilidad y rendimiento. La variante más pequeña T2V-1.3B requiere solo ~8.2 GB de memoria GPU, lo que la hace compatible con la mayoría de GPUs de consumo modernas. Mientras tanto, la versión más grande de 14B parámetros ofrece un rendimiento de última generación que supera tanto a las alternativas de código abierto como a muchos modelos comerciales en benchmarks estándar.

Wan 2.1 no se limita solo a la generación de texto a video. Su arquitectura versátil admite:

Esta flexibilidad significa que puedes comenzar con una indicación de texto, una imagen fija o incluso un video existente y transformarlo según tu visión creativa.

Como el primer modelo de video capaz de renderizar texto legible en inglés y chino dentro de los videos generados, Wan 2.1 abre nuevas posibilidades para creadores de contenido internacional. Esta función es especialmente valiosa para crear subtítulos o texto en escenas en videos multilingües.

En el núcleo de la eficiencia de Wan 2.1 está su AutoCodificador Variacional de Video causal 3D. Este avance tecnológico comprime eficientemente la información espaciotemporal, permitiendo que el modelo:

El modelo pequeño de 1.3B requiere solo 8.19 GB de VRAM y puede producir un video de 5 segundos a 480p en aproximadamente 4 minutos en una RTX 4090. A pesar de esta eficiencia, su calidad rivaliza o supera la de modelos mucho más grandes, logrando el equilibrio perfecto entre velocidad y fidelidad visual.

En evaluaciones públicas, Wan 14B logró la puntuación más alta en las pruebas Wan-Bench, superando a competidores en:

A diferencia de sistemas de código cerrado como Sora de OpenAI o Gen-2 de Runway, Wan 2.1 está disponible libremente para ejecutarse localmente. Generalmente supera a modelos de código abierto anteriores (como CogVideo, MAKE-A-VIDEO y Pika) e incluso a muchas soluciones comerciales en los benchmarks de calidad.

Una encuesta reciente de la industria señaló que “entre muchos modelos de video con IA, Wan 2.1 y Sora destacan”: Wan 2.1 por su apertura y eficiencia, y Sora por su innovación propietaria. En pruebas comunitarias, los usuarios han reportado que la capacidad de imagen a video de Wan 2.1 supera a la competencia en claridad y sensación cinematográfica.

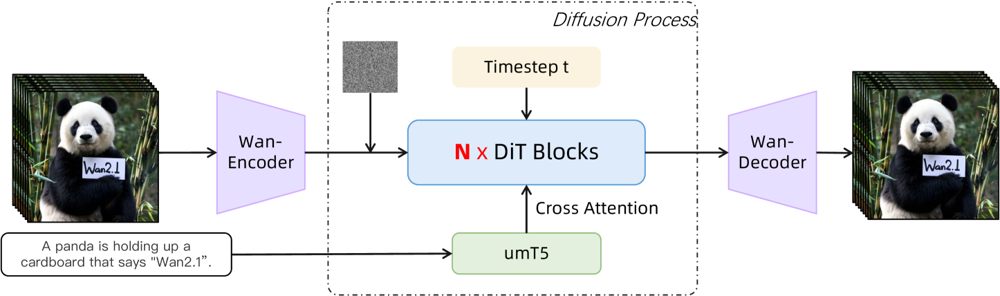

Wan 2.1 se basa en una columna vertebral de difusor-transformer con un novedoso VAE espaciotemporal. Así es como funciona:

Figura: Arquitectura de alto nivel de Wan 2.1 (caso de texto a video). Un video (o imagen) es primero codificado por el codificador Wan-VAE en un latente. Este latente luego pasa por N bloques de transformer de difusión, los cuales atienden a la incrustación de texto (de umT5) mediante cross-attention. Finalmente, el decodificador Wan-VAE reconstruye los fotogramas del video. Este diseño – que presenta un “codificador/decodificador VAE causal 3D rodeando un transformer de difusión” (ar5iv.org ) – permite una compresión eficiente de los datos espaciotemporales y soporta salidas de video de alta calidad.

Esta innovadora arquitectura—que presenta un “codificador/decodificador VAE causal 3D rodeando un transformer de difusión”—permite una compresión eficiente de los datos espaciotemporales y soporta salidas de video de alta calidad.

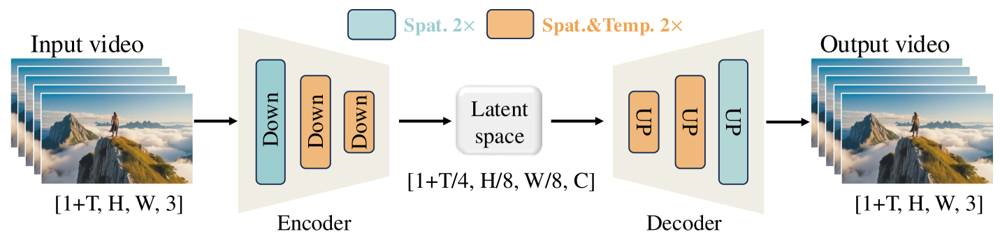

El Wan-VAE está especialmente diseñado para videos. Comprime la entrada por factores impresionantes (temporal 4× y espacial 8×) en un latente compacto antes de decodificarlo de nuevo a video completo. El uso de convoluciones 3D y capas causales (que preservan el tiempo) asegura movimiento coherente en todo el contenido generado.

Figura: Framework Wan-VAE de Wan 2.1 (codificador-decodificador). El codificador Wan-VAE (izquierda) aplica una serie de capas de reducción (“Down”) al video de entrada (forma [1+T, H, W, 3] fotogramas) hasta que llega a un latente compacto ([1+T/4, H/8, W/8, C]). El decodificador Wan-VAE (derecha) realiza un upsampling simétrico (“UP”) de este latente de vuelta a los fotogramas originales. Los bloques azules indican compresión espacial y los naranjas, compresión combinada espacial+temporal (ar5iv.org

). Al comprimir el video por 256× (en volumen espaciotemporal), Wan-VAE hace factible el modelado de video en alta resolución para el modelo de difusión subsecuente.

¿Listo para probar Wan 2.1 tú mismo? Así es como puedes empezar:

Clona el repositorio e instala las dependencias:

git clone https://github.com/Wan-Video/Wan2.1.git

cd Wan2.1

pip install -r requirements.txt

Descarga los pesos del modelo:

pip install "huggingface_hub[cli]"

huggingface-cli login

huggingface-cli download Wan-AI/Wan2.1-T2V-14B --local-dir ./Wan2.1-T2V-14B

Genera tu primer video:

python generate.py --task t2v-14B --size 1280*720 \

--ckpt_dir ./Wan2.1-T2V-14B \

--prompt "A futuristic city skyline at sunset, with flying cars zooming overhead."

--offload_model True --t5_cpu para descargar partes del modelo a la CPU--size (por ejemplo, 832*480 para 16:9 480p)Como referencia, una RTX 4090 puede generar un video de 5 segundos a 480p en unos 4 minutos. Se admiten configuraciones multi-GPU y diversas optimizaciones de rendimiento (FSDP, cuantización, etc.) para uso a gran escala.

Como una potencia de código abierto que desafía a los gigantes en la generación de video con IA, Wan 2.1 representa un cambio significativo en accesibilidad. Su naturaleza libre y abierta significa que cualquiera con una GPU decente puede explorar la generación de video de vanguardia sin cuotas de suscripción ni costes de API.

Para los desarrolladores, la licencia de código abierto permite personalizar y mejorar el modelo. Los investigadores pueden ampliar sus capacidades, mientras que los profesionales creativos pueden prototipar contenido de video rápida y eficientemente.

En una era en la que los modelos de IA propietarios están cada vez más encerrados tras muros de pago, Wan 2.1 demuestra que el rendimiento de última generación puede democratizarse y compartirse con la comunidad en general.

Wan 2.1 es un modelo de generación de video con IA completamente de código abierto desarrollado por el Tongyi Lab de Alibaba, capaz de crear videos de alta calidad a partir de indicaciones de texto, imágenes o videos existentes. Es gratuito, admite múltiples tareas y funciona eficientemente en GPUs de consumo.

Wan 2.1 admite generación de video multitarea (texto a video, imagen a video, edición de video, etc.), renderizado de texto multilingüe en videos, alta eficiencia con su Video VAE causal 3D, y supera a muchos modelos comerciales y de código abierto en benchmarks.

Necesitas Python 3.8+, PyTorch 2.4.0+ con CUDA y una GPU NVIDIA (8GB+ de VRAM para el modelo pequeño, 16-24GB para el modelo grande). Clona el repositorio de GitHub, instala las dependencias, descarga los pesos del modelo y utiliza los scripts proporcionados para generar videos localmente.

Wan 2.1 democratiza el acceso a la generación de video de última generación al ser de código abierto y gratuito, permitiendo a desarrolladores, investigadores y creativos experimentar e innovar sin muros de pago ni restricciones propietarias.

A diferencia de alternativas de código cerrado como Sora o Runway Gen-2, Wan 2.1 es completamente de código abierto y se puede ejecutar localmente. Generalmente supera a modelos de código abierto anteriores y iguala o supera a muchas soluciones comerciales en benchmarks de calidad.

Arshia es ingeniera de flujos de trabajo de IA en FlowHunt. Con formación en ciencias de la computación y una pasión por la IA, se especializa en crear flujos de trabajo eficientes que integran herramientas de IA en las tareas cotidianas, mejorando la productividad y la creatividad.

Empieza a crear tus propias herramientas de IA y flujos de trabajo de generación de video con FlowHunt o agenda una demo para ver la plataforma en acción.

FlowHunt ahora es compatible con los modelos de generación de video Wan 2.2 y 2.5 para texto a video, imagen a video, reemplazo de persona y animación. Transfor...

Explora las revolucionarias capacidades de Sora 2 en la generación de video con IA, desde la recreación realista de personajes hasta la simulación física, y des...

Explora las capacidades revolucionarias de Sora 2 en la generación de video con IA, desde la recreación realista de personajes hasta la simulación de física, y ...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.