Cómo construir un chatbot de IA: Guía completa paso a paso

Aprenda cómo crear un chatbot de IA desde cero con nuestra guía integral. Descubra las mejores herramientas, marcos y procesos paso a paso para crear sistemas i...

Descubre cómo los chatbots de IA procesan el lenguaje natural, comprenden la intención del usuario y generan respuestas inteligentes. Aprende sobre PLN, aprendizaje automático y arquitectura de chatbots con profundidad técnica.

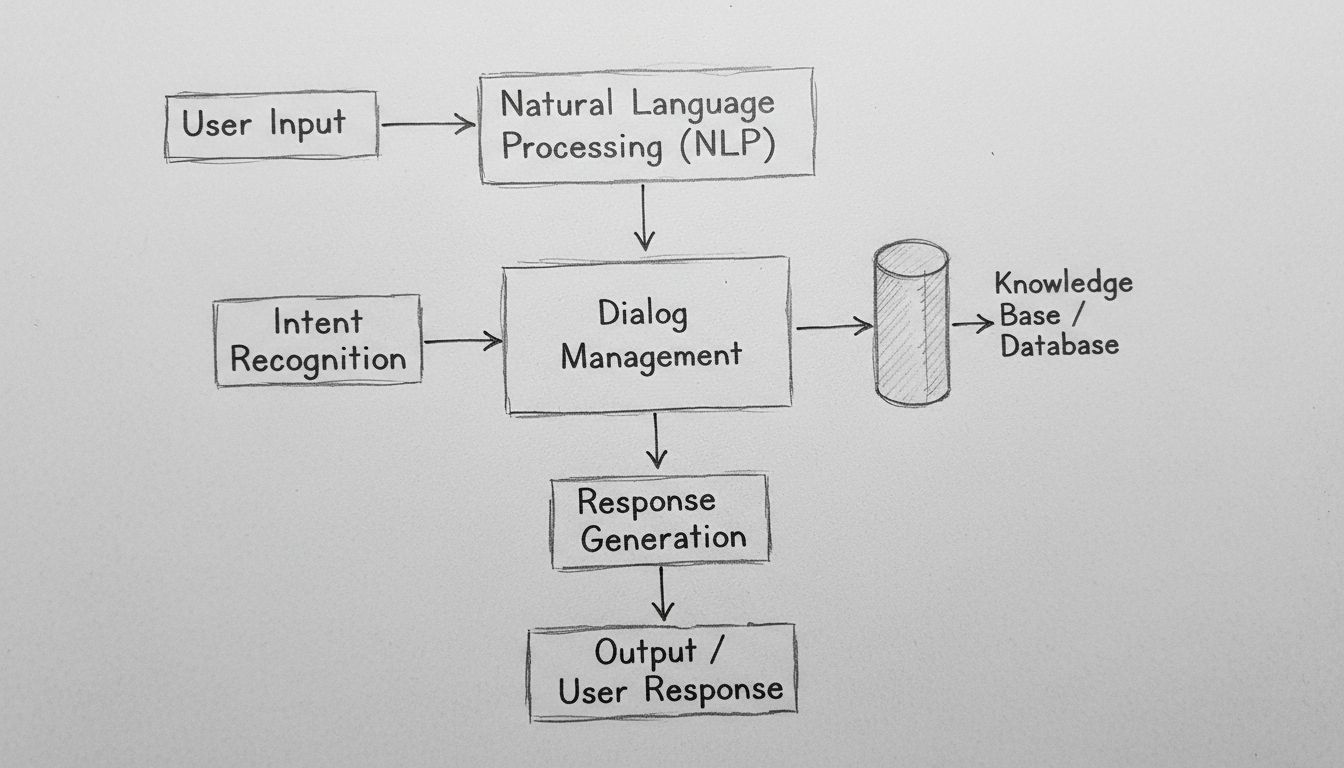

Los chatbots de IA funcionan procesando la entrada en lenguaje natural mediante algoritmos de PLN, reconociendo la intención del usuario, accediendo a bases de conocimiento y generando respuestas contextualmente relevantes utilizando modelos de aprendizaje automático. Los chatbots modernos combinan tokenización, extracción de entidades, gestión de diálogos y redes neuronales para simular conversaciones humanas a escala.

Los chatbots de IA representan una sofisticada convergencia de procesamiento de lenguaje natural, aprendizaje automático y sistemas de gestión de diálogos que trabajan en conjunto para simular la conversación humana. Cuando interactúas con un chatbot moderno de IA, te estás comunicando con un sistema tecnológico multinivel que procesa tu entrada a través de varias etapas distintas antes de entregar una respuesta. La arquitectura que sustenta estos sistemas ha evolucionado dramáticamente, pasando de simples árboles de decisión basados en reglas a complejas redes neuronales capaces de comprender el contexto, los matices e incluso el sentimiento. Entender cómo funcionan estos sistemas requiere examinar cada componente del pipeline y reconocer cómo interactúan para crear experiencias conversacionales fluidas.

El recorrido de cualquier mensaje de usuario a través de un chatbot de IA comienza con el procesamiento de entrada, una fase crítica que transforma el texto en bruto en datos estructurados que el sistema puede analizar. Cuando escribes un mensaje como “Necesito restablecer mi contraseña”, el chatbot no comprende tu intención de inmediato; primero debe descomponer tu mensaje en componentes manejables. Este proceso, llamado tokenización, divide tu oración en palabras individuales o unidades significativas llamadas tokens. El sistema convierte “Necesito restablecer mi contraseña” en tokens: [“Necesito”, “restablecer”, “mi”, “contraseña”]. Este paso aparentemente simple es fundamental porque permite al chatbot analizar cada elemento lingüístico de forma independiente mientras mantiene la conciencia de sus relaciones dentro de la estructura de la oración.

Después de la tokenización, el sistema aplica la normalización, que estandariza el texto convirtiéndolo a minúsculas, eliminando la puntuación y corrigiendo variaciones comunes de ortografía. Esto asegura que “Restablecer Contraseña”, “restablecer contraseña” y “reseteo de contraseña” sean reconocidos como el mismo concepto. El chatbot también elimina las palabras vacías—palabras comunes como “el”, “es”, “y” y “a” que tienen poco significado semántico. Al filtrarlas, el sistema enfoca los recursos computacionales en las palabras que realmente transmiten significado. Además, el sistema realiza etiquetado de partes de la oración, identificando si cada palabra funciona como sustantivo, verbo, adjetivo u otra categoría gramatical. Esta comprensión gramatical ayuda al chatbot a reconocer que “restablecer” es un verbo de acción en tu mensaje, lo cual es crucial para determinar lo que realmente deseas lograr.

El Procesamiento de Lenguaje Natural (PLN) representa la base tecnológica que permite a los chatbots comprender el lenguaje humano a nivel semántico. El PLN abarca múltiples técnicas interconectadas que trabajan juntas para extraer significado del texto. El Reconocimiento de Entidades Nombradas (NER) identifica entidades específicas en tu mensaje—nombres propios, fechas, ubicaciones, nombres de productos y otra información relevante. En el ejemplo de restablecimiento de contraseña, el NER identificaría “contraseña” como una entidad del sistema relevante para la base de conocimiento del chatbot. Esta capacidad se vuelve aún más poderosa en escenarios complejos: si escribes “Quiero reservar un vuelo de Madrid a Londres el 15 de diciembre”, el NER extrae la ciudad de origen, el destino y la fecha—toda información crítica para cumplir tu solicitud.

El análisis de sentimiento es otro componente crucial del PLN, permitiendo a los chatbots detectar el tono emocional subyacente de tu mensaje. Un cliente que dice “Llevo esperando tres horas y aún no he recibido mi pedido” expresa frustración, que el chatbot debería reconocer para ajustar el tono de su respuesta y priorizar el asunto adecuadamente. El análisis de sentimiento moderno utiliza modelos de aprendizaje automático entrenados con miles de ejemplos para clasificar el texto como positivo, negativo o neutral, y cada vez más, para detectar emociones más matizadas como frustración, confusión o satisfacción. Esta inteligencia emocional permite a los chatbots responder con empatía y urgencia apropiadas, mejorando significativamente los índices de satisfacción del cliente.

Tras procesar el texto en bruto, el chatbot debe determinar qué es lo que realmente quiere el usuario—su intención. El reconocimiento de intención es una de las funciones más críticas en la arquitectura de chatbots porque conecta lo que los usuarios dicen con lo que desean lograr. El sistema utiliza clasificadores de aprendizaje automático entrenados con miles de conversaciones de ejemplo para mapear las expresiones de los usuarios a intenciones predefinidas. Por ejemplo, las frases “Olvidé mi contraseña”, “¿Cómo restablezco mi contraseña?”, “No puedo iniciar sesión” y “Mi cuenta está bloqueada” podrían mapearse todas a la misma intención de “restablecimiento_contraseña”, aunque estén formuladas de maneras distintas.

Simultáneamente, el sistema realiza la extracción de entidades, identificando datos específicos dentro del mensaje del usuario que son relevantes para cumplir su solicitud. Si un cliente dice “Quiero actualizar mi plan al nivel premium”, el sistema extrae dos entidades clave: la acción (“actualizar”) y el objetivo (“nivel premium”). Estas entidades extraídas se convierten en parámetros que guían la generación de la respuesta del chatbot. Los chatbots avanzados utilizan análisis de dependencias para comprender las relaciones gramaticales entre palabras, reconociendo qué sustantivos son sujetos, cuáles son objetos y cómo se relacionan con verbos y modificadores. Esta comprensión sintáctica profunda permite al chatbot manejar oraciones complejas y frases ambiguas que confundirían a sistemas más simples.

La gestión de diálogo representa el “cerebro” del chatbot, responsable de mantener el contexto de la conversación y determinar las respuestas apropiadas. A diferencia de los sistemas simples de búsqueda, los gestores de diálogo sofisticados mantienen un estado conversacional que rastrea lo que se ha hablado, la información recopilada y el objetivo actual del usuario. Esta conciencia contextual permite conversaciones naturales y fluidas donde el chatbot recuerda intercambios previos y puede referenciarlos adecuadamente. Si preguntas “¿Cuál es el clima en Londres?” y luego sigues con “¿Y mañana?”, el gestor de diálogo entiende que “mañana” se refiere al pronóstico de Londres, no de otra ubicación.

El gestor de diálogo implementa la gestión de contexto almacenando la información relevante en un formato estructurado a lo largo de la conversación. Esto puede incluir la información de la cuenta del usuario, sus solicitudes previas, sus preferencias y el tema actual de conversación. Los sistemas avanzados utilizan máquinas de estados o redes jerárquicas de tareas para modelar los flujos conversacionales, definiendo qué estados son alcanzables desde otros y qué transiciones son válidas. Por ejemplo, un chatbot de atención al cliente puede tener estados para “saludo”, “identificación de problema”, “resolución de problemas”, “escalado” y “resolución”. El gestor de diálogo asegura que la conversación progrese lógicamente a través de estos estados en lugar de saltar aleatoriamente entre ellos.

Los chatbots de IA modernos no generan respuestas únicamente a partir de sus datos de entrenamiento; acceden a bases de conocimiento que contienen información actual y precisa específica de la organización. Esta integración es fundamental para mantener la precisión y relevancia. Cuando un cliente pregunta “¿Cuál es el saldo de mi cuenta?”, el chatbot debe consultar el sistema bancario real para recuperar el saldo actual, en lugar de generar un número plausible. De manera similar, al preguntar “¿Cuáles son los horarios de su tienda?”, el chatbot accede a la base de datos de información comercial para brindar horarios precisos y actualizados, en lugar de depender de datos de entrenamiento potencialmente obsoletos.

La Generación aumentada por recuperación (RAG) representa un enfoque sofisticado para la integración de conocimiento que ha cobrado importancia en 2025. Los sistemas RAG primero recuperan documentos o información relevante de una base de conocimiento en función de la consulta del usuario y luego usan esa información para generar una respuesta contextual apropiada. Este proceso en dos etapas mejora drásticamente la precisión en comparación con los enfoques de generación pura. Por ejemplo, si un cliente pregunta sobre una característica específica de un producto, el sistema RAG recupera la documentación del producto, extrae la sección relevante y genera una respuesta fundamentada en esa documentación real, en lugar de confiar en información potencialmente alucinada. Este enfoque ha resultado especialmente valioso en entornos empresariales donde la exactitud y el cumplimiento son primordiales.

Después de comprender la intención del usuario y reunir la información necesaria, el chatbot debe generar una respuesta apropiada. La generación de respuestas puede seguir varios enfoques distintos, cada uno con ventajas y limitaciones. La generación basada en plantillas utiliza respuestas prediseñadas con espacios variables que se completan con información específica. Por ejemplo, una plantilla podría ser “Su pedido #[ID_PEDIDO] llegará el [FECHA_ENTREGA].” Este enfoque es muy fiable y predecible, pero limitado en flexibilidad y naturalidad.

La generación basada en reglas aplica reglas lingüísticas específicas para construir respuestas en función de la intención identificada y las entidades extraídas. Estas reglas pueden especificar que, para una intención de “restablecimiento_contraseña”, la respuesta debe incluir un mensaje de confirmación, un enlace a la página de restablecimiento y las instrucciones para los siguientes pasos. Este enfoque ofrece más flexibilidad que las plantillas manteniendo la fiabilidad, aunque requiere una extensa ingeniería de reglas para escenarios complejos.

La generación basada en redes neuronales, impulsada por grandes modelos de lenguaje (LLMs), representa la vanguardia de la tecnología de generación de respuestas. Estos sistemas utilizan arquitecturas de aprendizaje profundo como los Transformers para generar respuestas novedosas y contextualmente apropiadas que suenan notablemente humanas. Los LLM modernos se entrenan con miles de millones de tokens de texto, aprendiendo patrones estadísticos sobre cómo funciona el lenguaje y cómo se relacionan los conceptos. Al generar una respuesta, estos modelos predicen la palabra más probable dada todas las palabras anteriores, repitiendo este proceso para construir frases completas. La ventaja de la generación neuronal es su flexibilidad y naturalidad; la desventaja es que ocasionalmente pueden “alucinar”, generando información plausible pero incorrecta.

El aprendizaje automático representa el mecanismo por el cual los chatbots mejoran con el tiempo. En lugar de ser sistemas estáticos con reglas fijas, los chatbots modernos aprenden de cada interacción, refinando gradualmente su comprensión de patrones lingüísticos e intenciones de usuario. El aprendizaje supervisado implica entrenar al chatbot con ejemplos etiquetados donde humanos han anotado la intención y las entidades correctas para miles de mensajes. El algoritmo de aprendizaje automático aprende a reconocer patrones que distinguen una intención de otra, construyendo progresivamente un modelo que puede clasificar mensajes nuevos y no vistos con alta precisión.

El aprendizaje por refuerzo permite a los chatbots optimizar sus respuestas en función del feedback de los usuarios. Cuando un usuario indica satisfacción con una respuesta (mediante feedback explícito o señales implícitas como continuar la conversación), el sistema refuerza los patrones que condujeron a esa respuesta. Por el contrario, cuando los usuarios expresan insatisfacción o abandonan la conversación, el sistema aprende a evitar patrones similares en el futuro. Este ciclo de retroalimentación crea un círculo virtuoso donde el desempeño del chatbot mejora continuamente. Los sistemas avanzados implementan aprendizaje con humanos en el circuito, donde agentes humanos revisan conversaciones desafiantes y proporcionan correcciones de las que el sistema aprende, acelerando dramáticamente la mejora en comparación con el aprendizaje puramente automatizado.

Los Grandes Modelos de Lenguaje (LLMs) han transformado fundamentalmente las capacidades de los chatbots desde 2023. Estos modelos, entrenados con cientos de miles de millones de tokens de datos de texto, desarrollan una comprensión sofisticada del lenguaje, el contexto y el conocimiento específico de dominio. Modelos como GPT-4, Claude y Gemini pueden mantener conversaciones matizadas, comprender instrucciones complejas y generar respuestas coherentes y apropiadas en una gran variedad de temas. El poder de los LLM proviene de su arquitectura transformer, que utiliza mecanismos de atención para comprender las relaciones entre palabras distantes en una oración, permitiendo al modelo mantener el contexto a lo largo de conversaciones extensas.

Sin embargo, los LLM presentan limitaciones que las organizaciones deben abordar. Pueden alucinar—generando con confianza información falsa que suena plausible. Pueden tener dificultades con información muy reciente que no está presente en sus datos de entrenamiento. Pueden mostrar sesgos presentes en sus datos de entrenamiento. Para abordar estas limitaciones, las organizaciones utilizan cada vez más la adaptación fina para adaptar LLMs de propósito general a dominios específicos y la ingeniería de prompts para guiar a los modelos hacia el comportamiento deseado. El enfoque de FlowHunt para la construcción de chatbots aprovecha estos modelos avanzados mientras proporciona salvaguardas e integración de fuentes de conocimiento para garantizar precisión y fiabilidad.

| Aspecto | Chatbots basados en reglas | Chatbots con IA | Chatbots basados en LLM |

|---|---|---|---|

| Tecnología | Árboles de decisión, coincidencia de patrones | PLN, algoritmos de ML, reconocimiento de intención | Grandes modelos de lenguaje, transformers |

| Flexibilidad | Limitada a reglas predefinidas | Se adapta a variaciones en la redacción | Muy flexible, maneja entradas novedosas |

| Precisión | Alta en escenarios definidos | Buena con entrenamiento adecuado | Excelente pero requiere salvaguardas |

| Aprendizaje | Sin capacidad de aprendizaje | Aprende de interacciones | Aprende de ajuste fino y feedback |

| Riesgo de alucinación | Ninguno | Mínimo | Requiere estrategias de mitigación |

| Tiempo de implementación | Rápido | Moderado | Rápido con plataformas como FlowHunt |

| Mantenimiento | Alto (actualización de reglas) | Moderado | Moderado (actualización de modelo, monitoreo) |

| Costo | Bajo | Moderado | Moderado a alto |

| Mejores casos de uso | Preguntas frecuentes simples, enrutamiento básico | Servicio al cliente, calificación de leads | Razonamiento complejo, generación de contenido |

Los chatbots modernos aprovechan la arquitectura Transformer, un diseño de red neuronal que revolucionó el procesamiento de lenguaje natural. Los transformers utilizan mecanismos de atención que permiten al modelo centrarse en partes relevantes de la entrada al generar cada palabra de la salida. Al procesar “El ejecutivo del banco estaba preocupado por la erosión de la orilla del río”, el mecanismo de atención ayuda al modelo a entender que el primer “banco” se refiere a una institución financiera y el segundo a la orilla de un río, según el contexto. Esta comprensión contextual es muy superior a los enfoques antiguos que procesaban el texto de forma secuencial sin este tipo de conciencia contextual.

La atención multi-cabeza extiende este concepto permitiendo que el modelo atienda a diferentes aspectos de la entrada simultáneamente. Una cabeza de atención puede centrarse en relaciones gramaticales, otra en relaciones semánticas y otra en la estructura discursiva. Este procesamiento en paralelo de distintos fenómenos lingüísticos permite al modelo construir representaciones ricas y matizadas del significado. El mecanismo de codificación posicional en transformers permite al modelo comprender el orden de las palabras a pesar de procesarlas todas en paralelo, una capacidad crucial para entender un lenguaje donde el orden de las palabras tiene significado.

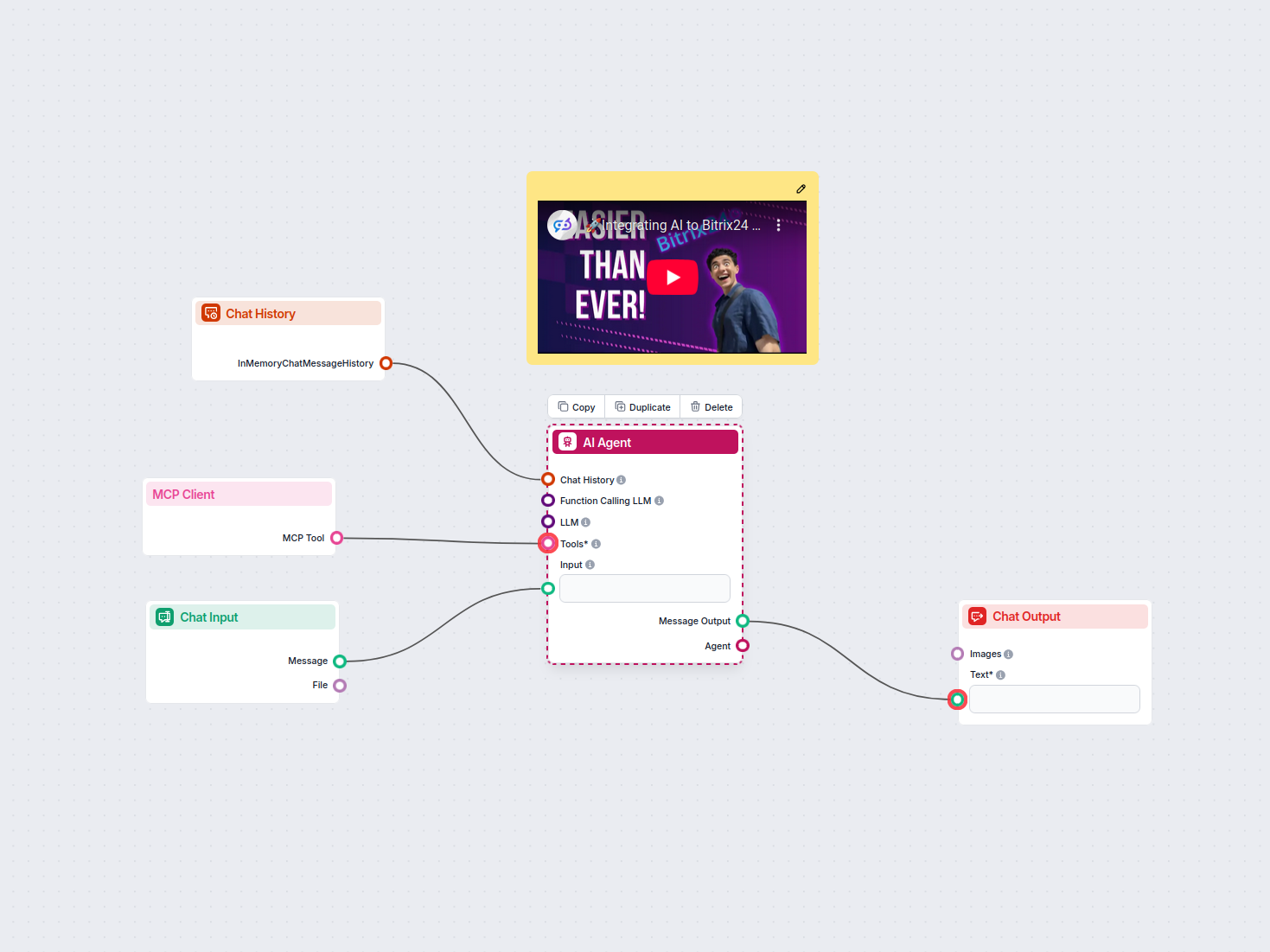

FlowHunt representa un enfoque moderno para el desarrollo de chatbots que abstrae gran parte de la complejidad técnica manteniendo acceso a potentes capacidades de IA. En lugar de requerir que los equipos construyan la infraestructura de chatbots desde cero, FlowHunt proporciona un constructor visual donde usuarios no técnicos pueden diseñar flujos conversacionales conectando componentes que representan diferentes funciones del chatbot. La plataforma gestiona el PLN subyacente, el reconocimiento de intención y la generación de respuestas, permitiendo a los equipos centrarse en diseñar la experiencia conversacional e integrarla con sus sistemas empresariales.

La función de Fuentes de Conocimiento de FlowHunt permite a los chatbots acceder a información en tiempo real desde documentos, sitios web y bases de datos, implementando principios RAG para asegurar la precisión. La capacidad de Agentes de IA de la plataforma permite construir sistemas autónomos que pueden realizar acciones más allá de la conversación—actualizar bases de datos, enviar correos electrónicos, programar citas o activar flujos de trabajo. Esto representa una evolución significativa respecto a los chatbots tradicionales que solo brindan información; los sistemas potenciados por FlowHunt pueden realmente realizar tareas en nombre de los usuarios. Las capacidades de integración de la plataforma conectan los chatbots con sistemas CRM, software de helpdesk y aplicaciones empresariales, permitiendo un flujo de datos y ejecución de acciones sin interrupciones.

El despliegue efectivo de chatbots requiere monitorear métricas clave de rendimiento que indiquen si el sistema está cumpliendo los objetivos empresariales. La precisión en el reconocimiento de intención mide el porcentaje de mensajes de usuario correctamente clasificados en la categoría deseada. La precisión en la extracción de entidades mide si el sistema identifica correctamente los datos relevantes. Los índices de satisfacción del usuario recopilados mediante encuestas post-conversación indican si los usuarios encontraron útil la interacción. La tasa de finalización de conversaciones mide el porcentaje de conversaciones que resultan en la resolución del problema del usuario sin escalamiento a un agente humano.

La latencia de respuesta mide la rapidez con la que el chatbot genera respuestas—crítico para la experiencia del usuario, ya que demoras superiores a unos segundos reducen considerablemente la satisfacción. La tasa de escalado indica el porcentaje de conversaciones que requieren derivación a agentes humanos, siendo las tasas más bajas generalmente indicativas de mejor desempeño del chatbot. El costo por conversación mide la eficiencia económica del chatbot, comparando el costo del procesamiento de IA contra el costo de la atención humana. Las organizaciones deben establecer métricas de referencia antes del despliegue y luego monitorearlas continuamente para identificar oportunidades de mejora y asegurar que el chatbot siga aportando valor a medida que evolucionan los patrones de uso.

Los chatbots manejan con frecuencia información sensible, incluyendo datos personales, información financiera y detalles confidenciales de negocios. La encriptación de datos asegura que la información transmitida entre los usuarios y los sistemas de chatbot esté protegida contra intercepciones. Los mecanismos de autenticación verifican que los usuarios son quienes dicen ser antes de proporcionar acceso a información sensible. Los controles de acceso aseguran que los chatbots solo accedan a los datos específicos necesarios para cumplir su función, siguiendo el principio de menor privilegio. Las organizaciones deben implementar registros de auditoría para mantener un historial de todas las interacciones del chatbot por razones de cumplimiento y seguridad.

Los principios de privacidad por diseño deben guiar el desarrollo de chatbots, garantizando que la recopilación de datos personales se minimice, la retención de datos se limite a los períodos necesarios y los usuarios tengan visibilidad sobre qué datos se recopilan y cómo se usan. El cumplimiento de regulaciones como GDPR, CCPA y requisitos específicos de la industria como HIPAA o PCI-DSS es esencial. Las organizaciones deben realizar evaluaciones de seguridad de sus sistemas de chatbot para identificar vulnerabilidades e implementar las mitigaciones apropiadas. La responsabilidad de la seguridad va más allá de la propia plataforma de chatbot e incluye las bases de conocimiento, integraciones y sistemas backend a los que el chatbot accede.

La evolución de la tecnología de chatbots sigue acelerándose. Los chatbots multimodales que procesan y generan texto, voz, imágenes y vídeo simultáneamente representan la próxima frontera. En lugar de interacciones solo por texto, los usuarios se comunicarán cada vez más con chatbots a través de su modalidad preferida—voz para situaciones manos libres, imágenes para consultas visuales de productos, vídeo para demostraciones complejas. La inteligencia emocional en chatbots avanzará más allá de la simple detección de sentimiento hacia la comprensión matizada de estados emocionales del usuario y respuestas emocionales apropiadas. Los chatbots reconocerán cuándo los usuarios están frustrados, confundidos o satisfechos y ajustarán su estilo de comunicación en consecuencia.

La asistencia proactiva es otra capacidad emergente, donde los chatbots anticipan necesidades del usuario antes de que estos soliciten ayuda de forma explícita. En lugar de esperar a que los clientes hagan preguntas, los chatbots identificarán patrones que indiquen posibles problemas y ofrecerán ayuda proactivamente. La personalización será cada vez más sofisticada, con chatbots que adaptan su estilo de comunicación, recomendaciones y asistencia en función de las preferencias, historial y contexto de cada usuario. La integración con sistemas autónomos permitirá a los chatbots coordinarse con automatización de procesos robóticos, dispositivos IoT y otros sistemas automatizados para realizar tareas complejas que abarcan múltiples sistemas y requieren orquestación.

Comprender cómo funcionan los chatbots de IA revela por qué se han vuelto herramientas empresariales esenciales en todos los sectores. La sofisticada interacción entre procesamiento de lenguaje natural, aprendizaje automático, gestión de diálogos e integración de conocimiento permite a los chatbots gestionar tareas cada vez más complejas manteniendo interacciones naturales y humanas. Las organizaciones que implementan chatbots de manera efectiva—utilizando plataformas como FlowHunt, que abstraen la complejidad técnica manteniendo potentes capacidades—obtienen ventajas competitivas significativas a través de una mayor satisfacción del cliente, reducción de costos operativos y tiempos de respuesta más rápidos.

La tecnología continúa evolucionando rápidamente, con avances en grandes modelos de lenguaje, capacidades multimodales y agentes autónomos que amplían lo que es posible. Las organizaciones deben ver la implementación de chatbots no como un proyecto puntual, sino como una capacidad continua que mejora con el tiempo mediante el aprendizaje, la optimización y el perfeccionamiento constantes. Las implementaciones más exitosas combinan tecnología de IA potente con un diseño conversacional reflexivo, salvaguardas adecuadas para asegurar precisión y seguridad, e integración con sistemas empresariales que permiten a los chatbots tomar acciones significativas. A medida que avanzamos en 2025 y más allá, los chatbots se convertirán cada vez más en la interfaz principal a través de la cual clientes y empleados interactúan con las organizaciones, haciendo que la inversión en esta tecnología sea estratégicamente importante para el éxito empresarial.

Deja de gestionar consultas repetitivas de clientes de forma manual. El creador de chatbots de IA sin código de FlowHunt te permite crear chatbots inteligentes y autónomos que gestionan servicio al cliente, generación de leads y soporte 24/7. Despliega en minutos, no en semanas.

Aprenda cómo crear un chatbot de IA desde cero con nuestra guía integral. Descubra las mejores herramientas, marcos y procesos paso a paso para crear sistemas i...

Aprende a construir un chatbot de IA para Discord con instrucciones paso a paso, métodos de integración de API, manejo de errores, buenas prácticas de seguridad...

Este flujo de trabajo aprovecha un Agente de IA integrado con la Herramienta Cliente MCP para procesar la entrada de chat del usuario, utilizar el historial de ...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.