Aprendizaje Automático

El Aprendizaje Automático (ML) es un subconjunto de la inteligencia artificial (IA) que permite a las máquinas aprender de los datos, identificar patrones, hace...

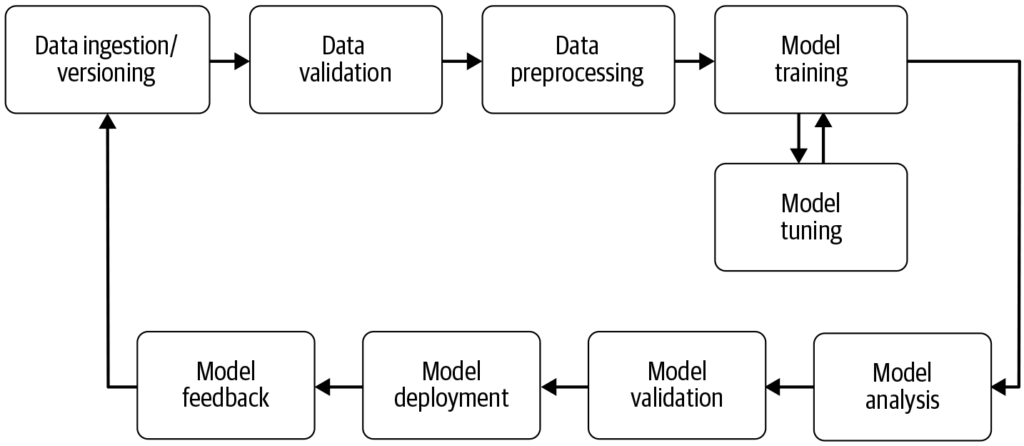

Un pipeline de aprendizaje automático automatiza los pasos desde la recopilación de datos hasta el despliegue del modelo, mejorando la eficiencia, reproducibilidad y escalabilidad en proyectos de aprendizaje automático.

Un pipeline de aprendizaje automático es un flujo de trabajo automatizado que agiliza el desarrollo, entrenamiento, evaluación y despliegue de modelos. Mejora la eficiencia, reproducibilidad y escalabilidad, facilitando tareas desde la recopilación de datos hasta el despliegue y mantenimiento del modelo.

Un pipeline de aprendizaje automático es un flujo de trabajo automatizado que abarca una serie de pasos involucrados en el desarrollo, entrenamiento, evaluación y despliegue de modelos de aprendizaje automático. Está diseñado para agilizar y estandarizar los procesos necesarios para transformar datos sin procesar en conocimientos accionables mediante algoritmos de aprendizaje automático. El enfoque de pipeline permite una gestión eficiente de los datos, el entrenamiento y el despliegue de modelos, facilitando la administración y el escalado de las operaciones de aprendizaje automático.

Fuente: Building Machine Learning

Recopilación de Datos: La etapa inicial donde se obtienen datos de diversas fuentes como bases de datos, APIs o archivos. La recopilación de datos es una práctica metódica orientada a adquirir información significativa para construir un conjunto de datos consistente y completo para un propósito empresarial específico. Estos datos sin procesar son esenciales para construir modelos de aprendizaje automático, pero a menudo requieren preprocesamiento para ser útiles. Como destaca AltexSoft, la recopilación de datos implica la acumulación sistemática de información para respaldar el análisis y la toma de decisiones. Este proceso es crucial, ya que sienta las bases para todos los pasos posteriores en el pipeline y suele ser continuo para asegurar que los modelos se entrenen con datos relevantes y actualizados.

Preprocesamiento de Datos: Los datos sin procesar se limpian y transforman en un formato adecuado para el entrenamiento de modelos. Los pasos comunes de preprocesamiento incluyen el manejo de valores faltantes, codificación de variables categóricas, escalado de características numéricas y división de los datos en conjuntos de entrenamiento y prueba. Esta etapa garantiza que los datos estén en el formato correcto y libres de inconsistencias que puedan afectar el rendimiento del modelo.

Ingeniería de Características: Creación de nuevas características o selección de aquellas relevantes a partir de los datos para mejorar el poder predictivo del modelo. Este paso puede requerir conocimiento y creatividad específicos del dominio. La ingeniería de características es un proceso creativo que transforma los datos sin procesar en características significativas que representan mejor el problema subyacente y aumentan el rendimiento de los modelos de aprendizaje automático.

Selección de Modelos: Se eligen los algoritmos de aprendizaje automático apropiados según el tipo de problema (por ejemplo, clasificación, regresión), las características de los datos y los requisitos de rendimiento. También puede considerarse el ajuste de hiperparámetros en esta etapa. Seleccionar el modelo adecuado es fundamental, ya que influye en la precisión y eficiencia de las predicciones.

Entrenamiento de Modelos: Los modelos seleccionados se entrenan utilizando el conjunto de datos de entrenamiento. Esto implica aprender los patrones y relaciones subyacentes dentro de los datos. También se pueden utilizar modelos preentrenados en lugar de entrenar uno nuevo desde cero. El entrenamiento es un paso vital donde el modelo aprende de los datos para hacer predicciones informadas.

Evaluación de Modelos: Tras el entrenamiento, se evalúa el rendimiento del modelo usando un conjunto de prueba separado o mediante validación cruzada. Las métricas de evaluación dependen del problema específico, pero pueden incluir precisión, exactitud, recall, F1-score, error cuadrático medio, entre otros. Este paso es crucial para asegurar que el modelo funcione bien con datos no vistos.

Despliegue de Modelos: Una vez que se desarrolla y evalúa un modelo satisfactorio, puede desplegarse en un entorno de producción para realizar predicciones sobre datos nuevos y no vistos. El despliegue puede implicar la creación de APIs e integración con otros sistemas. El despliegue es la etapa final del pipeline donde el modelo queda accesible para su uso en el mundo real.

Monitoreo y Mantenimiento: Tras el despliegue, es fundamental monitorear continuamente el rendimiento del modelo y reentrenarlo según sea necesario para adaptarse a los cambios en los patrones de datos, asegurando que permanezca preciso y confiable en contextos reales. Este proceso continuo garantiza que el modelo siga siendo relevante y preciso con el tiempo.

Procesamiento de Lenguaje Natural (PLN): Las tareas de PLN suelen involucrar múltiples pasos repetibles como la ingestión de datos, limpieza de texto, tokenización y análisis de sentimiento. Los pipelines ayudan a modularizar estos pasos, permitiendo modificaciones y actualizaciones sencillas sin afectar otros componentes.

Mantenimiento Predictivo: En industrias como la manufactura, los pipelines pueden usarse para predecir fallos de equipos analizando datos de sensores, permitiendo así un mantenimiento proactivo y reduciendo tiempos de inactividad.

Finanzas: Los pipelines pueden automatizar el procesamiento de datos financieros para detectar fraudes, evaluar riesgos crediticios o predecir precios de acciones, mejorando los procesos de toma de decisiones.

Salud: En el sector salud, los pipelines pueden procesar imágenes médicas o historiales de pacientes para asistir en diagnósticos o predecir resultados, mejorando las estrategias de tratamiento.

Los pipelines de aprendizaje automático son fundamentales para la IA y la automatización](https://www.flowhunt.io#:~:text=automation “Build AI tools and chatbots with FlowHunt’s no-code platform. Explore templates, components, and seamless automation. Book a demo today!”) al proporcionar una estructura organizada para automatizar tareas de aprendizaje automático. En el ámbito de la automatización de IA, los pipelines aseguran que los modelos se entrenen y desplieguen eficientemente, permitiendo que sistemas de IA como [chatbots aprendan y se adapten a nuevos datos sin intervención manual. Esta automatización es crucial para escalar aplicaciones de IA y asegurar que ofrezcan un rendimiento consistente y confiable en diversos dominios. Al aprovechar los pipelines, las organizaciones pueden potenciar sus capacidades de IA y garantizar que sus modelos de aprendizaje automático sigan siendo relevantes y efectivos en entornos cambiantes.

Investigación sobre Pipelines de Aprendizaje Automático

“Deep Pipeline Embeddings for AutoML” de Sebastian Pineda Arango y Josif Grabocka (2023) se centra en los desafíos de optimizar pipelines de aprendizaje automático en el Aprendizaje Automático Automatizado (AutoML). Este artículo introduce una novedosa arquitectura neuronal diseñada para capturar interacciones profundas entre los componentes del pipeline. Los autores proponen incrustar los pipelines en representaciones latentes a través de un mecanismo único de codificador por componente. Estas incrustaciones se utilizan dentro de un marco de Optimización Bayesiana para buscar pipelines óptimos. El artículo enfatiza el uso de meta-aprendizaje para afinar los parámetros de la red de incrustación del pipeline, demostrando resultados de vanguardia en optimización de pipelines en múltiples conjuntos de datos. Leer más.

“AVATAR — Machine Learning Pipeline Evaluation Using Surrogate Model” de Tien-Dung Nguyen et al. (2020) aborda la evaluación que consume mucho tiempo de los pipelines de aprendizaje automático durante los procesos de AutoML. El estudio critica métodos tradicionales como las optimizaciones bayesianas y basadas en genética por su ineficiencia. Para contrarrestar esto, los autores presentan AVATAR, un modelo sustituto que evalúa de manera eficiente la validez del pipeline sin ejecución. Este enfoque acelera significativamente la composición y optimización de pipelines complejos al filtrar aquellos inválidos temprano en el proceso. Leer más.

“Data Pricing in Machine Learning Pipelines” de Zicun Cong et al. (2021) explora el papel crucial de los datos en los pipelines de aprendizaje automático y la necesidad de establecer precios para los datos a fin de facilitar la colaboración entre múltiples partes interesadas. El artículo revisa los desarrollos más recientes en la fijación de precios de datos en el contexto del aprendizaje automático, enfocándose en su importancia en varias etapas del pipeline. Ofrece perspectivas sobre estrategias de precios para la recopilación de datos de entrenamiento, el entrenamiento colaborativo de modelos y la entrega de servicios de aprendizaje automático, resaltando la formación de un ecosistema dinámico. Leer más.

Un pipeline de aprendizaje automático es una secuencia automatizada de pasos—desde la recopilación y preprocesamiento de datos hasta el entrenamiento, evaluación y despliegue del modelo—que agiliza y estandariza el proceso de construcción y mantenimiento de modelos de aprendizaje automático.

Los componentes clave incluyen la recopilación de datos, preprocesamiento de datos, ingeniería de características, selección de modelos, entrenamiento de modelos, evaluación de modelos, despliegue de modelos y monitoreo y mantenimiento continuos.

Los pipelines de aprendizaje automático proporcionan modularización, eficiencia, reproducibilidad, escalabilidad, mejor colaboración y una implementación más sencilla de modelos en entornos de producción.

Los casos de uso incluyen procesamiento de lenguaje natural (PLN), mantenimiento predictivo en manufactura, evaluación de riesgos financieros y detección de fraudes, y diagnóstico en el sector salud.

Los desafíos incluyen garantizar la calidad de los datos, gestionar la complejidad del pipeline, integrarse con sistemas existentes y controlar los costos relacionados con recursos computacionales e infraestructura.

Agenda una demo para descubrir cómo FlowHunt puede ayudarte a automatizar y escalar tus flujos de trabajo de aprendizaje automático con facilidad.

El Aprendizaje Automático (ML) es un subconjunto de la inteligencia artificial (IA) que permite a las máquinas aprender de los datos, identificar patrones, hace...

Descubre qué es un pipeline de recuperación para chatbots, sus componentes, casos de uso y cómo la Generación Aumentada por Recuperación (RAG) y fuentes de dato...

MLflow es una plataforma de código abierto diseñada para agilizar y gestionar el ciclo de vida del aprendizaje automático (ML). Proporciona herramientas para el...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.