Introduction

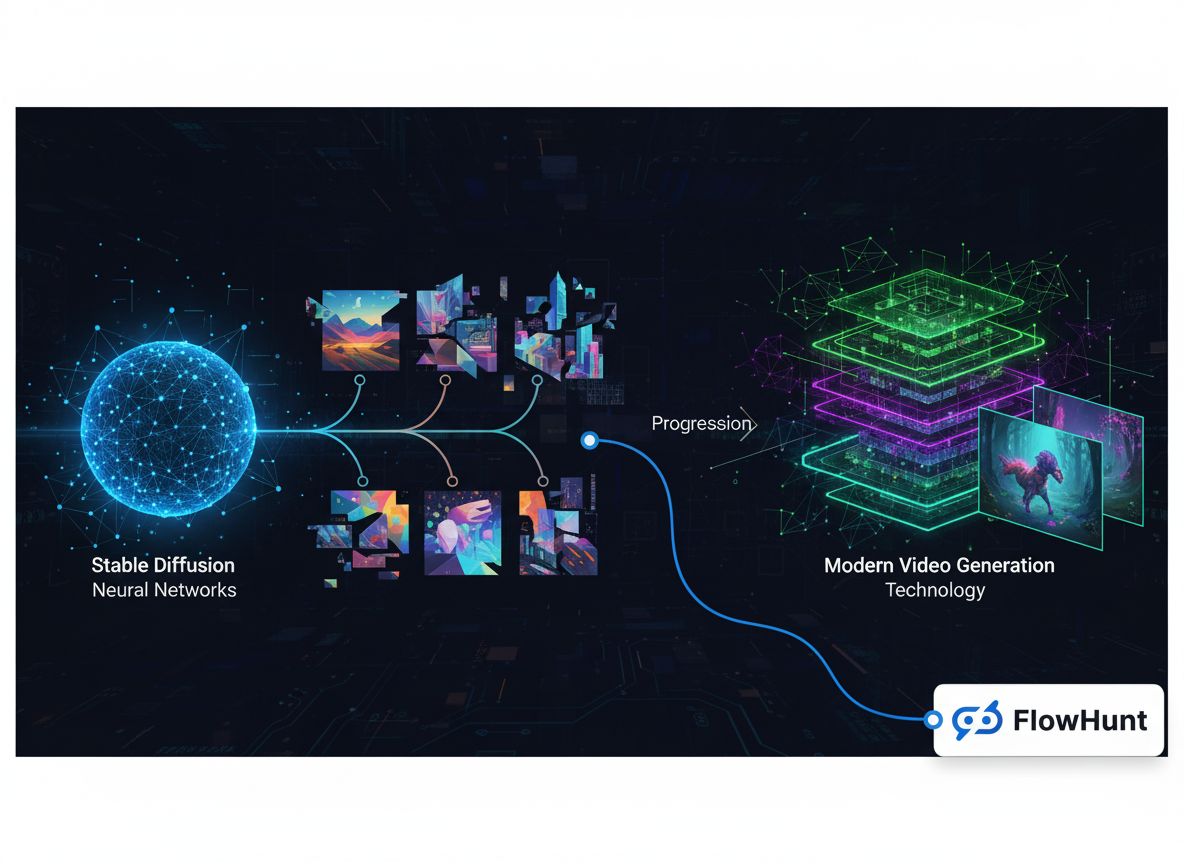

Le paysage des médias génératifs a connu une transformation remarquable ces dernières années, passant de projets de recherche expérimentaux à un marché d’infrastructure valant plusieurs milliards de dollars. Ce qui n’était au départ que des modèles spécialisés de génération d’images s’est étendu à un écosystème complet englobant la synthèse d’images, la création de vidéos, la génération audio et des capacités avancées d’édition. Cette histoire technique explore comment des entreprises comme FAL ont bâti une activité générant plus de 100 millions de dollars de revenus en identifiant une lacune critique du marché : les développeurs avaient besoin d’une infrastructure d’inférence optimisée et évolutive, conçue spécialement pour les modèles de médias génératifs, et non d’une simple orchestration générique de GPU ou d’un hébergement de modèles de langage. Le chemin de Stable Diffusion 1.5 aux modèles vidéo modernes comme Veo3 révèle des leçons essentielles sur le positionnement, la spécialisation technique et les exigences d’infrastructure qui permettent aux applications IA de passer de prototypes de recherche à des systèmes utilisés par des millions de développeurs.

Qu’est-ce que le média génératif et pourquoi c’est important

Les médias génératifs représentent une catégorie fondamentalement différente d’intelligence artificielle par rapport aux grands modèles de langage qui ont récemment fait la une. Tandis que les modèles de langage traitent du texte et génèrent des réponses selon des schémas appris, les systèmes de médias génératifs créent du contenu visuel et audio — images, vidéos, musiques et effets sonores — à partir de descriptions textuelles, d’images existantes ou d’autres modalités d’entrée. Cette distinction n’est pas qu’une question de vocabulaire ; elle reflète des différences profondes en matière d’exigences techniques, de dynamique de marché et d’opportunités business. Les modèles de médias génératifs fonctionnent sous des contraintes informatiques différentes, nécessitent des techniques d’optimisation spécialisées, et servent des cas d’usage qu’une infrastructure classique de modèles de langage ne peut pas gérer efficacement. L’essor des médias génératifs a donné naissance à une toute nouvelle catégorie d’acteurs de l’infrastructure, focalisés spécifiquement sur l’optimisation de l’inférence pour ces modèles, permettant aux développeurs d’intégrer des capacités sophistiquées de génération d’images et vidéos à leurs applications sans gérer de déploiement complexe de GPU ni subir une utilisation inefficace des ressources.

Les exigences techniques pour l’inférence des médias génératifs diffèrent nettement du service de modèles de langage. Les modèles de génération d’images comme Stable Diffusion et Flux fonctionnent via des processus de diffusion itératifs nécessitant une gestion mémoire soigneuse, une optimisation précise du timing et un traitement par lots efficace. La génération vidéo ajoute une couche supplémentaire de complexité, impliquant cohérence temporelle, synchronisation audio et ressources informatiques bien supérieures. Ces besoins ne peuvent être efficacement pris en charge par des plateformes d’orchestration GPU génériques ou des services d’inférence de modèles de langage. Ils requièrent une infrastructure spécialisée, conçue dès le départ pour gérer les caractéristiques uniques des modèles de diffusion, la génération d’images auto-régressive et la synthèse vidéo. Les entreprises ayant identifié ce besoin tôt — et investi dans une infrastructure dédiée — se sont positionnées pour capter des parts de marché substantielles à mesure que l’adoption des médias génératifs s’accélérait dans tous les secteurs.

Prêt à développer votre entreprise?

Commencez votre essai gratuit aujourd'hui et voyez les résultats en quelques jours.

L’intérêt business de la spécialisation : pourquoi les médias génératifs plutôt que les modèles de langage

Le choix de se spécialiser dans les médias génératifs plutôt que de suivre la voie, en apparence plus évidente, de l’hébergement de modèles de langage, représente l’un des choix stratégiques les plus déterminants de l’histoire récente de l’infrastructure IA. Lorsque les fondateurs de FAL ont évalué leurs options vers 2022-2023, ils ont dû trancher : fallait-il élargir leur runtime Python en une plateforme d’inférence généraliste pour modèles de langage, ou s’engager pleinement dans l’espace émergent des médias génératifs ? Leur réponse éclaire la dynamique du marché, le positionnement concurrentiel et l’importance de choisir ses batailles. L’hébergement de modèles de langage, séduisant par l’attention et les financements massifs attirés par les grands modèles, présentait un paysage concurrentiel insurmontable. OpenAI avait déjà imposé GPT comme modèle dominant avec une base d’utilisateurs et des revenus considérables. Anthropic construisait Claude avec des moyens techniques et financiers importants. Google, Microsoft et d’autres géants technologiques investissaient des milliards dans leur propre infrastructure. Pour une start-up, cela aurait signifié affronter des entreprises aux ressources infiniment supérieures, installées sur le marché et capables d’offrir l’accès aux modèles à prix coûtant, voire à perte, pour servir leurs intérêts stratégiques plus larges.

Le marché des médias génératifs, au contraire, présentait une dynamique concurrentielle radicalement différente. Lors de la sortie de Stable Diffusion 1.5 en 2022, un besoin immédiat d’infrastructure d’inférence optimisée s’est fait sentir, mais aucun acteur dominant n’émergeait encore. Le modèle était open source, donc accessible à tous, mais la plupart des développeurs manquaient de l’expertise ou des ressources pour l’optimiser efficacement. C’était l’opportunité idéale pour une entreprise d’infrastructure spécialisée. FAL a compris que les développeurs voulaient utiliser ces modèles sans gérer la complexité du déploiement GPU, de l’optimisation et du passage à l’échelle. En se concentrant exclusivement sur les médias génératifs, FAL pouvait devenir l’expert du domaine, nouer des relations privilégiées avec créateurs de modèles et développeurs, et s’imposer comme la plateforme de référence pour l’inférence de médias génératifs. Cette stratégie de spécialisation s’est révélée extrêmement fructueuse, permettant à FAL de passer d’un pivot à une entreprise servant 2 millions de développeurs et hébergeant plus de 350 modèles, pour des revenus annuels dépassant les 100 millions de dollars.

Comprendre l’infrastructure et l’optimisation des médias génératifs

Les fondations techniques des plateformes modernes de médias génératifs reposent sur une optimisation de l’inférence sophistiquée, bien plus avancée que l’exécution de modèles sur des GPU. Quand les développeurs ont commencé à utiliser Stable Diffusion 1.5, beaucoup ont essayé de le déployer eux-mêmes sur des clouds génériques ou des GPU locaux. Cette approche a révélé des inefficacités majeures : les modèles n’étaient pas optimisés pour le matériel utilisé, la mémoire était gaspillée par des batchs inefficaces, et les taux d’utilisation étaient faibles car chaque workload était isolé. Un développeur pouvait n’utiliser que 20 à 30 % de la capacité de son GPU tout en la payant à 100 %. Ce gâchis ouvrait la voie à une plateforme capable d’agréger la demande, d’optimiser l’inférence pour des configurations matérielles données et d’atteindre des taux d’utilisation bien supérieurs via du batching et du scheduling intelligents. L’approche de FAL a consisté à développer des kernels CUDA personnalisés — du code GPU bas niveau optimisé pour des opérations spécifiques des modèles génératifs — qui amélioraient significativement les performances par rapport aux implémentations génériques.

Le défi d’infrastructure va bien au-delà de l’optimisation des performances. Les modèles de médias génératifs présentent des caractéristiques propres nécessitant une gestion spécialisée. Les modèles de diffusion, qui alimentent la plupart des systèmes de génération d’images, fonctionnent par raffinements successifs du bruit aléatoire en images cohérentes, sur de nombreuses étapes. Chaque étape demande une gestion mémoire minutieuse pour éviter la saturation, et le processus doit être assez rapide pour des applications interactives. La génération vidéo ajoute la dimension temporelle, obligeant les modèles à maintenir la cohérence entre les images tout en produisant du contenu de haute qualité à 24 ou 30 images/seconde. Les modèles audio ont leurs propres exigences, allant du traitement temps réel à la restitution haute-fidélité. Une plateforme couvrant toutes ces modalités doit développer une expertise profonde dans chaque domaine et comprendre les opportunités et contraintes d’optimisation propres à chaque type de modèle. C’est précisément cette spécialisation qui fait la force des plateformes d’infrastructure de médias génératifs : elles accumulent un savoir-faire et des techniques d’optimisation difficilement reproductibles individuellement.

Rejoignez notre newsletter

Recevez gratuitement les derniers conseils, tendances et offres.

L’évolution des modèles de génération d’images : de Stable Diffusion à Flux

L’histoire des médias génératifs se lit à travers l’évolution des modèles de génération d’images, chacun marquant une étape clé du développement du marché. Stable Diffusion 1.5, sorti en 2022, fut le catalyseur qui transforma les médias génératifs d’une curiosité académique en un outil exploitable par les développeurs. Le modèle était open source, relativement efficace par rapport aux modèles antérieurs, et produisait des images de qualité raisonnable pour de nombreux usages. Pour FAL, Stable Diffusion 1.5 fut le déclic : ils commencèrent à proposer une version optimisée et prête à l’emploi via API, que les développeurs pouvaient utiliser sans gérer d’infrastructure GPU. Le succès a été immédiat — les développeurs ont reconnu la valeur de ne plus avoir à gérer la complexité du déploiement, et SD 1.5 est devenu le premier moteur de revenus de FAL. Par ailleurs, tout un écosystème de fine-tuning s’est développé autour du modèle. Les développeurs ont créé des LoRA (Low-Rank Adaptations) — des modifications légères permettant d’adapter le modèle à des styles artistiques, des visages ou des objets spécifiques. Ce cercle vertueux a rendu la plateforme toujours plus attractive, attirant davantage de développeurs et multipliant les possibilités de personnalisation.

Stable Diffusion 2.1, successeur du modèle original, illustre l’importance de la qualité des modèles dans ce marché. Bien que plus avancé techniquement, SD 2.1 a été perçu comme un recul en termes de qualité d’image, notamment pour les visages humains et les scènes complexes. Le modèle n’a pas trouvé son public et nombre de développeurs sont restés sur la version 1.5. Cette expérience a confirmé qu’ici, la qualité de sortie prime sur la sophistication technique : les utilisateurs s’intéressent au résultat, pas à l’architecture ou à la méthode d’entraînement. Stable Diffusion XL (SDXL), lancé en 2023, marqua un véritable bond en avant : meilleure résolution, plus de détails, rendu textuel amélioré. Pour FAL, SDXL fut une révolution — premier modèle à générer 1 million de dollars de revenus, il a aussi dynamisé l’écosystème de fine-tuning, avec des milliers de LoRA créés pour des applications précises. Le succès de SDXL a prouvé qu’il existait une forte demande commerciale pour la génération d’images de haute qualité, validant la stratégie de spécialisation de FAL.

Le lancement des modèles Flux par Black Forest Labs en 2024 fut un autre tournant. Flux fut la première génération à mériter l’appellation de modèle ’exploitable commercialement, prêt pour l’entreprise.’ La qualité était nettement supérieure, la vitesse de génération suffisante pour la production, et les résultats assez constants pour qu’on puisse bâtir des produits dessus. Pour FAL, l’effet fut spectaculaire : les revenus sont passés de 2 millions à 10 millions de dollars le premier mois, puis à 20 millions le mois suivant. Cette progression explosive reflète la demande accumulée pour une génération d’images fiable et de qualité, utilisable en production. Flux existe en plusieurs versions — Schnell (rapide et distillé), Dev (plus qualitatif, licence non commerciale), et Pro (nécessite une collaboration pour l’hébergement) — chacune adaptée à des cas d’usage et des tarifs différents. Le succès de Flux a démontré la maturité du marché et la volonté des entreprises d’investir massivement dans la génération d’images, bien au-delà de la simple expérimentation.

Le passage à la vidéo : un nouveau segment de marché

Si la génération d’images a capté beaucoup d’attention et de revenus, l’émergence de modèles vidéo réellement exploitables a ouvert un nouveau champ d’opportunités. Les premiers modèles texte-vidéo, dont Sora d’OpenAI, ont montré ce qui était possible en théorie, mais restaient soit inaccessibles, soit d’un intérêt limité pour la plupart des usages. Les vidéos étaient souvent muettes, comportaient des incohérences temporelles et manquaient de qualité professionnelle. La sortie de modèles comme Veo3 de Google DeepMind a changé la donne : Veo3 permettait de générer des vidéos avec audio synchronisé, rythme et timing corrects, synchronisation labiale pour les personnages, et une qualité visuelle proche des standards pros. Le modèle était coûteux à faire tourner — bien plus que la génération d’images — mais la qualité justifiait l’investissement pour de nombreux clients.

L’impact de la génération vidéo sur l’activité de FAL a été majeur. Elle a ouvert une nouvelle source de revenus et attiré une clientèle différente. Alors que la génération d’images concernait surtout développeurs, designers et petites équipes créatives, la vidéo a séduit de grandes entreprises désireuses de produire du contenu publicitaire, des vidéos marketing et autres applications professionnelles. FAL s’est associé à plusieurs acteurs de la vidéo, dont One d’Alibaba, Kling de Kuaishou, etc., pour proposer une offre complète. La croissance s’est accélérée à mesure que la vidéo prenait une part croissante de l’utilisation. Les défis techniques posés par la vidéo ont aussi stimulé l’innovation : optimisation spécifique, nouveaux kernels et architectures. Le succès de la vidéo a confirmé la vision de FAL : bâtir une plateforme multi-modalités couvrant image, vidéo et audio, et devenir LA plateforme de médias génératifs.

L’approche de FlowHunt pour les workflows de médias génératifs

Avec la centralisation croissante des médias génératifs dans la création de contenu et le développement applicatif, des plateformes comme FlowHunt sont apparues pour aider développeurs et équipes à gérer la complexité de l’intégration de ces capacités dans leurs workflows. FlowHunt sait que si des plateformes comme FAL ont résolu le défi de l’infrastructure pour faire tourner efficacement ces modèles, les développeurs font encore face à d’importants défis pour orchestrer ces modèles dans des workflows applicatifs plus larges. Une application type inclut plusieurs étapes : réception de la demande, validation, appel à un ou plusieurs modèles génératifs, post-traitement, stockage des résultats, gestion des analytics. FlowHunt propose des outils pour automatiser et optimiser ces workflows, permettant aux développeurs de se concentrer sur la logique métier, pas la gestion de l’infrastructure. En s’intégrant à FAL, FlowHunt permet de construire des applications sophistiquées de médias génératifs sans gérer la complexité sous-jacente du service de modèles, de l’optimisation et du passage à l’échelle.

L’approche de FlowHunt pour les workflows met l’accent sur l’automatisation, la fiabilité et l’observabilité. La plateforme permet de définir des workflows enchaînant plusieurs opérations de médias génératifs, de gérer les erreurs de façon robuste, et d’offrir une visibilité sur chaque étape. Par exemple, un workflow de création de contenu peut générer plusieurs variantes d’image, sélectionner la meilleure selon des métriques de qualité, appliquer des effets, puis publier le résultat. FlowHunt permet de définir tout cela de façon déclarative, avec relances automatiques, gestion des erreurs et monitoring. Cette couche d’abstraction est précieuse pour les équipes qui produisent du contenu à grande échelle. En gérant l’orchestration, FlowHunt laisse les développeurs se concentrer sur la créativité et la logique business, tandis que la plateforme gère la complexité technique de la coordination des opérations génératives.

La croissance remarquable de FAL et la qualité de service reposent sur une optimisation technique sophistiquée, invisible pour la plupart des utilisateurs. La plateforme a développé plus de 100 kernels CUDA personnalisés — du code GPU spécialisé, écrit en langage CUDA de NVIDIA — qui optimisent des opérations spécifiques des modèles génératifs. Ces kernels représentent des milliers d’heures d’ingénierie pour extraire le maximum des GPU. L’enjeu est simple : chaque milliseconde gagnée améliore l’expérience utilisateur et réduit les coûts d’infrastructure. Un modèle générant une image 20 % plus vite permet d’exploiter 20 % d’utilisateurs supplémentaires sur le même GPU, améliorant directement l’économie de la plateforme. Mais écrire de tels kernels est un défi : la programmation CUDA exige une connaissance fine de l’architecture GPU, des hiérarchies mémoire et du calcul parallèle. Ce n’est ni rapide à apprendre, ni généralisable : chaque kernel doit être finement adapté à chaque opération et matériel.

L’optimisation commence par le profiling — identifier où le temps s’écoule vraiment dans l’exécution du modèle. Beaucoup pensent que les opérations les plus coûteuses sont le goulet d’étranglement, mais le profiling réserve souvent des surprises : parfois, c’est le transfert de données mémoire, parfois le lancement trop fréquent de petites opérations GPU. Les ingénieurs de FAL profilent en profondeur, identifient les vrais points bloquants et écrivent des kernels personnalisés pour les résoudre : fusion d’opérations pour réduire le trafic mémoire, kernels adaptés aux dimensions et types de données spécifiques à chaque modèle. Ce niveau d’optimisation n’est rentable qu’à grande échelle — l’investissement se justifie par l’efficacité et la réduction des coûts.

Au-delà de l’optimisation micro, FAL a investi dans l’architecture du service de modèles : quantification (réduire la précision pour économiser mémoire et calcul), batching dynamique (regrouper les requêtes pour mieux exploiter le GPU), priorisation des requêtes (donner la priorité à la latence sur le débit selon le cas). Chaque technique doit être soigneusement implémentée pour maintenir la qualité. Par exemple, la quantification peut réduire la taille du modèle et accélérer l’exécution, mais si elle est mal faite, elle dégrade la qualité de sortie. Les équipes de FAL ont développé des stratégies avancées qui conservent la qualité tout en gagnant en efficacité. Le batching dynamique exige de prédire la durée de chaque requête pour maximiser l’utilisation GPU sans trop augmenter la latence. Ces améliorations architecturales, combinées à l’optimisation des kernels, permettent à FAL d’atteindre des taux d’utilisation et des performances inaccessibles avec une infrastructure générique.

Dynamiques de marché et paysage concurrentiel

Le marché des médias génératifs évolue très vite, avec de nouveaux modèles et capacités en permanence. Comprendre cette dynamique et la structure du marché est essentiel pour saisir pourquoi des plateformes spécialisées comme FAL ont tant de valeur. Le marché se structure grossièrement en plusieurs segments : génération d’images, de vidéos, d’audio, et outils d’édition/manipulation. Dans chaque segment, plusieurs modèles rivalisent sur la qualité, la vitesse, le coût et des fonctionnalités spécifiques. Pour l’image, on trouve les variantes de Stable Diffusion, les modèles Flux, Gemini Image de Google, et d’autres modèles spécialisés pour des usages précis comme le logo ou le visage humain. En vidéo, on retrouve Veo3, One (Alibaba), Kling (Kuaishou), etc. Cette diversité crée à la fois des opportunités et des défis pour les plateformes d’infrastructure. L’avantage : aucun modèle ne domine tous les usages — servir plusieurs modèles rend la plateforme plus attractive. Le défi : chaque modèle à supporter nécessite un effort d’optimisation conséquent.

La stratégie de FAL : sélectionner les modèles qui couvrent l’essentiel des besoins tout en maintenant un haut niveau de qualité. Plutôt que d’ajouter tous les modèles sortis, FAL évalue chaque nouveauté et ne retient que celles qui apportent un vrai plus. Cette curation a plusieurs avantages : garantir une sélection utile et qualitative, concentrer l’optimisation là où elle compte, et créer une boucle vertueuse où la réputation de la plateforme attire utilisateurs et créateurs de modèles. Les créateurs veulent leur modèle sur FAL car ils savent y toucher un public exigeant ; les utilisateurs viennent car ils savent que les modèles sont triés et optimisés. Ce cercle vertueux a été crucial pour le succès de FAL.

Le paysage concurrentiel inclut aussi d’autres plateformes d’infrastructure et la concurrence directe des créateurs de modèles proposant leur propre hébergement. Certains, comme Stability AI, offrent leur propre API d’inférence ; d’autres, comme Black Forest Labs avec Flux, préfèrent collaborer avec FAL. Le choix partenariat vs. build est stratégique : construire son infrastructure exige de lourds moyens et un savoir-faire opérationnel, tandis que collaborer permet de se concentrer sur la R&D. Pour la plupart, s’associer à FAL a bien plus de sens que de bâtir leur propre plateforme. Ce modèle a créé un écosystème sain où les créateurs se consacrent à la recherche, et les plateformes à l’optimisation et au passage à l’échelle.

Modèle de revenus et métriques business

Comprendre le modèle économique et les métriques de FAL éclaire la création de valeur et le passage à l’échelle des infrastructures de médias génératifs. FAL fonctionne sur un modèle à l’usage : les clients paient en fonction du nombre d’appels API et des ressources consommées. Cet alignement incitatif est efficace : plus les clients utilisent la plateforme, plus FAL croît. Les chiffres sont impressionnants : 2 millions de développeurs, plus de 350 modèles, et plus de 100 millions de dollars de revenus annuels. Cela traduit une belle échelle, mais aussi la jeunesse du marché : la pénétration reste faible et bien des usages restent à inventer. Les revenus accélèrent, surtout depuis l’introduction de la vidéo. Après la sortie de Flux, les revenus sont passés de 2 à 10 millions de dollars le premier mois, montrant l’impact d’un modèle de qualité sur la croissance d’une plateforme d’infrastructure.

Les métriques révèlent aussi la structure du marché : un revenu annuel de plus de 100 millions sur 2 millions de développeurs suggère un revenu moyen par utilisateur modeste (50-100 dollars/an). Cela reflète le fait que beaucoup expérimentent à petite échelle, mais la distribution est sûrement très déséquilibrée : une minorité d’utilisateurs professionnels génèrent la majorité des revenus. Ces utilisateurs intègrent la génération d’images/vidéos au cœur de leurs produits ou services. À mesure que le marché mûrit et que les entreprises adoptent massivement ces technologies, le revenu moyen devrait augmenter sensiblement. La trajectoire de croissance de la plateforme laisse penser que l’infrastructure des médias génératifs n’en est qu’au début d’une longue courbe de croissance, avec un potentiel considérable.

Perspectives avancées : le rôle du fine-tuning et de la personnalisation

L’une des évolutions majeures du marché des médias génératifs est l’apparition du fine-tuning et de la personnalisation, permettant d’adapter les modèles à des usages spécifiques. Le fine-tuning consiste à entraîner un modèle pré-entraîné sur des données spécialisées pour améliorer ses performances sur des tâches précises. Pour l’image, cela passe surtout par les LoRA (Low-Rank Adaptations), des modifications légères permettant d’adapter le modèle de base sans le réentraîner entièrement. Un designer peut créer une LoRA pour générer des images dans un style artistique donné, un photographe pour capter son esthétique, une entreprise pour générer des images de ses produits dans un contexte précis. L’écosystème LoRA est devenu crucial, avec des milliers de LoRA disponibles pour les modèles populaires comme Stable Diffusion et SDXL.

L’essor du fine-tuning a un impact fort sur les plateformes comme FAL. Gérer le fine-tuning exige plus que l’inférence du modèle de base : il faut fournir des outils de création et gestion de LoRA, les stocker efficacement, et les servir à l’inférence sans sacrifier la latence ou la qualité. FAL a beaucoup investi dans ces capacités, comprenant que la personnalisation est au cœur de la valeur pour de nombreux utilisateurs. Le support du fine-tuning a été un facteur clé de succès, permettant de répondre à des besoins sur mesure tout en profitant de l’optimisation et du passage à l’échelle de la plateforme. Avec la maturité du marché, la personnalisation deviendra encore plus centrale, chaque entreprise voulant des modèles adaptés à son usage.

L’avenir de l’infrastructure des médias génératifs

À l’avenir, ce marché va continuer à évoluer rapidement. Plusieurs tendances se dégagent. D’abord, les modèles continueront de s’améliorer en qualité et capacités, ouvrant de nouveaux usages et attirant de nouveaux publics. La génération vidéo n’en est qu’à ses débuts, mais elle deviendra probablement aussi courante que l’image. La génération audio et musicale est un nouveau front prometteur, avec des modèles comme PlayHD. Ensuite, le marché se consolidera sans doute autour de quelques modèles et plateformes dominantes, comme l’image s’est structurée autour de Stable Diffusion et Flux. Cela profitera aux plateformes spécialisées capables d’optimiser ces modèles clés. Enfin, les médias génératifs seront de plus en plus intégrés dans les outils et workflows quotidiens : ils ne seront plus une fonctionnalité isolée, mais intégrés dans les outils de design, de gestion de contenu, etc.

Les besoins d’infrastructure vont aussi évoluer. Les modèles, plus larges et puissants, exigeront plus de ressources, stimulant la demande d’optimisation de l’inférence. L’arrivée de nouveaux accélérateurs matériels (puces IA spécialisées, etc.) créera de nouveaux défis et opportunités d’optimisation. Les plateformes capables de servir efficacement des modèles sur divers matériels auront un avantage décisif. Par ailleurs, la fiabilité, la latence et l’optimisation des coûts seront de plus en plus centrales à mesure que les médias génératifs deviennent critiques pour les entreprises. Les early adopters acceptaient parfois des échecs ou une latence élevée ; désormais, la fiabilité et la rapidité seront exigées, poussant l’investissement dans l’optimisation et la robustesse.

Conclusion

L’histoire technique des médias génératifs met en lumière un marché passé de la recherche expérimentale à une opportunité d’infrastructure valant plusieurs milliards en quelques années. De Stable Diffusion 1.5 aux modèles vidéo modernes, l’innovation rapide des modèles IA a ouvert la voie à des plateformes d’infrastructure spécialisées. Le succès de FAL — 100 millions de dollars de revenus grâce à un focus exclusif sur l’infrastructure de médias génératifs, sans lutter sur le marché saturé des modèles de langage — illustre l’importance du positionnement stratégique et de la spécialisation technique. L’investissement dans l’optimisation des kernels CUDA, le support multi-modalités et la curation de modèles de qualité a permis de bâtir un service utilisé par des millions de développeurs. À mesure que les médias génératifs se généralisent dans la création de contenu et les applications, les plateformes d’infrastructure qui les servent vont gagner en importance. Amélioration continue des modèles, multiplication des usages, adoption croissante par les entreprises : tout laisse penser que l’infrastructure des médias génératifs n’en est qu’au début d’une trajectoire de croissance majeure, avec de vastes opportunités pour les plateformes capables d’offrir des services fiables, efficaces et innovants à leurs utilisateurs.

{{ cta-dark-panel

heading=“Boostez vos workflows avec FlowHunt”

description=“Découvrez comment FlowHunt automatise vos workflows de contenu IA et SEO — de la recherche à la génération, la publication et l’analytique — tout-en-un.”

ctaPrimaryText=“Réserver une démo”

ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo"

ctaSecondaryText=“Essayez FlowHunt gratuitement”

ctaSecondaryURL=“https://app.flowhunt.io/sign-in"

gradientStartColor="#123456”

gradientEndColor="#654321”

gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217”

}}