Introduction

L’ingénierie du contexte est devenue l’une des disciplines les plus cruciales pour concevoir des agents IA efficaces. À mesure que les modèles de langage gagnent en puissance et que les agents s’attaquent à des tâches complexes et multi-étapes, le défi ne réside plus seulement dans la capacité du modèle, mais dans la gestion stratégique des informations qui lui sont transmises. Chaque token compte. Dans ce guide complet, nous allons explorer ce qu’est l’ingénierie du contexte, pourquoi elle est essentielle à la performance des agents IA, et les techniques spécifiques utilisées par les organisations de recherche et plateformes de pointe pour concevoir des agents optimaux. Que vous développiez des bots de service client, des agents d’analyse de données ou des workflows autonomes, comprendre l’ingénierie du contexte améliorera fondamentalement les performances de vos systèmes IA.

Qu’est-ce que l’ingénierie du contexte ?

L’ingénierie du contexte représente un changement fondamental dans notre façon d’aborder la conception avec les grands modèles de langage. Plutôt que de considérer le LLM comme une boîte noire nécessitant simplement de bonnes instructions, l’ingénierie du contexte traite le modèle comme un système doté de ressources cognitives limitées qui doivent être soigneusement gérées. Au cœur de cette discipline, il s’agit de déterminer précisément quel contexte fournir à un agent IA—réfléchir délibérément à chaque token transmis lors d’un appel LLM afin de créer les conditions optimales pour la réussite de l’agent.

Ce concept, popularisé par des chercheurs comme Andrej Karpathy, prend de plus en plus d’importance à mesure que les agents IA évoluent de simples chatbots vers des systèmes sophistiqués capables de raisonnement et d’action autonomes. L’idée fondamentale est que les LLM, tout comme les humains, disposent d’une mémoire de travail et d’une capacité d’attention limitées. De la même manière qu’un humain ne peut se concentrer que sur une quantité limitée d’informations avant d’être confus ou de perdre des détails importants, les modèles de langage voient leurs capacités de raisonnement se dégrader lorsqu’ils reçoivent un contexte trop volumineux. Ainsi, la qualité du contexte importe bien plus que sa quantité.

L’ingénierie du contexte va au-delà du prompt engineering traditionnel, qui se concentrait essentiellement sur la rédaction du prompt ou des instructions systèmes idéales. Elle englobe désormais l’ensemble de l’écosystème informationnel accessible à un agent sur plusieurs tours d’interaction : prompts systèmes, définitions d’outils, exemples, historique des messages, données récupérées, informations chargées dynamiquement… L’objectif est de maintenir une fenêtre de contexte épurée et riche en signaux afin que l’agent dispose exactement de ce dont il a besoin pour prendre de bonnes décisions, sans être submergé d’informations non pertinentes.

Prêt à développer votre entreprise?

Commencez votre essai gratuit aujourd'hui et voyez les résultats en quelques jours.

Pourquoi l’ingénierie du contexte est cruciale pour des agents IA performants

L’importance de l’ingénierie du contexte ne saurait être surestimée lors de la création d’agents IA prêts pour la production. La recherche démontre de façon récurrente que les LLM subissent ce que l’on appelle la « context rot »—une dégradation mesurable de la performance à mesure que la fenêtre de contexte s’élargit. Des études utilisant des benchmarks « needle-in-a-haystack » ont montré que plus le nombre de tokens dans le contexte augmente, moins le modèle est capable de se souvenir et de raisonner précisément sur ces informations. Ce n’est pas un effet mineur : c’est une contrainte architecturale fondamentale des modèles de langage basés sur les transformers.

La raison de cette dégradation réside dans l’architecture même des transformers. Dans un transformer, chaque token peut prêter attention à tous les autres tokens du contexte, créant n² relations pour n tokens. À mesure que la longueur du contexte augmente, le mécanisme d’attention du modèle est étiré à l’extrême pour maintenir ces relations dans un espace toujours plus vaste. De plus, les modèles de langage sont principalement entraînés sur de courtes séquences et disposent donc de moins de paramètres spécialisés pour gérer de très longues dépendances. Il existe ainsi une tension naturelle entre la taille du contexte et la capacité de raisonnement : les modèles restent fonctionnels sur de longs contextes, mais leur précision pour l’extraction et le raisonnement à longue portée diminue fortement par rapport à des séquences plus courtes.

Au-delà de ces contraintes architecturales, une réalité s’impose : les LLM disposent d’un « budget d’attention » qui s’épuise à chaque nouveau token ajouté. Chaque information supplémentaire dans le contexte consomme une partie de ce budget et augmente la charge cognitive du modèle. C’est pourquoi l’ingénierie du contexte est essentielle. En sélectionnant soigneusement les informations transmises au modèle, vous n’optimisez pas seulement l’efficacité, vous améliorez directement la qualité du raisonnement et de la prise de décision de l’agent. Un agent avec une fenêtre de contexte épurée et bien organisée prendra de meilleures décisions, corrigera plus efficacement ses erreurs et maintiendra des performances constantes sur de longues séquences d’interaction—contrairement à un agent noyé sous des informations inutiles.

Comprendre l’ingénierie du contexte vs. le prompt engineering

Bien que l’ingénierie du contexte et le prompt engineering soient liés, ils correspondent à des niveaux d’abstraction différents dans la conception avec les modèles de langage. Le prompt engineering, qui dominait lors de la première vague d’usages LLM, se concentre sur la rédaction de prompts et d’instructions systèmes efficaces. Il s’agit essentiellement de trouver les bons mots et formulations pour obtenir le comportement souhaité du modèle sur une tâche donnée. Cette approche fonctionne bien pour des tâches unitaires comme la classification, le résumé ou la génération ponctuelle de texte.

L’ingénierie du contexte, en revanche, est l’évolution naturelle du prompt engineering à l’ère des agents autonomes multi-tours. Là où le prompt engineering demande « Comment rédiger l’instruction parfaite ? », l’ingénierie du contexte pose une question plus large : « Quelle est la configuration optimale de toutes les informations disponibles pour générer le comportement désiré ? ». Cela inclut non seulement le prompt système, mais aussi les outils accessibles à l’agent, les exemples, l’historique des messages, les données récupérées et les métadonnées qui aident l’agent à comprendre son environnement.

Le passage du prompt engineering à l’ingénierie du contexte reflète un changement fondamental dans la façon dont les applications IA sont conçues. Auparavant, la plupart des cas d’usage hors chat classique nécessitaient des prompts optimisés pour des tâches one-shot. Aujourd’hui, le domaine évolue vers des agents plus puissants opérant sur plusieurs tours d’inférence et sur la durée. Ces agents génèrent de plus en plus de données potentiellement pertinentes pour les décisions futures, nécessitant un affinage et une curation cyclique. L’ingénierie du contexte est la discipline qui consiste à gérer tout cet écosystème informationnel évolutif, pour garantir qu’à chaque étape du raisonnement, l’agent dispose exactement des bonnes informations pour prendre les meilleures décisions.

Rejoignez notre newsletter

Recevez gratuitement les derniers conseils, tendances et offres.

Les quatre techniques fondamentales de l’ingénierie du contexte

Les organisations de recherche IA et plateformes de pointe convergent vers quatre techniques principales pour une ingénierie du contexte efficace. Chacune répond à un aspect du défi de la gestion d’une fenêtre de contexte limitée tout en maintenant la performance de l’agent. Comprendre et savoir appliquer ces techniques est crucial pour créer des agents IA robustes.

Technique 1 : Offloading – Résumé et gestion des références

L’offloading consiste à résumer les informations et à stocker les données complètes sous forme de références externes, permettant à l’agent d’accéder aux détails uniquement si besoin. Par exemple, lorsqu’un agent fait appel à un outil—comme une base de données ou une API externe—il reçoit souvent une réponse volumineuse. Plutôt que d’injecter l’intégralité de cette réponse dans la fenêtre de contexte, on la résume en extrayant les éléments clés et en fournissant un lien permettant d’accéder aux données complètes si besoin.

Un exemple concret vient de Manus AI, un organisme de recherche travaillant sur des agents avancés. Lorsqu’un de leurs agents reçoit une réponse à un appel d’outil, ils n’incluent pas toute la réponse dans le contexte. À la place, ils fournissent un résumé concis et stockent la réponse complète dans un fichier ou une base de données, accompagnée d’un pointeur de référence. Si l’agent estime plus tard avoir besoin de détails supplémentaires, il peut alors consulter ces données stockées sans consommer de tokens supplémentaires dans la conversation principale. Cette approche s’inspire du fonctionnement humain : nous ne mémorisons pas chaque détail de chaque conversation, mais nous gardons des notes et des références à consulter au besoin.

Cognition, une autre organisation de pointe, a mis en place un système similaire mais avec une logique de résumé personnalisée. Plutôt que d’utiliser des résumés génériques, ils extraient l’information la plus pertinente selon leurs cas d’usage. Cela illustre un principe important : la meilleure stratégie d’offloading dépend du contexte. Ce qui constitue un bon résumé varie selon l’objectif de l’agent. En adaptant le résumé au domaine et à la tâche, vous maintenez un contexte riche en signal tout en réduisant drastiquement la consommation de tokens.

Technique 2 : Réduction – Compactage progressif du contexte

La réduction consiste à compacter et condenser le contexte pour diminuer le nombre total de tokens tout en conservant l’essentiel. Lorsqu’un agent fonctionne sur plusieurs tours, l’historique de la conversation s’allonge. Sans gestion active, cet historique peut vite occuper toute la fenêtre de contexte, laissant peu de place aux nouvelles informations ou au raisonnement. La réduction répond à ce problème en résumant périodiquement la conversation sous une forme plus concise.

Anthropic a mis en œuvre cette approche par le « compactage » de l’historique : au lieu de garder tous les échanges, ils résument ou compressent régulièrement l’historique. C’est une pratique essentielle car la recherche a montré qu’un contexte trop long nuit au raisonnement des agents IA. La présence d’informations superflues peut conduire à un phénomène de « context poisoning » : le raisonnement de l’agent est alors perturbé par des éléments non pertinents, l’éloignant de la solution optimale.

La technique de réduction s’appuie sur une observation fondamentale du fonctionnement des modèles de langage : ils ne raisonnent pas forcément mieux avec plus d’informations. Souvent, c’est l’inverse. Un contexte épuré, bien organisé et concentré sur l’essentiel produit un meilleur raisonnement et un comportement plus fiable de l’agent. C’est pourquoi de nombreuses organisations cherchent activement à réduire le contexte au fil du temps, même lorsque plus d’informations pourraient être disponibles. En gardant la fenêtre de contexte focalisée et gérable, elles préservent la capacité de l’agent à raisonner clairement et à prendre de bonnes décisions.

Technique 3 : Récupération (RAG) – Chargement dynamique du contexte

La génération augmentée par récupération (Retrieval-Augmented Generation, ou RAG) consiste à aller chercher dynamiquement, au moment de l’exécution, les informations pertinentes à charger dans le contexte, plutôt que de tout précharger. Cette approche gagne en popularité à mesure que les agents deviennent plus sophistiqués. Au lieu de tenter d’anticiper toutes les informations nécessaires et de les charger dès le départ, les systèmes RAG permettent aux agents de rechercher et de récupérer ce dont ils ont besoin au fil de l’eau.

L’avantage est double. D’abord, cela réduit considérablement la charge initiale sur la fenêtre de contexte : l’agent commence avec un contexte épuré et complète uniquement si besoin. Ensuite, cela permet une « divulgation progressive » où l’agent découvre progressivement le contexte pertinent à mesure de son exploration. Par exemple, un agent peut commencer par rechercher des fichiers pertinents, puis, selon leur nom ou leur date, décider d’en récupérer certains pour une analyse approfondie. Cette approche par niveaux est bien plus efficace que de tout charger d’emblée.

Claude Code d’Anthropic illustre parfaitement la RAG en pratique. Plutôt que de charger tout le code source en contexte, Claude Code se contente de stocker des identifiants légers (chemins de fichiers) et utilise des outils comme grep ou glob pour aller chercher les fichiers nécessaires. L’agent peut générer des requêtes ciblées, stocker les résultats et analyser de grands volumes sans jamais surcharger le contexte principal. Là encore, cette méthode s’inspire de la cognition humaine : nous ne mémorisons pas l’intégralité des informations, mais nous utilisons des systèmes d’organisation externe (systèmes de fichiers, moteurs de recherche…) pour retrouver ce dont nous avons besoin à la demande.

Technique 4 : Isolation – Sous-agents et séparation des tâches

L’isolation consiste à utiliser des sous-agents chargés de tâches spécifiques, afin que chaque agent travaille sur un problème distinct sans chevauchement de contexte. Cette technique part du principe que, parfois, la meilleure solution pour gérer le contexte est de diviser un problème complexe en sous-problèmes plus ciblés, chacun traité par un agent dédié avec sa propre fenêtre de contexte.

Deux grands paradigmes existent. Cognition déconseille l’utilisation de sous-agents sauf si les tâches sont totalement séparées sans recouvrement, estimant que les sous-agents ajoutent de la complexité et des points de défaillance potentiels. D’autres, comme Cloud Code, font de l’isolation via sous-agents un pilier de leur architecture : il est alors possible de créer des agents spécialisés pour chaque aspect d’une tâche, le tout coordonné par un agent « manager ».

Le point clé est qu’il s’agit d’un compromis. L’utilisation de sous-agents aide à gérer le contexte en divisant l’espace de problème : chaque agent dispose d’un contexte focalisé. Mais elle introduit aussi des coûts de coordination et des points de défaillance lors des transferts d’information. La bonne approche dépend du cas d’usage. Pour des tâches très complexes et bien séparées, l’isolation peut être très efficace. Si les aspects sont trop imbriqués, un agent unique avec un contexte bien géré sera souvent préférable.

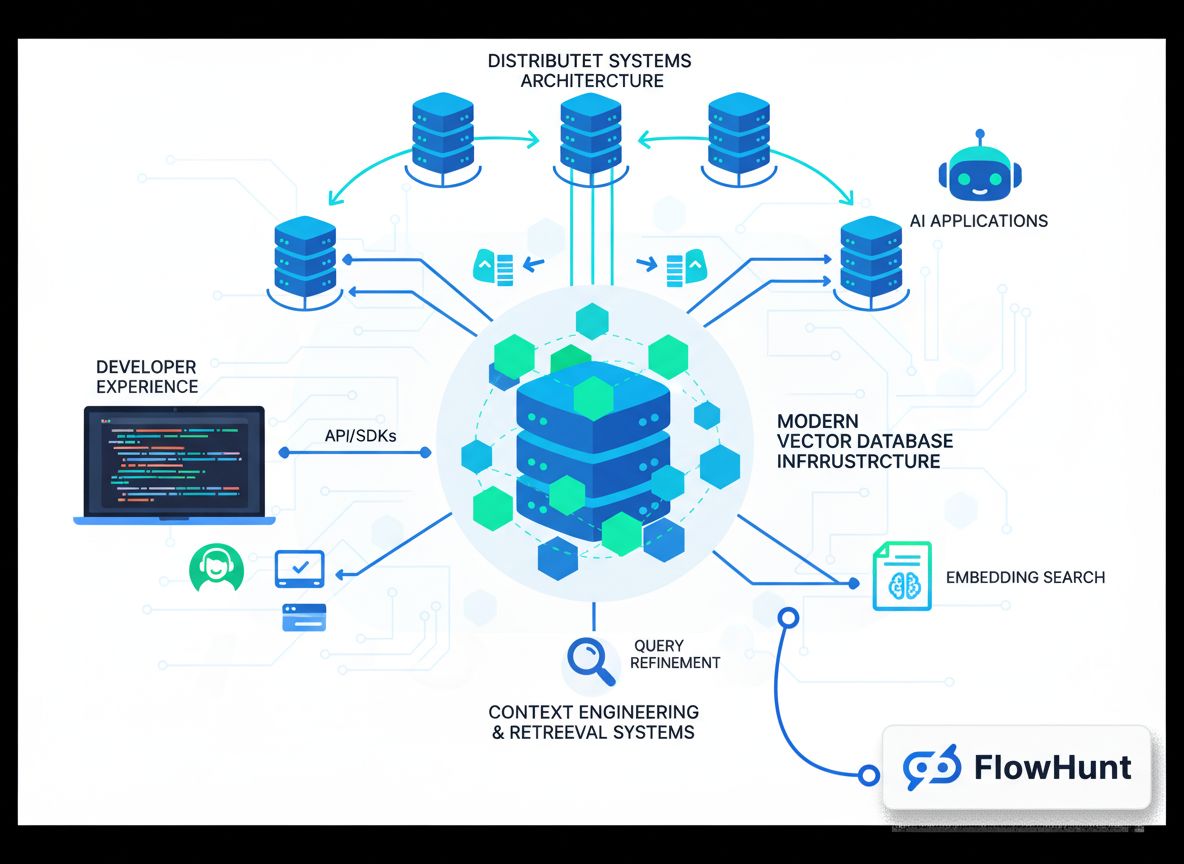

Mise en œuvre de l’ingénierie du contexte dans FlowHunt

FlowHunt propose une plateforme no-code complète pour l’application de toutes ces techniques d’ingénierie du contexte. Plutôt que d’exiger des solutions sur mesure, FlowHunt permet aux équipes de mettre en place des stratégies avancées de gestion du contexte via une interface visuelle intuitive. Cela démocratise l’ingénierie du contexte et la rend accessible même sans expertise approfondie en machine learning.

Dans FlowHunt, l’isolation peut être implémentée via des équipes auto-gérées (« self-managed crews »). Une équipe auto-gérée se compose de plusieurs agents IA coordonnés par un agent manager. Le manager reçoit la tâche initiale, la décompose en sous-tâches et les assigne à des agents spécialisés. Chaque agent maintient sa propre fenêtre de contexte focalisée sur sa responsabilité. Une fois les sous-tâches terminées, le manager synthétise les résultats. Cette approche permet de résoudre des problèmes complexes en les découpant en éléments gérables, chacun optimisé au niveau du contexte.

FlowHunt prend aussi en charge les workflows séquentiels, où plusieurs agents travaillent en chaîne, chaque sortie servant d’entrée au suivant. C’est particulièrement utile lorsque les tâches sont dépendantes : par exemple, pour la génération de contenu, un agent recherche le sujet, un second structure le plan, et un troisième rédige l’article final. Chacun dispose d’un contexte adapté à son étape.

Enfin, FlowHunt permet d’intégrer des systèmes intelligents de récupération directement dans vos flows. Plutôt que de tout charger dès le départ, vous configurez les agents pour aller chercher dynamiquement les données pertinentes. Cela peut consister à interroger des bases de données, des bases de connaissances, ou à récupérer des fichiers selon le raisonnement de l’agent. En combinant ces capacités, FlowHunt rend possible l’ingénierie du contexte de niveau entreprise, sans coder.

Stratégies avancées et applications réelles de l’ingénierie du contexte

Au-delà des quatre techniques fondamentales, plusieurs stratégies avancées sont utilisées par les organisations à la pointe pour repousser les limites de l’ingénierie du contexte. Ces approches combinent souvent plusieurs techniques et nécessitent des ajustements fins selon les cas d’usage.

Une stratégie avancée consiste à gérer le contexte de façon hybride, combinant chargement préalable et récupération à la demande. Plutôt que de choisir entre tout charger d’un coup ou tout récupérer dynamiquement, les approches hybrides chargent en avance les informations critiques pour la rapidité et la fiabilité, tout en maintenant la possibilité de récupérer d’autres informations si besoin. Claude Code illustre cette méthode : les fichiers CLAUDE.md sont ajoutés d’emblée au contexte car ils sont petits et contiennent des infos clés, tandis que les fichiers plus volumineux sont récupérés à la demande avec grep ou glob.

Une autre stratégie avancée s’appuie sur la sélection contextuelle pilotée par les métadonnées. Plutôt que de s’intéresser uniquement au contenu, des systèmes sophistiqués utilisent des métadonnées comme les noms de fichiers, dates, hiérarchies de dossiers, etc. pour déterminer l’information pertinente. Un agent opérant dans un système de fichiers peut, par exemple, déduire beaucoup d’un fichier nommé test_utils.py placé dans un dossier tests plutôt que dans src/core_logic/. Ces signaux organisationnels aident à déterminer quoi utiliser et quand, sans avoir à charger ou analyser tout le contenu.

La mitigation du context poisoning est également cruciale. Comme vu plus haut, le context poisoning survient quand une information non pertinente déroute le raisonnement de l’agent. Les systèmes avancés cherchent activement à identifier et retirer le contexte potentiellement toxique—en analysant, par exemple, la chaîne de raisonnement de l’agent pour voir où il a dévié, puis en supprimant ou reformulant le contexte à l’origine de la dérive. Progressivement, cela crée une boucle d’amélioration continue de la qualité du contexte.

L’avenir de l’ingénierie du contexte et du développement d’agents IA

À mesure que les agents IA se sophistiquent et sont déployés dans des scénarios toujours plus complexes, l’ingénierie du contexte prendra une importance croissante. Le domaine évolue rapidement, avec l’émergence régulière de nouvelles techniques et bonnes pratiques. Plusieurs tendances majeures se dessinent.

Premièrement, on verra apparaître des systèmes automatisés de curation du contexte de plus en plus sophistiqués. Au lieu de décider manuellement quelles informations inclure, les systèmes futurs utiliseront le machine learning pour déterminer dynamiquement le contexte optimal pour chaque agent et chaque tâche, en s’appuyant sur la performance des agents pour identifier les informations les plus utiles ou potentiellement toxiques.

Deuxièmement, l’ingénierie du contexte sera intégrée dès la conception de l’architecture des agents. Plutôt que de la traiter après coup, les systèmes agents de demain seront conçus dès l’origine pour optimiser le contexte, avec de nouvelles architectures ou représentations plus économes en tokens.

Troisièmement, l’ingénierie du contexte émergera comme discipline professionnelle à part entière, dotée d’outils, de frameworks et de référentiels dédiés. À l’instar de l’évolution du prompt engineering, les organisations investiront dans la constitution d’équipes spécialisées et d’outils pour l’optimisation du contexte.

{{ cta-dark-panel

heading=“Boostez vos workflows avec FlowHunt”

description=“Découvrez comment FlowHunt automatise tous vos workflows IA et SEO — de la recherche et génération de contenu à la publication et l’analytique — le tout sur une seule plateforme.”

ctaPrimaryText=“Demander une démo”

ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo"

ctaSecondaryText=“Essayez FlowHunt gratuitement”

ctaSecondaryURL=“https://app.flowhunt.io/sign-in"

gradientStartColor="#123456”

gradientEndColor="#654321”

gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217”

}}

Mise en pratique : créer son premier agent optimisé par l’ingénierie du contexte

Pour vous lancer dans l’ingénierie du contexte, prenons un cas concret de création d’agent pour la recherche et la génération de contenu. Cet exemple illustre l’application des techniques évoquées dans un scénario réel.

Commencez par définir clairement la responsabilité de votre agent. Ici, il s’agit de rechercher un sujet puis de générer un article complet. Plutôt que de tout confier à un seul agent avec une fenêtre de contexte massive, utilisez l’isolation pour créer un système multi-agents : un premier agent « chercheur » collecte de l’information sur le sujet, un second « rédacteur » utilise ces recherches pour rédiger l’article, sous la coordination d’un agent manager.

Pour l’agent chercheur, appliquez la récupération dynamique : au lieu de charger toutes les informations disponibles dès le départ, l’agent utilise des outils pour interroger des bases de données, APIs et récupérer des documents pertinents. Au fil de ses découvertes, il résume les points clés et stocke les références vers les sources complètes, gardant ainsi sa fenêtre de contexte épurée tout en conservant un accès possible à toutes les informations nécessaires.

Pour l’agent rédacteur, mettez en place l’offloading : le chercheur lui transmet un résumé des résultats, accompagné de références vers les sources complètes. Le contexte du rédacteur contient le résumé et la possibilité de consulter les sources si besoin, lui permettant d’être efficace sans être noyé sous des données brutes.

Tout au long du processus, surveillez le context poisoning. Si vous constatez que l’agent prend de mauvaises décisions ou s’égare, analysez son raisonnement pour identifier les éléments de contexte en cause, supprimez-les ou reformulez-les, puis testez à nouveau. Avec l’expérience, vous développerez une intuition sur le contexte optimal pour votre cas d’usage.

Mesurer et optimiser la performance de l’ingénierie du contexte

Une ingénierie du contexte efficace nécessite des mesures et une optimisation continue. Il est essentiel de définir des indicateurs permettant d’évaluer l’impact réel de vos efforts sur la performance des agents. Plusieurs métriques clés sont à surveiller.

D’abord, mesurez l’efficacité en tokens : le ratio entre la qualité de la sortie et le nombre de tokens consommés. Un agent produisant d’excellents résultats avec peu de tokens est plus efficient. Suivez cet indicateur dans le temps à mesure que vous appliquez les techniques d’ingénierie du contexte : vous devriez constater une amélioration grâce à l’offloading, la réduction et la récupération.

Ensuite, mesurez la qualité du raisonnement. Cela peut passer par l’analyse des chaînes de raisonnement de l’agent pour vérifier leur cohérence, ou par la comparaison des résultats à une référence. Une meilleure ingénierie du contexte doit améliorer cette qualité en réduisant la distraction due à des informations inutiles.

Troisième critère : la capacité de récupération après erreur. Un agent doit pouvoir se corriger efficacement : une ingénierie du contexte optimisée lui fournit des informations claires sur ce qui s’est mal passé et sur la marche à suivre.

Enfin, surveillez la latence et le coût. Si l’ingénierie du contexte vise avant tout la qualité, elle apporte aussi des gains d’efficacité : des agents avec des contextes mieux gérés sont plus rapides (car ils traitent moins de tokens) et moins coûteux. Suivez ces indicateurs pour évaluer l’impact global de vos efforts.

Dans la mise en œuvre de l’ingénierie du contexte, plusieurs pièges classiques sont à éviter.

Premier piège : la sur-optimisation. Vouloir à tout prix minimiser la fenêtre de contexte peut aboutir à un contexte trop épuré pour être utile. L’objectif est d’atteindre un équilibre optimal : suffisamment d’informations pour un bon raisonnement, mais pas au point de noyer l’agent. Commencez avec une quantité raisonnable et réduisez seulement si les résultats le permettent.

Deuxième piège : ignorer les spécificités de la tâche. L’ingénierie du contexte n’est pas universelle. Ce qui fonctionne pour un agent de support ne sera pas forcément adapté à un agent d’analyse de données. Prenez le temps d’analyser votre cas d’usage et d’adapter la stratégie en conséquence.

Troisième piège : négliger la surveillance et l’itération. L’ingénierie du contexte n’est pas une action ponctuelle. À mesure que l’agent rencontre de nouveaux cas ou que vos besoins évoluent, il faut surveiller la performance et ajuster la stratégie en continu. Intégrez cette boucle dans votre processus de développement.

Quatrième piège : sous-estimer l’importance des métadonnées. Beaucoup se concentrent sur le contenu du contexte mais négligent les métadonnées qui aident l’agent à comprendre comment exploiter l’information (noms de fichiers, dates, structure des dossiers…). Ces signaux organisationnels sont souvent plus utiles qu’on ne le pense. Soignez l’organisation et le nommage de vos données.

Conclusion

L’ingénierie du contexte marque un tournant fondamental dans la conception des agents IA, en passant d’un focus sur la rédaction de prompts parfaits à la gestion stratégique de toutes les informations disponibles pour optimiser la performance de l’agent. En comprenant et en appliquant les quatre techniques clés—offloading, réduction, récupération et isolation—ainsi que des stratégies avancées comme la gestion hybride du contexte ou la sélection pilotée par les métadonnées, vous pouvez construire des agents plus performants, fiables et efficients. Des plateformes comme FlowHunt rendent ces techniques accessibles via des interfaces no-code, démocratisant l’ingénierie du contexte pour toutes les équipes. Gardez à l’esprit que l’ingénierie du contexte est un processus itératif nécessitant mesure et optimisation continues. Commencez par les fondamentaux, mesurez vos résultats et intégrez progressivement des techniques avancées à mesure que vous gagnez en expertise. Les organisations qui maîtrisent l’ingénierie du contexte construiront les agents IA les plus capables et fiables, et bénéficieront d’avantages compétitifs majeurs dans un monde de plus en plus piloté par l’IA.