Introduction

Le passage de la création d’un prototype IA fonctionnel au déploiement d’un système de production reste l’un des plus grands défis du développement en intelligence artificielle. Ce qui paraît souvent simple lors des démonstrations — récupérer des informations pertinentes, enrichir les prompts, générer des réponses — devient exponentiellement plus complexe une fois à l’échelle de la production. Cette complexité pousse nombre d’acteurs du secteur à parler d’« alchimie » plutôt que d’ingénierie : un processus mystérieux où l’on ajuste les configurations, modifie les paramètres et espère que le système reste fiable. L’émergence de l’ingénierie du contexte comme discipline marque un tournant fondamental dans notre façon d’aborder la construction des systèmes IA, en s’éloignant de cette méthode par essais-erreurs pour adopter une démarche plus systématique et rigoureuse. Dans cette analyse approfondie, nous verrons comment les bases de données vectorielles modernes et les principes de l’ingénierie du contexte transforment le développement d’applications IA, permettant aux équipes de créer des systèmes non seulement fonctionnels mais véritablement fiables et maintenables à grande échelle.

Qu’est-ce que l’ingénierie du contexte et pourquoi cela compte

L’ingénierie du contexte s’impose aujourd’hui comme l’une des disciplines les plus cruciales du développement IA moderne, bien qu’elle reste encore méconnue de nombreux développeurs. Au cœur du concept, l’ingénierie du contexte consiste à gérer, organiser et optimiser de façon systématique l’information contextuelle utilisée par les systèmes IA pour prendre des décisions et générer des résultats. Contrairement au Retrieval-Augmented Generation (RAG) traditionnel, qui se limite à la récupération de documents pertinents pour enrichir un prompt destiné à un modèle de langage, l’ingénierie du contexte adopte une vision bien plus large de l’ensemble du pipeline. Elle englobe la circulation des données dans le système, leur stockage et indexation, la récupération, le classement, le filtrage des résultats et, in fine, la présentation du contexte au modèle. Cette approche holistique reconnaît que la qualité de la sortie d’un système IA est fondamentalement limitée par la qualité et la pertinence du contexte reçu. Si le contexte est mal géré — informations non pertinentes récupérées, détails importants manqués, répétitions — l’ensemble du système se dégrade. L’ingénierie du contexte répond à ces défis en considérant la gestion du contexte comme une préoccupation d’ingénierie à part entière, digne de la même rigueur que les autres composants critiques de l’infrastructure.

L’importance de l’ingénierie du contexte devient évidente lorsqu’on considère l’échelle des systèmes IA modernes. Un modèle de langage peut traiter des centaines de milliers de documents, synthétiser des informations provenant de sources multiples et générer des réponses cohérentes à partir de cette synthèse. Sans une ingénierie du contexte adéquate, ce processus tourne au chaos : des documents hors sujet saturent la fenêtre de contexte, des informations essentielles se perdent, et la performance du modèle se dégrade. De plus, à mesure que les systèmes IA deviennent plus sophistiqués et sont déployés dans des domaines critiques — service client, diagnostic médical, analyse financière — les conséquences d’une mauvaise gestion du contexte sont démultipliées. Un système qui renvoie parfois des informations non pertinentes peut passer pour un gadget, mais devient inacceptable lorsqu’il s’agit de décisions qui impactent la vie ou les moyens de subsistance des personnes. L’ingénierie du contexte garantit que l’information circulant dans le système soit non seulement abondante mais aussi réellement pertinente, bien organisée et optimisée pour la tâche visée.

Prêt à développer votre entreprise?

Commencez votre essai gratuit aujourd'hui et voyez les résultats en quelques jours.

L’évolution de la démo à la production : le problème de l’alchimie

L’un des défis les plus persistants du développement IA est ce que les vétérans du secteur appellent le « fossé entre la démo et la production ». Créer un prototype fonctionnel qui démontre les capacités d’une IA est relativement simple. Un développeur peut rapidement assembler un modèle de langage, le connecter à un système de recherche basique et obtenir un résultat bluffant en environnement contrôlé. Mais dès que ce système doit gérer des données réelles à grande échelle, maintenir sa fiabilité dans le temps et s’adapter à des exigences changeantes, tout se complique dramatiquement. Ce fossé a longtemps été franchi par ce que l’on ne peut appeler autrement que de l’alchimie : un mélange mystérieux de réglages de configuration, d’ajustements empiriques et d’essais-erreurs qui aboutit, d’une manière ou d’une autre, à un système fonctionnel. Le problème de cette approche, c’est qu’elle n’est ni reproductible, ni scalable, ni maintenable. Lorsqu’un incident survient en production, il est souvent difficile d’en identifier la cause, et il faut alors recommencer le même processus mystérieux.

La racine du problème de l’alchimie réside dans le fait que la plupart des infrastructures IA n’ont pas été conçues pour la production. Les premières bases vectorielles et systèmes de recherche ont surtout été bâtis pour démontrer la faisabilité de la recherche sémantique et du retrieval par embeddings. Ils fonctionnaient bien en environnement contrôlé, sur de petits jeux de données et des requêtes prévisibles. Mais à l’échelle de millions de documents, de milliers d’utilisateurs simultanés et de requêtes imprévisibles, ces systèmes s’effondrent souvent. La cohérence des données devient un problème, les performances se dégradent, le système devient difficile à déboguer et à surveiller. Les développeurs ne font plus vraiment de l’ingénierie, mais gèrent un artefact complexe et fragile, fonctionnant grâce à un mélange de chance et d’interventions constantes. C’est là qu’interviennent l’ingénierie moderne du contexte et l’infrastructure adaptée : en traitant le passage de la démo à la production comme un véritable défi d’ingénierie, et en construisant des systèmes conçus pour la charge de production, on transforme cette alchimie mystérieuse en pratique d’ingénierie réelle.

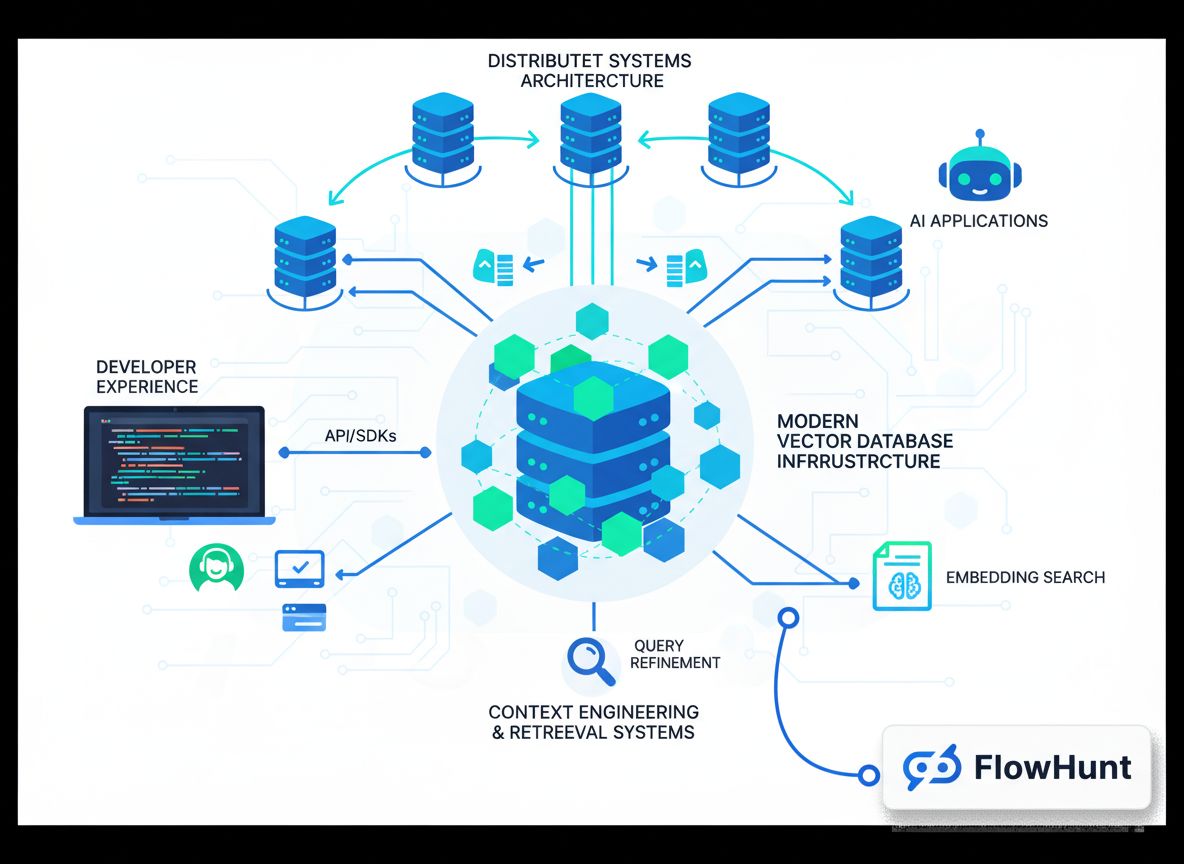

Comprendre l’infrastructure de recherche moderne pour l’IA

L’infrastructure de recherche traditionnelle, celle qui fait tourner Google ou d’autres moteurs de recherche, a été conçue avec des hypothèses précises sur l’usage de la recherche : gestion de requêtes par mots-clés d’utilisateurs humains, présentation de résultats sous la forme de « dix liens bleus » faciles à parcourir. L’infrastructure était optimisée pour ce cas d’usage : correspondance rapide de mots-clés, algorithmes de classement pour les jugements de pertinence humains, et présentation des résultats adaptée à la lecture humaine. Or, les systèmes IA ont des exigences fondamentalement différentes. Lorsqu’un modèle de langage consomme des résultats de recherche, il ne regarde pas dix liens — il peut traiter bien plus d’informations. Le modèle n’a pas besoin de résultats formatés pour des humains, mais de données structurées à analyser. Les requêtes ne sont plus basées sur des mots-clés, mais sur des critères sémantiques, via des embeddings et la similarité vectorielle. Ces différences fondamentales rendent l’infrastructure de recherche traditionnelle peu adaptée aux applications IA.

L’infrastructure moderne de recherche pour l’IA s’adapte à ces différences de plusieurs manières. Premièrement, les outils et technologies utilisés sont différents : au lieu d’index inversés et d’algorithmes de classement traditionnels, on utilise des embeddings vectoriels et des mesures de similarité sémantique, qui comprennent le sens et l’intention derrière la requête. Deuxièmement, les schémas de charges de travail changent : là où les systèmes classiques traitaient des requêtes simples avec peu de résultats, les systèmes IA doivent souvent récupérer et traiter de nombreux documents de façon sophistiquée. Troisièmement, les développeurs ont de nouveaux besoins : ils veulent des systèmes faciles à intégrer, offrant une bonne expérience et ne demandant pas d’expertise approfondie en recherche pour être utilisés efficacement. Enfin, et c’est sans doute le plus important, le consommateur du résultat change : là où l’humain faisait le dernier kilomètre — déterminer la pertinence, synthétiser l’information —, c’est désormais le modèle de langage qui s’en charge, et il peut digérer bien plus d’informations. Ce changement de paradigme redéfinit entièrement la conception de l’infrastructure.

Rejoignez notre newsletter

Recevez gratuitement les derniers conseils, tendances et offres.

FlowHunt et l’avenir de l’automatisation des workflows IA

À mesure que les entreprises prennent conscience de l’importance de l’ingénierie du contexte et des infrastructures de recherche modernes, le défi devient celui de l’intégration de ces capacités dans leurs workflows et processus de développement. C’est là que des plateformes comme FlowHunt interviennent, offrant un environnement unifié pour construire, tester et déployer des applications IA basées sur une gestion sophistiquée du contexte et des systèmes de recherche avancés. FlowHunt comprend que l’ingénierie du contexte ne se limite pas à la base de données — il s’agit d’avoir les bons outils et workflows pour gérer le contexte tout au long du cycle de développement IA. De l’ingestion initiale des données et leur indexation, à la récupération et au classement, jusqu’à l’inférence du modèle et la génération finale, chaque étape du pipeline doit être orchestrée et suivie avec soin. FlowHunt fournit des capacités d’automatisation qui rendent cette orchestration fluide, permettant ainsi aux développeurs de se concentrer sur l’application IA plutôt que sur les détails d’infrastructure.

L’approche de FlowHunt pour automatiser l’ingénierie du contexte est particulièrement précieuse pour les équipes qui développent plusieurs applications IA ou qui doivent gérer des pipelines de recherche complexes et multi-étapes. Plutôt que de reconstruire l’infrastructure à chaque fois, les équipes peuvent s’appuyer sur les composants préconçus et les workflows de FlowHunt pour accélérer le développement. La plateforme prend en charge l’ingestion, la génération d’embeddings, la gestion des index et l’orchestration de la recherche, libérant les développeurs pour se concentrer sur les aspects spécifiques à leur application. De plus, FlowHunt fournit des outils de visibilité et de monitoring qui facilitent la compréhension du flux de contexte dans le système, l’identification des goulets d’étranglement et l’optimisation des performances. Ce duo automatisation/visibilité transforme l’ingénierie du contexte d’un processus mystérieux et empirique en une discipline systématique et mesurable.

L’architecture des bases de données vectorielles prêtes pour la production

Créer une base de données vectorielle pour une démo est une chose ; en bâtir une qui serve des charges de production de façon fiable en est une autre. Une base vectorielle de production doit gérer de multiples utilisateurs simultanés, maintenir la cohérence des données, assurer une persistance fiable et évoluer harmonieusement à mesure que le volume de données augmente. Elle doit être débogable en cas d’incident, surveillable pour comprendre les comportements du système, et maintenable pour que les équipes puissent la faire évoluer. Ces exigences ont mené à l’émergence d’architectures modernes de bases vectorielles, incorporant les principes des systèmes distribués éprouvés au fil des décennies.

L’un des principes architecturaux clés des bases vectorielles modernes est la séparation du stockage et du calcul. Dans les bases de données monolithiques classiques, stockage et calcul sont étroitement couplés — le même serveur stocke les données et traite les requêtes. Cela pose des problèmes à l’échelle : pour plus de puissance de requête, il faut ajouter du stockage, pour plus de capacité de stockage, il faut ajouter du calcul. Ce couplage engendre des ressources gaspillées et des coûts accrus. En séparant stockage et calcul, les bases vectorielles modernes permettent à chacun d’évoluer indépendamment : le stockage est géré via des solutions économiques comme Amazon S3, tandis que les ressources de calcul s’ajustent selon la demande. Cette architecture apporte une grande flexibilité et efficacité. Autre principe essentiel : la multi-location, qui permet à une seule instance de base de données de servir plusieurs applications ou équipes en les isolant soigneusement. Bien conçue, la multi-location améliore l’utilisation des ressources et simplifie l’exploitation.

Les bases vectorielles modernes intègrent aussi des principes de systèmes distribués devenus la norme : séparation lecture/écriture (chaque type d’opération étant optimisé séparément), réplication asynchrone (durabilité des données sans sacrifier les performances), et consensus distribué pour garantir la cohérence entre nœuds. Associés à des langages modernes comme Rust, offrant performance et sécurité, ces principes permettent d’atteindre les niveaux de fiabilité et de performance nécessaires en production. Résultat : une infrastructure qui ne relève plus de l’alchimie, mais bien de l’ingénierie.

L’approche de Chroma sur l’expérience développeur

Dès sa création, l’équipe de Chroma avait une conviction claire : le fossé entre la création d’une démo IA et le déploiement en production tenait plus de l’alchimie que de l’ingénierie, et il fallait le combler. Leur approche a été de se concentrer obsessionnellement sur l’expérience développeur. Plutôt que de viser d’emblée le système le plus riche en fonctionnalités ou le plus scalable, ils ont voulu rendre l’accès à la base vectorielle et à la recherche sémantique incroyablement simple. D’où l’une des caractéristiques les plus marquantes de Chroma : une installation en une seule commande pip, utilisable immédiatement sans configuration complexe ni mise en place d’infrastructure. Cette simplicité était révolutionnaire dans le secteur, là où la plupart des bases de données nécessitaient des configurations lourdes avant de lancer une requête basique. Chroma a supprimé ces frictions, permettant l’expérimentation en quelques minutes au lieu de plusieurs heures ou jours.

Cet engagement envers l’expérience développeur va bien au-delà de la mise en route. L’équipe a fortement investi pour garantir la fiabilité sur différentes architectures et environnements. Dès le départ, les utilisateurs ont rapporté avoir fait tourner Chroma sur tout, des serveurs Linux standards aux Arduinos ou architectures Power PC. Loin de négliger ces cas d’usage, l’équipe Chroma a fait l’effort supplémentaire pour assurer la compatibilité sur tous ces supports. Ce souci d’universalité et de fiabilité a bâti la confiance et contribué à l’adoption rapide de la solution. L’équipe a compris que l’expérience développeur, ce n’est pas seulement la facilité d’utilisation, mais aussi la fiabilité, la cohérence, et la confiance que le système fonctionnera comme prévu, quels que soient l’environnement ou l’usage.

À mesure que Chroma a évolué et que l’équipe a commencé à concevoir Chroma Cloud, un choix s’est imposé : sortir rapidement une version hébergée du produit mono-nœud pour profiter de la demande, ou prendre le temps de concevoir un vrai produit cloud-native. Beaucoup d’acteurs ont opté pour la première solution, levant de gros fonds et marquant le marché. L’équipe Chroma a fait le choix inverse : elle a estimé qu’héberger simplement le produit mono-nœud était insuffisant pour l’expérience développeur. Un vrai produit cloud devait offrir la même simplicité d’utilisation et fiabilité que la version mono-nœud, tout en répondant aux exigences de l’échelle et de la fiabilité en production. Ce choix a retardé la sortie de Chroma Cloud, mais a abouti à un produit qui tient réellement la promesse de transformer l’alchimie en ingénierie.

Les quatre dimensions de « l’IA » dans l’infrastructure de recherche moderne

Lorsque l’on parle d’infrastructure de recherche moderne pour l’IA, il est important de reconnaître que « IA » recouvre des réalités différentes selon le contexte. Il existe en fait quatre dimensions distinctes où l’infrastructure moderne diffère du système traditionnel, et les comprendre est crucial pour bâtir des applications IA efficaces. Première dimension : la technologie. Les outils et technologies utilisés diffèrent radicalement (embeddings vectoriels, similarité sémantique, réseaux neuronaux pour le ranking, etc.) de ceux des systèmes classiques (index inversés, correspondance de mots-clés, TF-IDF, etc.). Ces différences reflètent la nature même des problèmes à résoudre et des capacités des systèmes IA modernes.

Deuxième dimension : les schémas de charges de travail. Les systèmes de recherche classiques traitaient des requêtes simples, sans état, renvoyant peu de résultats. Les systèmes IA modernes doivent gérer des pipelines complexes, avec plusieurs étapes de ranking et de filtrage, et potentiellement des milliers de documents à traiter. Les schémas de charge sont donc fondamentalement différents, impliquant une conception d’infrastructure adaptée.

Troisième dimension : le développeur. Les systèmes classiques étaient conçus et maintenus par des ingénieurs spécialisés en recherche. Les développeurs IA d’aujourd’hui sont souvent généralistes, sans expertise profonde en infrastructure de recherche, mais ont néanmoins besoin de capacités avancées. L’infrastructure doit donc être conçue pour la simplicité et l’accessibilité, pas seulement pour la puissance.

Quatrième et peut-être plus importante dimension : le consommateur des résultats. Dans les systèmes traditionnels, c’est l’humain qui consomme les résultats, traite une poignée de liens, détermine la pertinence et synthétise l’information. Dans les systèmes IA modernes, c’est le modèle de langage qui consomme directement, capable d’ingérer des centaines ou milliers de documents et d’en synthétiser l’information. Cette différence fondamentale change tout dans la conception de l’infrastructure : les algorithmes de classement sont optimisés pour la machine, la présentation des résultats pour le traitement automatique, et tout le pipeline est pensé pour un traitement finalisé par un système IA.

Construire et garder une vision dans un marché bruyant

Le marché des bases vectorielles en 2023 était l’un des plus dynamiques de l’infrastructure IA : levées de fonds massives, communication agressive, course aux fonctionnalités… Dans ce contexte, il aurait été facile pour Chroma de perdre le cap, de courir après toutes les tendances et de tenter d’être tout pour tout le monde. L’équipe a fait le choix délibéré de rester focalisée sur sa vision : bâtir un moteur de récupération pour applications IA offrant une expérience développeur exceptionnelle et comblant vraiment le fossé entre démo et production. Ce focus a exigé discipline et conviction, surtout quand d’autres levaient plus de fonds ou faisaient plus de bruit.

La clé de cette focalisation : une thèse claire et à contre-courant sur ce qui compte vraiment. Pour Chroma, l’essentiel n’était ni la quantité de fonctionnalités ni les montants levés, mais la qualité de l’expérience développeur et la fiabilité du système. Leur conviction : en faisant une seule chose — un moteur de récupération de très haut niveau — ils gagneraient le droit d’en faire plus demain. Cette philosophie de focalisation extrême est rare dans l’univers des startups surfinancées, où la pression pousse souvent à la dispersion. L’équipe Chroma, en restant droite dans ses choix même au prix d’une croissance plus lente, a finalement eu raison.

Garder cette vision passe aussi par une attention particulière au recrutement. Les personnes que vous embauchez façonnent la culture, et la culture détermine ce que vous construisez et comment. Chroma a choisi d’embaucher lentement et avec exigence, privilégiant l’alignement avec la vision, le souci de la qualité et la capacité d’exécution autonome. Cette approche, certes plus lente, garantit une équipe engagée et capable de contribuer pleinement à la mission. Cet alignement culturel est difficile à obtenir dans des startups à forte croissance, mais il est essentiel pour garder le cap sur le long terme.

L’importance du savoir-faire et de la qualité dans l’infrastructure

L’un des aspects les plus frappants de l’approche Chroma est l’importance du savoir-faire et de la qualité. Dans ce secteur, il est facile de tomber dans le piège du « toujours plus » (fonctionnalités, performance, échelle). Mais Chroma a compris que ce qui compte vraiment, c’est de construire des systèmes fiables, faciles à utiliser, qui résolvent vraiment les problèmes des développeurs. Ce souci de la qualité se manifeste dans le choix du langage Rust (performance et sécurité), dans l’engagement à garantir la compatibilité sur des architectures variées, même exotiques, et dans la décision de prendre le temps de bien faire, quitte à repousser la sortie de Chroma Cloud.

Cette exigence s’étend à la vision du problème : l’ingénierie du contexte n’est pas vue comme un détail technique à résoudre par des algorithmes malins, mais comme un défi global englobant expérience développeur, fiabilité, scalabilité et maintenabilité. Cette approche holistique aboutit à de meilleures solutions, car un système ne vaut que par son maillon le plus faible : le meilleur algorithme de récupération du monde ne sert à rien si le système est difficile à utiliser ou peu fiable en production. En plaçant la qualité au cœur de toutes les dimensions, Chroma a construit un produit qui fonctionne vraiment et comble véritablement le fossé entre démo et production.

Implications concrètes pour les équipes de développement IA

Pour les équipes qui développent des applications IA, les enseignements de l’approche Chroma se traduisent par plusieurs implications concrètes. Premièrement, il faut réaliser que l’ingénierie du contexte n’est pas une quête secondaire : c’est central. La qualité de votre système IA est limitée par celle du contexte qu’il reçoit, donc investir dans une infrastructure d’ingénierie du contexte n’est pas optionnel, c’est essentiel. Deuxièmement, méfiez-vous des systèmes qui promettent tout : les plus fiables et efficaces sont souvent ceux qui font une chose vraiment bien, puis construisent dessus. Si vous évaluez des bases vectorielles ou des systèmes de recherche, privilégiez la clarté du focus et l’excellence sur ce point précis. Troisièmement, l’expérience développeur compte : un système moins puissant mais facile à utiliser sera in fine plus utile qu’un système plus complexe mais difficile à prendre en main, car les développeurs pourront rapidement créer dessus au lieu de buter sur des obstacles.

Quatrièmement, la fiabilité et la cohérence sont plus cruciales qu’on ne le pense. Dans les premiers temps, on est tenté de privilégier fonctionnalités et performances ; mais dès que le système passe en production et gère du vrai volume, la fiabilité devient capitale. Un système fiable à 95 % peut sembler acceptable, mais sur des millions de requêtes par jour, 5 % d’échecs font des centaines de milliers de requêtes ratées. Investir dans la fiabilité dès le départ coûte moins cher que de la bricoler après coup. Enfin, pensez au long terme : l’infrastructure que vous choisissez aujourd’hui conditionnera ce que vous pourrez faire demain. Un choix conçu pour la production, évolutif et offrant bonne visibilité et monitoring, portera ses fruits à mesure que vos systèmes grandiront.

{{ cta-dark-panel

heading=“Boostez vos workflows avec FlowHunt”

description=“Découvrez comment FlowHunt automatise vos workflows IA et SEO — de la recherche à la génération de contenu, jusqu’à la publication et l’analyse — tout en un seul endroit.”

ctaPrimaryText=“Demander une démo”

ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo"

ctaSecondaryText=“Essayez FlowHunt gratuitement”

ctaSecondaryURL=“https://app.flowhunt.io/sign-in"

gradientStartColor="#123456”

gradientEndColor="#654321”

gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217”

}}

Le rôle de l’open source dans la confiance et la communauté

L’une des décisions les plus importantes prises par l’équipe Chroma a été d’ouvrir le code source du produit principal. Ce choix a eu plusieurs conséquences majeures. D’abord, il a instauré la confiance dans la communauté développeur : voir le code, comprendre le fonctionnement, pouvoir contribuer, tout cela favorise l’adoption. L’open source crée aussi un cercle vertueux : les contributions améliorent le produit, ce qui attire de nouveaux utilisateurs, qui eux-mêmes contribuent. Deuxièmement, l’ouverture du code a fédéré une communauté forte autour de Chroma : les utilisateurs, investis dans sa réussite, contribuent, donnent leur avis et recommandent le produit. Cette communauté devient un atout difficile à reproduire pour la concurrence.

Enfin, l’open source offre une voie naturelle pour la monétisation via des services hébergés : en ouvrant le cœur du produit, Chroma permet aux développeurs de l’utiliser gratuitement en self-host, mais nombre d’entre eux préféreront une version managée, qui gère l’exploitation, la montée en charge et la maintenance. C’est tout l’intérêt de Chroma Cloud : une expérience hébergée supérieure, tout en gardant le cœur open source, pour servir à la fois la communauté self-host et le marché du service managé. Ce modèle s’avère plus durable et mieux aligné avec les attentes des développeurs qu’un produit propriétaire fermé.

Mesurer le succès : les bons indicateurs

Pour évaluer le succès d’un projet d’infrastructure comme Chroma, il faut regarder les indicateurs qui reflètent réellement la valeur délivrée. Les chiffres de Chroma sont impressionnants : plus de 21 000 étoiles GitHub, plus de 5 millions de téléchargements mensuels, et plus de 60 à 70 millions au total. Ces chiffres témoignent de l’adoption massive par la communauté. Mais au-delà de ces métriques, ce qui importe vraiment, c’est la résolution effective des problèmes développeur : est-ce plus facile de construire des applications IA ? Le passage de la démo à la production est-il plus rapide ? Les systèmes bâtis sont-ils plus fiables ? D’après les retours de la communauté et l’adoption rapide, la réponse semble clairement positive.

Un autre indicateur important est la qualité de la communauté et la diversité des contributions : Chroma a reçu des apports de développeurs de tout l’écosystème, y compris des intégrations avec LangChain et Llama Index. Cette adoption transversale, ce maillage avec d’autres outils, signalent que Chroma répond à de vrais besoins. Le fait que Chroma soit devenu le choix par défaut pour la gestion vectorielle dans nombre de frameworks IA atteste de la qualité du produit et de la solidité de sa communauté. Ces métriques qualitatives — adoption communautaire, intégrations, retours positifs — sont souvent plus parlantes que les seuls chiffres de téléchargements.

L’avenir de l’ingénierie du contexte et de l’infrastructure IA

À mesure que les systèmes IA gagnent en sophistication et en diffusion, l’importance de l’ingénierie du contexte ne fera que croître. Les systèmes en construction aujourd’hui ne sont qu’un début. Demain, des approches encore plus avancées émergeront : gestion dynamique du contexte selon la tâche, apprentissage sur les retours pour améliorer la recherche, prise en charge de multiples modalités (texte, image, audio, vidéo) de façon fluide. L’infrastructure nécessaire sera plus sophistiquée, mais les principes resteront : priorité à l’expérience développeur, fiabilité et qualité, vision claire des problèmes à résoudre.

Le rôle des plateformes comme FlowHunt prendra aussi de l’ampleur : à mesure que l’ingénierie du contexte devient centrale, les équipes auront besoin d’outils pour construire, tester et déployer facilement des pipelines de gestion du contexte. L’approche de FlowHunt — automatiser et offrir de la visibilité sur tout le cycle IA — est bien adaptée à ce besoin. En masquant la complexité de l’infrastructure et en fournissant des outils de haut niveau, ces plateformes permettent aux développeurs de se concentrer sur la valeur métier plutôt que sur les détails d’infrastructure.

Conclusion

L’ingénierie du contexte marque un tournant dans la conception des systèmes IA, passant de l’alchimie empirique à une discipline systématique et rigoureuse. Les bases vectorielles modernes comme Chroma, fondées sur la séparation stockage/calcul, la multi-location et l’architecture distribuée, constituent le socle de ce changement. En y ajoutant l’exigence d’expérience développeur, de fiabilité et de qualité, les équipes peuvent bâtir des systèmes IA réellement prêts pour la production et évolutifs. Les enseignements de Chroma — focus sur la vision, recrutement aligné, priorité à la qualité sur les fonctionnalités, création d’une communauté open source — tracent une feuille de route pour les autres projets d’infrastructure et les équipes de développement IA. À mesure que le secteur mûrit, bien maîtriser l’ingénierie du contexte deviendra l’un des enjeux les plus stratégiques pour toute organisation construisant des systèmes IA.