Hugging Face Transformers

Hugging Face Transformers est une bibliothèque Python open-source de premier plan qui facilite la mise en œuvre de modèles Transformer pour des tâches d'apprent...

Un guide complet des stratégies modernes de pré-formation des modèles de langage, des techniques de curation de données et des méthodes d’optimisation utilisées par HuggingFace pour construire des modèles open-source efficaces et performants.

Le développement des modèles de langage a connu un bouleversement fondamental ces dernières années. Tandis que les grandes entreprises technologiques poursuivent la course à l’agrandissement des modèles, la communauté open-source a découvert qu’une performance exceptionnelle ne nécessite pas forcément des modèles à mille milliards de paramètres. Ce guide complet explore les techniques et stratégies de pointe utilisées par les chercheurs de HuggingFace pour construire des modèles de langage efficaces et performants grâce à des méthodologies rigoureuses de pré-formation. Nous examinerons comment SmolLM 3, FineWeb et FinePDF représentent un nouveau paradigme de développement de modèles, axé sur la maximisation de la performance dans des contraintes de calcul réalistes, tout en maintenant la rigueur scientifique et la reproductibilité. Les enseignements partagés ici sont le fruit de mois de recherche et d’expérimentation, offrant une véritable masterclass sur l’approche à adopter pour la pré-formation de modèles à l’ère moderne.

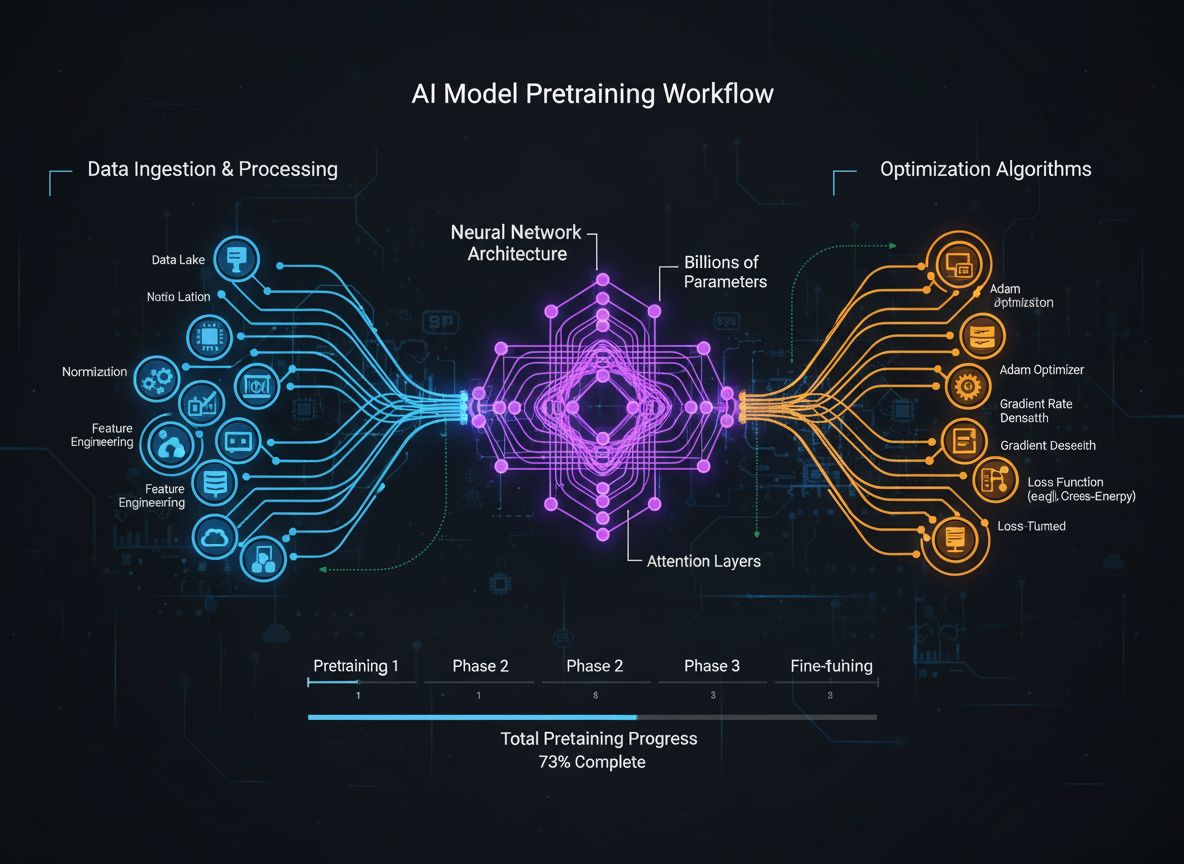

La pré-formation des modèles de langage a évolué d’un simple processus de traitement de texte brut par réseaux neuronaux vers une discipline sophistiquée impliquant de multiples objectifs d’optimisation interconnectés. Fondamentalement, la pré-formation consiste à exposer un modèle à d’immenses quantités de texte, lui permettant d’apprendre les structures statistiques du langage via l’apprentissage auto-supervisé. Cependant, l’approche moderne reconnaît que se contenter d’augmenter la quantité de données et de calculs ne suffit pas. Les chercheurs doivent orchestrer avec soin toutes les dimensions du processus d’entraînement : sélection et curation des données, choix architecturaux, algorithmes d’optimisation. Le domaine a mûri au point où comprendre ces subtilités distingue les modèles d’excellence des modèles médiocres. Cette évolution traduit une compréhension profonde : la performance d’un modèle ne dépend pas d’un seul facteur, mais d’une orchestration minutieuse de multiples objectifs partiellement orthogonaux pouvant être optimisés en parallèle. La communauté de recherche réalise de plus en plus que le « secret » du succès ne réside pas dans la montée en puissance brute, mais dans des choix intelligents à chaque étape de la chaîne d’entraînement.

L’un des enseignements les plus importants des recherches récentes est que la qualité et la diversité des données d’entraînement déterminent fondamentalement la performance du modèle, bien plus que la quantité brute de données. Ce principe, souvent résumé par « garbage in, garbage out », a été validé par la recherche empirique et l’expérience pratique. Les modèles entraînés sur des données mal curées, dupliquées ou de mauvaise qualité apprennent des schémas erronés et généralisent mal sur de nouvelles tâches. À l’inverse, des jeux de données soigneusement sélectionnés, dédupliqués et filtrés permettent aux modèles d’apprendre plus efficacement et d’atteindre de meilleures performances avec moins d’étapes d’entraînement. Cette prise de conscience a des implications profondes : organisations et chercheurs devraient investir massivement dans la curation et l’assurance qualité des données, plutôt que de simplement accumuler des données brutes. Ce changement de perspective a mené à la création d’équipes et d’outils spécialisés dans la création et l’affinage de jeux de données. Le jeu de données FineWeb, qui contient plus de 18,5 trillions de tokens de données web en anglais nettoyées et dédupliquées, en est un exemple. Plutôt que d’utiliser les données brutes de CommonCrawl, l’équipe FineWeb a mis en œuvre des techniques sophistiquées de filtrage, de déduplication et d’évaluation de la qualité pour créer un jeu de données qui surpasse constamment des alternatives brutes et plus volumineuses. C’est une réalisation fondamentale dans le domaine : la voie vers de meilleurs modèles passe par de meilleures données, pas forcément par plus de données.

La pré-formation moderne des modèles peut être comprise à travers cinq objectifs interconnectés mais partiellement orthogonaux que les chercheurs doivent optimiser simultanément. Comprendre ces piliers offre un cadre pour penser l’ensemble du processus d’entraînement et identifier les axes d’amélioration. Le premier pilier consiste à maximiser la pertinence et la qualité de l’information brute des données d’entraînement. Cela englobe la qualité des points de données individuels et la diversité globale du jeu de données. Un modèle entraîné sur des données de haute qualité et variées apprendra des schémas plus généralisables qu’un modèle entraîné sur des données étroites ou de faible qualité, quels que soient les autres optimisations. Le deuxième pilier concerne la conception architecturale du modèle, qui détermine à quelle efficacité le modèle traite l’information et dans quelles contraintes de calcul il opère. Les choix architecturaux impactent la vitesse d’inférence, la consommation mémoire, les besoins en cache KV et la capacité du modèle à s’exécuter sur certains matériels. Le troisième pilier vise à maximiser l’information extraite des données à chaque étape, avec des techniques comme la distillation des connaissances (où les petits modèles apprennent des gros) et la prédiction multi-tokens (où le modèle prédit plusieurs tokens à l’avance). Le quatrième pilier s’attache à la qualité des gradients et à la dynamique d’optimisation : choix de l’optimiseur, planification du taux d’apprentissage, techniques pour maintenir la stabilité de l’entraînement. Le cinquième pilier concerne l’ajustement des hyperparamètres et les stratégies de passage à l’échelle pour garantir la stabilité lors du passage à de grands modèles et empêcher l’explosion des gradients ou la divergence des activations. Ces piliers ne sont pas indépendants, ils interagissent de manière complexe, mais les aborder séparément aide à cibler les améliorations les plus impactantes.

FineWeb marque un tournant dans la création de jeux de données pour la pré-formation des modèles de langage. Plutôt que d’accepter le flux brut des crawlers web comme CommonCrawl, l’équipe HuggingFace a mis en œuvre une pipeline complète de nettoyage, filtrage et déduplication de données web à très grande échelle. Le jeu de données résultant contient plus de 18,5 trillions de tokens de texte anglais de haute qualité, en faisant l’un des plus vastes jeux de données curés disponibles à la communauté open-source. La création de FineWeb a impliqué de multiples étapes de traitement, chacune visant à éliminer le contenu de faible qualité tout en préservant l’information de valeur. L’équipe a mis en place des algorithmes de déduplication sophistiqués pour éliminer les contenus redondants, des filtres de qualité contre le spam et les pages médiocres, ainsi que la détection de langue pour garantir une majorité de texte en anglais. Ce qui rend FineWeb particulièrement précieux n’est pas seulement sa taille, mais la validation empirique de ses performances supérieures à celles d’alternatives brutes bien plus volumineuses. Mélangé à d’autres jeux de données, FineWeb surpasse systématiquement les jeux de données bruts beaucoup plus grands, prouvant que la qualité prime vraiment sur la quantité. Les courbes de performances montrent que les modèles entraînés sur FineWeb obtiennent de meilleurs résultats sur les benchmarks standards que les modèles entraînés sur des jeux de taille similaire provenant d’autres sources. Ce succès a inspiré la communauté à investir davantage dans la curation de données, reconnaissant que les gains de performance significatifs se trouvent là. FineWeb est librement accessible aux chercheurs, démocratisant l’accès à des données d’entraînement de qualité et permettant à des organisations plus petites et des équipes universitaires de former des modèles compétitifs.

Alors que FineWeb s’est concentré sur les données web, l’équipe HuggingFace a vu qu’une autre immense source de texte de qualité était largement sous-exploitée : les documents PDF. Ceux-ci contiennent d’énormes quantités d’informations structurées de qualité, incluant des articles académiques, des documentations techniques, des livres, des rapports professionnels. Mais l’extraction de texte depuis des PDF est techniquement complexe, et les approches précédentes n’avaient pas exploité cette source à grande échelle. FinePDF est la première initiative exhaustive d’extraction, de nettoyage et de curation de données PDF pour la pré-formation des modèles de langage. L’équipe a mis en place une pipeline sophistiquée qui relève les défis spécifiques du traitement PDF, comme la gestion des mises en page complexes, l’extraction de texte de documents multi-colonnes, ou la gestion des images et tableaux intégrés. Un aspect innovant de FinePDF est l’étape de « refetch from internet », qui règle un problème critique : les PDF stockés dans CommonCrawl sont souvent mal extraits ou obsolètes. En récupérant les PDF à la source sur Internet, l’équipe assure l’accès à la meilleure version des documents. Les résultats sont impressionnants : mélangé à d’autres jeux de données, FinePDF montre d’excellentes performances face à des bases récentes comme NeoTron B2. Le jeu fournit une nouvelle source de données de qualité qui complète les données web et permet aux modèles d’apprendre à partir d’informations structurées et diverses. Ce travail ouvre la voie à la création de nouveaux jeux de données, suggérant que d’autres sources inexplorées pourraient offrir des avantages similaires. La pipeline FinePDF est documentée en détail dans des articles de blog et de la documentation technique, permettant à d’autres chercheurs de s’en inspirer et d’appliquer ces techniques à d’autres sources.

SmolLM 3 incarne l’application de ces techniques de curation de données et d’optimisation de l’entraînement pour créer un modèle de langage très efficace. Avec 3 milliards de paramètres, SmolLM 3 est bien plus petit que beaucoup de modèles contemporains, mais il atteint des performances compétitives grâce à une optimisation soignée sur les cinq piliers de l’entraînement. Le modèle prend en charge le raisonnement à double mode, des capacités multilingues sur six langues et la compréhension de longs contextes, le rendant remarquablement polyvalent malgré sa taille modeste. Le développement de SmolLM 3 a impliqué des choix architecturaux minutieux visant l’efficacité : architecture transformeur équilibrée, attention « grouped query » pour réduire la mémoire et la latence. Le modèle a été entraîné par une approche en trois étapes qui améliore progressivement ses performances sur différents domaines, permettant d’optimiser pour des capacités spécifiques à chaque étape. SmolLM 3 est significatif car il prouve que la communauté open-source peut désormais produire des modèles rivalisant avec des modèles propriétaires beaucoup plus volumineux sur de nombreuses tâches. Cela remet en cause l’idée que « plus gros est toujours mieux » et suggère que le domaine a atteint un plateau sur les bénéfices du simple passage à l’échelle. L’accent se déplace donc vers l’efficacité, l’interprétabilité et la capacité de déploiement pratique. SmolLM 3 fonctionne sur du matériel grand public, des appareils en périphérie, et des environnements contraints, rendant des capacités avancées accessibles à un public bien plus large. Ses capacités multilingues et de long contexte prouvent que l’efficacité n’implique pas de sacrifier des fonctionnalités clés.

La distillation des connaissances est une technique puissante qui permet aux modèles plus petits de bénéficier du savoir acquis par des modèles plus grands. Plutôt que d’entraîner un petit modèle à partir de zéro, la distillation consiste à lui faire imiter les sorties d’un modèle plus performant. Cette approche est particulièrement précieuse lors de la pré-formation, car elle permet au modèle de taille réduite d’absorber des schémas déjà découverts par le grand modèle, accélérant l’apprentissage et améliorant la performance finale. Concrètement, la distillation implique d’entraîner le modèle élève (le plus petit) à correspondre aux distributions de probabilité générées par le modèle professeur (le plus gros), en minimisant la divergence entre les sorties, souvent via la divergence de Kullback-Leibler. Le paramètre de température contrôle la « douceur » des distributions : des températures élevées lissent la distribution, fournissant plus d’information sur la confiance relative entre prédictions. La distillation est particulièrement efficace en pré-formation des modèles de langage, car elle permet de transférer les acquis des grands modèles vers des modèles plus compacts et efficaces. C’est crucial pour les organisations qui souhaitent déployer des modèles sur des appareils en périphérie ou des environnements limités tout en profitant des avancées des modèles les plus puissants. La technique s’est sophistiquée, avec des méthodes comme le transfert d’attention (le modèle élève apprend aussi à imiter les schémas d’attention du professeur) ou la distillation basée sur les caractéristiques intermédiaires.

Traditionnellement, l’entraînement des modèles de langage se concentre sur la prédiction du prochain token. Mais des recherches récentes montrent que forcer les modèles à prédire plusieurs tokens futurs simultanément améliore nettement la performance, notamment pour les tâches de codage et de raisonnement complexe. La prédiction multi-tokens pousse le modèle à apprendre des dépendances à plus long terme et à développer une compréhension plus profonde des schémas sous-jacents dans les données. La méthode consiste à ajouter plusieurs têtes de prédiction, chacune chargée de prédire un token à une position future donnée. À l’entraînement, le modèle reçoit des signaux d’erreur de toutes ces têtes en même temps, ce qui l’incite à apprendre des représentations utiles pour prédire à plusieurs pas dans le futur. Plus exigeant que la prédiction du prochain token, cela produit de meilleures représentations apprises. Les bénéfices vont au-delà de la performance sur l’objectif d’entraînement : les modèles formés ainsi montrent de meilleures performances sur des tâches aval, une meilleure généralisation à de nouveaux domaines, et des capacités de raisonnement accrues. Cette technique est particulièrement efficace pour la génération de code, où comprendre les dépendances longues est crucial pour produire du code syntaxiquement et sémantiquement correct. Les recherches montrent des gains de 5 à 15% sur divers benchmarks, faisant de la prédiction multi-tokens l’une des techniques d’entraînement les plus impactantes de ces dernières années. Sa mise en œuvre est simple, mais nécessite de régler soigneusement le nombre de têtes et la pondération des pertes.

Pendant des années, AdamW a été le choix par défaut pour entraîner les grands modèles de langage : il combine la mise à jour des gradients avec de la décroissance pondérale, assurant stabilité et bonne convergence. Mais des travaux récents montrent qu’AdamW n’est pas optimal pour tous les scénarios, en particulier lors du passage à de très grands modèles. De nouveaux optimiseurs comme Muon et King K2 explorent d’autres approches pour améliorer la dynamique d’entraînement et la performance. Leur idée centrale : la matrice hessienne (qui capture la courbure de la fonction de perte) peut être mieux approchée avec des méthodes comme Newton-Schulz. En maintenant une meilleure approximation de la hessienne, ces optimiseurs fournissent des mises à jour de gradients plus informatives, accélérant la convergence et la performance finale. Muon, par exemple, utilise l’itération Newton-Schulz pour orthogonaliser la matrice des gradients, ce qui diffuse l’apprentissage sur plus de dimensions que les méthodes classiques à base de moment. Cela favorise un entraînement plus stable et encourage l’exploration de nouvelles régions de l’espace des paramètres. King K2 adopte une autre stratégie, suivant des quantités comme le log max par tête et ajustant dynamiquement les taux d’apprentissage et le clipping des gradients. L’innovation sur les optimiseurs a un impact majeur : beaucoup continuent à utiliser AdamW avec des hyperparamètres optimisés pour de petits modèles, même pour des modèles bien plus grands. Cela suggère que des gains de performance significatifs sont possibles en actualisant simplement les choix d’optimiseur et d’hyperparamètres pour les modèles modernes. Le domaine prend conscience que le choix de l’optimiseur n’est pas un problème résolu, et que l’innovation continue peut encore améliorer l’efficacité et la performance des modèles.

Maintenir des gradients de bonne qualité tout au long de l’entraînement est essentiel pour la performance des modèles. À mesure que les modèles atteignent des milliards, voire des trillions de paramètres, l’entraînement devient de plus en plus instable, avec des gradients susceptibles d’exploser ou de disparaître. Gérer ces problèmes exige une attention particulière à la qualité des gradients et la mise en œuvre de techniques assurant la stabilité tout au long du processus. Une approche classique consiste à appliquer du gradient clipping pour éviter que les gradients ne deviennent trop grands et n’instabilisent l’entraînement. Mais un clipping naïf peut supprimer des informations précieuses. Des méthodes plus sophistiquées normalisent les gradients de façon à préserver l’information tout en évitant l’instabilité. Un autre aspect crucial est le choix des fonctions d’activation et des techniques de normalisation des couches. Les fonctions d’activation influent fortement sur la propagation des gradients, et le choix optimal a un effet majeur sur la stabilité. La layer normalization, qui normalise les activations sur la dimension des caractéristiques, est devenue la norme sur les transformeurs car elle favorise un meilleur flux de gradients que la batch normalization. Le plan de taux d’apprentissage joue aussi un rôle clé : trop élevé, il provoque l’explosion des gradients ; trop faible, il ralentit la convergence. Les entraînements modernes utilisent souvent des plannings avec phase de warm-up, où le taux augmente progressivement pour stabiliser le modèle, suivie d’une phase de décroissance. Comprendre et optimiser ces aspects est crucial pour l’entraînement réussi de grands modèles, et reste un domaine de recherche actif.

La complexité de la pré-formation moderne — multiples objectifs d’optimisation, pipelines de données sophistiqués, réglages fins des hyperparamètres — pose de grands défis aux équipes souhaitant appliquer ces techniques. FlowHunt relève ces défis en fournissant une plateforme d’automatisation et d’orchestration des workflows d’entraînement de modèles. Plutôt que de gérer manuellement le traitement des données, l’entraînement et l’évaluation, les équipes peuvent définir des workflows automatisés avec FlowHunt, réduisant les erreurs et améliorant la reproductibilité. L’automatisation FlowHunt est particulièrement précieuse pour les étapes de curation et de traitement des données, si critiques pour la performance. La plateforme automatise les pipelines avancés de FineWeb et FinePDF : déduplication, filtrage, conversion de formats… Les équipes peuvent ainsi se concentrer sur les choix stratégiques et non sur les détails d’implémentation. FlowHunt facilite aussi la gestion de l’exploration d’hyperparamètres et des expérimentations nécessaires à l’optimisation. En automatisant les expérimentations et la collecte des résultats, FlowHunt permet une exploration plus efficace de l’espace des paramètres et une identification plus rapide des configurations optimales. Des outils de monitoring intégrés détectent les problèmes d’entraînement comme l’explosion des gradients et ajustent automatiquement les paramètres pour maintenir la stabilité. Pour les organisations qui développent ou affinent leurs modèles de langage, FlowHunt réduit considérablement le temps et l’effort nécessaires, tout en améliorant la qualité des résultats.

L’un des aspects les plus difficiles de l’entraînement de modèles est de comprendre comment passer de petits modèles à de grands modèles tout en maintenant stabilité et performance. La relation entre la taille du modèle et les hyperparamètres optimaux n’est pas triviale : les hyperparamètres adaptés aux petits modèles doivent souvent être ajustés pour les grands. C’est particulièrement vrai pour les taux d’apprentissage, généralement à réduire à mesure que la taille du modèle augmente. Comprendre les lois de passage à l’échelle est crucial pour prédire la performance et décider de l’allocation des ressources. Les recherches montrent que la performance suit des lois de puissance, où l’amélioration dépend de la taille du modèle, du dataset et du budget de calcul. Ces lois permettent d’anticiper les gains possibles en augmentant la taille du modèle ou du jeu de données, et donc de choisir où investir. Mais ces lois ne sont pas universelles : elles dépendent de l’architecture, de la procédure et du jeu de données utilisés. Les équipes doivent donc mener leurs propres expériences de passage à l’échelle. Ce passage s’accompagne de nouveaux défis de stabilité : plus le modèle est grand, plus il risque l’explosion ou la divergence des gradients. Les techniques comme le gradient clipping, un réglage fin du learning rate, voire des changements d’architecture ou d’optimiseur, sont alors nécessaires. La communauté prend conscience que l’enjeu n’est pas simplement de grossir les modèles, mais de maîtriser l’ensemble du processus pour garantir leur entraînement effectif.

L’apprentissage des caractéristiques désigne le processus par lequel les modèles apprennent à extraire des caractéristiques utiles à partir de données brutes. Pour les modèles de langage, cela revient à apprendre à représenter des concepts linguistiques, relations sémantiques et schémas syntaxiques en interne. Maximiser cet apprentissage — c’est-à-dire s’assurer que le modèle extrait le maximum d’information utile à chaque étape — est un objectif clé de l’entraînement moderne. On peut caractériser l’apprentissage des caractéristiques par l’ampleur des changements des représentations internes après chaque mise à jour de gradient : un modèle qui apprend efficacement voit ses représentations évoluer de façon significative pour améliorer ses prédictions. À l’inverse, des mises à jour inefficaces n’entraînent que de faibles changements ou n’améliorent pas la performance. Les techniques pour favoriser l’apprentissage des caractéristiques incluent l’initialisation soignée des poids, qui accélère l’apprentissage utile en début d’entraînement, ou l’usage de plannings de taux d’apprentissage permettant un apprentissage rapide au départ, puis plus lent à mesure que le modèle affine des schémas plus subtils. Le concept est lié à celui de « collapse des caractéristiques » : les modèles peuvent apprendre à ignorer certaines dimensions, trouvant des raccourcis performants mais réducteurs. La régularisation et le design de la fonction de perte aident à éviter ce collapse et à garantir l’apprentissage de caractéristiques diverses et utiles.

{{ cta-dark-panel heading=“Boostez votre workflow avec FlowHunt” description=“Découvrez comment FlowHunt automatise vos workflows IA et SEO — de la recherche à la génération de contenu, jusqu’à la publication et l’analyse — le tout en un seul endroit.” ctaPrimaryText=“Demander une Démo” ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo" ctaSecondaryText=“Essayez FlowHunt Gratuitement” ctaSecondaryURL=“https://app.flowhunt.io/sign-in" gradientStartColor="#123456” gradientEndColor="#654321” gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217” }}

Pendant plusieurs années, la tendance dominante en IA voulait que « plus gros = meilleur ». Cela a mené à une course à la taille, chaque entreprise voulant annoncer le modèle ayant le plus de paramètres. Mais les développements récents nuancent ce récit. Le succès de SmolLM 3 et d’autres modèles efficaces prouve que l’on peut atteindre des performances exceptionnelles avec des modèles bien plus petits. Ce changement traduit une compréhension plus profonde : la performance d’un modèle dépend de multiples facteurs, pas seulement du nombre de paramètres. Un modèle de 3 milliards de paramètres entraîné sur des données de qualité avec des techniques d’optimisation sophistiquées peut surpasser un modèle beaucoup plus gros, mais moins bien optimisé et avec des données de moindre qualité. Cette prise de conscience bouleverse le secteur. Elle suggère que la recherche la plus impactante ne consiste pas à construire les plus gros modèles, mais à améliorer la qualité des données, les techniques d’entraînement et les architectures. Cela démocratise aussi le développement de l’IA, permettant à des organisations modestes ou universitaires de concevoir des modèles compétitifs sans accès à des ressources massives. L’abandon du « tout-échelle » a aussi des implications pratiques : des modèles plus petits peuvent fonctionner sur des appareils en périphérie, dans des environnements contraints, avec moins de latence et de consommation énergétique. Cela ouvre les capacités avancées de l’IA à une gamme bien plus large d’applications et d’utilisateurs. La communauté de recherche admet de plus en plus que l’avenir de l’IA passera par un portefeuille de modèles de différentes tailles, chacun optimisé pour des cas d’usage spécifiques, plutôt que par une course au gigantisme.

L’ajustement des hyperparamètres consiste à choisir les valeurs des paramètres contrôlant l’entraînement, comme le taux d’apprentissage, la taille de batch, la décroissance pondérale… Ces paramètres impactent fortement la performance, et trouver les valeurs optimales est crucial. Souvent, cet ajustement reste empirique, relevant plus de l’art que de la science, avec beaucoup de tâtonnements. Les approches modernes explorent l’espace des hyperparamètres de façon plus systématique. Des techniques comme l’optimisation bayésienne permettent d’explorer efficacement l’espace des valeurs en identifiant les zones les plus prometteuses. La recherche en grille ou aléatoire, plus simples, peuvent aussi être efficaces, surtout combinées à l’exécution parallèle. Un enseignement clé des recherches récentes est que les hyperparamètres optimaux dépendent du modèle, du jeu de données et de la procédure d’entraînement. Cela impose de faire des balayages pour chaque nouveau modèle ou dataset, ce qui est coûteux mais souvent nécessaire pour une performance optimale. Comprendre le lien entre les hyperparamètres et la performance est aussi utile pour identifier les causes de problèmes d’entraînement : si l’entraînement est instable ou lent, cela tient souvent à des hyperparamètres inadaptés, pas à un défaut du modèle ou des données. L’exploration systématique de l’espace des hyperparamètres permet souvent d’identifier et de corriger ces problèmes.

Les enseignements de la recherche moderne sur la pré-formation des modèles ont des implications pratiques majeures pour les organisations qui développent ou affinent leurs modèles de langage. Avant tout, il faut investir massivement dans la curation et l’assurance qualité des données. Les preuves sont claires : des données de haute qualité valent plus qu’un grand volume de données médiocres. Cela implique de mettre en œuvre des pipelines sophistiqués de déduplication, filtrage, et standardisation des formats. Ensuite, il faut bien définir ses objectifs d’optimisation et s’assurer d’optimiser les bons critères : selon les applications, il faudra arbitrer entre taille du modèle, vitesse d’inférence et précision. Une définition claire de ces compromis en amont permet d’orienter les choix architecturaux et les procédures d’entraînement. Il est aussi important de se tenir informé des progrès récents en techniques d’entraînement et conception d’optimiseurs : le domaine évolue vite, et ce qui était à la pointe il y a un an est parfois dépassé. Lire les articles récents et expérimenter les nouvelles approches permet de rester compétitif. Enfin, investir dans des outils et des infrastructures facilitant la mise en œuvre de ces procédures sophistiquées (comme FlowHunt pour automatiser la curation et l’entraînement, ou des infrastructures pour l’expérimentation rapide) est crucial. Il faut aussi reconnaître que le développement de modèles ne se limite pas à l’entraînement, mais inclut l’évaluation, le débogage et l’itération systématiques, avec des benchmarks variés et des analyses de cas d’échec.

La pré-formation des modèles évolue rapidement, avec l’apparition régulière de nouvelles techniques et idées. Plusieurs tendances se dessinent pour l’avenir. D’abord, l’accent va rester mis sur la qualité et la curation des données : la reconnaissance de la supériorité de la qualité sur la quantité va conduire à des pipelines encore plus sophistiqués et à davantage de recherches sur la définition de « bonnes données ». Ensuite, l’innovation sur les optimiseurs et la dynamique d’entraînement va se poursuivre, comme le montrent les succès de Muon ou King K2. Troisième tendance : l’accent croissant sur l’efficacité et le déploiement pratique, avec des recherches sur la compression, la quantification et la distillation des modèles. Quatrième axe, l’interprétabilité : à mesure que les modèles deviennent plus puissants, comprendre leur fonctionnement et leurs décisions devient crucial. Enfin, la démocratisation de la construction de modèles va s’accélérer, avec de plus en plus d’outils et de techniques permettant à des équipes modestes ou universitaires de construire des modèles compétitifs.

L’approche moderne de la pré-formation des modèles de langage marque une évolution majeure par rapport aux méthodes plus simples du passé. Plutôt que de simplement augmenter la taille des données et des ressources de calcul, le succès repose désormais sur l’orchestration minutieuse de multiples objectifs d’optimisation, des techniques sophistiquées de curation de données et une innovation continue des méthodes d’entraînement et des optimiseurs. SmolLM 3, FineWeb et FinePDF incarnent ce nouveau paradigme, démontrant qu’une attention rigoureuse à la qualité des données, à l’efficacité architecturale et à l’optimisation de l’entraînement permet d’atteindre des performances exceptionnelles. Le passage du « tout-échelle » à l’efficacité et la qualité marque la maturation du domaine et ouvre la voie à une démocratisation de l’IA. Les organisations qui comprennent et appliquent ces principes seront mieux placées pour développer des modèles compétitifs, qu’il s’agisse de créations originales ou de fine-tuning. La communauté de recherche continue de repousser les limites, avec de nouvelles techniques et idées qui émergent sans cesse. En restant informées et en investissant dans les bons outils et infrastructures, les organisations s’assurent de construire des modèles à la pointe du développement.

SmolLM 3 est un modèle de 3 milliards de paramètres conçu pour maximiser l'efficacité tout en maintenant de hautes performances sur plusieurs langues et des tâches de raisonnement à long contexte. Contrairement aux modèles plus grands, SmolLM 3 vise une performance optimale dans des contraintes de calcul, le rendant idéal pour le déploiement sur des appareils en périphérie et des environnements à ressources limitées.

Le principe du 'garbage in, garbage out' est fondamental en apprentissage automatique. Des données de haute qualité et diversifiées impactent directement la performance du modèle, bien plus que la simple quantité. FineWeb et FinePDF démontrent qu'une curation, une déduplication et un filtrage minutieux des données d'entraînement produisent des résultats nettement supérieurs à ceux de jeux de données bruts et non traités.

La distillation des connaissances est une technique où un modèle plus petit apprend à partir d'un modèle plus grand et plus performant. Pendant la pré-formation, cette approche permet aux petits modèles d'extraire un maximum d'informations des données d'entraînement en apprenant des schémas déjà découverts par les grands modèles, ce qui aboutit à de meilleures performances avec moins de paramètres.

La prédiction multi-tokens entraîne les modèles à prédire plusieurs tokens futurs simultanément plutôt qu'un seul. Cette approche est particulièrement efficace pour les tâches de codage et améliore la capacité du modèle à comprendre les dépendances à long terme, ce qui conduit à de meilleures performances sur des tâches de raisonnement complexes.

Les optimiseurs modernes comme Muon vont au-delà de l'AdamW traditionnel en utilisant des techniques telles que les méthodes Newton-Schulz pour mieux approximer la matrice hessienne. Cela permet un entraînement plus stable, une meilleure qualité des gradients et une dynamique d'apprentissage améliorée, notamment lors du passage à des modèles de plus grande taille.

Arshia est ingénieure en workflows d'IA chez FlowHunt. Avec une formation en informatique et une passion pour l’IA, elle se spécialise dans la création de workflows efficaces intégrant des outils d'IA aux tâches quotidiennes, afin d’accroître la productivité et la créativité.

FlowHunt aide les équipes à rationaliser les pipelines de pré-formation, de traitement des données et d'optimisation des modèles grâce à l'automatisation intelligente.

Hugging Face Transformers est une bibliothèque Python open-source de premier plan qui facilite la mise en œuvre de modèles Transformer pour des tâches d'apprent...

Découvrez comment les chercheurs du MIT font progresser les grands modèles de langage (LLM) grâce à de nouvelles perspectives sur les croyances humaines, des ou...

Découvrez les meilleurs grands modèles de langage (LLM) pour le codage en juin 2025. Ce guide éducatif complet propose des analyses, des comparaisons et des con...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.