Sora 2 : Génération vidéo IA pour les créateurs de contenu

Découvrez les capacités révolutionnaires de Sora 2 en génération vidéo par IA, de la reconstitution réaliste de personnages à la simulation physique, et voyez c...

Découvrez les capacités révolutionnaires de Sora 2 en matière de génération vidéo par IA, depuis la recréation réaliste de personnages jusqu’à la simulation physique, et voyez comment cette technologie transforme la création et l’automatisation de contenu.

Sora 2 représente un bond en avant majeur dans la technologie de génération vidéo par intelligence artificielle. La dernière évolution du modèle vidéo d’OpenAI apporte des capacités inédites aux créateurs de contenu, aux marketeurs et aux entreprises souhaitant rationaliser leurs processus de production vidéo. Ce guide complet explore les fonctionnalités remarquables de Sora 2, ses applications pratiques, et les implications pour l’avenir de la création de contenu. De la recréation de personnages fictifs populaires à la génération de performances humaines réalistes, Sora 2 démontre le potentiel transformateur de l’IA générative dans la production visuelle. Que vous soyez intéressé par les aspects techniques, les possibilités créatives ou les usages business, cet article vous propose une analyse approfondie de ce qui fait de Sora 2 une technologie révolutionnaire.

La génération vidéo par intelligence artificielle représente l’un des domaines les plus passionnants de l’IA générative. Contrairement à la production vidéo traditionnelle — qui nécessite caméras, acteurs, équipements d’éclairage et un important travail de postproduction — la génération vidéo par IA crée des vidéos directement à partir de descriptions textuelles ou de prompts. La technologie s’appuie sur des modèles d’apprentissage profond entraînés sur d’immenses bases de vidéos pour comprendre la relation entre les descriptions textuelles et le contenu visuel. Ces modèles apprennent à reconnaître comment les objets se déplacent, comment la lumière interagit avec les surfaces, comment les gens gesticulent et expriment des émotions, et comment les scènes évoluent naturellement. Lorsqu’un utilisateur fournit un prompt textuel, le modèle IA traite l’information et génère la vidéo image par image, assurant la cohérence de l’apparence des personnages, des mouvements et des détails d’environnement tout au long de la séquence. Sous le capot, la technologie repose sur des modèles de diffusion et des architectures de type transformeur spécialement adaptés à la génération vidéo, permettant au système de maintenir une cohérence temporelle — c’est-à-dire que les objets et personnages se déplacent naturellement et de façon continue d’une image à l’autre, au lieu de « sauter » ou de clignoter à l’écran.

L’importance de la génération vidéo par IA va bien au-delà de la simple nouveauté. Cette technologie répond à des défis fondamentaux de la création de contenu : le temps, le coût et l’évolutivité. Une production vidéo traditionnelle peut prendre des semaines ou des mois et mobiliser des équipes de professionnels (réalisateurs, cadreurs, monteurs, spécialistes des effets spéciaux…). La génération vidéo par IA peut produire des résultats comparables en quelques minutes, la rendant accessible aux petites entreprises, créateurs indépendants ou sociétés qui n’avaient pas les moyens de produire des vidéos professionnelles. La démocratisation de la création vidéo via l’IA a un impact profond sur le marketing, l’éducation, le divertissement et la communication d’entreprise. Plus ces systèmes gagnent en sophistication et en accessibilité, plus ils bouleversent la manière dont les organisations abordent la stratégie de contenu visuel et les processus de production.

L’intérêt business pour la génération vidéo par IA est à la fois convaincant et multiple. À l’ère numérique, la vidéo domine tous les indicateurs d’engagement sur les plateformes. Selon les données du secteur, la vidéo génère des taux d’engagement nettement supérieurs à ceux des images ou du texte, et des plateformes comme TikTok, YouTube ou Instagram privilégient la vidéo dans leurs algorithmes. Pourtant, produire des vidéos de qualité à grande échelle est resté jusqu’ici coûteux pour la plupart des organisations. La génération vidéo par IA lève cette barrière en permettant de produire un nombre illimité de variantes pour l’A/B testing, la personnalisation et l’itération rapide. Les équipes marketing peuvent générer des dizaines de démonstrations produits dans différents styles sans refaire de tournage. Les établissements d’enseignement peuvent créer du contenu pédagogique personnalisé à grande échelle. Les services clients peuvent générer des vidéos de formation en temps réel pour de nouvelles procédures. L’impact économique est considérable : il est possible de réduire les coûts de production vidéo de 70 à 90 %, tout en multipliant la quantité produite.

Au-delà de la réduction des coûts, la génération vidéo par IA autorise de nouvelles formes de créativité et d’expérimentation. Les créateurs peuvent tester des idées folles sans engager trop de ressources. Ils peuvent générer plusieurs versions d’un concept pour voir celle qui plaît le plus à l’audience. Ils peuvent créer du contenu dans différents styles ou formats pour s’adapter à chaque cible ou plateforme. Cette flexibilité transforme la vidéo d’une ressource rare et planifiée en un support abondant et expérimental. Les répercussions sur la stratégie de contenu sont profondes : au lieu de miser sur quelques productions vidéo majeures par trimestre, les organisations peuvent adopter un flux continu de création où la vidéo devient aussi courante que la publication d’articles de blog. Ce changement permet un contenu plus réactif, personnalisé et pertinent, répondant mieux aux besoins de l’audience et aux objectifs business. En outre, la génération vidéo par IA ouvre la voie à du contenu interactif et dynamique, capable de s’adapter à chaque spectateur, et offrant ainsi des opportunités inédites d’engagement et de conversion.

Sora 2 améliore les précédents modèles de génération vidéo sur de nombreux aspects. La première amélioration visible concerne la qualité visuelle et le réalisme spectaculaires. Les vidéos générées par Sora 2 affichent un éclairage plus précis, une colorimétrie naturelle, des textures détaillées et des matériaux convaincants. Visionner une vidéo Sora 2 donne souvent l’impression de regarder une production cinématographique professionnelle. Le modèle excelle dans le rendu de scènes complexes avec plusieurs objets, maintient une cohérence d’éclairage sur toute l’image et crée des reflets et ombres réalistes. Ce niveau de qualité visuelle est crucial pour les usages professionnels où un rendu médiocre nuirait à la crédibilité ou à l’image de marque.

La simulation physique constitue un autre progrès majeur de Sora 2. Les anciens modèles avaient souvent du mal à respecter la physique : objets se déplaçant de façon invraisemblable, gravité incohérente, collisions non prises en compte… Sora 2 comprend beaucoup mieux les lois physiques et la façon dont les objets interagissent avec leur environnement. Quand une balle est lancée, sa trajectoire est réaliste. Quand une personne marche, la répartition du poids et les mouvements sont naturels. Lors de collisions, l’interaction paraît plausible. Cette évolution est particulièrement importante pour les cas où la justesse physique est cruciale (démonstrations produits, contenus éducatifs ou divertissement où le public repère vite les incohérences). La meilleure compréhension de la physique permet aussi de générer des scènes dynamiques et complexes, impossibles avec les générations précédentes.

La cohérence temporelle est aussi un point clé qui rend les vidéos de Sora 2 crédibles, comme de véritables enregistrements plutôt qu’une suite d’images indépendantes. Le modèle conserve l’identité des personnages sur toute la durée d’une vidéo : une personne garde le même visage et n’« évolue » pas d’un plan à l’autre. Les détails d’environnement restent constants — une plante en arrière-plan au début d’une vidéo y restera jusqu’à la fin, sans changer d’aspect. Cette cohérence est essentielle pour les usages pros et crée une expérience immersive. Le modèle comprend aussi mieux les mouvements et enchaînements d’actions, générant des transitions naturelles et fluides.

L’une des fonctionnalités les plus impressionnantes de Sora 2 est sa capacité à recréer fidèlement des visages humains grâce au scan facial. Les utilisateurs qui se prêtent à l’exercice rapportent que le modèle atteint environ 90 % de fidélité, que ce soit pour les traits, les expressions ou des détails subtils comme la texture de peau ou les reflets lumineux. Ce niveau de précision ouvre des perspectives dignes de la science-fiction. Regarder une vidéo générée de soi-même par Sora 2 est troublant : c’est bien vous, mais dans des situations inédites, effectuant des actions jamais réalisées. Le modèle ne se contente pas de reproduire les traits statiques, il capture aussi la dynamique du visage et les émotions. L’éclairage du visage paraît naturel, les reflets animent le regard, et les détails comme la texture de la peau ou le mouvement des cheveux sont bluffants.

Les implications de cette technologie sont enthousiasmantes mais aussi préoccupantes. Côté positif, les créateurs peuvent désormais générer du contenu à leur image sans être physiquement présents. Un youtubeur peut produire des dizaines de variantes d’une vidéo sans multiplier les prises. Un enseignant peut créer des contenus pédagogiques personnalisés le mettant en scène. Un dirigeant peut enregistrer des messages ou formations sans planifier de tournage. Le gain de temps et d’argent est énorme. Mais cette faculté pose aussi des questions de consentement, d’authenticité et de risques d’abus. On pourrait théoriquement produire des deepfakes ou des contenus trompeurs avec de vraies personnes sans leur accord. OpenAI a mis en place des garde-fous, notamment la possibilité de contrôler l’utilisation de son image, mais le potentiel d’abus reste une préoccupation majeure qui devra être régulée.

Sora 2 permet des usages créatifs jusqu’ici impossibles ou trop coûteux. L’un des plus amusants consiste à recréer des personnages fictifs et à les placer dans de nouveaux contextes. Des utilisateurs ont généré des vidéos de SpongeBob interprétant du rap drill, avec un rendu fidèle du personnage, du style d’animation et même de la voix. Le modèle saisit l’esthétique propre au personnage et la maintient sur toute la vidéo. De même, des scènes de jeux vidéo cultes comme Halo ont été recréées avec précision, y compris le style graphique, l’interface et la voix du narrateur. Ces exemples montrent la capacité de Sora 2 à comprendre et reproduire des styles visuels, des designs de personnages ou des conventions esthétiques spécifiques.

Les possibilités vont jusqu’à créer de nouveaux contenus dans l’esprit de franchises existantes. Des utilisateurs ont généré de véritables épisodes de SpongeBob en enchaînant plusieurs clips Sora 2, obtenant des histoires cohérentes avec un style visuel continu. Cette faculté laisse entrevoir un avenir où l’IA pourrait assister la production d’animation, générant des scènes clés que les animateurs humains pourraient ensuite affiner. La technologie pourrait démocratiser l’animation, permettant à des créateurs indépendants de produire du contenu animé sans équipe. La recréation de jeux vidéo est aussi fascinante : certains ont intégré des personnages dans l’univers Minecraft ou recréé Mario Kart en style photoréaliste. Ces usages démontrent la flexibilité du modèle, capable de s’adapter à divers styles et contextes.

Même si Sora 2 marque une avancée majeure, il est important d’en connaître les limites actuelles. Les tests révèlent que si la recréation faciale est généralement fidèle, il existe des cas où le modèle manque de cohérence d’un rendu à l’autre. Pour un même prompt, la vidéo générée peut varier sensiblement : parfois le visage est parfait, parfois il présente de légères déformations ou des différences dans les traits. Cette variation indique que la qualité du rendu n’est pas encore totalement déterministe, et il faudra parfois générer plusieurs vidéos pour obtenir un résultat satisfaisant. L’inconstance est surtout visible dans des cas complexes ou limites.

La dextérité des mains et la manipulation d’objets restent aussi un point faible des vidéos Sora 2. Dès que la scène implique des mouvements détaillés des mains ou la prise d’objets, le rendu devient souvent peu convaincant : les mains peuvent être déformées, les doigts bouger de façon étrange ou les objets mal tenus. Cette limite se remarque surtout dans les activités demandant de la précision, comme jouer d’un instrument, opérer ou effectuer des gestes techniques. Cela reflète une difficulté plus large des IA à comprendre et reproduire la biomécanique complexe de la main humaine. L’amélioration du rendu des mains est un axe de recherche prioritaire dans le domaine.

Des erreurs de physique apparaissent aussi parfois, surtout dans des scénarios complexes avec de nombreux objets ou forces. Certaines vidéos montrent des voitures roulant à l’envers, des objets flottant au lieu de tomber, ou des collisions non prises en compte. Ces erreurs sont moins fréquentes qu’avec les anciens modèles mais restent perceptibles dans les cas limites ou mal représentés dans les données d’entraînement. La synthèse vocale requiert également des progrès : selon la voix générée et la complexité du texte, le résultat peut être artificiel ou présenter des artefacts numériques.

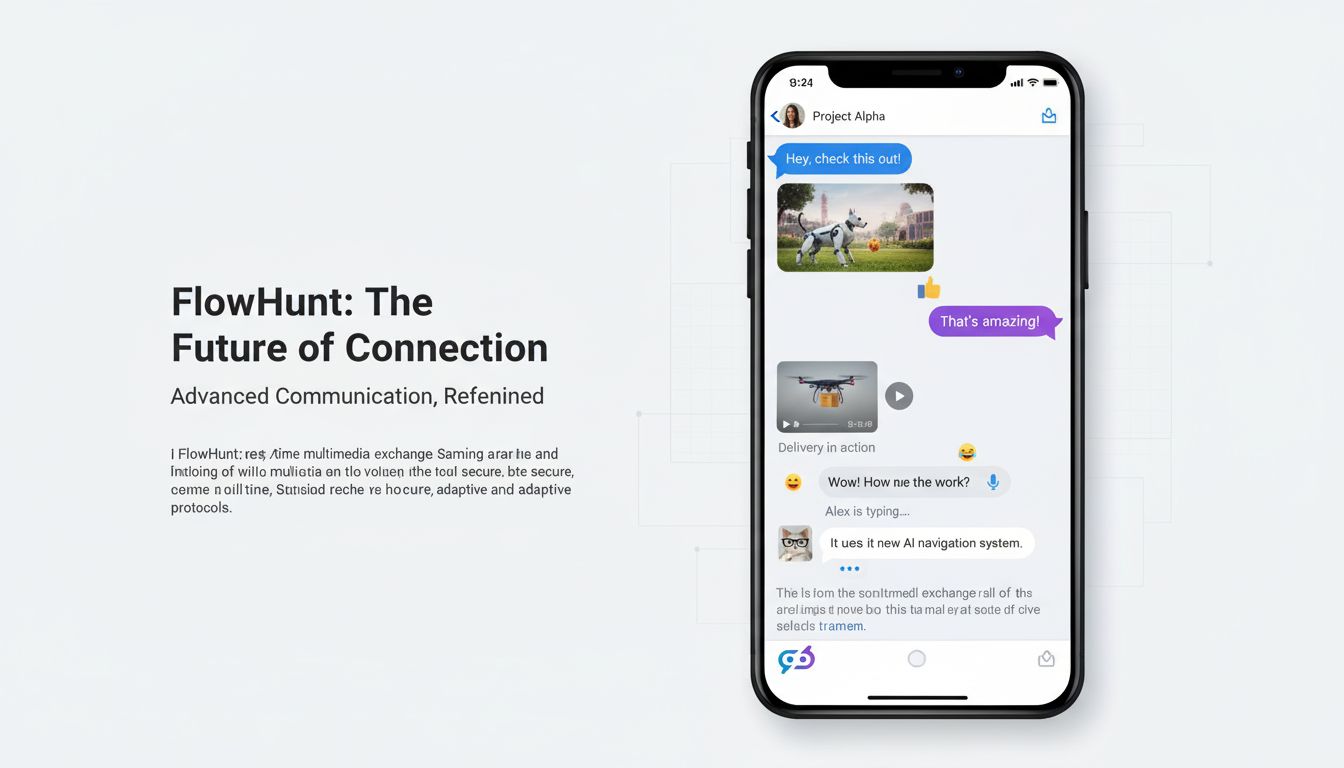

FlowHunt a compris le potentiel transformateur de la génération vidéo par IA et intègre ces capacités à sa plateforme d’automatisation pour aider les entreprises à fluidifier leur production de contenu. Plutôt que de considérer la génération vidéo comme un outil isolé, FlowHunt l’intègre dans un écosystème complet d’automatisation du contenu. Cette approche permet de créer des flux de travail de bout en bout mêlant génération vidéo, création de contenu, diffusion et analyse. Par exemple, une équipe marketing peut générer automatiquement des démonstrations produits, ajouter des sous-titres et du branding, publier sur plusieurs plateformes et suivre l’engagement — le tout sans intervention manuelle.

L’intégration de Sora 2 et de modèles similaires au sein de FlowHunt permet de déployer de puissants scénarios d’automatisation. Les équipes peuvent planifier des tâches récurrentes de génération vidéo. Les e-commerçants automatisent les vidéos produits pour chaque nouvel article. Les marketeurs créent des variantes personnalisées pour chaque segment d’audience. Les établissements éducatifs produisent du contenu de formation à la demande. Les services clients génèrent des tutoriels vidéo pour les questions fréquentes. En combinant génération vidéo et automatisation des workflows, les organisations atteignent une échelle et une efficacité inédites. La plateforme orchestre, programme et connecte les différents outils, libérant les équipes pour la stratégie et la créativité.

Les applications de Sora 2 couvrent pratiquement tous les secteurs et fonctions. En marketing et publicité, Sora 2 permet de générer des vidéos démonstration, des témoignages clients ou des spots promotionnels à grande échelle. Les marques peuvent créer plusieurs versions d’une pub pour tester différents messages, styles ou appels à l’action. Les sites e-commerce produisent des vidéos produits pour des milliers d’articles sans tournages individuels. Les agents immobiliers créent des visites virtuelles. Les agences de voyage réalisent des vidéos de destination. Les gains de temps et de budget sont transformateurs pour les équipes marketing.

En formation et éducation, Sora 2 ouvre la voie à la création de contenus pédagogiques personnalisés, de tutoriels et de supports d’apprentissage. Les établissements peuvent générer des vidéos avec les enseignants dans des contextes variés, expliquant des notions de différentes façons. Les services RH créent des vidéos d’onboarding, de sécurité ou de développement professionnel. Le contenu peut être mis à jour en temps réel selon les besoins. La personnalisation à grande échelle devient possible : chaque apprenant peut recevoir des vidéos adaptées à son style, son rythme, ses acquis.

Dans le divertissement et la production audiovisuelle, Sora 2 ouvre de nouvelles possibilités pour l’animation, les effets spéciaux ou la création de contenu, au-delà des contraintes de temps ou de budget. Les créateurs indépendants produisent des animations sans équipe. Le cinéma et la télévision utilisent l’IA pour les effets spéciaux, les décors ou même des scènes entières. Les clips musicaux sont générés pour accompagner des chansons. Les plateformes de streaming produisent du contenu original plus efficacement. La technologie démocratise la production de divertissement, rendant accessible la qualité pro.

En communication d’entreprise et opérations internes, Sora 2 permet de produire des messages exécutifs, annonces, vidéos de formation ou documentation interne. Les dirigeants enregistrent des messages personnalisés sans tournage. Les RH créent des vidéos pour les nouvelles procédures. Les équipes IT génèrent des tutoriels logiciels. Grâce à la rapidité et au faible coût, la communication interne gagne en fréquence et en efficacité.

L’IA vidéo évolue aujourd’hui dans une sorte de « far west » du droit d’auteur. Sora 2 peut générer des vidéos mettant en scène des personnages, célébrités ou propriétés intellectuelles protégées sans autorisation explicite. Il est possible de créer des vidéos de SpongeBob, Mario, Zelda, ou de personnalités publiques. Cette capacité soulève de sérieuses questions légales et éthiques sur le droit d’auteur, le consentement et l’usage approprié des contenus générés par IA. Comme la technologie peut recréer si fidèlement des personnages ou visages, le risque d’abus est réel.

OpenAI a intégré certains garde-fous, notamment la possibilité pour chaque utilisateur de contrôler l’usage de son image (paramètres de caméo). Mais ces mécanismes restent limités et ne règlent pas la question de fond : une IA devrait-elle pouvoir générer des contenus mettant en scène des personnages ou célébrités protégés sans autorisation ? Le cadre légal reste flou, avec des juges et régulateurs qui tâtonnent sur la notion d’usage équitable, de contrefaçon ou de limites à fixer. Certains estiment qu’un usage personnel relève du fair use, d’autres exigent une autorisation pour tout usage commercial. La question se complique encore car chaque pays a ses propres lois sur le droit d’auteur.

Les enjeux éthiques dépassent la question du copyright : consentement, authenticité, risques d’abus. Si un spectateur voit une vidéo d’une célébrité, il peut la croire authentique à moins d’un avertissement explicite. Cela ouvre la porte à la tromperie ou à la désinformation. La technologie pourrait servir à créer des deepfakes nuisibles ou trompeurs. Même si les limites actuelles de Sora 2 rendent difficile la création de deepfakes totalement convaincants, la technologie progresse vite. La société devra établir des normes, des régulations et des garde-fous techniques pour éviter les abus tout en préservant les bénéfices légitimes.

Les progrès de Sora 2 s’appuient sur plusieurs avancées techniques. Le modèle utilise des architectures de diffusion améliorées qui comprennent mieux la relation entre texte et image. L’entraînement s’appuie sur des vidéos plus variées et de meilleure qualité, permettant au modèle de saisir des patterns plus fins sur le fonctionnement du monde réel. Sa compréhension de la physique, de l’éclairage et des matériaux s’est accrue grâce à de meilleures données et à des fonctions de perte pénalisant les rendus irréalistes. Les progrès en cohérence temporelle sont dus à de meilleurs mécanismes de maintien de l’état d’une image à l’autre, et à une attention accrue aux dépendances longues dans les séquences vidéo.

La recréation faciale repose sur des modules spécialisés capables d’encoder les traits et l’identité de façon durable sur toute la vidéo. Ces modules utilisent sans doute des techniques proches de la reconnaissance faciale, adaptées à la génération vidéo. Le modèle apprend à associer l’identité à des motifs visuels spécifiques, et maintient cette association tout au long de la génération. La synthèse vocale bénéficie aussi de modèles texte-vers-parole améliorés et d’une meilleure intégration entre la génération vidéo et audio, permettant d’obtenir des voix mieux synchronisées avec les mouvements labiaux et les expressions.

Même si Sora 2 marque une avancée, il importe de savoir comment il se positionne face aux autres modèles du marché. D’autres outils comme Runway, Synthesia ou des alternatives open source ont chacun leurs points forts. Runway, par exemple, mise sur l’accessibilité et une communauté active. Synthesia se spécialise dans la génération de vidéos avatars pour la communication d’entreprise. Les modèles open source comme Stable Video Diffusion offrent personnalisation et flexibilité aux développeurs. Sora 2 se distingue par sa qualité visuelle supérieure, sa meilleure simulation physique et la fidélité de la recréation des personnages. Sa capacité à générer des vidéos plus longues et à gérer des scènes complexes lui donne un avantage dans bien des usages.

Cependant, Sora 2 a aussi ses limites. Certains modèles offrent une génération en temps réel ou consomment moins de ressources. D’autres permettent un contrôle plus granulaire sur chaque aspect de la vidéo générée, ou une meilleure intégration à des plateformes spécifiques. Le choix du modèle dépend des besoins, cas d’usage et contraintes. Pour une qualité visuelle maximale et du réalisme, Sora 2 est un excellent choix. Pour des besoins de génération instantanée ou de personnalisation avancée, d’autres solutions peuvent être préférables. Le domaine évolue vite ; on peut s’attendre à des progrès constants et à l’émergence de nouveaux modèles spécialisés.

Découvrez comment FlowHunt automatise vos workflows de génération de contenu et de vidéo par IA — de la recherche à la publication et l’analyse, tout en un seul endroit.

La trajectoire de la génération vidéo par IA montre que nous ne sommes qu’au tout début des possibles. Les prochaines versions de Sora et des modèles concurrents devraient corriger les limites actuelles (mains, physique, cohérence…). On peut s’attendre à des améliorations sur la longueur des vidéos, la résolution, et la capacité à gérer des scènes toujours plus complexes. Les modèles deviendront plus efficients, nécessitant moins de puissance de calcul. L’intégration à d’autres systèmes IA permettra des workflows plus sophistiqués, associant génération vidéo, création de contenu et analyse.

Les conséquences pour la création de contenu sont majeures. À mesure que la génération vidéo par IA devient plus puissante et accessible, la vidéo s’imposera comme un média aussi courant que le texte dans la communication numérique. Les organisations cesseront de voir la vidéo comme une ressource rare et planifiée, et l’envisageront comme un support abondant et expérimental. Cela permettra du contenu plus personnalisé, réactif et engageant. Mais cela posera aussi des défis d’authenticité, de désinformation, et la nécessité de nouveaux standards ou réglementations autour du contenu généré par IA. La technologie devrait bouleverser les industries créatives, supprimer certains métiers tout en créant de nouvelles opportunités pour ceux capables de piloter et valoriser le contenu IA.

Pour les organisations souhaitant exploiter Sora 2, quelques bonnes pratiques permettent d’optimiser les résultats. D’abord, bien cerner les points forts et limites du modèle : Sora 2 excelle sur les scènes réalistes, l’éclairage et la physique, mais peine avec les mains complexes et peut produire des résultats variables. Concevez des prompts qui tirent parti de ces atouts. Ensuite, générez plusieurs variantes pour un même prompt et retenez les meilleures : la variabilité du modèle fait qu’il faut parfois plusieurs essais. Utilisez le scan facial pour la recréation de personnages quand la fidélité est cruciale : cette fonction est bien plus précise qu’une simple description textuelle.

Autre astuce : découpez les vidéos complexes en plusieurs clips chaînés plutôt que d’essayer de tout générer en une fois. Cela donne un meilleur contrôle et améliore souvent le rendu final. Rédigez des prompts détaillés, précisant non seulement l’action mais aussi le style visuel, l’éclairage, l’ambiance… Les prompts vagues donnent des résultats médiocres, tandis qu’un prompt précis (détails visuels, angles de caméra, préférences esthétiques) produit des vidéos bien meilleures. Enfin, intégrez la génération vidéo à des workflows de contenu plus larges avec des outils comme FlowHunt qui automatisent la création, la publication et l’analyse. Ce mode de production maximise l’efficacité et permet de passer à l’échelle.

Avec la généralisation de la vidéo générée par IA, les préoccupations sur l’authenticité, la désinformation ou la disparition d’emplois sont légitimes. Les organisations doivent jouer la transparence sur l’usage de l’IA, surtout là où le public pourrait croire le contenu authentique. Préciser qu’un contenu est généré par IA renforce la confiance et permet au public de mieux comprendre ce qu’il regarde. Cette transparence est cruciale lorsque le contenu influence des décisions importantes. Dans les secteurs réglementés (santé, finance, juridique…), il peut exister des exigences spécifiques de divulgation.

Le risque d’abus via les deepfakes et la désinformation est réel et nécessite des mesures proactives. Les filigranes techniques (watermarking) permettent d’identifier les médias synthétiques. Les politiques et régulations devront évoluer. L’éducation aux médias aidera le public à comprendre le fonctionnement de l’IA et à développer son esprit critique. Les organisations devraient aussi se doter de politiques internes sur les usages appropriés de la génération vidéo et s’engager à utiliser la technologie de façon responsable. L’objectif : tirer parti des bénéfices de l’IA tout en prévenant les dérives et en maintenant la confiance dans l’information.

Sora 2 marque un tournant dans la génération vidéo par IA, offrant des capacités dignes de la science-fiction. Sa faculté à générer des vidéos réalistes, physiquement plausibles et à recréer fidèlement des personnages ouvre des perspectives inédites pour les créateurs, marketeurs, enseignants ou entreprises de tous secteurs. Si des limites subsistent (mains, cohérence physique, variabilité), la dynamique de progrès est nette. La technologie va continuer de s’améliorer, gagner en puissance, en efficacité et en accessibilité. Les organisations qui comprennent les forces et faiblesses de Sora 2 et l’intègrent à leur production de contenu bénéficieront d’avantages compétitifs : coûts réduits, volume augmenté, possibilité d’expérimenter à grande échelle. Mais ce pouvoir implique une responsabilité : il faudra anticiper les risques d’abus, communiquer de façon transparente sur les contenus IA, et mettre en place des garde-fous éthiques. À mesure que Sora 2 et ses équivalents bouleversent la création de contenu, la réussite ira à ceux qui sauront exploiter la technologie tout en restant authentiques, transparents et responsables.

Sora 2 est le dernier modèle de génération vidéo d'OpenAI, capable de créer des vidéos réalistes et physiquement cohérentes à partir de prompts textuels. Il améliore les anciens systèmes grâce à une meilleure simulation physique, une qualité de rendu supérieure, des vidéos plus longues et des contrôles créatifs plus avancés pour les utilisateurs.

Oui, Sora 2 peut reproduire l’apparence de personnes réelles avec une grande précision grâce à la technologie de scan facial. Les utilisateurs rapportent que le modèle atteint environ 90 % de fidélité pour la reproduction des traits, expressions et même des éléments d’arrière-plan, lorsque des données de référence appropriées sont fournies.

Bien que très performant, Sora 2 présente encore certaines limites : il arrive parfois que le modèle fusionne plusieurs sujets, que la dextérité des mains reste incohérente, qu’il produise des erreurs physiques dans des scènes complexes, ou que la qualité varie d’un rendu à l’autre pour un même prompt. La synthèse vocale nécessite également des améliorations dans certains cas.

Les entreprises peuvent s’appuyer sur Sora 2 pour créer des vidéos marketing, des démonstrations produits, des contenus de formation, des clips pour les réseaux sociaux ou du divertissement. Cette technologie réduit considérablement le temps et les coûts de production en automatisant la création vidéo à partir de descriptions textuelles, ce qui la rend précieuse dans les secteurs du marketing, de l’éducation ou du divertissement.

Arshia est ingénieure en workflows d'IA chez FlowHunt. Avec une formation en informatique et une passion pour l’IA, elle se spécialise dans la création de workflows efficaces intégrant des outils d'IA aux tâches quotidiennes, afin d’accroître la productivité et la créativité.

Intégrez la génération vidéo par IA à votre pipeline de contenu et rationalisez la production, de l'idée à la publication.

Découvrez les capacités révolutionnaires de Sora 2 en génération vidéo par IA, de la reconstitution réaliste de personnages à la simulation physique, et voyez c...

Découvrez tout ce qu’il faut savoir sur l’application Sora-2xa0: ses capacités, ses cas d’utilisation et sa comparaison avec les principaux générateurs vidéo IA...

Intégrez FlowHunt avec le serveur Creatify MCP pour automatiser la génération de vidéos avatar IA, simplifier les flux de travail vidéo et améliorer la création...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.