Introduction

Le paysage de l’intelligence artificielle connaît une accélération sans précédent, avec des technologies de rupture qui émergent simultanément dans de multiples domaines. Des lunettes intelligentes portables qui augmentent la perception humaine aux modèles de raisonnement capables de surpasser les humains dans la résolution de problèmes complexes, la convergence de ces innovations transforme fondamentalement notre manière d’interagir avec la technologie et d’automatiser nos flux de travail. Cette exploration approfondie examine les avancées majeures de l’IA en 2025, notamment les lunettes Ray-Ban de Meta, les capacités de raisonnement surhumain d’OpenAI, la technologie révolutionnaire de génération de mondes 3D et l’infrastructure émergente permettant aux agents autonomes de collaborer et de réaliser des transactions. Comprendre ces évolutions est essentiel pour les entreprises et les particuliers souhaitant exploiter le potentiel transformateur de l’IA dans leurs opérations et leur stratégie.

Comprendre l’état actuel du matériel IA et des objets connectés

L’évolution de l’intelligence artificielle a longtemps été limitée par les interfaces qui relient l’humain aux systèmes intelligents. Pendant des décennies, nous avons utilisé claviers, souris et écrans pour communiquer avec les ordinateurs, créant une dissonance fondamentale entre nos modes de perception naturels et les outils numériques. L’émergence de l’IA portable représente un changement de paradigme, faisant passer l’informatique de dispositifs fixes à des formats qui s’intègrent naturellement à notre quotidien. L’investissement de Meta dans les lunettes Ray-Ban illustre cette transition, s’appuyant sur des décennies de recherche en réalité augmentée et l’expérience de la société avec la plateforme Oculus. L’importance de ce changement est considérable : environ un tiers de la population mondiale porte des lunettes quotidiennement, représentant un marché colossal pour des lunettes enrichies par l’IA. En intégrant directement des capacités IA à un objet déjà porté, Meta se positionne à l’intersection de l’informatique personnelle et de l’intelligence artificielle, créant une plateforme où l’IA peut observer, comprendre et interagir avec le monde en temps réel aux côtés de l’utilisateur.

Prêt à développer votre entreprise?

Commencez votre essai gratuit aujourd'hui et voyez les résultats en quelques jours.

Pourquoi les objets connectés IA sont cruciaux pour l’avenir du travail et de l’interaction

Les implications des objets connectés enrichis par l’IA dépassent largement la commodité grand public et touchent des aspects fondamentaux de notre façon de travailler, d’apprendre et de communiquer. Quand un système IA peut voir ce que vous voyez, entendre ce que vous entendez et projeter de l’information directement dans votre champ de vision, cela transforme profondément la nature de l’interaction humain-machine. Au lieu d’interrompre votre activité pour consulter un appareil, l’information s’affiche naturellement devant vos yeux. Plutôt que de taper une requête, vous pouvez simplement parler à votre assistant IA tout en restant concentré sur votre environnement physique. Pour les applications professionnelles, cela représente un gain de productivité considérable : imaginez un technicien portant des lunettes IA capables d’identifier un équipement, de retrouver des procédures de maintenance et de guider les réparations en temps réel, ou un chirurgien dont l’assistant IA fournit des informations anatomiques et des conseils procéduraux pendant une opération. Les améliorations de batterie de la dernière génération des Ray-Ban, avec 42 % de capacité supplémentaire pour jusqu’à cinq heures d’utilisation continue, lèvent l’un des principaux freins à l’adoption. À mesure que ces appareils gagnent en praticité et en performance, ils deviendront probablement aussi omniprésents que les smartphones, bouleversant notre accès à l’information et notre usage de l’IA au quotidien.

La percée du raisonnement IA : des performances surhumaines à l’ICPC

L’une des avancées majeures de l’IA en 2025 est l’atteinte de performances surhumaines dans des tâches de raisonnement complexe. La finale mondiale de l’International Collegiate Programming Contest (ICPC) incarne l’excellence de la programmation compétitive, où les meilleures équipes universitaires mondiales résolvent des problèmes algorithmiques très difficiles sous contrainte de temps. Ces problèmes requièrent non seulement des compétences en codage, mais aussi un raisonnement mathématique poussé, de la créativité et la gestion des cas extrêmes et contraintes complexes. Le système de raisonnement d’OpenAI a obtenu un score parfait de 12/12 à la finale ICPC 2025, dépassant tous les concurrents humains ayant participé à la même compétition. La méthodologie employée est remarquable : le système recevait les problèmes au même format PDF que les humains, disposait de la même limite de cinq heures et soumettait ses réponses sans harnais de test dédié ni optimisation spécifique à la compétition. Pour onze des douze problèmes, la première réponse soumise était correcte, démontrant non seulement la capacité de résolution mais aussi la calibration de la confiance et la vérification des solutions. Pour le problème le plus difficile, le système a nécessité neuf soumissions avant d’arriver à la bonne solution, surpassant malgré tout la meilleure équipe humaine qui a résolu onze problèmes sur douze.

L’approche technique reposait sur un ensemble de modèles de raisonnement, dont GPT-5 et un modèle expérimental, travaillant ensemble pour générer et évaluer les solutions. Cela représente un changement fondamental : au lieu de tout résoudre en une seule passe, ces systèmes s’appuient sur l’itération, l’adaptation à l’exécution et les méthodes d’ensemble pour améliorer progressivement leurs solutions. Les implications sont profondes : si les systèmes IA surpassent les meilleurs programmeurs humains sur des problèmes algorithmiques inédits et complexes, cela suggère que de nombreuses tâches du savoir, jusqu’ici réservées à l’expertise humaine, sont désormais automatisables ou assistables par l’IA. Cette réalisation a été validée par des experts du secteur, dont Scott Woo, PDG de Cognition et ancien champion de mathématiques, qui a souligné la difficulté de cet exploit. Mark Chen, directeur scientifique d’OpenAI, a mis en perspective cet accomplissement dans une trajectoire plus large : aujourd’hui, l’intelligence de ces modèles est suffisante — il reste à bâtir l’infrastructure pour les exploiter efficacement.

Rejoignez notre newsletter

Recevez gratuitement les derniers conseils, tendances et offres.

Si les capacités de raisonnement constituent une frontière, le déploiement effectif de l’IA nécessite une infrastructure robuste pour la gestion de l’information et du contexte. La génération par récupération augmentée (RAG) s’impose comme technologie clé pour permettre aux systèmes IA d’accéder à des sources de connaissances externes — documents internes, articles scientifiques, bases de données propriétaires. Les systèmes RAG traditionnels font face à un défi majeur : plus le volume d’informations à récupérer est élevé, plus le coût computationnel de la recherche et du traitement augmente. Les Super Intelligence Labs de Meta ont répondu à ce défi avec ReRAG, une optimisation qui accélère RAG par 30 et permet de traiter des contextes 16 fois plus longs sans perdre en précision. L’innovation consiste à remplacer la plupart des tokens récupérés par des embeddings de segments pré-calculés et réutilisables, changeant fondamentalement la façon dont l’information est stockée et retrouvée. Plutôt que de traiter le texte brut à chaque requête, le système exploite des embeddings qui capturent la sémantique des segments d’information, permettant une récupération plus rapide et une utilisation optimale de la fenêtre de contexte du modèle.

Cette optimisation a des retombées immédiates pour le déploiement IA en entreprise. Les sociétés peuvent désormais offrir à leurs IA l’accès à des bases de connaissances bien plus vastes sans coût ou latence proportionnels. Un service client IA peut accéder à des millions de pages de documentation et répondre en quelques millisecondes. Un assistant de recherche peut interroger des bibliothèques entières d’articles scientifiques sans la charge computationnelle qui, auparavant, rendait ces tâches inenvisageables. Le gain de vitesse, multiplié par 30, fait de RAG une approche par défaut, pratique, pour tout système IA nécessitant un accès à l’information externe. Combinée à l’allongement de la fenêtre de contexte, ReRAG permet à l’IA de conserver une compréhension cohérente sur de longs documents et des structures d’informations complexes — indispensable pour l’analyse juridique, la synthèse scientifique ou l’intelligence d’affaires.

FlowHunt et l’orchestration des flux IA

La convergence des capacités avancées — modèles de raisonnement, systèmes de récupération, agents autonomes — crée à la fois des opportunités et des défis pour les organisations souhaitant exploiter ces technologies. La vraie valeur naît non de capacités isolées, mais de leur orchestration en flux cohérents qui résolvent de vrais problèmes métiers. FlowHunt répond à ce besoin en fournissant une plateforme pour concevoir et gérer des flux d’automatisation IA complexes, connectant outils, sources de données et modèles IA au sein de processus unifiés. Prenons un exemple concret : transformer une actualité en contenu formaté pour les réseaux sociaux. Cette tâche apparemment simple requiert l’orchestration de multiples capacités IA et outils externes. Le flux commence par la capture de l’URL de la nouvelle et la création d’enregistrements dans des systèmes de gestion de projet, déclenchant automatiquement des traitements parallèles pour chaque plateforme sociale. Pour chacune, le flux génère des titres adaptés via l’IA, récupère des ressources par scraping, crée des images d’en-tête personnalisées, puis publie le contenu sur les plateformes de planification. Chaque étape implique des outils et modèles IA différents, l’output de l’un servant d’input au suivant.

Ce type d’orchestration devient essentiel à mesure que les capacités IA se multiplient. Plutôt que de coder des intégrations sur-mesure pour chaque combinaison d’outils et de modèles, les plateformes comme FlowHunt fournissent l’infrastructure pour développer et déployer rapidement des flux automatisés. Grâce à plus de 8 000 intégrations, pratiquement tout processus métier peut être automatisé en combinant outils existants et IA. Cela démocratise l’automatisation IA, permettant aux organisations sans équipe d’ingénierie dédiée de bâtir des workflows sophistiqués. À mesure que les agents IA gagnent en autonomie, la capacité à orchestrer leur activité, gérer leurs interactions avec les systèmes externes et garantir la conformité des résultats devient critique. L’approche de FlowHunt, combinant éditeurs visuels et orchestration IA, en fait une couche d’infrastructure clé dans l’économie émergente pilotée par l’IA.

L’émergence d’une infrastructure pour agents autonomes

Au-delà des capacités individuelles, 2025 voit apparaître une infrastructure dédiée à l’interaction des agents autonomes entre eux et avec des systèmes externes. L’annonce par Google du protocole Agent Payment Protocol (AP2) marque une étape majeure. S’appuyant sur le protocole Agent-to-Agent permettant la communication entre agents, AP2 étend cette capacité aux transactions financières. Le protocole fournit un langage commun pour des transactions sécurisées et conformes, ouvrant la voie à une nouvelle classe d’activités économiques autonomes. Imaginez un agent IA gérant vos opérations et capable d’acheter des services, négocier des contrats ou gérer des fournisseurs sans intervention humaine. Ou imaginez l’optimisation de la chaîne logistique où des agents représentant différentes entreprises effectuent des transactions pour optimiser les stocks, les prix et les livraisons en temps réel.

Le protocole a déjà séduit de grands acteurs technologiques et économiques : Adobe, Accenture, OnePassword, Intuit, Red Hat, Salesforce, Okta. Ce niveau de soutien montre que les transactions agent-à-agent ne sont plus une perspective lointaine, mais une réalité que les entreprises s’apprêtent à intégrer. Les implications vont au-delà des simples transactions : AP2 permet la création de réseaux d’agents capables de collaborer, de se concurrencer et de se coordonner pour atteindre des objectifs complexes. Un agent IA pour la production pourrait ainsi sourcer automatiquement ses matières premières, s’accorder avec des agents logistiques pour la livraison, gérer les paiements — le tout sans intervention humaine. Cela représente un basculement fondamental dans l’organisation des processus, passant de workflows dirigés par l’humain à des écosystèmes coordonnés par des agents IA opérant avec une autonomie croissante.

La performance surhumaine en programmation compétitive s’inscrit dans un mouvement plus large d’IA atteignant ou dépassant le niveau humain dans des domaines toujours plus complexes. L’exploit à l’ICPC s’ajoute à d’autres jalons : sixième place à l’Olympiade internationale d’informatique (IOI), médaille d’or à l’Olympiade internationale de mathématiques (IMO), deuxième place à l’AtCoder Heuristic Contest. Cette progression montre que les capacités de raisonnement IA ne sont plus limitées à des domaines étroits mais se généralisent à toutes sortes de tâches complexes. Les implications pour les métiers du savoir sont majeures : si l’IA résout des problèmes inédits exigeant une compréhension algorithmique profonde, elle pourra probablement assister ou automatiser nombre d’autres tâches intellectuelles similaires.

Cependant, il est important de replacer ces réalisations dans le contexte plus large du développement IA. Comme l’a souligné Mark Chen, l’intelligence brute de ces modèles est aujourd’hui suffisante pour de nombreux usages — le principal enjeu est désormais l’infrastructure permettant de les exploiter efficacement. Cette “scaffolding” n’est pas seulement technique (RAG, protocoles agents…), elle inclut aussi les processus organisationnels, la sécurité et les cadres d’intégration permettant un déploiement responsable et efficace. La prochaine phase du développement IA portera probablement moins sur les capacités brutes que sur le déploiement, l’intégration et l’orchestration des outils existants.

Intelligence spatiale et génération de mondes 3D

Si le raisonnement et l’infrastructure agent représentent une frontière, l’intelligence spatiale en est une autre. World Labs, fondée par Fei-Fei Li, ouvre la voie au développement de Large World Models (LWMs) capables de générer et de comprendre des environnements tridimensionnels. Leur technologie prend une image et génère un monde 3D interactif dans lequel les utilisateurs peuvent se déplacer. Cela constitue une avancée fondamentale dans la compréhension et la représentation spatiale de l’IA : au lieu de traiter les images comme des données 2D statiques, ces systèmes construisent des modèles 3D cohérents, maintiennent la consistance lors des déplacements, intègrent des détails environnementaux, une gestion réaliste de la lumière et de la physique pour une expérience immersive.

Les applications dépassent largement le divertissement ou la visualisation. En architecture et urbanisme, on pourrait générer des environnements 3D complets à partir d’esquisses, permettant aux parties prenantes d’explorer les projets avant la construction. En éducation, les élèves pourraient visiter des sites historiques, explorer des environnements scientifiques ou des systèmes complexes. En formation et simulation, il serait possible de créer des environnements réalistes sans le coût d’installations physiques. Cette technologie a aussi un rôle pour la robotique et les systèmes autonomes : une IA capable de générer des modèles 3D cohérents peut mieux comprendre l’espace et planifier ses déplacements. À mesure qu’elle se démocratise, elle deviendra un outil standard de visualisation, de conception et de simulation dans de nombreux secteurs.

Agents IA open source et benchmarks compétitifs

La concurrence autour des capacités IA s’intensifie, avec de multiples organisations développant des systèmes avancés de raisonnement et d’agents. Tongyi DeepResearch d’Alibaba constitue une contribution open source majeure, atteignant des performances de pointe sur plusieurs benchmarks avec seulement 30 milliards de paramètres, dont 3 milliards activés en inférence. Cette efficacité est remarquable : le système rivalise avec de grands modèles propriétaires tout en utilisant une fraction des ressources. Il obtient 32,9 à Humanity’s Last Exam, 45,3 à BrowseComp et 75 à XBench Deep Research, attestant de solides performances sur des tâches variées.

Le caractère open source de Tongyi DeepResearch est déterminant car il démocratise l’accès à des capacités IA avancées. Au lieu d’être réservé aux entités capables d’entraîner de très grands modèles propriétaires, chercheurs et développeurs peuvent s’appuyer sur ce système de raisonnement de pointe. L’approche technique repose sur une stratégie automatisée de génération de données multi-étapes, produisant d’énormes volumes de données d’entraînement agentiques de qualité sans recourir à l’annotation humaine coûteuse. Cela répond à l’un des défis fondamentaux du développement IA : le besoin de grandes quantités de données de qualité. En automatisant ce processus, Tongyi DeepResearch montre que l’on peut atteindre des performances de pointe sans les efforts massifs d’annotation humaine traditionnellement nécessaires.

Investissements dans l’infrastructure IA et montée en puissance

La progression rapide des capacités IA entraîne un investissement massif dans l’infrastructure, notamment les capacités de datacenters et le matériel spécialisé. GRQ, fabricant de puces IA, a levé 750 millions de dollars à une valorisation post-financement de 6,9 milliards, avec des plans d’expansion, y compris en Asie-Pacifique. Ce tour de table, mené par Disruptive et avec BlackRock ou Neuberger Berman, reflète la compétition intense pour la capacité d’inférence et la conviction que l’infrastructure IA sera un goulet d’étranglement critique dans les années à venir. La demande pour l’inférence — les ressources nécessaires à l’exécution des modèles entraînés — pousse Nvidia, GRQ et Cerebras à accélérer leur production.

Ce déploiement d’infrastructure est indispensable pour exploiter le potentiel des capacités IA avancées. Les modèles de raisonnement, LLM et agents autonomes requièrent d’importantes ressources pour fonctionner. À mesure de leur adoption, la demande pour l’inférence ne fera que croître. Ces investissements ne sont pas spéculatifs : ils répondent à la réalité d’un déploiement IA massif et à la nécessité d’une infrastructure fiable et évolutive. L’expansion géographique en Asie-Pacifique reflète la mondialisation de l’IA et la nécessité de ressources distribuées pour garantir latence acceptable et conformité aux réglementations locales.

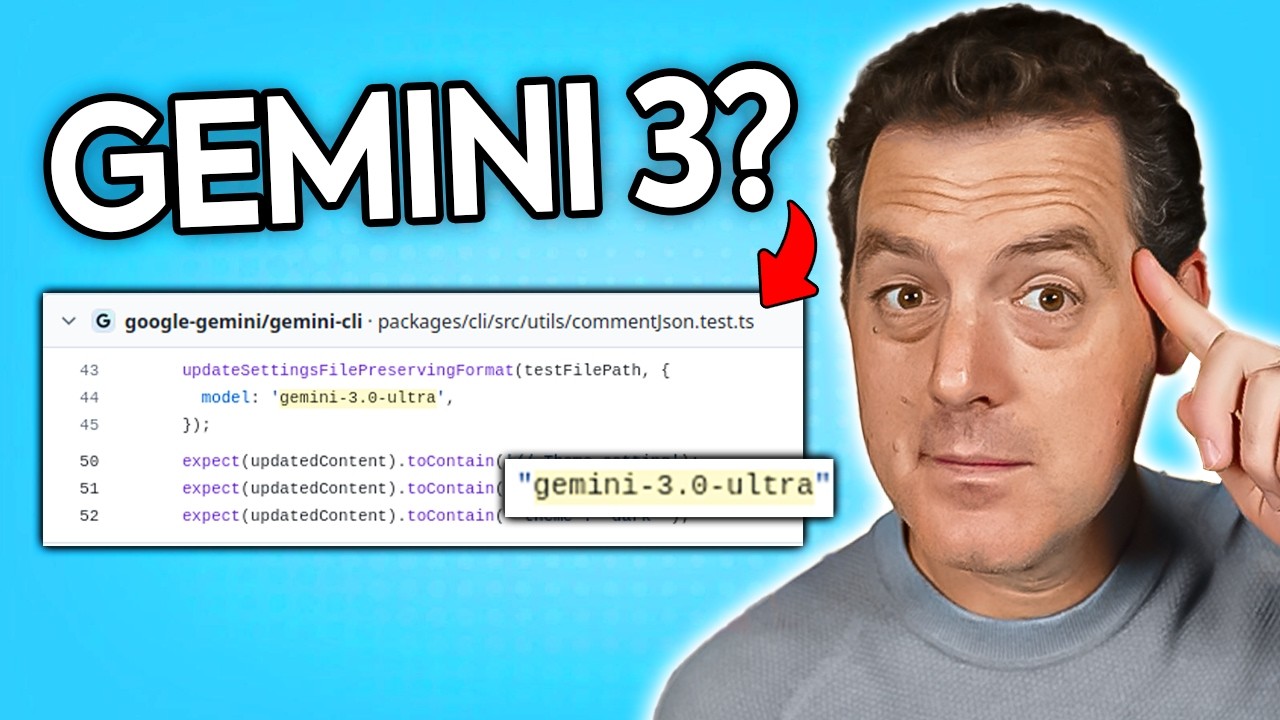

Tendances émergentes dans le développement de modèles IA

Le paysage compétitif des modèles IA évolue rapidement, chaque organisation adoptant des stratégies différentes. Le développement supposé de Gemini 3.0 Ultra, repéré dans le dépôt Gemini CLI de Google, suggère la sortie prochaine d’une nouvelle génération du modèle phare de raisonnement. La découverte de références à Gemini 3.0 Ultra dans des commits récents montre que les grandes sorties de modèles sont souvent précédées de modifications d’infrastructure et de préparation. Le rythme de versionnement et de publication laisse présager des mises à jour régulières des systèmes majeurs, chaque itération apportant des avancées progressives ou substantielles.

L’annonce par Elon Musk du début prochain de l’entraînement de Grok 5 indique que xAI avance aussi sur le raisonnement. La notion même de “version majeure” — nouvel entraînement, changement d’architecture, seuil de capacité — reste floue, mais la tendance est nette : de multiples acteurs investissent massivement dans le raisonnement avancé, et l’on peut s’attendre à des versions régulières toujours plus performantes. Cette dynamique concurrentielle est bénéfique pour l’écosystème, stimulant l’innovation et empêchant toute monopolisation des capacités IA de pointe.

Véhicules autonomes et déploiement réel de l’IA

Si le débat sur l’IA se concentre souvent sur le raisonnement et l’infrastructure agent, le déploiement réel progresse vite dans des domaines comme les véhicules autonomes. L’autorisation accordée à Waymo pour opérer des trajets autonomes à l’aéroport international de San Francisco est un jalon majeur de la commercialisation. Le déploiement progressif, débutant à l’aéroport avant d’étendre la zone desservie, reflète la prudence nécessaire pour des IA critiques en conditions réelles. La concurrence de Zoox (Amazon) montre que plusieurs acteurs réalisent des progrès significatifs.

Le déploiement dans un hub tel que SFO marque la transition des tests contrôlés vers l’opérationnel réel auprès de clients. L’environnement aéroportuaire, bien que plus contrôlé que le centre-ville, présente des défis concrets : météo variable, trafic complexe, interaction avec conducteurs et piétons. Une exploitation réussie ici prouve la maturité de la technologie, qui s’améliorera encore avec l’expérience et les données, ouvrant la voie à des déploiements plus larges.

L’intégration des capacités IA dans les processus métiers

La convergence des capacités IA avancées, de l’infrastructure agent et des plateformes d’automatisation permet aux organisations d’intégrer l’IA au cœur de leurs processus métiers, ce qui était auparavant impossible. L’exemple de la conversion d’actualités en contenu social, en apparence simple, illustre la complexité de l’automatisation IA réelle. Il faut coordonner plusieurs modèles IA (génération de titres, création d’images), des outils externes (scraping, planification de contenu) et une logique métier (formatage, timing par plateforme). Réussir de tels workflows requiert non seulement des capacités IA individuelles, mais aussi des plateformes d’orchestration capables de gérer les interactions entre composants.

L’approche de FlowHunt, alliant éditeurs visuels de workflows et orchestration IA, répond à ce besoin. En masquant la complexité technique des intégrations, ces plateformes permettent aux métiers de construire des automatisations sophistiquées sans expertise d’ingénierie IA. À mesure que l’IA gagne en puissance et accessibilité, la capacité à orchestrer ces outils au sein de processus cohérents devient un avantage concurrentiel décisif. Les organisations qui intègrent efficacement l’IA à leurs workflows gagneront en efficacité, réduiront leurs coûts et accéléreront la mise sur le marché de produits et services.

L’avenir de l’automatisation pilotée par l’IA

Les évolutions décrites annoncent un futur où l’IA est profondément intégrée aux processus d’entreprise et à la vie quotidienne. L’IA n’est plus un outil spécialisé, elle devient la solution par défaut pour automatiser et optimiser les workflows. Les agents autonomes se coordonnent pour gérer des processus complexes. Les IA dotées de raisonnement avancé résolvent des problèmes inédits et prennent des décisions stratégiques. Les objets connectés IA assistent en temps réel. L’intelligence spatiale permet de nouvelles formes de simulation et de visualisation. Ce futur n’est plus hypothétique — les technologies sont déjà en cours de déploiement.

Le rôle de plateformes comme FlowHunt devient crucial. À mesure que les capacités IA se multiplient et gagnent en puissance, la capacité à les orchestrer en workflows cohérents devient un avantage clé. Les organisations qui intègrent efficacement l’IA seront mieux armées pour réussir dans l’économie pilotée par l’IA. Les investissements d’infrastructure de sociétés comme GRQ, les contributions open source d’Alibaba et les plateformes commerciales comme FlowHunt rendent ces capacités de pointe accessibles et déployables à grande échelle.

Conclusion

Le paysage de l’IA en 2025 se caractérise par une progression rapide sur de multiples axes : du matériel portable qui augmente la perception humaine aux modèles de raisonnement qui surpassent l’humain sur des problèmes complexes, de l’infrastructure permettant les transactions autonomes à l’intelligence spatiale générant des mondes 3D immersifs. Ces avancées ne sont pas des exploits isolés mais des progrès interconnectés qui, ensemble, transforment la façon dont l’IA est déployée et intégrée dans l’économie et la société. La convergence de ces capacités, portée par des plateformes d’orchestration et des investissements massifs dans l’infrastructure, crée les fondations d’un futur piloté par l’IA où des systèmes autonomes gèrent des tâches de plus en plus complexes avec une intervention humaine minimale. Les organisations et individus qui comprennent ces évolutions et se positionnent pour en tirer parti seront les mieux préparés à prospérer dans l’économie émergente pilotée par l’IA.