LLM Meta AI

FlowHunt prend en charge des dizaines de modèles de génération de texte, y compris les modèles Llama de Meta. Découvrez comment intégrer Llama dans vos outils e...

LLM Mistral sur FlowHunt permet une intégration flexible de modèles IA Mistral avancés pour une génération de texte fluide dans les chatbots et outils IA.

Description du composant

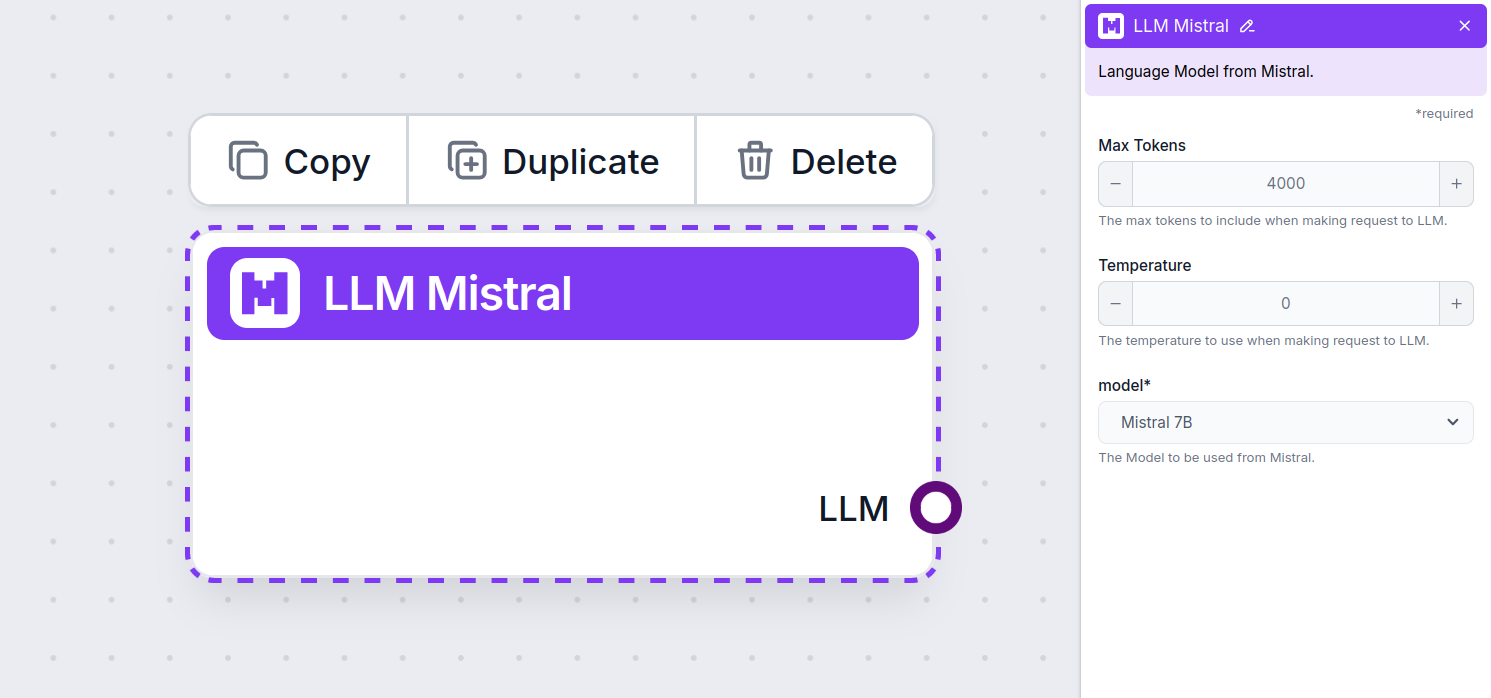

The LLM Mistral component connects the Mistral models to your flow. While the Generators and Agents are where the actual magic happens, LLM components allow you to control the model used. All components come with ChatGPT-4 by default. You can connect this component if you wish to change the model or gain more control over it.

Remember that connecting an LLM Component is optional. All components that use an LLM come with ChatGPT-4o as the default. The LLM components allow you to change the model and control model settings.

Tokens represent the individual units of text the model processes and generates. Token usage varies with models, and a single token can be anything from words or subwords to a single character. Models are usually priced in millions of tokens.

The max tokens setting limits the total number of tokens that can be processed in a single interaction or request, ensuring the responses are generated within reasonable bounds. The default limit is 4,000 tokens, which is the optimal size for summarizing documents and several sources to generate an answer.

Temperature controls the variability of answers, ranging from 0 to 1.

A temperature of 0.1 will make the responses very to the point but potentially repetitive and deficient.

A high temperature of 1 allows for maximum creativity in answers but creates the risk of irrelevant or even hallucinatory responses.

For example, the recommended temperature for a customer service bot is between 0.2 and 0.5. This level should keep the answers relevant and to the script while allowing for a natural response variation.

This is the model picker. Here, you’ll find all the supported models from Mistral. We currently support the following models:

How To Add The LLM Mistral To Your Flow

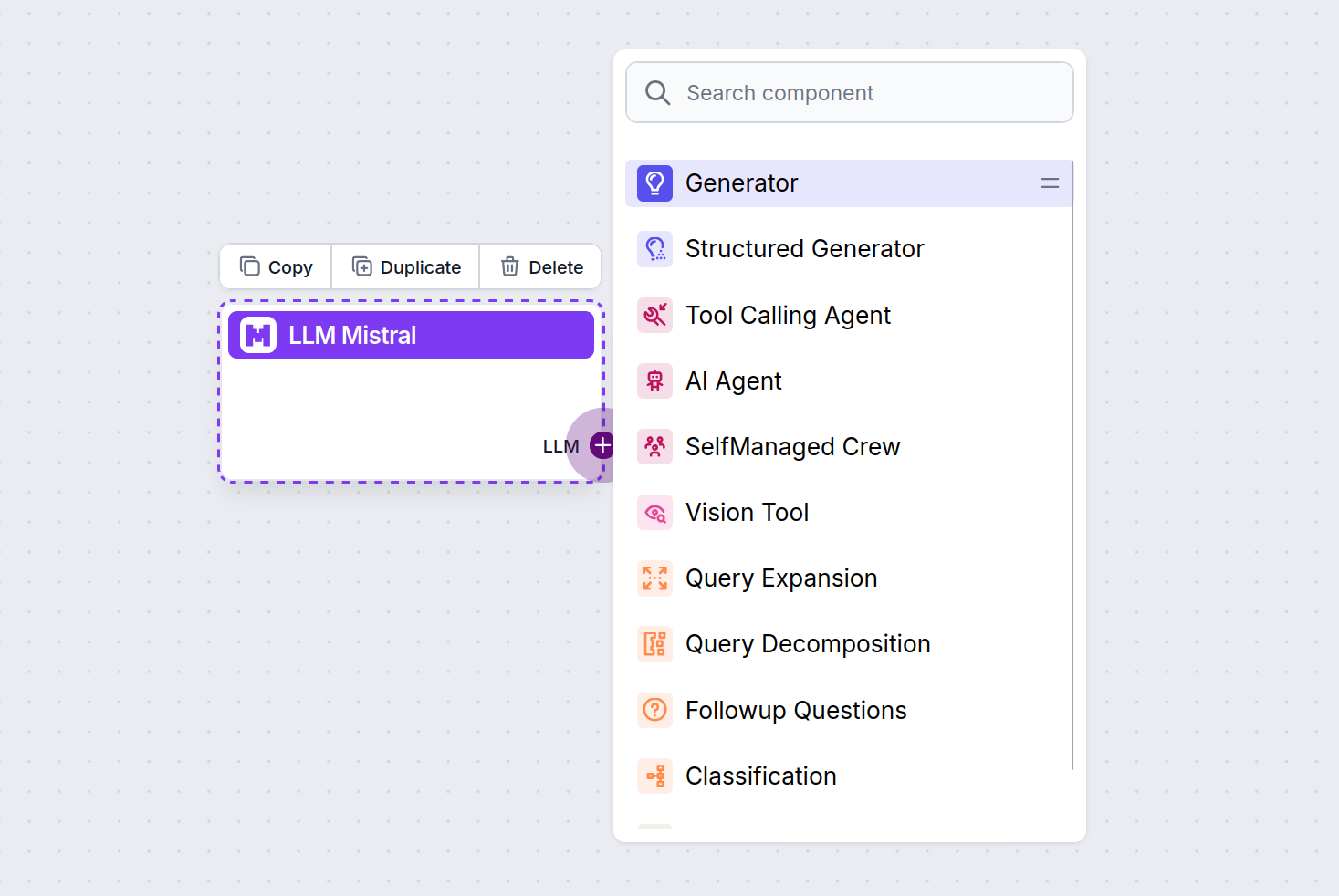

You’ll notice that all LLM components only have an output handle. Input doesn’t pass through the component, as it only represents the model, while the actual generation happens in AI Agents and Generators.

The LLM handle is always purple. The LLM input handle is found on any component that uses AI to generate text or process data. You can see the options by clicking the handle:

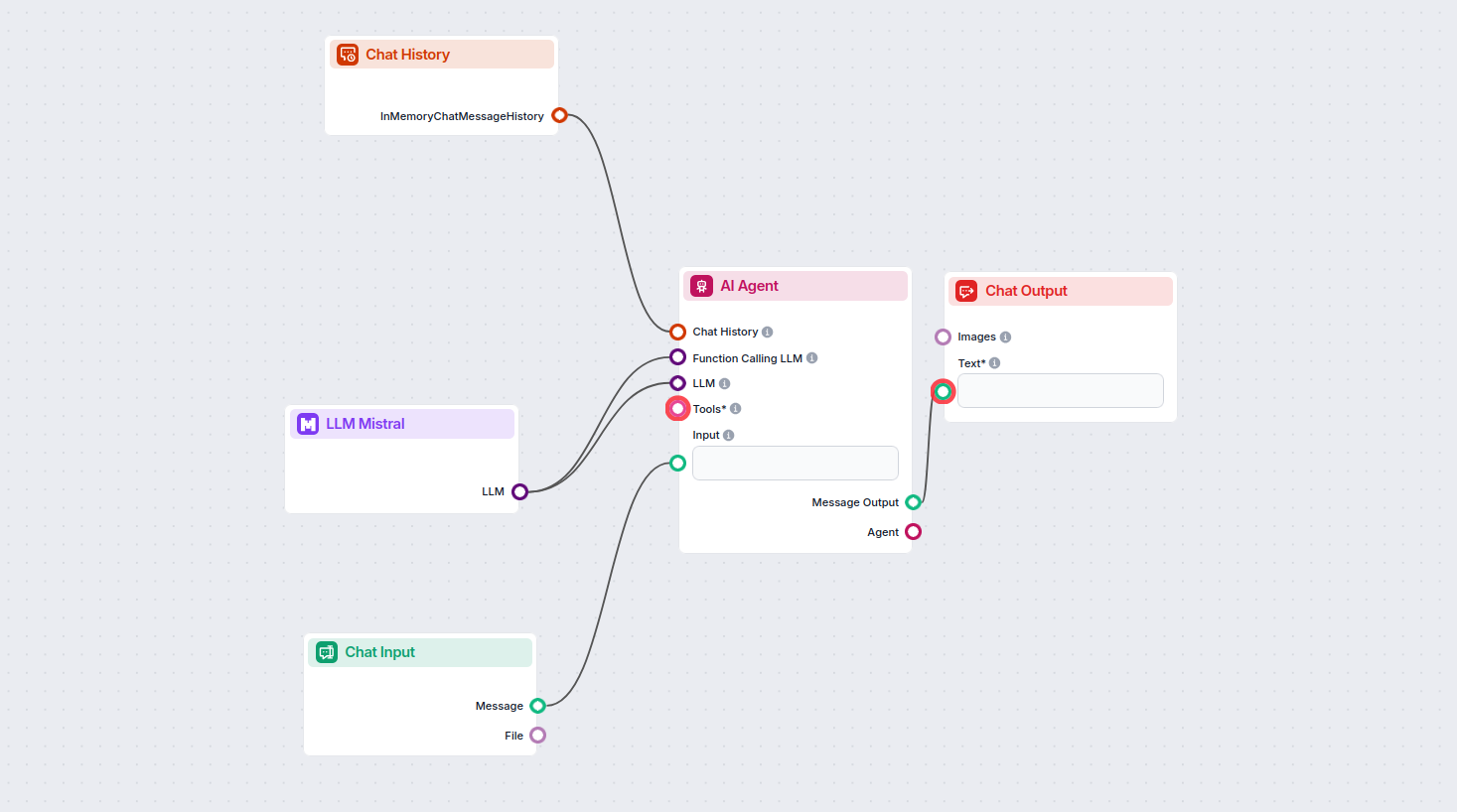

This allows you to create all sorts of tools. Let’s see the component in action. Here’s a simple AI Agent chatbot Flow that’s using the Mistral 7B model to generate responses. You can think of it as a basic Mistral chatbot.

This simple Chatbot Flow includes:

Le composant LLM Mistral vous permet de connecter les modèles IA Mistral à vos projets FlowHunt, offrant une génération de texte avancée pour vos chatbots et agents IA. Il vous permet de changer de modèle, de contrôler les paramètres, et d’intégrer des modèles comme Mistral 7B, Mixtral (8x7B) et Mistral Large.

FlowHunt prend en charge Mistral 7B, Mixtral (8x7B) et Mistral Large, chacun offrant différents niveaux de performance et de paramètres pour divers besoins de génération de texte.

Vous pouvez ajuster des paramètres comme le nombre maximal de tokens et la température, et choisir parmi les modèles Mistral pris en charge pour contrôler la longueur des réponses, la créativité et le comportement du modèle dans vos flux.

Non, connecter un composant LLM est optionnel. Par défaut, les composants FlowHunt utilisent ChatGPT-4o. Utilisez le composant LLM Mistral lorsque vous souhaitez plus de contrôle ou utiliser un modèle Mistral spécifique.

Commencez à créer des chatbots et outils IA plus intelligents en intégrant les puissants modèles linguistiques de Mistral avec la plateforme no-code de FlowHunt.

FlowHunt prend en charge des dizaines de modèles de génération de texte, y compris les modèles Llama de Meta. Découvrez comment intégrer Llama dans vos outils e...

FlowHunt prend en charge des dizaines de modèles de génération de texte, y compris ceux de xAI. Voici comment utiliser les modèles xAI dans vos outils et chatbo...

FlowHunt prend en charge des dizaines de modèles d'IA, y compris les modèles révolutionnaires DeepSeek. Voici comment utiliser DeepSeek dans vos outils d'IA et ...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.