MLflow

MLflow est une plateforme open source conçue pour simplifier et gérer le cycle de vie de l'apprentissage automatique (ML). Elle fournit des outils pour le suivi...

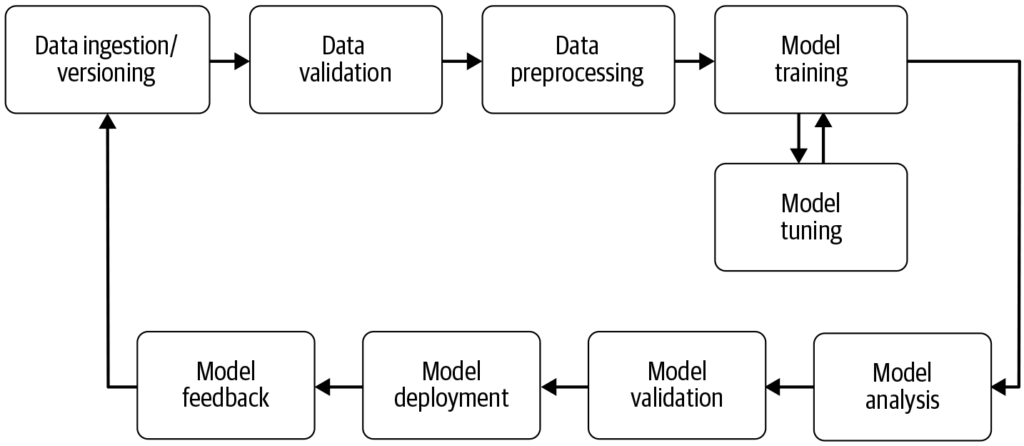

Un pipeline d’apprentissage automatique automatise les étapes allant de la collecte des données au déploiement du modèle, améliorant l’efficacité, la reproductibilité et la scalabilité dans les projets d’apprentissage automatique.

Un pipeline d’apprentissage automatique est un flux de travail automatisé qui rationalise le développement, l’entraînement, l’évaluation et le déploiement des modèles. Il améliore l’efficacité, la reproductibilité et la scalabilité, en facilitant les tâches allant de la collecte des données jusqu’au déploiement et à la maintenance du modèle.

Un pipeline d’apprentissage automatique est un flux de travail automatisé qui englobe une série d’étapes impliquées dans le développement, l’entraînement, l’évaluation et le déploiement de modèles d’apprentissage automatique. Il est conçu pour rationaliser et standardiser les processus nécessaires afin de transformer des données brutes en informations exploitables grâce à des algorithmes de machine learning. L’approche pipeline permet une gestion efficace des données, de l’entraînement et du déploiement des modèles, facilitant ainsi la gestion et la montée en charge des opérations d’apprentissage automatique.

Source : Building Machine Learning

Collecte des données : L’étape initiale où les données sont rassemblées à partir de diverses sources telles que des bases de données, des API ou des fichiers. La collecte des données est une pratique méthodique visant à acquérir des informations pertinentes pour constituer un jeu de données cohérent et complet dans un but métier précis. Ces données brutes sont essentielles pour construire des modèles d’apprentissage automatique mais nécessitent souvent un prétraitement pour être exploitables. Comme le souligne AltexSoft, la collecte de données implique l’accumulation systématique d’informations pour soutenir l’analyse et la prise de décision. Ce processus est crucial car il pose les bases de toutes les étapes suivantes du pipeline et est souvent continu afin de garantir que les modèles sont entraînés sur des données pertinentes et à jour.

Prétraitement des données : Les données brutes sont nettoyées et transformées dans un format adapté à l’entraînement des modèles. Les étapes courantes de prétraitement incluent la gestion des valeurs manquantes, l’encodage des variables catégorielles, la mise à l’échelle des caractéristiques numériques et la division des données en ensembles d’entraînement et de test. Cette étape garantit que les données sont dans le format correct et exemptes d’incohérences susceptibles d’affecter les performances du modèle.

Ingénierie des caractéristiques : Création de nouvelles variables ou sélection des caractéristiques pertinentes à partir des données afin d’améliorer la capacité prédictive du modèle. Cette étape peut nécessiter des connaissances spécifiques au domaine et de la créativité. L’ingénierie des caractéristiques est un processus créatif qui transforme les données brutes en variables significatives, représentant mieux le problème sous-jacent et améliorant les performances des modèles d’apprentissage automatique.

Sélection du modèle : L’algorithme d’apprentissage automatique approprié est choisi en fonction du type de problème (par exemple, classification, régression), des caractéristiques des données et des exigences de performance. L’ajustement des hyperparamètres peut également être envisagé à cette étape. Le choix du bon modèle est crucial, car il influence la précision et l’efficacité des prédictions.

Entraînement du modèle : Le(s) modèle(s) sélectionné(s) sont entraînés à partir du jeu de données d’entraînement. Cela implique l’apprentissage des structures et relations sous-jacentes dans les données. Des modèles préentraînés peuvent également être utilisés au lieu d’entraîner un nouveau modèle à partir de zéro. L’entraînement est une étape essentielle où le modèle apprend à partir des données pour faire des prédictions éclairées.

Évaluation du modèle : Après l’entraînement, les performances du modèle sont évaluées à l’aide d’un jeu de test séparé ou via la validation croisée. Les métriques d’évaluation dépendent du problème spécifique, mais peuvent inclure la précision, le rappel, la F-mesure, l’erreur quadratique moyenne, entre autres. Cette étape est cruciale pour s’assurer que le modèle fonctionnera bien sur des données inédites.

Déploiement du modèle : Une fois qu’un modèle satisfaisant a été développé et évalué, il peut être déployé en production pour effectuer des prédictions sur de nouvelles données. Le déploiement peut inclure la création d’API et l’intégration avec d’autres systèmes. Le déploiement est la dernière étape du pipeline où le modèle est rendu accessible à des fins réelles.

Supervision et maintenance : Après le déploiement, il est essentiel de surveiller en continu les performances du modèle et de le réentraîner si nécessaire pour s’adapter à l’évolution des données, garantissant ainsi sa fiabilité et son exactitude dans des contextes réels. Ce processus continu permet au modèle de rester pertinent et performant dans le temps.

Traitement du langage naturel (NLP) : Les tâches NLP impliquent souvent de multiples étapes répétitives telles que l’ingestion de données, le nettoyage de texte, la tokenisation et l’analyse de sentiments. Les pipelines permettent de modulariser ces étapes, facilitant les modifications et mises à jour sans impacter les autres composants.

Maintenance prédictive : Dans des secteurs tels que l’industrie, les pipelines peuvent être utilisés pour prédire les pannes d’équipement via l’analyse des données de capteurs, permettant ainsi une maintenance proactive et une réduction des arrêts de production.

Finance : Les pipelines peuvent automatiser le traitement des données financières afin de détecter la fraude, évaluer les risques de crédit ou prédire les cours boursiers, améliorant ainsi les processus de prise de décision.

Santé : Dans le domaine médical, les pipelines peuvent traiter des images médicales ou des dossiers patients pour aider au diagnostic ou prédire les issues de santé, améliorant ainsi les stratégies de traitement.

Les pipelines d’apprentissage automatique sont essentiels à l’IA et l’automatisation en fournissant un cadre structuré pour automatiser les tâches de machine learning. Dans le domaine de l’automatisation IA, les pipelines garantissent que les modèles sont entraînés et déployés efficacement, permettant à des systèmes d’IA comme les chatbots d’apprendre et de s’adapter à de nouvelles données sans intervention manuelle. Cette automatisation est cruciale pour faire évoluer les applications d’IA et assurer une performance constante et fiable dans divers domaines. En exploitant les pipelines, les organisations peuvent renforcer leurs capacités en IA et s’assurer que leurs modèles d’apprentissage automatique restent pertinents et efficaces dans des environnements en mutation.

Recherche sur les pipelines d’apprentissage automatique

« Deep Pipeline Embeddings for AutoML » par Sebastian Pineda Arango et Josif Grabocka (2023) se concentre sur les défis de l’optimisation des pipelines d’apprentissage automatique dans l’AutoML. Cet article présente une nouvelle architecture neuronale conçue pour capturer les interactions profondes entre les composants du pipeline. Les auteurs proposent d’encoder les pipelines dans des représentations latentes grâce à un mécanisme unique d’encodeur par composant. Ces embeddings sont exploités dans un cadre d’optimisation bayésienne pour rechercher des pipelines optimaux. L’article met en avant l’utilisation du méta-apprentissage pour affiner les paramètres du réseau d’embedding, démontrant des résultats de pointe sur plusieurs jeux de données. Lire la suite.

« AVATAR — Machine Learning Pipeline Evaluation Using Surrogate Model » par Tien-Dung Nguyen et al. (2020) aborde l’évaluation chronophage des pipelines d’apprentissage automatique lors des processus AutoML. L’étude critique les méthodes traditionnelles telles que les optimisations bayésiennes et génétiques pour leur inefficacité. Pour y remédier, les auteurs présentent AVATAR, un modèle substitut qui évalue efficacement la validité des pipelines sans exécution. Cette approche accélère significativement la composition et l’optimisation des pipelines complexes en filtrant rapidement les pipelines invalides. Lire la suite.

« Data Pricing in Machine Learning Pipelines » par Zicun Cong et al. (2021) explore le rôle crucial de la donnée dans les pipelines d’apprentissage automatique et la nécessité de tarification des données pour faciliter la collaboration entre divers acteurs. L’article passe en revue les avancées récentes en matière de tarification des données dans le contexte du machine learning, en se concentrant sur son importance à chaque étape du pipeline. Il propose des pistes sur les stratégies de tarification pour la collecte de données d’entraînement, l’entraînement collaboratif de modèles et la fourniture de services de machine learning, soulignant la formation d’un écosystème dynamique. Lire la suite.

Un pipeline d'apprentissage automatique est une séquence automatisée d'étapes—de la collecte et du prétraitement des données à l'entraînement, l'évaluation et le déploiement du modèle—qui rationalise et standardise le processus de création et de maintenance des modèles d'apprentissage automatique.

Les principaux composants incluent la collecte de données, le prétraitement des données, l'ingénierie des caractéristiques, la sélection du modèle, l'entraînement du modèle, l'évaluation du modèle, le déploiement du modèle, ainsi que le suivi et la maintenance continus.

Les pipelines d'apprentissage automatique offrent modularité, efficacité, reproductibilité, scalabilité, une meilleure collaboration et un déploiement plus facile des modèles dans des environnements de production.

Les cas d'utilisation incluent le traitement du langage naturel (NLP), la maintenance prédictive dans l'industrie, l'évaluation des risques financiers et la détection de la fraude, ainsi que le diagnostic médical.

Les défis incluent la garantie de la qualité des données, la gestion de la complexité du pipeline, l'intégration avec les systèmes existants et le contrôle des coûts liés aux ressources informatiques et à l'infrastructure.

Planifiez une démo pour découvrir comment FlowHunt peut vous aider à automatiser et à mettre à l'échelle vos flux de travail d'apprentissage automatique en toute simplicité.

MLflow est une plateforme open source conçue pour simplifier et gérer le cycle de vie de l'apprentissage automatique (ML). Elle fournit des outils pour le suivi...

L'apprentissage automatique (ML) est un sous-ensemble de l'intelligence artificielle (IA) qui permet aux machines d'apprendre à partir de données, d'identifier ...

Le Human-in-the-Loop (HITL) est une approche de l’IA et de l’apprentissage automatique qui intègre l’expertise humaine dans la formation, l’ajustement et l’appl...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.