Traitement automatique du langage naturel (TALN)

Le traitement automatique du langage naturel (TALN) permet aux ordinateurs de comprendre, d’interpréter et de générer le langage humain à l’aide de la linguisti...

Le fenêtrage en intelligence artificielle fait référence à la méthode consistant à traiter les données par segments ou « fenêtres » afin d’analyser et de générer des informations à partir de données séquentielles. Dans le domaine du traitement automatique du langage naturel (TALN), le fenêtrage est particulièrement important car il permet aux modèles de considérer un sous-ensemble de données à la fois, facilitant la compréhension et la génération de texte basée sur des indices contextuels. En examinant les données par portions, les systèmes d’IA peuvent gérer efficacement les ressources de calcul tout en conservant la capacité de capter les motifs pertinents dans les données.

Dans le contexte du TALN et des grands modèles de langage (LLM), le fenêtrage se rapporte souvent à la notion de fenêtres de contexte. Il s’agit de plages fixes de jetons que le modèle peut traiter simultanément. Les jetons représentent des éléments de texte, tels que des mots ou des sous-mots, et le nombre de jetons que le modèle peut traiter à la fois définit la taille de sa fenêtre de contexte. Cette approche permet aux modèles d’IA de se concentrer sur des parties spécifiques du texte, garantissant qu’ils génèrent des réponses basées sur des informations contextuelles pertinentes.

Le fenêtrage est utilisé en IA pour gérer et traiter efficacement les données séquentielles. En traitement automatique du langage naturel, il permet aux modèles de traiter de longs textes en les divisant en segments gérables. Chaque fenêtre comprend un certain nombre de jetons qui fournissent le contexte nécessaire à l’analyse et à la génération de réponses par le modèle d’IA. Cette méthode est essentielle pour les tâches impliquant la compréhension et la génération du langage humain, car elle permet aux modèles de prendre en compte le contexte requis sans être submergés par l’ensemble de la séquence de données.

En pratique, le fenêtrage permet aux modèles de se concentrer sur les parties pertinentes du texte tout en ignorant les informations inutiles. Cela est particulièrement utile dans des applications comme la traduction automatique, l’analyse de sentiment et l’IA conversationnelle, où la compréhension du contexte immédiat est vitale pour produire des résultats précis et cohérents. Grâce au fenêtrage, les systèmes d’IA peuvent maintenir leur performance et leur efficacité, même lors du traitement de données longues ou complexes.

En traitement automatique du langage naturel, le fenêtrage est employé pour analyser et comprendre les données textuelles. Par exemple, dans l’analyse de sentiment, un modèle d’IA peut utiliser le fenêtrage pour examiner un nombre fixe de mots autour d’une phrase cible afin de déterminer le sentiment exprimé. En se concentrant sur une fenêtre spécifique de texte, le modèle peut saisir le contexte immédiat qui influence le sentiment, comme les négations ou les intensificateurs.

Les systèmes de traduction automatique utilisent le fenêtrage pour traduire un texte d’une langue à une autre. Le modèle traite des segments du texte source à l’intérieur d’une fenêtre de contexte, garantissant que la traduction tient compte du contexte linguistique pertinent. Cette approche aide à maintenir le sens et la justesse grammaticale du texte traduit, notamment lorsqu’il s’agit de langues ayant des structures de phrases différentes.

Les chatbots utilisent le fenêtrage pour gérer le fil de la conversation. En se concentrant sur les interactions récentes à l’intérieur d’une fenêtre de contexte, le chatbot peut générer des réponses pertinentes et cohérentes. Cela est crucial pour maintenir un dialogue naturel et engageant avec les utilisateurs. Par exemple, un chatbot de service client peut utiliser le fenêtrage pour se souvenir des questions précédentes d’un client et offrir une assistance précise en fonction de la conversation en cours.

En analyse de séries temporelles, le fenêtrage sert à traiter des points de données collectés au fil du temps en analysant des segments à l’intérieur d’une fenêtre glissante. Cette technique permet aux modèles d’IA de détecter des tendances, des motifs ou des anomalies dans des périodes temporelles définies. Par exemple, en prévision financière, un système d’IA peut utiliser le fenêtrage pour analyser les prix des actions dans une fenêtre temporelle glissante afin de prédire les mouvements futurs du marché.

Il permet aux systèmes d’IA de se concentrer sur les portions pertinentes du texte, ce qui est essentiel pour les tâches nécessitant une compréhension contextuelle. En traitant les données dans une fenêtre de contexte, les modèles peuvent saisir les nuances et dépendances du langage nécessaires à une interprétation et une génération précises.

De plus, le fenêtrage aide à gérer les ressources de calcul en limitant la quantité de données traitées simultanément. Cela est crucial pour permettre aux modèles de TALN de traiter de grands ensembles de données ou de fonctionner dans des applications en temps réel. Le fenêtrage garantit que les modèles restent efficaces et réactifs, même lorsqu’ils traitent des données linguistiques volumineuses ou complexes.

Dans les grands modèles de langage, une fenêtre de contexte correspond à la séquence de jetons que le modèle prend en compte lors du traitement de données en entrée. La taille de la fenêtre de contexte détermine la quantité de texte que le modèle peut analyser simultanément. Des fenêtres de contexte plus grandes permettent aux modèles de prendre en compte des portions de texte plus étendues, de saisir des dépendances à longue portée et d’améliorer la cohérence des réponses générées.

La taille de la fenêtre de contexte affecte directement les performances des LLM. Avec une fenêtre de contexte plus grande, les modèles peuvent traiter des entrées plus longues et générer des sorties plus pertinentes sur le plan contextuel. Cela est particulièrement important pour des tâches comme le résumé de documents ou la génération de contenus longs, où la compréhension du contexte global est essentielle.

Cependant, l’augmentation de la taille de la fenêtre de contexte présente aussi des défis. Les fenêtres plus grandes nécessitent davantage de ressources de calcul, et les gains de performance peuvent devenir marginaux. Trouver le bon équilibre entre la taille de la fenêtre de contexte et l’efficacité est une considération clé dans la conception et le déploiement des LLM.

Différents LLM proposent diverses tailles de fenêtres de contexte. Par exemple :

La tokenisation est le processus qui consiste à diviser un texte en unités plus petites appelées jetons. En TALN, il s’agit d’une étape fondamentale qui permet aux modèles d’IA de traiter et d’analyser les données textuelles. Les jetons peuvent être des mots, des sous-mots, voire des caractères individuels, selon la langue et l’algorithme de tokenisation utilisé.

Par exemple, la phrase « The quick brown fox jumps over the lazy dog » peut être tokenisée en mots ou en sous-mots, permettant au modèle de traiter chaque élément séquentiellement. La tokenisation aide à standardiser les données d’entrée et à les rendre gérables pour le calcul.

L’encodage positionnel est une technique utilisée dans les modèles de type transformeur pour intégrer des informations sur la position des jetons dans la séquence. Puisque les transformeurs traitent les jetons en parallèle plutôt que séquentiellement, l’encodage positionnel garantit que le modèle est conscient de l’ordre des jetons, ce qui est crucial pour comprendre la syntaxe et le sens du texte.

En Python, l’encodage positionnel peut être implémenté ainsi :

import torch

import math

def positional_encoding(position, d_model):

pe = torch.zeros(position, d_model)

for pos in range(position):

for i in range(0, d_model, 2):

pe[pos, i] = math.sin(pos / (10000 ** ((2 * i)/d_model)))

pe[pos, i + 1] = math.cos(pos / (10000 ** ((2 * (i + 1))/d_model)))

return pe

Ce code génère une matrice d’encodage positionnel qui peut être ajoutée aux embeddings des jetons, fournissant au modèle des informations sur la position de chaque jeton.

Dans le contexte du fenêtrage, la tokenisation et l’encodage positionnel travaillent ensemble pour permettre au modèle de traiter des séquences de jetons à l’intérieur de la fenêtre de contexte. La tokenisation divise le texte en unités compréhensibles par le modèle, tandis que l’encodage positionnel préserve l’ordre de ces jetons. Cette combinaison permet au système d’IA d’analyser le texte avec précision dans chaque fenêtre, en maintenant la cohérence et le contexte nécessaires à la génération de réponses pertinentes.

L’un des principaux défis du fenêtrage en IA réside dans la complexité computationnelle liée au traitement de grandes fenêtres de contexte. À mesure que la taille de la fenêtre augmente, les ressources de calcul nécessaires pour le traitement croissent également, souvent de façon exponentielle. Cela peut engendrer des coûts accrus et des temps de traitement plus longs, ce qui peut ne pas être pratique pour les applications en temps réel ou le déploiement sur des dispositifs aux ressources limitées.

Bien que le fenêtrage facilite la gestion efficace des données, il peut aussi entraîner une perte d’information. En se concentrant uniquement sur les données à l’intérieur de la fenêtre de contexte, le modèle risque de manquer des informations importantes situées en dehors de celle-ci. Cela peut impacter la précision des prédictions ou la pertinence des réponses générées, en particulier pour les tâches nécessitant une compréhension plus large des données.

Trouver le bon équilibre entre la taille de la fenêtre de contexte et l’efficacité computationnelle est un défi majeur. Une fenêtre trop petite peut ne pas fournir suffisamment de contexte pour permettre au modèle d’être performant, tandis qu’une fenêtre trop grande peut être gourmande en ressources et lente. Cela nécessite une réflexion et une optimisation soigneuses lors de la conception et du déploiement du modèle.

Le fenêtrage peut rendre difficile pour les modèles de saisir les dépendances à long terme dans les données séquentielles. En traitement du langage, comprendre la relation entre des mots ou phrases éloignés est important pour des tâches telles que l’analyse du discours ou la compréhension narrative. Le fenêtrage limite la vision du modèle à une plage fixe, ce qui peut entraver sa capacité à saisir ces relations à longue portée.

Le fenêtrage en IA est le processus qui consiste à diviser les données en segments, ou fenêtres, afin d’analyser efficacement des informations séquentielles. Il aide les modèles à gérer le contexte et les ressources de calcul, en particulier en TALN et dans les grands modèles de langage.

Le fenêtrage permet aux TALN et LLM de traiter des segments de texte gérables, optimisant l’utilisation des ressources et rendant possible une analyse sensible au contexte. C’est crucial pour des tâches comme la traduction, l’analyse de sentiment et l’IA conversationnelle.

Le fenêtrage est utilisé en TALN pour l’analyse de texte, la traduction automatique, les chatbots pour gérer les conversations, et l’analyse de séries temporelles pour détecter des tendances et des motifs dans des plages temporelles définies.

Les défis incluent la complexité computationnelle avec de grandes fenêtres, le risque de perte d’information hors de la fenêtre, l’équilibre à trouver entre la taille de la fenêtre, le contexte et l’efficacité, ainsi que la difficulté à saisir les dépendances à long terme dans les données séquentielles.

Des chatbots intelligents et des outils d’IA sous un même toit. Connectez des blocs intuitifs pour transformer vos idées en Flows automatisés.

Le traitement automatique du langage naturel (TALN) permet aux ordinateurs de comprendre, d’interpréter et de générer le langage humain à l’aide de la linguisti...

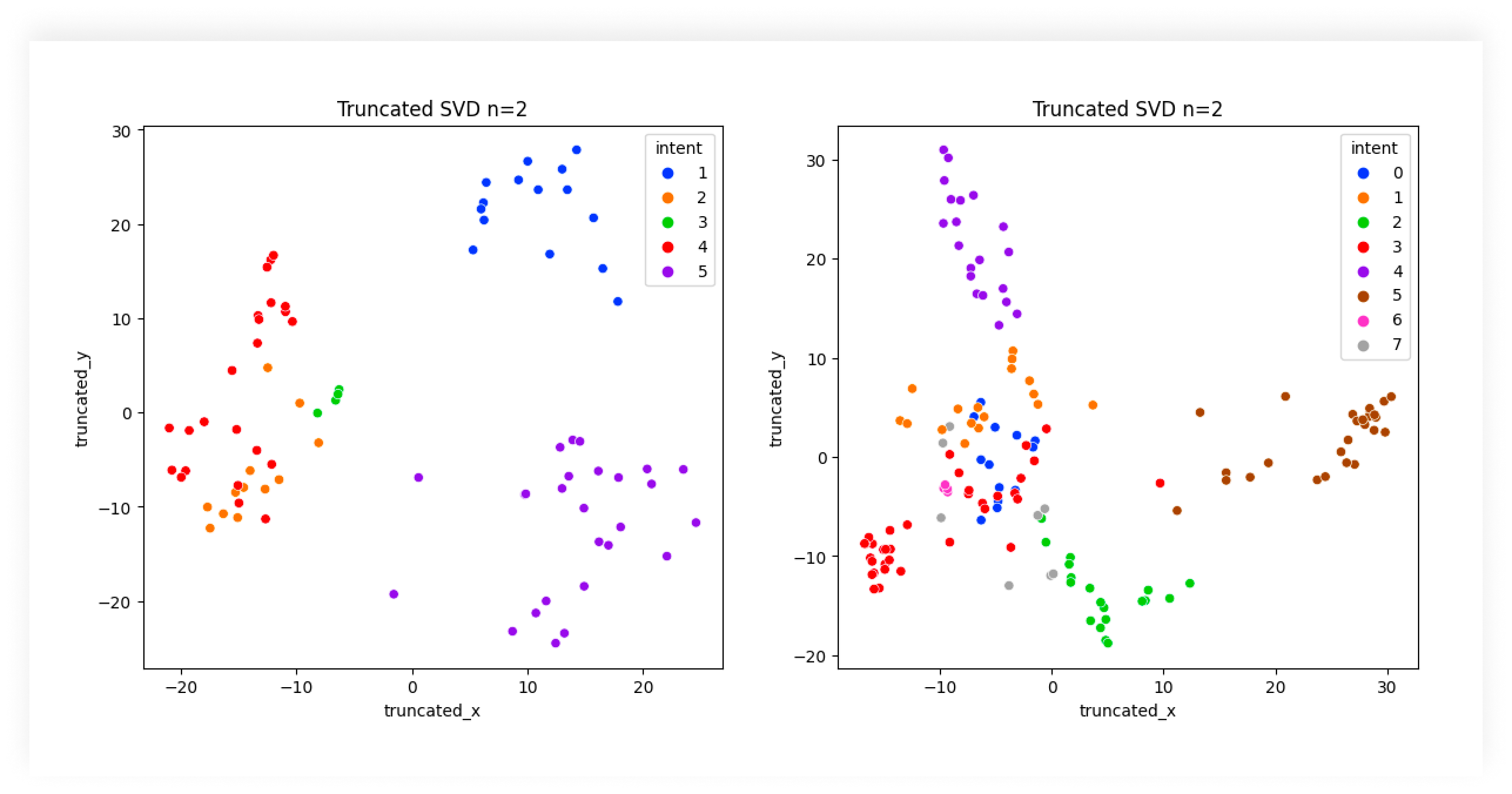

Découvrez le rôle essentiel de la classification d'intentions par l'IA pour améliorer les interactions utilisateurs avec la technologie, optimiser le support cl...

Le traitement automatique du langage naturel (TALN) est un sous-domaine de l'intelligence artificielle (IA) qui permet aux ordinateurs de comprendre, d'interpré...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.