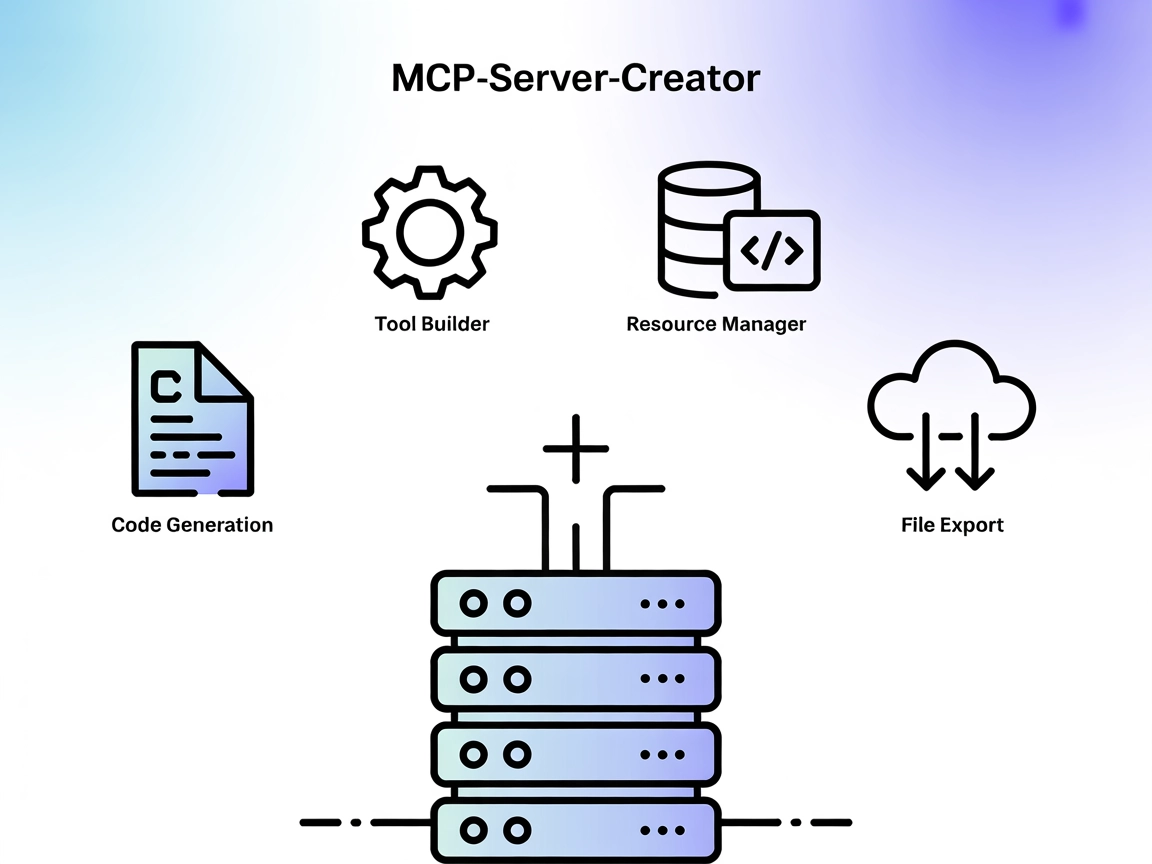

Serveur MCP-Server-Creator MCP

Le MCP-Server-Creator est un méta-serveur qui permet la création et la configuration rapides de nouveaux serveurs Model Context Protocol (MCP). Grâce à la génér...

Exécutez du code Python, installez des dépendances et gérez des environnements isolés directement dans vos flux FlowHunt avec le serveur MCP Code Executor.

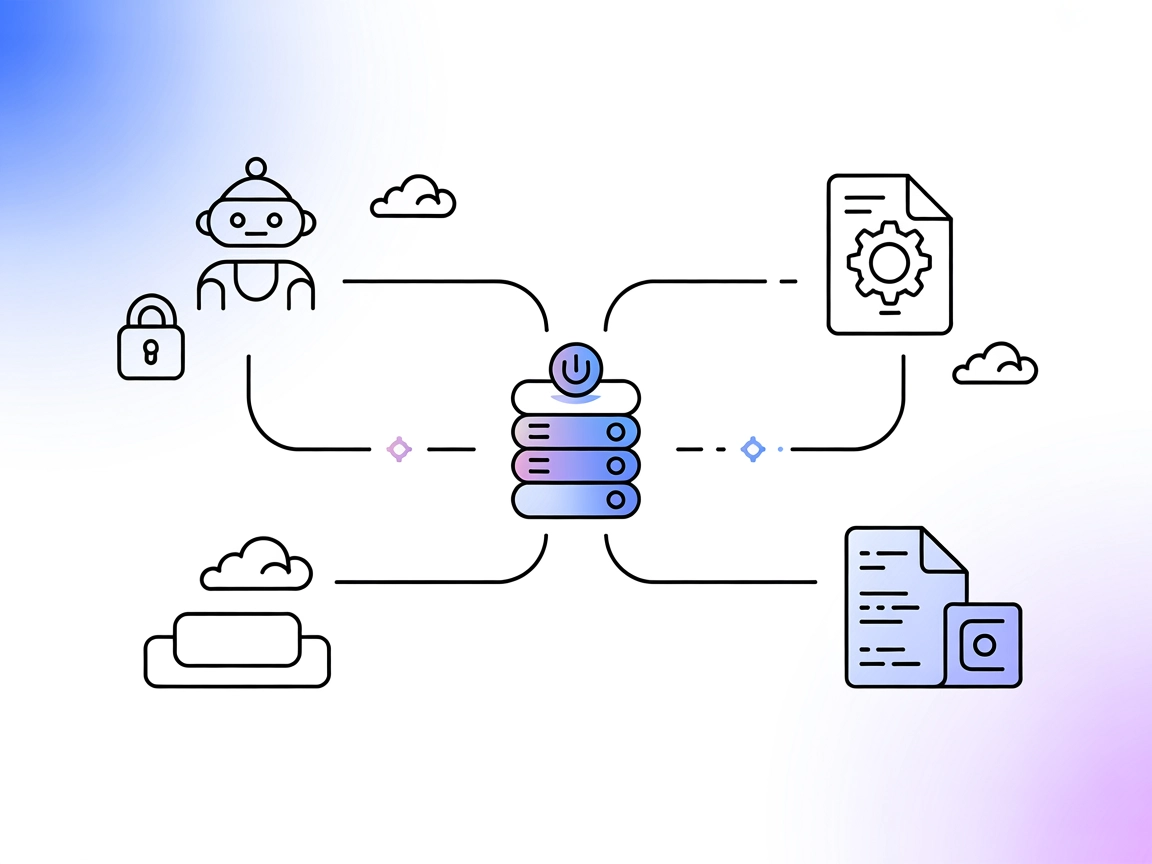

FlowHunt fournit une couche de sécurité supplémentaire entre vos systèmes internes et les outils d'IA, vous donnant un contrôle granulaire sur les outils accessibles depuis vos serveurs MCP. Les serveurs MCP hébergés dans notre infrastructure peuvent être intégrés de manière transparente avec le chatbot de FlowHunt ainsi qu'avec les plateformes d'IA populaires comme ChatGPT, Claude et divers éditeurs d'IA.

Le MCP Code Executor est un serveur MCP (Model Context Protocol) qui permet aux modèles de langage (LLM) d’exécuter du code Python au sein d’un environnement Python dédié, tel que Conda, virtualenv ou UV virtualenv. En reliant les assistants IA à de véritables environnements Python exécutables, il leur permet d’accomplir un large éventail de tâches de développement nécessitant exécution de code, gestion de bibliothèques et configuration dynamique d’environnement. Ce serveur prend en charge la génération de code incrémentale pour dépasser les limites de tokens, autorise l’installation à la volée de dépendances et facilite la configuration de l’environnement d’exécution. Les développeurs peuvent s’appuyer sur cet outil pour automatiser l’évaluation de code, expérimenter de nouveaux packages et gérer les calculs dans un environnement contrôlé et sécurisé.

Aucun modèle de prompt explicite n’est listé dans le dépôt ou la documentation.

Aucune ressource spécifique n’est décrite dans le dépôt ou la documentation.

{

"mcpServers": {

"mcp-code-executor": {

"command": "node",

"args": [

"/path/to/mcp_code_executor/build/index.js"

],

"env": {

"CODE_STORAGE_DIR": "/path/to/code/storage",

"ENV_TYPE": "conda",

"CONDA_ENV_NAME": "your-conda-env"

}

}

}

}

{

"mcpServers": {

"mcp-code-executor": {

"env": {

"CODE_STORAGE_DIR": "/path/to/code/storage",

"ENV_TYPE": "conda",

"CONDA_ENV_NAME": "your-conda-env",

"MY_SECRET_API_KEY": "${MY_SECRET_API_KEY}"

},

"inputs": {

"apiKey": "${MY_SECRET_API_KEY}"

}

}

}

}

{

"mcpServers": {

"mcp-code-executor": {

"command": "node",

"args": [

"/path/to/mcp_code_executor/build/index.js"

],

"env": {

"CODE_STORAGE_DIR": "/path/to/code/storage",

"ENV_TYPE": "conda",

"CONDA_ENV_NAME": "your-conda-env"

}

}

}

}

{

"mcpServers": {

"mcp-code-executor": {

"command": "node",

"args": [

"/path/to/mcp_code_executor/build/index.js"

],

"env": {

"CODE_STORAGE_DIR": "/path/to/code/storage",

"ENV_TYPE": "conda",

"CONDA_ENV_NAME": "your-conda-env"

}

}

}

}

{

"mcpServers": {

"mcp-code-executor": {

"command": "node",

"args": [

"/path/to/mcp_code_executor/build/index.js"

],

"env": {

"CODE_STORAGE_DIR": "/path/to/code/storage",

"ENV_TYPE": "conda",

"CONDA_ENV_NAME": "your-conda-env"

}

}

}

}

Remarque : Vous pouvez également utiliser Docker. Le Dockerfile fourni est testé pour le type d’environnement

venv-uv:

{

"mcpServers": {

"mcp-code-executor": {

"command": "docker",

"args": [

"run",

"-i",

"--rm",

"mcp-code-executor"

]

}

}

}

Utilisation de MCP dans FlowHunt

Pour intégrer des serveurs MCP à votre workflow FlowHunt, commencez par ajouter le composant MCP à votre flux et reliez-le à votre agent IA :

Cliquez sur le composant MCP pour ouvrir le panneau de configuration. Dans la section configuration système MCP, insérez les détails de votre serveur MCP au format JSON suivant :

{

"mcp-code-executor": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Une fois configuré, l’agent IA pourra utiliser ce MCP comme un outil avec accès à toutes ses fonctions et capacités. Pensez à remplacer “mcp-code-executor” par le nom réel de votre serveur MCP et l’URL par celle de votre serveur MCP.

| Section | Disponibilité | Détails/Remarques |

|---|---|---|

| Vue d’ensemble | ✅ | |

| Liste des prompts | ⛔ | Aucun modèle de prompt trouvé |

| Liste des ressources | ⛔ | Aucune ressource explicite décrite |

| Liste des outils | ✅ | execute_code, install_dependencies, check_installed_packages |

| Sécurisation des clés API | ✅ | Exemple fourni avec variables env |

| Support du sampling (moins important ici) | ⛔ | Non spécifié |

Ce serveur MCP offre des fonctionnalités essentielles et robustes pour l’exécution de code avec intégration LLM, ainsi que des instructions d’installation claires et des outils adaptés. Cependant, il manque de modèles de prompt, de ressources explicites, et d’informations sur les racines ou le support du sampling. Pour un MCP focalisé sur l’exécution de code, il est très solide, obtenant une excellente note pour son utilité pratique et sa facilité d’intégration, mais il perd quelques points sur l’absence de fonctions MCP avancées et l’exhaustivité de la documentation.

| Possède une LICENCE | ✅ (MIT) |

|---|---|

| Au moins un outil fourni | ✅ |

| Nombre de Forks | 25 |

| Nombre d’étoiles | 144 |

C'est un serveur Model Context Protocol (MCP) qui permet aux modèles de langage d'exécuter du code Python dans des environnements sécurisés et isolés (comme Conda ou venv), de gérer les dépendances et de configurer les environnements d'exécution. Idéal pour l'évaluation de code, la data science, les workflows automatisés et la configuration d'environnements dynamiques avec FlowHunt.

Il fournit des outils pour exécuter du code Python (`execute_code`), installer des dépendances à la volée (`install_dependencies`) et vérifier les packages installés (`check_installed_packages`).

Ajoutez MCP Code Executor en tant que composant MCP dans votre flux, puis configurez-le avec l'URL de votre serveur et la méthode de transport. Cela permet à vos agents IA d'utiliser ses capacités d'exécution de code et de gestion d'environnement dans FlowHunt.

Oui, le serveur prend en charge l'exécution de code dans des environnements Conda ou virtualenv isolés, assurant la reproductibilité et évitant les conflits de dépendances.

Oui, le serveur peut exécuter le code de manière incrémentale, ce qui est utile pour gérer du code dépassant les limites de tokens des LLM.

Oui, vous pouvez utiliser le Dockerfile fourni et configurer le serveur MCP pour fonctionner dans un conteneur Docker pour un isolement supplémentaire.

Renforcez vos flux avec une exécution sécurisée et automatisée de code Python. Intégrez le serveur MCP Code Executor et débloquez des workflows dynamiques pour la data science, l'automatisation et plus encore.

Le MCP-Server-Creator est un méta-serveur qui permet la création et la configuration rapides de nouveaux serveurs Model Context Protocol (MCP). Grâce à la génér...

Le serveur MCP Coda offre un moyen standardisé pour les assistants IA d'interagir avec la plateforme Coda, permettant des requêtes sur les documents, l'automati...

Le serveur MCP pydanticpydantic-aimcp-run-python fait le lien entre les assistants IA et des environnements d’exécution Python sécurisés et contrôlés. Il permet...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.