Serveur Model Context Protocol (MCP)

Le serveur Model Context Protocol (MCP) fait le lien entre les assistants IA et des sources de données externes, des API et des services, permettant une intégra...

Connectez les assistants IA avec les workflows Dify pour automatiser, orchestrer et gérer les processus sur des environnements cloud et locaux à l’aide du serveur Dify MCP.

FlowHunt fournit une couche de sécurité supplémentaire entre vos systèmes internes et les outils d'IA, vous donnant un contrôle granulaire sur les outils accessibles depuis vos serveurs MCP. Les serveurs MCP hébergés dans notre infrastructure peuvent être intégrés de manière transparente avec le chatbot de FlowHunt ainsi qu'avec les plateformes d'IA populaires comme ChatGPT, Claude et divers éditeurs d'IA.

Le serveur dify MCP (Model Context Protocol) est une passerelle qui connecte les assistants IA aux workflows Dify, leur permettant d’interagir avec des sources de données, des API et des services externes. En exposant les outils de workflow Dify via l’interface MCP, ce serveur autorise les agents IA à déclencher et gérer les workflows Dify de façon programmatique. Cela enrichit les workflows de développement en autorisant les systèmes IA à interroger des bases de données, gérer des fichiers ou interagir avec des API en utilisant Dify comme backend. Le serveur accepte une configuration via variables d’environnement ou fichiers YAML, ce qui le rend adaptable à la fois pour le cloud et les environnements locaux.

Aucune information fournie sur les modèles de prompt dans le dépôt.

Aucune ressource explicite documentée dans le dépôt ou le README.

Aucune liste explicite d’outils trouvée dans le dépôt ou le README. Il est fait mention des « outils du MCP » mais sans nom ou description spécifique.

Vérifiez que les prérequis comme Node.js et uvx/uv sont installés.

Préparez la configuration via les variables d’environnement ou un fichier YAML.

Ajoutez le serveur Dify MCP à votre configuration :

{

"mcpServers": {

"dify-mcp-server": {

"command": "uvx",

"args": [

"--from", "git+https://github.com/YanxingLiu/dify-mcp-server", "dify_mcp_server"

],

"env": {

"DIFY_BASE_URL": "https://cloud.dify.ai/v1",

"DIFY_APP_SKS": "app-sk1,app-sk2"

}

}

}

}

Sauvegardez et redémarrez Windsurf.

Vérifiez que le serveur fonctionne et que les workflows sont accessibles.

Installez uvx ou uv et configurez les variables d’environnement ou un fichier de config.

Ajoutez la configuration suivante au client Claude MCP :

{

"mcpServers": {

"dify-mcp-server": {

"command": "uvx",

"args": [

"--from", "git+https://github.com/YanxingLiu/dify-mcp-server", "dify_mcp_server"

],

"env": {

"DIFY_BASE_URL": "https://cloud.dify.ai/v1",

"DIFY_APP_SKS": "app-sk1,app-sk2"

}

}

}

}

Sauvegardez, redémarrez et vérifiez la configuration.

Vérifiez que uvx/uv est installé et que les variables d’environnement sont définies ou préparez un config.yaml.

Insérez la configuration du serveur dans la config MCP de Cursor :

{

"mcpServers": {

"dify-mcp-server": {

"command": "uvx",

"args": [

"--from", "git+https://github.com/YanxingLiu/dify-mcp-server", "dify_mcp_server"

],

"env": {

"DIFY_BASE_URL": "https://cloud.dify.ai/v1",

"DIFY_APP_SKS": "app-sk1,app-sk2"

}

}

}

}

Sauvegardez et redémarrez Cursor.

Confirmez le fonctionnement du serveur.

Installez uvx/uv et configurez les variables d’environnement ou fournissez un config.yaml.

Ajoutez le serveur Dify MCP à la configuration MCP :

{

"mcpServers": {

"dify-mcp-server": {

"command": "uvx",

"args": [

"--from", "git+https://github.com/YanxingLiu/dify-mcp-server", "dify_mcp_server"

],

"env": {

"DIFY_BASE_URL": "https://cloud.dify.ai/v1",

"DIFY_APP_SKS": "app-sk1,app-sk2"

}

}

}

}

Sauvegardez et redémarrez Cline.

Vérifiez que les workflows Dify sont accessibles.

Utilisez toujours des variables d’environnement pour stocker les données sensibles comme les clés API. Exemple de configuration :

{

"mcpServers": {

"dify-mcp-server": {

"command": "uvx",

"args": [

"--from", "git+https://github.com/YanxingLiu/dify-mcp-server", "dify_mcp_server"

],

"env": {

"DIFY_BASE_URL": "https://cloud.dify.ai/v1",

"DIFY_APP_SKS": "${DIFY_APP_SKS}" // Utilisez la variable d’environnement système

}

}

}

}

Utilisation de MCP dans FlowHunt

Pour intégrer des serveurs MCP dans votre workflow FlowHunt, commencez par ajouter le composant MCP à votre flow et connectez-le à votre agent IA :

Cliquez sur le composant MCP pour ouvrir le panneau de configuration. Dans la section de configuration système MCP, insérez les détails de votre serveur MCP en utilisant ce format JSON :

{

"dify-mcp-server": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Une fois la configuration terminée, l’agent IA pourra utiliser ce MCP comme un outil avec accès à toutes ses fonctions et capacités. N’oubliez pas de remplacer “dify-mcp-server” par le vrai nom de votre serveur MCP et de mettre l’URL de votre propre serveur MCP.

| Section | Disponibilité | Détails/Remarques |

|---|---|---|

| Vue d’ensemble | ✅ | |

| Liste des prompts | ⛔ | Aucun prompt/modèle trouvé |

| Liste des ressources | ⛔ | Aucune ressource explicite documentée |

| Liste des outils | ⛔ | Aucun outil explicite listé |

| Sécurisation des clés API | ✅ | Variables d’env. & config.yaml pris en charge |

| Prise en charge de l’échantillonnage | ⛔ | Non mentionné |

D’après les informations disponibles, ce serveur MCP offre une intégration basique mais robuste des workflows Dify dans les plateformes compatibles MCP. Cependant, la documentation concernant les prompts, ressources et outils est absente, ce qui limite son usage pour les interactions LLM avancées ou standardisées.

Score MCP : 4/10.

Le dify-mcp-server est facile à configurer et propose un vrai support cloud/local, mais il manque de documentation sur les prompts, ressources et outils, ce qui limite son utilité MCP à plus grande échelle.

| Dispose d’une LICENCE | ⛔ (aucun fichier LICENSE détecté) |

|---|---|

| Dispose d’au moins un outil | ⛔ |

| Nombre de forks | 31 |

| Nombre d’étoiles | 238 |

Le serveur Dify MCP agit comme une passerelle entre les assistants IA et les workflows Dify, permettant l’automatisation et l’orchestration d’appels API externes, de la gestion de fichiers et de l’exécution de workflows via le protocole MCP.

Il sert à l’orchestration de workflows, l’intégration d’API, l’accès à des workflows cloud et la gestion centralisée de plusieurs workflows Dify depuis une seule instance du serveur MCP.

Utilisez toujours des variables d’environnement pour stocker les informations sensibles comme les clés API. Vous pouvez référencer ces variables dans la configuration du serveur afin de garder vos identifiants sécurisés.

Aucun modèle de prompt ni liste explicite d’outils n’est fournie dans la documentation actuelle, ce qui peut limiter les cas d’usage avancés pour les LLM.

Ajoutez le composant MCP à votre flow dans FlowHunt, puis configurez-le avec les paramètres de votre serveur Dify MCP. Cela permet à votre agent IA d’accéder à toutes les fonctions de workflow exposées par le serveur.

Boostez vos agents IA en les connectant aux workflows Dify via le serveur Dify MCP. Automatisez des processus complexes et des appels API en toute simplicité.

Le serveur Model Context Protocol (MCP) fait le lien entre les assistants IA et des sources de données externes, des API et des services, permettant une intégra...

Le serveur Workflowy MCP connecte les assistants IA à Workflowy, permettant la prise de notes automatisée, la gestion de projet et des workflows de productivité...

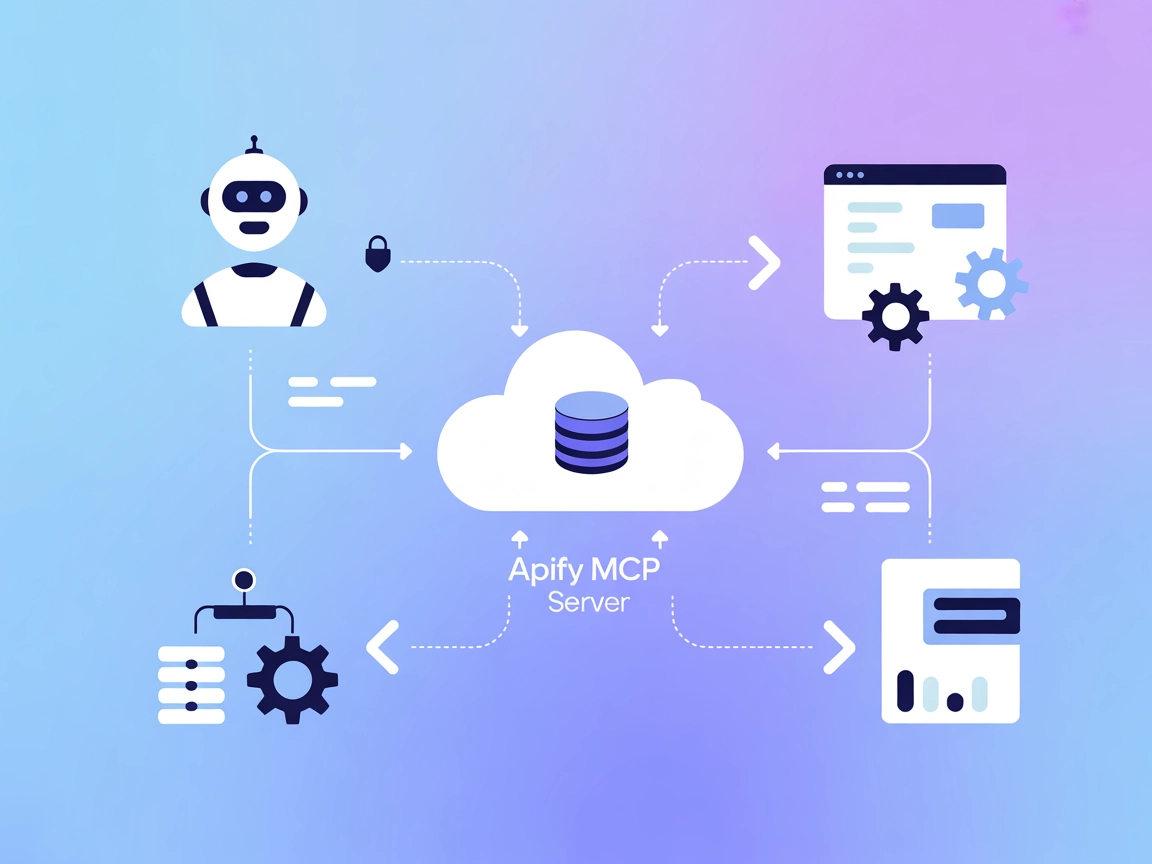

Le serveur Apify MCP connecte les assistants IA à la plateforme Apify, permettant une automatisation transparente, l’extraction de données et l’orchestration de...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.