Serveur MCP DeepSeek

Le serveur MCP DeepSeek agit en tant que proxy sécurisé, connectant les modèles de langage avancés de DeepSeek aux applications compatibles MCP comme Claude Des...

Le serveur DeepSeek MCP agit comme un pont axé sur la confidentialité entre vos applications et les modèles de langage DeepSeek, permettant des intégrations IA sécurisées et évolutives.

FlowHunt fournit une couche de sécurité supplémentaire entre vos systèmes internes et les outils d'IA, vous donnant un contrôle granulaire sur les outils accessibles depuis vos serveurs MCP. Les serveurs MCP hébergés dans notre infrastructure peuvent être intégrés de manière transparente avec le chatbot de FlowHunt ainsi qu'avec les plateformes d'IA populaires comme ChatGPT, Claude et divers éditeurs d'IA.

Le serveur DeepSeek MCP est un serveur Model Context Protocol (MCP) conçu pour intégrer les modèles de langage avancés de DeepSeek avec des applications compatibles MCP, telles que Claude Desktop. Agissant comme un pont, il permet aux assistants IA de se connecter aux APIs DeepSeek, facilitant des tâches comme la génération de texte, l’analyse, et plus encore. Le serveur fonctionne en tant que proxy, garantissant que les requêtes API sont traitées de façon sécurisée et anonyme — seul le serveur proxy est visible de l’API DeepSeek, et non le client. Cette conception renforce la confidentialité, simplifie l’intégration aux workflows, et permet aux développeurs et outils IA de tirer parti des capacités DeepSeek pour améliorer développement, recherche et automatisation.

Aucun modèle d’invite n’a été listé dans le dépôt ou la documentation.

Aucune ressource MCP explicite n’est documentée dans le dépôt ou le README.

Aucune liste explicite d’outils ou de fonctions d’outils n’est décrite dans le README ou le contenu du dépôt.

windsurf.config.json).mcpServers avec commande et arguments.{

"mcpServers": {

"deepseek-mcp": {

"command": "npx",

"args": ["@deepseek/mcp-server@latest"]

}

}

}

mcpServers.{

"mcpServers": {

"deepseek-mcp": {

"command": "npx",

"args": ["@deepseek/mcp-server@latest"]

}

}

}

mcpServers.{

"mcpServers": {

"deepseek-mcp": {

"command": "npx",

"args": ["@deepseek/mcp-server@latest"]

}

}

}

mcpServers.{

"mcpServers": {

"deepseek-mcp": {

"command": "npx",

"args": ["@deepseek/mcp-server@latest"]

}

}

}

Stockez votre clé API DeepSeek dans une variable d’environnement pour plus de sécurité. Transmettez-la au serveur via la section env :

{

"mcpServers": {

"deepseek-mcp": {

"command": "npx",

"args": ["@deepseek/mcp-server@latest"],

"env": {

"DEEPSEEK_API_KEY": "${DEEPSEEK_API_KEY}"

}

}

}

}

Utiliser MCP dans FlowHunt

Pour intégrer des serveurs MCP à votre workflow FlowHunt, commencez par ajouter le composant MCP à votre flux et connectez-le à votre agent IA :

Cliquez sur le composant MCP pour ouvrir le panneau de configuration. Dans la section de configuration système MCP, insérez les détails de votre serveur MCP au format JSON suivant :

{

"deepseek-mcp": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Une fois configuré, l’agent IA pourra utiliser ce MCP en tant qu’outil avec accès à toutes ses fonctions et capacités. N’oubliez pas de remplacer “deepseek-mcp” par le vrai nom de votre serveur MCP et de remplacer l’URL par celle de votre propre serveur MCP.

| Section | Disponibilité | Détails/Remarques |

|---|---|---|

| Aperçu | ✅ | Présent dans le README |

| Liste des modèles d’invite | ⛔ | Aucun modèle d’invite listé |

| Liste des ressources | ⛔ | Aucune ressource MCP explicitement documentée |

| Liste des outils | ⛔ | Aucun outil explicitement décrit |

| Sécurisation des clés API | ✅ | Exemple fourni via variables d’environnement |

| Support du sampling (moins important ici) | ⛔ | Aucune mention du support sampling |

Support des roots : Non mentionné

J’attribuerais à ce serveur MCP une note de 4/10 pour sa documentation et son utilité pratique d’après le README et le contenu du dépôt. Si la configuration et les aspects confidentialité sont clairs, il manque des détails sur les prompts, ressources et outils, ce qui limite l’utilisation pour des workflows MCP avancés.

| Présence d’une LICENSE | ✅ (MIT) |

|---|---|

| Au moins un outil | ⛔ |

| Nombre de forks | 32 |

| Nombre d’étoiles | 242 |

Le serveur DeepSeek MCP est un proxy qui intègre les modèles de langage DeepSeek avec des applications compatibles MCP, offrant un accès sécurisé et anonymisé aux APIs DeepSeek pour des tâches telles que la génération et l’analyse de texte.

Il agit comme un proxy, ce qui signifie que l’API DeepSeek ne voit que le serveur et non le client. Cela garantit que les requêtes sont traitées de manière anonyme, protégeant l’identité du client et les clés API.

Les cas d’usage incluent l’intégration des modèles DeepSeek dans des outils de développement, l’automatisation de la génération ou l’analyse de contenu, la mise en place de workflows IA respectueux de la vie privée, et un accès évolutif aux modèles de langage dans des systèmes basés sur MCP.

Stockez la clé API dans une variable d’environnement et transmettez-la au serveur via la section `env` de la configuration. Cela évite une exposition accidentelle dans le code ou les journaux.

Non, la documentation actuelle ne liste pas de modèles d’invite ni de fonctions d’outil explicites pour ce serveur MCP.

Ajoutez le composant MCP à votre flux FlowHunt, ouvrez sa configuration et insérez les détails de votre serveur MCP dans la section de configuration système MCP au format JSON fourni.

Profitez d’un accès sécurisé, évolutif et respectueux de la vie privée aux puissants modèles de langage DeepSeek grâce au serveur DeepSeek MCP. Idéal pour les développeurs, chercheurs et créateurs d’outils IA.

Le serveur MCP DeepSeek agit en tant que proxy sécurisé, connectant les modèles de langage avancés de DeepSeek aux applications compatibles MCP comme Claude Des...

Le serveur MCP Deepseek Thinker intègre le raisonnement du modèle Deepseek dans les clients IA compatibles MCP comme Claude Desktop, fournissant des sorties ava...

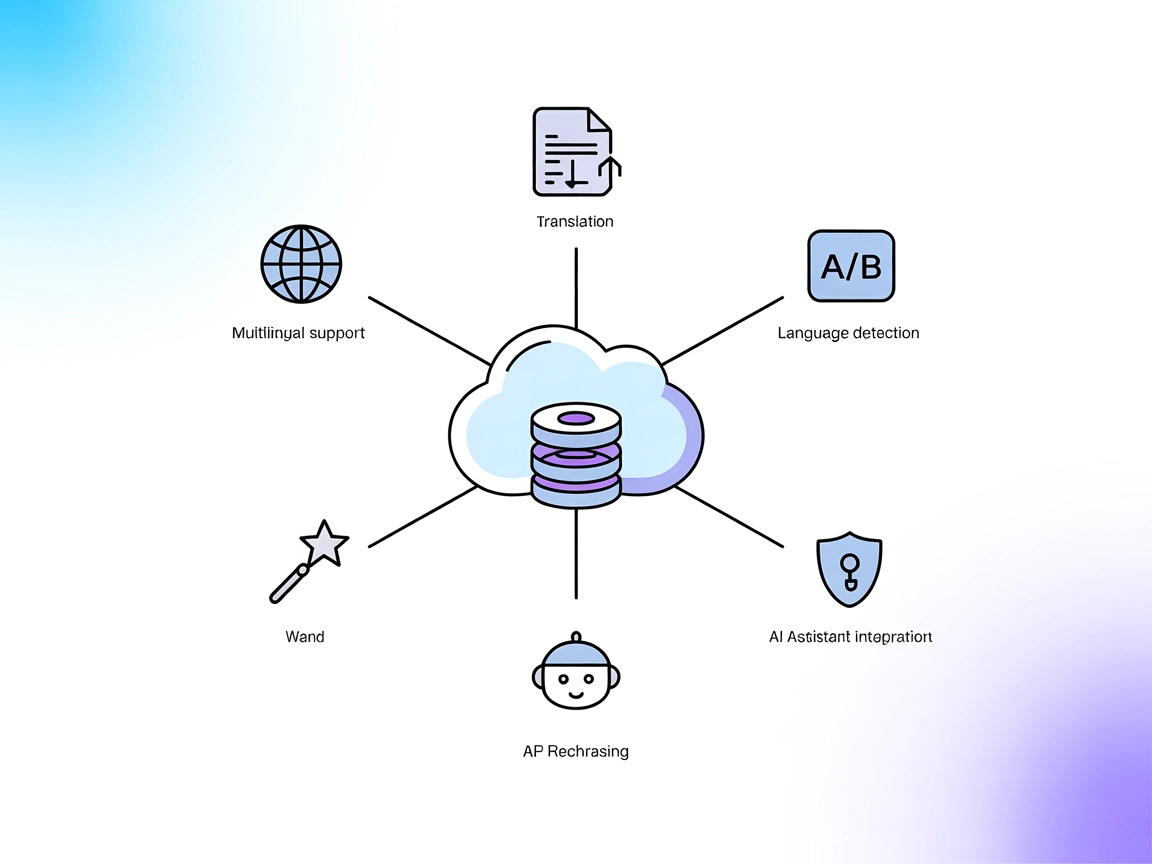

Le serveur DeepL MCP intègre la traduction avancée, la reformulation et la détection de langue dans les flux de travail IA via l’API DeepL. Il offre à FlowHunt ...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.