Prompt

Utwórz szablon prompta z dynamicznymi zmiennymi ({input}, {human_input}, {context}, {chat_history}, {system_message}, {all_input_variables}).

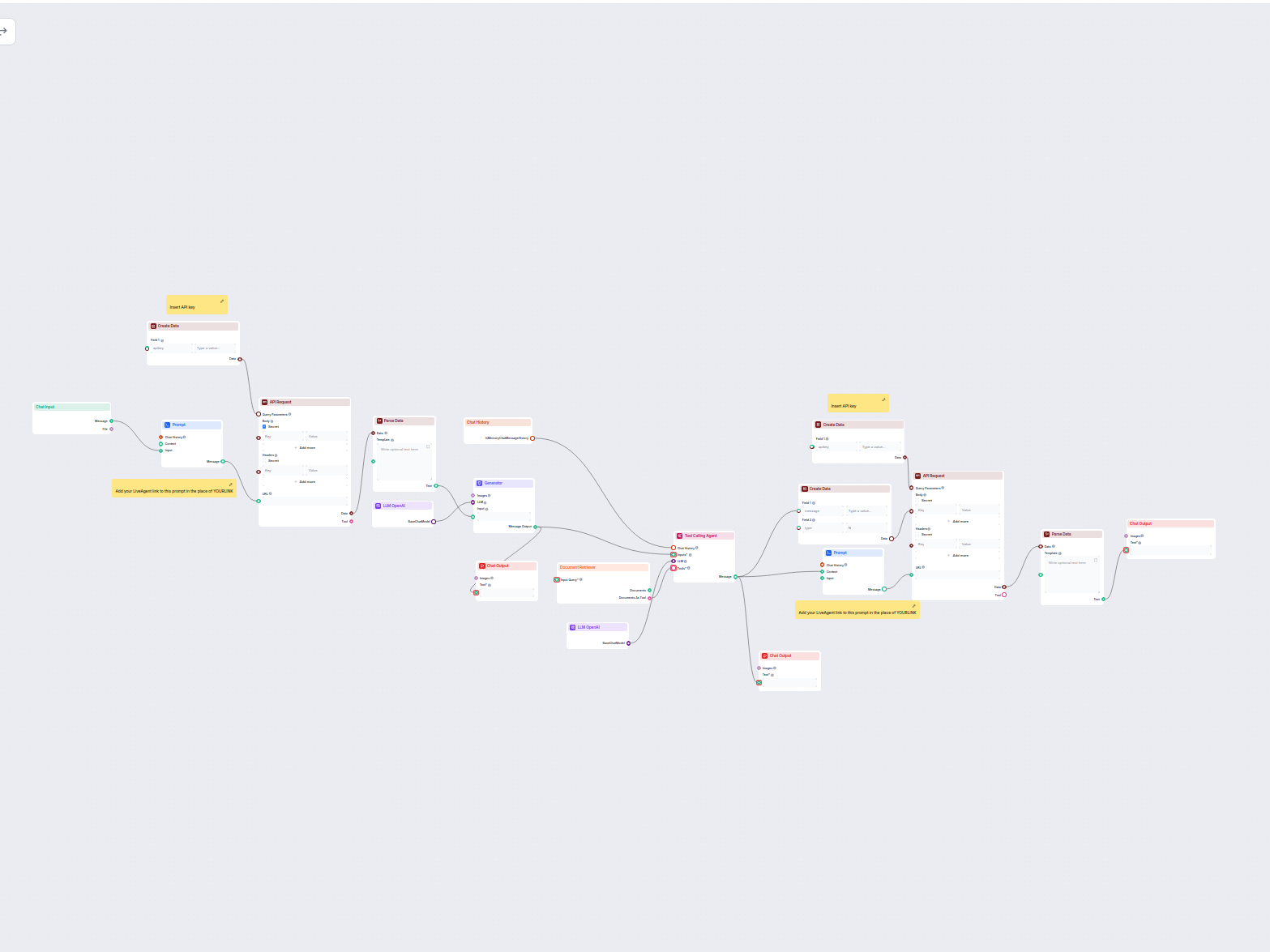

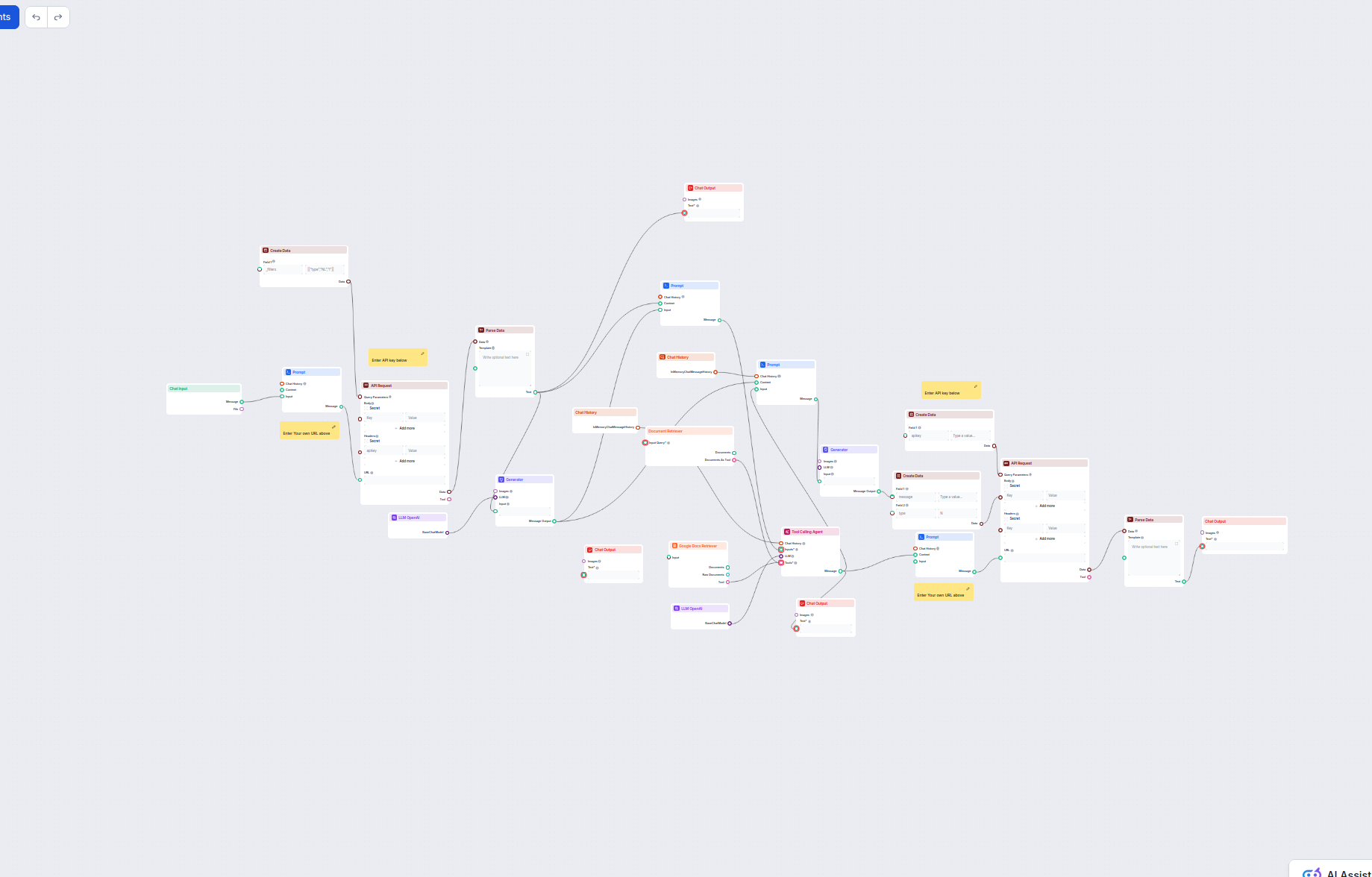

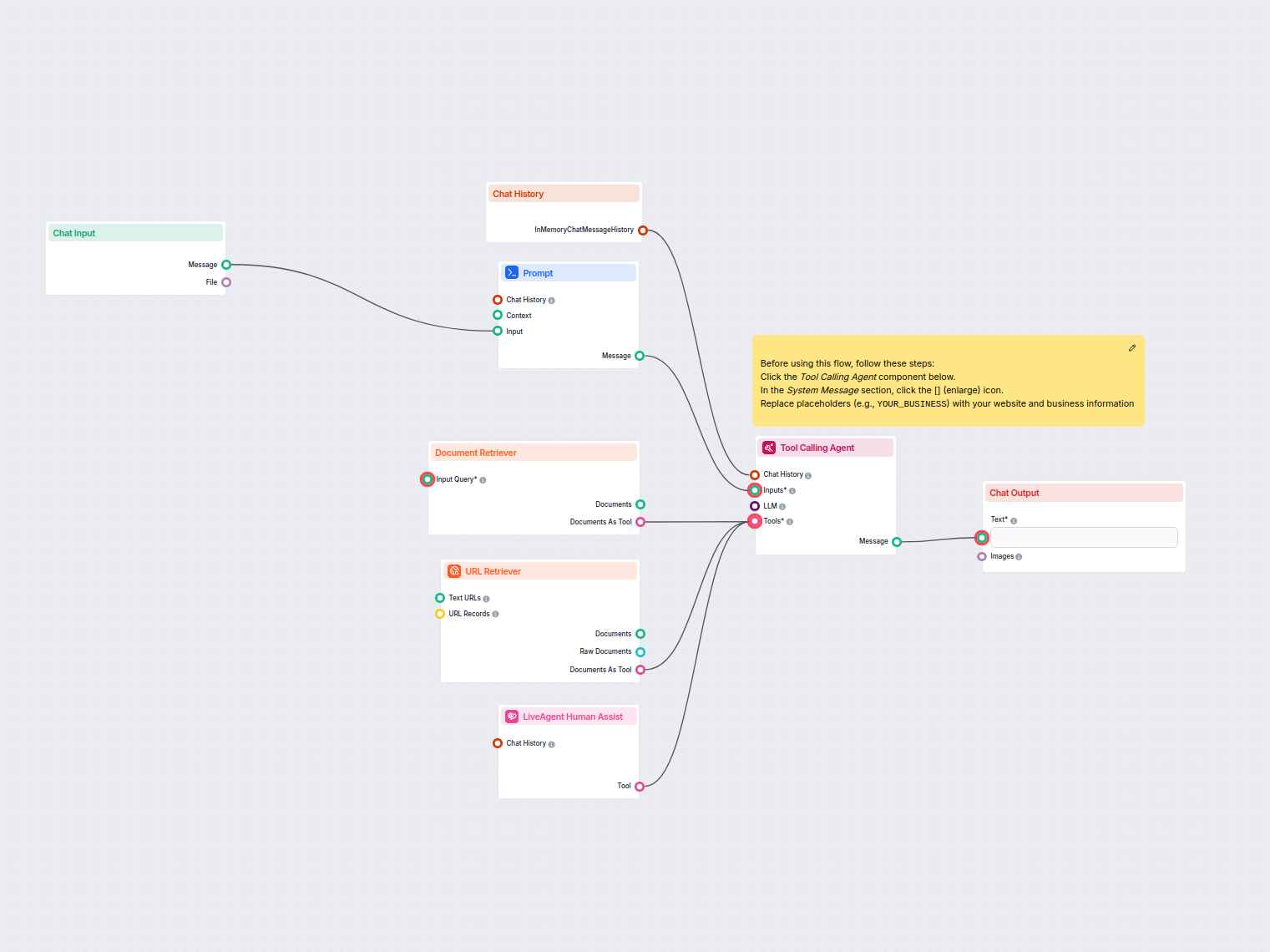

Ten workflow automatyzuje obsługę klienta w Twojej firmie poprzez integrację rozmów z LiveAgent, wydobywanie istotnych danych z konwersacji, generowanie odpowiedzi za pomocą modeli AI oraz pobieranie dokumentów z bazy wiedzy. Agent AI obsługuje napływające zapytania, wzbogaca kontekst o źródła wiedzy i dostarcza krótkie, profesjonalne odpowiedzi w przyjaznym dla klienta formacie.

Przepływy

Utwórz szablon prompta z dynamicznymi zmiennymi ({input}, {human_input}, {context}, {chat_history}, {system_message}, {all_input_variables}).

Utwórz szablon prompta z dynamicznymi zmiennymi ({input}, {human_input}, {context}, {chat_history}, {system_message}, {all_input_variables}).

Generuj tekst na podstawie prompta wejściowego i wybranego modelu LLM.

Agent wywołujący narzędzia.

Poniżej znajduje się pełna lista wszystkich komponentów wykorzystanych w tym przepływie do osiągnięcia jego funkcjonalności. Komponenty są podstawowymi elementami każdego przepływu AI. Pozwalają tworzyć złożone interakcje i automatyzować zadania poprzez łączenie różnych funkcjonalności. Każdy komponent służy określonemu celowi, takiemu jak obsługa danych wejściowych użytkownika, przetwarzanie danych lub integracja z zewnętrznymi usługami.

Komponent Chat Input w FlowHunt inicjuje interakcje z użytkownikiem, przechwytując wiadomości z Playground. Służy jako punkt początkowy dla przepływów, umożliwiając przetwarzanie zarówno tekstowych, jak i plikowych wejść.

Dowiedz się, jak komponent Prompt w FlowHunt pozwala definiować rolę i zachowanie Twojego bota AI, zapewniając trafne i spersonalizowane odpowiedzi. Dostosuj prompty i szablony dla skutecznych, kontekstowych przepływów czatbota.

Komponent Utwórz Dane umożliwia dynamiczne generowanie uporządkowanych rekordów danych z dowolną liczbą pól. Idealny do przepływów pracy wymagających tworzenia nowych obiektów danych na bieżąco, wspiera elastyczną konfigurację pól i płynną integrację z innymi krokami automatyzacji.

Integruj zewnętrzne dane i usługi w swoim workflow za pomocą komponentu Żądanie API. Bez wysiłku wysyłaj żądania HTTP, ustawiaj własne nagłówki, ciało i parametry zapytania oraz obsługuj wiele metod, takich jak GET i POST. Niezbędne do łączenia Twoich automatyzacji z dowolnym API lub usługą internetową.

Komponent Parsowanie danych przekształca dane strukturalne w zwykły tekst za pomocą konfigurowalnych szablonów. Umożliwia elastyczne formatowanie i konwersję danych wejściowych do dalszego wykorzystania w Twoim przepływie pracy, pomagając standaryzować lub przygotować informacje dla kolejnych komponentów.

FlowHunt obsługuje dziesiątki modeli generowania tekstu, w tym modele OpenAI. Oto jak używać ChatGPT w swoich narzędziach AI i chatbotach.

Poznaj komponent Generator w FlowHunt — potężne generowanie tekstu oparte na AI z wykorzystaniem wybranego modelu LLM. Bez wysiłku twórz dynamiczne odpowiedzi chatbotów, łącząc prompty, opcjonalne instrukcje systemowe, a nawet obrazy jako wejście, czyniąc Generator kluczowym narzędziem do budowy inteligentnych, konwersacyjnych przepływów pracy.

Poznaj Agenta Wywołującego Narzędzia w FlowHunt—zaawansowany komponent workflow, który umożliwia agentom AI inteligentny wybór i używanie zewnętrznych narzędzi do odpowiadania na złożone zapytania. Idealny do budowania inteligentnych rozwiązań AI wymagających dynamicznego korzystania z narzędzi, iteracyjnego rozumowania i integracji z wieloma zasobami.

Wyszukiwarka Dokumentów FlowHunt zwiększa dokładność AI, łącząc modele generatywne z Twoimi aktualnymi dokumentami i adresami URL, zapewniając wiarygodne i trafne odpowiedzi dzięki Retrieval-Augmented Generation (RAG).

Komponent Historia Czatów w FlowHunt umożliwia chatbotom zapamiętywanie poprzednich wiadomości, zapewniając spójne rozmowy i lepsze doświadczenia klientów przy jednoczesnej optymalizacji wykorzystania pamięci i tokenów.

Odkryj komponent Wynik czatu w FlowHunt—finalizuj odpowiedzi chatbota za pomocą elastycznych, wieloczęściowych wyjść. Niezbędny do płynnego kończenia przepływów i tworzenia zaawansowanych, interaktywnych chatbotów AI.

Opis przepływu

Ten workflow został zaprojektowany do automatyzacji i skalowania zaawansowanych zadań związanych z obsługą klienta oraz pozyskiwaniem wiedzy, wykorzystując LLM (Large Language Models), dynamiczne generowanie danych, zewnętrzne zapytania API (np. LiveAgent) oraz automatyczne pobieranie dokumentów. Jest szczególnie przydatny dla organizacji chcących usprawnić procesy wsparcia, odpowiadać na zapytania klientów w sposób kontekstowy oraz integrować wyszukiwanie w bazie wiedzy z interakcjami w systemach zewnętrznych.

Workflow koordynuje następujące główne kroki:

| Krok | Komponent | Cel |

|---|---|---|

| 1 | Wejście z chatu | Przyjmuje zapytania lub wiadomości użytkownika |

| 2 | Szablon prompta | Tworzy dynamiczne adresy URL do zapytań API, podstawiając dane użytkownika i kontekst do szablonów |

| 3 | Zapytanie API | Wysyła zapytania HTTP (GET/POST) do zewnętrznych API (np. LiveAgent), z parametrami i ciałem jeśli trzeba |

| 4 | Analiza danych | Konwertuje odpowiedzi API (JSON/dane) na zwykły tekst lub ustrukturyzowane prompty dla LLM |

| 5 | Generator LLM | Wykorzystuje LLM (np. OpenAI GPT-4.1) do wydobycia konkretnych sekcji (np. “Preview”) z danych wejściowych |

| 6 | Agent wywołujący narzędzia | Agent LLM, który otrzymuje cały kontekst, historię i narzędzia oraz jest sterowany dedykowanym promptem |

| 7 | Wyszukiwarka dokumentów | Przeszukuje źródła wiedzy w poszukiwaniu dokumentów powiązanych z zapytaniem użytkownika |

| 8 | Wyjście chatu | Przekazuje końcowe odpowiedzi lub wiadomości użytkownikowi |

YOURLINK w szablonach promptów na właściwy adres instancji LiveAgent.| Typ węzła | Główna rola |

|---|---|

| Notatka | Przypomnienia i instrukcje dotyczące konfiguracji |

| Wejście/Wyjście chatu | Punkty interakcji z użytkownikiem |

| Historia chatu | Zapewnia kontekst z poprzednich interakcji |

| Create Data | Dynamiczne budowanie danych zapytań API |

| Szablon prompta | Generuje adresy URL lub prompty |

| Zapytanie API | Komunikuje się z usługami zewnętrznymi |

| Analiza danych | Transformuje surowe dane dla LLM |

| Generator LLM | Wydobywa/przetwarza informacje za pomocą LLM |

| Wyszukiwarka dokumentów | Przeszukuje wewnętrzne źródła wiedzy |

| Agent wywołujący narzędzia | Orkiestruje narzędzia i generuje odpowiedzi |

Ten workflow jest idealny do automatyzacji obsługi klienta, integracji z zewnętrznymi systemami ticketowymi lub chatowymi oraz zapewnia, że odpowiedzi generowane przez LLM są zawsze oparte o autorytatywną wiedzę firmową. Może być fundamentem skalowalnego, inteligentnego asystenta wsparcia gotowego do wdrożeń w przedsiębiorstwach.

Pomagamy firmom takim jak Twoja rozwijać inteligentne chatboty, serwery MCP, narzędzia AI lub inne rodzaje automatyzacji AI, aby zastąpić człowieka w powtarzalnych zadaniach w Twojej organizacji.

Ten zautomatyzowany przez AI workflow automatyzuje obsługę klienta poprzez łączenie zapytań użytkowników ze źródłami wiedzy firmy, zewnętrznymi API (takimi jak ...

Ten oparty na AI workflow automatyzuje obsługę klienta poprzez łączenie wyszukiwania w wewnętrznej bazie wiedzy, pobierania informacji z Google Docs, integracji...

Automatyzuj obsługę klienta w LiveAgent za pomocą czatbota AI, który odpowiada na pytania wykorzystując Twoją wewnętrzną bazę wiedzy, pobiera odpowiednie dokume...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.