Wprowadzenie

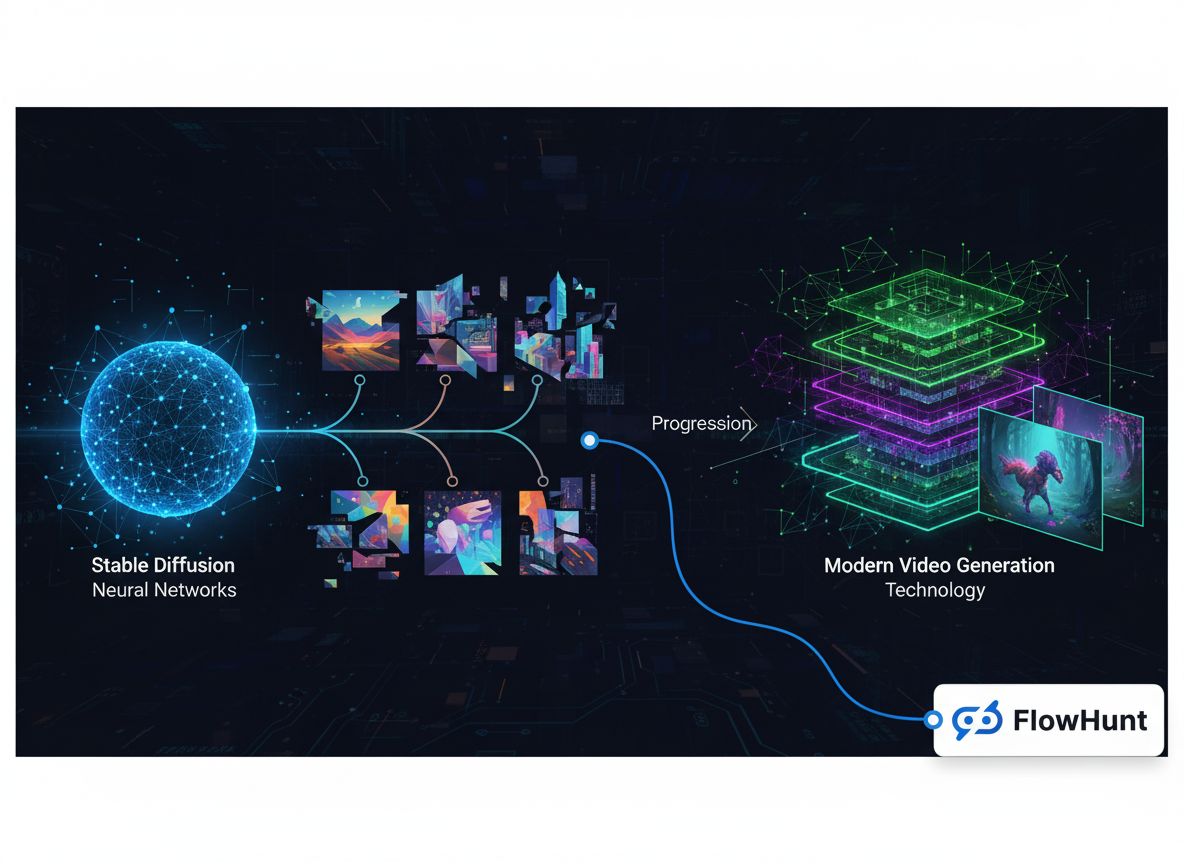

Krajobraz mediów generatywnych przeszedł w ostatnich latach niezwykłą transformację – od eksperymentalnych projektów badawczych do wielomiliardowego rynku infrastruktury. To, co zaczęło się od wyspecjalizowanych modeli do generowania obrazów, rozwinęło się w kompleksowy ekosystem obejmujący syntezę obrazów, tworzenie wideo, generowanie dźwięku i zaawansowane możliwości edycji. Ta historia techniczna pokazuje, jak firmy takie jak FAL zbudowały biznes o przychodach powyżej 100 mln dolarów, dostrzegając kluczową lukę na rynku: deweloperzy potrzebowali zoptymalizowanej, skalowalnej infrastruktury inferencyjnej zaprojektowanej specjalnie pod modele mediów generatywnych, a nie ogólnej orkiestracji GPU czy hostingu modeli językowych. Droga od Stable Diffusion 1.5 do nowoczesnych modeli wideo, takich jak Veo3, ujawnia ważne lekcje dotyczące pozycji rynkowej, specjalizacji technicznej i wymagań infrastrukturalnych, które pozwalają aplikacjom AI przejść od prototypów badawczych do systemów produkcyjnych obsługujących miliony deweloperów.

Media generatywne stanowią zupełnie odrębną kategorię sztucznej inteligencji w porównaniu do dużych modeli językowych, które ostatnio dominują w nagłówkach. Podczas gdy modele językowe przetwarzają tekst i generują odpowiedzi na podstawie wyuczonych wzorców, systemy mediów generatywnych tworzą treści wizualne i dźwiękowe – obrazy, wideo, muzykę i efekty dźwiękowe – na podstawie opisów tekstowych, istniejących obrazów lub innych modalności wejściowych. To rozróżnienie to coś więcej niż semantyka; odzwierciedla fundamentalne różnice w wymaganiach technicznych, dynamice rynku i możliwościach biznesowych. Modele mediów generatywnych działają w innych ograniczeniach obliczeniowych, wymagają wyspecjalizowanych technik optymalizacyjnych i obsługują przypadki użycia, których tradycyjna infrastruktura modeli językowych nie jest w stanie efektywnie realizować. Wzrost znaczenia mediów generatywnych stworzył zupełnie nową kategorię firm infrastrukturalnych, skoncentrowanych na optymalizacji inferencji dla tych modeli, umożliwiając deweloperom integrację zaawansowanych możliwości generowania obrazów i wideo w swoich aplikacjach bez zarządzania złożonymi wdrożeniami GPU czy nieefektywnym wykorzystaniem zasobów.

Wymagania techniczne dla inferencji mediów generatywnych znacząco różnią się od obsługi modeli językowych. Modele generowania obrazów, takie jak Stable Diffusion czy Flux, działają poprzez iteracyjne procesy dyfuzji wymagające precyzyjnego zarządzania pamięcią, optymalizacji czasu oraz wydajnego przetwarzania wsadowego. Generowanie wideo to kolejna warstwa złożoności: wymaga spójności czasowej, synchronizacji dźwięku i znacznie większych zasobów obliczeniowych. Tych wymagań nie da się efektywnie zrealizować na ogólnych platformach do orkiestracji GPU czy usługach inferencji modeli językowych. Potrzebna jest wyspecjalizowana infrastruktura zbudowana od podstaw pod charakterystykę modeli dyfuzyjnych, autoregresywnego generowania obrazów i syntezy wideo. Firmy, które wcześnie dostrzegły tę lukę i zainwestowały w dedykowaną infrastrukturę, zdobyły znaczną część rynku, gdy adaptacja mediów generatywnych przyspieszyła w różnych branżach.

Gotowy na rozwój swojej firmy?

Rozpocznij bezpłatny okres próbny już dziś i zobacz rezultaty w ciągu kilku dni.

Decyzja o specjalizacji w mediach generatywnych zamiast oczywistego wydawałoby się hostingu modeli językowych to jeden z najważniejszych wyborów strategicznych w najnowszej historii infrastruktury AI. Gdy założyciele FAL rozważali swoje opcje w latach 2022-2023, stanęli przed kluczowym dylematem: czy rozwinąć swoje środowisko Pythona w platformę inferencyjną dla modeli językowych ogólnego przeznaczenia, czy skupić się na rozwijającym się segmencie mediów generatywnych? Odpowiedź pokazuje istotne aspekty dynamiki rynku, pozycji konkurencyjnej i znaczenia wyboru walki, którą można wygrać. Hosting modeli językowych, choć pozornie atrakcyjny ze względu na dużą uwagę i finansowanie, oznaczałby niemożliwą walkę konkurencyjną. OpenAI już zdominowało rynek GPT, Anthropic rozwijało Claude z dużym wsparciem technicznym, a Google, Microsoft i inne giganty inwestowały miliardy w swoje rozwiązania. Konkurując w tej przestrzeni, startup musiałby stawić czoła firmom o nieporównywalnie większych zasobach i pozycji rynkowej.

Rynek mediów generatywnych wyglądał zupełnie inaczej. Po premierze Stable Diffusion 1.5 w 2022 roku powstało natychmiastowe zapotrzebowanie na zoptymalizowaną infrastrukturę inferencyjną, ale żaden lider rynku nie zdążył się pojawić. Model był open-source, więc każdy mógł go pobrać i uruchomić, ale większości deweloperów brakowało wiedzy lub zasobów, by go skutecznie zoptymalizować. To stworzyło idealną okazję dla wyspecjalizowanej firmy infrastrukturalnej. FAL dostrzegło, że deweloperzy chcą korzystać z tych modeli, ale nie chcą zarządzać złożonością wdrożeń GPU, optymalizacji i skalowania. Skupiając się wyłącznie na mediach generatywnych, FAL mogło stać się ekspertem w tej dziedzinie, budować relacje z twórcami modeli i deweloperami, oraz ugruntować pozycję jako platforma pierwszego wyboru do inferencji mediów generatywnych. Ta strategia okazała się niezwykle skuteczna – FAL urosło z punktu zwrotnego do firmy obsługującej 2 miliony deweloperów, z 350 modelami i przychodami przekraczającymi 100 mln dolarów rocznie.

Infrastruktura mediów generatywnych i optymalizacja

Techniczna podstawa nowoczesnych platform mediów generatywnych opiera się na zaawansowanej optymalizacji inferencji, wykraczającej daleko poza samo uruchamianie modeli na GPU. Gdy deweloperzy zaczęli korzystać ze Stable Diffusion 1.5, wielu próbowało wdrażać go samodzielnie na chmurze lub lokalnych GPU. Szybko ujawniły się istotne nieefektywności: modele nie były zoptymalizowane pod konkretny sprzęt, pamięć była marnowana przez nieefektywne batchowanie, a wykorzystanie GPU było niskie, bo każdy użytkownik korzystał z własnych zasobów. Deweloper wykorzystywał 20-30% GPU, płacąc za 100%. To marnotrawstwo stworzyło okazję dla platformy, która mogłaby agregować zapotrzebowanie, optymalizować inferencję pod konkretne konfiguracje sprzętu i uzyskać wyższe wykorzystanie GPU przez inteligentne batchowanie i harmonogramowanie. Podejście FAL polegało na budowie własnych jąder CUDA – niskopoziomowego kodu na GPU zoptymalizowanego dla konkretnych operacji w modelach generatywnych – co znacznie poprawiało wydajność względem ogólnych implementacji.

Wyzwania infrastrukturalne sięgają dalej niż sama optymalizacja wydajności. Modele mediów generatywnych mają unikalne cechy wymagające specjalnego traktowania. Modele dyfuzyjne, które zasilają większość systemów generowania obrazów, działają iteracyjnie – model stopniowo przekształca losowy szum w spójny obraz przez wiele kroków. Każdy krok wymaga precyzyjnego zarządzania pamięcią GPU i musi być na tyle szybki, by zapewnić akceptowalną latencję. Generowanie wideo dodaje wymiar czasowy: modele muszą zachować spójność między klatkami i generować wysoką jakość przy 24 lub 30 FPS. Modele audio mają swoje wymagania: czasami przetwarzanie w czasie rzeczywistym, czasami najwyższa jakość dźwięku. Platforma obsługująca te wszystkie modalności musi zdobyć głęboką wiedzę w każdej z nich, poznając specyficzne możliwości optymalizacyjne i ograniczenia każdego typu modelu. To właśnie ta specjalizacja czyni firmy infrastrukturalne mediów generatywnych tak wartościowymi – gromadzą wiedzę i techniki optymalizacji, których pojedynczy deweloper nie jest w stanie szybko odtworzyć.

Dołącz do naszego newslettera

Otrzymuj najnowsze wskazówki, trendy i oferty za darmo.

Ewolucja modeli generowania obrazów: od Stable Diffusion do Flux

Historia mediów generatywnych to w dużej mierze historia ewolucji modeli generowania obrazów, z których każdy wyznaczał znaczący punkt zwrotny na rynku. Stable Diffusion 1.5, wydany w 2022 roku, był katalizatorem przekształcającym media generatywne z ciekawostki akademickiej w praktyczne narzędzie dla deweloperów. Model był open-source, stosunkowo wydajny i dawał rozsądną jakość obrazów do wielu zastosowań. Dla FAL Stable Diffusion 1.5 był momentem, gdy dostrzegli szansę na pivot całej firmy. Zaczęli oferować zoptymalizowaną, gotową do użycia wersję modelu na API, bez konieczności zarządzania własną infrastrukturą GPU. Odpowiedź była przytłaczająca – deweloperzy natychmiast docenili wartość rezygnacji z wdrożeniowej złożoności, a SD 1.5 stał się pierwszym głównym źródłem przychodów FAL. Co więcej, wokół Stable Diffusion 1.5 powstał cały ekosystem fine-tuningu. Deweloperzy tworzyli LoRA (Low-Rank Adaptations) – lekkie modyfikacje modelu pod konkretne style artystyczne, twarze czy obiekty. Im więcej opcji fine-tuningu, tym platforma była cenniejsza, przyciągając kolejnych deweloperów i tworząc dalsze możliwości dostosowań.

Stable Diffusion 2.1, wydany jako następca, pokazał jak ważna w mediach generatywnych jest jakość, a nie tylko zaawansowanie techniczne. Choć technicznie model był nowocześniejszy, powszechnie uznano go za krok wstecz pod względem jakości obrazów – zwłaszcza twarzy i scen złożonych. Model nie zdobył popularności, a wielu deweloperów pozostało przy wersji 1.5. Ta lekcja była istotna: w mediach generatywnych liczy się efekt końcowy, nie architektura czy metodyka uczenia. Stable Diffusion XL (SDXL), wydany w 2023 roku, był prawdziwym przełomem – pozwalał generować obrazy w wyższej rozdzielczości, z większą szczegółowością i dokładniejszym tekstem. Dla FAL SDXL to był punkt przełomowy – pierwszy model, który wygenerował dla platformy 1 mln dolarów przychodu. Również tu ekosystem LoRA eksplodował: deweloperzy tworzyli tysiące adaptacji dla specyficznych zastosowań. Sukces SDXL pokazał, że istnieje realny popyt komercyjny na wysokiej jakości generowanie obrazów, potwierdzając słuszność specjalizacji FAL.

Wydanie modeli Flux przez Black Forest Labs w 2024 roku było kolejnym kluczowym punktem zwrotnym. Flux to pierwsza generacja modeli rzeczywiście „komercyjnie użytecznych” i „gotowych dla przedsiębiorstw” – jakość była dużo wyższa niż poprzednich modeli, czas generowania akceptowalny dla aplikacji produkcyjnych, a wyniki na tyle przewidywalne, że firmy mogły budować na nich swoje produkty. Dla FAL Flux był przełomem: przychody platformy wzrosły z 2 do 10 mln dolarów w pierwszym miesiącu po premierze, następnie do 20 mln w kolejnym. Ten gwałtowny wzrost odzwierciedlał skumulowany popyt na wysokiej jakości generowanie obrazów do zastosowań komercyjnych. Flux występował w kilku wersjach – Schnell (szybka, destylowana), Dev (wyższa jakość, licencja niekomercyjna) i Pro (wymaga współpracy przy hostingu) – każda dla innych zastosowań i segmentów cenowych. Sukces Flux pokazał, że rynek dojrzał do momentu, w którym firmy są gotowe inwestować poważne środki w możliwości generowania obrazów, a nie tylko eksperymentować z technologią.

Przejście do wideo: nowy segment rynku

Choć generowanie obrazów przyciągnęło dużo uwagi i przychodów, pojawienie się praktycznych modeli generowania wideo otworzyło zupełnie nowe możliwości rynkowe. Wczesne modele tekst-na-wideo, jak Sora od OpenAI, pokazywały potencjał, ale nie były szeroko dostępne lub dawały rezultaty ciekawe z punktu widzenia badań, lecz mało przydatne praktycznie. Filmy często były pozbawione dźwięku, miały niespójności czasowe i brakowało im profesjonalnego wykończenia. Sytuację zmieniła premiera modeli takich jak Veo3 od Google DeepMind, które stanowiły prawdziwy przełom jakościowy. Veo3 generował wideo z synchronizowanym dźwiękiem, właściwym tempem i rytmem, poprawną synchronizacją ust oraz jakością wizualną zbliżoną do profesjonalnych produkcji. Model był kosztowny w użyciu – znacznie bardziej obciążający obliczeniowo niż generowanie obrazów – ale jakość uzasadniała koszt w wielu zastosowaniach.

Wpływ wysokiej jakości generowania wideo na biznes FAL był ogromny. Wideo stworzyło zupełnie nowy strumień przychodów i przyciągnęło inny segment klientów. Podczas gdy generowanie obrazów wykorzystywali głównie indywidualni deweloperzy, graficy i małe zespoły kreatywne, generowanie wideo zainteresowało większe firmy, tworzące treści reklamowe, marketingowe i profesjonalne. FAL współpracowało z wieloma dostawcami modeli wideo, jak One od Alibaba, Kling od Kuaishou i innymi, oferując bogaty zestaw opcji generowania wideo. Wraz z rosnącym udziałem wideo w całości wykorzystania, przychody platformy jeszcze bardziej przyspieszyły. Wyzwania techniczne generowania wideo napędzały innowacje infrastrukturalne FAL – modele wideo wymagały innych strategii optymalizacyjnych niż obrazowe, konieczna była budowa nowych jąder i zmian architektonicznych. Sukces wideo potwierdził też słuszność strategii budowy platformy obsługującej różne modalności. FAL nie ograniczyło się tylko do obrazów – stworzyło elastyczną infrastrukturę pod obrazy, wideo i dźwięk, stając się kompleksową platformą mediów generatywnych.

Wraz z rosnącą rolą mediów generatywnych w kreacji treści i rozwoju aplikacji pojawiły się platformy takie jak FlowHunt, które pomagają deweloperom i zespołom zarządzać złożonością integracji tych możliwości w przepływach pracy. FlowHunt dostrzega, że choć platformy takie jak FAL rozwiązały problem infrastrukturalny efektywnego uruchamiania modeli, deweloperzy nadal napotykają wyzwania przy orkiestracji tych modeli w większych aplikacjach. Typowa aplikacja generatywna to wiele kroków: przyjęcie żądania, przetwarzanie i walidacja wejścia, wywołanie jednego lub kilku modeli generatywnych, post-processing wyników, przechowywanie, zarządzanie analizą. FlowHunt oferuje narzędzia do automatyzacji i usprawnienia tych przepływów, pozwalając deweloperom skupić się na logice aplikacji zamiast zarządzaniu infrastrukturą. Dzięki integracji z FAL, FlowHunt pozwala budować zaawansowane aplikacje generatywne bez konieczności zarządzania złożonością inferencji, optymalizacji i skalowania.

Podejście FlowHunt do przepływów pracy z mediami generatywnymi opiera się na automatyzacji, niezawodności i obserwowalności. Platforma umożliwia definiowanie workflow łączących wiele operacji generatywnych, obsługę błędów i pełną widoczność na każdym etapie. Przykładowy workflow tworzenia treści może obejmować generowanie kilku wariantów obrazu, wybór najlepszego na podstawie metryk jakości, zastosowanie efektów post-processingu i publikację. FlowHunt umożliwia deklaratywne definiowanie całego przepływu, z automatycznym retry, obsługą błędów i monitoringiem. Ta warstwa abstrakcji jest szczególnie cenna dla zespołów budujących aplikacje produkcyjne, które muszą niezawodnie generować treści na dużą skalę. Przejmując odpowiedzialność za orkiestrację i zarządzanie workflow, FlowHunt pozwala zespołom skupić się na kreatywności i logice biznesowej, podczas gdy platforma obsługuje złożoność techniczną.

Techniczne szczegóły: własne jądra i optymalizacja wydajności

Imponujący wzrost biznesu FAL i jakość jego usług opierają się na zaawansowanej optymalizacji technicznej, której większość użytkowników nigdy nie widzi. Platforma opracowała ponad 100 własnych jąder CUDA – wyspecjalizowanego kodu na GPU w języku CUDA od NVIDII – optymalizującego konkretne operacje w modelach generatywnych. Te jądra to tysiące godzin inżynieryjnych poświęconych maksymalizacji wydajności sprzętu GPU. Motywacja jest prosta: każda milisekunda mniej latencji to lepsze doświadczenie użytkownika i niższe koszty infrastruktury. Model, który generuje obraz 20% szybciej, pozwala GPU obsłużyć o 20% więcej użytkowników, bezpośrednio poprawiając ekonomię platformy. Pisanie własnych jąder to jednak duże wyzwanie. Programowanie CUDA wymaga głębokiej wiedzy o architekturze GPU, hierarchii pamięci i zasadach obliczeń równoległych. To nie jest coś, czego można się szybko nauczyć lub zastosować ogólnie – każde jądro musi być precyzyjnie dostrojone pod konkretne operacje i konfiguracje sprzętowe.

Proces optymalizacji zaczyna się od profilowania – analizy, na co faktycznie zużywany jest czas podczas wykonywania modelu. Wielu deweloperów zakłada, że najintensywniejsze obliczeniowo operacje są wąskim gardłem, tymczasem profilowanie często ujawnia zaskakujące wyniki. Czasem wąskim gardłem jest transfer danych między pamięcią GPU a jednostkami obliczeniowymi, a nie sama kalkulacja. Czasem problemem jest narzut z uruchamiania wielu drobnych operacji zamiast ich batchowania. Inżynierowie FAL intensywnie profilują modele, identyfikują rzeczywiste wąskie gardła i piszą jądra rozwiązujące te problemy. Mogą np. napisać jądro wykonujące kilka operacji naraz, redukując transfery danych i narzut uruchomieniowy, albo zoptymalizować pod konkretne wymiary i typy danych danego modelu. Taki poziom optymalizacji ma sens ekonomiczny tylko przy obsłudze milionów użytkowników – inwestycja w rozwój własnych jąder zwraca się dzięki wyższej efektywności i niższym kosztom.

Poza optymalizacją samych jąder FAL inwestuje także w architekturę serwowania modeli. Platforma używa technik takich jak kwantyzacja modeli (obniżenie precyzji wag dla oszczędności pamięci i mocy obliczeniowej), batchowanie dynamiczne (grupowanie żądań dla lepszego wykorzystania GPU) czy priorytetyzacja żądań (zapewnienie, że te wrażliwe na opóźnienia są obsługiwane szybciej niż te nastawione na przepustowość). Wszystkie te techniki wymagają precyzyjnego wdrożenia, by nie pogorszyć jakości wyników. Kwantyzacja zmniejsza rozmiar i przyspiesza model, ale wykonana źle może pogorszyć jakość. Inżynierowie FAL opracowali zaawansowane strategie, pozwalające osiągnąć zyski wydajności bez utraty jakości. Batchowanie dynamiczne wymaga przewidywania czasu wykonania żądań i grupowania ich tak, by zmaksymalizować użycie GPU bez dodawania zbędnej latencji. Te architektoniczne usprawnienia, w połączeniu z własnymi jądrami, pozwalają FAL osiągać wydajność i wykorzystanie GPU niemożliwe do uzyskania na ogólnej infrastrukturze.

Dynamika rynku i krajobraz konkurencyjny

Rynek mediów generatywnych ewoluuje bardzo szybko, z nieustannie pojawiającymi się nowymi modelami i możliwościami. Zrozumienie dynamiki konkurencyjnej jest kluczowe, by docenić, dlaczego wyspecjalizowane platformy jak FAL są tak wartościowe. Rynek można podzielić na kilka segmentów: generowanie obrazów, generowanie wideo, generowanie dźwięku i narzędzia do edycji/manipulacji. W każdym segmencie konkurują różne modele pod względem jakości, szybkości, kosztu i możliwości. W generowaniu obrazów mamy warianty Stable Diffusion, modele Flux, modele Gemini od Google i różne modele wyspecjalizowane pod konkretne przypadki, jak generowanie logo czy twarzy. W wideo konkurują Veo3, One od Alibaba, Kling od Kuaishou i inni. Różnorodność modeli to zarówno szansa, jak i wyzwanie dla platform infrastrukturalnych. Szansa, bo żaden model nie dominuje wszystkich przypadków użycia – platforma obsługująca wiele modeli jest cenniejsza. Wyzwanie, bo wsparcie dla wielu modeli wymaga ogromu pracy optymalizacyjnej.

Strategia FAL polega na kuracji modeli – wybierają takie, które razem pokrywają najważniejsze zastosowania i utrzymują wysoką jakość. Nie dodają każdego nowego modelu, tylko te, które wnoszą unikalne możliwości lub istotnie przewyższają istniejące pod względem jakości. Takie podejście daje kilka korzyści. Po pierwsze, zapewnia wysoką jakość oferty i użyteczność platformy, zamiast przytłoczenia użytkowników przeciętnymi opcjami. Po drugie, pozwala skoncentrować wysiłki optymalizacyjne na modelach, które rzeczywiście będą używane. Po trzecie, tworzy efekt pozytywnej pętli: dobra reputacja przyciąga zarówno użytkowników, jak i twórców modeli. Ci chcą mieć swoje modele na FAL, bo wiedzą, że użytkownicy doceniają jakość; użytkownicy wybierają FAL, bo modele są dobrze wyselekcjonowane i zoptymalizowane. Ta pozytywna spirala była kluczowa dla sukcesu platformy.

Konkurencja to także inne platformy infrastrukturalne oraz twórcy modeli oferujący własny hosting. Niektórzy, jak Stability AI, oferują swoje API; inni, jak Black Forest Labs z Flux, wolą partnerować z platformami typu FAL niż budować własną infrastrukturę. Decyzja partnerować czy budować jest strategiczna – własna infrastruktura wymaga dużych zasobów i wiedzy operacyjnej, partnerstwo pozwala skupić się na rozwoju modeli. Dla większości twórców modeli partnerstwo z wyspecjalizowanymi platformami jest bardziej opłacalne niż budowa własnego hostingu. Taka dynamika tworzy zdrowy ekosystem: twórcy modeli skupiają się na badaniach i rozwoju, a platformy infrastrukturalne na optymalizacji i skalowaniu.

Model przychodowy i metryki biznesowe

Zrozumienie modelu biznesowego FAL i jego metryk pozwala zobaczyć, jak firmy infrastrukturalne mediów generatywnych tworzą wartość i skalę. FAL działa w oparciu o model rozliczeń za zużycie – klienci płacą za liczbę wywołań API i wykorzystane zasoby obliczeniowe. Ten model dobrze scala interesy: im więcej używasz, tym więcej płacisz, a przychody FAL rosną wraz z wartością i popularnością platformy. Liczby są imponujące: 2 miliony deweloperów, 350+ modeli, ponad 100 mln dolarów przychodu rocznie. To skala, która pokazuje, że rynek jest wciąż na wczesnym etapie – penetracja potencjalnych użytkowników jest niska, a wiele przypadków użycia wciąż czeka na odkrycie. Wzrost przychodów przyspieszył zwłaszcza po wprowadzeniu generowania wideo. Po premierze Flux, przychody platformy skoczyły z 2 do 10 mln dolarów w pierwszym miesiącu – pokazując wpływ wysokiej jakości modeli na wyniki finansowe.

Metryki biznesowe ujawniają też dynamikę rynku. Skoro FAL osiągnął ponad 100 mln dolarów rocznie przy 2 mln deweloperów, oznacza to, że średni przychód na użytkownika jest relatywnie niski – ok. 50-100 dolarów rocznie. Wynika to z faktu, że wielu użytkowników eksperymentuje lub wykorzystuje media generatywne na małą skalę. Rozkład jest jednak mocno skośny – niewielka liczba „power userów” generuje dużą część przychodów. To najczęściej firmy budujące media generatywne w swoich produktach. Wraz z dojrzewaniem rynku i integracją mediów generatywnych w działalność biznesową, średni przychód na użytkownika prawdopodobnie znacząco wzrośnie. Trajektoria wzrostu FAL wskazuje, że infrastruktura mediów generatywnych jest wciąż na wczesnym etapie długoterminowego trendu wzrostowego, z dużymi możliwościami na przyszłość.

Zaawansowane możliwości: fine-tuning i personalizacja

Jednym z najważniejszych trendów w mediach generatywnych jest pojawienie się możliwości fine-tuningu i personalizacji modeli pod konkretne zastosowania. Fine-tuning to dodatkowe trenowanie wstępnie wyuczonego modelu na danych domenowych, by poprawić skuteczność w wybranych zadaniach. W generowaniu obrazów najpopularniejszą formą są LoRA – lekkie modyfikacje bazowego modelu bez konieczności pełnego powtórnego trenowania. Grafik może stworzyć LoRA do stylu artystycznego, fotograf do własnej estetyki, firma do generowania obrazów produktów w konkretnym kontekście. Ekosystem LoRA stał się kluczowym elementem rynku – dla popularnych modeli jak Stable Diffusion czy SDXL powstały tysiące adaptacji.

Pojawienie się fine-tuningu ma duże znaczenie dla platform infrastrukturalnych takich jak FAL. Obsługa fine-tuningu wymaga czegoś więcej niż tylko serwowania bazowych modeli. Platforma musi oferować narzędzia do tworzenia i zarządzania LoRA, ich wydajnego przechowywania i serwowania razem z modelem bazowym. Musi także rozwiązać techniczne wyzwania łączenia bazowego modelu z LoRA przy inferencji, zapewniając wysoką jakość i niską latencję. FAL sporo zainwestowało w te możliwości, wiedząc, że fine-tuning to klucz dla wielu użytkowników. Wsparcie dla personalizacji było ważnym czynnikiem sukcesu platformy – użytkownicy mogą dostosować modele pod swoje potrzeby, korzystając jednocześnie z optymalizacji i skalowania FAL. Wraz z dojrzewaniem rynku, fine-tuning i personalizacja będą jeszcze ważniejsze – firmy będą inwestować w własne modele dopasowane do swoich zastosowań.

Przyszłość infrastruktury mediów generatywnych

Patrząc w przyszłość, rynek infrastruktury mediów generatywnych będzie dalej dynamicznie się rozwijał. Kilka trendów będzie go kształtować. Po pierwsze, modele będą się poprawiać jakościowo i funkcjonalnie, otwierając nowe zastosowania