Wprowadzenie

Budowa skutecznych agentów AI wymaga czegoś więcej niż tylko połączenia modeli językowych z narzędziami. Prawdziwym wyzwaniem jest to, jak agenci rozwiązują złożone problemy, zarządzają dużą ilością informacji i realizują wieloetapowe przepływy pracy w sposób efektywny. W tym kompleksowym przewodniku omawiamy zaawansowane techniki implementacji agentów AI, skupiając się szczególnie na planowaniu — kluczowej umiejętności odróżniającej wysoko wydajnych agentów od podstawowych wdrożeń. Planowanie pozwala agentom AI rozbić złożone zadania na mniejsze kroki, pokonać ograniczenia okna kontekstu oraz realizować przepływy szybciej i taniej. Niezależnie od tego, czy tworzysz agentów badawczych, systemy automatyzacji czy inteligentnych asystentów, zrozumienie, jak wdrażać planowanie w agentach AI, znacząco poprawi ich skuteczność i niezawodność.

Kim są agenci AI i dlaczego są ważni?

Agenci sztucznej inteligencji stanowią fundamentalną zmianę w podejściu do rozwiązywania problemów za pomocą modeli językowych. W przeciwieństwie do tradycyjnych aplikacji przetwarzających dane wejściowe i generujących odpowiedź w jednym kroku, agenci AI działają jako autonomiczne systemy, które mogą postrzegać otoczenie, podejmować decyzje i wykonywać działania iteracyjnie. Typowy agent AI składa się z modelu językowego („mózg”), zestawu narzędzi lub funkcji, które może wywoływać, oraz pętli sterującej decydującej, kiedy i jak użyć danego narzędzia. Taka architektura pozwala agentom radzić sobie ze złożonymi, wieloetapowymi zadaniami, których pojedyncze wywołanie LLM nie jest w stanie wykonać. Przykładowo, agent może potrzebować przeszukać Internet, przetworzyć znalezione informacje, wykonać obliczenia, a następnie wszystko zsyntetyzować w spójną odpowiedź. Siła agentów tkwi w ich zdolności do rozumowania nad koniecznymi krokami i wykonywania ich sekwencyjnie, ucząc się z rezultatów każdego etapu.

Znaczenie agentów AI rośnie wykładniczo, gdy organizacje dostrzegają ich potencjał w automatyzacji, badaniach, obsłudze klienta i pracy z wiedzą. Firmy coraz częściej wdrażają agentów do takich zadań jak analiza danych, generowanie treści, wsparcie klienta czy rozwiązywanie złożonych problemów. Jednak wraz z rozwojem agentów i podejmowaniem przez nich coraz trudniejszych wyzwań, pojawiają się poważne bariery. Jedną z najważniejszych jest zarządzanie ograniczeniami modeli językowych, zwłaszcza ich oknem kontekstu — czyli maksymalną ilością tekstu, którą mogą przetworzyć naraz. Gdy agent musi pracować z dużymi dokumentami, obszernymi wynikami wyszukiwania lub złożonymi wieloetapowymi przepływami, szybko pojawia się spadek dokładności i wydajności. Tu właśnie kluczowe staje się planowanie.

Gotowy na rozwój swojej firmy?

Rozpocznij bezpłatny okres próbny już dziś i zobacz rezultaty w ciągu kilku dni.

Zrozumienie problemu okna kontekstu: dlaczego planowanie jest ważne

Ograniczenie okna kontekstu to jedno z największych wyzwań współczesnego projektowania agentów AI. Choć ostatnie postępy zwiększyły okna kontekstu do 100 000 tokenów lub więcej, badania wykazały nieintuicyjny problem: większe okna nie przekładają się automatycznie na lepszą skuteczność. Zjawisko to, nazwane przez badaczy Chroma „context rot”, pokazuje, że modele językowe mają trudności z dokładnym wyszukiwaniem i przetwarzaniem informacji w ogromnych kontekstach tokenów. W praktyce, gdy LLM musi odnaleźć konkretną informację ukrytą w 10 000 tokenach tekstu, jego dokładność spada znacząco w porównaniu do sytuacji, gdy ta sama informacja jest podana w mniejszym kontekście. Problem nasila się jeszcze bardziej, gdy w kontekście pojawiają się „dystraktory” — informacje związane z zapytaniem, ale nie udzielające odpowiedzi.

Zespół badawczy Chroma przeprowadził szeroko zakrojone testy z ulepszoną wersją testu „igły w stogu siana”, który tradycyjnie mierzył, jak modele radzą sobie z wyszukiwaniem konkretnej informacji w dużych dokumentach. Jednak tradycyjny test miał wadę: nie uwzględniał scenariuszy z prawdziwego świata, gdzie dokumenty zawierają powiązane, ale mylące informacje. Po wprowadzeniu dystraktorów — akapitów omawiających temat igły, ale nie dających konkretnej odpowiedzi — badacze odkryli, że skuteczność modeli gwałtownie spada. Przykładowo, Claude 4.5 utrzymuje lepszą dokładność niż inne modele w różnych scenariuszach z dystraktorami, ale nawet najlepsze modele wykazują znaczny spadek skuteczności wraz ze wzrostem długości kontekstu. Badania te zasadniczo zmieniły podejście programistów do budowy agentów AI: zamiast polegać na przeszukiwaniu ogromnych kontekstów, należy pomóc agentom zaplanować działanie i rozbić problem na mniejsze, bardziej przystępne części.

Jak planowanie rozwiązuje problem kontekstu

Planowanie to zmiana paradygmatu w architekturze agentów AI. Zamiast reagować na każdy krok i przeszukiwać ogromne konteksty, planowanie zmusza agenta do przemyślenia całego problemu z góry i stworzenia uporządkowanego podejścia. To analogiczne do sposobu, w jaki ludzie rozwiązują złożone zadania: nie działamy przypadkowo, lecz najpierw rozumiemy problem, dzielimy go na kroki i tworzymy plan. Gdy agent AI tworzy plan przed wykonaniem zadania, może skupić się na konkretnych podzadaniach, używając tylko odpowiedniego kontekstu potrzebnego w danym momencie. Znacząco zmniejsza to obciążenie modelu językowego i zwiększa dokładność. Przykładowo, zamiast prosić LLM o przeszukanie 50 000-tokenowego dokumentu w celu znalezienia kilku informacji, agent planujący najpierw tworzy plan: „Krok 1: Znajdź informacje o X, Krok 2: Znajdź informacje o Y, Krok 3: Zsyntetyzuj obie informacje”. Następnie do każdego kroku agent używa tylko odpowiedniego fragmentu kontekstu, utrzymując wysoką precyzję przez cały proces.

Podejście planistyczne pozwala również agentom realizować złożone przepływy pracy efektywniej. Mając jasny plan, agent może zidentyfikować, które kroki można wykonać równolegle, które są zależne od innych oraz jak zoptymalizować całość wykonania. Jest to szczególnie ważne w scenariuszach, gdzie trzeba wywołać wiele narzędzi lub dokonać wielu wywołań API. Zamiast wykonywać kolejne wywołania i czekać na ich zakończenie przed podjęciem kolejnego kroku, dobrze zaplanowany agent może zidentyfikować niezależne zadania i realizować je równocześnie. Ta możliwość równoległego działania może skrócić czas realizacji nawet 3-4x w porównaniu do tradycyjnych agentów reaktywnych, co pokazują zaawansowane architektury takie jak LLMCompiler. Co więcej, planowanie umożliwia lepszą obsługę błędów i odzyskiwanie po awariach: mając plan, agent może przeplanować działania od danego punktu, zamiast zaczynać wszystko od nowa, co zwiększa odporność i wydajność systemu.

Dołącz do naszego newslettera

Otrzymuj najnowsze wskazówki, trendy i oferty za darmo.

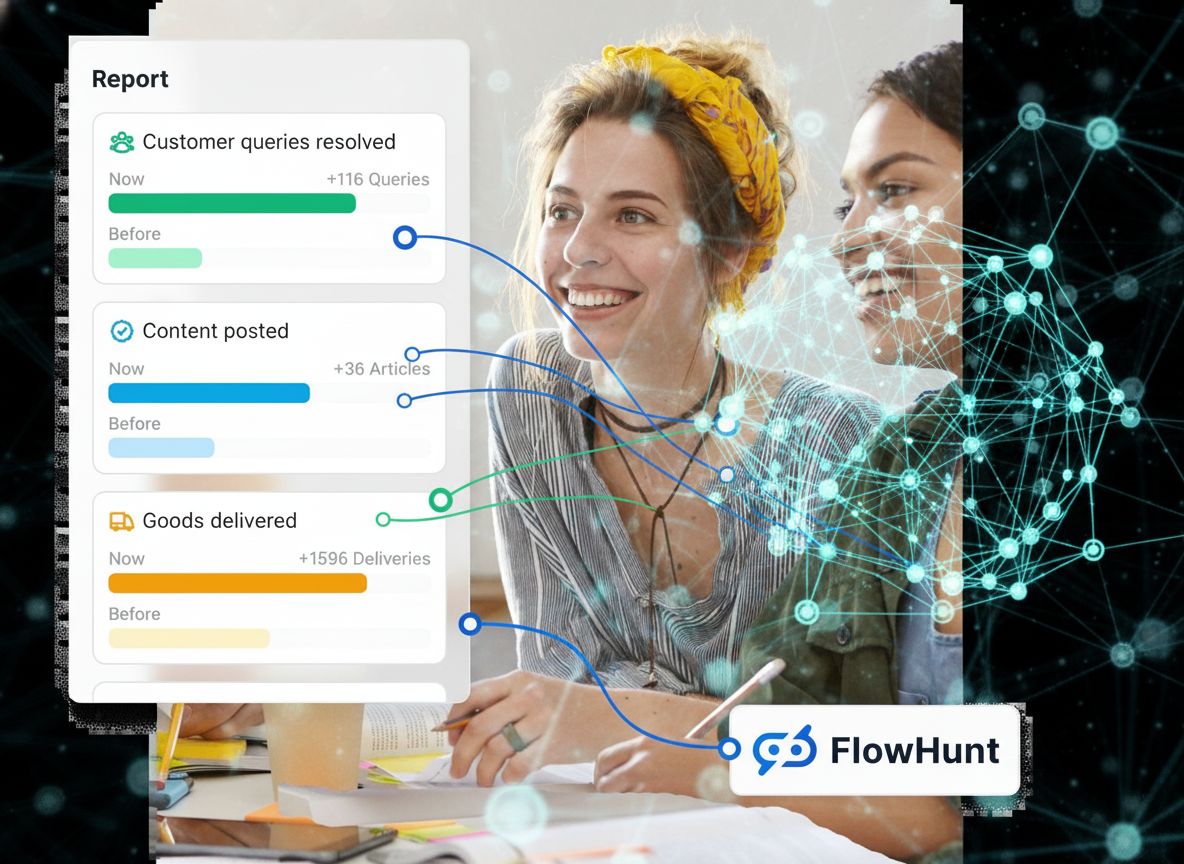

FlowHunt i automatyzacja agentów AI: upraszczanie złożonych przepływów

FlowHunt to potężna platforma umożliwiająca budowę i automatyzację przepływów agentów AI bez potrzeby zaawansowanej wiedzy technicznej. Platforma pozwala projektować zaawansowane architektury agentów, w tym oparte o planowanie, przez intuicyjny interfejs bez kodowania. Z FlowHunt możesz definiować stany agenta, tworzyć kroki planowania, konfigurować integracje narzędzi i monitorować wykonanie — wszystko bez pisania złożonego kodu. To demokratyzuje budowę agentów AI, umożliwiając zespołom tworzenie zaawansowanych systemów automatyzacji, które tradycyjnie wymagałyby dużych zasobów programistycznych. Podejście FlowHunt do automatyzacji agentów doskonale współgra z architekturą opartą na planowaniu, umożliwiając użytkownikom tworzenie agentów rozbijających złożone zadania na przystępne kroki, zachowujących dokładność przy dużych zbiorach informacji i realizujących zadania efektywnie.

Platforma zapewnia także wbudowane monitorowanie i analitykę wydajności agentów, pomagając zespołom zrozumieć, gdzie agenci osiągają sukcesy, a gdzie wymagają poprawek. To kluczowe dla iteracji projektów i optymalizacji działania agentów w czasie. FlowHunt integruje się z popularnymi dostawcami LLM oraz ekosystemami narzędzi, ułatwiając podłączenie agentów do potrzebnych zasobów. Niezależnie czy tworzysz agentów badawczych przeszukujących Internet i syntetyzujących informacje, agentów automatyzujących współpracę systemów, czy agentów obsługi klienta radzących sobie ze złożonymi zapytaniami, FlowHunt zapewnia infrastrukturę umożliwiającą efektywną realizację tych zadań.

LangGraph: fundament zaawansowanej implementacji agentów AI

LangGraph to framework zaprojektowany specjalnie do budowy stanowych agentów AI z wykorzystaniem architektury automatu stanów. W podstawie LangGraph reprezentuje przepływy pracy agenta jako skierowane grafy, gdzie każdy węzeł to stan lub akcja, a krawędzie to przejścia między stanami. Takie podejście daje szereg przewag nad tradycyjnym programowaniem sekwencyjnym: logika agenta jest jawna i łatwa do wizualizacji, umożliwia złożone przepływy z pętlami i warunkowymi rozgałęzieniami, a także zapewnia przejrzystą strukturę zarządzania stanem w całym wykonaniu agenta. Budując agenta w LangGraph, de facto definiujesz automat stanów, według którego agent realizuje zadanie.

Pojęcie automatu stanów jest kluczowe w zrozumieniu działania zaawansowanych agentów. W agencie LangGraph stan zawiera wszystkie informacje potrzebne do podjęcia decyzji i wykonania działań. Dla agenta planującego stan może obejmować oryginalne zapytanie użytkownika, bieżący plan, wykonane zadania, oczekujące zadania oraz wyniki wywołań narzędzi. W miarę postępu agent aktualizuje ten stan na każdym kroku. Gdy agent ukończy zadanie, aktualizuje stan, oznaczając je jako zrealizowane i zapisuje wynik. Gdy musi zdecydować, co zrobić dalej, analizuje bieżący stan i wybiera odpowiednią następną akcję. Takie podejście zapewnia, że agent zawsze ma dostęp do potrzebnych informacji i zachowuje spójność przez cały proces.

Implementacja planowania w LangGraph: Deep Agent State

Implementacja planowania w LangGraph opiera się na stworzeniu uporządkowanego stanu śledzącego postępy agenta przez cały plan. „Deep Agent State” to struktura danych zawierająca dwa główne komponenty: todos (zadania do wykonania) oraz files (zgromadzone informacje). Każdy element todos reprezentuje konkretne zadanie, które agent ma wykonać, wraz z opisem i aktualnym statusem (oczekujące, w trakcie, ukończone). Taka struktura pozwala agentowi zachować jasny zapis tego, co zostało do zrobienia, co jest aktualnie wykonywane, a co już ukończone. Śledzenie statusów jest kluczowe, ponieważ umożliwia agentowi ocenę postępów i podejmowanie inteligentnych decyzji dotyczących dalszych działań.

Implementacja obejmuje również wzorzec reduktora do zarządzania aktualizacjami stanu, zwłaszcza przy wykonywaniu wielu zadań równolegle. Reduktor to funkcja, która przyjmuje obecny stan i aktualizację, zwracając nowy stan. Jest to niezbędne w LangGraph, ponieważ zapewnia, że przy jednoczesnych aktualizacjach przez wiele wątków lub procesów, wszystkie zmiany zostaną prawidłowo połączone i żadna informacja nie zginie. Przykładowo, jeśli dwa zadania kończą się w tym samym czasie i oba chcą zaktualizować stan, reduktor zapewnia, że obie aktualizacje zostaną poprawnie zintegrowane. To zaawansowana koncepcja odróżniająca produkcyjne implementacje agentów od prostych prototypów. Wzorzec reduktora umożliwia także bardziej złożone scenariusze zarządzania stanem, np. agregowanie wyników z wielu zadań równoległych czy rozwiązywanie konfliktów przy aktualizacji tych samych informacji.

Przepływ agenta planującego: od zapytania do wykonania

Agent planujący realizuje określony przepływ pracy, który pokazuje, jak planowanie poprawia skuteczność działania. Po otrzymaniu zapytania użytkownika agent najpierw przechodzi do fazy planowania, w której wykorzystuje model językowy do wygenerowania kompleksowego planu rozwiązania problemu. Plan dzieli złożone zadanie na mniejsze, przystępne kroki. Przykładowo, na pytanie „Przedstaw krótkie podsumowanie MCP (Model Context Protocol)” agent może stworzyć plan: „Krok 1: Wyszukaj informacje o MCP, Krok 2: Zrozum, czym jest MCP i jakie są jego kluczowe cechy, Krok 3: Zsyntetyzuj informacje w zwięzłe podsumowanie”. Agent zapisuje te kroki jako listę todos w stanie, oznaczając je jako oczekujące.

Gdy plan zostanie utworzony, agent przechodzi do fazy wykonania. Odczytuje listę todos i realizuje po kolei każde zadanie. Dla pierwszego zadania (wyszukiwanie informacji) agent wywołuje narzędzie wyszukiwania internetowego z odpowiednim zapytaniem. Wyniki są zwracane i zapisywane w stanie. Agent oznacza to zadanie jako ukończone i przechodzi do następnego. Przy drugim zadaniu agent wykorzystuje model językowy do przetworzenia i zrozumienia wyników wyszukiwania, wyodrębniając kluczowe informacje o MCP. Wynik jest znów zapisany w stanie, a zadanie oznaczone jako ukończone. Wreszcie, w trzecim zadaniu agent syntetyzuje zgromadzone informacje w krótkie podsumowanie odpowiadające pierwotnemu zapytaniu użytkownika. Przez cały proces agent zachowuje czytelny zapis wykonanych czynności, aktualnie realizowanych oraz pozostałych do wykonania. Taka struktura gwarantuje, że agent nie traci kontroli nad postępem i może niezawodnie realizować złożone, wieloetapowe zadania.

Zaawansowane architektury planujące: więcej niż tylko podstawowe planowanie

Choć podstawowe planowanie stanowi ogromny postęp względem agentów reaktywnych, istnieją architektury, które idą jeszcze dalej. Architektura Plan-and-Execute to podstawowe podejście, gdzie agent tworzy plan i realizuje go krok po kroku. Jednak ma ona ograniczenia: zadania są wykonywane sekwencyjnie, a każde zadanie nadal wymaga wywołania LLM. Architektura ReWOO (Reasoning WithOut Observations) rozwiązuje część tych ograniczeń, pozwalając planującemu na korzystanie z przypisania zmiennych. W ReWOO planista może odwołać się do wyników poprzednich zadań za pomocą składni typu „#E2” (wynik zadania 2), umożliwiając zależności bez konieczności konsultowania planisty po każdym kroku. Redukuje to liczbę wywołań LLM i pozwala na bardziej efektywne wykonanie.

Architektura LLMCompiler to najnowocześniejsze podejście do projektowania agentów planujących. Wprowadza kilka innowacji znacząco poprawiających wydajność. Po pierwsze, planista generuje skierowany graf acykliczny (DAG) zadań zamiast prostej listy. Każde zadanie w grafie zawiera narzędzie do wywołania, przekazywane argumenty oraz listę zależności (które inne zadania muszą zakończyć się wcześniej). Po drugie, jednostka pobierająca zadania odbiera strumieniowo wyjście planisty i planuje zadania natychmiast po spełnieniu ich zależności. To umożliwia masową równoległość: jeśli planista wyznaczy dziesięć niezależnych zadań, wszystkie mogą wykonać się równocześnie zamiast sekwencyjnie. Po trzecie, argumenty zadań mogą być zmiennymi odwołującymi się do wyników wcześniejszych zadań, dzięki czemu agent działa szybciej niż przy tradycyjnym wywoływaniu narzędzi równolegle. Połączenie tych cech daje nawet 3,6-krotne przyspieszenie względem tradycyjnych agentów (według artykułu naukowego). Te zaawansowane architektury pokazują, że planowanie to nie jedna technika, lecz spektrum podejść z różnymi kompromisami między złożonością, wydajnością a kosztami.

Narzędzia i integracje: wyposażenie agenta planującego

Aby agent planujący był efektywny, musi mieć dostęp do odpowiednich narzędzi umożliwiających zbieranie informacji i podejmowanie działań. Najczęściej używane narzędzia to wyszukiwarka internetowa (do znajdowania informacji), zapytania do baz danych (dostęp do danych strukturalnych), wywołania API (integracja z zewnętrznymi usługami) oraz wywołania modelu językowego (przetwarzanie i rozumowanie nad informacjami). W implementacji LangGraph narzędzia udostępniane są agentowi przez starannie zaprojektowany interfejs. Agent może wywoływać narzędzia, generując określone funkcje, a wyniki wracają do agenta do przetworzenia. Kluczem do skutecznej integracji narzędzi jest ich dobre zdefiniowanie — precyzyjne wejścia i wyjścia oraz jasność, kiedy i jak agent powinien ich używać.

Poza podstawowymi narzędziami, zaawansowani agenci planujący często posiadają specjalistyczne narzędzia do zarządzania własnym stanem i postępem. Przykładowo, narzędzie „read todos” pozwala agentowi sprawdzić aktualny plan i dowiedzieć się, jakie zadania pozostały. Narzędzie „write todos” umożliwia agentowi aktualizację planu, oznaczanie zadań jako ukończone czy dodawanie nowych w trakcie realizacji. Te meta-narzędzia (operujące na stanie agenta) są kluczowe, by agent mógł adaptować plan w miarę zdobywania nowych informacji. Jeśli agent odkryje, że pierwotny plan był niekompletny lub błędny, może za pomocą write todos go poprawić. Ta adaptacyjność odróżnia produkcyjne implementacje agentów od prostych prototypów. Połączenie narzędzi domenowych (do realizacji właściwej pracy) i meta-narzędzi (do zarządzania rozumowaniem i planowaniem agenta) daje potężny system radzący sobie z trudnymi, nieprzewidywalnymi sytuacjami.

Praktyczny przykład: implementacja agenta badawczego

Aby zobrazować, jak działa planowanie w praktyce, rozważmy agenta badawczego zbierającego informacje na złożony temat. Na zapytanie „Przedstaw kompleksowy przegląd Model Context Protocol (MCP) i jego zastosowań” agent realizuje następujący przepływ: najpierw tworzy plan: „Krok 1: Wyszukaj informacje ogólne o MCP, Krok 2: Wyszukaj zastosowania i przypadki użycia MCP, Krok 3: Wyszukaj techniczne szczegóły implementacji MCP, Krok 4: Zsyntetyzuj wszystkie informacje w kompleksowy przegląd”. Agent zapisuje te cztery zadania jako todos, każde jako oczekujące. Następnie przechodzi do wykonania. Dla Kroku 1 wywołuje narzędzie wyszukiwania z zapytaniem „Czym jest Model Context Protocol MCP?” i otrzymuje wyniki, które zapisuje i oznacza zadanie jako ukończone. Dla Kroku 2 szuka „Zastosowania i przypadki użycia MCP”, znów zapisuje wyniki. Dla Kroku 3 szuka technicznych szczegółów implementacji. Wreszcie w Kroku 4 wykorzystuje model językowy do zsyntetyzowania wszystkich zgromadzonych informacji w spójny przegląd odpowiadający pierwotnemu zapytaniu.

Przez cały proces agent utrzymuje jasny zapis postępów. Jeśli w którymś momencie odkryje, że plan jest niekompletny (np. wyniki wyszukiwania nie zawierają wystarczających informacji), może go zaktualizować, dodając kolejne zadania. Ta adaptacyjność jest kluczowa w rzeczywistych sytuacjach, gdzie pierwotny plan często okazuje się niewystarczający. Agent może odkryć, że potrzebuje więcej informacji o konkretnych wdrożeniach MCP lub musi porównać MCP z alternatywnymi rozwiązaniami. Dzięki możliwości poprawy planu w trakcie wykonania agent radzi sobie z takimi odkryciami bez problemu, zamiast zawodzić lub podawać niepełne informacje. Ten przykład pokazuje siłę planowania: porządkuje proces rozumowania agenta i zapewnia elastyczność potrzebną do dostosowania się do nowych danych.

{{ cta-dark-panel

heading=“Przyspiesz swój przepływ pracy z FlowHunt”

description=“Zobacz, jak FlowHunt automatyzuje Twoje przepływy treści i SEO z AI — od badań i generowania treści po publikację i analitykę — w jednym miejscu.”

ctaPrimaryText=“Umów Demo”

ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo"

ctaSecondaryText=“Wypróbuj FlowHunt za darmo”

ctaSecondaryURL=“https://app.flowhunt.io/sign-in"

gradientStartColor="#123456”

gradientEndColor="#654321”

gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217”

}}

Optymalizacja wydajności: redukcja kosztów i zwiększenie szybkości

Jednym z najważniejszych powodów wdrożenia planowania u agentów AI jest ogromna poprawa parametrów wydajności. Tradycyjni agenci w stylu ReAct wymagają wywołania LLM do każdej akcji, co oznacza, że zadanie wymagające dziesięciu kroków to dziesięć wywołań LLM. Agenci oparci na planowaniu zwykle wymagają tylko dwóch lub trzech wywołań LLM: jedno do fazy planowania, jedno lub więcej do wykonania kroków wymagających rozumowania i ewentualnie jedno do przeplanowania, jeśli plan okaże się niewystarczający. Redukcja wywołań LLM przekłada się bezpośrednio na oszczędności, zwłaszcza przy korzystaniu z drogich modeli jak GPT-4. Dla organizacji uruchamiających tysiące agentów dziennie różnica kosztów między ReAct a agentami planującymi może być znaczna — nawet dziesiątki tysięcy dolarów miesięcznie.

Poza oszczędnościami, planowanie umożliwia znaczące przyspieszenie działania. W tradycyjnych agentach każdy krok musi zakończyć się przed rozpoczęciem następnego, tworząc wąskie gardło. Agenci planujący, szczególnie wykorzystujący architektury DAG (jak LLMCompiler), mogą zidentyfikować niezależne zadania i wykonać je równolegle. Jeśli jedno zadanie wymaga wyszukania informacji o temacie A, a drugie o temacie B i są one niezależne, oba mogą być wykonane jednocześnie. Ta równoległość skraca czas wykonania nawet 3-4 razy względem działania sekwencyjnego. Dla aplikacji skierowanych do użytkowników końcowych przekłada się to na lepsze doświadczenie, a w zastosowaniach wsadowych — na większą ilość pracy wykonanej w tym samym czasie. Połączenie redukcji kosztów i przyspieszenia działania sprawia, że agenci planujący są atrakcyjni praktycznie dla każdej organizacji wykorzystującej AI na dużą skalę.

Radzenie sobie ze złożonością: gdy plany wymagają adaptacji

Rzeczywiste scenariusze rzadko przebiegają zgodnie z idealnym planem. Agenci planujący muszą umieć radzić sobie w sytuacjach, gdy pierwotny plan okazuje się niewystarczający lub błędny. Wymaga to zaawansowanej obsługi błędów i możliwości przeplanowania. Gdy agent napotka nieoczekiwaną sytuację — np. narzędzie zwróci błąd, wyniki wyszukiwania nie zawierają oczekiwanych informacji lub zadanie okazuje się trudniejsze niż przypuszczano — musi się zaadaptować. Najlepszym podejściem jest umożliwienie agentowi przeplanowania na podstawie zdobytych informacji. Przykładowo, jeśli plan agenta zakładał wyszukiwanie informacji i syntezę, ale wyszukiwanie nie zwraca wyników, agent powinien to rozpoznać i skorygować plan. Może spróbować innych zapytań, poszukać alternatywnych źródeł lub inaczej rozbić zadanie.

Implementacja adaptacyjnego planowania wymaga starannego zarządzania stanem i logiki decyzyjnej. Agent musi śledzić nie tylko wykonane działania, ale także wiedzę zebraną o problemie. Jeśli wyszukiwanie „MCP” nie daje rezultatów, powinien spróbować „Model Context Protocol” lub „protokół MCP” przed poddaniem się. Jeśli narzędzie zgłasza błąd, agent powinien zdecydować, czy spróbować ponownie, użyć innego narzędzia czy przekazać problem dalej. Te decyzje wymagają od agenta rozumowania nad postępem i dostosowywania strategii na bieżąco. Tu przewaga agenta planującego jest wyraźna: mając jawny plan, agent może ocenić, czy realizacja idzie zgodnie z założeniami i sensownie go poprawić. Agent reaktywny nie ma takiej struktury i musi podejmować decyzje na bieżąco, bez znajomości całości zadania.

Monitorowanie i debugowanie agentów planujących

Wraz ze wzrostem złożoności agentów planujących rośnie znaczenie monitorowania i debugowania. W przeciwieństwie do prostych aplikacji, gdzie łatwo prześledzić ścieżkę wykonania, agenci planujący angażują wiele punktów decyzyjnych, wywołań narzędzi i aktualizacji stanu. Skuteczne monitorowanie wymaga wglądu w kilka aspektów działania: stworzony plan, ukończone zadania, wyniki każdego wywołania narzędzia oraz decyzje podejmowane na każdym etapie. LangGraph zapewnia wsparcie przez LangSmith — platformę monitoringu i debugowania wizualizującą wykonanie agenta w postaci grafu. Możesz dokładnie zobaczyć, które węzły zostały wykonane, w jakiej kolejności i jaki stan był przekazywany między nimi. Taka wizualizacja jest nieoceniona przy analizie zachowania agenta i wskazywaniu miejsc do optymalizacji.

Debugowanie agentów planujących wymaga również zrozumienia promptów używanych do generowania planów. Jakość planu bezpośrednio wpływa na skuteczność agenta, więc jeśli agent działa źle, warto najpierw przyjrzeć się promptowi planującemu. Możesz odkryć, że prompt nie dostarcza wystarczającego kontekstu lub nie precyzuje oczekiwanych formatów planu. Iteracje nad promptem często znacząco poprawiają działanie agenta. Monitorowanie wyników narzędzi pomaga także ustalić, czy zwracają one oczekiwane rezultaty i czy wymagają przeprojektowania. Jeśli np. wyszukiwarka zwraca nieistotne wyniki, można zmienić format zapytania lub dodać filtry. Łącząc wizualizację grafu wykonania z analizą promptów i wyników, można systematycznie poprawiać skuteczność agentów planujących.

Najlepsze praktyki w budowie agentów planujących

Na podstawie badań i doświadczenia praktycznego wyłoniło się kilka najlepszych praktyk w budowie skutecznych agentów planujących. Po pierwsze, warto zainwestować czas w tworzenie wysokiej jakości promptów do planowania. Prompt powinien jasno wyjaśniać zadanie, zawierać przykłady dobrych planów i precyzować format wyjścia. Dobrze przygotowany prompt znacząco podnosi jakość planów i ogranicza potrzebę przeplanowania. Po drugie, star