Inżynieria kontekstu dla agentów AI: Sztuka dostarczania LLM-om właściwych informacji

Dowiedz się, jak projektować kontekst dla agentów AI poprzez zarządzanie informacjami zwrotnymi z narzędzi, optymalizację wykorzystania tokenów oraz wdrażanie s...

Dowiedz się, jak inżynieria kontekstu optymalizuje wydajność agentów AI poprzez strategiczne zarządzanie tokenami, redukcję nadmiaru kontekstu oraz wdrażanie zaawansowanych technik takich jak offloading, redukcja, retrieval i izolacja.

Inżynieria kontekstu stała się jedną z najważniejszych dyscyplin w budowaniu skutecznych agentów AI. Wraz ze wzrostem mocy modeli językowych i coraz bardziej złożonymi, wieloetapowymi zadaniami agentów, wyzwaniem nie jest już tylko posiadanie odpowiedniego modelu—kluczowe staje się strategiczne zarządzanie informacją, którą temu modelowi przekazujesz. Każdy token ma znaczenie. W tym kompleksowym przewodniku omówimy, czym jest inżynieria kontekstu, dlaczego jest niezbędna dla wydajności agentów AI oraz konkretne techniki, które wiodące organizacje badawcze i platformy AI stosują, aby budować optymalne agenty. Niezależnie od tego, czy budujesz boty obsługi klienta, agentów analizy danych, czy autonomiczne przepływy pracy, zrozumienie inżynierii kontekstu zasadniczo poprawi wydajność Twoich systemów AI.

Inżynieria kontekstu oznacza fundamentalną zmianę w podejściu do budowania rozwiązań z dużymi modelami językowymi. Zamiast traktować LLM jako czarną skrzynkę wymagającą jedynie dobrych instrukcji, inżynieria kontekstu postrzega model jako system o ograniczonych zasobach poznawczych, które należy starannie gospodarować. W swojej istocie inżynieria kontekstu to praktyka świadomego decydowania, jaki kontekst przekazać agentowi AI—przemyślenie każdego tokena, który trafia do każdego wywołania LLM, by stworzyć optymalne warunki do sukcesu agenta.

Koncepcja ta została spopularyzowana przez badaczy takich jak Andrej Karpathy i zyskuje na znaczeniu, ponieważ agenci AI ewoluują od prostych chatbotów do zaawansowanych systemów zdolnych do autonomicznego wnioskowania i działania. Kluczowym spostrzeżeniem jest to, że LLM-y, podobnie jak ludzie, mają ograniczoną pamięć roboczą i pojemność uwagi. Tak jak człowiek może skupić się tylko na ograniczonej ilości informacji naraz, zanim zacznie się gubić lub tracić istotne szczegóły, modele językowe doświadczają spadku zdolności rozumowania przy nadmiarze kontekstu. Oznacza to, że jakość kontekstu jest dużo ważniejsza niż jego ilość.

Inżynieria kontekstu wykracza poza tradycyjne prompt engineering, które skupiało się głównie na tworzeniu idealnego prompta systemowego lub instrukcji. Obejmuje cały ekosystem informacji dostępnych dla agenta przez wiele tur interakcji—w tym prompty systemowe, definicje narzędzi, przykłady, historię wiadomości, pobierane dane i dynamicznie ładowane informacje. Celem jest utrzymanie szczupłego, wysokosygnałowego okna kontekstu, które daje agentowi dokładnie to, czego potrzebuje do podejmowania dobrych decyzji, nie przytłaczając go zbędnymi informacjami.

Znaczenie inżynierii kontekstu nie może być przecenione podczas budowania agentów AI klasy produkcyjnej. Badania niezmiennie pokazują, że LLM-y doświadczają tzw. “context rot”—mierzalnego pogorszenia wydajności wraz ze wzrostem długości okna kontekstu. Badania z użyciem benchmarków typu needle-in-a-haystack wykazały, że wraz ze wzrostem liczby tokenów w kontekście, maleje zdolność modelu do dokładnego przypominania i rozumowania na podstawie tych informacji. To nie jest marginalny efekt; to fundamentalne ograniczenie architektury modeli transformatorowych.

Przyczyną tego zjawiska jest sama architektura transformera. W transformerach każdy token może odnosić się do każdego innego tokena w kontekście, tworząc n² relacji dla n tokenów. Wraz z wydłużaniem kontekstu mechanizm uwagi modelu jest coraz bardziej obciążony, próbując utrzymać te relacje na coraz większej przestrzeni. Dodatkowo modele językowe są trenowane głównie na krótszych sekwencjach, więc mają mniej doświadczenia i mniej wyspecjalizowanych parametrów do obsługi bardzo długich zależności. Powoduje to naturalne napięcie między rozmiarem kontekstu a zdolnością do rozumowania—modele pozostają funkcjonalne przy dłuższych kontekstach, ale wykazują gorszą precyzję przy wyszukiwaniu informacji i rozumowaniu dalekosiężnym w porównaniu do wydajności przy krótszych sekwencjach.

Poza ograniczeniami architektonicznymi istnieje też praktyczna rzeczywistość: LLM-y mają “budżet uwagi”, który wyczerpuje się z każdym nowym tokenem. Każda informacja dodana do kontekstu zużywa część tego budżetu, zwiększając obciążenie poznawcze modelu. Dlatego przemyślana inżynieria kontekstu jest niezbędna. Starannie dobierając informacje przekazywane modelowi, nie tylko optymalizujesz wydajność, ale bezpośrednio poprawiasz jakość rozumowania i podejmowania decyzji przez agenta. Agent z szczupłym, dobrze zorganizowanym oknem kontekstu podejmuje lepsze decyzje, skuteczniej odzyskuje się po błędach i utrzymuje stabilną wydajność nawet przy dłuższych sekwencjach niż agent tonący w nieistotnych informacjach.

Chociaż inżynieria kontekstu i prompt engineering są powiązanymi pojęciami, reprezentują różne poziomy abstrakcji w budowaniu rozwiązań z modelami językowymi. Prompt engineering, które dominowało we wczesnej erze zastosowań LLM, koncentruje się na tym, jak napisać skuteczny prompt i instrukcje systemowe. Głównym celem jest dobranie słów i fraz, które wywołają pożądane zachowanie modelu dla danego zadania. To podejście sprawdza się przy pojedynczych, jednorazowych zadaniach takich jak klasyfikacja, streszczenie czy generowanie tekstu na żądanie.

Inżynieria kontekstu to naturalna ewolucja prompt engineering w erze wieloturnych, autonomicznych agentów. Podczas gdy prompt engineering pyta “Jak napisać idealną instrukcję?”, inżynieria kontekstu stawia szersze pytanie: “Jaka jest optymalna konfiguracja wszystkich dostępnych informacji, która wygeneruje pożądane zachowanie?” Obejmuje to nie tylko prompt systemowy, ale także narzędzia dostępne dla agenta, dostarczone przykłady, historię wiadomości z poprzednich tur, pobrane dane i metadane pomagające agentowi zrozumieć środowisko.

Przejście od prompt engineering do inżynierii kontekstu odzwierciedla fundamentalną zmianę w sposobie budowania aplikacji AI. We wczesnych dniach większość zastosowań poza zwykłym chatem wymagała promptów zoptymalizowanych pod jednorazowe zadania. Dziś branża zmierza w kierunku bardziej zaawansowanych agentów działających przez wiele tur wnioskowania i na dłuższych horyzontach czasowych. Tacy agenci generują coraz więcej danych, które potencjalnie mogą być istotne dla przyszłych decyzji, a te informacje muszą być cyklicznie udoskonalane i selekcjonowane. Inżynieria kontekstu to dyscyplina zarządzania tym zmieniającym się ekosystemem informacji, zapewniająca, by na każdym etapie rozumowania agent miał dostęp do dokładnie tych informacji, które umożliwiają mu podejmowanie dobrych decyzji.

Wiodące organizacje badawcze i platformy AI wypracowały cztery główne techniki skutecznej inżynierii kontekstu. Każda z nich odpowiada na inny aspekt wyzwania zarządzania ograniczonym oknem kontekstu przy zachowaniu wydajności agenta. Zrozumienie tych technik i umiejętność ich zastosowania jest kluczowe w budowaniu agentów AI klasy produkcyjnej.

Offloading to praktyka polegająca na streszczaniu informacji i przechowywaniu pełnych danych jako zewnętrznych referencji, dzięki czemu agent uzyskuje dostęp do szczegółowych danych tylko wtedy, gdy jest to potrzebne. Gdy agent AI wykonuje wywołanie narzędzia—np. zapytanie do bazy danych lub zewnętrznego API—otrzymuje odpowiedź, która może być bardzo obszerna. Zamiast wrzucać całą odpowiedź do okna kontekstu, offloading polega na podsumowaniu kluczowych informacji i przekazaniu referencji, dzięki której agent może pobrać pełne dane w razie potrzeby.

Praktycznym przykładem tego podejścia jest Manus AI, organizacja badawcza pracująca nad zaawansowanymi agentami AI. Gdy ich agent wykonuje wywołanie narzędzia i otrzymuje odpowiedź, nie umieszczają całej odpowiedzi w kontekście. Zamiast tego dostarczają zwięzłe podsumowanie i przechowują pełny wynik wywołania narzędzia w pliku lub bazie danych z wskaźnikiem referencyjnym. Jeśli agent później uzna, że potrzebuje bardziej szczegółowych danych, może sięgnąć po zapisane informacje, nie zużywając kolejnych tokenów kontekstu w głównej rozmowie. To podejście przypomina sposób pracy ludzi—nie zapamiętujemy wszystkich szczegółów każdej rozmowy, ale prowadzimy notatki i referencje, do których możemy sięgnąć w razie potrzeby.

Cognition, inna czołowa organizacja badawcza AI, wdrożyła podobne rozwiązanie, lecz z własnym systemem podsumowań. Zamiast polegać na ogólnych streszczeniach, zbudowali specjalistyczną logikę podsumowań, która wyciąga najbardziej istotne informacje dla swoich przypadków użycia. Pokazuje to ważną zasadę: najlepsza strategia offloadingu jest często specyficzna dla zadania. To, co stanowi użyteczne podsumowanie, zależy od tego, co agent ma osiągnąć. Dopasowując podsumowania do konkretnej domeny i zadania, możesz utrzymać wysokosygnałowy kontekst przy znacznym ograniczeniu liczby tokenów.

Redukcja to technika polegająca na kompaktowaniu i kondensowaniu kontekstu, aby zmniejszyć całkowitą liczbę tokenów przy zachowaniu kluczowych informacji. W miarę jak agent działa przez wiele tur, historia rozmowy rośnie. Bez aktywnego zarządzania ta historia szybko wypełni całe okno kontekstu, pozostawiając niewiele miejsca na nowe dane lub rozumowanie. Redukcja polega na okresowym kompaktowaniu rozmowy do bardziej zwięzłej formy.

Anthropic wdrożył tę technikę przez regularne “kompaktowanie” rozmowy. Zamiast przechowywać pełną historię każdej wymiany wiadomości, okresowo streszczają lub kompresują historię rozmowy do krótszej postaci. Jest to szczególnie ważne, ponieważ badania pokazują, że długi kontekst utrudnia agentom AI skuteczne rozumowanie. Nadmiar informacji może prowadzić do tzw. “context poisoning”—zjawiska, w którym proces rozumowania agenta zostaje zaburzony przez nieistotne dane, co prowadzi do odejścia od optymalnej ścieżki rozumowania.

Technika redukcji opiera się na fundamentalnym spostrzeżeniu dotyczącym działania modeli językowych: nie zawsze lepiej rozumują, mając więcej informacji. Wręcz przeciwnie, często jest odwrotnie. Szczupły, dobrze zorganizowany kontekst zawierający tylko najistotniejsze dane zazwyczaj prowadzi do lepszego rozumowania i bardziej niezawodnych zachowań agenta. Dlatego wiele wiodących organizacji aktywnie dąży do ograniczania rozmiaru kontekstu w czasie, nawet gdy teoretycznie dostępnych może być więcej informacji. Utrzymując okno kontekstu skupione i przejrzyste, zachowują zdolność agenta do jasnego rozumowania i podejmowania dobrych decyzji.

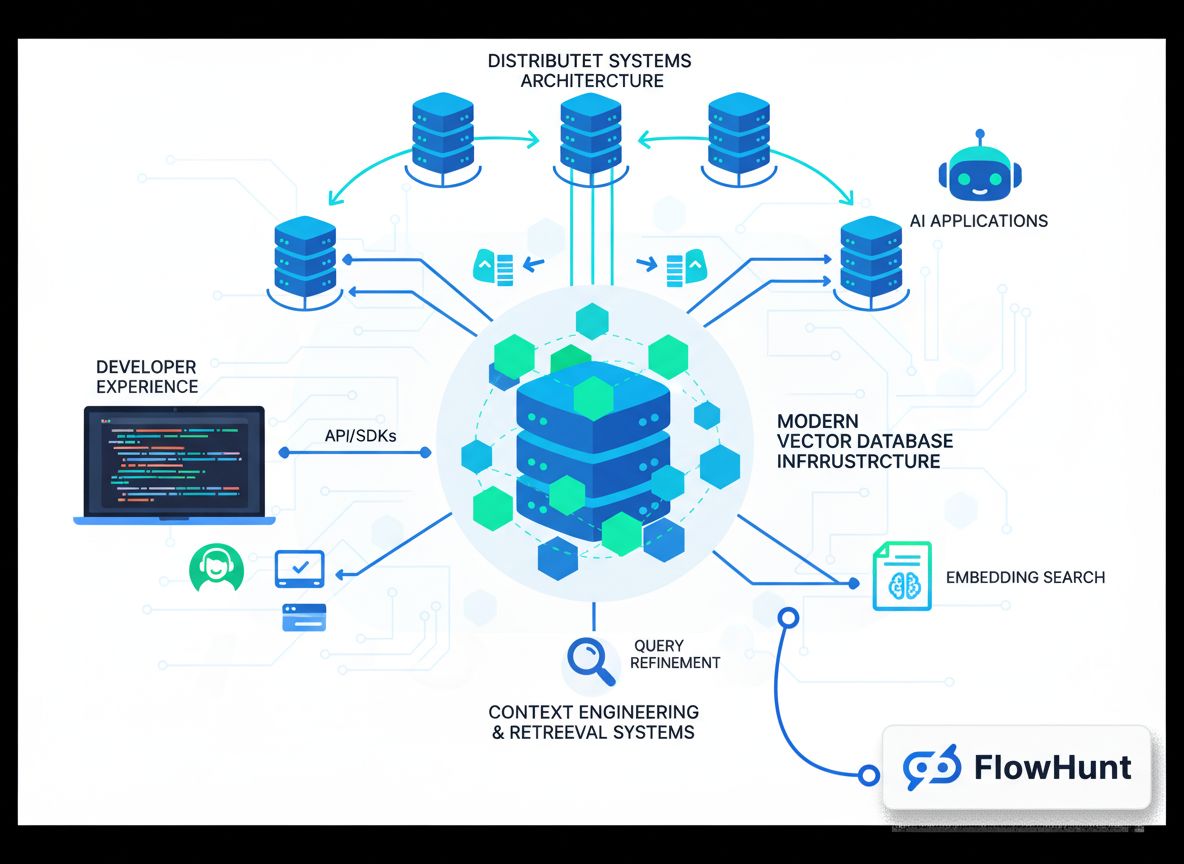

Retrieval-Augmented Generation (RAG) to technika, w której istotne informacje są dynamicznie pobierane i ładowane do kontekstu w czasie rzeczywistym, zamiast być wstępnie załadowane. Podejście to zyskuje na popularności wraz z rozwojem bardziej zaawansowanych agentów. Zamiast próbować przewidzieć wszystkie informacje, których agent może potrzebować i ładować je od razu, systemy RAG umożliwiają agentom aktywne wyszukiwanie i pobieranie informacji, gdy uznają to za konieczne.

To podejście przynosi istotne korzyści. Po pierwsze, znacząco zmniejsza początkowe obciążenie kontekstu—agent zaczyna z szczupłym oknem kontekstu i tylko w razie potrzeby pobiera dodatkowe informacje. Po drugie, umożliwia progresywne odkrywanie informacji—agent stopniowo poznaje istotny kontekst przez eksplorację. Każda interakcja dostarcza nowych danych, które wpływają na kolejne decyzje. Na przykład agent może zacząć od wyszukania odpowiednich plików, odkryć, że pewne pliki są ważniejsze na podstawie ich nazw lub dat, i pobrać właśnie te pliki do szczegółowej analizy. Takie warstwowe podejście do odkrywania kontekstu jest dużo bardziej wydajne niż ładowanie wszystkiego z góry.

Claude Code od Anthropica jest świetnym przykładem RAG w praktyce. Zamiast ładować całą bazę kodu do kontekstu, Claude Code utrzymuje lekkie identyfikatory, takie jak ścieżki plików, i korzysta z narzędzi takich jak grep i glob do dynamicznego pobierania odpowiednich plików w razie potrzeby. Agent może pisać ukierunkowane zapytania, przechowywać wyniki i wykorzystywać narzędzia konsolowe do analizy dużych zbiorów danych bez ładowania pełnych obiektów danych do kontekstu. To podejście odzwierciedla ludzką kognicję—nie zapamiętujemy całych zbiorów informacji, ale tworzymy zewnętrzne systemy organizacji, takie jak systemy plików i wyszukiwarki, które umożliwiają pobranie istotnych danych na żądanie.

Izolacja to praktyka polegająca na wykorzystaniu sub-agentów do obsługi konkretnych zadań, dzięki czemu różni agenci pracują nad oddzielnymi problemami bez nakładania się kontekstu. Technika ta zakłada, że czasami najlepszym sposobem zarządzania kontekstem jest podzielenie złożonych problemów na mniejsze, bardziej wyspecjalizowane podzadania, z których każde obsługuje dedykowany agent z własnym oknem kontekstu.

Są dwa główne podejścia do izolacji. Cognition, czołowa organizacja AI, wręcz odradza użycie sub-agentów, jeśli zadania nie są całkowicie rozdzielone—uważają, że sub-agenci wprowadzają dodatkową złożoność i potencjalne punkty awarii, więc warto ich używać tylko w razie bezwzględnej potrzeby. Inne organizacje, jak Cloud Code, uczyniły sub-agentów kluczowym elementem swojej architektury. W Cloud Code możesz tworzyć sub-agentów do różnych aspektów większego zadania, a agent-menedżer koordynuje ich pracę.

Najważniejsze przy izolacji jest to, że wiąże się ona z kompromisem. Z jednej strony sub-agenci pomagają zarządzać kontekstem poprzez podział przestrzeni problemowej—każdy agent ma skupione okno kontekstu odpowiednie do swojego zadania. Z drugiej strony sub-agenci wprowadzają koszty koordynacji i potencjalne miejsca, gdzie informacja musi być przekazywana między agentami. Właściwe podejście zależy od konkretnego przypadku użycia. Dla bardzo złożonych zadań z wyraźnie oddzielonymi podproblemami izolacja może być bardzo skuteczna. Dla zadań, w których różne aspekty są silnie powiązane, lepszy może być pojedynczy agent z dobrze zarządzanym kontekstem.

FlowHunt oferuje kompleksową platformę no-code do wdrażania wszystkich technik inżynierii kontekstu. Zamiast wymagać od programistów budowania własnych rozwiązań, FlowHunt pozwala zespołom wdrażać zaawansowane strategie zarządzania kontekstem poprzez intuicyjny interfejs wizualny. To demokratyzuje inżynierię kontekstu, czyniąc ją dostępną także dla zespołów nieposiadających głębokiego doświadczenia w machine learningu.

W FlowHunt możesz wdrażać izolację za pomocą samo-zarządzających się zespołów. Taki zespół składa się z kilku agentów AI oraz agenta-menedżera koordynującego pracę. Agent-menedżer otrzymuje zadanie, dzieli je na podzadania i deleguje je do wyspecjalizowanych agentów. Każdy agent utrzymuje skupione okno kontekstu powiązane ze swoją odpowiedzialnością. Po zakończeniu pracy przez sub-agentów, agent-menedżer łączy wyniki. To podejście pozwala rozwiązywać złożone problemy przez rozbicie ich na mniejsze części, z których każda ma zoptymalizowany kontekst.

FlowHunt obsługuje także sekwencyjne przepływy zadań, gdzie kilku agentów pracuje nad problemem kolejno, a wyjście jednego staje się wejściem dla kolejnego. To szczególnie przydatne w workflow, gdzie zadania są zależne. Na przykład w procesie tworzenia treści jeden agent może zbadać temat, drugi przygotować konspekt, a trzeci napisać ostateczny tekst. Każdy agent pracuje w oparciu o kontekst istotny tylko dla swojego etapu.

Dodatkowo FlowHunt umożliwia budowę inteligentnych systemów retrieval bezpośrednio w przepływach. Zamiast ładować wszystkie informacje z góry, możesz skonfigurować agentów do dynamicznego pobierania istotnych danych w razie potrzeby—np. poprzez zapytania do baz danych, przeszukiwanie baz wiedzy lub pobieranie plików na podstawie rozumowania agenta. Dzięki połączeniu tych możliwości FlowHunt pozwala wdrażać rozwiązania klasy enterprise w zakresie inżynierii kontekstu bez konieczności pisania kodu.

Poza czterema podstawowymi technikami istnieje kilka zaawansowanych strategii, które wiodące organizacje wykorzystują, by przesuwać granice możliwości inżynierii kontekstu. Często łączą one różne techniki i wymagają starannego dostrojenia pod konkretne zastosowania.

Jedna z takich strategii to hybrydowe zarządzanie kontekstem, w którym część informacji ładowana jest z góry, a część pobierana dynamicznie. Zamiast wybierać pomiędzy ładowaniem wszystkiego na starcie a pobieraniem wszystkiego na żądanie, podejścia hybrydowe wczytują kluczowe informacje z góry dla szybkości i niezawodności, jednocześnie zachowując zdolność do pobierania dodatkowych danych w razie potrzeby. Claude Code stosuje takie podejście—pliki CLAUDE.md są ładowane od razu, bo są zwykle niewielkie i zawierają istotne informacje konfiguracyjne, a większe pliki i dane pobierane są w razie potrzeby z użyciem grep i glob.

Inna zaawansowana strategia to selekcja kontekstu oparta na metadanych. Zamiast patrzeć tylko na treść informacji, zaawansowane systemy wykorzystują metadane takie jak nazwy plików, daty, struktury folderów i inne sygnały organizacyjne, by podejmować inteligentne decyzje o przydatności informacji. Agent operujący w systemie plików może np. wiele wywnioskować z obecności pliku test_utils.py w folderze tests vs. tym samym pliku w src/core_logic/. Takie sygnały pomagają agentowi zrozumieć, jak i kiedy wykorzystać daną informację, ograniczając potrzebę ładowania i przetwarzania pełnej zawartości.

Kolejna istotna strategia to przeciwdziałanie context poisoning. Jak wspomniano, context poisoning to sytuacja, gdy nieistotne informacje w kontekście powodują odejście agenta od optymalnej ścieżki rozumowania. Zaawansowane systemy aktywnie identyfikują i usuwają potencjalnie szkodliwy kontekst. Może to oznaczać analizę łańcucha rozumowania agenta, wykrycie momentu “zboczenia z kursu” i usunięcie lub przeformułowanie kontekstu, który do tego doprowadził. Tworzy to pętlę zwrotną, która z czasem stale poprawia jakość kontekstu.

Wraz z coraz większym zaawansowaniem agentów AI i ich wdrażaniem w coraz bardziej złożonych realnych scenariuszach, inżynieria kontekstu będzie nabierać jeszcze większego znaczenia. Dziedzina ta dynamicznie się rozwija, pojawiają się nowe techniki i najlepsze praktyki. Kilka trendów prawdopodobnie ukształtuje jej przyszłość.

Po pierwsze, prawdopodobnie pojawią się coraz bardziej zaawansowane, automatyczne systemy selekcji kontekstu. Zamiast ręcznego decydowania o zawartości kontekstu, przyszłe systemy będą wykorzystywać uczenie maszynowe do automatycznego ustalania optymalnego kontekstu dla każdego agenta i zadania. Takie systemy mogą uczyć się na podstawie danych o wydajności agentów, które fragmenty kontekstu są najcenniejsze, a które mogą powodować context poisoning.

Po drugie, inżynieria kontekstu będzie coraz bardziej zintegrowana z projektowaniem architektury agentów. Zamiast traktować zarządzanie kontekstem jako dodatek, przyszłe systemy agentowe będą projektowane od podstaw z myślą o efektywności kontekstu. Może to oznaczać nowe architektury agentów, które lepiej gospodarują ograniczonym oknem kontekstu, lub nowe sposoby reprezentacji informacji, bardziej oszczędne pod względem tokenów.

Po trzecie, prawdopodobnie wykształci się inżynieria kontekstu jako odrębna specjalizacja zawodowa, z dedykowanymi narzędziami, frameworkami i dobrymi praktykami. Tak jak prompt engineering ewoluowało od ad hoc do uznanej dyscypliny z ustalonymi technikami, tak samo inżynieria kontekstu podąża tą ścieżką. Organizacje będą inwestować w budowę wyspecjalizowanych zespołów i narzędzi skupionych na optymalizacji kontekstu.

{{ cta-dark-panel heading=“Przyspiesz swój workflow z FlowHunt” description=“Zobacz, jak FlowHunt automatyzuje Twoje procesy AI i SEO — od researchu i generowania treści po publikację i analitykę — wszystko w jednym miejscu.” ctaPrimaryText=“Umów demo” ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo" ctaSecondaryText=“Wypróbuj FlowHunt za darmo” ctaSecondaryURL=“https://app.flowhunt.io/sign-in" gradientStartColor="#123456” gradientEndColor="#654321” gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217” }}

Aby ułatwić Ci rozpoczęcie pracy z inżynierią kontekstu, przejdźmy przez praktyczny przykład budowy agenta z inżynierią kontekstu dla typowego zastosowania: researchu i generowania treści. Ten przykład pokazuje, jak zastosować opisane techniki w rzeczywistym scenariuszu.

Zacznij od jasnego określenia głównej odpowiedzialności agenta. W tym przypadku jego zadaniem jest zbadanie tematu i wygenerowanie kompleksowego artykułu. Zamiast próbować zrobić wszystko w jednym agencie z ogromnym oknem kontekstu, zastosuj izolację i stwórz system wieloagentowy. Pierwszy agent to researcher, który zbiera informacje o temacie. Drugi agent to copywriter, który na ich podstawie tworzy artykuł. Koordynuje nimi agent-menedżer.

Dla agenta researcher’a zastosuj retrieval-based context management. Zamiast ładować wszystkie dostępne informacje na temat od razu, agent researcher powinien mieć narzędzia do przeszukiwania baz danych, zapytań do API i pobierania dokumentów. W miarę odkrywania informacji streszcza najważniejsze wnioski i przechowuje referencje do pełnych źródeł. Dzięki temu jego okno kontekstu pozostaje szczupłe, a jednocześnie ma dostęp do wszystkich potrzebnych danych.

Dla agenta copywritera zastosuj offloading. Researcher przekazuje mu podsumowanie ustaleń wraz z referencjami do pełnych źródeł. Kontekst copywritera obejmuje podsumowanie i możliwość sięgnięcia po pełny materiał źródłowy w razie potrzeby. Dzięki temu copywriter pracuje wydajnie, nie będąc przytłoczonym surowymi danymi z researchu.

Przez cały proces monitoruj context poisoning. Jeśli zauważysz, że agent podejmuje nietrafione decyzje lub schodzi z kursu, przeanalizuj jego rozumowanie, by zidentyfikować, które fragmenty kontekstu mogły to spowodować. Usuń lub przeformułuj te dane i przetestuj ponownie. Z czasem nabierzesz intuicji, jaki kontekst najlepiej sprawdza się w Twoim przypadku użycia.

Skuteczna inżynieria kontekstu wymaga pomiaru i ciągłej optymalizacji. Musisz określić metryki, które pomogą ocenić, czy Twoje działania rzeczywiście poprawiają wydajność agenta. Istnieje kilka kluczowych wskaźników wartych śledzenia.

Po pierwsze, mierzyć efektywność wykorzystania tokenów—stosunek użytecznego outputu do liczby zużytych tokenów. Agent generujący wysokiej jakości wyniki przy mniejszym zużyciu tokenów jest bardziej wydajny. Śledź ten wskaźnik w miarę wdrażania technik inżynierii kontekstu. Powinieneś zauważyć poprawę po zastosowaniu offloadingu, redukcji i retrieval.

Po drugie, mierz jakość rozumowania. Może to oznaczać analizę łańcuchów rozumowania agenta pod kątem spójności i logiki lub porównanie jakości wyników agenta ze standardem referencyjnym. Wraz z poprawą inżynierii kontekstu powinna wzrosnąć jakość rozumowania, bo agent ma mniej rozpraszających, nieistotnych informacji.

Po trzecie, mierz zdolność do odzyskiwania po błędach. Jak dobrze agent potrafi się zrehabilitować po popełnieniu błędu? Lepsza inżynieria kontekstu powinna przełożyć się na skuteczniejsze odzyskiwanie po błędach, bo agent ma jaśniejsze informacje o tym, co poszło nie tak i co zrobić dalej.

Po czwarte, mierz opóźnienia i koszty. Choć inżynieria kontekstu skupia się głównie na jakości, przynosi też korzyści wydajnościowe. Agenci z lepiej zarządzanym kontekstem mają zazwyczaj niższe opóźnienia (przetwarzają mniej tokenów) i niższe koszty (zużywają mniej tokenów). Śledź te wskaźniki, by w pełni ocenić wpływ swoich działań.

Wdrażając inżynierię kontekstu, zespoły napotykają kilka typowych pułapek. Świadomość ich pomoże uniknąć kosztownych błędów.

Pierwsza pułapka to nadmierna optymalizacja. Kuszące jest wyciskanie każdego

Inżynieria kontekstu to praktyka strategicznego dobierania i zarządzania tokenami przekazywanymi agentowi AI lub modelowi językowemu w celu optymalizacji wydajności. Polega na przemyślanym traktowaniu każdego tokena, który przechodzi przez wywołanie LLM, aby stworzyć dla agenta jak najlepszy kontekst do efektywnego rozumowania i działania.

Prompt engineering koncentruje się na pisaniu skutecznych promptów i instrukcji systemowych dla jednorazowych zadań. Inżynieria kontekstu jest szersza i bardziej iteracyjna—zarządza całym stanem kontekstu przez wiele tur wnioskowania, obejmując instrukcje systemowe, narzędzia, dane zewnętrzne, historię wiadomości oraz dynamicznie pobierane informacje.

Context rot to pogorszenie zdolności LLM do dokładnego przypominania i rozumowania na podstawie informacji, gdy okno kontekstu się powiększa. Wynika to z ograniczonego 'budżetu uwagi' LLM i malejących korzyści przy nadmiarze tokenów, co sprawia, że staranna selekcja kontekstu jest kluczowa.

Cztery główne techniki to: (1) Offloading—podsumowywanie odpowiedzi narzędzi i przechowywanie pełnych danych jako referencji; (2) Redukcja—kompaktowanie rozmów w celu zmniejszenia liczby tokenów; (3) Retrieval (RAG)—dynamiczne pobieranie istotnych informacji w czasie rzeczywistym; oraz (4) Izolacja—wykorzystywanie sub-agentów do obsługi konkretnych zadań bez nakładania się kontekstu.

FlowHunt oferuje platformę no-code do wdrażania wszystkich technik inżynierii kontekstu. Możesz tworzyć samo-zarządzające się zespoły z agentami menedżerami, korzystać z sekwencyjnych przepływów zadań, wdrażać sub-agentów dla izolacji oraz budować inteligentne systemy retrieval—wszystko to bez kodowania.

Arshia jest Inżynierką Przepływów Pracy AI w FlowHunt. Z wykształceniem informatycznym i pasją do sztucznej inteligencji, specjalizuje się w tworzeniu wydajnych przepływów pracy, które integrują narzędzia AI z codziennymi zadaniami, zwiększając produktywność i kreatywność.

Buduj inteligentniejsze i wydajniejsze agenty AI dzięki możliwościom inżynierii kontekstu FlowHunt. Zarządzaj tokenami inteligentnie i skaluj swoje procesy automatyzacji.

Dowiedz się, jak projektować kontekst dla agentów AI poprzez zarządzanie informacjami zwrotnymi z narzędzi, optymalizację wykorzystania tokenów oraz wdrażanie s...

Poznaj, jak inżynieria kontekstu przekształca rozwój AI, ewolucję od RAG do systemów gotowych na produkcję oraz dlaczego nowoczesne bazy wektorowe, takie jak Ch...

Dowiedz się, dlaczego czołowi inżynierowie odchodzą od serwerów MCP i poznaj trzy sprawdzone alternatywy — podejścia oparte na CLI, narzędzia skryptowe oraz wyk...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.