llms.txt

Plik llms.txt to standaryzowany plik Markdown zaprojektowany w celu optymalizacji sposobu, w jaki Duże Modele Językowe (LLM) uzyskują dostęp i przetwarzają treś...

Dowiedz się, jak pliki LLMs.txt pomagają agentom AI sprawnie poruszać się po Twojej stronie, priorytetyzować ważne treści i zwiększać widoczność Twojego biznesu w wynikach wyszukiwania opartych na AI.

W miarę jak sztuczna inteligencja coraz bardziej zmienia sposób odkrywania i interakcji z treściami online, strony internetowe stają przed nowym wyzwaniem: skąd agenci AI wiedzą, które podstrony są najważniejsze? Jak sprawić, by model AI najpierw trafiał na Twoje najlepsze treści? Odpowiedzią jest nowy internetowy standard — LLMs.txt — specjalny format pliku zaprojektowany, by pomagać dużym modelom językowym efektywnie poruszać się po Twojej stronie i priorytetyzować najcenniejsze zasoby. Ten kompleksowy przewodnik wyjaśnia, czym jest LLMs.txt, dlaczego ma znaczenie dla Twojego biznesu i jak skutecznie go wdrożyć, by poprawić widoczność w nowym świecie wyszukiwania napędzanego AI.

LLMs.txt to fundamentalna zmiana w sposobie komunikacji stron ze sztuczną inteligencją. Dotychczas, gdy udostępniałeś agentowi AI swoją stronę jako źródło wiedzy, cały serwis był ładowany do systemu AI, który musiał potem wykonywać kosztowne wyszukiwanie podobieństw, dopasowanie słów kluczowych i inne zasobożerne operacje, by znaleźć właściwe informacje. To nieefektywne podejście często powodowało, że AI pomijała ważne treści lub priorytetyzowała mniej istotne strony. LLMs.txt rozwiązuje ten problem, tworząc uporządkowany, możliwy do przetworzenia przez maszyny przewodnik, który jasno wskazuje agentom AI, gdzie znajdują się najważniejsze treści i jak je traktować priorytetowo.

Pomyśl o LLMs.txt jak o wyspecjalizowanej mapie strony, ale przeznaczonej wyłącznie dla sztucznej inteligencji. Podczas gdy tradycyjne mapy XML wymieniają każdą podstronę dla wyszukiwarek, LLMs.txt dostarcza wyselekcjonowany, hierarchiczny przegląd treści, zorganizowany według ważności i kategorii. Ten plik w formacie markdown umieszcza się w głównym katalogu witryny (pod adresem /llms.txt) i stanowi mapę drogową, która pomaga dużym modelom językowym zrozumieć strukturę strony, zidentyfikować kluczowe oferty i błyskawicznie odnaleźć informacje najbardziej istotne dla zapytań użytkowników. Wdrażając LLMs.txt, tworzysz dla systemów AI coś na kształt przewodnika VIP, dzięki czemu sięgają one najpierw po najlepsze treści i poprawnie reprezentują Twój biznes w generowanych odpowiedziach AI.

Znaczenie LLMs.txt wykracza poza samą wygodę. Wraz z rosnącą popularnością wyników wyszukiwania opartych na AI, okienek odpowiedzi i asystentów konwersacyjnych, strony oferujące jasne, uporządkowane wskazówki dla systemów AI zyskują znaczącą przewagę konkurencyjną. Gdy model AI generuje odpowiedź, cytując Twoje treści, chcesz, aby wskazywał te najbardziej autorytatywne, dogłębnie opracowane i reprezentatywne strony. LLMs.txt umożliwia to, jasno wskazując systemom AI, które treści są priorytetowe, które strony są kluczowe dla biznesu, a które zasoby mają charakter uzupełniający. Ten poziom kontroli nad sposobem interakcji AI z Twoją stroną jest bezprecedensowy i stanowi istotną szansę dla firm na kształtowanie swojej widoczności w świecie AI.

Plik LLMs.txt ma określony, ustandaryzowany format sprawiający, że jest czytelny zarówno dla ludzi, jak i maszyn. Stworzony jako propozycja Jeremy’ego Howarda i społeczności AI, LLMs.txt opiera się na markdownie, co ułatwia korzystanie z niego zarówno systemom AI, jak i programistom. Struktura pliku jest celowo prosta, ale jednocześnie elastyczna, pozwalając na przekazanie agentom AI nawet złożonych hierarchii informacji bez potrzeby analizowania skomplikowanego XML-a czy posiadania specjalistycznej wiedzy technicznej.

Prawidłowo sformatowany plik LLMs.txt zaczyna się od pojedynczego nagłówka H1 z nazwą projektu lub strony — to jedyny wymagany element, więc nawet minimalna wersja niesie wartość. Po tytule możesz dodać opcjonalny blok cytatu zawierający krótkie podsumowanie projektu, przekazujące kluczowe informacje potrzebne do zrozumienia reszty pliku. Podsumowanie to powinno być zwięzłe, ale treściwe, by AI od razu wiedziała, czego dotyczy Twoja strona i jakie treści tam znajdzie. Następnie możesz dodać dowolną liczbę sekcji markdown z dokładnymi informacjami o projekcie, sposobie interpretacji pliku oraz innymi kontekstowymi danymi pomagającymi AI lepiej zrozumieć Twoje zasoby.

Prawdziwą siłą LLMs.txt są kategoryzowane listy plików, oddzielone nagłówkami H2. Każda sekcja reprezentuje kategorię treści, np. “Strony główne”, “Dokumentacja”, “Wpisy blogowe”, “Zasoby” lub inne struktury logiczne dopasowane do Twojej strony. W każdej kategorii tworzysz listę markdown, gdzie każdy element zawiera obowiązkowy link z nazwą strony i adresem URL, opcjonalnie uzupełniony o opis. Pozwala to uporządkować zasoby w jasną hierarchię, łatwą do przetworzenia przez AI. Przykładowo, strona z cennikiem może się znaleźć w sekcji “Strony główne” z opisem “Szczegółowe informacje o cenach i porównanie planów”, podczas gdy wpis blogowy o trendach w branży w sekcji “Treści kluczowe” z wyjaśnieniem jego znaczenia.

Szczególnie przydatną cechą LLMs.txt jest sekcja “Optional” (Opcjonalne), która pełni specjalną rolę w hierarchii. Wszystkie treści umieszczone w tej sekcji mogą zostać pominięte przez AI, jeśli musi ona skrócić kontekst lub działać w warunkach ograniczonej liczby tokenów. Dzięki temu możesz dołączyć materiały dodatkowe, obszerne raporty, studia przypadków czy inne zasoby, które mają wartość, ale nie są niezbędne do podstawowego zrozumienia biznesu. Wyraźnie oznaczając je jako opcjonalne, pomagasz AI podejmować inteligentne decyzje o tym, co uwzględnić w ograniczonym kontekście, zapewniając priorytet dla informacji kluczowych, a jednocześnie dostępność materiałów uzupełniających.

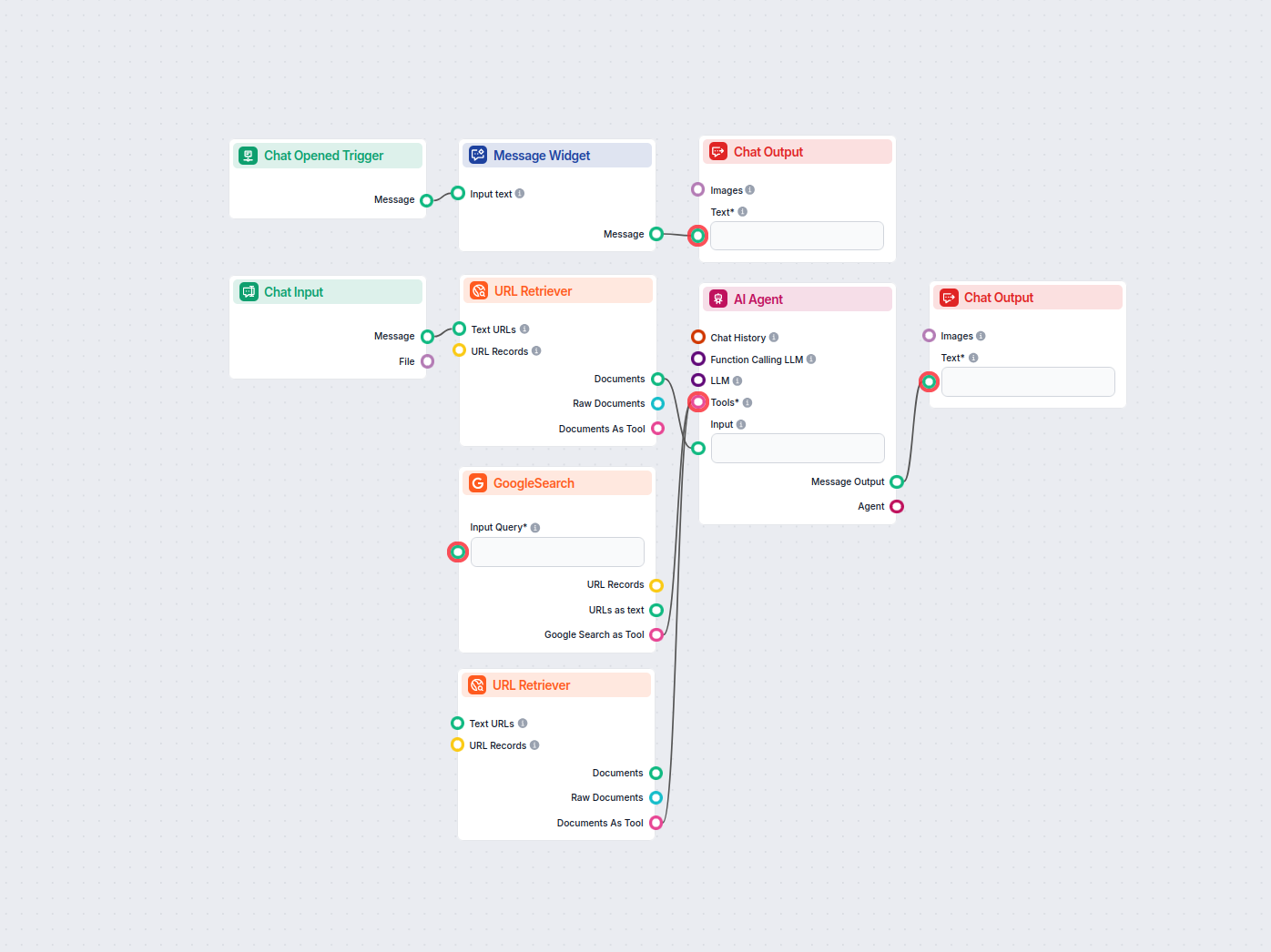

Ręczne tworzenie pliku LLMs.txt jest możliwe, ale czasochłonne i łatwo o błędy, zwłaszcza przy rozbudowanych stronach. Właśnie tu z pomocą przychodzi generator LLMs.txt od FlowHunt, automatyzując cały proces i gwarantując prawidłowy format pliku. FlowHunt opracował inteligentny, oparty na AI flow, który pobiera istniejącą mapę XML i automatycznie przekształca ją w poprawnie sformatowany LLMs.txt — z inteligentnym kategoryzowaniem i ustalaniem priorytetów treści.

Generator FlowHunt działa dzięki agentowi AI, który rozumie specyfikację LLMs.txt i potrafi analizować strukturę strony. Po podaniu adresu mapy strony, agent AI korzysta z funkcji pobierania URL i wyszukiwania Google, by przeanalizować każdą podstronę, zrozumieć jej cel i przypisać do odpowiedniej kategorii i poziomu ważności. System rozróżnia, że np. strony z cennikiem, demo czy usługami są ważniejsze niż pojedyncze wpisy blogowe czy materiały dodatkowe. Na tej podstawie generator automatycznie porządkuje treści, umieszczając najważniejsze na górze w sekcji “Strony główne”, a treści wspierające w odpowiednich kategoriach pobocznych.

To podejście jest szczególnie skuteczne, ponieważ nie polega jedynie na mechanicznym konwertowaniu mapy XML. System stosuje rozumowanie semantyczne, by określić znaczenie i wagę każdej podstrony. Generator korzysta z przykładów udanych wdrożeń (np. projektu Langfuse), by Twój plik LLMs.txt był zgodny z najlepszymi praktykami i standardami branżowymi. Dzięki temu otrzymujesz plik nie tylko poprawny technicznie, ale i strategicznie zoptymalizowany pod kątem prezentacji Twojej strony systemom AI. Cały proces jest zautomatyzowany, więc nie musisz ręcznie przeglądać i kategoryzować setek stron — FlowHunt wykona to za Ciebie.

Korzystanie z generatora LLMs.txt w FlowHunt jest proste. Wystarczy przejść do biblioteki FlowHunt, wyszukać “LLMs.txt generator” i kliknąć “Dodaj do moich flowów”. Po dodaniu możesz korzystać z tego flow, gdy tylko chcesz wygenerować lub zaktualizować plik LLMs.txt. Generator tworzy wynik w prawidłowym formacie markdown, gotowy do umieszczenia w katalogu głównym Twojej strony. Jeśli masz pytania lub chcesz wprowadzić poprawki, dokumentacja i wsparcie FlowHunt są dostępne, by pomóc zoptymalizować wdrożenie.

Po wygenerowaniu pliku LLMs.txt w FlowHunt lub jego ręcznym utworzeniu, kolejnym krokiem jest wdrożenie go na stronie. Proces implementacji jest niezwykle prosty — to jeden z powodów rosnącej popularności LLMs.txt jako standardu webowego. Plik LLMs.txt należy umieścić w głównym katalogu strony, pod adresem https://twojadomena.com/llms.txt. To ustandaryzowane położenie, dzięki czemu systemy AI łatwo odnajdują plik bez konieczności specjalnej konfiguracji.

Prostota wdrożenia jest zamierzona. W przeciwieństwie do niektórych standardów webowych, które wymagają skomplikowanej konfiguracji serwera czy specjalnych nagłówków, LLMs.txt to zwykły plik tekstowy dostępny przez HTTP. Możesz go przesłać przez menedżera plików, klienta FTP lub panel CMS. Jeśli korzystasz z generatorów statycznych (np. Hugo, Jekyll, Next.js), wystarczy umieścić plik w katalogu public/static, a będzie serwowany automatycznie. Dla stron dynamicznych możesz generować plik programistycznie, aktualizując go przy każdej zmianie struktury strony.

Po opublikowaniu pliku LLMs.txt, systemy AI obsługujące ten standard mogą go automatycznie wykrywać i wykorzystywać. Niektóre agenty AI sprawdzają, czy plik istnieje, i analizują go, by zrozumieć strukturę strony przed pobraniem treści. Inne mogą wymagać ręcznego podania URL pliku podczas integracji. Wraz ze wzrostem adopcji, coraz więcej systemów AI będzie automatycznie wykrywać i wykorzystywać pliki LLMs.txt — podobnie jak wyszukiwarki automatycznie wykrywają robots.txt i mapy XML. To oznacza, że wdrażając LLMs.txt już dziś, przygotowujesz swoją stronę na przyszłość eksploracji treści przez AI.

Choć techniczny format LLMs.txt jest prosty, skuteczne wdrożenie wymaga strategicznego podejścia do treści i sposobu interakcji AI z Twoją stroną. Najważniejsza zasada to selektywność. LLMs.txt nie powinien zawierać wszystkich podstron — do tego służy mapa XML. Powinien być zbiorem najcenniejszych, najlepiej przygotowanych i najbardziej autorytatywnych materiałów. Taka selekcja pozwala AI skupić się na kluczowych treściach, zmniejsza obciążenie modeli językowych i zapewnia, że systemy AI cytują najbardziej reprezentatywne i wysokiej jakości strony.

Wybierając, co umieścić w LLMs.txt, priorytetowo traktuj strony odpowiadające na konkretne pytania lub kompleksowo omawiające ważne zagadnienia. Najlepiej sprawdzają się treści evergreen, które długo zachowają aktualność. Warto dołączyć bazy wiedzy, poradniki, treści filarowe, dobrze zorganizowane wpisy z wyraźnymi nagłówkami i punktami, przystępne do analizy przez AI. Przeglądy produktów, cenniki, sekcje FAQ i artykuły z centrum pomocy są cenne, bo dostarczają konkretnych, pewnych informacji, które AI może cytować.

Unikaj natomiast stron typowo marketingowych i ogólnych stron brandowych, które często nie zawierają konkretnych, faktograficznych informacji przydatnych AI. Materiały zastrzeżone lub wrażliwe, które mogłyby zostać źle zinterpretowane lub wyrwane z kontekstu, również powinny być wykluczone, by chronić interesy firmy. Treści oparte głównie na interaktywności, animacjach czy elementach wizualnych tracą wartość w przetwarzaniu przez AI, więc tych stron nie warto uwzględniać. Promocje czasowe, treści sezonowe oraz strony z datą ważności szybko się dezaktualizują i mogą prowadzić do cytowania nieaktualnych informacji. Strony o niejasnym lub zbyt szerokim zakresie bez konkretnej tematyki również nie są wskazane — AI nie uzyska z nich wartościowych, konkretnych informacji.

Organizacja i kategoryzacja są kluczowe dla skutecznego LLMs.txt. Grupuj powiązane treści w logiczne kategorie odzwierciedlające strukturę Twojego biznesu i sposób myślenia użytkowników. Dla SaaS mogą być to “Kluczowe funkcje”, “Dokumentacja”, “Cennik i plany”, “Studia przypadków”, “Blog”. Dla e-commerce — “Kategorie produktów”, “Poradniki zakupowe”, “Opinie klientów”, “Polityki”. Dla firm usługowych — “Usługi”, “Studia przypadków”, “Zespół”, “Zasoby”. Konkretne kategorie są mniej istotne niż ich logiczność i przejrzystość dla AI. W każdej kategorii na początku wymień najważniejsze strony, gdyż AI może traktować priorytetowo te z góry listy.

LLMs.txt to stosunkowo nowy standard, ale jego popularność stopniowo rośnie w ekosystemie AI. Obecnie kilka kategorii systemów AI obsługuje LLMs.txt: narzędzia developerskie i frameworki jak LangChain czy LangGraph mają natywną obsługę, umożliwiając automatyczne wykrywanie i wykorzystanie pliku LLMs.txt przez aplikacje AI. Wsparcie pojawia się też w mniejszych narzędziach AI i chatbotach, szczególnie tych branżowych. Niektóre pluginy IDE i asystenci kodowania AI zaczynają wspierać ten standard w fazach beta. Należy jednak pamiętać, że główni dostawcy LLM, jak OpenAI (ChatGPT), Anthropic (Claude) czy Google (Bard), obecnie nie obsługują LLMs.txt natywnie.

Ten brak wsparcia ze strony największych dostawców może wydawać się ograniczeniem, ale warto uwzględnić kontekst. Duże modele językowe są trenowane na ogromnych zbiorach danych z internetu i zazwyczaj nie odwiedzają stron w czasie rzeczywistym podczas generowania odpowiedzi. Generują treści na podstawie wzorców poznanych podczas treningu. Jednak w miarę rozwoju funkcji wyszukiwania w czasie rzeczywistym oraz własnych baz wiedzy, wsparcie dla LLMs.txt najprawdopodobniej się pojawi. Dodatkowo wiele firm buduje własne aplikacje AI i agentów korzystających z zasobów stron na bieżąco — i właśnie te systemy coraz chętniej wdrażają LLMs.txt.

Przyszłość LLMs.txt wygląda obiecująco. Wraz ze wzrostem znaczenia wyszukiwania i asystentów AI, potrzeba komunikacji stron z systemami AI będzie coraz większa. LLMs.txt daje ustandaryzowany, prosty sposób na taką komunikację, więc jego adopcja powinna przyspieszyć. Liderzy branży i innowacyjne firmy już wdrażają LLMs.txt, tworząc najlepsze praktyki. W miarę jak więcej systemów AI będzie obsługiwać ten standard, strony, które już mają wdrożony LLMs.txt, zyskają przewagę, będąc lepiej przygotowanymi na AI. Standard prawdopodobnie będzie się rozwijał i ulepszał wraz z doświadczeniem użytkowników.

Warto jasno powiedzieć: tradycyjne wyszukiwarki jak Google, Bing czy inne duże platformy nie wykorzystują obecnie plików LLMs.txt do indeksowania czy pozycjonowania stron. Opierają się one na sprawdzonych standardach — mapach XML, robots.txt i znacznikach danych strukturalnych — i nie planują wdrożenia LLMs.txt do klasycznej optymalizacji pod SEO. To oznacza, że wdrożenie LLMs.txt nie poprawi bezpośrednio pozycji w wynikach wyszukiwania. Jednak to ograniczenie nie umniejsza wartości LLMs.txt w innym, równie ważnym zastosowaniu: dla własnych agentów AI i wyspecjalizowanych aplikacji AI. Gdy firmy budują własnych agentów, chatboty czy systemy automatyzacji wymagające zrozumienia i interakcji z witrynami, LLMs.txt staje się niezwykle wartościowy. Takie rozwiązania mogą programistycznie pobierać LLMs.txt, by szybko zrozumieć strukturę domeny, odnaleźć autorytatywne treści i wydobyć istotne informacje bez analizowania całej strony. Przykładowo agent AI przeznaczony do badań branżowych, porównań produktów czy analizy konkurencji może dzięki LLMs.txt sprawniej nawigować po serwisie i lepiej rozumieć ofertę. W tym kontekście LLMs.txt to potężne narzędzie, by Twoja strona była lepiej dostępna i zrozumiała dla systemów AI, nawet jeśli wyszukiwarki ją ignorują. Wraz z rozwojem własnych rozwiązań AI przez firmy, dobrze przygotowany plik LLMs.txt zapewni Twojej stronie lepszą obsługę przez inteligentne systemy.

Standard LLMs.txt spotkał się z krytyką ze strony specjalistów SEO i technicznych, którzy twierdzą, że szum wokół niego znacznie przewyższa rzeczywistość. Jest kilka silnych argumentów podważających praktyczną wartość wdrażania LLMs.txt. Przede wszystkim analiza logów serwerowych wielu stron pokazuje, że crawler’y AI od największych dostawców — OpenAI, Google, Microsoft — nie pobierają plików llms.txt podczas wizyt na stronach. To oznacza, że pomimo teoretycznych korzyści nie ma żadnych dowodów na rzeczywiste użycie przez systemy AI, które najbardziej liczą się dla biznesu. John Mueller z Google publicznie uznał LLMs.txt za zbędny, a niezależne testy (np. Redocly) wykazały, że o ile nie wkleisz zawartości llms.txt bezpośrednio do rozmowy z LLM, modele nie pobierają i nie respektują tego pliku.

Dużym problemem jest też nakład pracy przy utrzymaniu pliku. W przeciwieństwie do map XML, które większość CMS-ów generuje automatycznie, LLMs.txt wymaga regularnej, ręcznej aktualizacji, by był przydatny i zgodny z rzeczywistością. Wraz z rozwojem strony musisz ciągle aktualizować plik, usuwać nieaktualne podstrony i reorganizować kategorie. To ciągła praca bez gwarancji wymiernych efektów. Jeszcze większym ryzykiem jest rozjazd pliku markdown i rzeczywistych treści — jeśli LLMs.txt nie będzie zgodny z zawartością serwisu, AI może pobrać nieaktualne lub mylące dane, prowadząc do błędów lub fałszywych cytowań, co może zaszkodzić bardziej niż brak pliku.

Krytycy podkreślają również, że LLMs.txt może rozwiązywać problem, który wkrótce przestanie istnieć. Modele AI coraz lepiej radzą sobie z analizą stron w formacie HTML, rozumieją strukturę stron jak człowiek i nie potrzebują prostych przewodników w markdownie. Inwestycja w tworzenie i utrzymanie LLMs.txt może się więc szybko zdezaktualizować. Co więcej, standard sam w sobie nie jest wiarygodny — nic nie stoi na przeszkodzie, by właściciel strony zamieścił w LLMs.txt nieistniejące lub mylące informacje i “oszukał” AI w sposób trudny do wykrycia.

Co najważniejsze, nie ma obecnie dowodów na to, że LLMs.txt poprawia skuteczność pobierania danych przez AI, zwiększa ruch z systemów AI ani poprawia sposób cytowania Twoich treści przez modele. Żaden duży dostawca AI nie zobowiązał się do wykorzystywania LLMs.txt, a nieliczne przykłady wdrożeń pochodzą z mniejszych, wyspecjalizowanych narzędzi, a nie platform napędzających realne wyniki biznesowe. Dla firm z ograniczonymi zasobami wdrożenie LLMs.txt może być złym wykorzystaniem czasu w porównaniu do innych działań optymalizacyjnych o udowodnionym zwrocie z inwestycji. Te zarzuty należy potraktować poważnie i wdrażać LLMs.txt z realistycznymi oczekiwaniami co do jego aktualnych ograniczeń i niepewnej przyszłości.

Aby zrozumieć praktyczne zastosowanie LLMs.txt, warto przyjrzeć się rzeczywistym wdrożeniom. Projekt FastHTML, popularny framework webowy, wdrożył LLMs.txt dla swojej dokumentacji i stanowi świetną referencję. Ich plik LLMs.txt jasno organizuje dokumentację w sekcje z linkami do najważniejszych stron. Dodatkowo przygotowali wersje markdown swoich podstron HTML (dostępne po dopisaniu .md do adresu URL), co jeszcze bardziej ułatwia AI dostęp do czystych treści. To podejście — przewodnik LLMs.txt + wersje markdown — staje się najlepszą praktyką, którą wdrażają kolejne strony.

Innym ważnym przykładem jest projekt nbdev, na którym opiera się dokumentacja fast.ai i Answer.AI. Domyślnie nbdev generuje markdownowe wersje wszystkich stron dokumentacji, dzięki czemu projekty korzystające z nbdev mogą łatwo obsłużyć LLMs.txt. Pokazuje to, że wsparcie dla LLMs.txt można wbudować w narzędzia i frameworki, upraszczając adopcję dla użytkowników końcowych.

Dla firm wdrażających LLMs.txt najważniejsza lekcja z tych przykładów to fakt, że standard działa najlepiej w połączeniu z czystymi, dobrze zorganizowanymi treściami. Jeśli Twoja strona już posiada dobrze zorganizowaną dokumentację, przejrzyste strony produktowe czy kompletne poradniki, jesteś już blisko skutecznego LLMs.txt. Wystarczy wskazać AI te treści i logicznie je uporządkować. Dlatego właśnie zautomatyzowane podejście FlowHunt jest tak wartościowe — analizuje istniejące treści i tworzy optymalny plik LLMs.txt bez konieczności przebudowy całej witryny.

Wdrożenie LLMs.txt powinno być elementem szerszej strategii optymalizacji strony pod kątem AI. Choć LLMs.txt pomaga AI znaleźć i priorytetyzować Twoje treści, działa najlepiej w połączeniu z innymi działaniami optymalizacyjnymi. Po pierwsze, zadbaj, by treści na stronie były dobrze ustrukturyzowane, jasno napisane i czytelne zarówno dla ludzi, jak i AI. Używaj przejrzystych nagłówków, logicznego podziału akapitów, formatowania ułatwiającego skanowanie. Unikaj żargonu, a gdy musisz go użyć — wyjaśnij pojęcia. To korzystne zarówno dla ludzi, jak i dla AI.

Po drugie, rozważ przygotowanie wersji markdown najważniejszych podstron, zgodnie ze specyfikacją LLMs.txt. Choć nie jest to wymagane, czyste wersje markdown ułatwiają AI przetwarzanie i dokładne cytowanie treści. To szczególnie ważne dla dokumentacji technicznej, poradników i treści, gdzie liczy się format i struktura. Po trzecie, regularnie aktualizuj LLMs.txt wraz z rozwojem strony. Dodając ważne podstrony, uwzględnij je w pliku; usuwając lub dezaktualizując — wykreśl z pliku. Dzięki temu AI zawsze będzie mieć aktualny przewodnik po Twojej stronie.

Na koniec monitoruj, jak systemy AI wykorzystują Twoje treści i cytują Twoją stronę. Wraz z rozwojem wyników wyszukiwania opartych na AI, będziesz mógł zobaczyć, które strony są najczęściej cytowane i jak AI prezentuje Twoje treści. Na tej podstawie możesz udoskonalać plik LLMs.txt i swoją strategię contentową. Jeśli dane strony są często cytowane — rozbuduj je. Jeśli ważne strony nie są cytowane — sprawdź, czy są odpowiednio opisane i zaklasyfikowane w LLMs.txt.

LLMs.txt to potencjalna szansa, by strona mogła świadomie kierować tym, jak systemy AI odkrywają i wykorzystują jej treści — ale decyzja o wdrożeniu powinna być przemyślana i oparta na realnych oczekiwaniach. Z jednej strony standard daje prosty sposób na przekazanie uporządkowanych wskazówek agentom AI, co szczególnie docenią twórcy własnych rozwiązań AI, narzędzi developerskich czy aplikacji branżowych. Dla firm budujących własne narzędzia AI, LLMs.txt realnie poprawia sposób rozumienia i wykorzystania treści. Implementacja jest prosta, a narzędzia takie jak generator FlowHunt automatyzują analizę i organizację zawartości.

Z drugiej strony — krytyka jest poważna i nie można jej zignorować. Żadna duża platforma AI nie korzysta obecnie z LLMs.txt, brak dowodów na wzrost widoczności czy ruchu, a nakład pracy może przewyższyć niepewne korzyści. Klasyczne wyszukiwarki całkowicie go ignorują, a nawet asystenci AI dla konsumentów od OpenAI, Anthropic czy Google nie planują wdrożenia. Być może standard rozwiązuje przejściowy problem, który zniknie, gdy modele AI zaczną sprawniej analizować strony HTML.

Pragmatyczne podejście to potraktowanie LLMs.txt jako niskokosztowego eksperymentu, a nie kluczowego priorytetu optymalizacyjnego. Jeśli masz narzędzie takie jak FlowHunt, które wygeneruje plik automatycznie, wdrożenie LLMs.txt jest sensowną, przyszłościową inwestycją, która może zaprocentować, jeśli adopcja wzrośnie. Jeśli jednak wymagałoby to dużej pracy ręcznej i ciągłej obsługi, lepiej przeznaczyć zasoby na działania o udowodnionym zwrocie z inwestycji. Ostatecznie o wartości LLMs.txt zdecyduje to, czy zostanie przyjęty przez głównych dostawców AI — a to pozostaje otwartą kwestią. Na dziś warto traktować go jako opcjonalne udogodnienie dla własnych rozwiązań AI, a nie obowiązkowy element widoczności w AI.

LLMs.txt to plik tekstowy w formacie markdown umieszczany w głównym katalogu strony, który przekazuje agentom AI oraz dużym modelom językowym mapę najważniejszych, przyjaznych AI treści. Pomaga LLM-om zrozumieć, które strony są najbardziej wartościowe i powinny być priorytetowo traktowane podczas odwiedzania Twojej witryny.

Podczas gdy mapy strony XML wymieniają wszystkie strony serwisu dla wyszukiwarek, LLMs.txt jest zaprojektowany specjalnie dla dużych modeli językowych. Zawiera wyselekcjonowaną, priorytetową listę najlepszych treści pogrupowanych według kategorii, dzięki czemu agenci AI szybko odnajdują najbardziej odpowiednie i autorytatywne informacje bez konieczności analizowania całej witryny.

Obecnie główni dostawcy LLM, tacy jak OpenAI (ChatGPT) i Anthropic (Claude), nie obsługują natywnie plików LLMs.txt. Jednak wsparcie rośnie wśród niestandardowych wdrożeń AI, narzędzi developerskich oraz frameworków takich jak LangChain. Wraz ze wzrostem znaczenia wyszukiwania opartego na AI, przewiduje się szybki wzrost adopcji tego standardu.

Zamieść ponadczasowe treści odpowiadające na konkretne pytania, bazy wiedzy, poradniki krok po kroku, dobrze ustrukturyzowane wpisy blogowe, FAQ, opisy produktów i artykuły z centrum pomocy. Unikaj stron zorientowanych na marketing, treści zastrzeżonych, czasowych promocji oraz podstron opartych głównie na elementach interaktywnych lub wizualnych.

Możesz ręcznie stworzyć plik markdown zgodnie ze specyfikacją LLMs.txt lub skorzystać z automatycznych narzędzi, takich jak generator LLMs.txt od FlowHunt. Wystarczy wkleić adres URL mapy strony do narzędzia, a ono automatycznie wygeneruje odpowiednio sformatowany plik LLMs.txt, który możesz umieścić w głównym katalogu swojej witryny.

Arshia jest Inżynierką Przepływów Pracy AI w FlowHunt. Z wykształceniem informatycznym i pasją do sztucznej inteligencji, specjalizuje się w tworzeniu wydajnych przepływów pracy, które integrują narzędzia AI z codziennymi zadaniami, zwiększając produktywność i kreatywność.

Twórz i zarządzaj plikami LLMs.txt automatycznie, optymalizuj swoją stronę pod kątem agentów AI i zwiększaj widoczność w wynikach wyszukiwania opartych na AI.

Plik llms.txt to standaryzowany plik Markdown zaprojektowany w celu optymalizacji sposobu, w jaki Duże Modele Językowe (LLM) uzyskują dostęp i przetwarzają treś...

Automatycznie przekształć sitemapę swojej strony (sitemap.xml) w format dokumentacji przyjazny dla LLM. Ten konwerter oparty na AI wyodrębnia, przetwarza i stru...

Przekształć dowolny plik sitemap.xml w dobrze ustrukturyzowany format llms.txt za pomocą AI. Ten workflow pobiera adresy URL z mapy strony, pobiera i przetwarza...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.